Skript Messen, urteilen und entscheiden, Modul B

Werbung

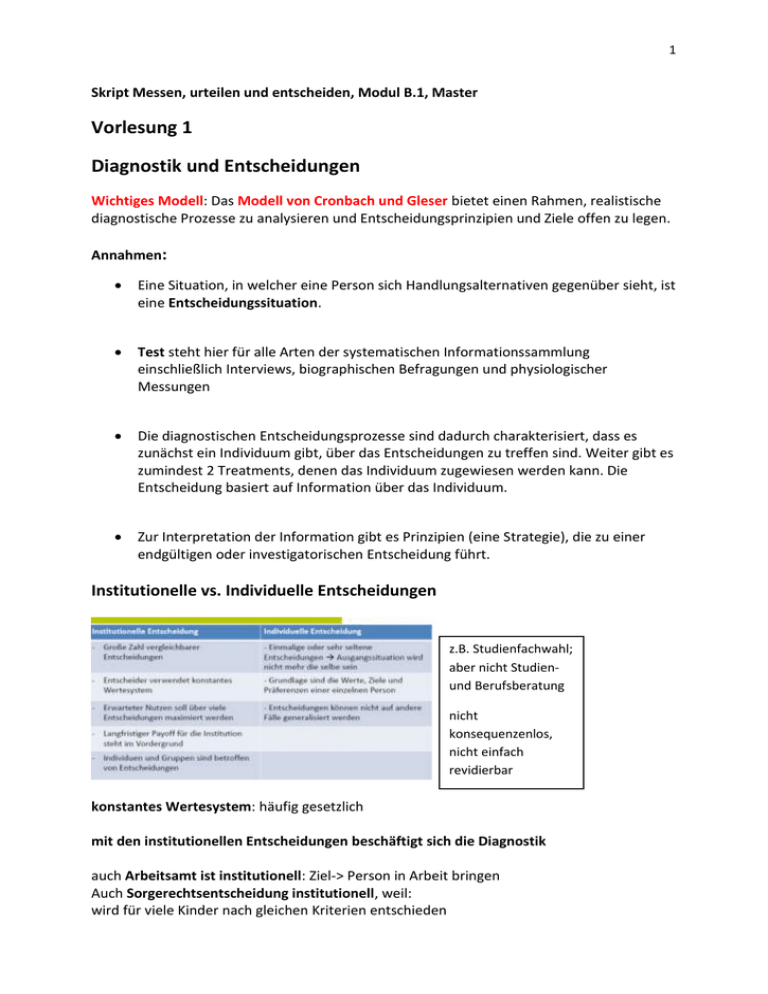

1 Skript Messen, urteilen und entscheiden, Modul B.1, Master Vorlesung 1 Diagnostik und Entscheidungen Wichtiges Modell: Das Modell von Cronbach und Gleser bietet einen Rahmen, realistische diagnostische Prozesse zu analysieren und Entscheidungsprinzipien und Ziele offen zu legen. Annahmen: Eine Situation, in welcher eine Person sich Handlungsalternativen gegenüber sieht, ist eine Entscheidungssituation. Test steht hier für alle Arten der systematischen Informationssammlung einschließlich Interviews, biographischen Befragungen und physiologischer Messungen Die diagnostischen Entscheidungsprozesse sind dadurch charakterisiert, dass es zunächst ein Individuum gibt, über das Entscheidungen zu treffen sind. Weiter gibt es zumindest 2 Treatments, denen das Individuum zugewiesen werden kann. Die Entscheidung basiert auf Information über das Individuum. Zur Interpretation der Information gibt es Prinzipien (eine Strategie), die zu einer endgültigen oder investigatorischen Entscheidung führt. Institutionelle vs. Individuelle Entscheidungen z.B. Studienfachwahl; aber nicht Studienund Berufsberatung nicht konsequenzenlos, nicht einfach revidierbar konstantes Wertesystem: häufig gesetzlich mit den institutionellen Entscheidungen beschäftigt sich die Diagnostik auch Arbeitsamt ist institutionell: Ziel-> Person in Arbeit bringen Auch Sorgerechtsentscheidung institutionell, weil: wird für viele Kinder nach gleichen Kriterien entschieden 2 Kindeswohl ist max. Nutzen für die Organisation, soll durch Nutzen einer Serie von Entscheidungen maximiert werden Klassifikation: zweidimensionale Entscheidung = bivariat, weil x und y; alle kommen unter Platzierung: eindimensional, quasi Klassifikation anhand eines Scores; alle kommen unter Selektion/ Auswahl: es werden welche ausgeschlossen, z.B. mehr Bewerber als Stellen 3 Entscheidungsstrategien ein Wert kann den anderen ausgleichen bei der Oder-Strategie gibt es Cut-Off-Werte je nach Strategie fallen die Entscheidungen für die gleiche Person unterschiedlich aus man muss über beide Cut-Off-Werte liegen 4 Einzelteststrategie/ einstufig: 1 Test entscheidet Mehrstufige Entscheidungsstrategien: versch. Verfahren hintereinander, z.B. Vorauswahl bei Führerscheinprüfung: wer durch Theorie fällt, kommt nicht weiter Vorentscheidung: 1. Test entscheidet, ob drin oder weitergeleitet Vollständige sequentielle Strategie: kombiniert beides, welche fliegen raus, andere sind drin, andere werden weiter getestet Klausurfrage: Was ist ein sequenzielles Verfahren? wird in der Praxis meist angewendet die Verfahren können unterschiedliche Formen annehmen Zumindest für einen Teil der Testpersonen wird nach einer ersten Testung noch keine endgültige Entscheidung getroffen, sondern eine sogenannte investigatorische Entscheidung (weiteres Testen, vorläufige Zuweisung zu einem Treatment, „try-out“…) z.B. erst soziale Kriterien, dann Eignung oder Sichtung der Bewerbungsunterlagen, dann Einladung zum Gespräch oder nicht usw. 5 Beispiel Castingsshows: • • • • • • • Üblicherweise institutionelle Entscheidungen Aufnahmequote zunächst variabel (eine Reihe von Leuten kommt weiter), dann fest (10 Leute im Finale, einer gewinnt) Behandlung: Training, Coaching etc. Mehrstufiges Auswahlverfahren: erste Ausscheidung, „recall“, etc. Selektion Multivariate Information (Gesang, Aussehen, Auftreten) Zunächst investigatorisch, dann terminal Nutzenerwägungen • Welche Strategie ist nun die beste? Nutzenerwägungen! • Ziel von Diagnostik: Optimierung von Entscheidungen • Optimierung wird durch Nutzen abgelesen, es muss also möglich sein, den Nutzen von Entscheidungen zu vergleichen, bzw. auf Dauer berechnen zu können. • Daher ist es erforderlich anzunehmen, dass unterschiedliche Ergebnisse eines Entscheidungsprozesses in „gleichen Einheiten“ (z.B. €) des Nutzens ausgedrückt werden können: Kardinalskala (Verhältnisskala) des Nutzens • Diese Einheiten sollen sich über verschiedene Entscheidungen addieren lassen. Diese Annahme ist in einigen Bereichen eher realistisch, in anderen problematisch (z.B. Personalentscheidungen versus Entscheidungen über das Kindeswohl) Strategiematrizen • Strategien lassen sich übersichtlich in Strategiematrizen zusammenfassen. • Halten die Regeln fest, nach denen auf der Basis von diagnostischen Informationen Entscheidungen getroffen werden 6 • Empirische Entscheidungen in einer Strategiematrix zu tabulieren dient der Klärung des Entscheidungsprozesses und kann „verborgene“ Informationssammlungen oder Fehler im Entscheidungsprozess aufdecken. nur 1 und 0 (wenn, dann), keine Zeile oder Stelle darf leer sein Strategiematrix ist erstmal normativ (wie es laufen sollte) empirische Werte können hinterher ausgefüllt werden und anders aussehen wenn empirische Werte anders sind, waren verdeckte Kriterien am Werk Outcomes • Nachdem die Regeln formalisiert sind, die beschreiben, welche Entscheidungen bei gegebenen Informationen zu treffen sind, muss evaluiert werden, ob die Entscheidungen bzw. „Treatments“, welche auf diesen Regeln basieren, erfolgreich sind. • Erfolgreich sind sie dann, wenn ein bestimmtes Kriterium erreicht wird – kann Erfolg sein oder das Vermeiden von Misserfolg. • Das Ergebnis eines Entscheidungsprozesses besteht in allen Konsequenzen einer Entscheidung, die für die entscheidende Person (besser seine Institution) von Bedeutung sind (Gesamtbeitrag einer Person bewerten, nicht nur 1 Eigenschaft) Da nur fehlerbehaftete Information vorliegt, hat die entscheidende Person lediglich eine Wahrscheinlichkeitsverteilung von Ergebnissen (Kriterienmaßen, „outcomes“) zur Verfügung. Diese Wahrscheinlichkeitsverteilung gibt für jede Informationskategorie die über viele Entscheidungen erwarteten Ergebnisse an. • • Ergebnisse früherer „Fälle“ (oder Forschungen) dienen dazu zu beschreiben, welche Beziehung zwischen einer Informationskategorie und einem Kriteriumszustand besteht. Für jede Behandlung (Treatment) lässt sich somit eine Validitätsmatrix erstellen. -> Generierung von a priori Wissen für zukünftige Entscheidungen wenn ich weiß, dass Menschen produktiver sind, wenn sie intelligent sind, weiß ich, dass ich Intelligenz messen muss und nichts anderes 7 Validitätsmatrix • Verknüpfung von Behandlung und Ergebnis = Erfolg im Kriterium • Einträge geben die Wahrscheinlichkeit dafür an, dass ein Proband mit xr und der Behandlung t den Kriteriumswert cr erlangt: p(c|xr,t). • Die Kriteriumswerte können im einfachsten Fall dichotome Kategorien (erfolgreich/nicht erfolgreich; gesund/krank) bilden; möglich sind auch kontinuierliche Abstufungen. Informationsklassen: z.B. niedriger und hoher IQ kategoriale Darstellung von Korrelationen -> zeigt Zusammenhang von Prädiktor und Outcome Kreuztabelle mit verbundenen WSK -> x²-Test kann prüfen, ob a-priori-Wissen vorliegt könnte hier auch multivariate Infos zeigen: Inf1 depr. Episode ja/nein Inf2 Wahnv. Ja/ nein Dann wären es 4 Informationsklassen Bewertung der Entscheidungsfindung • Führt die gewählte Prozedur zu Entscheidungen, die auf der Basis der gegebenen Information optimal sind? • Würde die Sammlung weiterer Informationen die Entscheidungen verbessern? • Wie groß ist der Unterschied bezüglich der Güte von Entscheidungen zwischen zwei alternativen Entscheidungsprozeduren? Erweiterung der psychologischen Diagnostik um ökonomische Komponente Inkrementelle Validität des Verfahrens 8 Bewertung von Ergebnissen • Jede Informationskategorie kann zu einer anderen Verteilung der erwarteten Ergebnisse für ein Treatment führen • Um alternative Strategien vergleichen und evaluieren zu können, muss die Wünschbarkeit jedes Kriterienzustandes bewertet werden. • Jedem Kriterienzustand wird also ein Wert zugewiesen. Für viele weitere Überlegungen sollen diese Bewertungen auf einer Verhältnisskala vorgenommen werden. „Payoff“-Funktionen: Die Beziehung zwischen Nutzen. Fähigkeit und Treatment • Im Falle eines einzelnen Treatments und der Vorhersage aufgrund kontinuierlicher Testwerte können wir „payoff“-Funktionen erstellen, die angeben, mit welchem Nutzen wir für eine Person mit einem bestimmten Wert bei dem gewählten Treatment rechnen können. Zuweisung der Person zu dem Treatment mit dem höchsten Nutzen tC und tB nicht linear im unteren Bereich alle in Treatment tA, weil es am meisten Profit verspricht, dann tB, dann tC ab einem bestimmten Wert ist es besser, Treatment A zu geben (hier etwa bei 3) 9 Vorlesung 2 Grundbegriffe der Probabilistischen Testtheorie Grundidee IRT nicht einzelne Theorie, sondern zusammenfassende Bezeichnung für eine Klasse „ähnlicher“ Modelle • Rasch Modell (auch 1 PL, dichotome Antworten ja / nein ; richtig / falsch) • Birnbaum-Modelle (dichotome Antworten, unterschiedliche Trennschärfe) • Partial-Credit-Model (mehrkategorielle Antworten, Erweiterung des 1PL) • Linear Logistisches Test Modell (LLTM) • Sowohl KTT als auch IRT wollen Personen testen, d.h. ihnen die Ausprägung eines bestimmten Merkmals zuordnen • Unterschied zur KTT: Merkmal und Verhalten im Test werden nicht gleichgesetzt • Das Merkmal ist nicht direkt beobachtbar, sondern eine latente Dimension, auf die geschlossen werden muss • Annahme: Latente Eigenschaften schlagen sich in beobachtbaren (manifesten) Antworten nieder • Wird Verhalten auf zwei Items durch die gleiche latente Variable beeinflusst, sollten diese Items korrelieren • Wenn die Testitems Indikatoren der latenten Variablen sind, kann die latente Variable als »Ursache« für die Korrelation zwischen den manifesten Variablen angesehen werden • Items korrelieren NUR, weil sie die gleiche latente Dimension erfassen -> Itemhomogenität • Voraussetzung lokale stochastische Unabhängigkeit IC-Funktion • Annahmen über Zusammenhänge der latenten Variable (Merkmalsausprägung) und der Wahrscheinlichkeit für das Auftreten bestimmter Antworten • „Herzstück“ der IRT sind die Itemcharakteristischen Funktionen (ICF), also die Darstellung dieser Beziehung zwischen der Wahrscheinlichkeit des manifesten Antwortverhaltens in Abhängigkeit von der Ausprägung einer Person auf dem zugrundeliegenden latenten Trait • Je nach Art des IRT-Modells werden zur besten Modellierung des Antwortverhaltens unterschiedliche Funktionstypen angenommen. 10 Begrifflichkeiten: ϴ (theta, manchmal auch ξ) = Ausprägung des latenten Trait σ (sigma) = Itemparameter (bei Schwierigkeit oft beta) P(ϴ) = Wahrscheinlichkeit, der Antwort bei gegebenem Fähigkeitslevel -> y-Achse Pij(ϴj; bi) = Wahrscheinlichkeit einer Person j mit Fähigkeit ϴ, das Item mit der Eigenschaft i (z.B. Schwierigkeit) zu lösen probabilistisch: mit WSK-Dimension 1 Fähigkeitsdimension (latente, nicht beobachtbare Variable) z.B. Intelligenz a: deterministisches Modell (ja/nein) g: Item ist zu 30% zu lösen, z.B. Multiple Choice mit 3 Antwortmöglichkeiten -> 3Parameter logistisches Modell Beispiel IC-Funktion Guttman Skala deterministisches Modell z.B. Wie viel wiegen Sie? <60 kg, <80 kg, < 100kg wenn VP 90 kg wiegt, sagt er erst nein und bei allen weiteren Fragen ja oder soziale Distanz/ Nähe Haben Sie etwas dagegen, wenn Ausländer in Ihre Stadt, Straße, Haus ziehen? irgendwann kippt es von nein auf ja und bleibt dabei! 11 Rasch- Modell (1PL-Modell) WSK richtig gelöst WSK falsch gelöst Gegenwahrscheinlichkeit alle Charakteristika von Items gleich, Steilheit vorgeschrieben WSK, Item zu lösen in Abhängigkeit der Ausprägung der Eigenschaft (latente Variable) Keine Rate-WSK, können nicht raten, keine Antwortalternativen Lösungswahrscheinlichkeit ist umso höher, je größer die Differenz zwischen Fähigkeit und Schwierigkeit ist bei P (0,5) ist das Item mittelschwer 1PL -> Itemschwierigkeit als einziger Parameter, der variiert Annahme: keine Lern- oder Transfereffekte 12 • Beschreibt Wahrscheinlichkeit, dass Person j mit Fähigkeit ϴ Item i mit Schwierigkeit б löst. • Wahrscheinlichkeit ist also Funktion von Personenfähigkeit und Itemschwierigkeit • Fähigkeit und Schwierigkeit werden auf einer Achse abgetragen • Reaktionen sind „lokal stochastisch unabhängig": Ob eine Person eine bestimmte Aufgabe löst oder nicht, hängt nur von ihrer Fähigkeit und der Schwierigkeit der Aufgabe ab, nicht aber davon, welche anderen Aufgaben sie bereits gelöst hat oder noch lösen wird, keine Reihenfolgeeffekte Rasch-Modell Item-Informationsfunktion Klausur: Gib an, wie gut Item differenziert/ wie hoch Informationsgehalt eines Items an einem best. Punkt ist Wieviel Information man aus einem Item ziehen kann, hängt davon an, wie ähnlich seine Schwierigkeit der Fähigkeit der Person ist 13 P= WSK richtige Antwort/ Lösungswsk Q= WSK falsche Antwort/ Komplementärwsk 0,5 * 0,5 = 0,25 Item leichter: IC + Infofunktion verschieben sich nach links Item schwerer: nach rechts Max. Info über Person; differenziert besonders gut in Mitte Rasch-Modell IC-Funktionen unterschiedlich schwerer Items Implikation: Man braucht verschieden schwierige Items, um über alle Personen möglichst viel Information zu bekommen bei schwierigen Items wird die Kurve nach rechts verschoben Items unterscheiden sich nicht in Trennschärfe -> Steigung immer gleich Rasch-Modell Testcharakteristische Funktion • ICF bilden die Wahrscheinlichkeit ab, dass Person das Item richtig beantwortet • TCF macht das gleiche für den ganzen Test: Für jede Fähigkeit zeigt sie den erwarteten Testscore • Beobachtbarer Testscore: Bei 5 Items kann der Wert zwischen 0 und 5 liegen 14 • Für jedes Item gibt es eine Lösungswahrscheinlichkeit bei gegebener Fähigkeit • Summe dieser Wahrscheinlichkeiten = erwarteter Testscore Lösungswahrscheinlichkeiten addieren: 0,1 + 0,25 + 0,5 + 0,8 + 0,85 = ca. 2, 5 = erwarteter Testwert für Personen mit mittlerer Fähigkeit wenn ϴ=-1: 0,05 + 0,1 + 0,25 + 0,7 + 0,85 = 1,95 (erwarteter Testscore) Rasch-Modell Testinformationsfunktion Klausur: zeichnen und definieren können • Ebenfalls Analog zur Iteminformationsfunktion: Wieviel Information bekomme ich durch den Test über die Person? • Testinformationsfunktion = Summe aller Iteminformationsfunktionen alle blauen Kurven addiert = rote Kurve • Sagt die Genauigkeit vorher, mit der man jede Ausprägung der latenten Eigenschaft messen kann 15 hier sieht man, dass der Test in der Mitte differenziert und an den Rändern nicht Maximum sollte zwischen 2 bis -2 liegen Rasch-Modell Standardfehler Klausur: Wie berechnet man den Standardfehler? testcharakteristische Funktion in KTT = Konstante (nur abhängig von Reliabilität) Varianz des Tests ist der gegenläufige Wert der Testinformationskurve SEM = Standardfehler ist die Wurzel aus der Varianz wo Test am besten funktioniert, ist Standardfehler am kleinsten 16 Standardfehler wird breiter, wenn Testinfo breiter -> auch an Rändern mehr Info (kleinerer Fehler an Rändern) Viele Items über Spektrum verteilt -> gute Differenzierung wir messen schlecht, wo wenig Infos vorliegen blau = Testinformationsfunktion rot = Standardfehler (flacher wg. Wurzel) Rasch- Modell Fähigkeitsbestimmung Sinn und Zweck eines Tests: Bestimmung der Ausprägung einer Person auf der latenten Dimension von 5 Items 1 gelöst = -2,2 Fähigkeit 17 • Für jeden Test gibt es eine Reihe von Antwortmustern, die sich gegenseitig ausschließen -> lokale stochastische Unabhängigkeit • bei k Items: 1+k Antworten (0, 1,….,k), k² Antwortmuster, bei 5 Items z.B. 32 • Wir wollen nun wissen, mit welcher Wahrscheinlichkeit eine Person mit einer bestimmten Fähigkeit ein bestimmtes Antwortmuster erreicht • Für jedes Einzelitem: bzw. (1- ( )) • Da lokal stochastisch unabhängig: -> Likelihood-Funktion: Wahrscheinlichkeit eines Antwortmusters für eine Person bei gegebener Fähigkeit und Itemparametern • Eine Likelihood-Funktion für jedes Antwortmuster, die in der Summe auf jeder Stufe von Theta 1 ergeben. 18 • Wahrscheinlichkeit (probability) vs. Likelihood: Wahrscheinlichkeit von Antwort bei gegebener Fähigkeit vs. Likelihood von Fähigkeit bei gegebener Antwort • Maximum Likelihood: Die Fähigkeit, die bei beobachtetem Antwortmuster und gegebenen Itemparametern die höchste Likelihood hat = Schätzung • Fähigkeitsparameter sind unabhängig davon, welche Items richtig beantwortet wurden, sondern nur davon, wie viele. • Likelihoodfunktionen für Antwortmuster mit der gleichen Anzahl korrekter Antworten peaken auf dem gleichen Level 19 Rasch- Modell Modelltest • Itemhomogenität • Anzahl der gelösten Items reicht aus, um Fähigkeitsparameter zu bestimmen -> Erschöpfende Statistiken • Stichprobenunabhängigkeit/Spezifische Objektivität von Item- und Personenparameterschätzungen -> Der Vergleich je zweier Items ist unabhängig davon, welche Personenstichprobe zur Schätzung verwendet wird -> Der Vergleich zweier Personen ist unabhängig davon, welche Itemstichprobe verwendet wurde • Unabhängigkeit der Parameterschätzungen -> Annahmen können getestet werden und müssen nicht als geltend angenommen werden -> Adaptives Testen wird möglich Empirische Modellkontrollen: Unterteilung der Stichprobe anhand eines Merkmals und Vergleich der Itemparameter -> Test der Stichprobenunabhängigkeit/spezifische Objektivität Graphischer Modelltest Nicht exakt, aber anschaulich! Hinreichend große Stichprobe wird in niedrige und hohe Ausprägung geteilt oder in Deutschland/ Schweiz Geschätzte Itemparameter werden eingetragen, Stichprobe 1 & 2 sollten gleich sein Abweichungen von Grade deuten auf Nicht-Gelten des Rasch-Modells hin -> Item kann man aber rausnehmen! 20 21 • Person-Fit-Indizes • Globale Modelltests, z.B. Chi-Quadrat, Bootstrap • Relative Modellvergleiche, z.B. AIC, BIC Partial Credit Model 3 verschiedene Lösungsmöglichkeiten 1 Fähigkeitsdimension: probabilistische Beziehung zum Antwortverhalten teilweise Punkte möglich schwarz: total falsch blau: Teil 1 richtig, Teil 2 falsch -> Teilpunkte, deshalb partial credit rot: total richtig WSK, 1 Punkt zu erhalten ist im mittleren Fähigkeitsbereich am höchsten oder Offenheitsitem „Ich gehe gern auf Partys“ Schwarz: niedrige Offenheit, trifft nie zu, hohe WSK blau: mitteloffen, hin und wieder rot: trifft zu an den Kreuzungen der Verläufe sind die Schwellenpunkte 22 Lokale stochastische Unabhängigkeit Klausur: Wie prüft man die lokale stochastische Unabhängigkeit? lokal: auf best. Stufen der Fähigkeit sollten Items unabhängig sein KTT: Annahme, dass alle Items gleiches latentes Konstrukt messen IRT: dies wird geprüft • Wenn alle Items Indikatoren für das gleiche latente Konstrukt sind, entstehen Korrelationen zwischen Items nur durch Unterschiede in Ausprägung der latenten Dimension • Hält man die Ausprägung/ Varianz konstant (z.B. nur Personen mit IQ von 100), sollten die Korrelationen der Items verschwinden -> Lokale stochastische Unabhängigkeit und Itemhomogenität -> Empirisch prüfbare Annahme (Unterschied zur KTT) • Wahrscheinlichkeit für Lösung zweier Items bei Vorliegen eines Wertes Theta ist also die multiplizierte Einzelwahrscheinlichkeit 23 Item i einfacher, weil .60 > .40; höhere Lösungswsk lokale statistische Unabhängigkeit mit Korrelationsmatrix prüfen: wenn alle Items glich gepolt sind, sollten sich positive Korrelationen ergeben (oder 0, aber selten), aber keine komischen Korrelationsmuster (negativ, 0,positiv) Produkt der 2 Lösungswsk wäre .24 (.60*.40), wenn Items unabhängig aber es ist .33, d.h. in ausgelesener SP abhängig Wenn man die SP aufteilt in hohe (c) und niedrige Fähigkeit (b), sind die Randsummen doch richtig (.30*.10=.03 und .90*.70=.63), dann r=0 -> (b) und (c) sind stochastisch unabhängig, lokale stochastische Unabhängigkeit liegt vor -> bei (a) nicht WSK Item j und i zu lösen WSK Item i zu lösen WSK Item j zu lösen wenn man Fähigkeit konstant hält, ist kein korrelativer Zusammenhang mehr vorhanden -> wenn alle Items gleiches messen, entsteht Korrelation zwischen den Items nur aufgrund der latenten Fähigkeit (und sonst nix) 24 Anwendung: Adaptives Testen Adaptives Testen: mit möglichst wenig Items den höchsten Infogehalt bekommen (sehr vorteilhaft, oft gleich gute Ergebnisse wie bei Durchführung des gesamten Tests) • Zur genauen Bestimmung der Personenparameter sind möglichst viele, möglichst unterschiedlich schwierige Items notwendig -> unökonomisch • Vorteil: die Items, deren Schwierigkeit die der Fähigkeit der Person entsprechen, sind am informativsten, man braucht eigentlich nur die Wenn wir Fähigkeit nicht wissen, fangen wir ca. in der Mitte an; löst er das Item, wird das nächst schwierigere genommen usw. • Tailored (jedes Item wird anhand des vorherigen ausgewählt, Start mit Itemparameter von 0) & branched testing (einzelne Subtests werden ausgewählt) • Beispiel: Adaptives Intelligenzdiagnostikum (AID-2) von Kubinger & Wurst (2000) -> Bei allen Testformen wichtig, extrem gut kalibrierten Itempool zu haben 25 2 Parameter logistisches Modell (Birnbaum-Modell) IC-Funktion 2. Parameter: a = Diskriminationsparameter, wie gut kann das Item differenzieren?/ Trennschärfe immer noch dichotom: ja/ nein oder nicht gelöst/ gelöst Steigung des Items: Ausmaß, in dem ein Item an einer bestimmten Stelle differenziert also unterschiedliche Steigung/ Steilheit Klausur: Skizzieren Sie 2 Items aus 2PL-Modell & Iteminformationskurve. grün trennt nicht so gut, ist aber schwieriger Schwierigkeit schwarz und blau ist gleich blau differenziert mehr 26 2 Parameter logistisches Modell (Birnbaum-Modell) Item-Informationsfunktion 2 Parameter logistisches Modell (Birnbaum-Modell) Item-Response-Funktion und Testinformationsfunktion 27 3-Parameter-logistisches Modell 3. Parameter: Ratewahrscheinlichkeit, hier 1/8 setzt die untere Asymptote Schwierigkeit = c + (1-c)/2 = 0.2 + (1-0.2)/2 = 0.2+0.4 = 0.6 Klausur: 3 Modelle unterscheiden können, für was sind sie gut, z.B. adaptives Testen? Vorlesung 3 Klinische vs. Statistische Urteilsbildung Urteile/ Vorhersagen als Ziel von Diagnostik • Ein Patient berichtet mehrdeutige Symptome – Therapie oder auch (potentiell nebenwirkungslastige) Medikation? • Ältere Patientin berichtet Gedächtnisverlust, der Neuropsychologe soll eine progressive neurologische Erkrankung testen • Bei einem Patienten wird Krebs im Endstadium diagnostiziert, er fragt den Arzt, wie lange er noch zu leben hat -> Optimale Planung und Behandlung hängen von der Beurteilung des Diagnostikers ab 28 Klinische Vorhersage und Akkuratheit • Akkuratheit (über viele Situationen und Targets hinweg) Welcher Beurteiler ist besser? Güte einer Beurteilung in Formel ist die euklidische Distanz enthalten (kürzeste Entfernung zwischen 2 Punkten) Akkuratheit von Vorhersagen • Elevation: Übereinstimmung der durchschnittlichen Vorhersage des Beurteilers mit dem durchschnittlichen Wert der anderen Beurteiler • Differential Elevation: Fähigkeit des Beurteilers, die Abweichungen der Personen vom Mittelwert richtig vorherzusagen/ Sensitivität des Beurteilers für zeitliche Veränderungen • Stereotype accuracy: Fähigkeit des Beurteilers das durchschnittliche Antwortverhalten über alle Personen hinweg vorherzusagen • Differential accuracy: Inwiefern stimmen die Beurteilungen der Unterschiede zwischen Personen für jedes Item mit wahrem Unterschied überein ob wir einschätzen können, ob eine eigentlich ungeeignete Person in einem anderen Bereich doch geeignet ist 29 Empirische Untersuchung klinischer Urteile Brunswiks Linsenmodell links: wahrer Wert, z.B. Alkoholkonsum linke und rechte Seite müssen nicht gleich sein, kann aber Kliniker könnte aus Erfahrung einen Wert anders gewichten als links cues/ Hinweisreize sind nicht immer klar, bei intuitiven schwer fest zu machen Klinische vs. Statistische Vorhersage • Klinische Vorhersage: Informationen werden vom Kliniker selbst interpretiert, er kommt durch Überlegungen zu seiner Entscheidung, „intuitive“ Urteilsbildung -> Fachwissen, Erfahrung, Intuition • Statistische Vorhersage: Entscheidungen werden einzig und allein auf der Basis empirischer Zusammenhänge zwischen Kriterien und dem Outcome getroffen -> automatic and based on empirical relations, z.B. Regressionsgleichung Kombination von Regeln, die an Gruppen gewonnen wurden, auf individuelle Fälle anwenden • Auch Kombination von beidem möglich, jedoch Problem der Übereinstimmung 30 Grundproblem: Was ist besser? zum Vergleich sollten genau die gleichen Daten dem Kliniker + dem Statistikprogramm zur Verfügung gestellt werden das gleiche Kriterium wird vorhergesagt + geschaut, welche Vorhersage besser ist Vergleichsstudien (z.B. Meehl): Statistisches ist klinischem Urteil vorzuziehen, jedoch…. Datenerhebung –und Kombination (Sawyer, 1966) Unterscheidung zwischen Datenerhebung und – kombination: Datenerhebung: Wie wird die Information generiert? Kombination: Wie kommt man aus den Daten zu einem Urteil? mechanical data collection = rules can be prespecified so that no clinical judgment needs to be involved in the procedure clinical data collection (z.B. Interview) statistical (mechanical) combination of data clinical combination 31 1.Pure clinical: Clinically collected data, clinically combined Der Kliniker trifft ein Urteil anhand Information aus z.B. Interview oder persönlicher Beobachtung 2. Trait ratings: Clinically collected data, mechanically combined z. B. Rating von Interviews nach klar festgelegten Kriterien 3. Profile Interpretation: Mechanically collected data, clinically combined z.B. Kliniker benutzt Testscores, um zu Urteil zu kommen, Personaler benutzt Ergebnis von Assessment Center zur Entscheidung 4. Pure statistical: Statistically collected data, mechanically combined Verschiedene Testscores werden in einer Regression zur Vorhersage genutzt 5. Clinical composite: both methods of collection, clinically combined z. B. Testsscores und Interview werden zum Urteil herangezogen 6. Mechanical composite: both methods of collection, mechanically combined z.B. Testscores und Interview werden in Regressionsgleichung überführt Synthese: Die jeweils eine Methode wird als erster Schritt vor die zweite geschaltet 7. Clinical synthesis: Mechanisch gebildetes Urteil wird als Bezugspunkt für klinisches Urteil genutzt (1+3+6, Ich entscheide, ob und wie ich das mechanische Urteil gewichte) 8. Mechanical synthesis: Klinisches Urteil fließt in Mechanisches (Regressionsmodell) ein 32 Vergleich der Methoden Untersuchung von Studien, in denen Verhaltensvorhersage durch klinische und statistische Urteilsbildung verglichen wurde Schlussfolgerungen • Mechanische Modelle der Datenkombination besser, unabhängig von der Erhebungsmethode • Klinische Sammlung von Daten alleine immer schlechter, egal wie kombiniert wird • Effektivste Methode ist die der mechanischen Komposition, Verfügbarkeit klinischer Vorhersage als Information in mechanischer Synthese bringt keine zusätzliche Verbesserung Fazit: Statistische Vorhersage trägt in fast allen Fällen mehr zur Korrektheit des Urteils bei Aber: beste Methode bezieht klinisches Urteil mit ein Meta-Analyse von Aegisdottir (2006) für Klausur wichtig • Zusammenfassung der Clinical vs. Statistical Debatte • Argumente für die klinische Methode (Holt, 1958): Akkuratheit der Prädiktoridentifikation und –integration nur durch Erfahrung und Training möglich • Jedoch: Reviews und Metaanalysen zeigen konsistent den Vorteil statistischer Methoden • Aber kaum Einfluss auf die klinische Praxis 33 • Kliniker sind mit den Befunden nicht vertraut, • “glauben” die Befunde nicht, • glauben, dass die Vergleiche zugunsten der statistischen Vorhersagen verzerrt waren. • Die meisten Kliniker schätzen “interpersonal sensitivity”. Sie sehen in der Anwendung statistischer Form eine Dehumanisierung. • Überzeugung, dass gruppenbasierte Statistiken und nomothetische Regeln nicht auf den Einzelfall angewandt werden können. •Praktiker unterliegen einer konfirmatorischen Verzerrung (Belege für gute Vorhersagen werden besser erinnert als das Scheitern). • Neuer Versuch der Meta-Analyse für die Beratungspsychologie • Vergleich von statistischen Modellen und Urteilen von Mental Health Professionals • Identifikation von Moderatoren der Zusammenhänge (z.B. Setting, Jahr, Validität der Prädiktoren etc.) • Identifikation von 60 Studien mit 173 Effektstärken • AV: Genauigkeit des Urteils (gemessen an z.B. Rückfallrate und tatsächlicher Diagnose) Befundlage wie 50 Jahre zuvor 12% zusätzliche Varianz werden durch statistische Vorhersage aufgeklärt effect size -.12 (relativ klein, aber nicht zu vernachlässigen) Implikationen • Wenn möglich, statistische Methoden zur Vorhersage einbeziehen • Aber: nicht alles statistischen Formeln sind gleich gut • Praktiker sollten sich mit statistischen Methoden beschäftigen und in diesen ausgebildet werden • Und diese auch in ihr Urteil einfließen lassen • Prävalenz – und Basisraten sollten einbezogen werden, um Wahrscheinlichkeiten besser abschätzen zu können • Praktiker sollten ihr eigenes Urteil kritisch hinterfragen Schlussfolgerungen Notwendigkeit statistische Vorhersagemodelle zu entwickeln • Identifikation relevanter Prädiktoren • Erstellung eines Modells 34 • Optimale Regressionsgleichung ermitteln (möglichst gute Vorhersage mit möglichst wenig Prädiktoren) • Ausreichend große, repräsentative Stichprobe • Kreuzvalidierung • Stichproben kombinieren und endgültige Gleichung erstellen Goldberg`s (1970) Daumenregeln für die „klinische“ Praxis 1. Wenn Kriteriumsinformation vorliegt, sammle sie und nutze sie um statistische Methoden der Datenkombination zu entwickeln. (Dies ermöglicht es den Klinikern, ihre Zeit zu nutzen, um ihre Fähigkeiten in der Beobachtung zu entwickeln und somit ihrer angemessenen Rolle als Datensammler gerecht zu werden). 2. Wenn keine Kriteriumsinformation vorliegt (z.B. für die Tendenz sich selbst zu töten), es aber viele klinische Beurteiler mit Erfahrung in der Aufgabe gibt, dann benutze das gemittelte Urteil der erfahrenen Beurteiler (unter der Bedingung, dass die damit verbundenen hohen Kosten gerechtfertigt sind). 3. Wenn keine Kriteriumsinformation vorliegt und es viele klinische Beurteiler mit Erfahrung in der Aufgabe gibt, dann mittle ihre Urteile und suche den Kliniker, der am höchsten mit dem mittleren Urteil übereinstimmt, modelliere sein Urteilsverhalten (durch lineare Regression) und nutze das Modell für die Vorhersage. 4. Wenn keine Kriteriumsinformation vorliegt und es einen klinischen Beurteiler mit Erfahrung in der Aufgabe gibt, dann modelliere sein Urteilsverhalten (durch lineare Regression) und nutze das Modell für die Vorhersage anstelle des Beurteilers (aus ökonomischen Gründen). Vorlesung 4 Vorhersagemodelle: Regression, Moderator- und Suppressoreffekte Multiple Regression • Wir sind an der Analyse von Zusammenhängen interessiert, z.B. welche Variablen sind gute Prädiktoren von Rückfall bei jugendlichen Straftätern? • Identifikation von Prädiktoren • Tragen diese Prädiktoren zusätzlich zu anderen zur Varianzaufklärung bei? -> Inkrementelle Validität Zuwachs der Vorhersagegüte, den ein Prädiktor über einen bereits vorhandenen Prädiktor liefert • Auch abhängig von Korrelation der Prädiktoren untereinander 35 Venn-Diagramm A: z.B. das was Dominanz und Führung allein gemeinsam haben Überschneidungen = Korrelationen • Vorhersage wird besser, wenn Prädiktoren hoch mit Kriterium und niedrig untereinander korrelieren • Jedoch ist auch der umgekehrte Fall möglich, Vorhersage wird besser wenn neuer Prädiktor niedrig mit Kriterium, aber hoch mit anderen Prädiktoren korreliert. Kreuzvalidierungen sind unverzichtbar, wenn aus einem Satz von möglichen Prädiktoren die besten ausgewählt werden (sonst werden Korrelationen erhöht verzerrt). Korrekturformeln liefern realistischere Werte als Kreuzvalidierungen, wenn ein fester Satz von Prädiktoren verwendet wird, aber Auswahl besser als fester Satz. Suppressoreffekte S korreliert nicht mit Kriterium, aber mit Prädiktor bereinigt Prädiktor um kriteriumsirrelevante Varianz (bindet Fehlervarianz) • Kriteriumsirrelevante Varianzanteile werden „unterdrückt“ Bsp: AV = tatsächliches Gewicht UV1 = Gewicht mit Kleidern UV2 = Gewicht der Kleider UV2 abziehen, bindet Störvarianz, die in UV1 ist UV2 hat nix mit AV zu tun (korreliert nicht mit Kriterium) 36 Verschiedene Arten von Suppression Prädiktoren korrelieren miteinander; einer positiv, anderer negativ mit Kriterium -> beide werden verbessert Suppressoreffekte – Beispiele 4. Prädiktor (verbal ability) korrelierte gar nicht mit Kriterium Vorhersage besserte sich aber, wenn man ihn mit rein nimmt -> weil verbal mit anderen Aufg. korreliert, verbal wird rausgerechnet, „reinerer Anteil“ bleibt übrig 37 Besser in Modell 2, wenn Scham & Schuld reingenommen werden Validitätssteigerung durch Supressoreffekte 38 Abhängig von: • Korrelation zwischen Prädiktor und Supressor • Test-Kritieriumsvalidität Es kann gezeigt werden, dass die Supressorvarianz viermal soviel Varianz der Prädiktorvarianz erklären muss wie ein weiterer Prädiktor an der Kriteriumsvarianz, um die gleiche Validitätssteigerung zu erzielen. Moderatoreffekte • Der Zusammenhang zwischen einem Prädiktor und einem Kriterium (bzw. die Validität eines Zusammenhangs) ist nicht für alle Personen gleich (z.B. bei Männern und Frauen verschieden) • Ausprägung einer Moderatorvariable verändert den Zusammenhang zwischen x und y (Im Extremfall zeigt er ihn erst auf) • ≠ Mediator (vermittelt den Zusammenhang zwischen x und y), Zusammenhang verschwindet, wenn ich Mediator rausnehme Moderatoreffekte bei kategorialen Variablen Klausur: Wie würde ich bemerken, ob ein Moderatoreffekt vorliegt? will schauen, ob auf verschiedenen Stufen Zusammenhang verschieden ist • Identifikation von Variablen • Einfachster Fall: Stichprobe unterteilen (Fraktionierung) • Validitätskoeffizienten berechnen und vergleichen, bei signifikanten Unterschieden liegt Moderatoreffekt vor • Wann ist das sinnvoll? Wenn Merkmal natürlich dichotom oder mehrklassig diskret (z.B. Nationalität, Geschlecht, Haarfarbe) • Und wann nicht? Wenn Merkmal kontinuierlich (z.B. IQ, Alter), da Vergrößerung des Stichprobenfehlers (Aufteilung willkürlich, keine mathematische Modellierung möglich) 39 Moderatoreffekte bei kontinuierlichen Variablen Saunders (1956): Aufnahme des Moderators in die Regressionsgleichung: y = a + bx Auf jeder Stufe des Moderators z wird nun eine andere Steigung angenommen y = c + dx + ez + fxz wird Produkt aus fxz (entspricht Interaktionsterm) signifikant -> signifikanter Moderationseffekt Interpretation analog zu Interaktion in Varianzanalysen Rechenbeispiel • Zusammenhang von Altersbild und Lebenszufriedenheit • X = Altersbild, Y = Lebenszufriedenheit, M = Alter Annahme: Je älter, desto stärker Zusammenhang Altersbild + Lebenszufriedenheit 1. Schritt. Neue Variable bilden (Produkt aus Prädiktor + Moderator) vorher zentrieren -> Multikollinearität verringern 40 2. Schritt: Multiple Regression rechnen Beispiele für Moderatoreffekte in der Psychologie 41 Vorlesung 5 Zuordnungs- und Klassifikationsstrategien • Zentrales Ziel von diagnostischen Entscheidungen: Möglichst fehlerfreie Zuordnung zu verschiedenen Kriteriumsklassen (gesund/krank, einstellen/ablehnen, fähig/unfähig….) Wichtige Begriffe & Definitionen • Grund-/ Basisrate = Häufigkeit des Auftretens eines Merkmals in der Population = TP+FN/alle Natürlicher Eignungsquotient Kann selten tatsächlich bestimmt werden, sondern muss geschätzt werden • Selektionsrate = Anzahl der auszuwählenden Personen an der Grundgesamtheit (z.B. offene Stellen) • Validität des Instruments Entscheidungsfehler 2 Fehlerarten: FN (falsch- negativ), die wir nicht entdecken FP (falsch-positiv): die wir als depressiv bezeichnen, obwohl sie es nicht sind 42 1. Sensitivität: Wahrscheinlichkeit, mit der ein vorliegender positiver Zustand auch als solcher erkannt wird (z.B. Anteil der richtig diagnostizierten Kranken an der Gesamtgruppe der Kranken) -> Hoch ausgeprägt, wenn viele RP und wenige FN -> Möglichst kein geeigneter soll abgelehnt werden 2. Spezifität: Wahrscheinlichkeit, mit der ein vorliegender negativer Zustand als solcher erkannt wird (z.B. Anteil der richtig diagnostizierten Gesunden an der Gesamtgruppe der Gesunden) -> Hoch ausgeprägt, wenn viele RN und wenige FP -> Möglichst kein ungeeigneter soll ausgewählt werden 3. Positiver Prädiktionswert: Wahrscheinlichkeit, mit der eine positive Diagnose zutreffend ist (z.B. Anteil der tatsächlich Kranken an allen als krank diagnostizierten Personen) -> Effizienz des Auswahlverfahrens/ Selektiver Eignungsquotient 4. Negativer Prädiktionswert: Wahrscheinlichkeit, mit der eine negative Diagnose zutreffend ist (z.B. Anteil der tatsächlich Gesunden an allen als gesund diagnostizierten Personen) 43 BR, SR und Validität bestimmen den Ausgang der Entscheidungsstrategie Cut-Off erhöhen, wenn es uns ganz wichtig ist keine FP zu haben 44 Klausur: Rechnungen können wenn Prävalenz hoch ist, bessere Vorhersagewerte Massenscreening ungenau, danach spezifische Tests nötig (fiktives) Beispiel Ein Arzt teilt Ihnen mit, dass Sie Brustkrebs haben. Sie wissen: • 1 % der Frauen erkranken an Brustkrebs (Basisrate) • Davon werden 90 % korrekt diagnostiziert (Sensitivität) • 9 % aller gesunden Frauen werden fälschlich diagnostiziert (False Positive) Wie hoch ist die Wahrscheinlichkeit, dass Sie tatsächlich Brustkrebs haben? a) 90% b) 81% c) 10% d) 1% Positiver Prädiktionswert (Anteil der tatsächlich kranken an den als krank diagnostizierten) = TP/(TP+FP) = 9/(9+89) = 9% 45 Entscheidungsregeln Es ist immer wichtig, die Entscheidung im Kontext zu treffen und sich zu verdeutlichen, was Entscheidungsfehler bedeuten. Danach sollten die Entscheidungsregel ausgewählt werden. • Neymann-Pearson Kriterium Analog zur statistischen Hypothesentestung wird die Wahrscheinlichkeit des Alpha-Fehlers angepasst (z.B. α ≤ .05) Beta-Fehler steigt entsprechend an • Minmax- Kriterium Maximaler Zuordnungsfehler über alle Klassen wird möglichst klein gehalten nicht immer machbar • Minimum Loss- Kriterium Über alle Klassen hinweg wird der Zuordnungsfehler minimiert 46 Zuordnungsmethoden Ein Entscheidungsfehler setzt voraus, dass eine Entscheidung statt gefunden hat. Diese kann ebenfalls durch verschiedene Methoden bestimmt werden. • Zugehörigkeitswahrscheinlichkeiten mit Hilfe von Likelihoodquotienten jedes Individuum wird der Klasse zugeordnet, der es am wahrscheinlichsten angehört • Regressionstechniken Einsetzen individueller Pädiktorwerte in die Regressionsformel und Berechung des Kriteriumswertes, Vergleich mit vorher bestimmtem Cut-Off-Wert • Diskriminanzanalyse Kritischer Diskriminationswert, der alle Klassen voneinander trennt wird verglichen mit Ergebnis einer Diskriminanzfunktion, in die individueller Messwert eingeht steckt Regressionsanalyse dahinter, aber einfacher • Ähnlichkeits- oder Distanzmaße Vergleich des individuellen Testprofils mit durchschnittlichem Profil der unterschiedlichen Klassen unsystematischer, gibt keine Trennwerte, nur ob nah oder weit weg Festsetzung von Testtrennwerten • Je weiter man den Cut-Off Richtung Merkmal verschiebt, desto geringer wird der Fehler erster Art -> Positiver Prädiktionswert wird besser • Jedoch vergrößert sich dadurch beta • Grundquote von Bedeutung • ROC-Kurven zur Bestimmung von Sensitivität und Spezifität unabhängig von der Basisrate Verteilung in den jeweiligen Gruppen muss bekannt sein ROC-Kurven Kombinationen von Sensitivität und Spezifität werden für alle möglichen Trennwerte eines Tests abgetragen Verhältnis von Sensitivität (TP Rate) und 1 – Spezifität (FP Rate) 47 Sensitivität auf x1 erhöhen -> 1-Spezifität wird auch höher -> Spezifität geringer Anteil der Kurve sollte möglichst hoch sein ______ Uninformative Kurve/ schlechteste ROC-Kurve: Sensitivität = 1-Spezifität, TP=FP _______ Maximal informative Kurve • Problem: Keine eindeutige Lösung möglich • Selbst wenn „klare“ methodische Berechnung der Trennwerte, müssen Fehlermöglichkeiten bewertet werden • Festlegung von Trennwerten nicht allein wissenschaftlich begründbar, sondern auch Berücksichtigung persönlicher, sozialer, ökonomischer u. praktischer Aspekte • Fairnessaspekte müssen berücksichtigt werden Vorlesung 6 Konstruktvalidität Wie gut misst mein Konstrukt das, was es wirklich messen soll? • Verwendung vieler unterschiedlicher Methoden in der psychologischen Diagnostik • Validität der Erhebung eines Merkmals kann so bestimmt werden • Intendierte Aussagen über das Merkmal, sollen weniger von der Erfassungsmethode als durch Merkmalsausprägung bedingt sein • Messung zweier unterschiedlicher Konstrukte sollte sich unterscheiden -> Nomologisches Netzwerk (Netzwerk von Begriffen) 48 • Ein Maß eines Konstrukts sollte mit anderen Maßen desselben Konstrukts hoch korrelieren (HAWIE und IST, beides misst Intelligenz) • Es sollte mit Maßen anderer Konstrukte in der Höhe der Korrelation der Konstrukte korrelieren. • Eigenschaftsfaktoren (latent, beeinflussen Messung) • Methodenfaktoren (Varianzquelle durch best. Methoden, z.B. Antworttendenzen) • Konvergente Validität • Diskriminante Validität Multitrait-Multimethod-Analyse (Campbell & Fiske, 1959) Literatur: Eid, Nussbeck & Lischetzke, 2006 Vier Aspekte des Validierungsprozesses n. Campbell & Fiske (1959) 1. Zum Nachweis der Validität muss gezeigt werden, dass verschiedene unabhängige Methoden zur Erfassung eines Merkmals konvergieren (das gleiche messen) (konvergente Validität). Im Idealfall kommen verschiedene Methoden zum selben Ergebnis in Bezug auf die Merkmalsausprägung. 2. Eine Messmethode eines Merkmals muss diskriminante Validität aufweisen, das heißt diese Methode darf nicht hoch mit Messmethoden anderer Merkmale zusammenhängen, von denen es hinreichend verschieden sein soll. Wenn ich was anderes messe, soll auch was anderes rauskommen. 3. Jede Messmethode (z. B. Test, Fragebogen) stellt eine Trait-Methoden-Einheit dar, d. h. interindividuelle Unterschiede, die anhand dieser Methode festgestellt werden, spiegeln sowohl Unterschiede wider, die auf Merkmalsunterschiede (Trait-Unterschiede) zurückgeführt werden, als auch Unterschiede, die durch die Messmethode bedingt sind und nichts mit dem Inhalt des Merkmals zu tun haben. Methodenfaktor wird immer auch mit erfasst -> wollen wir nicht! 4. Um die diskriminante Validität und den relativen Anteil von Trait- und Methodenvarianz abschätzen zu können, müssen mehr als ein Merkmal (Trait) und mehr als eine Methode im Validierungsprozess berücksichtigt werden. Faustregel: mind. 3 Traits x 3 Methoden 49 Multitrait-Multimethod-Matrix T1 + 2 + 3 = Traits wie Intelligenz, Depression u. Persönlichkeit jede Eigenschaft wurde mit jeder Methode gemessen Erwartung: diskr. Sollte immer geringer sein als konvergente konvergente: gleiches Trait mit unterschiedl. Methoden gemessen diskr.: gleiche Methode, versch. Traits Kriterien zur Bewertung einer MTMM-Matrix Klausur: Kriterien können Konvergente Validität 1. Die Werte auf der Validitätsdiagonalen sollten signifikant von null verschieden und genügend hoch sein. Diskriminante Validität 2. Die Werte auf der Validitätsdiagonalen sollten höher sein als die anderen Werte in derselben Zeile und Spalte (im selben Block mit konv. vergleichen) des dazugehörigen Heterotrait-Heteromethod Blocks. Dieses Kriterium stellt diskriminante Validität sicher, da die Korrelationen zwischen verschiedenen Traits (gemessen mit zwei verschiedenen Methoden) geringer sein sollten als die Korrelationen für einen Trait (gemessen mit diesen beiden verschiedenen Methoden). 3. Die Monotrait-Heteromethod-Korrelationen (einer Variablen) sollten höher sein als die Heterotrait-Monomethod-Korrelationen (dieser Variablen). Auch dieses Kriterium betrifft vor allem die diskriminante Validität, da die Korrelationen zwischen verschiedenen Traits, wenn sie mit derselben Methode erfasst wurden, geringer sein sollten als die Maße der konvergenten Validität. x darf mit nix höher korrelieren als mit sich selbst, egal, wie es gemessen wird 4. Die Interkorrelationen zwischen verschiedenen Traits sowohl in den Monomethod-Blöcken als auch in den Heteromethod-Blöcken sollten ein ähnliches Muster aufweisen. Dieses Kriterium betrifft die diskriminante Validität, da der Zusammenhang zwischen verschiedenen Traits unter allen Messbedingungen ähnlich sein sollte. Rangreihen sollten bei jeder Methode ähnliches Muster haben 50 Früher hat man geschaut: Wie oft wird das Kriterium der divergenten Validität für Trait x in folgendem Beispiel verletzt? (Beispiele) Einschränkungen der MTMM-Matrix • Schwierig, wenn die Verfahren unterschiedlich reliabel sind (je geringer die Reliabilität, desto geringer die mögliche Korrelation) • Keine statistische Hypothesenprüfung möglich • Subjektive Auswahlkriterien • Erst statistisches Modell erlaubt die Erklärung und Trennung von Methoden- und Traiteinflüssen -> Weiterführung des Ansatzes durch SEM (Konfirmatorische Faktorenanalyse) Gute Tests/ Konstrukte: Hohe Traitladungen (konv. V.) geringe Residuen geringe Methodenvarianz Strukturgleichungsmodelle Klausur: Modelle können 51 Correlated Trait Modell • Beobachtete Variable lässt sich nur in Trait und Residuum zerlegen • Der durch den Traitfaktor erklärte Varianzanteil einer beobachteten Variable ist die konvergente Validität • Residualvariablen repräsentieren unsystematische, für die Trait-Methodeneinheit spezifische Messfehler- und Methodeneinflüsse • Korrelation der Traitfaktoren = diskr. Validität Correlated Trait – Correlated Uniqueness Modell • Korrelationen zwischen den Residuen derselben Methode werden zugelassen • Jedoch keine Trennung von systematischen (Methode) und unsystematischen (Messfehler) Einflüssen möglich • Korrelationen der Residuen zwischen verschiedenen Methoden werden nicht zugelassen 52 Correlated Trait – Uncorrelated Method Modell • Korrelationen der Residuen werden durch Methodenfaktor erklärt – Trennung von Messfehler und Methodeneinfluss möglich • Durch Traitfaktor erklärter Varianzanteil = konvergente Validität • Durch Methodenfaktor erklärter Varianzanteil = Methodenspezifität • Korrelation der Traitfaktoren = diskriminante Validität • Methodeneffekte sind unkorreliert wenn Methode Effekt hat, Einfluss auf Traits Correlated Trait Correlated Method-Modell – meist nicht identifizierbar Zusammensetzung der Varianz Varianz von B3 (Extraversion im Peer-Bericht) setzt sich zusammen aus: • Traitvarianz = .67*.67 = .45 • Methodenvarianz = .27*.27 = .07 • Fehler = 1 – (.45+.07) = .48 53 Correlated Trait Correlated Method (-1) Modell 1 Methodenfaktor raus 5 Parameter müssen nicht geschätzt werden fehlende M1 ist Referenzmethode -> Methode wird als Standardmethode eingesetzt, die anderen mit dieser kontrastiert • Methodeneffekte sind die Residuen bzgl. der Referenzmethode, also der Varianzanteil des Indikators, der nicht durch die Referenzmethode erklärt werden kann. wenn Traits unabhängig + kein Methodenfaktor -> nur konvergente V. wäre ausgeprägt, alle anderen 0 Mehrere Indikatoren pro Trait- Methodeneinheit Skalen in 2 Halbskalen geteilt zur besseren Schätzung eigentlich möchten wir keine Signifikanz haben, wie hier aber zu sehen ist Referenz = Selbstbericht 54 • Traitspezifischer Methodeneinfluss kann untersucht werden, z.B. wirkt sich Fremdbericht bei N anders aus als bei E • Für jede Trait-Methoden-Einheit gibt es einen Methodenfaktor • Korrelationen zwischen Methodenfaktoren zeigen Generalisierbarkeit d. Methodeneffekts Korrelationen mit Selbstbericht als Referenzmethode viel Methodenvarianz 96% Konsistenz = konv. Valid. wenig Konsistenz -> 4% Varianz durch Trait erklärt -> wäre besser, wenn mehr Konsistenz Vorlesung 7 Validitätsgeneralisierung Problem • Validität wichtigstes Gütekriterium eines Tests • Validierung kostspielig und aufwändig -> In jedem Fall Test neu validieren? Oder sind Test-Kriteriumsvaliditäten auch auf andere Situationen übertragbar? Antwort bis in die 70er Jahre: NEIN! (z.B. Ghiselli, 1966) • Hohe Situationsspezifität von Validitätskoeffizienten, trotz gleicher Tests und Kriterien • Keine Validitätsgeneralisierung möglich, Frage nach Kosten-Nutzen des Einsatzes von Tests Lösung • Metaanalyse Schmidt & Hunter (1977) -> Statistische Artefakte führen zu Streuung der Validitätskoeffizienten 55 Beispiel: Test mit wahrer Validität von .45 Kriteriumsreliabilität .70 Selektionsrate = 60% Stichprobe N = 68 -> Nur in 50% der Fälle würde man überhaupt signifikante Validitätskoeffizienten bekommen Meta-analytisches Verfahren der Validitätsgeneralisierung Klausur: Verfahren der Validitätsgeneralisierung können Ziel: Entwicklung eines Verfahrens, mit dem sich bereinigte Validitätskoeffizienten darstellen und vergleichen lassen Hypothese: Kontrolliert man für alle statistischen Artefakte, soll die Streuung der Validitätskoeffizienten Null und die mittlere Validität stabil sein - Sammlung von Validitätskoeffizienten - Standardisierung in Fisher‘s z - Varianzquellen aufgrund verschiedener Fehler eliminieren - Bestimmung der wahren Varianz und Test auf Unterschiedlichkeit der Koeffizienten von Null – Homogenitätstests eigentlich soll Varianz 0 sein, wenn ich alle Artefakte rausgerechnet habe es gibt Tests wie Chi-Quadrat, die das testen können - Bestimmung des wahren Validitätskoeffizienten - Bestimmung des Konfidenzintervalles, wenn wahrer Koeffizient variiert (untere Grenze sollte noch gute Validität aufweisen) z.B. .25 (.18-.30) -> berichten: mit 90% WSK liegt er nicht unter .18 Konfidenzintervall sollte schmal sein wenn 0 im Konfidenzintervall -> schlecht, wollen wir nicht -Tut sie das nicht oder ist die Variabilität noch hoch – Suche nach Moderatoren! Wie wirkt sich eine Korrektur um die mangelnde Reliabilität der Kriterien auf (a) die Variabilität der Validitätskoeffizienten -> geringer (b) die Höhe der über alle Studien gemittelten „wahren“ Validität aus? -> höher 56 77% der Variabilität können durch beobachtbare Artefakte erklärt werden Klausur: Ergebnisse der Metaanalyse wissen und a priori-Verteilung kennen Ergebnisse Metaanalyse Korrelationen SD 90% WSK, dass wahrer Wert der Korr. >.30 ist 57 hinreichende Validitätsgeneralisierung möglich, bei neuen Bereichen aber neue Metaanalysen durchführen a priori-Verteilung/ prior distribution spiegelt gegenwärtige Situation wieder Typische Fehlerquellen Klausur: wissen, welche Artefaktquellen angeschaut werden • Stichprobengröße je kleiner die Stichprobe desto größer der Fehler • Reliabilität von (Prädiktor und) Kriterium je geringer die Reliabilität, desto geringer der maximale Wert, den die Validität erreichen kann • Range restriction durch Auswahl verringert sich der Range der möglichen Ausprägungen im Prädiktor (als auch bei Kriterium) • Qualität der Datenverarbeitung • Kriterienkontamination wie gut wurde Kriterium erfasst (z.B. persönliche Beziehung bei Einschätzung, nur ein Teil der fürs Kriterium relevanten Eigenschaften, etc.) 58 Einfache Minderungskorrektur: wahre Reliabilität .50 = rtc/√.61 .50*√.61= Rel.= .61 Kriteriumsreliabilität .39 MW verändert sich große SP: steilere Kurve ohne 0 SP hat nur Auswirkung auf Streuung, Standardabw. (Verteilung), MW konstant die anderen auch auf MW wenn Reliabilität gering, sinkt auch Validität Probleme bei Meta-Analysen im Allgemeinen • Garbage in – Garbage Out Problem Qualität der Studien, die in die MA eingehen •Äpfel und Birnen Vergleiche Messen die Konstrukte der verschiedenen Studien das gleiche? 59 • Abhängigkeit von Studienergebnissen Wenn verschiedene Kennwerte aus einer Studie berichtet werden • File Drawer Problem Nicht signifikante Studienergebnisse werden nicht veröffentlicht -> MA aufwändig, aber unverzichtbar Vorlesung 8 Nutzenbestimmung hauptsächlich sinnvoll in A&O Ein psychologischer Test ist dann nützlich, wenn… • mit dem Test „nicht unwesentliche oder durch andere Tests ebenso gut bzw. besser messbare Merkmale festgestellt werden" (Hacker & Stapf, 1998, S. 586). d.h. • Der Test ein Merkmal erfasst, dass relevant/bedeutsam und interessant für die Fragestellung ist. • Er dieses Merkmal besser (zuverlässiger, valider und/oder ökonomischer) erfasst als vorherige Tests bzw. kein Test. In der Praxis werden psychologische Tests eingesetzt, weil man sich von ihnen einen Nutzen (meist: Gewinn) erwartet. Bei statistischen institutionellen Entscheidungen wird in der Regel ein maximaler, durchschnittlicher Gewinn (oder ein minimaler Verlust) über viele gleichartige Entscheidungen angestrebt. z.B. Produktivität der Mitarbeiter, Balance von Produktivität und Zufriedenheit, Maximaler Erfolg der Weiterbildung Voraussetzungen: • A priori Wissen des Diagnostikers -> Validität der Verfahren • Annahme des Ausdrucks in äquivalenten Einheiten (Verhältnis-/Kardinalskala) -> ist häufig, aber muss nicht geldwertäquivalent sein (beschwerdefreie Jahre, natürlicher Nullpunkt, sollte nicht 0 werden) Frage: Welchen Nutzen bringt der Einsatz einer bestimmten diagnostischen Vorgehensweise im Vergleich zu der vorher angewandten Strategie? 60 Wie stellt man den Nutzen nun so fest, dass er auch anderen kommuniziert werden kann? • Historisch: Determinationskoeffizient als Maß der aufgeklärten Varianz durch ein Verfahren z.B. r= .20, 4% Varianz werden aufgeklärt -> schlechtes Kriterium Taylor-Russel-Tafeln Problem: • Schlecht verständlich und kommunizierbar. • Auch geringe Varianzaufklärung kann großen Nutzen bedeuten. stattdessen-> Cronbach & Gleser (1965) (Brogden-Cronbach-Gleser-Formel) Formel zur Nutzenbestimmung Nutzen hoch, wenn Validität hoch und/ oder hohe SD und/ oder strikte Auswahl! je höher Validität, umso besser kann ich vorhersagen, weil Merkmal gut erfasst wird bei 1 -> perfekt vorhersagen bei 0 -> sage so gut vorher wie Test -> MW je strikter Auswahl -> je höher MW, Nutzen, Produktivität wenn r, SD oder z =0 -> MW, kein Gewinn Y= Nutzen rxy = Zusammenhang zwischen Prädiktor und Kriterium (Validität) SDy = Standardabweichung des bewerteten Kriteriums, Variation in der die Leistung (Wert) schwanken kann Z = standardisierter Testwert der ausgewählten Bewerber, Cut-Off-Wert, Selektionsrate, z.B. 1,96; je höher, desto strikter Selektion! μy = Beitrag zufällig ausgewählter Bewerber zur Organisation (Basisrate), Achsenabschnitt, MW des durchschn. Bewerbers Nutzen für eine Person und ein Jahr Nettonutzen des gesamten Verfahrens = Multiplikation mit N und der Verweildauer im Unternehmen T Warum wird für Reinigungskraft kein Assessment-Center gemacht, aber für Bankmanager? Wenig individueller Spielraum der Leistungsmöglichkeit -> SD-Variable zentral auch wenn Validität nicht so hoch ist, macht das bei Management Sinn 61 Anwendung der Nutzenbestimmung Unter welchen Bedingungen ist der Nutzen eines Testverfahrens in einer diagnostischen Situation hoch? Und warum? • Hohe Validität des Tests und/oder • Hohe SD des Kriteriums und/oder • Sehr strikte Auswahl (hoher Cut-Off Wert) Was sind Anwendungsbereiche? • Vergleich des Nutzens verschiedener Verfahren • Optimale Grundlage für Festlegung von Selektionskennwerten, so dass Nutzen maximiert wird • Vermittlung und Begründung psychologischer Maßnahmen im Unternehmen Bewertung der Nutzenbestimmung - Linearer Zusammenhang zwischen Prädiktor und Kriterium nicht immer gegeben - Konkrete Ermittlung der (Validitäts)Parameter schwierig - Institutioneller, individueller und gesellschaftlicher Nutzen - Nicht immer sind Geldwertäquivalente zu bestimmen oder sinnvoll - Opportunitätskosten nicht berücksichtigt + Berechnung relativ einfach und auch bei komplexen Tätigkeiten möglich + kann erhebliche Einsparungen leisten 62 Vorlesung 9 Testfairness • Ein Test gilt dann als unfair, wenn er bestimmte Personengruppen systematisch benachteiligt • Vor allem relevant in Auswahlsituationen (Arbeits- oder Studienplatzvergabe, etc…) • Nur dann relevant, wenn überhaupt benachteiligte Personen in der Population (z.B. deutschsprachiger Test nur dann unfair, wenn Nicht-deutsch sprechende Personen potentielle Bewerber) -> Fairness relatives Konzept, wann ein Test fair ist, hängt von Art der betrachteten Fairness (z.B. einzelner Items, der Benennung, der Verwendung), den zugrundeliegenden Handlungsund Entscheidungsaspekten und damit dem betrachteten Fairnessmodell ab • Mangelnde Fairness nicht an Mittelwertsunterschieden ablesbar > Test und Kriterium sollen für alle Indikatoren des selben Konstrukts sein Klausur: Modelle können Wie wird Fairness jeweils definiert? 1. Modell der proportionalen Repräsentation (Identitäts-/ Quotenmodell) • In diesem Modell gilt eine Selektionsmaßnahme dann als fair, wenn sie gewährleistet, dass in der Stichprobe der ausgewählten Bewerber das Verhältnis der miteinander verglichenen Gruppen dieselbe ist wie in der nicht ausgewählten Bewerberpopulation (= proportionale Repräsentation) z.B. 30% Frauen bewerben sich, 70% Männer, dann sollen später auch 30% Frauen, 70% Männer ausgewählt werden • Forderung nach Übereinstimmung der Mittelwerte und Standardabweichungen (sowie weiterer Verteilungskennwerte) für Populationssubgruppen, z.B. durch Verwendung von Normierungen -> Konstruktion gruppenspezifischer, kulturfreier Tests • Problem: Ignoriert die wahre Test-Kriteriumsbeziehung, z.B. dass Frauen eh besser sind in der Schule 63 • Alle möglichen Gruppenunterschiede werden auf mangelnde Fairness des Tests attribuiert, jedoch sind wahre Unterschiede möglich -> Diese zu ignorieren geht zu Lasten der Güte des Verfahrens • Schwierig für Normierung, etc. alle relevanten Subpopulationen einzubeziehen, nicht alle möglichen Unterscheidungsmerkmale auch sinnvoll -> Quotenmodell in der Praxis kaum angewendet 2. Regressionsmodell von Cleary Ein Test ist dann fair, wenn bei seiner Anwendung für keine der miteinander verglichenen Gruppen eine systematische Über- oder Unterschätzung der Kriteriumswerte entsteht -> Regressionsgeraden für alle Gruppen sind identisch, d.h. haben die gleiche Steigung und schneiden die Ordinate an der gleichen Stelle Wie kann man das feststellen? Gruppenzugehörigkeit als Moderator • Bei gleichen Prädiktorwerten unterschiedliche Ergebnisse, je nachdem, welche Regressionsgerade verwendet wird Überprüfung • Erhebung von Test und Kriterium in allen relevanten Gruppen • Berechnen der Regressionsgerade insgesamt und gruppenspezifisch 64 • Vergleich der Konstanten und Regressionskoeffizienten -> Können sich trotz Mittelwertsunterschieden in den Gruppen gleichen -> Keine Unterschiede: Gleichung kann für alle Gruppen verwendet werden, ohne das Gruppen benachteiligt werden -> Unterschiede: Verwendung unterschiedlicher Gleichungen für die verschiedenen Gruppen um Fairness zu gewährleisten sonst über- oder unterschätze ich einzelne Gruppen bei der Auswahl Vorteil zum Quotenmodell: Auswahl findet anhand der geschätzten Kriteriumsleistung/ gemittelten Regressionsgerade statt -> Erfolgsrate der ausgewählten Bewerber wird maximiert -> höherer Nutzen wird erzielt • Qualified individualism: Fairer Prozess für jeden Bewerber, voraussichtlich bessere Kandidaten werden voraussichtlich weniger guten Kandidaten vorgezogen Nachteil: Modell gilt nicht immer erreicht damit keine Diversifizierung in der Auswahl Quote der Bewerber & Fähigen aus jeder Gruppe in der Population nicht berücksichtigt 3. Constant Ratio Model/ Modell konstanter Verhältnisse von Thorndike Vorteil: Modell kann immer hergestellt werden • Das Verhältnis zwischen der Zahl der durch die Testung ausgewählten Bewerber und der Zahl im Kriterium potentiell (d.h. ohne Auswahl!) Erfolgreichen in den miteinander verglichenen Gruppen sollte gleich oder konstant sein • Gefordert wird die Gleichheit der Proportionen für alle Gruppen Ausgewählte: Potentiell Fähige = (RP + FP) : (RP + FN) z.B. 60 Frauen und 40 Männer sind potentiell fähig -> Auswahl 6 Frauen und 4 Männer Verhältnis der geeigneten zu Verhältnis der ausgewählten hier zentral je mehr geeignete ich in einer Gruppe habe , desto mehr darf ich auswählen 65 Nachteile: • i.d.R. mehrere Cut-off Werte, da selten gegeben, dass genau gleiche Regressionsgerade und gleiche Mittelwertsunterschiede in Test und Kriterium -> Nutzen geringer unter ganz seltenen Bedingungen geht 1 Cut-Off-Wert: gleiche Regeressionsgerade, MWUnterschied auf x und y gleich • Natürliche Eignungsquote kann selten ermittelt werden • Durchschnittliche Kriteriumsleistung der ausgewählten Kandidaten reduziert sich -> Quote wichtiger als dass es für jedes Individuum fair ist • Fair gegenüber den Angenommenen der leistungsschwächeren Gruppe, unfair gegenüber Abgelehnten der leistungsstärkeren Gruppe -> Fairness als solche ist nicht zu erreichen „Ein Test, der fair ist mit Blick auf die Selegierten, ist unfair gegenüber den Abgelehnten“ Weitere Fairnessmodelle • Cole (1973) Conditional probability model RP:(RP+FN) Anteil der validen Positiven an allen potentiell Erfolgreichen -> Für alle potentiell erfolgreichen soll die Wahrscheinlichkeit ausgewählt zu werden gleich hoch sein • Linn (1973) Equal probability model RP:(RP+FP) Anteil der validen Positiven an allen Selektierten -> für alle Ausgewählten sollte die Wahrscheinlichkeit des Erfolgs im Kriterium gleich hoch sein 66 Beispielhafter Vergleich der Modelle nicht fair für die Ostdeutschen, werden unterschätzt 67 Vorlesung 10 Veränderungsmessung in der psychologischen Diagnostik Ziele der Veränderungsmessung • Status- vs. Prozessdiagnostik -> Identifikation von Veränderungen in der Ausprägung psychologischer Variablen und Abbildung wahrer Merkmalsveränderungen im zeitlichen Verlauf -> Können das Ergebnis psychologischer Entwicklungs- und Reifungsprozesse sein, aber auch Resultat von Handlungsbemühungen (Interventionen) -> Wirksamkeit psychologischer Maßnahmen und Verstehen von Entwicklung (inter-, intraindividuell, gruppenbezogen) Ursachen von Veränderung oder auch Unreliabilität der Messinstrumente 68 Was ist Veränderung? Veränderung von Ausprägungen über die Zeit • Absolute Konsistenz; intraindividuelle Vergleiche mehrfacher Messungen • Relative Konsistenz; interindividuelle Vergleiche (stabile Rangordnung). Korrelationen zwischen Zeitpunkten. Vergleich der Messwerte einer Person mit dem Populationsmittelwert (kann auch 1 sein, wenn Mittelwerte sich unterscheiden) • Intraindividuelle Profilvergleiche. Erhebung einer Reihe von Variablen (z.B. Eigenschaften), Korrelationen pro Individuum zwischen Zeitpunkten über Variablen (Profilstabilität) Veränderungen von Beziehungen zwischen Konstrukten über die Zeit (z.B. zunehmende Differenzierung), Konstrukt muss nicht zu jeder Zeit dasselbe heißen strukturelle Veränderung von Variablen ->auch wenn wir gleiche Instrumente nutzen, können wir nicht davon ausgehen, dass M2 (2. Zeitpunkt) dasselbe misst hohe Profilstabilität 2 Linien vorstellen als versch. Zeitpunkte wichtig: mehrere Messungen in jeder Situation -> Trennung von Messfehler und wirklichem Wert 69 Veränderung über Situationen Inwiefern ist das Verhalten einer Person von Eigenschaften der Person selbst oder der Situation gekennzeichnet? State -Traitmodelle, latente Modellierung -> Nur dann aussagekräftig, wenn mehrere Messzeitpunkte der selben Situation, um Messfehler und zufällige Schwankungen auszuschließen Latent-State-Trait-Modell: mehrere Messungen hier 3 States, 1 Trait Experience Sampling Studien Messung intraindividueller Variabilität und interindividuelle Unterschiede Reliabler, wenn mehr Tage im Sample 70 • Verhalten in spezifischer Situation ist durch Eigenschaftsmaß schlecht vorherzusagen -> Aggregation von Verhalten über verschiedene Situationen – Verhaltenstendenzen z.B. Verhaltensbeobachtungen, jeden Tag 1 Messung über 30 Tage hinweg -> Aggregate bilden wir können nicht die Messung für einen anderen Tag vorhersagen aus der Messung eines Tages! aber: Verhaltenstendenzen vorhersagen durch Aggregation -> Aggregationsprinzip – aus vielfältigen Informationen wird Eigenschaftsmaß – stabil und gut für langfristige Vorhersagen z.B. Vorhersage von Jobperformance durch Einstellungstest: es sollten mehrere Situationen zur Verhaltenserfassung hinzugezogen werden • Items als Situationen Vier Prinzipien der Stabilität von (Persönlichkeits-) Eigenschaften 1. Für Erstmessungen T1 in vergleichbarem Alter sinkt die Stabilität kontinuierlich mit wachsendem Retestintervall T2 – T1; das Sinken der Stabilität folgt annähernd der Funktion r21 = R*rn wobei r21 die beobachtete Stabilität zwischen T1 und T2, R die kurzfristige Retestreliabilität der Messung, r die wahre (für Unreliabilität korrigierte) Einjahresstabilität und n die Länge des Retestintervalls in Jahren ist. Je näher Messzeitpunkte aneinander sind, desto stabiler. Je länger Zeitraum zwischen dem wir messen, desto geringer Stabilität. 71 2. Für unterschiedliche Persönlichkeitsmerkmale sind die Stabilitäten unterschiedlich hoch. Am stabilsten ist der IQ, mittelhoch stabil sind selbst- und fremdbeurteilte Temperamentseigenschaften, und am wenigsten stabil sind allgemeines Selbstwertgefühl und allgemeine Lebenszufriedenheit 3. Für viele Eigenschaften sinkt die Stabilität mit zunehmend instabiler Umwelt. Je mehr Varianz in der Umwelt, desto instabiler, z.B. Ende der Schule bis Beruf 4. Bei Kindern und Jugendlichen ist die Stabilität über ein Retestintervall fester Länge meist umso geringer, je jünger die untersuchte Stichprobe zum Zeitpunkt T1 ist. Im Erwachsenenalter sind die Ergebnisse unabhängig von T1; im hohen Alter können die Stabilitäten wieder sinken. ab einem gewissen Alter mehr Einfluss auf meine Umwelt, die ich suche Stabilität nimmt mit dem Alter zu IQ-Test ist bei einem 1jährigen nicht aussagekräftig Vergleich 8&9jähirger besser als 1&2jährige 72 Probleme bei der Messung von Veränderungen Einfachste Alternative: Bildung der Differenzwerte zwischen T1 und T2 (indirekte Veränderungsmessung) Probleme: • Messfehler sind per Definition unkorreliert • Messfehlerfreie Werte zu T1 und T2 korrelieren hoch positiv • Normalerweise werden solche Werte aggregiert/ addiert, um die Reliabilität des Maßes zu erhöhen • Hier wird subtrahiert – übrig bleibt der Messfehler -> Subtraktion zweier positiv korrelierter Werte führt zu Herausnehmen der wahren Varianz und Überbetonung des Messfehlers 73 Klausur: Reliabilität von Differenzwerten Probleme bei der Messung von Veränderungen • Reliabilitäts-Validitäts-Dilemma Je höher die Korrelation der Messwerte zu T1 und T2, desto unreliabler wird der Differenzwert Je geringer die Korrelation der Messwerte zu T1 und T2, desto weniger Aussagen über Validität möglich -> Probabilistische Testtheorie -> Messung von states statt traits zur Veränderungsbestimmung -> Paralleltests statt identischer Tests -> Formelkorrektur Reliable Change Index Es wird geprüft, ob die Differenz zweier Testwerte zufällig ist. Hierfür wird die Reliabilität der Messungen berücksichtigt. Der RCI ist analog zu einem z-Wert zu interpretieren. Entspricht der Betrag des RCI dem kritischen z-Wert, oder liegt darüber, ist die Veränderung nicht auf den Messfehler zurückzuführen. Bühner, M. (2011) Einführung in die Test- und Fragebogenkonstruktion (3. Aufl.). 74 X1 = Messwert T1 X2 = Messwert T2 Sdiff = Standardmessfehler der Differenz SE = Standardmessfehler S1 = Standardmessfehler der Normstichprobe bzw. von T1 rW = Retestreliabilität d.h. Messwert/ Differenz ist zu 95% nicht durch Zufall oder Messfehler entstanden Probleme bei der Messung von Veränderungen • Regression zur Mitte - Extreme Messwerte zu T1 rücken zu T2 näher an den Mittelwert der Verteilung heran -> Entsteht durch zufällig extremen Messfehler bei T1, unwahrscheinlich, dass dieser sich bei T2 wiederholt - Umso ausgeprägter, je unreliabler das Verfahren ist 75 • Ausgangswertproblematik - Höhe des Ausgangswertes ist negativ mit möglichem Zuwachs korreliert quasi „Deckeneffekt“ • Physicalism-subjectivism Dilemma - Bedeuten gleiche Änderungen auf unterschiedlichen Skalenabschnitten das Gleiche? Weitere Arten der Veränderungsmessung • Direkte Veränderungsmessung Erfragung der Veränderung zu T1, subjektive Einschätzung des Patienten/Probanden Vorteil: schnell & günstig Problem: - Verzerrung des Vergleichs T1-T2 - Überschätzung der Veränderung durch soziale Erwünschtheit Keine Lösung der Probleme der indirekten VM, eher als eigenständiges Verfahren zu sehen Vorlesung 11 Gutachten Definition psychologisches Gutachten „Psychodiagnostische Gutachten für (meist fachfremde) Dritte als selbständige (in sich geschlossene) zusammenfassende Darstellung der psychodiagnostischen Vorgehensweise, der Befunde und Schlussfolgerungen in Bezug auf eine hinsichtlich einer konkreten Fragestellung zu begutachtenden Person, Institution oder Situation, basierend auf einem der Fragestellung gemäßen, angemessen komplexen diagnostischen Prozess für einen Gutachtenempfänger (Auftraggeber). Mit Hilfe des Gutachtens soll sein Empfänger Entscheidungen in seinem System (seinem diagnostischen Prozess) fundierter treffen können.“ Schmidt (1995) Schmidt-Atzert & Amelang (2012) 76 Wozu psychologische Gutachten? z.B. Gesundheitswesen (psych. Beeinträchtigung, Berentung) z.B. Eignungsdiagnostik: Kann Person x ihr angestrebtes Umschulungsziel „Altenpflegerin“ erreichen und diesen beruf auch später erfolgreich ausführen? z.B Entscheidungshilfen vor Gericht: Sorgerechtsfragen nach elterlicher Scheidung; Rückfallprognosen bei Sexualstraftätern, Glaubhaftigkeit bei Zeugenaussagen z.B. Geschlechtsangleichungen uvm. -> Nutzen fundierter psychologischer Kenntnisse zur Verhaltensbeschreibung, - erklärung und – vorhersage als Entscheidungshilfe, häufig für Fachfremde Ethische Richtlinien der Föderation deutscher Psychologenvereinigungen IV.1. Sorgfaltspflicht Allgemein gilt, dass die Erstellung und Verwendung von Gutachten und Untersuchungsberichten von Psychologen größtmögliche sachliche und wissenschaftliche Fundiertheit, Sorgfalt und Gewissenhaftigkeit erfordert. Gutachten und Untersuchungsberichte sind frist- und formgerecht anzufertigen. Die föderativen Richtlinien für die Erstellung von Gutachten sind zu beachten. IV.2. Transparenz Gutachten und Untersuchungsberichte müssen für die Adressaten inhaltlich nachvollziehbar sein. (z.B. für Gericht, aber nicht für den Angeklagten) IV.3. Einsichtnahme Sind Auftraggeber und Begutachteter nicht identisch, kann das Gutachten bzw. der Untersuchungsbericht nur mit Einwilligung des Auftraggebers den Begutachteten zugänglich gemacht werden. Psychologen sind gehalten, darauf hinzuwirken, dass die Begutachteten ihr Gutachten bzw. den Untersuchungsbericht auf Wunsch einsehen können, sofern für sie kein gesundheitlicher Schaden zu befürchten ist. Falls der Auftrag eine Einsichtnahme von vornherein ausschließt, müssen die Begutachteten vorab davon in Kenntnis gesetzt werden. IV.4. Gefälligkeitsgutachten Gefälligkeitsgutachten sind nicht zulässig, ebenso wenig die Abgabe von Gutachten, die Psychologen durch Dritte ohne eigene Mitwirkung erstellen lassen. IV.5. Stellungnahme zu Gutachten von Kollegen Stellungnahmen zu Gutachten von Kollegen sind zulässig, wobei der Abschnitt B.II.2 (1) dieser Ethischen Richtlinien besonders zu beachten ist. 77 Gesetzliche Rahmenbedingungen Menschenrechte Vertraulichkeitsschutz (1) Verletzung von Privatgeheimnissen „ Wer unbefugt ein fremdes Geheimnis, namentlich ein zum persönlichen Lebensbereich gehörendes Geheimnis oder ein Betriebs- oder Geschäftsgeheimnis, offenbart, das ihm als 1. Arzt… 2. Berufspsychologen mit staatlich anerkannter wissenschaftlicher Abschlussprüfung anvertraut worden oder sonst bekannt geworden ist, wird mit Freiheitsstrafe bis zu einem Jahr oder mit Geldstrafe bestraft.“ wichtige Ausnahme: wenn Patient von Verschwiegenheit entbunden hat Betriebsverfassungsgesetz § 53 StPO: „Zeugnisverweigerungsrecht“: Psycholog/inn/en nein, Psychologische Psychotherapeut/inn/en ja Bedingungen und Voraussetzungen Fragestellung eindeutig formuliert? Psychologe als zuständiger Experte? Genügend Wissen zur Bearbeitung? Bearbeitung rechtlich erlaubt? Bearbeitung ethisch verantwortbar bzw. mit dem eigenen Gewissen zu vertreten? Neutralität? Ist das diagnostische Vorgehen gerechtfertigt (Kosten/Nutzen)? Schränkt die Fragestellung das diagnostische Vorgehen ungerechtfertigt ein? Wird schon eine Intervention vorgeschlagen, die ein bestimmtes Ergebnis impliziert? 78 Der Prozess der Gutachtenerstellung Fragestellung Annahmen Anforderungsprofil (Kompensierbarkeit Stabilität, Veränderbarkeit) Psychologische Fragen (Hypothesen) Untersuchungsplan Durchführung der diagnostischen Untersuchung Darstellung der Ergebnisse Befund: Beantwortung der psychologischen Fragestellung und damit der Hypothesen Vorschläge bzw. Empfehlungen zum weiteren Vorgehen Verhaltensgleichung von Westhoff und Kluck (1998, 2014) Klausur: Gleichung merken Psychologische Variablen: K, E, M, S Nicht psychologische Variablen: U, O Ziele: 1. Sie fasst die Variablen, die bei der Erklärung, Vorhersage und Beeinflussung individuellen Verhaltens wichtig sind zu wenigen Gruppen zusammen und erlaubt somit 2. Eine Strukturierung dieses sonst kaum zu überschaubaren Bereiches 3. Sie unterstützt die Prüfung, ob bei einer Begutachtung alle wichtigen Bereiche bedacht wurden. Sie ist also als Hilfsmittel für das praktische Arbeiten gedacht. Umgebungsvariablen (U) = äu0ere Lebensbedingungen z.B. finanzielle Situation, Wohnsituation, Zeit, Kommunikationsmöglichkeiten Organismusvariable (O) = körperliche Bedingungen z.B. Belastbarkeit, Ernährungsweise, Alter, Krankheiten, Drogenabhängigkeit Kognitive Variable (K) = Leistungsfähigkeit und Inhalte des Wahrnehmens, Lernens und Denkens, z.B. Intelligenz(struktur), Konzentration, Gedächtnis, Kenntnisse, Kreativität, Arbeitsstil 79 Emotionale Variable (E) z.B. emotionale Belastbarkeit, Umgang mit Belastungen, Frustrationen und Gefühlen, emotionale Bindungen Motivationale Variable (M) z.B. Motive, Interessen Werte, Ziele, Erwartungen, Aktivität Soziale Variable (S) z.B. soziale Intelligenz, Einstellungen, Normen/ Stereotype, Pflichten, Einfluss von anderen Auswahl der Variablen nach reproduzierbarem Zusammenhang und praktischer Bedeutsamkeit Erhebungsmethoden (teil)standardisierte diagnostische Verfahren z.B. Fragebögen, strukturierte und standardisierte Interviews, Tests Entscheidungsorientierte Gesprächsführung Verhaltensbeobachtung Sonstige Informationsquellen z.B. Zeugnisse, Akten, Arztberichte Beispiel Befundbogen 80 Mögliche Fehler und deren Minimierung z.B. durch Stereotype, Urteilsheuristiken, ungünstige Informationserhebung, „Milde-„ und „Strenge“Fehler, Interaktionsfehler etc. Fehler und Verzerrungen im Prozess der diagnostischen Begutachtung können schwerwiegende Folgen haben und sollten minimiert werden Erwerb zusätzlichen Wissens (Grundlagenfächer, Diagnostik, spez. Auf Gutachtertätigkeit bezogen) Möglichst klare, strukturierte Ausgangsbedingungen (z.B. Hypothesen, Konkretheit, Erhebung) Verknüpfung von Aussagen Entscheidungsregeln Dokumentation Aufbau des Gutachtens baut sich auf wie Forschungsbericht -> Einzelfallforschung Fragestellung muss von außen gesetzt werden, mir klar sein -> sonst nachfragen Ergebnisbericht: nicht interpretiert, nicht auf Fragestellung bezogen 81 Qualitätsanforderungen an ein Gutachten Wissenschaftliche Fundiertheit: - Bezugnahme auf ein theoretisch begründetes methodisches Vorgehen - Formulierung von psychologischen Fragen, die anhand geeigneter diagnostischer Daten überprüfbar sind - Begründete Auswahl von Verfahren, die eine Prüfung der formulierten psychologische Fragen ermöglichen - Begründete Festlegung von Entscheidungskriterien vor der Datenerhebung - Berücksichtigung aller Ergebnisse, keine selektive Nutzug von Informationen - Ableitung von Schlussfolgerungen unter Beachtung von wissenschaftlich gesicherten Gesetzmäßigkeiten zur Beantwortung der Fragestellung Nachvollziehbarkeit und Transparenz: Es muss nachvollziehbar sein, - welche spezifischen Fragen bzw. Hypothesen untersucht und warum sie geprüft wurden, - zu welchen Ergebnissen der Gutachter gekommen ist und auf welchem Weg er sie ermittelte, - mit welchen Begründungen die gutachterlichen Schlussfolgerungen gezogen worden sind, 82 - auf welchen Informationen die Beuteilungen beruhen. - Die genannten Schritte sind sprachlich so darzustellen, dass der Adressat sie inhaltlich nachvollziehen kann. DGPs -> spezifischere Merkmale für die einzelnen Teile