Der ventrale Strang

Werbung

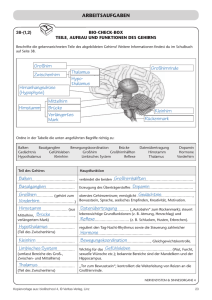

Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer Handout zum Vortrag am 18.04.2011 „Neurobiologische Modelle der Sprache“ I. Einleitung: Zwei Ansätze können bei der wissenschaftlichen Beschäftigung mit neurobiologischen Modellen unterschieden werden: Linguistische Herangehensweise Parameter-basierte Herangehensweise Linguistischer Ansatz: Definition: Unter Linguistik versteht man die wissenschaftliche Beschäftigung mit der menschlichen Sprache als System, ihren Bestandteilen und Einheiten und deren Bedeutung. Sprache kann formal/strukturell analysiert werden, man beschäftigt sich dann mit Phonetik-Phonologie-MorphologieGrammatik - Syntax. In anderen Kernbereichen der Linguistik wird Sprache auch danach untersucht, wie ihr Wortschatz aufgebaut ist (Lexikologie), wie sie Bedeutung vermittelt, d.h. man beschäftigt sich mit Semantik (Lehre von der Konstruktion von Bedeutung aus Wörtern und Kontext) und mit Pragmatik (Lehre der Konstruktion von Bedeutung aus dem Sprachkontext). Bei der linguistischen Herangehensweise wird versucht zu erklären, wo, wann und wie im Gehirn diese komplexen Analysen der linguistischen Komponenten zustande kommen. Es werden also linguistische Konzepte zur Erklärung der während der Sprachverarbeitung im Gehirn ablaufenden neurobiologischen Prozesse herangezogen. ABER: Nach Ansicht von Poeppel und Embick (2005) werden dabei aber zwei fundamentale Probleme ignoriert: Conceptual granularity mismatch: Neurowissenschaftliche und linguistische Sprachforschung verwenden zur Erklärung von Sprache Erklärungseinheiten, die sich in ihrer Detailgenauigkeit wesentlich unterscheiden. Linguistik arbeitet mit sehr feinkörnigen Erklärungseinheiten und unter der Annahme genauer Verrechnungsschritte, während man in den Neurowissenschaften eher breitere Erklärungskonzepte verwendet. 1 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer Ontological immensurability : Die Grundelemente der linguistischen Theorie können nicht soweit reduziert oder angepasst werden, dass sie den biologischen Grundelementen der Neurowissenschaften entsprechen würden. Konsequenz: Der Versuch, die tatsächlichen neurobiologischen Abläufe im Gehirn bei Sprachwahrnehmung und –produktion mit Hilfe von linguistischen Konzepten zu verstehen, kann in die Irre führen. Denn die Maschinerie, mit der linguistische Phänomene erklärt werden, steht in keiner Beziehung zu den im Gehirn ablaufenden Prozessen und den dabei eine Rollen spielenden Einheiten. Parameter-basierter Ansatz: Oszillo- und Spektrogramm zeigen deutlich: Sprache ist ein akustisches Signal mit physikalischen Parametern wie Frequenz, Energie/Amplitude etc., das sich über die Zeit hin entwickelt. Dieses Signal wird in unserem Gehirn in neuronale Aktivität umgewandelt. Neuronale Aktivität kann sich innerhalb von spezialisierten Neuronenpopulationen bis hin zu über das Gehirn verteilten, grossräumigen neuronalen Netzwerken entfalten, innerhalb derer die Neurone gleichzeitig oder nacheinander in bestimmten Frequenzbändern aktiv werden (Synchronisation und Desynchronisation). Neuronale Aktivität besitzt somit die Dimensionen Raum und Zeit. Beim parameter-basierten Ansatz wird versucht, die Prozessierung des Sprachinputs und –ouputs im Gehirn als das Ergebnis des koordinierten Zusammenwirkens verschiedener Gehirnareale zu verstehen, die auf Grund ihrer neurobiologischen und elektrophysiologischen Spezialisierung spezifische Funktionen bei der Sprachverarbeitung wahrnehmen. 2 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer 3 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer II. Das dynamic dual pathway model von Friederici et al. (2002, 2004) Linguistischer Ansatz Methoden: EEG, bzw. ERP-Ableitung für Bestimmung der drei Verarbeitungsphasen; Verortung der dafür zuständigen Gehirnareale mit bildgebenden Verfahren (PET und fMRI). Erklärungsebene: auditorische Satzverarbeitung. Bei dem neurokognitiven Modell von Friederici et al. handelt es sich um ein bilaterales temporofrontales Netzwerk. Die temporalen Areale haben dabei eher die Aufgabe der Identifikation auf der Ebene Phonetik, Semantik und Syntax, die frontalen Areale eher die Aufgabe der Erfassung von syntaktischen und semantischen Beziehungen. Der linke Temporalkortex unterstützt dabei die Prozesse, die die phonetischen, lexikalischen und strukturellen Elemente identifizieren. Der linke Frontalcortex ist zuständig für die Sequenzierung und die Formation der phonetischen, strukturellen und thematischen Beziehungen. ⇒ Segmentelle, lexikalische und syntaktische Informationen und Beziehungen werden links verarbeitet. Im rechten Temporallappen findet die Identifikation der prosodischen Parameter statt und der rechte Frontalkortex ist zuständig für die Verarbeitung der Satzmelodie. ⇒ Suprasegmentelle Informationen auf Satzebene wie Akzentuierung, Tonhöhe, Pausen etc. werden rechts verarbeitet. Linke und rechte temporo-frontale Areale interagieren während der Satzverarbeitung dynamisch miteinander (Interaktion von prosodischer und syntaktischer Information) über das hintere Drittel des Corpus Callosum, jedoch ist der zeitliche Ablauf dieser Interaktion noch unklar. 4 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer Auditorische & phonologische Basisprozesse => Bilateral - primärer auditorischer Cortex. Syntaktisches Netzwerk => Links - STG anterior – Frontales Operculum – unterer Teil des Gyrus frontalis Inferior BA 44 (Broca Area). Semantische Netzwerk => Links - posteriorer und mittlerer STG– MTG – BA 45 im IFG (=Gyrus frontalis inferior). Prosodisches Netzwerk => Rechts Frontales Operculum und Areale auf dem STG. Das Modell von Friederici et al. postuliert drei Phasen der auditorischen Satzverarbeitung in den linken temporo-frontalen Gebieten. Die drei Zeitphasen wurden auf der Basis auf elektrophysiologischen Daten definiert, bzw. der Aufzeichnung und Analyse verschiedener Event-Related-Potentials (ERP)Ableitungen bei verschiedenen semantischen und syntaktischen Regelverletzungen. ERP’s und ihre Bedeutung: Syntax: ELAN: Early-Left-Anterior-Negativity im Zeitfenster von 150-200 ms – sprachspezifisch - korreliert mit schnell entdeckbaren Fehlern der Wortkategorie, dominant im Temporal- und Frontalkortex der LH, obwohl die homologen RH-Areale vermutlich auch involviert sind. LAN: Left-Anterior-Negativity im Zeitfenster von 200-500ms – sprachspezifisch - korreliert mit morphosyntaktischen Fehlern. P600: Late-Central-Positivity im Zeitfenster 600+ ms – tritt sowohl nach semantischen wie syntaktischen Regelverletzungen auf - korreliert mit einem späten Integrationsprozess 5 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer Semantik: N400: Centro-Parietal-Negativity 400 ms nach Word-Onset – korreliert mit Wörtern, die semantisch nicht in den vorausgehenden Kontext eingeordnet werden können – kann sich aber auch auf eher allgemeinere Aspekte der Bedeutung als den lexikalisch-semantischen Aspekt beziehen, denn N400Effekte finden sich auch in nicht-linguistischen Kontexten. Die drei aus den mit Regelverletzungsparadigmen gewonnen Zeitphasen der auditorischen Satzverarbeitung Phase 0: Zeitfenster 0 – 100 ms: Erste akustische Analyse – Identifikation der Phoneme – Identifikation der Wortform. Phase 1: Zeitfenster von 100-300 m: Auf der Basis der im Satz vorhandenen, verschiedenen Wortkategorien findet in einem autonomen Prozess eine erste syntaktische Strukturanalyse des gehörten Satzes statt. Phase 2: In dem Zeitfenster von 300-500 ms finden die für die thematische Rollenzuordnung notwendigen lexikalisch-semantischen und morphosyntaktischen Prozesse statt. Die Verarbeitung syntaktischer und semantischer Informationen erfolgt auf dieser Stufe parallel und voneinander unabhängig. 6 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer ⇒ Achtung: Die Prozesse in Phase 1 sind immer unabhängig von Phase 2. Jedoch können die Prozesse in Phase 2 durch Phase 1 insofern beeinflusst werden, dass die lexikalische Integration eines Elementes in den Kontext davon abhängt, ob es zuvor in Phase 1 syntaktisch lizenziert/zugelassen worden ist. Phase 3: Im Zeitfenster von 500-1000 ms kommt es schliesslich zur Integration oder bei zweideutigen oder falsch strukturierten Sätzen zu Reanalysen/Reparatur der verschiedenen Informationstypen. Das Modell von Friederici et al. nimmt damit sowohl serielle (1.Phase), wie parallele Verarbeitung (2. Phase) und Interaktion der verschiedenen Verarbeitungsstufen (Einfluss von 1. Phase auf die 2. Phase, sowie Integration/Reanalyse sämtlicher Informationen aus Phase 1 und Phase 2 in der 3. Phase) an . Synopsis des Modells von Friederici et al. 7 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer III. Das Asymmetric Sampling in Time (AST) Hypothese von D. Poeppel (2003) Parameter-basierter Ansatz Methoden: EGG und bildgebende Verfahren Ebene: Prozessierung des primären Sprachinputs Aus verschiedenen Beobachtungen aus der kognitiven Neurowissenschaft und der Psychophysik leitet Poeppel vier verschiedene Prämissen für seine „Asymmetric-Sampling in Time-Hypothese „ ab: 1. Die funktionale Anatomie der Sprachverarbeitung verweist auf einen bilaterale Prozessierung des primären Sprachinputs. 2. Die linke Hemisphäre ist besonders befähigt, schnell wechselnde Signale zu verarbeiten. 3. Verschiedene Zeitskalen sind bei der Verarbeitung des Sprachsignals relevant, denn das Sprachsignal enthält sowohl segmentelle wie auch suprasegmentelle Informationen und diese müssen adäquat verarbeitet werden 4. Wir empfinden Zeit intuitiv als Fluss und auch die Physik beschreibt Zeit als kontinuierliche Variable. Elektrophysiologische und psychophysische Studien aber zeigen, dass das Gehirn Zeit nicht als Fluss, sondern in einzelnen zeitlich definierten Chunks und damit nicht kontinuierlich verarbeitet. Zeitliche Integrationsfenster bieten somit den besten logistischen Rahmen, um sich in der Zeit entwickelnde Information zu quantifizieren. Die Theorie: Zwischen den primären auditorischen Cortices der beiden Hemisphären besteht kein Unterschied – beide besitzen neuronale Populationen mit Zeitkonstanten zwischen 25 und 200 ms. Der linke Gyrus temporalis superior posterior allerdings besitzt eine Präferenz zur Verarbeitung von Information aus kurzen zeitlichen Integrationsfenstern (20-50 ms => Frequenz von 40 Hz Gamma-Band). Analysen, die hohe zeitliche Auflösung erfordern, wie z.B. Formantenübergänge, er- folgen links. Der rechte Gyrus temporalis superior posterior präferiert die Verarbeitung der Information aus langen zeitlichen Integrationsfenstern (150-250ms => Frequenz von 4-5 Hz Theta-Band). Analysen mit hoher spektraler Auflösung wie z.B. Satzmelodie erfolgen rechts. 8 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer Es besteht ein enger Zusammenhang zwischen den beiden zeitlichen Integrationsfenstern der linken und der rechten Hemisphäre und den neuronalen Oszillationen. Die Integrationsfenster reflektieren neuronale Oszillationen, bzw. die beiden verschiedenen Samplingrates für das Sprachsignal im Gehirn. Damit kann unser Gehirn gleichzeitig beide für die Sprachaufschlüsslung wichtigen Informationsebenen (segmentell und syllabisch) verarbeiten. Die Verarbeitung des primären Sprachsignals erfolgt bilateral. Auf dieser frühen Ebene der Verarbeitung besteht noch keine anatomische Lateralisierung der Sprachverarbeitung, jedoch eine funktionale Asymmetrie, bzw. eine zeitliche Asymmetrie der präferiert verarbeiteten Einheiten des Sprachsignals. Jedoch nur die primäre Analyse des Sprachsignals erfolgt bilateral. Die weitere Verarbeitung von Sprache ist dann grösstenteils in der sprachdominanten linken Hemisphäre angesiedelt. 9 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer Ein Modell der Sprachverarbeitung, das in seinen frühen Phasen die AST-Hypothese von Poeppel integriert, ist das : IV. Das Dual Stream Model der Sprachverarbeitung von Hickok und Poeppel (2004, 2007 & 2009) Parameter-basierter Ansatz Methoden: Bildgebung und Läsionsstudien Erklärungsebene: Sprachwahrnehmung und Spracherkennung auf kortikaler Ebene Einerseits um die Auswirkungen verschiedener Läsionen auf die Sprachverarbeitung und – produktion erklären zu können, andererseits in Analogie zum visuellen Verarbeitungssystem, wo man einen dorsalen und ventralen Strang unterscheidet, nehmen Hickok und Poeppel auch für die Sprachverarbeitung zwei Verarbeitungsstränge an. Der ventrale Strang ist weitgehend bilateral angelegt und seine Aufgabe besteht in der Spracherkennung, d.h. dem Prozess, durch den das Sprachsignal mit der lexikalischen Repräsentation/der semantischen und konzeptuellen Bedeutung zusammenzugebracht wird, d.h. mapping sound to meaning. Der dorsale Strang ist linksdominant und er erfüllt primär die Funktion der Sprachwahrnehmung, indem er die akustische Sprachsignale mit artikulatorischen Netzwerken im Frontalkortex verbindet. 10 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer Die ersten Verarbeitungsschritte für beide Pfade erfolgen bilateral und parallel und sind z.T. sogar redundant. Die teilweise Redundanz dieser spektralen und temporalen Signale bewirkt, dass wir auch Sprache oft auch dann noch verstehen können, wenn das Sprachsignal schlecht ist. 1. Spektrotemporale Analyse: Eine Vorverarbeitung des auditorischen Inputs und damit des Sprachsignals findet schon in der dem auditorischen Kortex vorgelagerten Hörbahn statt. Als einer der ersten kortikalen Verarbeitungsschritte erfolgt dann in den dem primären auditorischen Areal nachgelagerten dorsalen Gyri temporales superiores die spektrotemporale Analyse des Sprachsignals. Die Integration der Sprachinformation erfolgt dabei über zwei distinkte Zeitskalen – einem kurzen Informationsintegrationsfenster mit einer Länge von 24-50 ms Gammafrequenz, d.h. der Sampling-Rate für segmentale Representationen, und einem langen Integrationsfenster mit einer Länge von 150-300ms Thetafrequenz , d.h. der Sampling-Rate für syllabische Repräsentationen. Während die linke Hemisphäre eher weniger selektiv bei der Verarbeitung dieser beiden Sprachsignale zu sein scheint, ist der neuronale Mechanismus zur Verarbeitung des Sprachsignals über lange Integrationsfenster eindeutig rechtsdominant. Beide Hemisphären interagieren auf dieser Verarbeitungsstufe miteinander. 2. Phonologische Verarbeitung: In den mittleren bis posterioren Sulci temporales superiores erfolgt dann die weitere Verarbeitung des Sprachsignales auf phonologischer Ebene, d.h. die Ergebnisse der spektralen und temporalen Analyse werden mit in den STS gespeicherten phonologischen Codes abgeglichen. 3. Nach diesem Verarbeitungsschritt erfolgt die weitere Prozessierung des Sprachinputs in zwei getrennten Bahnen. Der ventrale Strang In diesem Stadium haben wir jetzt phonologische Codes, aber das eigentliche Ziel der Sprachverarbeitung ist ja, diese phonologischen Codes mit Bedeutung zu füllen. Die Verbindung dieses phonologischen Codes mit höher repräsentierten lexikalischer, semantischer und konzeptioneller Information erfolgt über den ventralen Strang. Die Verarbeitung der Sprachinformation erfolgt im ventralen Strang grösstenteils bilateral und parallel. Man nimmt an, dass es in jeder der beiden Hemisphäre zumindest einen Verarbeitungspfad gibt, der Sprachsignale soweit verarbeiten kann, dass sie mit dem Inhalt eines mentalen Lexikons abgeglichen werden können. Das lexikalische Interface bilden die Regionen des posterioren Gyrus temporalis medialis und des posterioren Sulcus inferior bilateral. Die Aufgabe dieses Interface ist das Mapping der über den ganzen Kortex verteilten semantischer und konzeptueller Repräsentationen mit dem Output aus den 11 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer STS. Auf dieser Verarbeitungsebene scheint eine leichte Dominanz der linken Hemisphäre vorzuliegen. Der dorsale Strang: Die Notwendigkeit eines ventralen Stranges mit der Funktion, den auditorisch vermittelten Sprachinput mit über den Kortex verteilten Repräsentation von Bedeutung und Konzepten in Bezug zu bringen, leuchtet intuitiv ein. Warum es aber für die Sprachverarbeitung, d.h. für das Sprachverstehen, nicht für die Sprachproduktion, auch einen dorsalen Strang braucht, der den Sprachinput mit artikulatorischen Repräsentation verbindet, ist nicht ganz so offensichtlich. Folgende Gründe sprechen für eine auditorisch-motorische Integration des Sprachsignals: 1. Beobachtung, dass der gesprochene Laut keine 1:1-Entsprechung mit dem wahrgenommen Sprachsignal hat. Der Buchstabe /d/ wird anders gehört, wenn danach ein /a/ folgt, als wenn darauf ein /i/ kommt. Die Artikulation des /d/ ist immer dieselbe, die Wahrnehmung nicht. Die Motortheorie der Sprachverarbeitung (Liberman, 1985) leitete aus dieser – übrigens falschen Beobachtung – ab, dass Sprachlaute in ihrer invarianten, d.h. motorischen Form im Gehirn gespeichert sein müssen. 2. Spracherwerb ist primär eine motorische Aufgabe. Das kleine Kind hört gesprochene Sprache und muss diese so akkurat als möglich in Bewegungen des Vokaltraktes umsetzen, um diese Laute selbst zu artikulieren zu können. Es braucht daher neuronale Mechanismen, die Sprachlaute kodieren und diese sensorischen Codes nützen können, um selbst diese Sprachlaute zu produzieren. 3. Auch ein erwachsener Sprecher ist auf das Feedback der auditorisch-motorischen Integrationsschleife angewiesen, wenn er sauber artikuliert sprechen will. Dass auditorischer Input auch bei der Sprachproduktion notwendig ist, zeigt sich daran, dass die Sprache von Menschen, die ertauben, längerfristig unverständlicher wird und die Fähigkeit, neue Wörter zu lernen, bzw. zu artikulieren, vermindert ist. Im Modell von Hickok und Poeppel gibt es zwei verschiedene Ebenen der auditorischmotorischen Interaktion: einmal auf Ebene der der einzelnen Sprachsegmente = Erwerb und Aufrechterhaltung rudimentärer artikulatorischer Fähigkeiten wie auch auf der Ebene der Sequenzierung der Sprachsegmente = Erwerb eines neuen Wortes führt zu einer sensorischen Repräsentation dieses Wortes in der Form eines Codes seiner Segmente und Silben. Diese kann wiederum dazu benutzt werden in einer Feedfor12 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer ward-Schlaufe die Artikulation des neuen Wortes zu ermöglichen, ebenso kann gleichzeitig eine online Feedback-Kontrolle des gesprochenen Wortes erfolgen. Bildgebende Studien verweisen auf ein ganzes Netzwerk von Regionen ausgehend vom posterioren STS bilateral. Danach sind aber ausschliesslich nur noch Regionen auf der linken Hemisphäre involviert und zwar eine Grenzregion im posterioren Übergangsgebiet der Sylvischen Fissur und Parietal-Frontalkortex, die Area Spt (sie liegt innerhalb des Planum temporale, in der Faltung der Sylvischen Fissur verborgen) sowie weitere Gebiete im Frontalkortex. Die linke Area Spt/das sylvisch-parietale-temporale Areal hat die Funktion eines sensorischmotorischen Interfaces, dem die Transformation von sensorischem zu motorischem Code (und zurück beim Sprechakt) obliegt. Die Area Spt ist zwar funktional eng mit den Spracharealen des Frontalkortex verbunden, jedoch ist sie nicht rein sprachspezifisch, sondern zeigt bei fMRI-Studien ebenfalls Aktivierungen beim Hören und verdeckten Produzieren von Summen. Läsionen im Bereich der Area Spt führen zu Symptomen wie bei der Conduction Aphasia, das Sprachverständnis jedoch bleibt intakt. Hickok (2009) interpretiert die Funktion dieses Gebietes als ein Areal zur sensorischmotorischen Integration für die Bewegungen des Vokaltraktes. 13 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer Synopsis des Dual-Stream Modelles von Hickok und Poeppel Auffallend am Modell von Hickok und Poeppel ist nicht nur das auditorische-motorische Interface, die Area Spt, die so in keinem anderen Modell postuliert wird, sondern auch der Umstand, dass die ganze Sprachverarbeitung nur im Kortex erfolgt. Subkortikale Gebiete wie z.B. die Basalganglien und der Thalamus oder auch das Cerebellum spielen in ihrem Modell keine Rolle. Das ist erstaunlich, gerade weil die beiden Forscher so sehr betonen, dass zur Sprachverarbeitung die Anbindung an artikulatorische, bzw. motorische Gebiete im Frontalkortex wichtig ist. Cerebellum und subkortikalen Regionen wie die Basalganglien jedoch spielen bei der Steuerung und Koordination von Bewegung eine sehr wichtige Rolle 14 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer III. Das Integrative Speech Processing Framework von Kotz und Schwartze (2010) Parameter-basierter Ansatz Ebene: Sprachverarbeitung und Sprachproduktion. Die Autoren betonen: Sprache transportiert Energiemuster über die Zeit. Darum wird ein Interface für die Integration der Outputs der Systeme für die auditorische und temporale Verarbeitung benötigt. Hier bieten sich die Motorsysteme an, da effiziente Bewegung ein akkurates Timing und eine hohe zeitliche Koordination der einzelnen Muskelgruppen voraussetzt. Besonders vom Cerebellum wie auch von den Basalganglien ist bekannt, dass sie nicht nur bei motorischen Aufgaben, sondern auch bei kognitiven Leistungen die Funktion von Schrittmachern erfüllen können. Die Sprachverarbeitung erfolgt folgendermassen: Das Sprachsignal gelangt über die Hörbahn mit dem Thalamus als Relais in den primären auditorischen Kortex im Temporalkortex und in das Cerebellum. Bei der weiteren Verarbeitung des Sprachsignals werden dann zwei parallele auditorische Verarbeitungspfade unterschieden: 1. Die prä-attentive Encodierung der ereignisbasierten temporalen Struktur erfolgt im Cerebellum, das über den Thalamus mit dem Frontalkortex verbunden ist. 2. Im temporalen Kortex erfolgt die Verarbeitung des Sprachsignals bis zum Abruf der Gedächtnisrepräsentation weitgehend so, wie das für den ventralen Strang des Modells von Hickok und Poeppel dargestellt wurde. Der Temporalkortex projiziert in den Frontalkortex. . 15 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer Ein System für die Sprachwahrnehmung Die preSMA bindet die temporale Struktur, erhält Input vom Cerebellum und schickt Informationen an den dorsolateralen Präfrontalkortex, wo die Gedächtnisrepräsentationen und die temporalen Informationen integriert werden. Zusätzlich evaluieren die durch Aufmerksamkeit modulierbaren Basalganglien die temporalen Beziehungen und unterstützen die Extraktion regelmässiger Zeitmuster. Ebenfalls sind die Basalganglien zuständig für Re-Analyse und Re-Sequenzierung, wann immer die temporale Struktur eines Stimulus unvertraut oder inkongruent ist. Sie erhalten dazu Input vom preSMA und dem Frontalkortex, in den sie über den Thalamus wieder zurückprojizieren. Thalamus und Cerebellum sind aber auch in direktem Austausch mit den Basalganglien Ein System für die Sprachproduktion Gedächtnisrepräsentation werden vom Temporalkortex zum Frontalkortex übermittelt, wo sie auf eine zeitliche Ereignisstruktur abgebildet werden, die vom preSMA zusammen mit dem Cerebellum und den Basalganglien generiert wurde. Cerebellum und Basalganglien übernehmen damit bei der Planung der Sprachproduktion die Funktion von Schrittmachern. Das Cerebellum ist zudem bei der Silbenformung beteiligt. In Interaktion miteinander benutzen das SMAproper, der Prämotorkortex und der primäre Motorkortex diese temporale Basisstruktur, um die Artikulation zu steuern. 16 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer Die Bedeutung des Thalamus Das eingehende auditorische Sprachsignal wird immer - gleichgültig ob es dann in den primären auditorischen Kortex oder in das Cerebellum weitergeleitet wird - vom Thalamus vorverarbeitet. Der Thalamus reagiert auf Input entweder in einem tonischen Modus, der primär die Funktion hat, die Linearität des Signals aufrechtzuhalten, oder mit Salven. Dieser Salvenmodus hat quasi die Funktion eines Wecksignales für den Frontalkortex, die Salven an den Frontalkortex erfolgen mit denselben temporalen Eigenschaften wie die des eingehenden Stimulus, was die Entdeckung des Signals verbessert. Es wird spekuliert, dass dieses Salven-Feuer die salienten Wechseln des Energielevels des Inputs gleichsam kennzeichnen kann, z.B. könnte es beim Sprachsignal On- und Off-Sets des akustischen Signals und andere prägnante Merkmale markieren. Solche thalamischen Salven wären damit in der Lage, die zeitlichen Beziehungen zwischen verschiedenen Ereignissen für die weitere Verarbeitung im Kortex vermitteln und auch verstärken. Im Cerebellum wird das Sprachsignal nach seiner ereignisbasierten temporalen Struktur prozessiert und an den Thalamus zur Übertragung an den Frontalkortex weitergeleitet. Enkodiert der Thalamus diesen Input als Salvenfeuer, kann er die zeitlichen Marker der Ereignisse präzis an den Frontalkortex übermitteln. Parallel erhält er via der auditorischen Bahn eine linearere und kontinuierliche Repräsentation des Sprachsignals, die der Thalamus im tonischen Modus weiterleitet, der detaillierte spektrotemporale Struktur des Sprachsignals bewahren kann. 17 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer Interessant in diesem Kontext ist nun die Tatsache, dass dieses Salvenfeuer des Thalamus durch Interspikes-Intervalle von ca. 100 ms Dauer und der tonische Modus durch Intervalle von 30ms Dauer charakterisiert ist. Diese Frequenzen entsprechen ungefähr der Sampling-Rate der zeitlichen Integrationsfenster der beiden Hemisphären. Es macht damit fast den Anschein, als ob zumindest das kürzere der beiden zeitlichen Integrationsfenster aus dem AST-Modell dadurch, wie der Thalamus InformationsChunks im tonischen Modus zusammenpackt, bestimmt wird. Darstellung des tonischen Modus (a) oder des Salvenmodus (b) von Zellen des nucleus geniculatus lateralis des Thalamus einer Katze bei visueller Stimulation 18 Seminar: Neurokognition von Hören und Sprache Angela M. Müller Dozent: Dr. M. Meyer Literatur Boemio, A., Fromm, S., Braun, A., & Poeppel, D. (2005). Hierarchical and asymmetric temporal sensitivity in human auditory cortices. Nature Neuroscience, 8, 389–395. (nur für das Referat benutzt) Friederici, A.D. (2002) Towards a neural basis of auditory sentence processing. Trends in cognitive Science, 6, 78–84. Friederici, A.D., & Alter, K. (2004). Lateralization of auditory language functions: A dynamic dual pathway model. Brain and Language, 89, 267–276. Friederici, A.D., von Cramon, D.Y., &. Kotz, S.A. (2007). Role of the Corpus Callosum in Speech Comprehension: Interfacing Syntax and Prosody. Neuron, 53, 135–145. Hickok, G. (2009b). The functional neuroanatomy of language. Physics of Life Reviews, 6, 121–143. Hickok, G., & Poeppel, D. (2004). Dorsal and ventral streams: A framework for understanding aspects of the functional anatomy of language. Cognition, 92, 67–99. Hickok G., & Poeppel D. (2007). The cortical organization of speech processing. Nature Review Neuroscience, 8, 393–402. Kotz, S.A., & Schwartze, M. (2010). Cortical speech processing unplugged: a timely subcorticocortical framework. Trends in Cognitive Sciences 14, 392–399. Poeppel , D. (2003). The analysis of speech in different temporal integration windows: Cerebral lateralization as “asymmetric sampling in time”. Speech Communication,41, 245–55. Poeppel, D. & Embick, D. (2005). The relation between linguistics and neuroscience. In Twenty-first century psycholinguistics: four cornerstones (ed. A. Cutler), pp. 103–120. Hillsdale, NJ: Lawrence Erlbaum Associates, Inc. 19