02 Testtheorie

Werbung

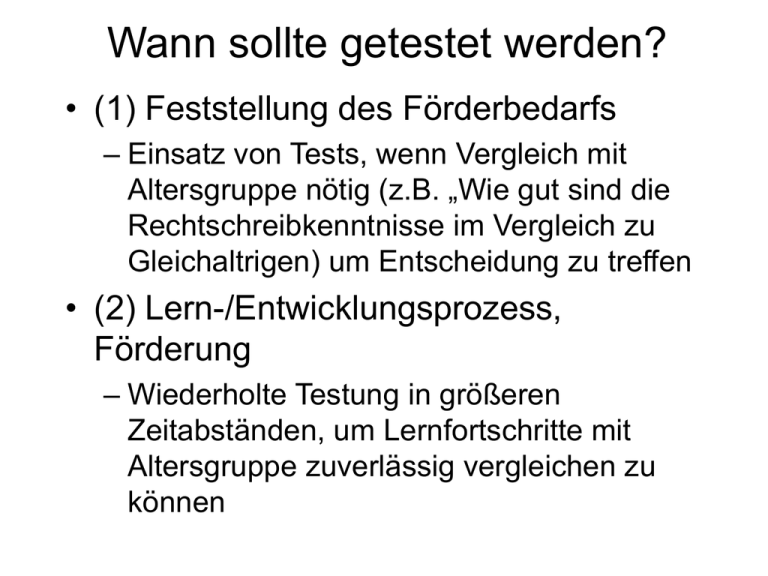

Wann sollte getestet werden? • (1) Feststellung des Förderbedarfs – Einsatz von Tests, wenn Vergleich mit Altersgruppe nötig (z.B. „Wie gut sind die Rechtschreibkenntnisse im Vergleich zu Gleichaltrigen) um Entscheidung zu treffen • (2) Lern-/Entwicklungsprozess, Förderung – Wiederholte Testung in größeren Zeitabständen, um Lernfortschritte mit Altersgruppe zuverlässig vergleichen zu können Definition eines Tests • Ein Test ist ein wissenschaftliches Routineverfahren zur Untersuchung eines oder mehrerer empirisch abgrenzbarer Persönlichkeitsmerkmale mit dem Ziel einer möglichst quantitativen Aussage über den relativen Grad der individuellen Merkmalsausprägung. (Lienert, 1969). • Bei einem Test handelt es sich um ein spezielles psychologisches Experiment mit dem Ziel, vergleichende Aussagen über Personen abzuleiten. (Rost 1996) Bestandteile • Handbuch / Manual – Angaben zum Testgegenstand (Konstrukt), Testentwicklung, Gütekriterien, Durchführung, Auswertunganweisungen, Normentabellen • Testhefte, Aufgabenmaterialien, Testbogen • Auswertungsschablonen, Protokollbogen, Auswertungsbogen Beispiel: Intelligenztest CFT 20 • Weiß, R. H. (1998). Grundintelligenztest Skala 2 – CFT 20. 4. Aufl., Göttingen, Hogrefe • Altersbereich: Schüler 8,5 – 18 Jahre – Für Erwachsene mit einfacher Schulbildung (20-70 J) • Erfasst die „fluide Intelligenz“ • Ist ein „produktorientiertes“ Verfahren, d.h., es werden keine Prozedurmerkmale des Problemlösens erfasst, sondern Menge und Geschwindigkeit Fluide Intelligenz • Intelligenz im Sinne eines wissensfreien („kulturfreien) Intelligenztests ist eine kognitive Ressource, welche die Geschwindigkeit und Qualität von Informationsverarbeitungsprozessen beeinflusst • Ihre basalen Komponenten sind vermutlich: • • • • • Reizverarbeitung (z.B. Differenzierung) Informationsverarbeitungsgeschwindigkeit Kurzzeitgedächtnis Verfügbarkeit elementarer Vergleichsprozesse und Heuristiken Neurobiologische Ansätze werden hier neue Methoden zur Messung der Basisintelligenzfaktoren hervorbringen Durchführung 1. 2. 3. 4. 5. 6. 7. 8. 9. Proband bekommt Testheft und Antwortbogen ausgehändigt VL liest Instruktion für Beispiele etc., vor PB betrachtet Aufgaben im Testheft und notiert die seiner Ansicht nach richtige Antwort auf dem Antwortbogen VL beendet die Bearbeitung einer Aufgabengruppe, wenn die vorgeschriebene Testzeit vorbei ist VL nimmt den Antwortbogen VL zählt mit Hilfe der Auswertungsschablone die Zahl der richtigen Antworten pro Block (Rohwert) VL trägt diese Rohwerte auf Rückseite des Antwortbogens ein VL liest anhand der Normwerte-Tabelle (im Manual) für jeden Rohwert den angegebenen IQ-Wert, bzw. Prozentrang ab Fertig Wie funktioniert so ein Ding? Testtheorie und ähnliche Unannehmlichkeiten Testtheorien • Ein Test ist nur ein psychologisches Experiment, aus dessen Ergebnissen vergleichende Aussagen über Personen abgeleitet werden können, wenn seiner Konstruktion eine Theorie zugrunde gelegt ist, die angibt, wie Testergebnis und zu messendes Merkmal zusammenhängen Testtheorie Testauswertung Personenmerkmal beeinflußt Testverhalten • Einem Test muss eine Theorie zugrunde liegen, die beschreibt, wie Testverhalten und psychisches Merkmal zusammenhängen und wie dieser Zusammenhang berechnet wird Empirie Theorie Population von Personen, Menge von Situationen, Menge von Verhaltensweisen Theorie über das Antwortverhalten der Personen in diesen Situationen (mit Hilfe eines Testmodells) Person a und Person b bearbeiten einen Test (z.B. Analogieaufgaben, Bewertung eigener Leistung) vergleichende Aussage über 2 Personen (z.B. a ist intelligenter als b, oder Person a hat einen negativen, Person b einen positiven Attributionsstil) Daten Ergebnis • Es gibt zwei derartige Theorien: – Klassische Testtheorie (KT) – Probabilistische Testtheorie (Item Response Theory, IRT; auch: Rasch-Modell) Item [aitem] • ist die Bezeichnung für die einzelne Aufgabe in einem Test • oder für die einzelne Frage in einem Fragebogen Skala • (1) Mehrere Items, die dieselbe Eigenschaft/Fähigkeit erfassen – Je mehr Items gelöst/beantwortet werden, desto stärker ist die Eigenschaft/Fähigkeit ausgeprägt • (2) Die Antwortskala eines Items, z.B.: Stimme zu – stimme teilweise zu – stimme nicht zu [2,1,0] – Oder allgemeiner: „Richtige Lösung / Falsche Lösung“ [0,1] Itemeigenschaften • Schwierigkeit: – Prozentsatz der Leute, die eine Aufgabe lösen (bzw. eine bestimmte Antwort geben) • Trennschärfe: – Informationsgehalt eines Items – Wie gut stellt es Unterschiede zwischen Personen fest? Klassische Testtheorie • Rohwert = wahrer Testwert + Messfehler Probabilistische Testtheorie • Wahrscheinlichkeit einer Antwort = Funktion latenter Fähigkeit und Itemeigenschaften X=T+E • T = Wahrer Testwert = Fähigkeit P(x) = F(Theta, bi) Klassische Testtheorie Probabilistische Testtheorie • P(x) = F(T, bi) p(xvi=1) 1 0,5 • X=T+E 0 v 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 1 E(xvi) • Der Messfehler E besteht aus zufälligen Fehlereffekten • • Messfehler E und wahrer Testwert (Fähigkeit) T sind unabhängig • • Itemeigenschaft „Trennschärfe“ wird aus X abgeleitet. Man kann sie nicht für ein einzelnes Item bestimmen • Itemeigenschaften „Schwierigkeit“ und „Trennschärfe“ sind Teil der Itemfunktion • Ein einzelnes Item stellt keine zuverlässige Schätzung einer Fähigkeit dar • Ein Item stellt einen Schätzer für eine bestimmte Fähigkeitsausprägung auf einem bestimmten Wahrscheinlichkeitsniveau dar Die Beziehung zwischen Fähigkeit und Antwortwahrscheinlichkeit wird durch eine spezielle Itemfunktion dargestellt Messfehler = Anpassungsgüte des Modell KT vrs. IRT Klassische Testtheorie (KT) • • • • • Probabilistische Testtheorie (IRT) Test muss aus mehreren Items bestehen Die Items müssen unterschiedlich schwer sein Die Items müssen möglichst trennscharf sein Eine Schwierigkeitsstufe muss durch mehrere Items repräsentiert werden • Test muss aus mehreren Items bestehen • Die Items müssen unterschiedlich schwer sein • Die Items müssen möglichst trennscharf sein • Eine Schwierigkeitsstufe kann durch ein einzelnes Items repräsentiert werden Alle Probanden müssen alle Items (zu) beantworten (versuchen) • Jeder Proband muss nur so viele Items beantworten, wie es seiner Fähigkeit entspricht => Adaptives Testen möglich Adaptives Testen CFT 20 • Der CFT-20 ist auf der Basis der klassischen Testtheorie konstruiert und evaluiert worden • Mit ihm ist kein adaptives Testen möglich • Ein adaptiver Intelligenztest für unsere Klientel ist der AID (Allgemeines Intelligenz Diagnosticum) Auswahlkriterien für die Eignung eines Test • Konstrukt (z.B. Intelligenz) • Testgütekriterien • Angemessenheit der Normierung Testgütekriterien • Um die Kriterien „wissenschaftliches Routineverfahren“, bzw. „psychologisches Experiment“ erfüllen zu können, muss ein diagnostisches Verfahren bestimmte Bedingungen erfüllen: Objektivität Reliabilität Validität Objektivität • Die Erfassung, Auswertung und Interpretation der Testdaten ist unabhängig von subjektiven Faktoren • (z.B. Vorurteilen, Einstellungen, Erwartungshaltungen, Verfälschungstendenzen) • Dies trifft in hohem Maße für Leistungstests (Intelligenztests, Konzentrationstest, etc.) zu • De facto kann diese Forderung aber nicht von jedem Test erfüllt werden. So sind z.B. Persönlichkeitstests nicht völlig verfälschungssicher Konstruktion eines klassischen Tests 1. Konstruktion eines Itempools: Viele Items, von denen man (begründet) annimmt, dass ihre Lösung (Beantwortung) die (nicht direkt beobachtbare) Zieleigenschaft repräsentiert 2. Vorgabe an Stichprobe (möglichst groß) Konstruktion eines klassischen Tests 3. Statistische Analysen: • • Prüfung, welche Items eine Dimension bilden (Homogenität, interne Validität) Prüfung der Itemschwierigkeit (Zahl der Personen, die ein Item lösen) 4. Zusammenfassung der homogenen Items mit steigender Schwierigkeit zu einem Test (oder Subtest) 5. Normierung 5 Items aus dem KFT Reliabilität • Reliabilität: Zuverlässigkeit • Hierunter versteht man die Messgenauigkeit eines Tests – Wie wiederholbar sind die Ergebnisse? – Bis zu welchem Grad lassen sich die Eigenschaften zweier Personen unterscheiden? Bestimmung der Reliabilität eines Tests • • • Re-Test-Reliablität : – Bestimmung des statistischen Zusammenhangs (Korrelation) zwischen zwei aufeinanderfolgenden Messungen Split-Half-Reliabilität: – Korrelation zwischen zwei Hälften der Items eines Tests Cronbachs Alpha: – Mittelwert der Korrelationen zwischen allen Einzelitems – Ausreichende Reliabilität: r: = .75 (.75: andere Notation für 0,75) – Gute Reliabilität: r = .90 • Probleme: • Die Messgenauigkeit kann nur für mehrere Items (Skala, Test, Subtest) bestimmt werden, nicht für Einzelitems Daher liefert ein Test, der nicht vollständig durchgeführt wurde, keine zuverlässige Messung Je mehr Items ein Test (Subtest, Skala) enthält, desto genauer wird er • • Reliabilitätssteigerung durch Testverlängerung Reliabilität des verlängerten Tests 1 r = 0,9 0,9 r = 0,8 0,8 r = 0,7 r = 0,6 0,7 r = 0,5 0,6 0,5 1 2 3 Testverlängerungsfaktor 4 5 Konfidenzintervalle • Die Reliabilität gibt nicht nur an, wie genau ein Test im allgemeinen misst • Mit ihrer Hilfe kann man das sog. „Konfidenzintervall“ (auch. Vertrauensintervall) eines Testergebnisses berechnen • Das Konfidenzintervall gibt an, mit welcher Wahrscheinlichkeit der „wahre Testwert“ in einem bestimmten Bereich von beobachteten Testergebnissen liegt • Z.B: • IQ (Testergebnis) = 98 • 95%-Konfidenzintervall:= 93-103 • D.h.: Mit einer Wahrscheinlichkeit von 95% liegt der „wirkliche“ IQ zwischen 93 und 103 Validität • Validität: Gültigkeit • Misst ein Test das, was er messen soll? – Zusammenhang zwischen dem Testergebnis und anderen Kriterien für das Zielverhalten – Skalenaufbau und –struktur entspricht dem psychologischen Wissen über das zu messende Konstrukt Bestimmung der Validität eines Tests • Augenschein- / Expertenvalidität – Entsprechen die Items dem Forschungsstand über das zu messende Merkmal? • Interne Validität: – Entspricht die Dimensionalität der Subtests den theoretisch zu erwartenden Dimensionen? – Ist die Zuordnung zwischen Items und Dimensionen sinnvoll? – Methode: Faktorenanalysen • Externe Validität: – Bestimmung des Zusammenhangs (Korrelationen) zwischen dem Testergebnis und anderen Kriterien für das messende Verhalten • Ökologische Validität: – Ist die Art, in der das Merkmal gemessen wird, geeignet, Aussagen über das Verhalten in Realsituationen zu treffen? Normierung • Sowohl ein klassischer als auch ein nach dem IRT-Modell konstruierter Test gelten für die Stichprobe(n), auf deren Basis die Prüfstatistiken berechnet wurden. • Um sinnvolle Vergleiche innerhalb verschiedener Teilpopulationen (z.B. Männer/Frauen, Altersgruppen, Bildungsschichten, etc.) vornehmen zu können, müssen getrennte Tabellen erstellt werden • Dazu muss bestimmt werden, welche Kriterien für die Aufteilung in Teilpopulationen sinnvoll ist Definitionen • Statistischer Normalbereich: -1 SD bis 1 SD – Bereich um den Mittelwert – Entspricht 68,2 % der Population • SD (Standardabweichung ist ein abstraktes Maß) • Es gibt verschiedene Umrechung (Transformationen) der Rohwerte in einen anschaulicheren Wert • Z-Wert, T-Wert, Abweichungs-IQ, Prozentrang z-Wert • Der sog. z-Wert gibt die Abweichung eines individuellen Testergebnisses vom Mittelwert an • Mittelwert: 0 • Abstand: Standardabweichung (mittlere Abweichung der Testwerte) – Negative z-Werte: unter dem Mittelwert – Positive z-Werte: über dem Mittelwert – Normalbereich: -1 bis +1 T-Werte • Der T-Wert ist eine Transformation des zWerts • Er repräsentiert die exakt gleiche Information, nämlich die Abweichung eines Testergebnisses vom Mittelwert, gemessen in Standardabweichungen • Er ist aber so transformiert, dass die Zahlen etwas anschaulicher sind • Mittelwert der Verteilung: t-Wert = 50, SD=10 • Normalbereich: 40 - 60 Sinn? • Z-Werte und t-Werte haben durchaus einen Sinn: • Da sie standardisierte, verteilungs-unabhängige Kennwerte sind, kann man die z- und t-Werte unterschiedlicher Tests miteinander vergleichen – War die erste Messung vor einem Jahr besser oder schlechter als die aktuelle Messung? – Z.B. Ist der Proband im Lesen besser als im Schreiben? • Dagegen lassen sich Rohwerte oder Prozentränge von Tests NICHT unmittelbar miteinander vergleichen • Um zwei Testwerte (des gleichen Tests, z.B. Wiederholungsmessung) vergleichen zu können, muss man allerdings berücksichtigen, dass auch z-, T- und IQ-Werte messfehlerbehaftet sind • Dies wird beim Vergleich berücksichtigt, indem man die sog. kritische Differenz bestimmt • Die kritische Differenz hängt von der Reliabilität des Tests ab • Krit. Diff = 1.96 * 10 * Wurzel aus (2 * [1-Reliabilität]) • Sie gibt an, um wie viele T-Wert-Punkte zwei TWerte auseinander liegen müssen, um tatsächlich einen Unterschied darzustellen Vergleich zweier unterschiedlicher Tests • Vergleich der t-Werte aus zwei verschiedenen Tests: • Dkrit= 1,96 * 10* Wurzel (2-[ReliaTest1 + ReliaTest2]) – – – – Dkrit = 1,96 * 10 * SQR(2-[.86+.92]) Dkrit = 19,6 * SQR(0,22) Dkrit = 9.2 In diesem Fall müssen sich die beiden T-Werte um 9,2 (bzw. abgerundet: 9) unterscheiden, um wirklich einen bedeutsamen Unterschied darzustellen • Das muss man leider wirklich per Hand rechnen, da es in den Testhandbüchern nicht enthalten ist Prozentrang • Prozentrang gibt an, welcher Prozentsatz der Vergleichsgruppe ein gleich gutes oder schlechteres Ergebnis erzielt haben • Normalbereich: abhängig von der Standardabweichung und Verteilungsform des Tests (d.h., der konkreten Rohwerteverteilung) • 15,8 % - 84% • PR ist sehr anschaulich, aber weniger informativ als z- oder T-Werte