Stochastische Unabhängigkeit, bedingte Wahrscheinlichkeiten

Werbung

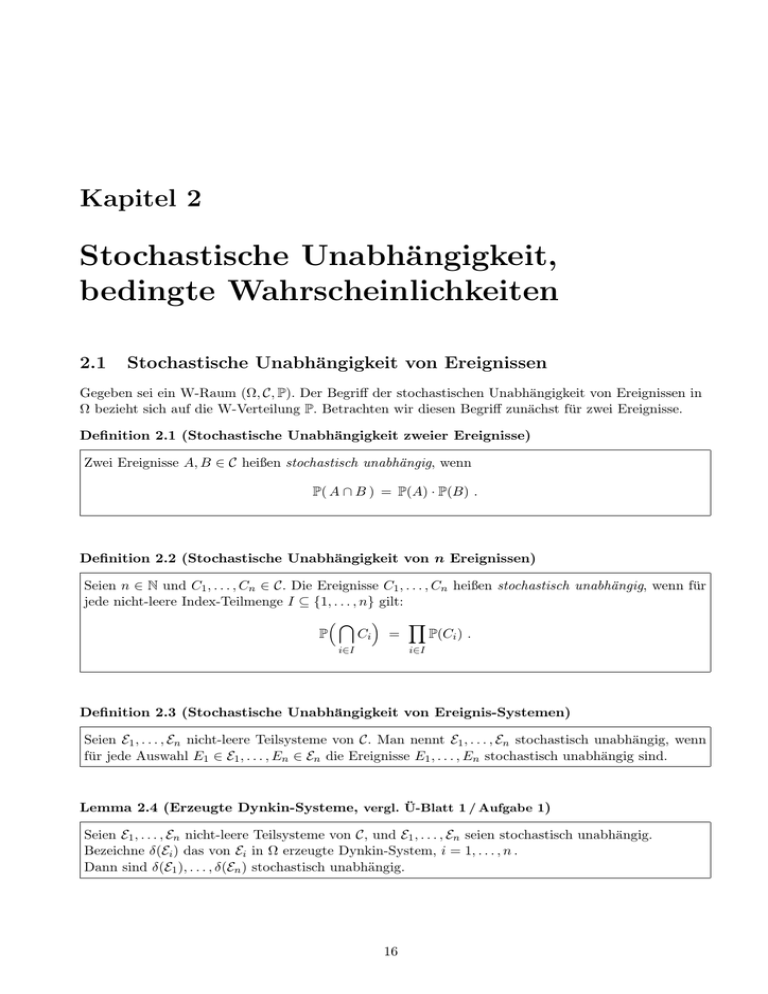

Kapitel 2

Stochastische Unabhängigkeit,

bedingte Wahrscheinlichkeiten

2.1

Stochastische Unabhängigkeit von Ereignissen

Gegeben sei ein W-Raum (Ω, C, P). Der Begriff der stochastischen Unabhängigkeit von Ereignissen in

Ω bezieht sich auf die W-Verteilung P. Betrachten wir diesen Begriff zunächst für zwei Ereignisse.

Definition 2.1 (Stochastische Unabhängigkeit zweier Ereignisse)

Zwei Ereignisse A, B ∈ C heißen stochastisch unabhängig, wenn

P( A ∩ B ) = P(A) · P(B) .

Definition 2.2 (Stochastische Unabhängigkeit von n Ereignissen)

Seien n ∈ N und C1 , . . . , Cn ∈ C. Die Ereignisse C1 , . . . , Cn heißen stochastisch unabhängig, wenn für

jede nicht-leere Index-Teilmenge I ⊆ {1, . . . , n} gilt:

³\ ´

Y

P

Ci =

P(Ci ) .

i∈I

i∈I

Definition 2.3 (Stochastische Unabhängigkeit von Ereignis-Systemen)

Seien E1 , . . . , En nicht-leere Teilsysteme von C. Man nennt E1 , . . . , En stochastisch unabhängig, wenn

für jede Auswahl E1 ∈ E1 , . . . , En ∈ En die Ereignisse E1 , . . . , En stochastisch unabhängig sind.

Lemma 2.4 (Erzeugte Dynkin-Systeme, vergl. Ü-Blatt 1 / Aufgabe 1)

Seien E1 , . . . , En nicht-leere Teilsysteme von C, und E1 , . . . , En seien stochastisch unabhängig.

Bezeichne δ(Ei ) das von Ei in Ω erzeugte Dynkin-System, i = 1, . . . , n .

Dann sind δ(E1 ), . . . , δ(En ) stochastisch unabhängig.

16

Norbert Gaffke: Vorlesung “Einführung in die Wahrscheinlichkeitstheorie und Statistik”, Wintersemester 2012/13

Kapitel 2: Stochastische Unabhängigkeit, bedingte Wahrscheinlichkeiten

Korollar 2.5

Seien C1 , . . . , Cn ∈ C stochastisch unabhängige Ereignisse.

Die Indexmenge {1, . . . , n} sei partitioniert in r nicht-leere, paarweise disjunkte Teilmengen I1 , . . . , Ir .

©

ª

Betrachte die Mengensysteme Ek := Ci : i ∈ Ik , k = 1, . . . , r.

Dann sind die erzeugten Sigma-Algebren σ(E1 ), . . . , σ(Er ) stochastisch unabhängig.

2.2

Stochastische Unabhängigkeit von Zufallsvariablen

Gegeben seien ein W-Raum (Ω, C, P) sowie n Messräume (Mi , Ai ) und Zufallsvariablen Xi : Ω −→ Mi

(messbar bezgl. C und Ai ) , i = 1, . . . , n.

Definition 2.6 (Stochastische Unabhängigkeit von Zufallsvariablen)

Die Zufallsvariablen X1 , . . . , Xn heißen stochastisch unabhängig, wenn für jede Auswahl

A1 ∈ A1 , . . . , An ∈ An gilt: Die Ereignisse {X1 ∈ A1 } , . . . , {Xn ∈ An } sind stochastisch unabhängig.

Anmerkung: Eine äquivalente Formulierung der stochastischen Unabhängigkeit von X1 , . . . , Xn ist:

n

Y

¢

¡

P(Xi ∈ Ai ) ∀ Ai ∈ Ai , i = 1, . . . , n.

P X1 ∈ A1 , . . . , Xn ∈ An =

i=1

Im Fall diskreter Zufallsvariablen lässt sich die Beschreibung der stochastischen Unabhängigkeit wesentlich vereinfachen:

Lemma 2.7 (Stochastische Unabhängigkeit diskreter Zufallsvariablen)

Die Wertebereiche Mi seien abzählbar und Ai = P(Mi ) , i = 1, . . . , n. Dann gilt:

Die Zufallsvariablen X1 , . . . , Xn sind genau dann stochastisch unabhängig, wenn

¡

P X1 = x1 , . . . , Xn = xn

¢

=

n

Y

P(Xi = xi ) ∀ xi ∈ Mi , i = 1, . . . , n.

i=1

Bemerkung: Produkt diskreter W-Verteilungen und stoch. Unahhängigkeit diskreter ZV’en

Wenn (Mi , Pi ) , i = 1, . . . , n , diskrete W-Räume sind, dann ist durch

P (x) :=

n

Y

n

Pi (xi ) ∀ x = (x1 , . . . , xn ) ∈ M := × Mi

i=1

i=1

P

eine¡nicht-negative

Funktion auf M mit

x∈M P (x) = 1 gegeben, die also eine W-Verteilung P

¢

auf M, P(M ) definiert (Lemma 1.6 (b)). Diese W-Verteilung heißt das Produkt der W-Verteilungen

n

P1 , . . . , Pn , Abk.: P = ⊗ Pi .

i=1

Das Resultat von Lemma 2.7 lässt sich auch so formulieren:

X1 , . . . , Xn stoch. unabhängig

⇐⇒

n

P(X1 ,...,Xn ) = ⊗ PXi .

i=1

Auch für nicht-diskrete Zufallsvariablen ist eine Reduktion der Bedingung für stochastische Unabhängigkeit von Definition 2.6 möglich.

17

Norbert Gaffke: Vorlesung “Einführung in die Wahrscheinlichkeitstheorie und Statistik”, Wintersemester 2012/13

Kapitel 2: Stochastische Unabhängigkeit, bedingte Wahrscheinlichkeiten

Theorem 2.8 (Reduktion auf durchschnitt-stabile Erzeuger)

Für jedes i = 1, . . . , n sei Ei ⊆ P(Mi ) ein durchschnitt-stabiler Erzeuger

S∞der Sigma-Algebra Ai mit

der weiteren Eigenschaft, dass eine isotone Folge Ei,j ∈ Ei (j ∈ N) mit j=1 Ei,j = Mi existiert.

Dann gilt die Äquivalenz:

Die Zufallsvariablen X1 , . . . , Xn sind genau dann stochastisch unabhängig, wenn

n

Y

¡

¢

P(Xi ∈ Ei ) ∀ Ei ∈ Ei , i = 1, . . . , n .

P X1 ∈ E1 , . . . , Xn ∈ En =

i=1

Korollar 2.9 (Stochastische Unabhängigkeit reeller Zufallsvariablen)

Seien (Mi , Ai ) = (R, B 1 ) , i = 1, . . . , n, also X1 , . . . , Xn reelle Zufallsvariablen auf Ω.

(a) X1 , . . . , Xn sind genau dann stochastisch unabhängig, wenn

n

Y

¢

¡

P(Xi ≤ bi ) ∀ b1 , . . . , bn ∈ R .

P X1 ≤ b1 , . . . , Xn ≤ bn =

i=1

(b) Sei noch vorausgesetzt, dass für jedes i = 1, . . . , n die Zufallsvariable Xi Lebesgue-stetig verteilt

ist, d.h. dass PXi eine Lebesgue-Dichte fi besitzt . Dann gilt die Äquivalenz:

X1 , . . . , Xn sind genau dann stochastisch unabhängig, wenn die gemeinsame Verteilung

P(X1 ,...,Xn ) die Lebesgue-Dichte

f (x) :=

n

Y

fi (xi ) ∀ x = (x1 , . . . , xn ) ∈ Rn

i=1

n

besitzt, d.h. wenn gilt: P(X1 ,...,Xn ) = ⊗ PXi

i=1

(vergl. Lemma 1.18).

Die beiden folgenden Lemmata sind von Nutzen, wenn aus stochastisch unabhängigen Zufallsvariablen

durch messbare Transformationen neue Zufallsvariablen erzeugt werden.

Wenn wir bei der Formulierung von Lemma 2.11 doppelt indizierte Zufallsvariablen und Messräume verwenden,

so soll das nur zur besseren Lesbarkeit dienen und hat inhaltlich keine weitere Bedeutung.

Lemma 2.10

Seien X1 , . . . , Xn stochastisch unabhängige Zufallsvariablen, wobei Xi : Ω −→ Mi , (i = 1, . . . , n) .

Seien noch weitere Messräume (Ni , Bi ) (i = 1, . . . , n) gegeben sowie messbare Abbildungen:

Ti : Mi −→ Ni

messbar bezgl. Ai und Bi , i = 1, . . . , n .

Dann gilt für Yi := Ti ◦ Xi , i = 1, . . . , n :

Die Zufallsvariablen Y1 , . . . , Yn sind stochastisch unabhängig.

18

Norbert Gaffke: Vorlesung “Einführung in die Wahrscheinlichkeitstheorie und Statistik”, Wintersemester 2012/13

Kapitel 2: Stochastische Unabhängigkeit, bedingte Wahrscheinlichkeiten

19

Lemma 2.11

Seien X11 , . . . , X1n1 , X21 , . . . , X2n2 , . . . , Xk1 , . . . , Xknk stochastisch unabhängige Zufallsvariablen,

wobei

Xij : Ω −→ Mij , (Mij , Aij ) ein Messraum , i = 1, . . . , k , j = 1, . . . , ni .

³ ni

´

ni

Betrachte die Messräume

× Mij , ⊗ Aij , i = 1, . . . , k , und die “mehrdimensionalen” Zufallsvaj=1

j=1

riablen

ni

X i = ( Xi1 , . . . , Xini ) : Ω −→ × Mij ,

j=1

i = 1, . . . , k .

Dann sind die Zufallsvariablen X 1 , . . . , X k stochastisch unabhängig.

2.3

Modellierung unabhängiger Zufallsexperimente

Oft haben wir es mit Zufallsexperimenten zu tun, die aus mehreren “unabhängigen” Einzelexperimenten bestehen (z.B. die mehrmalige unabhängige Durchführung eines 0-1-Experiments). Mit Hilfe des

Begriffes der stochastischen Unabhängigkeit lässt sich eine geeignete Modellierung dann allgemein wie

folgt vornehmen.

Das gesamte Zufallsexperiment bestehe aus n unabhängigen Einzelexperimenten; ein Ergebnis des

(gesamten) Zufallsexperiments ist ein n-Tupel

x = (x1 , x2 , . . . , xn ) ,

wobei xi das Ergebnis des i-ten Einzelexperiments bezeichnet, i = 1, . . . , n. Das Modell für das i-te

Einzelexperiment sei durch einen W-Raum (Mi , Ai , Pi ) gegeben (i = 1, . . . , n). Wir können das auch

etwas “ausschmücken”:

Sei (Ω, C, P) ein W-Raum im Hintergrund, und seien Zufallsvariablen Xi : Ω −→ Mi mit PXi = Pi

(i = 1, . . . , n) gegeben. Ein Ergebnis des Gesamtexperiments ist dann ein Wert der Zufallsvariablen

X = (X1 , . . . , Xn ) , und das Modell des Gesamtexperiments ist der W-Raum

³n

´

n

× Mi , ⊗ Ai , P(X1 ,...,Xn ) .

i=1

i=1

Die Unabhängigkeit der Einzelexperimente wird als stochastische Unabhängigkeit der Zufallsvariablen

X1 , X2 , . . . , Xn in die Modellierung eingebracht, so dass – jedenfalls in den beiden Fällen, dass die

Zufallsvariablen entweder diskret oder Lebesgue-stetig verteilt sind – die Produkt-Verteilung resultiert:

n

n

i=1

i=1

P(X1 ,...,Xn ) = ⊗ PXi = ⊗ Pi .

³

Das Modell für das Gesamtexperiment ist also der Produkt-W-Raum

´

n

n

n

× Mi , ⊗ Ai , ⊗ Pi .

i=1

i=1

i=1

Oft haben wir spezieller die Situation, dass es sich bei den Einzelexperimenten um unabhängige

Durchführungen desselben Experiments handelt. Dann sind also die W-Räume (Mi , Ai , Pi ) (i = 1, . . . , n)

identisch zu wählen, und die Verteilungen der Zufallsvariablen Xi (i = 1, . . . , n) sind daher identisch.

Man spricht von identisch verteilten Zufallsvariablen X1 , X2 , . . . , Xn , und – zusammen mit der vorausgesetzten stochastischen Unabhängigkeit dieser Zufallsvariablen – von stochastisch unabhängigen

und identisch verteilten (Abk: u.i.v.) Zufallsvariablen X1 , X2 , . . . , Xn . Engl.: independent and identically

distributed (i.i.d.) random variables X1 , X2 , . . . , Xn .

Norbert Gaffke: Vorlesung “Einführung in die Wahrscheinlichkeitstheorie und Statistik”, Wintersemester 2012/13

Kapitel 2: Stochastische Unabhängigkeit, bedingte Wahrscheinlichkeiten

Beispiel: Modell mit n u.i.v. normalverteilten Zufallsvariablen

Z.B. in einer industriellen Fertigung: Zur Überwachung einer (reellen) Produktcharakteristik wird

Stichprobe von n gefertigten Stücken vermessen. Modellierung oft durch n stochastisch unabhängige

reelle Zufallsvariablen X1 , . . . , Xn , die jeweils als normal-(β, σ 2 )-verteilt angenommen werden. Kurzschreibweise:

X1 , . . . , Xn u.i.v. ∼ N(β, σ 2 ) .

Ihre gemeinsame Verteilung (eine W-Verteilung auf (Rn , B n )) ist daher:

¡

¢

n

P(X1 ,...,Xn ) = ⊗ N(β, σ 2 ) = N β1n , σ 2 I n ,

i=1

wobei 1n = (1, . . . , 1)t ∈ Rn und I n die n × n Einheitsmatrix bezeichnen. Die Lebesgue-Dichte dieser

Verteilung ist:

³

´

n

¡ ¢−n/2

1 P

exp − 2

f (x1 , . . . , xn ) = (2π)−n/2 σ 2

(xi − β)2

∀ (x1 , . . . , xn ) ∈ Rn .

2σ i=1

Beispiel: n-malige unabhängige Durchführung eines 0-1-Experiments

Die Wahrscheinlichkeit für “1” im Einzelexperiment sei mit p ∈ [ 0 , 1 ] bezeichnet. Das Modell für

das Gesamtexperiment (n-malige unabhängige Durchführung des 0-1-Experiments) ist gegeben durch

stochastisch unabhängige 0-1-wertige Zufallsvariablen X1 , X2 , . . . , Xn mit P(Xi = 1) = p und

P(Xi = 0) = 1 − p , i = 1, 2, . . . , n , also:

X1 , . . . , Xn u.i.v. ∼ Bi(1, p) .

n

Die gemeinsame Verteilung ist daher P(X1 ,...,Xn ) = ⊗ Bi(1, p) , und ihre Zählichte ist:

i=1

n

Pn

Pn

Y

¢

¡

P(Xi = xi ) = p i=1 xi (1 − p)n− i=1 xi

P X1 = x1 , X2 = x2 , . . . , Xn = xn =

i=1

n

∀ (x1 , . . . , xn ) ∈ {0, 1} .

Hier ist

Pn

i=1 xi

gleich der Anzahl der erzielten “1”-en und n−

Pn

i=1 xi

die Anzahl der erzielten “0”-en.

Beispiel: Binomial-verteilte Anzahl

In der Praxis wird man bei einem Zufallsexperiment wie im vorigen Beispiel nicht die ausführliche

Sequenz (n-Tupel) (x1 , x2 , . . . , xn ) als Ergebnis dokumentieren, sondern die Reduktion auf die Anzahl

der “1”-en vornehmen. Das Ergebnis des Zufallsexperiments ist dann ein Wert einer Zufallsvariablen

X, die ihre möglichen Werte in der Menge {0, 1, . . . , n} hat.

Die adäquate Verteilungsannahme ist dann: X ∼ Bi(n, p) (s. nachfolgendes Lemma),

¡

¢

und ein adäquates Modell für das Zufallsexperiment ist der (diskrete) W-Raum {0, 1, . . . , n} , Bi(n, p) .

Lemma 2.12 (Summe von stochastisch unabhängigen binomial-(ni , p)-verteilten ZV’en)

Seien X1 , . . . , Xm stochastisch unabhängige Zufallsvariablen mit Xi ∼ Bi(ni , p) (i = 1, . . . , m),

wobei ni ∈ N (i = 1, . . . , m) und p ∈ [ 0 , 1 ] . Dann gilt:

m

X

i=1

Xi ∼ Bi(n, p) mit n =

m

X

i=1

ni .

20

Norbert Gaffke: Vorlesung “Einführung in die Wahrscheinlichkeitstheorie und Statistik”, Wintersemester 2012/13

Kapitel 2: Stochastische Unabhängigkeit, bedingte Wahrscheinlichkeiten

21

Bemerkung: Summe von stochastisch unabhängigen 0-1-wertigen ZV’en;

Poisson-Verteilung als Approximation

Seien X1 , . . . , Xn stochastisch unahängige 0-1-wertige Zufallsvariablen, aber nicht notwendig identisch

verteilt: Xi ∼ Bi(1, pi ) mit pi ∈ [0 , 1 ] (i = 1, . . . , n). Wir interessieren uns für die Verteilung der

n

P

Summenvariablen S :=

Xi . Diese ist i.A. analytisch schwierig zu handhaben. Eine brauchbare

i=1

Approximation liefert eine Poisson-(λ)-Verteilung mit λ :=

n

P

i=1

pi , sofern die Wahrscheinlichkeiten

pi klein sind, (s. nachfolgendes Lemma). Daher ist oft plausibel, dass eine zufällige Anzahl, z.B. die

Anzahl der Kunden einer Service-Station an einem Tag, oder z. B. die Anzahl zerfallener Teilchen einer

radioaktiven Substanz in einer Sekunde, in guter Näherung durch eine Poisson-verteilte Zufallsvariable

beschreibbar ist. Man kann sich nämlich vorstellen, dass die zufällige Anzahl durch eine Reihe von

unabhängigen 0-1-Experimenten mit jeweils kleinen Wahrscheinlichkeiten für “1” zu Stande kommt.

Lemma 2.13 (Poisson-Verteilung als Approximation)

Seien X1 , . . . , Xn stochastisch unabhängige 0-1-wertige Zufallsvariablen, Xi ∼ Bi(1, pi ) mit

n

P

pi ∈ [ 0 , 1 ] , i = 1, . . . , n. Betrachte die Summenvariable S :=

Xi .

i=1

Dann gilt für die Verteilung von S und die Poisson-(λ)-Verteilung mit λ :=

n

P

i=1

n

¯

¯

X

¯ S

¯

p2i

¯ P (A) − Poi(λ)(A) ¯ ≤

pi :

für alle A ⊆ N0 .

i=1

2.4

Bedingte Wahrscheinlichkeiten

Definition 2.14

Seien (Ω, C, P) ein W-Raum und A, B ∈ C mit P(B) > 0. Dann heißt die Zahl

P( A | B ) =

P( A ∩ B )

P(B)

die bedingte Wahrscheinlichkeit von A unter B.

Bemerkungen

1. Wie man leicht sieht, gilt 0 ≤ P(A|B) ≤ 1 .

2. Zur Interpretation des Wertes P(A|B) :

Im Unterschied zur “unbedingten” Wahrscheinlichkeit P(A) des Ereignisses A ist P(A|B) die aktualisierte Wahrscheinlichkeit von A unter der Zusatzinformation, dass das Ereignis B eintritt (oder

eingetreten ist).

3. Wann bleibt die Wahrscheinlichkeit für A dieselbe, d.h. wann gilt P(A|B) = P(A) ?

Das ist offensichtlich genau dann der Fall, wenn P(A ∩ B) = P(A) · P(B) ist, d.h. wenn die Ereignisse

A und B stochastisch unabhängig sind.

4. Wenn wir die bedingte Wahrscheinlichkeit P(A|B) für variierendes A ∈ C betrachten, aber mit

einem festen B ∈ C (mit P(B) > 0), so erkennen wir: P( · |B) ist eine W-Verteilung auf C;

Norbert Gaffke: Vorlesung “Einführung in die Wahrscheinlichkeitstheorie und Statistik”, Wintersemester 2012/13

Kapitel 2: Stochastische Unabhängigkeit, bedingte Wahrscheinlichkeiten

diese bedingte W-Verteilung unter B interpretieren wir als Aktualisierung der W-Verteilung P unter

der Zusatzinformation, dass das Ereignis B eintritt (oder eingetreten ist).

5. Sei X : Ω −→ M eine Zufallsvariable, wobei (M, A) ein Messraum ist, und sei B ∈ C mit P(B) > 0

gegeben. Dann heißt die Funktion auf A,

PX|B (C) := P( {X ∈ C} | B ) , C ∈ A ,

die bedingte Verteilung von X unter B ; diese ist eine W-Verteilung auf (M, A). Offensichtlich gilt:

¡

¢X

PX|B = P( · |B)

.

Beispiel: Gedächtnislosigkeit der Exponentialverteilung

Sei X : Ω −→ R eine exponential-(λ)-verteilte Zufallsvariable: PX = Exp(λ) , mit einem λ > 0 .

Sei x0 ∈ ( 0 , ∞) gegeben.

Wir interessieren uns für die bedingte Verteilung der Zufallsvariablen X − x0 unter { X > x0 }.

Ergebnis: PX−x0 |X>x0 = Exp(λ) .

Jetzt noch einige allgemeine (aber elementare) Resultate über bedingte Wahrscheinlichkeiten. Zu

Grunde liege ein W-Raum (Ω, C, P) .

Lemma 2.15 (Multiplikationsformel für bedingte Wahrscheinlichkeiten)

³ n−1

´

T

Wenn n ∈ N, n ≥ 2, und A1 , A2 , . . . , An ∈ C mit P

Aj > 0 , dann gilt:

j=1

n

³T

´

³ ¯ i−1

´

n

Y

¯ T

P

Ai = P(A1 )

P Ai ¯

Aj .

i=1

j=1

i=2

Korollar 2.16 (Gemeinsame Verteilung diskreter ZV’en)

Seien X1 , . . . , Xn diskrete Zufallsvariablen, Xi : Ω −→ Mi , Mi abzählbar, (i = 1, . . . , n). Dann gilt:

¡

P X1 = x1 , X2 = x2 , . . . , Xn = xn

¢

n

Y

¯

¡

¢

= P( X1 = x1 )

P Xi = xi ¯ X1 = x1 , . . . , Xi−1 = xi−1

i=2

für alle x1 ∈ M1 , x2 ∈ M2 , . . . , xn ∈ Mn mit P( X1 = x1 , X2 = x2 , . . . , Xn−1 = xn−1 ) > 0.

Lemma 2.17 (Bayes’sche Formeln)

Seien I eine abzählbare, nicht-leere Indexmenge

und Ai ∈ C, i ∈ I , eine Familie paarweise disjunkter

S

Ereignisse mit P(Ai ) > 0 ∀ i ∈ I und

Ai = Ω , (die Ai , i ∈ I , bilden also eine disjunkte Zerlegung

von Ω).

i∈I

Dann gilt für jedes Ereignis B ∈ C :

X

P(B) =

P(B|Ai ) P(Ai ).

(“Formel von der totalen Wahrscheinlichkeit”)

i∈I

Wenn P(B) > 0 ist, dann gilt noch:

P(Ai |B) =

P(B|Ai ) P(Ai )

P(B)

für jedes i ∈ I.

22