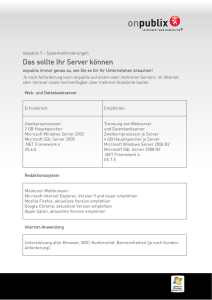

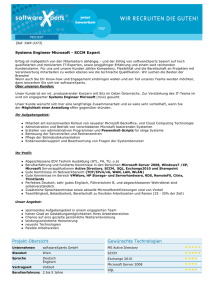

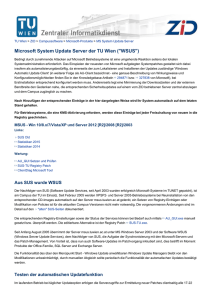

die fabasoft referenzarchitektur im microsoft windows

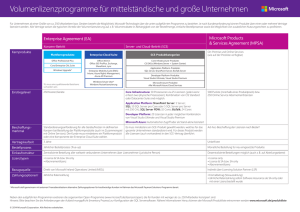

Werbung