Das Gedächtnis-Konzept als kognitive Fassung des Lernproblems

Werbung

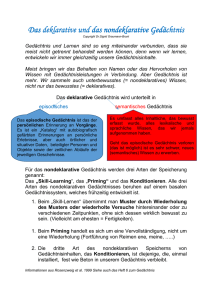

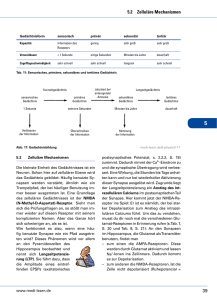

Das Gedächtnis-Konzept als kognitive Fassung des Lernproblems Die Anforderungen der Computerentwicklung treiben die Ablösung der behavioristischen Lerntheorie durch Forschungen zur Informationsverarbeitung voran. Nicht nur die Begriffe der neu belebten kognitiven Theorie entstammen der Computerlogik - wie Input, Output, Encodierung, Abruf, Speicher -‚ auch die Forschungen richten sich auf künstliche Intelligenz, also auf leistungsfähige Hilfsmittel zur Problemlösung und Wissensakkumulation. Holzkamp berichtet, dass die liegen gebliebenen Ansätze - etwa von Ebbinghaus (1985) - wieder aufgenommen und mit dem zusätzlichen Bonus einer womöglich exakten Naturwissenschaft versehen werden. So treten kognitive Prozesse ins Zentrum der Psychologie. Dabei ging es zunächst nicht um Lernprozesse, ja es scheint, als hätte die Besetzung des Lernkonzepts durch die SR-Psychologie dieses für die kognitive Wende zumindest zunächst uninteressant gemacht: „Dies ging so weit, dass in dem Manifest der kognitiven Wende von Neisser (1967) der Terminus »Lernen« als in irgendeinem Sinne systematischer Begriff praktisch nicht mehr vorkommt.“ (119) Dafür gerät ein relevanter Begriff für jedes Lernen, der des Gedächtnisses, ins Zentrum kognitivistischer Forschung; Holzkamp fasst dies als »Spezifizierung des Stimulus-Responsetheoretischen Lernkonzeptes« (120). Er skizziert die verschiedenen durch Experimente gestützten Stufen und Annahmen zur Frage des Gedächtnisses. Der Phase der Untersuchung von Gedächtniselementen, um dessen Funktion und Aufbau zu erforschen, durch das Experimentieren mit »sinnlosen Silben« (zunächst durch Ebbinghaus) und der dabei entwickelten Methoden von Erlernen, Behalten und Vergessen, folgten theoretische Konzepte, die das Vorhandensein unterschiedlicher Speicher annahmen (Kurz- und Langzeitspeicher etwa bei Atkinson und Shiffrin, 1968). „Das Phänomen, dessen Aufbau Ebbinghaus erforschen wollte, war jedoch nicht das Bewußtsein im Ganzen, sondern spezieller das Gedächtnis als quasi zeitlicher Prozeß-Aspekt des Bewußtseins. Aber auch dabei war es sein Ziel, die Elemente, hier von Gedächtnisprozessen, zunächst möglichst rein, d.h. unbeeinflußt von zusätzlichen komplizierenden Faktoren, zu erfassen, um so den Gedächtnis-Aufbau »von unten« her auf die assoziativen Verknüpfungsgesetze der Elemente hin untersuchen zu können. Das »Gedächtniselement«, das Ebbinghaus unter dieser Zielsetzung herausanalysierte (...), war die »sinnlose Silbe«: Ein Kunstwort aus drei Buchstaben, zwei Konsonanten und einem von diesen umschlossenen Vokal, z.B. MUB, NUF, MEy. Durch das Lernen und spätere Reproduzieren bzw. Wiedererkennen solcher sinnloser Silben sollten die Gesetze des Behaltens und Vergessens ohne Verfälschungen durch schon vorher im Alltag Gelerntes und Eingeprägtes, eben in reiner Form, faßbar werden. Dazu entwickelten Ebbinghaus und seine Mitarbeiter (so insbesondere Müller & Schumann, 1894) spezifische »Gedächtnismethoden« ‚ z.B. »Methode des Erlernens«, »Ersparnismethode«, »Methode des Behaltens«; das zeitliche Verhältnis zwischen Lernen und Vergessen des Materials wurde in sog. Gedächtniskurven bzw. Vergessenkurven dargestellt (...). Die kognitivistische Gedächtnisforschung hat mit der klassischen Gedächtnisforschung gemeinsam, daß dabei so gut wie ausschließlich sprachliches bzw. symbolisches Material (i.w.S.) benutzt 2 wird, allerdings neben sinnlosen Silben zunehmend auch bedeutungsvolle Wörter, Sätze, bis hin zu ganzen Texten. Das entscheidende Spezifikum der Gedächtnisforschung nach der kognitiven Wende ist jedoch - wie gesagt - die Verwendung von auf die Computer-Metapher gestützten Termini und Modellen. Dabei wurde praktisch von Anfang an (seit den fünfziger Jahren) nicht nur das Gedächtnis in Analogie zum Computerspeicher gesetzt, sondern man entwickelte darüber hinaus theoretische Konzepte, in denen das Gedächtnis als aus nicht nur einem, sondern aus zwei bzw. drei unterschiedlichen Speichern bestehend modelliert wurde. Die (...) Herrschaft von solchen »Mehrspeicher-« oder »Mehrkomponentenmodellen« begann wohl mit Broadbent (1959), dessen Untersuchungen über die begrenzte Kanalkapazität des menschlichen Sensoriums die Annahme eines »Zwischenspeichers« (»buffer«), der bei Überschreitung der sensorischen Aufnahmefähigkeit die einkommende Information kurzfristig festhalten kann, als vom bisher allein betrachteten Langzeitgedächtnis unterscheidbar nahelegte. Im weiteren wurde daraus, über mehrfache Umdeutungen und Erweiterungen, ein Dreispeichermodell des Gedächtnisses, wie es von Atkinson & Shiffrin (1968) in Zusammenfassung vorgängiger Untersuchungen und Diskussionen entworfen worden ist und in gewissen Strömungen der Kognitiven Psychologie noch heute (teilweise abgewandelt und ergänzt) tradiert wird. Demnach hat man einen Ultrakurzzeitspeicher mit einer Haltezeit von 1/4 bis 2 Sekunden als »Sensorisches Register« (SR), einen Kurzzeit-Speicher (Short term memory = STM) mit mehreren (5-20) Sekunden Haltezeit und einen Langzeit-Speicher (LTM) mit unbegrenzter Haltezeit (das eigentliche »Gedächtnis«) zu unterscheiden. Dabei ist vorausgesetzt, daß Schwierigkeiten bei der Aktualisierung von Daten aus dem Langzeit-Speicher nicht auf Grenzen der Haltezeit, sondern auf Mängel der Wiedererinnerung, also des Abrufprozesses, zurückgehen. Der Informationsfluß soll gemäß diesen Modellvorstellungen vom SR zum STM, von da aus zum LTM und (beim Erinnern als »Abruf« aus dem LTM) wieder in den STM (und von da aus u.U. noch in eine Art von »Response-Generator«, der die Umsetzung der Information in manifestes Verhalten besorgt) gehen.“ (121f) Allen ist der Bezug zum symbolischen Material (Sprache) gemeinsam. Wichtig werden Fragen des unterschiedlichen Wiedererinnerns (des Abrufs), die später (etwa von Bredenkamp und Wippich, 1977) als Kontext-bezogen, also vom Prozess der Einübung/Speicherung abhängig, ausgemacht werden. Die Unterscheidung der Gedächtnisarten wird verfeinert. Holzkamp hält die von Tulving (1972) gemachte Differenzierung zwischen episodischem und semantischem Gedächtnis für die relevanteste (124). Sie erlaube es, Gedächtnisteile, die an bestimmte Ereignisse/Orte gekoppelt sind, von solchen zu unterscheiden, die sich semantischen Netzwerken (sprachliche, logische und axiomatische Ordnungen) verdanken. In dieser Weise sollen unterschiedliche Wissenssysteme in ihrer Bindung an Gedächtnisleistungen erforschbar sein. „Als dem episodischen Gedächtnis zugehörig gelten Gedächtnisinhalte, die sprachliche Repräsentanzen jeweils bestimmter, raumzeitlich bzw. geographisch-historisch fixierbarer Ereignisse darstellen, bei denen der Einprägungsvorgang lokalisiert werden kann: Ich habe dich das letzte mal vor 3 Jahren in Kopenhagen gesehen (was impliziert, daß ich mir damals an diesem Ort eingeprägt habe, was ich heute erinnern kann). Im semantischen Gedächtnis dagegen sollen nicht Repräsentanzen konkreter Ereignisse, sondern Repräsentanzen begrifflicher Strukturen oder Ordnungen gespeichert sein, wobei der Zusammenhang zwischen diesen Repräsentanzen nicht im raumzeitlichen Bezugssystem, sondern nach Regeln, Formeln, Algorithmen hergestellt ist, die über die aufgenommene Information hinausgehende Inferenzen, Schlußfolgerungen enthalten bzw. gestatten. So habe ich mir das Statement »ein physischer Gegenstand 2 3 kann sich nicht gleichzeitig an verschiedenen Orten befinden« niemals für sich genommen eingeprägt, kann es aber dennoch über Inferenzaktivitäten jederzeit aus meinem semantischen Gedächtnis abrufen. Aber auch einfache sprachliche Über- und Unterordnungen, wie »Löwen sind Säugetiere« oder »ein Mann ist ein männlicher Mensch«, haben keine »episodische«, sondern eine »semantische« Struktur, gehören also nicht zu meinem anschaulichen »Weitwissen«, sondern zu meinem »propositionalen« (aussagebezogenen) Wissen als Grundlage (und Resultat) von Denkaktivitäten aller Art (vgl. Bower & Hilgard 1984, S.258f). In Abhängigkeit von der somit unterstellten unterschiedlichen Struktur des episodischen und semantischen Gedächtnisses werden für beide auch unterschiedliche Arten von Wiedererinnerns- bzw. Abrufvorgängen zur Aktualisierung der jeweiligen Repräsentanzen angenommen: Mit Bezug auf »episodisch« gespeicherte Repräsentanzen soll das Erinnern in raumzeitlich orientierten Suchprozessen bestehen (warte mal, 1984 waren wir in Norwegen in Ferien, danach bin ich krank geworden, seitdem waren wir nicht mehr weg, also muß der Österreich-Urlaub früher gewesen sein). Beim Erinnern von Repräsentanzen im semantischen Gedächtnis dagegen bewege man sich innerhalb der dort »abgelegten« sprachlichen, logischen, axiomatischen Ordnungen hin und her, um schließlich den Schnittpunkt im Wissenssystem zu finden, der jeweils konkret »gefragt« ist.“ (124f) Die Bezüge zur Linguistik schließlich brachten die Unterscheidung in propositionales (gewusst, dass) und prozedurales (gewusst, wie) Gedächtnis, eine Differenz, die es schließlich erlaubte, die Gedächtnisarten nicht nur hierarchisch anzuordnen, sondern auch das Erlernen von Bewegungen wenigstens ansatzweise in das Gedächtniskonzept aufzunehmen. Eine weitere Forschungsannahme, die »der alternativen Modellierung von Gedächtnisprozessen« (126f) (durch Craik und Lockart, 1972) schlug schließlich vor, die Gedächtnisleistung als abhängig vom Verarbeitungsprozess zu untersuchen. Die Art, wie der Gegenstand ins Gedächtnis kam (sensorisch, phonetisch, semantisch und wie intensiv), und nicht, in welchem Behälter er landete (Kurzzeit oder Langzeit), soll die Gedächtnisleistung bestimmen. „Eine in diesem Zusammenhang charakteristische experimentelle Untersuchung (mit zehn Einzelexperimenten) stammt von Craik & Tulving (1975): Hier bot man den Versuchspersonen eine Liste mit Wörtern kurzzeitig dar, wobei vor der Darbietung jedes Wortes eine darauf bezogene Frage gestellt wurde. Als wesentliche unabhängige Variable diente die Variation der Fragen hinsichtlich der damit zu induzierenden Verarbeitungstiefe (>depth of semantic involvement>, S.268) bei der Kodierung der jeweiligen Wörter: Eine sensorische Analyse des jeweiligen Wortes sollte durch Fragen über dessen physische Struktur (ist das Wort in Großbuchstaben gedruckt?) induziert werden; eine phonemische Analyse durch Fragen über die Reim-Charakteristik (reimt sich das Wort auf »train«?); eine semantische Analyse durch kategoriale Fragen (ist das Wort ein Tiername?) oder durch Satzergänzungs-Fragen (paßt das Wort in den Satz »the girl placed the — on the table«?). Nach einer langen Serie von derartigen Fragen mit anschließenden Wortdarbietungen (wobei jeweils die Hälfte der Fragen mit Ja bzw. mit Nein zu beantworten waren) wurden die Vpn (mit verschiedenen »Gedächtnismethoden«) einer für sie unerwarteten Behaltensprüfung unterzogen. Als allgemeines Resultat ergab sich dabei, daß die Versuchspersonen bei den >tieferen< Kodierungsformen sowohl längere Zeit zur Einprägung brauchten wie in der Behaltensprüfung zu besseren Resultaten kamen. Um die Frage zu beantworten, wieweit nur die längere Dauer der Kodierungsphase oder tatsächlich die wachsende Verarbeitungstiefe zu den besseren Behaltensleistungen geführt hatte, wurden u.a. in einem weiteren Experiment Bedingungen hergestellt, unter denen komplexere sensorische Kodierungsaufgaben längere Zeit in Anspruch nahmen als leichtere 3 4 semantische Kodierungen, wobei sich ergab, daß dennoch auf dem semantischen Verarbeitungsniveau bessere Behaltensleistungen erzielt wurden etc. Als eine Quintessenz aus ihren (hier nur ausschnitthaft dargestellten) Untersuchungen heben die Autoren heraus: »All these studies conform to the new look of memory research in that the stress is on mental operations, items are remembered not as presented stimuli acting on the organism, but as components of mental activity. Subjects remember not what was ‘out there‘ but what they did during encoding« (S.292).” (128) „Demnach wäre die Verarbeitungstiefe eher ein Kontinuum mit qualitativen Umschlägen von einer Ebene zur nächst höheren. Generell wird dabei angenommen, dass es von der so gefassten Tiefe der Informationsverarbeitung abhängig sei, wie stark sich die jeweilige Gedächtnisspur ausprägt, wie lange also die entsprechende Information behalten wird.“ (128) Wichtig wird in diesem Kontext schließlich auch der Faktor der Aufmerksamkeit und ihrer Zuwendung fürs Behalten sowie die Frage der Wiederholung. Craik schlägt 1985 vor, das Gedächtnis nicht als strukturelles System, sondern als Prozess des Sich-Erinnerns aufzufassen, der von Reiz, Kontext und Vorwissen geleitet sei. „Dieser Erinnerungsprozess sei als eine Rekapitulation der ursprünglichen Erfahrung aufzufassen, wobei es von der Art der jeweiligen Erinnerungsaufgabe abhänge, wieweit sich diese Rekapitulation in einem relativ »wörtlichen« Durchgang durch die erfahrenen Ereignisse oder als Rekonstruktion aufgrund Information höherer Ordnung, die aus der Erfahrung abstrahiert worden ist, vollziehe.“ (130) Sich-Erinnern sei aktiver Vollzug mit Rekonstruktionsstrategien zur Bewältigung der Erinnerungsaufgabe. Diese Forschungsannahmen zeigten sich den Mehrspeicher-Modellen zunächst überlegen. Da aber die Versuche Gedächtnis in Schichten der Verarbeitung zu denken, wiederum die Probleme der Mehr-Speichertheorie insofern nicht überwinden konnten, als sie ebenso wie dieses die immer differenzierter werdenden Datenmengen wenig einheitlich erklären konnten, wurde seit Beginn der achtziger Jahre praktisch das Mehrspeicher-Modell aktualisiert (vgl. etwa Anderson 1983). Im Zusammenhang mit der Computersimulation psychischer Prozesse stand eine neue Arbeitsrichtung - der Konnektionismus (vgl. etwa McClelland u.a. 1986). Der Grundgedanke ist die Annahme von Netzwerken, welche Daten empfangen, und anderen, die sie aussenden, also eine Interaktion mit jeweiligen Umgebungen. Fehlerminimierung wird in diesem Kontext als Lernen bezeichnet (132). Holzkamp überprüft die kognitivistischen Gedächtnistheorien mit seinem »Begründungsmuster-Konzept« und kommt zu dem ersten Ergebnis, dass alle diskutierten Ansätze, da sie zur Bewältigung bestimmter Aufgaben konstruiert wurden, entsprechend über Begründungsmuster verfügen; andererseits eine Überprüfung schwer falle, da sie allesamt ohne Subjekte (Akteure) formuliert seien. Dies nachzutragen wird erster Kritikschritt. Er entdeckt, dass Lösun4 5 gen, die Subjekte in das System zu denken, das »wirkliche individuelle Subjekt mystifizieren« (135). „Die Tendenz zu einer solchen Mystifizierung des Handlungssubjekts muß dann noch begünstigt werden, wenn man bereits die Operationen des realen Computers derart versprachlicht, daß dieser in quasi animistischer Weise als selbständiges »Subjekt« seiner Operationen erscheint, also schon auf dieser Ebene dessen »Mittel«-Charakter verloren geht, womit das dergestalt konstituierte Computer-Subjekt mit der metaphorischen Fassung des Computers als Modell menschlicher Kognition unmittelbar in das Individuum »hineinwandert«. So charakterisiert etwa Bower die gängige Verwendung der Computer-Sprache, in welcher seiner Auffassung nach »äußerst attraktive Metaphern und Analogien für psychologische Deutungsversuche« angeboten werden, um deren »Nutzen« zu verdeutlichen, auf folgende Weise: »Man sagt von programmierten Maschinen, daß sie Stimuli entdecken, identifizieren, vergleichen und klassifizieren; daß sie Informationen speichern und wieder abrufen; daß sie lernen und Fragen beantworten; daß sie denken, Probleme lösen und über die Verwendung von Strategien entscheiden usw. Weil wir die ‚Mechanik‘ dessen sehen können, wie diese Prozesse im Computerprogramm ausgeführt werden, glauben wir, daß wir jetzt verstehen, wie richtige Organismen diese Dinge tun, die wir mit den angegebenen Namen bezeichnen« (Bower & Hilgard 1984, S.215). Die auf diesem Wege vorerst noch implizit vollzogene Hineinverlagerung des Computer-Subjekts in das Individuum, damit Eliminierung des wirklichen Handlungssubjekts aus der Wissenschaftssprache, wird mit aller Klarheit offenbar, wenn Bower aus seinen Überlegungen die Konsequenz zieht: »So ist das kognitive System in der Lage, sich selbst für erfolgreiche Anpassungen und Handlungen in seiner Umwelt zu programmieren« (a.a.O., S.227). In dieser Modellvorstellung vom sich selbst programmierenden Computer, worin der Computer vom Hilfsmittel des Menschen zur mythischen »causa sui« stilisiert wird (also die Computer-Metapher sich quasi selbst aufhebt), verdichten sich in besonders zugespitzter Weise gängige kognitivistische Denk- und Redeweisen, in welchen »informationsverarbeitende Systeme« oder Untersysteme animistisch als Subjekte ihrer eigenen Operationen angesehen werden und so der metaphorische Computer mit allerlei Homunculi bevölkert ist, die »von innen« dessen Anwendungsarten, die Wechselwirkung seiner Teilsysteme u.ä., planen und realisieren. Diese Homunculus-Annahme ist in den Anfängen des Kognitivismus gelegentlich offengelegt, problematisiert, aber auch (so von Attneave, 1961, in einem Artikel »In defence of homunculi«) verteidigt worden. In der Sprache der heutigen Kognitiven Psychologie dagegen ist die »Homunculisierung« von Systemkomponenten vielerorts mehr oder weniger unhinterfragt gang und gäbe, wobei oft - besonders wenn nicht theoretische Modelle diskutiert, sondern die Aktivitäten von Versuchspersonen im Experiment interpretiert werden - damit vermischt auch Formulierungen antreffbar sind, in denen von wirklichen Individuen als Ursprung der Systemoperationen die Rede ist - dies als Ausdruck der prinzipiellen Unklarheit darüber, wo und was in der kognitivistischen Theorie eigentlich das »Subjekt« sei.“ (135f) Wichtig werde (nach Herrmann 1982), ob man den Kognizierenden als System (mit Speichern etc.) fasse oder als handelndes Individuum, welches interpretiere, Ziele setze und bewerte (136). Sein Vorhaben, den »realen Subjektstandpunkt« zu rekonstruieren, führt Holzkamp zu dem Ergebnis, dass zum einen in der Entwicklung der Theorien selbst - vom Mehrspeicher zur Verarbeitungsebenentheorie - eine Wendung zum Subjekt vollzogen worden sei, wodurch sich die konzeptuelle Überlegenheit Letzterer erkläre, zugleich die Computer-Analogie und die neueren Versuche der Wiedereinsetzung von Homunkuli in die kognitivistische Sprache zum anderen als Rollback einzustufen wären. 5 6 Nach den diskutierten Schwierigkeiten, das denkende Subjekt in der kognitivistischen Theorieebene einzuführen, fährt Holzkamp fort, die implizite Einbeziehung der Subjekte in die kognitivistische Sprache heraus zuarbeiten, und kommt zu dem Ergebnis, dass hier ähnlich wie in der SR-Theorie die verdinglichenden Bezeichnungen der Alltagssprache in die Theoriebildung eingegangen sind. Etwa, wenn das Gedächtnis als Ursache der Behaltensleistung behauptet wird (ich habe ein schlechtes Gedächtnis, 139). Damit werden die Begründungszusammenhänge der Gedächtnisleistungen selbst verstellt. Er weist darauf hin, dass ebendiese Unterlassung bzw. Verstellung die Hinzufügung immer weiterer Zusatzannahmen nötig machte (Kurzzeitspeicher, Ultrakurzspeicher, prozeduraler und deklarativer Speicher etc.). Nimmt man diese Mystifizierungen des Handlungssubjekts zurück, werde klar, dass die genannten Konzepte in Wahrheit von unterschiedlichen Suchstrategien der Subjekte handeln, deren diese sich »vernünftigerweise« bedienen. Soweit es sich um quasi automatische Prozesse ohne Bewusstheit handele, gälte der gleiche Einwand wie bei den Konditionierungsprozessen beim SR-psychologischen Experiment, womit aber die beabsichtigte Rehabilitation des Bewusstseins, mit dem die kognitive Psychologie angetreten ist, wieder zurückgenommen sei. Aufgrund der Nähe des Gedächtnisbegriffs zu Vorstellungen von Behältnis oder Speicher schlägt Holzkamp vor, von Behalten und Erinnern als menschlichen Handlungen zu sprechen (141). In der traditionellen Gedächtnisforschung werden Behalten und Erinnern als voneinander abhängig gefasst - wobei das Behalten an erster Stelle, das Erinnern, Abrufen, in die davon abhängige Position rückt (142). Behalten und Erinnern treten als Wenn-DannKomponenten in einem kontingenten Zusammenhang auf. Die Prozesse sind also zugleich unabhängig voneinander; dies werde z.B. deutlich in Konzepten des Lernens bzw. Einprägens mit Wiederholung, wobei die Wiederholung als Maß des Lernens genommen wird. (Man erinnere das Experiment mit den sinnlosen Silben, die so oft wiederholt werden, bis man sie fehlerfrei nachsagen kann.) Der allgemeine theoretische Rahmen ist die Spurenbildung im Gehirn. »Die jeweiligen Assoziationen bzw. Spuren bilden sich unabhängig vom Erinnerungsprozess« (143). Holzkamp hingegen fügt den Prozess des Behaltens in den Begründungsdiskurs und kommt zu dem Resultat, dass die Behaltensaktivitäten darin begründet sind, ob man erinnern will, es sich also um eine »inferenziell-implikative Beziehung« handele und nicht um eine kontingent-empirische. Behaltensintentionen ohne antizipierte Erinnerungsanforderung sind vom Subjektstandpunkt offensichtlich sinnlos; bzw., noch weiter zugespitzt, die Behaltensintention ist in gewisser Weise mit der Intention, mich später an das Behalten erinnern zu wollen, identisch. (143) 6 7 Das Subjekt braucht Gründe fürs Lernen. Miller, Galanter & Pribram (1960) haben die Diskrepanz zwischen dem, was der Experimentator annimmt, und dem, was die Versuchsperson tut, vorgewiesen, indem sie selbst von einer Intentionalität bzw. einem Plan ausgehen, Annahmen, die zur Formulierung vom Standpunkt des Subjekts befähigen. “»Ordinarily the simplest way to find out what a person is doing is to ask him« (S.126). Gerade dieses Fragen werde aber von den Psychologen aus Gründen methodischer »Objektivität« eliminiert. Wenn man jedoch eine Vp danach frage, was sie in den traditionellen, mit sinnlosen Silben durchgeführten Untersuchungen getan habe, so stelle sich heraus, daß diese, um die ihnen aufgetragene Aufgabe des »memorizing« erfüllen zu können, notwendig die Absichten des Experimentators durchkreuzen müsse, indem sie versucht, die sorgfältig ausgesuchten »sinnlosen Silben« dennoch in einen sinnvollen Zusammenhang zu bringen: »Well, it wasn‘t easy, but he did it« (S.126). Miller, Galanter & Pribram bringen dafür mannigfache Beispiele aus ihrer experimentellen Arbeit und verallgemeinern diese mit der Feststellung, daß die Vpn dabei »two different kinds of plans« ausführen müßten: »On the one hand, the subject is attempting to construct a Plan that will, when executed, generate the nonsense syllables in the correct order. But at the same time he must adopt a Plan to guide his memorizing, he must choose a strategy for constructing the Plan for recall« (S.128). Dafür stünden der Vpn verschiedene Wege offen: Sie könnten z.B. die sinnlosen Silben in Worte übersetzen, diese in Sätze einordnen und aus diesen eine Geschichte erfinden, um bei der geforderten Wiedergabe (als seriellem Lernen) den gleichen Weg rückwärts zu gehen und so die korrekte Reihenfolge der Silben rekonstruieren zu können. Ein anderer möglicher Plan bestehe in der rhythmischen Gruppierung der Silben, ein wieder anderer darin, die Silben in einem imaginären Raum anzuordnen und beim Erinnern jeweils dahin zu »blicken« und die Reihenfolge der Silben dort »abzulesen«, wo sie »stehen« (S.128f). Dies wird von Miller, Galanter & Pribram in folgender Weise verallgemeinert auf den Begriff gebracht: »Unless a person has some kind of Plan for learning, nothing happens. Subjects have read nonsense syllables hundreds of times and learned almost nothing about them if they were not aware that they would later be tested for recall. In order to get the list memorized, a subject must have that mysterious something called an ‚intent to learn‘. An intention to learn means that the subject executes a Plan to form a Plan to guide recall«. Solche Pläne mögen, so Miller, Galanter & Pribrarn, u.U. lediglich fragmentarischer Natur sein, mehr oder weniger »absent minded« und zufällig erfolgen, wobei die Vpn also auch ohne eindeutige und bewußte Intentionen einiges lernen könnten (s.u.): »The important thing« sei jedoch »to have a Plan to execute for generating the recall response; ordinary, but not invariably, that Plan will not be achieved without intend to learn, that is to say, without a metaplan for constructing a Plan that will guide recall« (S.129)” (144) Die Einzelnen brauchen also eine Lernabsicht. (...)Das Konzept der Behaltens-ErinnernsAktivitäten gehört gewiss zum Lernen; aber es wird ein bestimmter Aspekt des Lernens hervorgehoben, die Dauerhaftigkeit des Lernresultats. Bei intentionalem Lernen gibt es die Möglichkeit, dass die Lernintention auf das Behalten selbst oder auf andere Dimensionen (etwa Können oder Verstehen) gerichtet ist. Damit wäre Gedächtnisforschung ein Spezialfall der Lernforschung, was faktisch in der Forschungstradition nicht gesehen werde. Holzkamps weitere Kritik gilt der Nicht-Einlassung der Gedächtnisstrategien in sachlich-soziale Bedeutungszusammenhänge, mithin ihrer Zentrierung auf mentale Prozesse. An die Stelle von Welt trete Weltwissen und statt Praxiszusammenhängen gebe es Wissensdomänen (148f). Das Subjekt 7 8 ist in sprachlicher Bedeutung gefangen, es führt kein Weg in die praktische Lebenswelt. Es gibt nur Informationen, ihre Einspeisung und ihren Abruf durch entsprechende Hirne. Die Welt erscheint als Inbegriff von Gegebenheitszufällen, deren Verknüpfung dem Individuum obliegt, wie schon in der SR-Theorie. Das verbindende Theorem ist das Assoziationsprinzip als strukturbildender Faktor. Das findet seinen zusammenfassenden Ausdruck in der Fassung des Gedächtnisses als »associative memory« durch Kohonen (1984). „Aus der Erörterung der kognitivistischen Gedächtnisforschung ließ sich verallgemeinern, dass hier der »input« und der »output«, also die Eingabe- und Ausgabefunktion des »Systems«, an die Stelle der unabhängigen Lebenswelt tritt, und dass dabei die Sprache (i.w.S.) quasi als undurchdringliche Mauer zwischen dem Subjekt und der Außenwelt steht.“ (151) Die Frage bleibt: Wie ist die Weltlosigkeit der traditionellen Lerntheorien zu überwinden? Holzkamp stößt bei seiner Suche nach dem Subjekt auch in den kognitivistischen Lerntheorien, wie erwartet, auf eine Leerstelle. Dort, wo durch die Einführung der Bewusstseinskategorie denkende Akteure hätten auftauchen müssen, findet stattdessen eine Art Substitutionsprozess statt. Dinge, Speicher, Behältnisse, Systeme übernehmen Akteursaufgaben. Wie bei der SR-Theorie erscheint Welt als Zufallsgegebenheit. Die Schwierigkeit, unter diesen Umständen Gedächtnisleistungen einigermaßen konsistent denken zu wollen, treibt die Theoriebildung zu immer neuen Zusatzannahmen. Dabei gerät sie auch von mehr dinglichen zu mehr aktivitäts- und prozessorientierten Vorstellungen, ohne jedoch grundlegend vom Standpunkt des Subjekts zu formulieren bzw. den aus dem Subjektstandpunkt folgenden Zusammenhang zur Welt zu fassen. Dies stellt Holzkamp als dritte Kritik seines Analyseverfahrens vor: Dem Subjektverlust entspricht ein ebensolcher Verlust an Welt. 8