Skript

Werbung

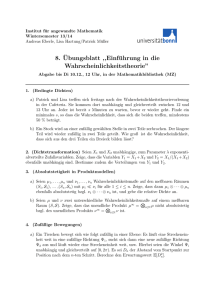

Einführung in die

Wahrscheinlichkeitstheorie

Thomas Richthammer

Vorlesung an der TUM im WS 2011/2012

12. März 2012

Inhaltsverzeichnis

1 Wahrscheinlichkeitsräume

1.1 Einführende Beispiele . . . . . . . .

1.2 Axiomatische Beschreibung . . . .

1.3 Wahl des Wahrscheinlichkeitsraums

1.4 Diskrete Wahrscheinlichkeitsmaße .

1.5 Stetige Wahrscheinlichkeitsmaße . .

1.6 Verteilungsfunktion . . . . . . . . .

.

.

.

.

.

.

3

3

4

6

7

10

12

2 Zufallsvariablen

2.1 Verteilung einer Zufallsvariable . . . . . . . . . . . . . . . . . . . . . .

2.2 Simulation von Zufallsvariablen . . . . . . . . . . . . . . . . . . . . . .

2.3 Transformation von Zufallsvariablen: . . . . . . . . . . . . . . . . . . .

14

14

17

18

3 Bedingte Wahrscheinlichkeiten und Verteilungen

3.1 Bedingte Wahrscheinlichkeiten . . . . . . . . . . . . . . . . . . . . . . .

3.2 Bedingte Verteilungen . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.3 Unabhängigkeit . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

21

21

23

24

4 Erwartungswert

4.1 Erwartungswert . . . . . . . . . . . . .

4.2 Kovarianz und Varianz . . . . . . . . .

4.3 Verwendung von Indikatorfunktion und

4.4 Momentenerzeugende Funktionen . . .

.

.

.

.

27

27

29

32

34

5 Beispiele für Zufallsvariablen

5.1 Zufällige Ereignisse in diskreter Zeit . . . . . . . . . . . . . . . . . . . .

5.2 Zufällige Ereignisse in stetiger Zeit . . . . . . . . . . . . . . . . . . . .

5.3 Normalverteilung . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

35

35

37

39

6 Grenzwertsätze

6.1 Gesetz der großen Zahl . . . . . . . . . .

6.1.1 Schwaches Gesetz der großen Zahl

6.1.2 Starkes Gesetz der großen Zahl .

6.2 Zentraler Grenzwertsatz . . . . . . . . .

43

43

43

44

46

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

. . . . . . . .

. . . . . . . .

Bedingungen

. . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1 Wahrscheinlichkeitsräume

3

Vorwort

Dieses Skript ist eine Weiterentwicklung des Skriptes zur Vorlesung “Einführung in

die Wahrscheinlichkeitstheorie” vom Wintersemester 2010/11. Besonderer Dank geht

an die Studenten R. Hager, P. Hoffmann und A. Leitner, die eine erste Version dieses

Skripts geTEXt haben, und an alle Studenten der Vorlesung, die mich auf Fehler im

Skript hingewiesen haben.

Zur Verwendung des Skripts im Wintersemester 2011/12: Das Skript enthält im Wesentlichen alles, was in der Vorlesung besprochen wurde, abgesehen von Bildern und

Skizzen.

1

Wahrscheinlichkeitsräume

1.1

Einführende Beispiele

Viele Vorgänge des täglichen Lebens sind mit einer gewissen Unsicherheit behaftet. Beispiele hierfür sind Wettervorhersage, Lotto, Aktienkurse, die Ausbreitung von Krankheiten, das Verhalten großer Teilchenmengen (Physik), das Verhalten großer Menschenmassen z.B. bei Panik, die Wartezeit in Warteschlangen, u.s.w.

Die Wahrscheinlichkeitstheorie, ein Teilgebiet der Stochastik, dient zur mathematischen

Beschreibung solcher Phänomene. Diese Vorlesung soll eine erste Einführung in dieses

Gebiet vermitteln.

Ziel der Vorlesung ist:

• die präzise Beschreibung unsicherer Situationen,

• die Quantifizierung des Zufalls,

• Gesetzmäßigkeiten zu erkennen und zu erklären.

Betrachten wir zunächst ein paar einfache konkrete Situationen:

(a) Einmaliges Werfen eines Würfels. Diese Situation wird komplett beschrieben

durch die Menge der möglichen Ergebnisse {1, 2, 3, 4, 5, 6}, sowie deren Wahrscheinlichkeiten:

Ergebnis

1 2 3 4 5 6

Wahrscheinlichkeit 16 16 16 16 16 16

(b) Zufällige Bruchstelle einer Fahrzeugachse (der Länge 1). Die Menge der möglichen

Bruchstellen kann beschrieben werden durch [0, 1]. Dass die Achse exakt an einer

festen Stelle x ∈ [0, 1] bricht, z.B. x = 0.233517..., ist extrem unwahrscheinlich

(d.h. dies hat Wahrscheinlichkeit 0). Die Angabe der Einzelwahrscheinlichkeiten

ist daher zur Beschreibung der Bruchstelle ungeeignet. Sinnvoll dagegen ist z.B.

die Betrachtung der Wahrscheinlichkeit für einen Bruch in [0, 12 ]. Aus Symmetriegründen würde man hierfür annehmen, dass diese Wahrscheinlichkeit 12 ist.

1.2

Axiomatische Beschreibung

4

(c) Schadensfälle einer Versicherung. Ein mögliches Ergebnis wäre hier z.B. durch

die Angabe der Zeitpunkte aller Schadensfälle bestimmt. Sinnvoll wäre hier z.B.

die Betrachtung der Wahrscheinlichkeit dafür dass in einem gewissen Zeitraum 3

Schadensfälle stattfinden, oder dafür dass zwischen 2. und 3. Schadensfall höchstens 2 Tage liegen.

Diese Beispiele sollen zeigen, dass es zur Beschreibung eines probabilistischen Sachverhalts oft nicht ausreicht, die Wahrscheinlichkeiten aller möglicher Einzelergebnisse zu

betrachten. Stattdessen sollten besser Mengen von Ergebnissen (sogenannte Ereignisse)

betrachtet werden. Im nächsten Abschnitt beschreiben wir zufälliges Verhalten durch

eine Funktion, die jedem Ereignis (das für uns interessant ist) seine entsprechende

Wahrscheinlichkeit zuordnet.

Bemerkung: Die Wahrscheinlichkeitstheorie gibt keine Antwort auf die Frage: Was

ist Zufall? Diese Frage ist Gegenstand der Philosophie (vgl. naive, frequentistische,

subjektive Interpretation). Die Mathematik soll unabhängig von der Interpretation

von Wahrscheinlichkeit funktionieren.

1.2

Axiomatische Beschreibung

Für die Beschreibung einer Situation mit Unsicherheit (=Zufallsexperiment) soll ein

mathematisches Modell verwendet werden, bestehend aus:

• Ω = Menge aller Ergebnisse (d.h. aller möglichen Ausgänge des Experiments).

• F = Menge aller Ereignisse, die wir zur Beschreibung des Experiments verwenden

wollen. Ein Ereignis ist hierbei eine gewisse Menge von Ergebnissen, d.h. eine

Teilmenge von Ω.

• P = Abbildung, die jedem Ereignis eine Wahrscheinlichkeit zuordnet.

Einige Eigenschaften sollten Ω, F, P sinnvollerweise grundsätzlich haben, unabhängig

von der Art des betrachteten Zufallsexperiments. Diese werden in einer axiomatischen

Definition zusammengefasst:

Definition:

• Ein Mengensystem F ⊂ P(Ω) heißt σ-Algebra auf Ω 6= ∅, falls

(S1) Ω ∈ F

(S2) Für jedes A ∈ F ist auch Ac (= Ω − A) ∈ F.

S

(S3) Für beliebige Ai ∈ F, i ∈ I (mit I abzählbar), ist auch i∈I Ai ∈ F.

• Eine Abbildung P : F → [0, 1] heißt Wahrscheinlichkeitsmaß auf (Ω, F) falls:

(P1) P (Ω) = 1

S

P

(P2) Für disjunkte Ai ∈ F, i ∈ I (mit I abzählbar), ist P ( i∈I Ai ) = i∈I P (Ai ).

• Die Menge Ω 6= ∅ heißt Ergebnisraum. Ist F eine σ-Algebra auf Ω, so heißt (Ω, F)

Ereignisraum. Ist P ein Wahrscheinlichkeitsmaß auf (Ω, F ), so heißt (Ω, F, P )

Wahrscheinlichkeitsraum.

1.2

Axiomatische Beschreibung

5

Bemerkung:

• (P1) = Normiertheit (Ω enthält mit Sicherheit alle möglichen Ergebnisse)

(P2) = σ-Additivität (vgl. Massenfunktion)

• Warum statt F nicht einfach ganz P(Ω)?

Dann ist Forderung (P2) zu stark (→ Banach-Tarski-Paradox)

• Warum Abzählbarkeit?

Sonst

S

P Probleme z.B. bei “zufälliger Bruchstelle”:

P ([0, 1]) = P ( x {x}) = x P ({x}) = 0

• Warum nicht einfach nur für endliche I?

Unendliche I nötig für Betrachtung von Grenzprozessen

• (S1) nötig für (P1), (S3) nötig für (P2)

(S2),(S3): Abgeschlossenheitsaxiome: Bestimmte Mengenoperationen auf Ereignissen ergeben wieder Ereignisse

Bemerkung: Alle Mengenoperationen lassen sich auf Komplementbildung

und

S VereiT

c

c c

c

nigung zurückführen, z.B. A ∩ B = (A ∪ B ) , A − B = A ∩ B , i∈I Ai = ( i∈I Aci )c ,

daher gilt für eine σ-Algebra:

• ∅ = Ωc = Ω − Ω ∈ F

• Für A, B ∈ F ist auch A − B ∈ F

• Für Ai ∈ F, i ∈ I (mit I abzählbar) ist auch

T

i∈I

Ai ∈ F

Aus (P1) und (P2) folgen viele weitere Eigenschaften von Wahrscheinlichkeitsmaßen.

Satz: Sei P ein Wahrscheinlichkeitsmaß auf (Ω, F), und seien A, B, Ai ∈ F.

(a) Additivität: A ∩ B = ∅ ⇒ P (A ∪ B) = P (A) + P (B)

insbesondere: P (Ac ) = 1 − P (A)

(b) Monotonie: A ⊂ B ⇒ P (B) = P (A) + P (B − A)

insbesondere: A ⊂ B ⇒ P (A) ≤ P (B)

(c) σ-Stetigkeit:

S

An ↑ A (d.h. A1 ⊂ A2 ⊂ A3 ... mit Tn An = A)

An ↓ A (d.h. A1 ⊃ A2 ⊃ A3 ... mit n An = A)

(d) Ein-/Ausschluß-Formel: P (

n

S

Ai ) =

i=1

d.h. P (A1 ∪ A2 ∪ ... ∪ An ) =

n

P

i=1

n

P

⇒

⇒

(−1)k+1

k=1

P (Ai ) −

P (An ) ↑ P (A)

P (An ) ↓ P (A)

P

J⊂{1,...,n}:|J|=k

P

P(

T

Aj ),

j∈J

P (Ai ∩ A2 ) + ...,

1≤i1 <i2 ≤n

also insbesondere P (A ∪ B) = P (A) + P (B) − P (A ∩ B)

Beweis:

(a) Additivität folgt aus (P2), mit B := Ac folgt der Rest.

(b), (c): Hausaufgabe, (d) beweisen wir später.

1.3

Wahl des Wahrscheinlichkeitsraums

1.3

6

Wahl des Wahrscheinlichkeitsraums

Bemerkung:

• Vor der Bearbeitung eines Problems sollte immer zuerst das verwendete Modell

angegeben werden, d.h. der zugrundeliegende Wahrscheinlichkeitsraum (Ω, F, P ),

sowie die Interpretation eines Ereignisses x ∈ Ω.

• Die Wahl des Modells kann nicht mathematisch begründet werden (aber manche

Modelle sind plausibler als andere).

• Verschiedene Modelle können zum gleichen Ziel führen.

Der Ergebnisraum Ω sollte alle möglichen Ergebnisse enthalten. Der Grad der Vereinfachung hängt davon ab, an was genau man interessiert ist.

Beispiel: Einmaliges Würfeln. Mögliche Ergebnismengen sind:

(a) Ω = (R3 )N mit N := Anzahl der Atome des Würfels

(x1 , ..., xN ) ∈ Ω: xi := Position des i-ten Atoms nach dem Wurf in R3

Problem: Wahl von P ist kompliziert, die Lage jedes einzelnen Atoms interessiert

normalerweise gar nicht!

(b) Ω = {1, 2, ..., 6, 0} wobei 0 = unklarer Ausgang, z.B. Würfel bleibt auf Kante

stehen. Normalerweise wird 0 einfach ignoriert. Dies führt zu:

(c) Ω = {1, ..., 6}. Hier beschreibt x ∈ Ω die Augenzahl.

(d) Ω = {0, 1} mit 0 = “gerade Augenzahl”, 1 = “ungerade Augenzahl”

Problem: Ereignis “Augenzahl ist 4” kann nicht beschrieben werden!

Bei der Wahl des Ereignisraumes legt man in der Regel zunächst fest, welche Art von

elementaren Ereignissen auf jeden Fall betrachtet werden sollen.

Definition: Für ein gegebenes Mengensystem S ⊂ P(Ω) bezeichne σ(S) die kleinste

σ-Algebra, die S enthält. Ist σ(S) = F, so heißt F die von S erzeugte σ-Algebra, und

S heißt Erzeuger von F.

Bemerkung: Die kleinste σ-Algebra, die S enthält, kann man explizit konstruieren:

Sei F der Durchschnitt aller σ-Algebren, die S enthalten. Dann ist F tatsächlich eine

σ-Algebra, die S enthält, und für jede weitere σ-Algebra F 0 , die S enthält, gilt F 0 ⊃ F.

Beispiel:

• Falls Ω abzählbar ist (z.B. endlich), wählt man in der Regel S = {{ω} : ω ∈ Ω}.

Man erhält dann σ(S) = P(Ω) (denn jede Teilmenge ist abzählbare Vereinigung

von 1-elementigen Mengen).

1.4

Diskrete Wahrscheinlichkeitsmaße

7

• Falls Ω ein topologischer Raum ist (z.B. Rn oder eine Teilmenge davon), wählt

man in der Regel S als das System aller offenen Mengen. Man erhält dann σ(S) =:

BΩ , die sogenannte Borel-σ-Algebra.

Bemerkung:

• Oft ist Ω = R, F = BR =: B. Es gilt B =

6 P(R), aber B enthält alle Mengen, die

man in gewisser Weise “sinnvoll definieren” kann.

• B hat neben der Menge der offenen Mengen noch weitere nützliche Erzeuger, z.B.

S 0 := {(−∞, c] : c ∈ R} oder S 0 := {[a, b] : a ≤ b ∈ R}.

Die Betrachtung von Erzeugern hat einen weiteren Vorteil:

Satz: (Eindeutigkeitssatz.) Seien P1 , P2 Wahrscheinlichkeitsmaße auf (Ω, F), und sei

S ⊂ P(Ω) ∩-stabil (d.h. A, B ∈ S ⇒ A ∩ B ∈ S) mit σ(S) = F. Ist P1 (A) =

P2 (A) ∀A ∈ S, dann gilt bereits P1 (A) = P2 (A) ∀A ∈ F, d.h. ein Wahrscheinlichkeitsmaß ist durch seine Werte auf S bereits eindeutig festgelegt.

Beweis: Maßtheorie.

Beispiel: Sei Ω = N, F = P(N) und P ein Wahrscheinlichkeitsmaß. S = {∅, {1}, {2}, ...}

ist ein ∩-stabiler Erzeuger von F. Dass P durch

seine Werte

S

P auf S eindeutig festgelegt

ist, sieht man hier auch direkt: P (A) = P ( x∈A {x}) = x∈A P ({x}).

Die Wahl eines geeigneten Wahrscheinlichkeitsmaßes ist in der Regel der schwierigste

Teil der Modellbildung. In der Vorlesung betrachten wir meist diskrete oder stetige

Wahrscheinlichkeitsmaße. Wie man diese konstruiert, wird in den nächsten beiden Abschnitten besprochen.

1.4

Diskrete Wahrscheinlichkeitsmaße

Ist Ω abzählbar, kann man ein geeignetes P definieren, indem man die Wahrscheinlichkeit aller Ergebnisse angibt:

Definition: Sei Ω abzählbar.

• Eine Funktion ρ : Ω → [0, 1] mit

P

ρ(x) = 1 heißt Zähldichte.

x∈Ω

• P (A) :=

P

ρ(x) heißt diskretes Wahrscheinlichkeitsmaß mit Zähldichte ρ.

x∈A

Bemerkung: P ist ein Wahrscheinlichkeitsmaß auf (Ω, P(Ω)), denn

(P1) ergibt sich aus Normiertheit,

(P2) aus dem verallgemeinertem Kommutativitätsgesetz

Das wichtigste Beispiel ist die diskrete Gleichverteilung.

1.4

Diskrete Wahrscheinlichkeitsmaße

8

Definition: Sei Ω endlich. Das Wahrscheinlichkeitsmaß auf (Ω, P(Ω)) mit Zähldichte

1

, x ∈ Ω heißt (diskrete) Gleichverteilung auf Ω : UΩ .

ρ(x) := |Ω|

Bemerkung: Ist P = UΩ die Gleichverteilung auf (Ω, P(Ω)), so ist

P (A) =

X

ρ(x) =

x∈A

X 1

|A| # betrachtete Ergebnisse

=

=

b

.

|Ω|

|Ω|

# mögliche Ergebnisse

x∈A

Beispiel: Man wähle rein zufällig eine Zahl aus N = {1, 2, 3, ...}. Mit welcher Wahrscheinlichkeit ist die Zahl gerade? (Vermutete Antwort: 12 .)

Lösung: Wahrscheinlichkeitsraum: Ω = N, F = P(N), A = {2, 4, 6, ...}. Was ist P ?

Wir verfolgen drei Ansätze:

(a) Da die Zahl rein zufällig gewählt werden soll, würden

P wir gerne eine Zähldichte ρ

wählen mit

P ρ(n) = c ≥ 0 konstant. Falls c = 0, so folgt n∈N ρ(n) = 0 6= 1. Falls c > 0,

6 1. In beiden Fällen ergibt sich ein Widerspruch zur

so folgt n∈N ρ(n) = ∞ · c = ∞ =

Normiertheitsbedingung. Wir sehen also, dass es keine Gleichverteilung auf N gibt!

(b) Wir wählen ein großes N und P = U{1,2,...,2N } . Hier gilt wie vermutet P (A) =

1

. (Aber die zufällige Zahl ist hier immer ≤ 2N .)

2

N

2N

=

(c) Wir wählen P mit Zähldichte ρ so dass ρ(n + 1) = 12 ρ(n) ∀n ∈ N. (Diese Wahl ist

1

1

natürlich etwas beliebig.) Es giltP

dann ρ(n) = P

ρ(n − 1) = . . . = 2n−1

ρ(1)∀n ∈ N, und

2

1

1

aus der Normiertheit folgt 1 = n∈N ρ(n) = n∈N 2n−1 ρ(1) = 1− 1 ρ(1) = 2ρ(1), d.h.

ρ(1) =

1

2

und somit ρ(n) =

P (A) =

X

n∈A

1

.

2n

2

Hieraus ergibt sich

ρ(n) =

X 1

X 1

1

=

=

2m

m

2

4

1−

m∈N

m∈N

1

4

1

−1= .

3

Wir stellen fest: Die Aufgabe ist schlecht gestellt. Es ist nicht klar, was “rein zufällig

in N” bedeutet.

Bemerkung: Die Formel P (A) = |A|

sieht leicht aus, aber es kann ziemlich schwierig

|Ω|

sein, die Anzahl der Elemente einer Menge richtig zu zählen!

Beispiel: Es wird drei mal gewürfelt. Bestimmen Sie die Wahrscheinlichkeiten der

Ereignisse A = “Summe = 5”, B = “6 dabei”, C = “jeder Wert mehr als vorher”.

Lösung: Wahrscheinlichkeitsraum: Ω = {1, ..., 6}3 = {(x1 , x2 , x3 ) : xi ∈ {1, ..., 6}}

(mit xi = Ergebnis im i-ten Wurf), F = P(Ω), P = UΩ . Es gilt |Ω| = 216.

(a) A = {(1, 2, 2), (2, 1, 2), (2, 2, 1), (1, 1, 3), (1, 3, 1), (3, 1, 1)}. Wir erhalten |A| = 6 und

6

1

somit P (A) = 216

= 36

.

(b) B = B1 ∪ B2 ∪ B3 wobei Bi = {(x1 , x2 , x3 ) ∈ Ω : xi = 6}. Wir versuchen zunächst

|B| = |B1 | + |B2 | + |B3 | = 3 · 36. Dies ist aber falsch, denn die Bi sind nicht disjunkt!

1.4

Diskrete Wahrscheinlichkeitsmaße

9

Das Ergebnis (6, 2, 6) wurde z.B. doppelt gezählt. Ein richtiges Ergebnis erhält man

mit der Einschluss-Ausschluss-Formel:

P (B) =

3

X

P (Bi ) −

i=1

X

P (Bi ∩ Bj ) + P (B1 ∩ B2 ∩ B3 ) = 3 ·

1≤i≤j≤3

Einfacher ist: P (B) = 1 − P (B c ) = 1 − ( 56 )3 .

(c) C = {(x1 , x2 , x3 ) ∈ Ω : x1 < x2 < x3 }, also |C| =

6

3

1

1

1

− 3 · 2 + 3.

6

6

6

= 5 · 4 und P (C) =

5·4

.

63

Beispiel: Poker wird mit 4 × 13 = 52 Karten gespielt. Eine Poker-Hand besteht aus 5

Karten. Man bestimme die Wahrscheinlichkeit dafür, folgendes Blatt zu erhalten:

(a) einen Zwilling (aber nichts besseres) (b) zwei Zwillinge (aber nichts besseres)

Lösung: Ω =Menge

aller Kombinationen von 5 aus 52 Karten, F = P(Ω), P = UΩ .

4 12 3

(a) |A| = 13 2 3 4 . (Wähle zuerst Wert für den Zwilling, und 2 entsprechende Karten, dann drei weitere Werte und je eine Karte.) Es folgt P (A) ≈ 42.3%.

42

(b) |B| = 13

· 11 · 4. (Wähle zuerst zwei Werte und je zwei Karten, dann einen

2

2

weiteren Wert und eine Karte.) Es folgt P (B) ≈ 4.8%.

Beispiel: n Bosonen (z.B. H2 - Atome) werden auf N Zellen (des Ort-/Impulsraumes)

verteilt. Wie hoch ist die Wahrscheinlichkeit, dass keine Zelle doppelt besetzt ist?

Lösung: Wir verfolgen zwei verschiedene Lösungsansätze:

(1) Wir setzen Ω = {1, ....., N }n , F = P(Ω), P = UΩ . Für x ∈ Ω bezeichne xi die Zelle

für Teilchen i. Das Ereignis ist dann A = {(x1 , ....., xn ) : xi alle verschieden}, und es

gilt

N · (N − 1) · ... · (N − n + 1)

N!

1

|A|

=

=

.

P (A) =

n

|Ω|

N

(N − n)! N n

(2) Wir setzem Ω = {(k1 , ...., kN ) ∈ ZN : ki ≥ 0, k1 +....+kN = n}, F = P(Ω), P = UΩ .

Für k ∈ Ω bezeichne ki die Anzahl von Teilchen in Zelle i. Das Ereignis ist dann

A = {k ∈ Ω : ki ∈ {0, 1}}. Es gilt |A| = Nn . (Wähle n der Zellen zur Besetzung.) Für

|Ω| verwenden wir einen Trick: Wir beschreiben das Ergebnis k1 = 3, k2 = 2, k3 = 0.....

durch: ooo|oo||o|oo|....|o.

(o sind die n Teilchen, | sind N − 1 Zellwände). Es ist dann

|Ω| = n+Nn −1 . (Wähle n von (n + N − 1) Plätzen für die Teilchen.) Es folgt

P (A) =

|A|

N!

1

=

·

.

|Ω|

(N − n)! N · (N + 1) · .... · (N + n − 1)

Die Ergebnisse sind je nach Wahl des Modells verschieden. In physikalischen Experimenten zeigt sich, dass das Modell (b) die Realität besser beschreibt. (Bosonen sind

nicht unterscheidbar, und in (b) haben wir die Gleichverteilung auf Konfigurationen

von nicht unterscheidbarer Teilchen.)

1.5

Stetige Wahrscheinlichkeitsmaße

1.5

10

Stetige Wahrscheinlichkeitsmaße

Interpretiert man P als Massenverteilung ergibt sich folgendes Bild:

• Ist Ω abzählbar, so sitzt die Masse in abzählbar vielen Punkten: “Massenpunkte”

• Ist dagegen Ω = Rn , so ist die Masse über ganz Ω verschmiert: “Massendichte”

Definition: f : Rn → R heißt (Borel-) messbar, falls f −1 (A) ∈ BRn für alle A ∈ B.

Bemerkung:

• “Praktisch alle interessanten Funktionen” sind messbar

(→ Maßtheorie), z.B.

(

1 für x ∈ A

mit A ∈ BR .

stetige Funktionen oder Indikatorfunktion: 1A (x) :=

0 für x ∈

/A

• Für

Funktionen

f≥

R messbare

R

R 0 existiertRdas Lebesgue-Integral (→ Maßtheorie):

f (x)dλn (x) = f (x)dx = dxf (x) = dx1 ...dxn f (x1 , ..., xn ).

• Ist f ≥ 0 Riemann-integrierbar, so ist f messbar, und das Lebesgue-Integral ist

gleich dem Riemann-Integral.

R

• 1A (x)dλn (x) = λn (A). λn ist das sogenannte Lebesguemaß. λ1 ist die Länge, λ2

die Fläche, λ3 das Volumen.

Definition:

R

• Eine messbare Funktion f : Rn → [0, ∞) mit f (x)dx = 1 (Normierung) heißt

Dichtefunktion (auf Rm ).

R

R

• P (A) := A f (x)dx = f (x)1A (x)dx heißt stetiges Wahrscheinlichkeitsmaß

mit Dichtefunktion f .

Bemerkung: RP ist tatsächlich ein Wahrscheinlichkeitsmaß auf (Rn , BRn ):

(P1) P (Rn ) = f (x)dx = 1 wegen Normierung.

(P2) folgt aus den Eigenschaften des Lebesgue-Integrals.

Bemerkung: f (x) ist ein gewisses MaßRdafür, wie wahrscheinlich

der Punkt x ist.

Rx

Aber f (x) 6= P ({x}), sondern: P ({x}) = {x} f (y)dy = x f (y)dy = 0.

Auch hier ist das wichtigste Beispiel die Gleichverteilung.

Definition: Sei S ∈ BRn mit 0 < λn (S) < ∞. Das Maß mit Dichtefunktion f (x) =

c · 1S (x) = λn1(S) 1S (x) heißt (stetige) Gleichverteilung auf S: US .

Bemerkung: Ist P = US , so sind alle x ∈ S “gleichwahrscheinlich” und es gilt:

Z

Z

1

λn (A)

“Volumen von A00

∀A ∈ BS : P (A) =

f (x)dx =

1

(x)dx

=

=

.

A

λn (S)

λn (S)

“Volumen von S 00

A

1.5

Stetige Wahrscheinlichkeitsmaße

11

Beispiel: Romeo und Julia treffen sich heimlich. Beide haben eine Verspätung von

zwischen 0-1 Stunde. Muss einer auf den anderen länger als 1/4 Stunde warten, begeht

er Selbstmord. Bestimme die Wahrscheilichkeit für ein “glückliches Ende”!

Lösung: Wir setzen Ω = [0, 1]2 , F = BΩ , P = UΩ . Für t ∈ Ω sei t1 die Verspätung

von Romeo und t2 die Verspätung von Julia. Das betrachtete Ereignis ist dann A :=

{(t1 , t2 ) : |t1 − t2 | ≤ 41 }, d.h. ein Quadrat weniger zweier Dreiecke. Ω ist ein Quadrat

mit Fläche λ2 (Ω) = 1. Es folgt

λ2 (A)

1

3

3

7

= λ2 (A) = 1 − · 2 · ( )2 = 1 − ( )2 = .

2

λ (Ω)

2

4

4

16

R

Alternativ (aber schwieriger) kann man P (A) = 1A (x)dx auch berechnen durch

P (A) =

Z

Z

dx1

Z

1

4

Z

dx1

dx2 1A (x) =

0

1

+x1

4

3

4

Z

dx2 +

0

Z

1

+x1

4

dx1

1

4

1

Z

dx2 +

− 14 +x1

Z

1

dx1

3

4

dx2 =

− 14 +x1

7

.

16

Beispiel: (Bertrandsches Paradox.) In einem Kreis mit Radius 1 wird zufällig eine

Sehne gezogen. Mit welcher Wahrscheinlichkeit ist diese länger als die Seite des einbeschriebenen gleichseitigen Dreiecks?

Lösung: Wir beschreiben drei Lösungsvarianten:

(1) Wir beschreiben die Sehne durch ihren Mittelpunkt. Ω = {(x, y) : x2 + y 2 ≤ 1},

F = BΩ , P = UΩ . Das Ereignis A wird dann gerade durch den Inkreis des Dreiecks

2

( 12 )2 π

beschrieben (Radius 12 ). Es folgt P (A) = λλ2 (A)

=

= 14 .

(Ω)

12 π

(2) Wir beschreiben die Sehne durch ihren Mittelpunktswinkel. Ω = (0, π), F = BΩ , P =

π

1

3

UΩ . Das Ereignis ist dann A = ( 23 π, π), also P (A) = λλ1 (A)

=

= 13 .

(Ω)

π

(3) Wir beschreiben die Sehne durch ihren Abstand zum Mittelpunkt. Ω = [0, 1], F =

1

BΩ , P = UΩ . Das Ereignis ist dann A = [0, 12 ], also P (A) = λλ1 (A)

= 12 .

(Ω)

Dass man verschiedene Antworten erhält erscheint paradox, ist es aber nicht. Es kommt

eben darauf an, wie genau der Zufallsmechanismus aussieht, mit dem die Kante gewählt

wird. “Rein zufälliges” ziehen einer Sehne lässt verschiedene Interpretationen zu.

Bemerkung: Man kann auch Zufallsexperimente betrachten, die stetige und diskrete

Anteile haben. Ist zum Beispiel Ω = {(x1 , x2 ) : x1 ∈ N, x2 ∈P

R} =

R N×R und F = BΩ , so

kann ein Wahrscheinlichkeitsmaß definieren durch

R = x1 dx2 f (x1 , x2 )1A (x1 , x2 )

PP (A)

mit f : N × R → [0, ∞) messbar und normiert: x1 dx2 f (x1 , x2 ) = 1.

1.6

Verteilungsfunktion

1.6

12

Verteilungsfunktion

S = {(−∞, c] : c ∈ R} ist ein ∩-stabiler Erzeuger von B, daher ist nach dem Eindeutigkeitssatz jedes Wahrscheinlichkeitsmaß P auf (R, B) schon durch seine Werte

P ((−∞, c]) eindeutig festgelegt. Dies gibt Anlass zu folgender Definition:

Definition: Die Verteilungsfunktion eines Wahrscheinlichkeitsmaßes P auf (R, B)

ist die Funktion

F : R → [0, 1],

F (c) := P ((−∞, c]).

Bemerkung:

P

• Ist P diskret mit Dichte ρ(x), x ∈ S, so ist F (c) = x∈S:x≤c ρ(x).

Rc

• Ist P stetig mit Dichte f (x), so ist F (c) = −∞ f (x)dx.

Wir verwenden im Folgenden eine Kurzschreibweisen für Limiten:

F (c−) := lim F (x), F (c+) := lim F (x), F (∞) := lim F (x), F (−∞) := lim F (x).

x→c−

x→c+

x→∞

x→−∞

Lemma: Sei F die Verteilungsfunktion von P . Dann ist F (c−) = P ((−∞, c)).

Beweis: Sei cn ↑ c dann ist F (c−) = limn F (cn ) = limn P ((−∞, cn ]) = P ((−∞, c)),

denn (−∞, cn ] ↑ (−∞, c).

Hieraus folgt insbesondere, dass ich die Wahrscheinlichkeiten aller Intervalle leicht

durch F ausdrücken lassen, z.B. P ([a, b]) = P ((−∞, b]) − P ((−∞, a)) = F (b) − F (a−).

Der folgende Satz liefert ein einfaches Kriterium, welche Funktionen Verteilungsfunktionen sind:

Satz: Eine Funktion F : R → [0, 1] ist genau dann eine Verteilungsfunktion, wenn gilt:

(i) F ist monoton wachsend (d.h. c1 ≤ c2 ⇒ F (c1 ) ≤ F (c2 )).

(ii) F ist rechtsstetig (d.h. F (c+) = F (c)).

(iii) F (∞) = 1, F (−∞) = 0.

Beweis: Für eine Verteilungsfunktion sind die Eigenschaften (i), (ii), (iii) leicht nachzuweisen (Hausaufgabe). Jedes F mit den Eigenschaften (i), (ii), (iii) ist eine Verteilungfunktion (nächstes Kapitel).

Es ergibt sich also, dass die Wahrscheinlichkeitsmaße auf (R,B) eindeutig den Funktionen F : R → [0, 1] mit den Eigenschaften (i), (ii), (iii) entsprechen: Für jedes P

hat die Verteilungsfunktion die entsprechenden Eigenschaften, und für jede Funktion

mit diesen Eigenschaften gibt es ein passendes Wahrscheinlichkeitsmaß P . In wichtigen

Fällen, lässt sich P sogar explizit aus F bestimmen:

1.6

Verteilungsfunktion

13

Satz: Sei F die Verteilungsfunktion von P und sei S ⊂ R diskret (d.h. eine abzählbare

Menge ohne Häufungspunkte).

(a) P ist diskretes Wahrscheinlichkeitsmaß auf S ⇔

F ist stückweise konstant mit Sprungstellen höchstens in S.

In diesem Fall gilt ρ(x) = F (x) − F (x−) für x ∈ S.

(b) P ist stetig mit Dichte f , so dass f stetig auf R − S

F ist stetig auf R und stetig diffbar auf R − S.

In diesem Fall gilt f (x) = F 0 (x) für x ∈ R − S.

⇔

Beweis:

P

(a) Sei P diskret mit Dichte ρ(x), x ∈ S, dann ist F (c) = x∈S:x≤c ρ(x) stückweise

konstant mit Sprungstellen höchstens in S und Sprunghöhen F (x) − F (x−) = ρ(x). Ist

umgekehrt F stückweise konstant mit Sprungstellen höchstens in S und sei P ∗ diskret

mit Dichte ρ∗ (x) := F (x)−F (x−), dann folgt wie eben, dass F ∗ stückweise konstant ist

mit Sprungstellen höchstens in S und Sprunghöhen ρ∗ (x). Also haben F, F ∗ dieselben

Sprungstellen und Sprunghöhen, d.h. F = F ∗ und somit P = P ∗ .

(b) Sei P stetig mit Dichte f , so dass f stetig ist auf R − S. Es gilt

Z

x+h

F (x + h) − F (x) = P ((x, x + h]) =

Z

x

f (y)dy →

x

f (y) = 0

für h → 0,

x

mit monotoner Konvergenz (Maßtheorie!), d.h. F ist stetig. Ferner ist für x ∈

/S

1

1

(F (x + h) − F (x)) =

h

h

Z

x+h

f (y)dy → f (x)

für h → 0,

x

d.h. F 0 (x) = f (x) und insbesondere ist F stetig diffbar auf R − S. Ist umgekehrt F

stetig und stetig diffbar auf R − S und sei P ∗ stetig mit Dichte f ∗ (x) = F 0 (x) für

x ∈ R − S, dann folgt wie eben, dass F ∗ stetig ist und stetig diffbar auf R − S mit

(F ∗ )0 = f ∗ = F 0 . Hieraus folgt F = F ∗ und somit P = P ∗ .

Bemerkung:

• Teil (b) ist wichtig zur Bestimmung von Dichten

• Es gilt nicht: P stetig ⇔ F stetig

• Es gibt Wahrscheinlichkeitsmaße auf (R, B), die weder diskret noch stetig sind.

Analog kann man eine mehrdimensionale Verteilungsfunktion für ein Wahrscheinlichkeitsmaß P auf (Rn , BRn ) definieren: FP (c1 , ..., cn ) = P ((−∞, c1 ] × ... × (−∞, cn ]).

Diese Funktion hat ähnliche Eigenschaften wie im 1-dimensionalen, insbesondere folgende, die man zur Berechnung von Dichten verwenden kann: Ist F stetig, “stückweise”

stetig diffbar, so ist P stetig mit Dichte f (x1 , ..., xn ) = ∂x∂ 1 ... ∂x∂n F (x1 , ..., xn ).

2 Zufallsvariablen

2

14

Zufallsvariablen

2.1

Verteilung einer Zufallsvariable

Manchmal interessiert bei einem Zufallsexperiment (Ω, F, P ) nicht genau das Ergebnis

ω ∈ Ω, sondern eine Eigenschaft des Ergebnisses: X(ω).

Definition: Sei (Ω, F, P ) ein Wahrscheinlichkeitsraum und (Ω0 , F 0 ) ein Ereignisraum.

• Eine Abbildung X : Ω → Ω0 heißt (Ω0 -wertige) Zufallsvariable (ZVe), falls

{X ∈ A0 } := X −1 A0 = {ω ∈ Ω : X(ω) ∈ A0 } ∈ F

∀A0 ∈ F 0 (∗)

• Für A0 ∈ F 0 sei P 0 (A0 ) := P ({X ∈ A0 }). P 0 heißt die Verteilung von X. Man

schreibt dann X ∼ P 0 oder P 0 = P ◦ X −1 .

Lemma: Die Verteilung P 0 einer ZVe X ist ein Wahrscheinlichkeitsmaß auf (Ω0 , F 0 ).

Beweis: P 0 : F 0 → [0, 1] ist wohldefiniert (da X ZVe ist) und erfüllt die Axiome:

(P1) P 0 (Ω0 ) = P (X ∈ Ω0 ) = P (Ω) = 1

(P2) Seien

abzählbar).

Es gilt dann

P

P 0

S

S (I

S Ai0, i ∈ I disjunkt

0

0

P (X ∈ Ai ) =

P (Ai ).

Ai ) = P ( {X ∈ A0i }) =

P ( Ai ) = P (X ∈

i∈I

i∈I

i∈I

i∈I

i∈I

Bemerkung:

• Formal ist X eine Funktion Ω → Ω0 , und ω ∈ Ω wird zufällig gemäß P gewählt.

Wird ω zufällig gewählt, ist auch der Wert X(ω) zufällig. Daher kann man sich

X vorstellen als eine Größe mit zufälligem Wert, z.B. eine zufällige reelle Zahl.

Die Verteilung P ◦ X −1 beschreibt das gesamte zufällige Verhalten von X.

• Für Ereignisse, die das Verhalten von X betreffen, verwenden wir eine Kurzschreibweise, z.B.:

{X ∈ A} := {ω ∈ Ω : X(ω) ∈ A} ist das Ereignis, dass X einen Wert in A hat.

{X ≤ c} := {ω ∈ Ω : X(ω) ≤ c} ist das Ereignis, dass X einen Wert ≤ c hat.

• Die definierende Eigenschaft (*) einer ZVe, prüfen wir hier in der Regel nicht

nach. Diese Eigenschaft ist in allen Beispielen der Vorlesung automatisch erfüllt.

• Spezialfall: Ist Ω0 = R, so heißt X eine reelle Zufallsvariable.

Bemerkung: Jede Eigenschaft eines Wahrscheinlichkeitsmaßes kann auf eine ZVe X

übertragen werden (mittels der Verteilung von X), z.B.:

• X heißt diskret, falls P ◦ X −1 diskret ist, d.h. falls es eine Zähldichte ρ(x) auf

einer abzählbaren Teilmenge S ⊂ Ω0 gibt, so dass

P (X = x) = P 0 ({x}) = ρ(x) ∀x ∈ S.

2.1

Verteilung einer Zufallsvariable

15

• X heißt stetig, falls P ◦ X −1 stetig ist, d.h. falls es eine Dichte f (x) gibt, so dass

Z

0

P (X ∈ A) = P (A) = f (x)dx ∀A ∈ F 0 .

A

• Die Verteilungsfunktion von X ist die Verteilungsfunktion von P ◦ X −1 , d.h.

FX (c) = P ◦ X −1 ((−∞, c]) = P (X ∈ (−∞, c]) = P (X ≤ c).

Beispiel: Zwei Würfel werden geworfen. Man bestimme die Verteilung der Summe der

Augenzahlen und die Wahrscheinlichkeit dafür, dass die Summe zwischen 5 und 8 liegt.

Lösung: Wir wählen Ω = {1, ...., 6}2 , F = P(Ω), P = UΩ . Die Summe Z kann im

Modell definiert werden durch Z : Ω → R, Z(i, j) = i + j. Die Menge S der mögliche

Werte von Z ist abzählbar: S = {2, 3, ..., 12}. Daher ist Z eine diskrete Zufallsvariable.

Die Zähldichte berechnet man durch ρ(k) = P (Z = k), k ∈ S, z.B:

1

2

P (Z = 2) = P ({(1, 1)}) = 36

, P (Z = 3) = P ({(1, 2), (2, 1)}) = 36

. Man erhält somit

k

ρ(k)

2

3

4

5

6

7

8

9

10 11 12

1

36

2

36

3

36

4

36

5

36

6

36

5

36

4

36

3

36

2

36

1

36

Für die Berechnung der Wahrscheinlichkeit gibt es zwei Möglichkeiten. Entweder man

verwendet P und die Definition von Z

P (5 ≤ Z ≤ 8) = P ({(i, j) : 5 ≤ i + j ≤ 8}) = P ({(1, 4), ..., (6, 2)}) =

20

,

36

oder man verwendet die Verteilung von Z, d.h. die Zähldichte ρ

P (5 ≤ Z ≤ 8) = P (Z ∈ {5, 6, 7, 8}) =

8

X

ρ(k) =

k=5

4+5+6+5

20

= .

36

36

Beispiel: Eine Lampe im Abstand L vom Boden eines Zimmers strahlt gleichmässig

in alle Richtungen. Um die Leuchtintensität am Boden zu bestimmen, betrachten wir

ein Photon, das von der Lampe in einer zufälligen Richtung ausgesandt wird. Sei X der

Auftreffort des Photons am Boden. Wir nehmen an, dass die gesuchte Leuchtintensität

der Dichte von X entspricht.

Lösung: Sei Ω = (− π2 , π2 ) (θ ∈ Ω sei der Ausfallwinkel), F = BΩ , P = UΩ . Der

Auftreffort kann beschrieben werden durch X : Ω → R, X(θ) = L tan(θ). X hat

beliebige Werte in R und für c ∈ R ist

FX (c) = P (X ≤ c) = P ({θ ∈ Ω : L tan(θ) ≤ c}) = P

also fX (c) = FX0 (c) =

1

π

·

1

2

1+ c 2

L

·

1

L

=

1

πL

·

1

2

1+ c 2

L

.

π

c tan−1 ( Lc ) + π2

− , tan−1 ( ) =

,

2

L

π

2.1

Verteilung einer Zufallsvariable

16

Betrachtet man mehrere (reelle) ZVen X1 , ..., Xn , so kann man die Xi als Komponenten

eines zufälligen Vektors X betrachten: X : Ω → Rn , X = (X1 , ..., Xn ). P ◦ X −1

heißt dann gemeinsame Verteilung der Xi . Die gemeinsame Verteilung beschreibt

das gemeinsame zufällige Verhalten aller ZVen. Das gemeinsame Verhalten beinhaltet

natürliche insbesondere das Verhalten der einzelnen ZVen:

Lemma: Bestimmung der Einzelverteilungen aus der gemeinsamen Verteilung.

(a) Sind X1 , .., Xn diskret mit gemeinsamer

Zähldichte ρ(x1 , ..., xn ), so ist auch X1

P

diskret mit Zähldichte ρ1 (x1 ) = x2 ....xn ρ(x1 , ..., xn ).

(b) Sind X1 , .., Xn stetigRmit gemeinsamer

Dichte f (x1 , .., xn ), so ist auch X1 stetig

R

mit Dichte f1 (x1 ) = dx2 .... dxn f (x1 , ....xn ).

Beweis: (a) funktioniert analog zu (b), und für (b) berechnet man für A ∈ B:

Z

n−1

P (X1 ∈ A) = P ((X1 , .., Xn ) ∈ A × R ) =

dx1 ...dxn f (x1 , ..., xn )

A×Rn−1

Z

Z

Z

Z

=

dx1 dx2 ... dxn f (x1 , ..., xn ) =

dx1 f1 (x1 ).

A

A

Beispiel: Ein Punkt im Einheitskreis wird rein zufällig gewählt. Man bestimme die

gemeinsame Verteilung des Abstands zum Mittelpunkt und des Winkels mit der xAchse, und berechne daraus die Einzelverteilungen.

Lösung: Ω = {(x, y) ∈ R2 : x2 + y 2 ≤ 1}, F = BΩ , P = UΩ . Die betrachteten Größen

sind die ZVen R : Ω → [0, 1] und Φ : Ω → [0, 2π), deren Werte R(x, y) und Φ(x, y)

eindeutig durch (x, y) bestimmt sind gemäß x + iy = reiϕ . Für a ∈ [0, 1], b ∈ [0, 2π) ist

b

a2 π · 2π

b

= a2

FR,Φ (a, b) = P (R ≤ a, Φ ≤ b) =

2

1π

2π

(Fläche eines Kreissegments).

1

Die gemeinsame Dichte ist also fR,Φ (a, b) = ∂a∂bFR,Φ (a, b) = 2a 2π

, (a, b) ∈ [0, 1] ×

[0, 2π). Die

sich aus obigem Lemma durch Integration:

Es ist

R Einzeldichten ergeben

R 2π

R

1

f (r) = dϕfR,Φ (r, ϕ) = 0 dϕ2r 2π = 2r, r ∈ [0, 1] und fΦ (ϕ) = drfR,Φ (r, ϕ) =

RR1

1

dr2r 2π

= π1 , d.h. der Winkel ist gleichverteilt (wie zu erwarten).

0

Bemerkung: Interessieren bei einem Zufallsexperiment nur die Größen X1 , ..., Xn hat

man bei der Modellierung zwei Möglichkeiten:

1. Man definiert (Ω, F, P ) und X1 , ..., Xn als Funktionen auf Ω.

2. Man definiert die gemeinsame Verteilung P 0 von X1 , ..., Xn .

Die Wahrscheinlichkeit, dass die ZVen Werte in A ∈ BRn annehmen, ist in beiden Fällen

bestimmbar: P ((X1 , ..., Xn ) ∈ A) = P 0 (A) .

2.2

Simulation von Zufallsvariablen

2.2

17

Simulation von Zufallsvariablen

Aus Kapitel 1.6 ist noch nachzutragen, dass zu einer Funktion mit den Eigenschaften

(i)-(iii) immer ein zugehöriges Wahrscheinlichkeitsmaß existiert. Dieses Wahrscheinlichkeitsmaß erhält man am einfachsten als Verteilung einer geeignet definierten ZVe,

der sogenannten Quantil-Transformation.

Satz: Sei F : R → [0, 1] monoton wachsend, rechtsstetig und F (∞) = 1, F (−∞) = 0.

Sei (Ω, F, P ) = ((0, 1), B(0,1) , U(0,1) ) und X : (0, 1) → R die “linksstetige Umkehrfunktion” von F , d.h.

X(w) = inf{c ∈ R : F (c) > w}.

Dann ist FX = F , d.h. F ist die Verteilungsfunktion von P ◦ X −1 .

Beweis: Es gilt F (c) ≥ w genau dann, wenn X(w) ≤ c. Somit ist

FX (c) = P (X ≤ c) = P ({w ∈ Ω : X(w) ≤ c}) = P ({w ∈ Ω : F (c) > ω}) = F (c).

Bemerkung: Ist F explizit berechenbar und hat man einen U(0,1) Zufallsgenerator (wie

er in jedem Taschenrechner eingebaut ist), so kann der Satz dazu verwendet werden,

um eine Zufallsvariable X mit der vorgegebenen Verteilung zu simulieren, d.h. einen

zufälligen Wert zu erzeugen, der gemäß der Verteilungsfunktion F verteilt ist.

Beispiel: Die Exponentialverteilung ist stetig mit Dichte f (x) = e−x , x > 0. Wie kann

man einen zufällige exponentialverteilte Zahl erzeugen?

Lösung: Zunächst bestimmt

R c man die Verteilungsfunktion: Für c ≤ 0 ist F (c) = 0

und für c ≥ 0 ist F (c) = −∞ e−x dx = 1 − e−c . Die linksstetigen Umkehrfunktion

X(ω) = F −1 (ω) aus dem Satz erhält man durch Umformung:

1 − e−c = ω

⇔

1 − ω = e−c

⇔

c = − ln(1 − ω).

Zur Erzeugung der gewünschten Zahl kann man dann so vorgehen:

• Erzeuge ω ∈ (0, 1) mit U(0,1) .

• X(ω) = − ln(1 − w) ist die gesuchte Zahl.

2.3

Transformation von Zufallsvariablen:

2.3

18

Transformation von Zufallsvariablen:

Transformationen von ZVen kann man einfach punktweise definieren, z.B.:

• Sind X, Y : Ω → R ZVen, so ist X + Y : Ω → R, (X + Y )(ω) := X(ω) + Y (ω).

• Ist X : Ω → Ω0 eine ZVe und g : Ω0 → Ω00 messbar, so ist g(X) : Ω → Ω00 ,

g(X)(ω) := g(X(ω)).

Bemerkung: Man interpretiert X + Y als Summe der beiden zufälligen Werte X, Y

und g(X) als Funktionswert des zufälligen Wertes X. Man kann zeigen, dass X + Y

und g(X) wieder ZVen sind.

Wir betrachten nun folgendes Problem: Gegeben ist eine ZVe mit bekannter Verteilung.

Man bestimme die Verteilung einer gewissen Transformation dieser ZVe.

Beispiel: (X, Y ) sei gleichverteilt auf {−1, 0, 1}2 . Was ist die Verteilung von Z = XY ?

Lösung:

X, Y haben die gemeinsame Zähldichte ρ(x, y) = 91 für alle −1 ≤ x, y ≤ 1. Z = g(X, Y )

mit g : R2 → R, g(x, y) = xy. Die möglichen Werte von Z sind {−1, 0, 1}, und die

Zähldichte ρZ erhält man durch aufsummieren, z.B.

2

ρZ (−1) = P (Z = −1) = P ((X, Y ) ∈ {(1, −1), (−1, 1)}) = ρ(1, −1) + ρ(−1, 1) = .

9

Analog erhält man ρZ (1) =

2

9

und ρZ (0) = 95 .

Beispiel: Sei X gleichverteilt auf [−2, 2]. Man bestimme die Verteilung von Y = X 2 .

Lösung: Die möglichen Werte von Y sind [0, 4]. Für c ∈ [0, 4] ist

√

√

Z √c

√

√

2 c

c

2

FY (c) = P (Y ≤ c) = P (X ≤ c) = P (− c ≤ X ≤ c) = √ f (x)dx =

=

,

4

2

− c

also fY (c) = FY0 (c) =

1

√

,

4 c

d.h. fY (y) =

1

√

1

4 y {0≤y≤4}

bzw. fY (y) =

1

√

,

4 y

0 ≤ y ≤ 4.

Beispiel: Sei X stetig mit Dichte f . Man bestimme die Dichte von Y = X 2 .

Lösung: Y kann nur nichtnegative Werte annehmen, und für c ≥ 0 ist

Z √c

√

√

FY (c) = √ f (x)dx = FX ( c) − FX (− c).

− c

Das Integral kann zwar nicht weiter vereinfacht werden, aber die Ableitung davon kann

man bestimmen:

√

√

√

√

1

1

1

fY (c) = FY0 (c) = FX0 ( c) · √ + FX0 (− c) · √ = √ (f ( c) + f (− c)).

2 c

2 c

2 c

2.3

Transformation von Zufallsvariablen:

19

Beispiel: X, Y haben die gemeinsame Dichte f (x, y) = 21 xy 2 · e−x−y , x, y ≥ 0. Man

X

bestimme die gemeinsame Verteilung von U = X + Y, V = X+Y

.

x

Lösung: (U, V ) = g(X, Y ) = (u(X, Y ), v(X, Y )) mit u(x, y) = x + y, v(x, y) = x+y

.

2

g : (0, ∞) → (0, ∞) × (0, 1) ist bijektiv mit Umkehrfunktion: x = uv = x(u, v), y =

u − uv = y(u, v). Nun gibt es zwei Möglichkeiten fortzufahren:

(1) Integration bezüglich dxdy:

X

≤ b) =

FU,V (a, b) = P (U ≤ a, V ≤ b) = P (X + Y ≤ a,

X +Y

Z

f (x, y)dxdy = (∗)

A

x

mit A = {(x, y) ∈ [0, ∞)2 : x + y ≤ a, x+y

≤ b}. Um A auf dxdy aufteilen zu können,

x

= b,

macht man eine Skizze und bestimmt den Schnittpunkt der Kurven x + y = a, x+y

1

d.h. y = a − x, y = ( b − 1)x. Dieser hat die Korrdinaten (c, d) mit c = ab, d = a − ab.

R c R a−x

Es folgt (∗) = 0 dx ( 1 −1)x dy 12 xy 2 e−x−y . Dieses Integral kann nun berechnet werden,

b

und hieraus ergibt sich fU,V (a, b) = ∂U ∂V FU,V (a, b) für (a, b) ∈ (0, ∞) × (0, 1).

(2) Integration bezüglich dudv: g ist ein Diffeomorphismus (g bijektiv, g, g −1 stetig

diffbar). Will man (∗) durch Integration über dudv berechnen benötigt man die JacobiMatrix von g bzw. g −1 : Formal gilt

∂u ∂u d(u, v)

d(u, v)

∂x

∂y

dxdy, wobei

:= | det Dg(x, y)| mit Dg =

, bzw.

dudv =

∂v

∂v

d(x, y)

d(x, y)

∂x

∂y

∂x ∂x d(x, y)

d(x, y)

−1

−1

∂u

∂v

dxdy =

dudv, wobei

:= | det Dg (u, v)| mit Dg =

.

∂y

∂y

d(u, v)

d(u, v)

∂u

∂v

Für beliebiges A ∈ BR2 ist dann

P ((U, V ) ∈ A) = P (g(X, Y ) ∈ A) = P ((X, Y ) ∈ g −1 A)

Z

Z

d(x, y)

dudv

dxdyf (x, y) =

f (x(u, v), y(u, v)),

=

d(u, v)

g −1 (A)

A

d.h. die gemeinsame Dichte von U, V ist dann

fU,V (u, v) =

d(x, y)

f (x(u, v), y(u, v)).

d(u, v)

In unserem Beispiel ist x = uv, y = u − uv und damit

d(x, y) v

u

= det

= |v · (−u) − u · (1 − v)| = | − u| = u

1

−

v

−u

d(u, v)

und

1

1

f (x(u, v), y(u, v)) = (uv)(u − uv)2 e−u = (1 − v)2 u3 e−u ,

2

2

1

also fU,V (u, v) = 2 (1 − v)2 u4 e−u , (u, v) ∈ (0, ∞) × (0, 1).

Dies funktioniert ganz allgemein, solange g ein Diffeomorphismus ist:

2.3

Transformation von Zufallsvariablen:

20

Satz: Sei X eine Rn -wertige Zufallsvariable mit Dichte f , und sei g : M → N ein

Diffeomorphismus (M, N ⊂ Rn offen, g, g −1 stetig differenzierbar) mit P (X ∈ M ) = 1.

Dann ist Y = g(X) stetig mit Dichte

fY (y) = | det Dg −1 (y)|fX (g −1 (y)), y ∈ N.

Beweis: Wie im Beispiel vorher.

Bemerkung:

• Besonders wichtig ist der eindimensionale Spezialfall: Ist X eine reelle ZVe mit

Dichte f , M, N ⊂ R Intervalle mit P (X ∈ M ) = 1 und g : M → N ein

Diffeomorphismus, dann ist Y = g(X) eine reelle ZVe mit Dichte

fY (y) = |(g −1 )0 (y)|fX (g −1 (y)).

• Ist g nicht bijektiv, kann Methode (2) nicht verwendet werden!

• Ist g : Rn → R, so kann man Methode (2) anwenden, falls man g zu einem

Diffeomorphismus ergänzen kann.

Beispiel: Sei (X1 , X2 ) gleichverteilt auf [0, 1]2 . Was ist die Dichte von Y = X1 X2 ?

Lösung: Wir betrachten wieder beide Möglichkeiten (1) und (2). Die gemeinsame

Dichte von X1 , X2 ist fX1 ,X2 (x1 , x2 ) = 1, x1 , x2 ∈ [0, 1].

(1) Y hat Werte in [0, 1] und für c ∈ [0, 1] ist

Z

FY (c) = P (Y ≤ c) = P (X1 X2 ≤ c) = 1 − P (X1 X2 > c) = 1 −

1

1

Z

dx2 1

dx1

c

x1

c

= 1 − [x1 − c ln(x1 )]1c = .... = 1 − (1 − c + c · ln(c)) = c − c · ln(c),

also fY (c) = 1 − ln(c) − c · 1c , d.h. fY (y) = − ln(y), 0 < y < 1.

(2) Wir betrachten Z1 = X1 , Z2 = Y = X1 X2 , d.h. Z = g(X) mit g : (0, 1)2 →

{(z1 , z2 ) : 0 < z2 < z1 < 1}, g(x1 , x2 ) = (x1 , x1 x2 ). g ist ein Diffeomorphismus mit

Umkehrabbildung g −1 : x1 = z1 , x2 = zz12 . Nach obigem Satz ist

1

fZ1 ,Z2 (z1 , z2 ) = det

z2

−z12

Die Dichte von Y = Z2 ist daher

Z 1

Z

fY (y) =

dz1 fZ1 ,Z2 (z1 , y) =

z2

y

0

1

z1

1

dz1

1

= ,

z1

0 < z2 < z1 < 1.

1

= ln(z1 )|1y = − ln(y),

z1

0 < y < 1.

3 Bedingte Wahrscheinlichkeiten und Verteilungen

3

21

Bedingte Wahrscheinlichkeiten und Verteilungen

In diesem Abschnitt soll untersucht werden, wie sich Wahrscheinlichkeiten bzw. Verteilungen verändern, falls zusätzliche Informationen zur Verfügung stehen.

3.1

Bedingte Wahrscheinlichkeiten

Definition: Sei (Ω, F, P ) ein Wahrscheinlichkeitsraum und B ∈ F mit P (B) 6= 0. Die

(bedingte) Wahrscheinlichkeit von A ∈ F gegeben B sei

P (A|B) :=

P (A ∩ B)

.

P (B)

Lemma: P (.|B) ist wieder ein Wahrscheinlichkeitsmaß auf (Ω, F).

Beweis: Es ist P (Ω|B) = P P(Ω∩B)

= 1, und für disjunkte Mengen Ai gilt

(B)

S

S

P

[

P ( i (Ai ∩ B))

P ( i (Ai ∩ B))

P (Ai ∩ B) X

P ( Ai |B) =

=

= i

=

P (Ai |B),

P (B)

P (B)

P (B)

i

i

den auch die B ∩ Ai sind dann disjunkt.

Was beschreibt das neue Wahrscheinlichkeitsmaß P (.|B)? Es gilt P (B|B) = 1, also ist

das Ergebnis des Zufallsexperiments mit Sicherheit in B. Für Ereignisse A1 , A2 ⊂ B

dagegen bleibt die relative Wahrscheinlichkeit unverändert:

P (A1 ∩ B)/P (B)

P (A1 )

P (A1 |B)

=

=

.

P (A2 |B)

P (A2 ∩ B)/P (B)

P (A2 )

P (.|B) ist also im Prinzip die gleiche Wahrscheinlichkeitsverteilung wie P , abgesehen

davon, dass Ergebnisse in B c ignoriert werden. Man interpretiert P (.|B) daher als

Verteilung eines Zufallsexperiments, das eigentlich durch P beschrieben wird, unter

der zusätzlichen Information, dass das Ergebnis des Experiments in B liegt.

Beispiel: Beim Würfeln mit zwei Würfeln ergibt sich die Summe 5. Wie ist die Augenzahl des ersten Würfels verteilt?

Lösung: Sei Ω = {1, ..., 6}2 , F = P(Ω), P = UΩ . Die Augenzahlen der Würfel werden

beschrieben durch die Projektionen X1 , X2 mit Xi (x1 , x2 ) := xi . Man sieht leicht, dass

P (X1 = k) = 16 für alle k ∈ {1, 2, 3, 4, 5, 6}, d.h. X1 ist gleichverteilt auf {1, 2, 3, 4, 5, 6}.

Dies berücksichtigt jedoch nicht die gegebene Information. Gesucht ist hier stattdessen

P (X1 = k|B) mit B := {X1 + X2 = 5}. Es ist

k

P (X1 = k|B)

1

2

3

4

1

4

1

4

1

4

1

4

5 6

,

0 0

4

denn P (B) = P ({1, 4}, ..., {4, 1}) = 36

und beispielsweise P ({X1 = 1} ∩ B) =

1

1

P ({(1, 4}) = 36 , also P (X1 = 1|B) = 4 . Durch die Zusatzinformation haben sich also

die Wahrscheinlichkeiten von 1, 2, 3, 4 erhöht, dagegen sind 5, 6 jetzt ausgeschlossen.

3.1

Bedingte Wahrscheinlichkeiten

22

Satz: (Fallunterscheidungsformel für Wahrscheinlichkeiten.) Sei (Ω, F, P ) ein Wahrscheinlichkeitsraum

und A ∈ F. Für jede Partition Bi , i ∈ I, von Ω (d.h. Bi ∈ F

S

disjunkt, i Bi = Ω) gilt

X

P (A) =

P (A|Bi )P (Bi ).

i

Beweis: A ∩ Bi ist eine Partition von A, daher gilt

X

i

P (A|Bi )P (Bi ) =

X P (A ∩ Bi )

i

P (Bi )

P (Bi ) =

X

i

[

P (A ∩ Bi ) = P ( (A ∩ Bi )) = P (A).

i

Die Fallunterscheidungsformel ist nützlich bei der Bestimmung von P (A). Dabei ist

es aber oft schwierig, eine Partition Bi zu finden, die die Berechnung von P (A|Bi )

möglichst einfach macht.

Beispiel: Im sogenannten Auktionsproblem oder Heiratsproblem, stehen n Objekte zur

Verfügung, die man hintereinander sieht. Man möchte genau eines auswählen, muss bei

jedem sofort entscheiden, ob man es will oder nicht. Was ist eine gute Strategie, um

mit möglichst hoher Wahrscheinlichkeit das beste Objekt zu erhalten?

Lösung: Sei A das Ereignis, das beste Objekt zu bekommen. Eine mögliche Strategie

besteht darin, zu warten bis man k der Objekte gesehen hat, und dann das nächste zu

nehmen, das besser ist als alle bisherigen. (Falls kein besseres mehr kommt geht man

leer aus.) Zumindest dann wenn das zweitbeste Objekt unter den ersten k, und das

beste unter den letzten n−k ist, bekommt man das beste. Insofern ist P (A) mindestens

k n−k

( ≈ 14 für k := n2 ). Wir wollen P (A) für beliebiges k genauer bestimmen und

n n−1

versuchen, k optimal zu wählen.

Seien dazu 1, 2, 3, ..., n die n Objekte, sortiert nach aufsteigendem Wert. Sei Ω die

Menge der Permutationen von {1, 2, ..., n}, d.h. Ω = {σ : {1, 2, ..., n} → {1, 2, ..., n} : σ

bijektiv}, F = P(Ω), P = UΩ . Für σ ∈ Ω sei σ(i) das i-te Objekt. Für die Berechnung

von P (A) bedingen wir auf die Position des besten Objekts: Bi := {σ : σ(i) = n}.

Die Bi bilden eine Partition. Für i ≤ k ist P (A|Bi ) = 0, denn dann besteht keine

Möglichkeit das beste Objekt zu erhalten. Für i > k ist

P (A|Bi ) = P (max{σ(1), ...σ(i − 1)} ∈ {σ(1)...σ(k)}) =

k

,

i−1

denn unter den i − 1 Anfangsobjekten ist das beste mit gleicher Wahrscheinlichkeit an

jeder Stelle. Aus Symmetriegründen gilt ferner P (Bi ) = n1 für alle 1 ≤ i ≤ n. Mit der

Fallunterscheidungsformel folgt nun

Z

n

n

n

X

X

k 1

k X 1

k n1

k

k

=

≈

dx = − log .

P (A) =

P (A|Bi )P (Bi ) =

i−1n

n i=k+1 i − 1

n k x

n

n

i=1

i=k+1

Für f (x) := −x log x ist f 0 (x) = − log x − 1, also hat f ein Maximum bei x = 1e .

Also wird P (zumindest für große n) maximal für nk ≈ 1e , und die entsprechende

Wahrscheinlichkeit ist dann P (A) ≈ 1e ≈ 0, 37 (praktisch unabhängig von der Anzahl

n der Objekte).

3.2

Bedingte Verteilungen

3.2

23

Bedingte Verteilungen

Ein Zufallsexperiment liefert zwei Werte X, Y . Was ist die Verteilung von X bei bekanntem Wert Y = y? Falls X, Y diskret sind, liefert das letzte Kapitel die Antwort:

P (X = x|Y = y) =

ρX,Y (x, y)

ρY (y)

falls P (Y = y) 6= 0.

Ist Y stetig, ist zwar P (Y = y) = 0, dennoch gehen wir analog vor: Im diskreten Fall

ist die Verteilung von X bei gegebenem Y = y bestimmt durch die renormalisierte

Zähldichte ρ(., y), also definieren wir im stetigen Fall die bedingte Verteilung durch die

geeignet renormalisierte Dichtefunktion f (., y).

Definition: Bedingte Verteilung.

ρ

(x,y)

• Sind X, Y diskret, so definieren wir ρX (x|Y = y) := X,Y

ρY (y)

als bedingte Zähldichte von X gegeben Y = y, falls ρY (y) 6= 0.

f

(x,y)

• Sind X, Y stetig, so definieren wir fX (x|Y = y) := X,Y

fY (y)

als bedingte Dichte von X gegeben Y = y, falls fY (y) 6= 0.

In beiden Fällen bezeichnen wir mit PX (.|Y = y) die zugehörige Verteilung, die sogenannte bedingte Verteilung von X, gegeben den Wert von Y . Ähnlich kann man

vorgehen bei mehr als zwei Zufallsvariablen oder im gemischt diskret-stetigen Fall.

Bemerkung:

• Man kann leicht nachprüfen, dass ρX (.|Y = y) und fX (.|Y = y) die Normalisierungsbedingung erfüllen.

• Obige Definition impliziert, dass sich die gemeinsame Verteilung von (X, Y ) z.B.

aus der Verteilung von Y und der bedingter Verteilung von X gegeben Y ergibt: fX,Y (x, y) = fY (y) · fX (x|Y = y). Bei der Modellierung genügt es also,

entsprechende Verteilungen und bedingte Verteilungen anzugeben.

Beispiel: Ein zufälliger Punkt (X, Y ) der Menge {(x, y) : x, y > 0, x + y ≤ 1} wird

gemäß der Dichte fX,Y (x, y) = x gewählt. Bestimmen Sie P (X ≥ 12 |Y = 31 ).

Lösung: Die bedingte Dichte ist fX (x|Y = 13 ) = cx, 0 < x < 23 . Die neue NormalisieR 2/3

rungskonstante c ergibt sich aus 0 xdx = 92 , d.h. c = 92 . Es folgt

1

1

P (X ≥ |Y = ) =

2

3

1

Z

1

2

1

fX (x|Y = )dx =

3

2

3

Z

1

2

9

7

xdx = .

2

16

Beispiel: Eine seltene Krankheit betrifft 1 unter 10000 Personen. Ein Bluttest bezüglich

dieser Krankheit liefert bei gesunden Personen ein korrektes Ergebnis mit 99% und bei

kranken Personen mit 95%. Bei der Blutuntersuchung einer Person ergibt sich ein positives Testresultat. Mit welcher Wahrscheinlichkeit ist die Person wirklich krank?

3.3

Unabhängigkeit

24

Lösung: Seien X1 , X2 ZVen mit Werten in {g, k}. Hierbei bedeutet g gesund, k krank,

X1 sei der wirkliche Gesundheitszustand und X2 das Testergebnis. Gegeben sind:

P (X1 = k) =

1

,

10000

P (X2 = k|X1 = k) = 0.95,

P (X2 = g|X1 = g) = 0.99,

d.h. gegeben sind die Verteilung von X1 und die bedingte Verteilung von X2 . Damit

ist das Problem vollständig modelliert. Wir erhalten

P (X1 = k|X2 = k) =

1

0.95 · 10000

P (X1 = k, X2 = k)

=

9999 ≈ 1%.

1

P (X2 = k)

+ 0.01 10000

0.95 10000

Im zweiten Schritt haben wir die Wahrscheinlichkeiten durch Fallunterscheidung nach

den möglichen Werten von X1 berechnet. Obiges Ergebnis ist vielleicht etwas überraschend: der Test scheint doch eigentlich recht gut zu sein scheint. Die Erklärung für

das Ergebnis liegt darin, dass die Krankheit so selten ist: Unter 10000 Personen ist

nur einer wirklich krank. Unter den 9999 gesunden haben im Durchschnitt 1 %, also

ca. 100 ein positives Testresultat. Um dem schlechten Testverhalten abzuhelfen, sollte

man also den Test wiederholen, bzw. auf andere Anzeichen testen.

3.3

Unabhängigkeit

Von Unabhängigkeit spricht man, falls sich die Wahrscheinlichkeit nicht ändert durch

zusätzliche Information. Bei Ereignissen A, B ∈ F bedeutet dies: P (A) = P (A|B) =

P (A∩B)

. d.h. P (A ∩ B) = P (A)P (B).

P (B)

Definition: Unabhängigkeit von Ereignissen. Sei (Ω, F, P ) ein Wahrscheinlichkeitsraum und Ai ∈ F.

(a) A1 , A2 unabhängig :⇔ P (A1 ∩ A2 ) = P (A1 )P (A2 )

(b) Ai , i ∈ I paarweise unabhängig :⇔ P (Ai ∩ Aj ) = P (Ai )P (Aj ) ∀i 6= j

T

Q

(c) Ai , i ∈ I unabhängig :⇔ für jedes endliche J ⊂ I : P ( i∈J Ai ) = i∈J P (Ai )

Beispiel: Seien A, B unabhängig. Man zeige: A, B c sind auch unabhängig.

Lösung: P (A ∩ B c ) = P (A) − P (A ∩ B) = P (A) − P (A)P (B) = P (A)(1 − P (B)) =

P (A)P (B c ).

Beispiel: Eine Münze wird zweimal geworfen. Zeigen Sie, dass folgende Ereignisse

paarweise unabhängig, aber nicht unabhängig sind:

A = “1. Münze Zahl”, B = “2. Münze Zahl”, C = “beide Münzen gleich”

Lösung: Wir wählen Ω = {0, 1}2 , F = P(Ω), P = UΩ . Drückt man alle Ereignisse

als Teilmengen von Ω aus erhält man P (A) = P (B) = P (C) = 21 und P (A ∩ B) =

P (A ∩ C) = P (B ∩ C) = 14 , aber P (A ∩ B ∩ C) = 14 .

Analog definiert man Unabhängigkeit für Zufallsvariablen:

3.3

Unabhängigkeit

25

Definition: Unabhängigkeit von ZVen.

Sei (Ω, F, P ) ein Wahrscheinlichkeitsraum und Xi : (Ω, F) → (Ωi , Fi ) ZVen, i ∈ I.

(a) X1 , X2 unabhängig :⇔

P (X1 ∈ A1 , X2 ∈ A2 ) = P (X1 ∈ A1 )P (X2 ∈ A2 ) ∀A1 ∈ F1 , A2 ∈ F2

(b) Xi , i ∈ I paarweise unabhängig :⇔

P (Xi ∈ Ai , Xj ∈ Aj ) = P (Xi ∈ Ai )P (Xj ∈ Aj ) ∀Ai ∈ Fi , Aj ∈ Fj , i 6= j ∈ I

(c) Xi , i ∈ I unabhängig :⇔

Q

für jedes endliche J ⊂ I, Ai ∈ Fi : P (Xi ∈ Ai ∀i ∈ J) = i∈J P (Xi ∈ Ai ).

Bemerkung:

• Wir betrachten {X ∈ A} für beliebige A, da beliebige Informationen über X

berücksichtigt werden sollen.

• Statt jeweils alle Ai ∈ Fi , genügt es nur Ai ∈ Si zu betrachten, wobei Si ein

∩-stabiler Erzeuger von Fi ist. (Dies folgt aus dem Eindeutigkeitssatz.)

• X1 , ..., Xn unabhängig ⇔ ∀Ai ∈ Fi : P (Xi ∈ Ai ∀1 ≤ i ≤ n) =

n

Q

P (Xi ∈ Ai ).

i=1

(Man setze für festes J in obiger Definition einfach Ai := Ωi für i ∈

/ J.)

Auch auf der Ebene von Dichtefunktionen kann Unabhängigkeit durch entsprechende

Produktformeln charakterisiert werden:

Satz: Seien X1 , ..., Xn reele Zufallsvariablen.

(a) Für X1 , ..., Xn diskret:

(b) Für X1 , ..., Xn stetig:

Q

X1 , ..., Xn unabh. ⇔ ρX1 ,..,Xn (x1 , ..., xn ) = ni=1 ρXi (xi )

Q

X1 , ..., Xn unabh. ⇔ fX1 ,...,Xn (x1 , ..., xn ) = ni=1 fXi (xi )

Beweis: (b) ist Hausaufgabe. Wir zeigen (a):

“⇒”: Dies folgt sofort aus der Definition mit Ai := {xi }.

”⇐”: Für beliebige Ai ∈ Fi ist

P (X1 ∈ A1 , ..., Xn ∈ An ) =

X

ρX1 ,..,Xn (x1 , ..., xn ) =

x1 ∈A1 ,...,xn ∈An

=

X

ρX1 (x1 ) · ... ·

x1 ∈Ai

X

X

x1 ∈A1

...

n

X Y

ρXi (xi )

xn ∈An i=1

ρXn (xn ) = P (X1 ∈ A1 ) · ... · P (Xn ∈ An ).

xn ∈An

Bemerkung:

• X, Y unabhängig ⇔ ρX (x) = ρX (x|Y = y) bzw. fX (x) = fX (x|Y = y) ⇔ das

Verhalten von Y ist irrelevant für die Verteilung von X. (Dies folgt direkt aus

dem letzten Satz.)

• Sind f1 , f2 Zähldichten bzw. Dichtefunktion und gilt fX,Y (x, y) = f1 (x)f2 (y),

so folgt sofort, dass X,

R Y unabhängig sind mit Dichten f1 , f2 , denn dann ist

automatisch fX (x) = dyfX,Y (x, y) = f1 (x), und analog fY (y) = f2 (y).

3.3

Unabhängigkeit

26

Beispiel: : Seien X1 , X2 .... die binäre Nachkommastellen einer zufällige Zahl X in

[0, 1]. Man zeige: X1 , X2 , ... sind unabhängig, und Xi ist gleichverteilt auf {0, 1}.

P

Lösung: Es ist X = i X2ii . Es genügt zu zeigen, dass ρX1 ,...,Xn (k1 , ..., kn ) = 12 · ... · 21 .

Nach obiger Bemerkung folgt dann, dass X1 , ..., Xn unabhängig sind mit Dichte ρi (ki ) =

1

, also gleichverteilt. Damit ist dann auch jede endliche Teilmenge der Xi unabhängig.

2

P

Seien also ki ∈ {0, 1}, dann ist mit c := i k2ii

ρX1 ,...,Xn (k1 , ..., kn ) = P (X1 = k1 , ..., Xn = kn ) = P (c ≤ X < c +

P (X ∈ [c, c +

1

)=

2n

λ([c, c + 21n ))

1

1

= n.

))

=

n

2

λ([0, 1])

2

Satz: (Vererbung von Unabhängigkeit.) Seien Xi , i ∈ I unabhängige ZVen, Jk ⊂ I

disjunkt und fk : ×i∈Jk Ωi → Ω(k) . Dann sind die ZVen Yk := fk (Xi : i ∈ Jk ), k ∈ K,

auch wieder unabhängig, (z.B. Y1 = f1 (X1 , X2 ), Y2 = f2 (X4 , X7 , X3 )).

Beweis: Hausaufgabe (im Spezialfall).

Beispiel: Eine Münze wird 100 Mal geworfen. Y1 bzw. Y2 gebe an wie oft “Zahl” bei

den ersten 50 bzw. nächsten 50 Würfen fällt. Man zeige, dass Y1 , Y2 unabhängig sind.

Lösung: Sei Xi das Ergebnis des i-ten Wurfes, (1 =

ˆ Zahl; 0 =

ˆ Kopf). Die Xi sind dann

unabhängig,

P und es ist Y1 = f1 (X1 , ..., X50 ) und Y2 = f2 (X51 , ..., X100 ) mit f1 (x) =

f2 (x) = 50

i=1 xi . Nach dem Satz sind daher Y1 , Y2 unabhängig.

Satz: (Faltung von ZVen.) Seien X1 , X2 unabhängig und Y = X1 + X2 .

(a) Sind X1 , X2 diskret mit Zähldichten ρ1 , ρ2 , dann ist Y diskret mit Zähldichte

X

ρ1 (l)ρ2 (k − l).

ρ(k) =

l

(b) Sind X1 , X2 stetig mit Dichten f1 , f2 , dann ist Y stetig mit Dichte

Z

f (y) = dxf1 (x)f2 (y − x).

Beweis: (b) ist Hausaufgabe und (a) folgt aus

X

ρ(k) = P (X1 + X2 = k) =

ρX1 ,X2 (k1 , k2 ) =

k1 ,k2 :k1 +k2 =k

X

ρ1 (k1 )ρ2 (k2 ).

k1 ,k2 :k1 +k2 =k

Mit l := k1 ist k2 = k − l und die Summe hat die gegebene Form.

4 Erwartungswert

4

27

Erwartungswert

4.1

Erwartungswert

Der Erwartungswert E(X) ist Mittelwert einer reellen ZVe X : Ω → R, wobei jeder

mögliche Wert mit seiner Wahrscheinlichkeit gewichtet wird. (Dies entspricht also dem

Massenschwerpunkt einer Massenverteilung.)

Der Erwartungswert wird schrittweise definiert:

• Ist X ≥ 0 eine Treppenfunktion, d.h. X =

P

An ∈ B, setzt man E(X) := N

n=1 an P (An ).

PN

n=1

an 1An mit N ∈ N, an ≥ 0,

• Ist X ≥ 0 beliebig, approximiert man X von unten durch Treppenfunktionen Xn ,

d.h. Xn ↑ X, und setzt dann E(X) := limn→∞ E(Xn ).

• Für beliebiges X setzt man E(X) := E(X+ )−E(X− ). Hierbei ist X+ = |X|·1{X>0}

der Positiv-Teil und X− = |X| · 1{X<0} der Negativ-Teil von X.

• L1 sei die Menge aller ZVen X mit E(|X|) < ∞, d.h. E(X+ ), E(X− ) < ∞.

Bemerkung:

• Für Details, siehe Maßtheorie. Insbesondere im 1. und 2. Schritt ist zu zeigen, dass

E(X) wohldefiniert ist, also nicht von der speziellen Darstellung von X abhängt.

• Im dritten Schritt kann es passieren, dass E(X+ ) oder E(X− ) unendlich sind. Falls

beide unendlich sind, ist der Erwartungswert nicht definiert. Falls einer unendlich

ist, ist E(X) = ∞ bzw. −∞. Für X ∈ L1 sind beide endlich, und daher ist E(X)

definiert und hat einen endlichen Wert.

Satz: Erwartungswert von diskreten und stetigen ZVen. Sei g : Rn → R messbar. Sind

X1 , ..., Xn reelle ZVen mit gemeinsamer Zähldichte ρ bzw. Dichte f , dann ist

X

E(g(X1 , ..., Xn )) =

g(k1 , ..., kn )ρ(k1 , ..., kn ), bzw.

k1 ,...,kn

Z

E(g(X1 , ..., Xn )) =

g(x1 , ..., xn )f (x1 , ..., xn )dx1 ...dxn .

Insbesondere ist für eine reelle ZVe mit Zähldichte ρ bzw. Dichte f

Z

X

E(X) =

kρ(k) bzw. E(X) = xf (x)dx.

k

Beweis: Maßtheorie.

Bemerkung:

• Im Satz sind die Gleichungen so zu verstehen, dass die eine Seite genau dann

wohldefiniert ist, wenn es die andere Seite ist. Beispielsweise im Falle von X mit

Zähldichte existiert der Erwartungswert genau dann, wenn die Reihe konvergiert.

4.1

Erwartungswert

28

• Für unsere Zwecke kann man die Gleichungen aus dem Satz als Definition des

Erwartungswerts ansehen.

• Man beachte, dass der Erwartungswert jeweils nur von der Verteilung abhängt.

Beispiel: Erwartungswert der Augenzahl bei einmaligem Werfen eines Würfels.

P

Lösung: E(X) = 6k=1 k · 16 = 3, 5.

Beispiel: Erwartungswert für X mit der Dichte f (x) =

R

R∞

Lösung: E(X) = xf (x)dx = −∞ π1 ·

Erwartungswert ist also nicht definiert!

x

1+x2

=

1

2π

1

π

·

1

1+x2

(Cauchy-Verteilung).

∞

ln(1 + x2 ) −∞ = ∞ − ∞. Der

Satz: (Eigenschaften des Erwartungswerts.) Sei (Ω, F, P ) ein Wahrscheinlichkeitsraum, seien X, Y reelle ZVen, A ∈ F, a, b ∈ R.

(a) E(1A ) = P (A), E(1) = E(1Ω ) = 1

(b) Linearität: E(aX + bY ) = a · E(X) + b · E(Y )

(c) Monotonie: X ≤ Y ⇒ E(X) ≤ E(Y )

(d) Multiplikativität: X,Y unabhängig ⇒ E(XY ) = E(X)E(Y )

Beweis: (für diskrete ZVen). Seien X, Y diskret mit gemeinsamer Dichte ρ.

(a) E(1A ) = 1 · P (1A = 1) + 0 · P (1A = 0) = P (A), denn {1A = 1} = A.

(b) Mit g(x, y) = ax + by folgt aus dem letzten Satz

X

X X

X X

E(aX + bY ) =

(ax + by)ρ(x, y) = a

x

ρ(x, y) + b

y

ρ(x, y)

x,y

=a

x

X

xρX (x) + b

x

X

y

y

x

yρY (y) = aE(X) + bE(Y ).

y

(c) Nach (b) ist E(Y ) − E(X) = E(Y − X) =

P

(y − x) · ρ(x, y) ≥ 0.

x,y | {z }

≥0

(d) Mit g(x, y) = xy folgt aus dem letzten Satz

X

X

X

X

E(XY ) =

xyρ(x, y) =

xyρX (x)ρY (y) = (

xρX (x))(

yρY (y)) = E(X)E(Y ).

x,y

x,y

x

y

Bemerkung:

• Im Satz ist implizit vorausgesetzt, dass die Erwartungswerte existieren.

• Per Induktion verallgemeinert man (b), (d) auf endliche Summen und Produkte.

4.2

Kovarianz und Varianz

4.2

29

Kovarianz und Varianz

Definition: Sei L2 := {X : Ω → R ZVe : E(X 2 ) < ∞}.

Bemerkung:

• Es gilt L2 ⊂ L1 und man kann zeigen, dass L1 und L2 Vektorräume sind.

• Für X, Y ∈ L2 ist E(XY ) wohldefiniert.

Definition: Für X, Y ∈ L2 ist die Kovarianz definiert durch

Cov(X, Y ) := E[(X − E(X))(Y − E(Y ))] = E(XY ) − E(X)E(Y ).

Für X1 , ..., Xn ∈ L2 wird (E(Xi ))i als Erwartungsvektor und (Cov(Xi , Xj ))i,j als

Kovarianzmatrix bezeichnet.

Bemerkung:

• Die Gleichheit in der Definition ergibt sich durch Ausmultiplizieren aus der Linearität des Erwartungswerts.

• Interpretation der Kovarianz: das Vorzeichen von Cov(X, Y ) bestimmt sich daraus, ob X −E(X) und Y −E(Y ) bevorzugt gleiches Vorzeichen oder verschiedenes

Vorzeichen haben. Cov(X, Y ) ist also ein gewisses Maß dafür, ob X und Y lieber

gleichzeitig relativ große und relativ kleine Werte annehmen (bezogen auf den

jeweiligen Mittelwert) oder nicht. Man bezeichnet bei

> 0 X, Y als positiv korreliert

Cov(X, Y ) < 0 X, Y als negativ korreliert

= 0 X, Y als unkorreliert

• Aus der Multiplikativitätsregel des Erwartungswerts folgt sofort, dass unabhängige ZVen automatisch unkorreliert sind.

Satz: (Eigenschaften der Kovarianz.). Seien X, Y, Xi , Yi ∈ L2 , ai , bi , c ∈ R, 1 ≤ i ≤ n.

(a) Symmetrie: Cov(X, Y ) = Cov(Y, X).

P

P

P P

(b) Bilinearität: Cov( i ai Xi , j bj Yj ) = i j ai bj Cov(Xi , Yj ).

(c) Konstanten: Cov(X, Y + c) = Cov(X, Y ), Cov(X, c) = 0.

(d) C := (Cov(Xi , Xj ))ij ist positiv semidefinit: ∀v ∈ Rn : v T Cv =

P

i,j

vi Cij vj ≥ 0.

4.2

Kovarianz und Varianz

30

Beweis: (a) ist klar

(b) Wegen (a) genügt es die Linearität in der ersten Komponente zu zeigen:

X

X

X

Cov

ai X i , Y = E

ai Xi − E(

ai Xi ) Y − E(Y )

i

i

X

iX

=E

ai (Xi − E(Xi ))(Y − E(Y )) =

ai E (Xi − E(Xi ))(Y − E(Y ))

i

=

X

i

ai Cov(Xi , Y ).

i

(c) Cov(X, c) = E((X − E(X))(c − E(c))) = E(0) = 0 und P

der Rest folgt mit (b).

(d) Für v ∈ Rn ist wegen (b) unter Verwendung von Z := i vi Xi

X

X

X

vi Cov(Xi , Xj )vj = Cov

v i Xi ,

vj Xj = Cov(Z, Z) = E((Z − E(Z))2 ) ≥ 0.

i,j

i

j

Definition: Für X ∈ L1 ist die Varianz definiert durch

V(X) := Cov(X, X) = E[(X − E(X))2 ] = E(X 2 ) − E(X)2 .

Bemerkung:

• Aus der Definition folgt sofort V(X) ≥ 0. Für X ∈ L1 kann V(X) = ∞ sein. Für

X ∈ L2 ist V(X) < ∞.

• V(X) = E[(X − E(X))2 ] ist der durchschnittliche quadratische Abstand von X

zu seinem Mittelwert. V(X) ist also ein gewisses Maß dafür, wie stark die Werte

von X streuen.

Satz: (Eigenschaften der Varianz.) Seien X, Xi ∈ L2 und c ∈ R, 1 ≤ i ≤ n.

(a) Konstanten: V(X + c) = V(X), V(cX) = c2 V(X), V(c) = 0.

P

P

P

(b) Summenregel: V( i Xi ) = P i V(Xi )P

+ i6=j Cov(Xi , Xj ). Insbesondere gilt für

unabhängige X1 , ..., Xn V( i Xi ) = i V(Xi ).

Beweis: Diese Eigenschaften ergeben sich sofort aus V(X) = Cov(X, X) und den

Eigenschaften der Kovarianz.

Beispiel: Man bestimme E und V für die Augensumme bei 12 Mal Würfeln.

Lösung: Seien X1 , ..., X12 die erzielten Augenzahlen. Die Xi sind unabhängig und

gleichverteilt auf

P {1, ..., 6}. Wir2verfolgen

P 22 Ansätze:

(1) E(X) =

k kρX (k), E(X ) =

k k ρX (k). Um diese Summen zu berechnen,

benötigen wir ρX . Diese Zähldichte zu bestimmen, ist aber sehr aufwändig, daher beschreiten wir einen Alternativweg:

4.2

Kovarianz und Varianz

31

(2) Wir bestimmen zunächst E(Xi ) und V(Xi ):

6

X

1 + ... + 6

7

1

=

E(Xi ) =

k =

6

6

2

k=1

und

E(Xi2 )

=

6

X

k2

k=1

1

12 + ... + 62

91

=

= ,

6

6

6

49

35

91

2

2

. Mit den Rechenregeln für E und V folgt

also V(Xi ) = E(X

P i ) − E(Xi ) = 6 − 4 = 12P

nun E(X) = i E(Xi ) = 42 und V(X) = i V(Xi ) = 35. Letzteres gilt, da die Xi

unabhängig sind.

Bisweilen ist es sinnvoll ZVen auf eine Normalform zu bringen,

√

die Standardisierung von X.

Definition: Für X ∈ L2 heißt X ∗ := X−E(X)

V(X)

Bemerkung:

• Nach den Rechenregeln für E und V ist E(X ∗ ) = √ 1

V(X)

V(X ∗ ) = ( √ 1

V(X)

(E(X) − E(X)) = 0 und

)2 V(X) = 1. X ∗ ist also eine größenbereinigte Version von X.

• X ∗ hat die gleiche Wahrscheinlichkeitsverteilung wie X, abgesehen davon dass

die Werte entsprechend verschoben und gestaucht wurden.

Definition:

• Für X ∈ L1 ist die Standardabweichung definiert durch σ(X) :=

• Für X, Y ∈ L2 ist die Korrelation definiert durch ρ(X, Y ) :=

p

V(X).

Cov(X,Y )

.

σ(X)σ(Y )

Bemerkung:

Y −E(Y )

• Es gilt ρ(X, Y ) = E( X−E(X)

) = E(X ∗ Y ∗ ) = Cov(X ∗ , Y ∗ ).

σ(X)

σ(Y )

• Cov und V haben die schöneren Eigenschaften, und sind daher zum Rechnen

besser geeignet. Dafür haben σ und ρ die interessantere Interpretation:

• Da V ein Maß für die durchschnittliche quadratische Abweichung vom Mittelwert ist, kann σ als Maß für die durchschnittliche Abweichung vom Mittelwert

betrachtet werden.

• ρ(X, Y ) = E(X ∗ Y ∗ ) ist ein Maß für die Tendenz, dass X ∗ und Y ∗ gleichgroße

Werte haben. Nach dem folgenden Lemma ist ρ(X, Y ) ∈ [−1, 1] und die extremalen Fälle werden erreicht durch ρ(X, X) = 1 (Größe genau gleich) und

ρ(X, −X) = −1 (Größe genau gegenläufig).

Lemma: Für X, Y ∈ L2 ist ρ(X, Y ) ∈ [−1, 1].

Beweis: Die Behauptung folgt mittels der Rechenregeln aus

0 ≤ V(X ∗ ± Y ∗ ) = V(X ∗ ) + V(Y ∗ ) ± 2Cov(X ∗ , Y ∗ ) = 2 ± 2ρ(X, Y ).

4.3

Verwendung von Indikatorfunktion und Bedingungen

4.3

32

Verwendung von Indikatorfunktion und Bedingungen

P

Ist X = i 1Ai , so haben wir für jedes Ai , das eintritt, 1Ai = 1, d.h. X ist die Anzahl

von allen Ereignissen Ai die eintreten. Hier kann man den Erwartungswert (und die

Varianz) besonders einfach berechnen:

P

Satz: Ist X = i 1Ai mit Ai ∈ F, 1 ≤ i ≤ n, so ist

X

X

X

E(X) =

P (Ai ) und E(X 2 ) =

P (Ai ) +

P (Ai ∩ Aj ).

i

i

i6=j

P

P

P

Beweis: E(

) = i P (Ai ) P

und die zweite

Gleichung folgt ebenso,

i

i 1Ai ) =P i E(1AP

P

P

2

2

2

da X = ( i 1Ai ) = i 1Ai + i6=j 1Ai 1Aj = i 1Ai + i6=j 1Ai ∩Aj .

Beispiel: Wir wählen rein zufällig eine 8-stellige Codezahl mit Ziffern aus {1, ..., 6}.

Man bestimme, wie viele verschiedenen Ziffer die Codezahl im Durchschnitt hat.

Lösung: Sei Ω {1, ..., 6}8 , F = P(Ω), P = UΩ . Sei P

X die Anzahl der verschiedenen

Ziffern, die in der Codezahl vorkommen. Es ist X =

1Ai , wobei Ai das Ereignis ist,

dass Ziffer i vorkommt. P (Ai ) und P (Ai ∩ Aj ) sind aber nicht so leicht zu bestimmen.

P

Leichter ist P (Aci ) = ( 65 )8 und P (Aci ∩ Acj ) = ( 46 )8 . Daher setzen wir Y := i 1Aci die

Anzahl der Ziffern, die nicht vorkommen. Es gilt X = 6−Y und E(Y ) und V(Y ) ergeben

sich aus dem vorhergehenden Satz: E(Y ) = 6( 65 )8 ≈ 1, 4, E(Y 2 ) = 6( 65 )8 +6·5( 46 )8 ≈ 2, 6,

also V(Y ) = E(Y 2 ) − E(Y )2 = 0, 6. Hieraus folgt sofort E(X) = 6 − E(Y ) ≈ 4, 6 und

V(X) = V(Y ) ≈ 0, 6.

Beispiel: Man zeige mittels Indikatorfunktionen die Einschluss-Ausschlussformel:

P

n

[

Ai =

i=1

n

X

X

(−1)k+1

k=1

P

J⊂{1,...,n}:|J|=k

\

Aj

für Ai ∈ F.

j∈J

Lösung: Schreibt man die Wahrscheinlichkeiten als Erwartungen von Indikatorfunktionen, so genügt es wegen der Linearität der Erwartung zu zeigen, dass

1

S

i Ai

n

X

X

=

(−1)k+1

1T

k=1

Aj ,

d.h.

1−1

S

j∈J

J:|J|=k

i Ai

=

n

X

(−1)k

k=0

X

J:|J|=k

1T

Aj .

j∈J

Q

Dies zeigt man unter Verwendung von 1 − 1A = 1Ac und 1∩Ai = 1Ai : Es ist

Y

Y

XY

1 − 1Si Ai = 1(Si Ai )c = 1Ti Aci =

1Aci =

(1 − 1Ai ) =

(−1Ai ) und

i

X

k

k

(−1)

X

J:|J|=k

1

T

i∈J

Ai

i

J

i∈J

X

X Y

X X Y

=

(−1)k

1Ai =

(−1Ai ).

k

J:|J|=k i∈J

k

J:|J|=k i∈J

4.3

Verwendung von Indikatorfunktion und Bedingungen

33

Eine andere Methode zur Berechnung des Erwartungswerts beruht auf einer Fallunterscheidungsformel analog zu der für Wahrscheinlichkeiten. Hierbei steht E(X|Y = y)

für den Erwartungswert von X unter dem Wahrscheinlichkeitsmaß P (.|Y = y).

Satz: Seien X, Y reelle Zufallsvariablen. Hat Y Zähldichte ρ bzw. Dichte f so gilt

Z

X

E(X) =

E(X|Y = y)ρ(y) bzw. E(X) = dyE(X|Y = y)f (y),

y

falls die rechte Seite definiert ist. Zusammenfassend schreibt man diese Formel auch in

der Form E(X) = E(E(X|Y )) (“Turmeigenschaft für den Erwartungswert”).

P

P ρ (x,y)

, also

Beweis: (für X, Y diskret.) E(X|Y = y) = x xρX (x|Y = y) = x x X,Y

ρY (y)

X

X X ρX,Y (x, y)

XX

E(X|Y = y)ρ(y) =

x

ρY (y) =

xρX,Y (x, y) = E(X).

ρ

(y)

Y

y

y

x

x

y

Beispiel: Ein Stab der Länge 1 bricht an einer zufälligen Stelle. Der rechte Teil wird

weggeworfen, der linke Teil bricht wieder an einer zufälligen Stelle, und der rechte Teil

wird wieder weggeworfen. Wie groß ist der restliche Teil im Durchschnitt?

Lösung:

Sei Y die Restlänge nach dem ersten Bruch und X die Restlänge nach dem zweiten

Bruch. Die Verteilung von Y ist U[0,1] und die bedingte Verteilung von X, gegeben

Y = y, ist U[0,y] . Wir verfolgen 2 Ansätze:

(1) Aus den gegebenen Verteilungen bestimmt man die gemeinsame Dichte

fX,Y (x, y) =

R

1

fY (y)fX (x|Y = y) = 1[0,1] (y) y 1[0,y] (x), und berechnet hieraus E(X) = dxdyxfX,Y (x, y).

Aufgrund der Struktur des Problems ist aber folgender Ansatz einfacher: