kq

Werbung

4. Das multiple lineare Regressionsmodell

Bisher:

• 1 endogene Variable y wurde zurückgeführt auf 1 exogene

Variable x (einfaches lineares Regressionsmodell)

Jetzt:

• Endogenes y wird regressiert auf mehrere exogene Variablen

x1, . . . , xK (multiples lineares Regressionsmodell)

Es zeigt sich:

• Viele Ergebnisse und Intuitionen der einfachen Regression

übertragen sich auf das multiple Modell

130

Wichtige Hilfsmittel:

• Matrixalgebra

• Erwartungswertvektor

• Kovarianzmatrix

• multivariate Normalverteilung

131

Inhaltlicher Aufbau:

• Modellspezifikation

(A-, B-, C-Annahmen)

• Punktschätzung

(KQ-, ML-Schätzung, Bestimmtheitsmaß)

• Hypothesentests

(t-Test, F -Test)

• Prognose

132

4.1 Spezifikation

Beispiel: (I)

• Schätzung einer Produktionsfunktion für Gerste

• Exogene Variablen (Düngemitteleinsätze):

Phosphat p (in kg/ha)

Stickstoff n (in kg/ha)

• Endogene Variable (Output):

Gerste g (in 100kg/ha)

133

Beispiel: (II)

• Stichprobenumfang:

30 Beobachtungen (Parzellen)

• Ökonomisches Modell:

g = f (p, n)

(grundlegender Wirkungszusammenhang)

Nächster Schritt:

• Funktionale Spezifikation

134

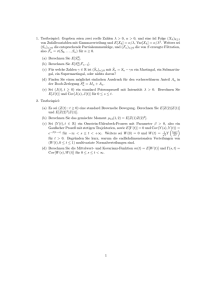

Erhobener Datensatz

i

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

pi

22.00

22.00

22.00

22.00

23.00

23.00

23.0

23.00

24.00

24.00

24.00

24.00

25.00

25.00

25.00

ni

40.00

60.00

90.00

120.00

50.00

80.00

100.00

120.00

40.00

60.00

90.00

120.00

50.00

80.00

100.00

gi

38.36

49.03

59.87

59.35

45.45

53.23

56.55

50.91

44.87

54.06

60.34

58.21

51.52

58.58

57.27

i

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

pi

25.00

26.00

26.00

26.00

26.00

27.00

27.00

27.00

27.00

28.00

28.00

28.00

28.00

29.00

29.00

ni

110.00

50.00

70.00

90.00

110.00

40.00

60.00

80.00

100.00

50.00

70.00

100.00

110.00

60.00

100.00

gi

59.55

55.24

54.13

66.57

61.74

48.99

54.38

58.28

62.81

50.76

51.54

59.39

68.17

59.25

64.39

135

1. Funktionale Form (A-Annahmen)

Spezifikation in 3 Schritten:

• 1. Schritt: (I)

Möglicher Wirkungszusammenhang:

g = α + β1p + β2n

(α, β1, β2 unbekannte Parameter)

Nachteil: keine abnehmenden Grenzerträge

136

• 1. Schritt: (II)

Realistischer:

g = Apβ1 nβ2

mit Parametern A, β1, β2

(Cobb-Douglas-Produktionsfunktion)

Nachteil: Zusammenhang ist nicht linear

Ausweg: Logarithmieren

ln(g) = ln(A) + β1 ln(p) + β2 ln(n)

Definiere

y ≡ ln(g),

x1 ≡ ln(p),

−→ Lineares Modell

x2 ≡ ln(n),

α ≡ ln(A)

y = α + β1x1 + β2x2

137

Logarithmierter Datensatz

i

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

x1i

[ln(pi )]

3.0910

3.0910

3.0910

3.0910

3.1355

3.1355

3.1355

3.1355

3.1781

3.1781

3.1781

3.1781

3.2189

3.2189

3.2189

x2i

[ln(ni)]

3.6889

4.0943

4.4998

4.7875

3.9120

4.3820

4.6052

4.7875

3.6889

4.0943

4.4998

4.7875

3.9120

4.3820

4.6052

yi

[ln(gi )]

3.6470

3.8924

4.0922

4.0835

3.8166

3.9746

4.0351

3.9301

3.8038

3.9901

4.1000

4.0641

3.9420

4.0704

4.0478

i

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

x1i

[ln(pi)]

3.2189

3.2581

3.2581

3.2581

3.2581

3.2958

3.2958

3.2958

3.2958

3.3322

3.3322

3.3322

3.3322

3.3673

3.3673

x2i

[ln(ni)]

4.7005

3.9120

4.2485

4.4998

4.7005

3.6889

4.0943

4.3820

4.6052

3.9120

4.2485

4.6052

4.7005

4.0943

4.6052

yi

[ln(gi)]

4.0868

4.0117

3.9914

4.1983

4.1229

3.8916

3.9960

4.0653

4.1401

3.9271

3.9424

4.0841

4.2220

4.0818

4.1650

138

• 2. und 3. Schritt:

Das ökonometrische Modell lautet für i = 1, . . . , 30:

yi = α + β1x1i + β2x2i + ui

Jetzt:

• Allgemeine Formulierung des multiplen linearen Regressionsmodells mit K exogenen Variablen

yi = α + β1x1i + β2x2i + . . . + βK xKi + ui

für i = 1, . . . , N , bzw. ausgeschrieben

y1 = α + β1x11 + β2x21 + . . . + βK xK1 + u1

y2 = α + β1x12 + β2x22 + . . . + βK xK2 + u2

...

yN = α + β1x1N + β2x2N + . . . + βK xKN + uN

139

Bemerkungen:

• Die (K + 1) Parameter α, β1, . . . , βK heißen Regressionsparameter oder Regressionskoeffizienten

• Die Zufallsvariable ui ist eine Störgröße

Jetzt:

• Formulierung der klassischen A-, B-, C-Annahmen für das

multiple Regressionsmodell

140

1. Funktionale Form (A-Annahmen)

• Annahme A1:

Im multiplen Regressionsmodell (Folie 139) fehlen keine relevanten exogenen Variablen und die benutzten exogenen Variablen x1, x2, . . . , xK sind nicht irrelevant

• Annahme A2:

Der wahre Zusammenhang zwischen x1i, x2i, . . . , xKi und yi

ist linear

• Annahme A3:

Die Parameter α, β1, . . . , βK sind für alle N Beobachtungen

(x1i, x2i, . . . , xKi, yi) konstant

141

Bemerkung:

• Die Annahmen A1 bis A3 postulieren, dass das ökonometrische

Modell funktional nicht fehlspezifiziert ist

2. Störgrößenspezifikation (B-Annahmen) (I):

• Annahme B1:

Die Störgröße ui hat für alle Beobachtungen i = 1, . . . , N

einen Erwartungswert von Null, d.h.

E(ui) = 0

für i = 1, . . . , N

142

2. Störgrößenspezifikation (B-Annahmen) (II):

• Annahme B2: (Homoskedastie)

Die Störgröße ui hat für alle Beobachtungen i = 1, . . . , N eine

konstante Varianz, d.h. für i = 1, . . . , N gilt

V ar(ui) = σ 2

• Annahme B3: (Keine Autokorrelation)

Die Störgröße ui ist nicht autokorreliert, d.h. für alle i =

1, . . . , N und j = 1, . . . , N mit i 6= j gilt

Cov(ui, uj ) = 0

• Annahme B4:

Die Störgrößen ui sind normalverteilt, d.h. ui ∼ N (0, σ 2)

143

Bemerkung:

• B1 bis B4 besagen, dass die N Störgrößen u1, . . . , uN die

gleiche Wahrscheinlichkeitsverteilung besitzen (nämlich ui ∼

N (0, σ 2)) und alle unabhängig voneinander sind

144

3. Variablenspezifikation (C-Annahmen)

• Annahme C1:

Die exogenen Variablen x1i, . . . , xKi sind keine Zufallsvariablen, sondern können wie in einem Experiment kontrolliert

werden

• Annahme C2: (Freiheit von perfekter Multikollinearität)

Es existieren keine Parameterwerte γ0, γ1, . . . , γK (wobei mindestens ein γk 6= 0), so dass zwischen den exogenen Variablen

x1i, . . . , xKi die lineare Beziehung

γ0 + γ1x1i + . . . + γK xKi = 0

für alle i = 1, 2, . . . , N gilt

145

Bemerkung: (Perfekte Multikollinearität)

• Betrachte Zweifachregression

yi = α + β1x1i + β2x2i + ui

• Wenn C2 verletzt ist, gibt es γ0, γ1, γ2 mit

γ0 + γ1x1i + γ2x2i = 0

und damit

x2i = −(γ0/γ2) −γ1/γ2 x1i

|

{z

≡δ0

}|

{z }

≡δ1

−→ Es liegt keine Zweifachregression vor, denn

yi = (α + β2δ0) + (β1 + β2δ1)x1i + ui

146

Jetzt:

• Formulierung des multiplen linearen Regressionsmodells von

Folie 139 in Matrixschreibweise

Setze dazu:

y=

y1

y2

...

yN

,X =

1 x11 · · · xK1

α

β

1 x12 · · · xK2

1

β

=

,

...

...

.

...

···

..

1 x1N · · · xKN

βK

,u =

u1

u2

...

uN

−→ Matrixschreibweise:

y = Xβ + u

147

Ausgeschrieben:

y1

1

y

1

..2 = ..

.

.

yN

x11

x12

...

1 x1N

· · · xK1

· · · xK2

...

···

· · · xKN

α

u1

u

β

..1 + ..2

.

.

βK

uN

Jetzt:

• Formulierung der A-, B-, C-Annahmen in Matrixdarstellung

148

1. Funktionale Form (A-Annahmen)

• Annahme A1:

Im multiplen Regressionsmodell fehlen keine relevanten exogenen Variablen und die benutzten exogenen Variablen (Spalten der X-Matrix) sind nicht irrelevant

• Annahme A2:

Der wahre Zusammenhang zwischen X und y ist linear

• Annahme A3:

Der Parametervektor β ist für alle N Beobachtungen (xi, yi)

konstant

149

2. Störgrößenspezifikation (B-Annahmen) (I)

• Annahme B1:

E(u) = 0N ×1

Zwischenbemerkungen: (I)

• Betrachte die (N × N )-Matrix uu0 mit Erwartungswert

u1 u1 u1 u2 · · · u1 u N

u2u1 u2u2 · · · u2uN

0

E(uu ) = E

...

...

...

···

uN u1 uN u2 · · · u N uN

E(u2

E(u1u2) · · · E(u1uN )

1)

E(u2u1)

E(u2

· · · E(u2uN )

2)

=

...

...

...

···

E(uN u1) E(uN u2) · · · E(u2

N)

150

Zwischenbemerkungen: (II)

• Wegen B1 gilt E(ui) = 0 bzw. E(uj ) = 0 und damit

E(uiuj ) =

(

E{[ui − E(ui)][uj − E(uj )]} = Cov(ui, uj )

E{[ui − E(ui)][ui − E(ui)]} = V ar(ui)

, für i 6= j

, für i = j

Hieraus folgt

0

E(uu ) =

V ar(u1)

Cov(u1, u2)

V ar(u2)

Cov(u2, u1)

...

...

Cov(uN , u1) Cov(uN , u2)

· · · Cov(u1, uN )

· · · Cov(u2, uN )

...

···

V ar(uN )

···

= Cov(u)

151

Definition 4.1: (Varianz-Kovarianz-Matrix)

Die Matrix E(uu0) = Cov(u), die sowohl die Varianzen sämtlicher

Störgrößen als auch alle Kovarianzen zwischen den Störgrößen

enthält, wird als Varianz-Kovarianz-Matrix des multiplen Regressionsmodells bezeichnet.

Zwischenbemerkungen: (III)

• Gilt nun V ar(ui) = σ 2 für alle i = 1, . . . , N (Annahme B2,

vgl. Folie 143) sowie Cov(ui, uj ) = 0 für alle i = 1, . . . , N und

j = 1, . . . , N mit i 6= j (Annahme B3, vgl. Folie 143), so folgt

für die Varianz-Kovarianz-Matrix

Cov(u) =

σ2 0

0 σ2

...

...

0 0

··· 0

··· 0

· · · ...

· · · σ2

2

=σ

1

0

...

0

0

1

...

0

···

···

···

···

0

0

...

1

= σ 2IN

152

2. Störgrößenspezifikation (B-Annahmen) (II)

• Annahmen B2 und B3:

Cov(u) = σ 2IN

• Annahme B4:

Der Störgrößenvektor u ist multivariat normalverteilt mit

u ∼ N (0N ×1, σ 2IN )

153

3. Variablenspezifikation (C-Annahmen) (I)

• Annahme C1:

Keines der Elemente der (N × [K + 1])-Matrix X ist eine

Zufallsvariable

Zwischenbemerkungen: (I)

• Die X-Matrix lässt sich wie folgt zerlegen:

mit

X = [x0 x1 · · · xK ]

x0 ≡

1

1

...

1

,

x1 ≡

x11

x12

...

x1N

,···,

xK ≡

xK1

xK2

...

xKN

154

Zwischenbemerkungen: (II)

• Die Spaltenvektoren x1, . . . , xK repräsentieren jeweils die N

Beobachtungen der K exogenen Variablen

• Gilt rang(X) = K + 1, so sind die Spaltenvektoren x0, x1, . . . ,

xK linear unabhängig

(vgl. Definitionen 2.7, 2.8 auf den Folien 32, 33)

3. Variablenspezifikation (C-Annahmen) (II)

• Annahme C2: (Freiheit von perfekter Multikollinearität)

rang(X) = K + 1

155

4.2 (Punkt)Schätzung

Für die KQ-Schätzung im multiplen linearen Regressionsmodell:

• Ökonometrisches Modell:

y = Xβ + u

yi = α + β1x1i + β2x2i + . . . + βK xKi + ui

• Geschätztes Modell:

b

ŷ = Xβ

ŷi = α̂ + β̂1x1i + β̂2x2i + . . . + β̂K xKi

• Residuen:

b = y−y

b

u

ûi = yi − ŷi

156

Jetzt:

b im multiplen Modell

• Bestimmung des KQ-Schätzers β

Herleitung: (I)

• Residualquadratsumme in Matrixschreibweise:

b 0u

b

Sûû = u

=

N

X

û2

i

i=1

157

Herleitung: (II)

• Wegen

b

b = y − Xβ

u

ûi = yi − α̂ − β̂1x1i − . . . − β̂K xKi

folgt:

Sûû =

=

0

b

b

y − Xβ

y − Xβ

N

X

i=1

yi − α̂ − β̂1x1i − . . . − β̂K xKi

2

158

Herleitung: (IV)

• Minimierungsbedingungen lauten:

∂ Sûû

b

∂β

=

∂ Sûû/∂ α̂

∂ Sûû/∂ β̂1

...

∂ Sûû/∂ β̂K

(Normalengleichungen)

= 0(K+1)×1

159

Herleitung: (VI)

• Berechung des Gradienten: (siehe Übung)

∂ Sûû

b

∂β

0

∂

b

b

=

y − Xβ

y − Xβ

b

∂β

=

0 y − ∂ 2y0 Xβ

b + ∂ β

b 0X0Xβ

b

y

b

b

b

∂β

∂β

∂β

∂

b

= −2X0y + 2X0Xβ

−→ Normalengleichungssystem:

−→ KQ-Schätzer:

b = X0 y

X0Xβ

−1

0

b = XX

β

X0 y

160

Ausführliche Schreibweise:

0

XX =

=

1

1 ···

1

x11 x12 · · · x1N

...

...

...

...

xK1 xK2 ... xKN

N

PN

x1i

Pi=1

N x2

i=1 1i

PN

i=1 x1i

.

...

P ..

PN

N x

i=1 xKi x1i

i=1 Ki

0

Xy =

1 x11 · · · xK1

1 x12 · · · xK2

...

...

...

···

1 x1N · · · xKN

PN

x

···

PNi=1 Ki

···

i=1 x1i xKi

...

...

...

1

1

1 ···

y1

x11 x12 · · · x1N

y2

...

...

...

...

...

yN

xK1 xK2 ... xKN

PN

2

i=1 xKi

,

PN

y

PNi=1 i

i=1 x1i yi

=

...

P

N x y

i=1 Ki i

161

Illustration: (Düngemittelbeispiel) (I)

• Aus den N = 30 Daten von Folie 138 errechnet man:

N = 30,

30

X

x1i = 96.77,

i=1

30

X

yi = 120.42,

i=1

30

X

i=1

x1iyi = 388.57,

30

X

x2i = 129.72

i=1

30

X

x2

1i = 312.39,

i=1

x1ix2i = 418.46

i=1

i=1

30

X

30

X

x2

2i = 564.63,

30

X

x2iyi = 521.66

i=1

162

Illustration: (Düngemittelbeispiel) (II)

• Somit folgt:

30

b =

β

96.77

−1

96.77 129.72

120.42

312.39 418.46 388.57

129.72 418.46 564.63

0.9543

= 0.5965 =

0.2626

521.66

α̂

β̂1

β̂2

163

EViews-Output für die Düngemittelregression

Dependent Variable: Y

Method: Least Squares

Date: 07/12/04 Time: 15:16

Sample: 1 30

Included observations: 30

Variable

Coefficient

Std. Error

t-Statistic

Prob.

C

X1

X2

0.954315

0.596520

0.262552

0.469432

0.137878

0.033997

2.032913

4.326445

7.722780

0.0520

0.0002

0.0000

R-squared

Adjusted R-squared

S.E. of regression

Sum squared resid

Log likelihood

Durbin-Watson stat

0.742742

0.723686

0.065210

0.114812

40.91675

1.751158

Mean dependent var

S.D. dependent var

Akaike info criterion

Schwarz criterion

F-statistic

Prob(F-statistic)

4.013865

0.124054

-2.527783

-2.387663

38.97652

0.000000

164

Jetzt:

• Bestimmtheitsmaß R2 bei multipler Regression

Weiterhin gilt:

• Streuungszerlegung

Syy = Sŷŷ + Sûû

(vgl. Satz 3.6, Folie 96)

−→ Definition des multiplen Bestimmtheitsmaßes:

Sŷŷ

Syy − Sûû

Sûû

2

=

=1−

R =

Syy

Syy

Syy

(vgl. Def. 3.7, Folie 97)

165

Jetzt:

• Explizite Berechnung des multiplen Bestimmtheitsmaßes

Satz 4.2: (Formel für das R2)

Für das multiple Bestimmtheitsmaß R2 gilt:

b − N y2

Sŷŷ

y0X(X0X)−1X0y − N y 2

y 0 Xβ

2

R =

=

= 0

.

0

2

2

Syy

y y − Ny

y y − Ny

Bemerkungen:

• Herleitung: Von Auer (2007)

• Vgl. auch Übung

166

Illustration: (Düngemittelbeispiel) (I)

• Aus den N = 30 Daten von Folie 138 errechnet man:

N = 30,

y0y =

y = 4.013865,

120.415937

X0y = 388.565728 ,

521.658742

30

X

i=1

yi2 = 483.779553

0.954315

b =

β

0.596520

0.262552

167

Illustration: (Düngemittelbeispiel) (II)

• Daraus folgt

0.954315

b =

y0Xβ

120.415937 388.565728 521.658742 0.596520

0.262552

= 483.664510

h

i

und somit

483.664510 − 30 · 4.0138652

2

R =

= 0.742164

2

483.779553 − 30 · 4.013865

168

Bemerkungen:

• Rundungsfehler

• Aufnahme zusätzlicher X-Variablen führt (fast) immer zur

Erhöhung des R2

−→ Adjustiertes Bestimmtheitsmaß:

2 = 1 − (1 − R2)

Radj

N −1

N −K −1

Jetzt:

• Eigenschaften des KQ-Schätzers

b = (X0X)−1X0y

β

169

Satz 4.3: (Erwartungstreue des KQ-Schätzers)

Unter den A-, B-, C-Annahmen (ohne B4) ist der KQ-Schätzer

b = (X0X)−1X0y erwartungstreu für β , d.h.

β

b = β.

E β

Für die Varianz-Kovarianz-Matrix des KQ-Schätzers gilt:

−1

0

2

b

.

Cov β = σ X X

170

Bemerkungen: (I)

• Im Detail besagt die Erwartungstreue

E(α̂) = α,

E(β̂1) = β1,

...

E(β̂K ) = βK

• Zur Herleitung der Erwartungstreue sowie der Kovarianzmab vgl. Übung

trix von β

• Spezialfall der Einfachregression (K = 1):

1 x1

X = ... ... ,

1 xN

X0 X =

"

#

PN

N

i=1 xi

PN

PN

2

i=1 xi

i=1 xi

171

Bemerkungen: (II)

• Inverse einer (2 × 2)-Matrix:

A=

"

a11 a12

a21 a22

#

,

A−1 =

1

a11a22 − a12a21

−→ Berechnung von

b) =

Cov(β

"

V ar(α̂) Cov(α̂, β̂)

Cov(α̂, β̂) V ar(β̂)

#

"

a22 −a12

−a21 a11

= σ 2(X0X)−1

(vgl. Satz 4.3, Folie 170; Übung)

172

#

Satz 4.4: (Gauß-Markov-Theorem)

Unter den A-, B-, C-Annahmen (ohne B4) ist der KQ-Schätzer

b = (X0X)−1X0y der beste lineare unverzerrte Schätzer für den

β

Parametervektor β .

(BLUE = Best Linear Unbiased Estimator)

Bemerkungen:

• Bedeutung von BLUE im multiplen Fall?

∗

b

• Es sei β ein anderer linearer E-treuer Schätzer für β

b ) ist positiv semidefinit

b ∗) − Cov(β

−→ Cov(β

(vgl. Definition 2.13, Folie 47)

173

Verteilung von y: (I)

• Zunächst

y = Xβ + u,

d.h. y ist eine lineare Funktion von u

• Aufgrund der B-Annahmen gilt

u ∼ N (0N ×1, σ 2IN )

−→ auch y ist multivariat normalverteilt

174

Verteilung von y: (II)

• Erwartungswertvektor von y:

E(y) = E(Xβ + u)

= E(Xβ ) + E(u)

= Xβ

• Kovarianzmatrix von y:

Cov(y) = Cov(Xβ + u)

= Cov(u)

= σ 2IN

• Also gilt:

y ∼ N (Xβ , σ 2IN )

175

b : (I)

Verteilung von β

• Zunächst

b = (X0X)−1X0y,

β

b ist eine lineare Funktion von y

d.h. β

• Verteilung von y

y ∼ N (Xβ , σ 2IN )

(vgl. Folie 175)

b ist multivariat normalverteilt

−→ auch β

176

b : (II)

Verteilung von β

b sind

• Erwartungswertvektor und Kovarianzmatrix von β

b = β,

E β

(vgl. Satz 4.3, Folie 170)

• Also gilt:

b = σ 2(X0X)−1

Cov β

b ∼ N (β , σ 2(X0X)−1)

β

b gilt

• Für die Einzelkomponenten von β

α̂ ∼ N (α, V ar(α̂))

bzw.

β̂k ∼ N (βk , V ar(β̂k )),

mit V ar(α̂) bzw. V ar(β̂k ) als den entsprechenden Diagonalelementen von σ 2(X0X)−1

177

Problem erneut:

• Störtermvarianz σ 2 ist unbekannt

b ) = σ 2(X0X)−1 kann nicht berechnet werden

−→ Cov(β

(vgl. Einfachregression, Folien 91 ff.)

Satz 4.5: (E-treuer Schätzer für σ 2)

Ein erwartungstreuer Schätzer für die unbekannte Störtermvarianz

σ 2 ist gegeben durch

σ̂ 2 =

N

b

b 0u

X

u

1

2

û =

.

N − K − 1 i=1 i

N −K−1

178

Bemerkungen:

• Man zeige die Erwartungstreue, d.h. E(σ̂ 2) = σ 2, mittels der

Beziehung

b = y−y

b

u

b

= y − Xβ

= y − X(X0X)−1X0y

=

(vgl. Übung)

h

i

0

−1

0

IN − X(X X) X y

• Von besonderer Bedeutung: M ≡ IN − X(X0X)−1X0

(Residuen-Erzeugungsmatrix)

179

EViews-Output für die Düngemittelregression

Dependent Variable: Y

Method: Least Squares

Date: 07/12/04 Time: 15:16

Sample: 1 30

Included observations: 30

Variable

Coefficient

Std. Error

t-Statistic

Prob.

C

X1

X2

0.954315

0.596520

0.262552

0.469432

0.137878

0.033997

2.032913

4.326445

7.722780

0.0520

0.0002

0.0000

R-squared

Adjusted R-squared

S.E. of regression

Sum squared resid

Log likelihood

Durbin-Watson stat

0.742742

0.723686

0.065210

0.114812

40.91675

1.751158

Mean dependent var

S.D. dependent var

Akaike info criterion

Schwarz criterion

F-statistic

Prob(F-statistic)

4.013865

0.124054

-2.527783

-2.387663

38.97652

0.000000

180

Illustration: (Düngemittelbeispiel) (I)

b 0u

b = 0.114812

• Sum squared resid = u

b 0u

b

0.114812

u

2

=

= 0.0042523

=⇒ σ̂ =

N −K−1

30 − 2 − 1

• S.E. of regression =

r

b

b 0u

u

N −K−1 =

√

σ̂ 2 = σ̂ = 0.065210

• σ̂ 2 = 0.0042523 und Hauptdiagonalelemente von σ̂ 2(X0X)−1

liefern die geschätzten Varianzen Vd

ar(α̂), Vd

ar(β̂1), Vd

ar(β̂2)

181

Illustration: (Düngemittelbeispiel) (II)

• σ̂ = 0.065210 und die Wurzeln der Hauptdiagonalelemente

von σ̂ 2(X0X)−1 liefern die Standardfehler der KQ-Schätzer

SE(α̂) = 0.469432

SE(β̂1) = 0.137878

SE(β̂2) = 0.033997

182

4.3 Hypothesentests

2 Arten von Hypothesentests:

• t-Tests (Tests basierend auf der t-Verteilung)

• F -Tests (Tests basierend auf der F -Verteilung)

183

Zunächst:

• Testen einer Linearkombination von Parametern

• In der Einfachregression hatten wir

H0 : β = q

gegen

H1 : β 6= q

• Im multiplen Modell betrachten wir

H0 : r0α + r1β1 + . . . + rK βK = q

H1 : r0α + r1β1 + . . . + rK βK 6= q

i

h

0

bzw. mit r = r0 r1 · · · rK

H0 : r0 β = q

H1 : r0β 6= q

184

Illustration: (Düngemittelbeispiel)

• Test auf konstante Skalenerträge:

also

α

β=

β1 ,

β2

0

r = 1 ,

1

q=1

H0 : r0β = β1 + β2 = 1

H1 : r0β = β1 + β2 6= 1

zum Signifikanzniveau a = 5%

185

Geeignete Teststatistik: (I)

b −q

r0β

• T =

b)

SE(r0β

b ):

• Form des Standardfehlers SE(r0β

b )r = σ 2r0(X0X)−1r

b ) = r0Cov(β

V ar(r0β

mit

b) =

=⇒ SE(r0β

σ̂ 2 =

q

b) =

Vd

ar(r0β

q

σ̂ 2r0(X0X)−1r

N

b

b 0u

X

1

u

û2

=

N −K−1

N − K − 1 i=1 i

186

Geeignete Teststatistik: (II)

• Verteilung von T unter Gültigkeit von H0 : r0β = q:

T

(unter H0)

∼

tN −K−1

(t−Verteilung mit N − K − 1 Freiheitsgraden)

−→ Kritischer Bereich:

(−∞, −tN −K−1;1−a/2] ∪ [tN −K−1;1−a/2, +∞)

d.h. lehne H0 ab, falls

|T | ≥ tN −K−1;1−a/2

187

EViews-Output für die Düngemittelregression

Dependent Variable: Y

Method: Least Squares

Date: 07/12/04 Time: 15:16

Sample: 1 30

Included observations: 30

Variable

Coefficient

Std. Error

t-Statistic

Prob.

C

X1

X2

0.954315

0.596520

0.262552

0.469432

0.137878

0.033997

2.032913

4.326445

7.722780

0.0520

0.0002

0.0000

R-squared

Adjusted R-squared

S.E. of regression

Sum squared resid

Log likelihood

Durbin-Watson stat

0.742742

0.723686

0.065210

0.114812

40.91675

1.751158

Mean dependent var

S.D. dependent var

Akaike info criterion

Schwarz criterion

F-statistic

Prob(F-statistic)

4.013865

0.124054

-2.527783

-2.387663

38.97652

0.000000

188

Berechnung der Teststatistik:

h

b =

r0 β

α̂

0 1 1 β̂1 = β̂1 + β̂2

β̂2

i

= 0.596520 + 0.262552 = 0.859072

Standardfehler der Teststatistik:

b ) = SE(β̂ + β̂ )

SE(r0β

1

2

q

=

=

=

d β̂ , β̂ )

Vd

ar(β̂1) + Vd

ar(β̂2) + 2Cov(

1 2

q

(0.137878)2 + (0.033997)2 + 2 · 0.0000287

p

0.01901 + 0.001156 + 0.000057

= 0.142208

189

−→

T =

b −q

r0β

=

0

b

SE(r β )

0.859072 − 1

= −0.990999

0.142208

Testentscheidung:

|T | = 0.990999 < 2.0518 = t27;0.975

−→ H0 kann nicht abgelehnt werden

(konstante Skalenerträge sind mit den Daten vereinbar)

190

Spezialfälle des allgemeinen t-Tests: (I)

• Betrachte die K + 1 Vektoren

r0 =

1

0

...

0

r1 =

,

0

1

...

0

,...,

rK =

0

0

...

1

,

q=0

−→ Testprobleme

H0 : α = 0 gegen H1 : α 6= 0

H0 : β1 = 0 gegen H1 : β1 6= 0

...

H0 : βK = 0 gegen H1 : βK 6= 0

191

Spezialfälle des allgemeinen t-Tests: (II)

• Teststatistiken:

b

r00β

α̂

Tα =

=

b

0

SE(α̂)

SE(r0β )

Tβ1

TβK

0β

b

r1

β̂1

=

=

b

0

SE(β̂1)

SE(r1β )

...

b

r0K β

β̂K

=

=

b)

SE(β̂K )

SE(r0K β

192

EViews-Output für die Düngemittelregression

Dependent Variable: Y

Method: Least Squares

Date: 07/12/04 Time: 15:16

Sample: 1 30

Included observations: 30

Variable

Coefficient

Std. Error

t-Statistic

Prob.

C

X1

X2

0.954315

0.596520

0.262552

0.469432

0.137878

0.033997

2.032913

4.326445

7.722780

0.0520

0.0002

0.0000

R-squared

Adjusted R-squared

S.E. of regression

Sum squared resid

Log likelihood

Durbin-Watson stat

0.742742

0.723686

0.065210

0.114812

40.91675

1.751158

Mean dependent var

S.D. dependent var

Akaike info criterion

Schwarz criterion

F-statistic

Prob(F-statistic)

4.013865

0.124054

-2.527783

-2.387663

38.97652

0.000000

193

EViews-Output:

Koeffizientenschätzung

• t-Statistic = Standardfehler

des Koeffizientenschätzers

• Prob. = p-Wert des t-Tests

(Kleinstes Signifikanzniveau zur Ablehnung von H0)

Einseitiger (linksseitiger) t-Test:

H0 : r 0 β ≥ q

gegen

• Teststatistik

T =

H 1 : r0 β < q

b −q

r0 β

b)

SE(r0β

• Lehne H0 zum Niveau a ab, falls T < −tN −K−1;1−a

194

Jetzt:

• Simultanes Testen mehrerer Parameterbeziehungen

(F -Test)

Lineares multiples Regressionsmodell:

y

(N ×1)

=

X

·

β

(N ×[K+1]) ([K+1]×1)

+

u

(N ×1)

Null- und Alternativhypothese:

H 0 : Rβ = q

H 1 : Rβ 6 = q

mit R einer (L × [K + 1])-Matrix und q einem (L × 1)-Vektor

195

Beispiele: (I)

• H0 : β1 = β2 = . . . = βK = 0

−→ R =

0

0

...

0

1

0

...

0

0 ···

1 ···

... ...

0 ···

0

0

...

1

,

q=

0

0

...

0

= 0L

• H0 : β1 + . . . + βK = 1 und gleichzeitig β1 = 2β2

−→ R =

"

0 1 1 1 ··· 1

0 1 −2 0 · · · 0

#

,

q=

"

1

0

#

196

Beispiele: (II)

• H0 : β1 = 5 und gleichzeitig β2 = . . . = βK = 0

−→ R =

0

0

0

...

0

1

0

0

...

0

0

1

0

...

0

0

0

1

...

0

···

···

···

...

···

0

0

0

...

1

,

q=

5

0

0

...

0

197

Grundidee des F -Tests: (I)

• Vergleiche Residualquadratsumme des Regressionsmodells

b0b

Sûû = u u =

N

X

ûi2

i=1

mit Residualquadratsumme des Nullhypothesenmodells

N

X

0

0

2

b =

b )0 u

(û0

Sû0û0 = (u

i)

i=1

b 0 ist der Residualvektor, der sich bei der KQ-Schätzung

(u

unter Berücksichtigung von H0 ergibt)

198

Grundidee des F -Tests: (II)

• Es muss immer gelten

Sû0û0 ≥ Sûû

• Die Nullhypothese ist vermutlich falsch, falls

Sû0û0 >> Sûû

199

Durchführung des Tests: (I)

• Geeignete Teststatistik:

F =

=

Sû0û0 − Sûû /L

Sûû/(N − K − 1)

i

i0 h

i−1 h

0

0

−1

b

b

Rβ − q

Rβ − q R(X X) R

b0b

h

u u/(N − K − 1)

• Verteilung von F unter Gültigkeit von H0 : Rβ = q:

F

(unter H0)

∼

FL,N −K−1

(F −Verteilung mit L und N − K − 1 Freiheitsgraden)

200

Durchführung des Tests: (II)

• Kritischer Bereich zum Signifikanzniveau a:

[FL,N −K−1;1−a, +∞)

d.h. lehne H0 zum Niveau a ab, falls

F ≥ FL,N −K−1;1−a

[(1 − a)-Quantil der FL,N −K−1-Verteilung]

201

EViews-Output für die Düngemittelregression

Dependent Variable: Y

Method: Least Squares

Date: 07/12/04 Time: 15:16

Sample: 1 30

Included observations: 30

Variable

Coefficient

Std. Error

t-Statistic

Prob.

C

X1

X2

0.954315

0.596520

0.262552

0.469432

0.137878

0.033997

2.032913

4.326445

7.722780

0.0520

0.0002

0.0000

R-squared

Adjusted R-squared

S.E. of regression

Sum squared resid

Log likelihood

Durbin-Watson stat

0.742742

0.723686

0.065210

0.114812

40.91675

1.751158

Mean dependent var

S.D. dependent var

Akaike info criterion

Schwarz criterion

F-statistic

Prob(F-statistic)

4.013865

0.124054

-2.527783

-2.387663

38.97652

0.000000

202

EViews-Output:

• F-statistic = F -Test für das Testproblem

H0 : β1 = β2 = . . . = βK = 0

• Prob(F-statistic) = p-Wert des F -Tests

(Kleinstes Signifikanzniveau zur Ablehnung von H0)

203

4.4 Prognose

Ziel:

• Bedingte Prognose des endogenen Wertes y0 bei gegebenen

Werten der K exogenen Variablen x10, x20, . . . , xK0

(vgl. Prognose der Einfachregression, Abschnitt 3.4)

204

Dafür: (I)

• Es seien

0 =

x0

h

1 x10 x20 · · · xK0

der Vektor der exogenen Variablen und

i

b = (X0X)−1X0y

β

der KQ-Schätzer des multiplen Regressionsmodells

−→ Bedingte Punktprognose:

b

ŷ0 = x00β

• Prognosefehler:

b − x0 β − u = x0

ŷ0 − y0 = x00β

0

0

0

b

β − β − u0

205

Dafür: (II)

• Varianz des Prognosefehlers:

0

2

0

−1

V ar(ŷ0 − y0) = σ 1 + x0(X X) x0

• Geschätzte Varianz des Prognosefehlers:

−1

2

0

0

d

V ar(ŷ0 − y0) = σ̂ 1 + x0(X X) x0

b

b 0u/(N

mit σ̂ 2 = u

− K − 1)

−→ Standardfehler des Prognosefehlers:

SE(ŷ0 − y0) =

q

Vd

ar(ŷ0 − y0)

206

Jetzt:

• Konstruktion eines (1 − a)-Prognoseintervalls über die Standardisierung des Prognosefehlers

(vgl. Folie 125)

T =

=0

}|

{

(ŷ0 − y0) − E (ŷ0 − y0)

z

SE(ŷ0 − y0)

• Man kann zeigen, dass

T ∼ tN −K−1

(t-Verteilung mit N − K − 1 Freiheitsgraden)

−→ (1 − a)-Prognoseintervall:

[ŷ0−tN −K−1;1−a/2·SE(ŷ0−y0), ŷ0+tN −k−1;1−a/2·SE(ŷ0−y0)]

207