Schätzen und Testen

Werbung

Schätzen und Testen

c

M.

Gruber, FHM

Version vom 18. Juni 2007

1

1 STICHPROBEN UND DEREN VERWENDUNG

2

1 Stichproben und deren Verwendung

Die Vorlesung verzweigt nun in zwei Richtungen, die unabhängig voneinander studiert werden können. Jeder Zweig führt in ein Spezialgebiet der inferentiellen Statistik ein, in die Schätztheorie einerseits, in

die Testtheorie andrerseits.

1.1 Stichproben

Eine Stichprobe ist eine endliche und echte Teilmenge einer statistischen Grundgesamtheit, die Aufschluss über die Grundgesamtheit liefern soll. Die Anzahl n der Stichprobenelemente heißt Stichprobenumfang.

Stichproben werden zur Beurteilung der Grundgesamtheit herangezogen, wenn eine Vollerhebung zu teuer, zu zeitaufwendig, nicht sinnvoll, zu keiner Zeit durchführbar, oder wegen der unendlichen Größe

der Grundgesamtheit nicht möglich ist.

Die wesentliche Eigenschaft einer Stichprobe ist ihre Zufälligkeit.

1.2 Schätzen

Mit Hilfe von Stichproben ist man in der Lage, den Typ oder Parameter

(z.B. Mittelwert, Streuung, Anteilswert) von Merkmalsverteilungen zu

schätzen.

Die Schätzung kann in der Angabe einer bestimmten Zahl für den

unbekannten Parameter bestehen (Punktschätzung) oder in der Angabe

eines Intervalls, das den unbekannten Parameter überdeckt (Intervallschätzung).

In beiden Fällen sind die Schätzungen mit Unsicherheit behaftet, die

man mit Hilfe der Wahrscheinlichkeitsrechnung abschätzt und möglichst klein hält.

1.3 Testen

Bei statistischen Testverfahren werden Hypothesen über den Typ oder

über Parameter der Merkmalsverteilung einer Grundgesamtheit durch

Stichproben überprüft. Ein solches Testverfahren kann dazu führen,

daß die vor dem Test aufgestellte Hypothese verworfen (andernfalls beibehalten) wird.

Eine derartige Entscheidung ist mit Unsicherheit behaftet, da sie

aufgrund eines Zufallsexperiments, nämlich der Stichprobe, gefällt wird.

Diese Unsicherheit wird mit Hilfe der Wahrscheinlichkeitsrechnung abgeschätzt und möglichst klein gehalten.

2 ELEMENTE DER SCHÄTZTHEORIE

3

2 Elemente der Schätztheorie

2.1 Ein Beispiel

2.1.1 Schätzung eines Fehleranteils

Der p eines Serienproduktes soll geschätzt werden. Dazu werden n zufällige Stichproben gezogen, d.h. es werden B(1, p)-verteilte Zufallsvariablen X1 , . . . , Xn “realisiert”: xi = 1, wenn das i-te gezogene Stück fehlerhaft ist, andernfalls xi = 0. Man beachte, dass wir Zufallsvariablen

groß schreiben, deren Realisierungen dagegen klein. Aus den beobachteten Werten soll nun das unbekannte p möglichst gut durch einen

Schätzwert p̂ geschätzt werden.

Wir schätzen

p̂ = U (X1 , . . . , Xn )

mit der Schätzfunktion

U (x1 , . . . , xn ) =

1 X

xi ,

n

1≤i≤n

d.h.: Ist bei den n Stichproben N -mal ein fehlerhaftes Stück gezogen

worden, schätzen wir

N

p̂ = .

n

2.1.2 Eigenschaften der Schätzfunktion p̂

1. p̂ ist erwartungstreu (auch unverzerrt, engl. unbiased), d.h.

Ep̂ = p.

2. p̂ ist konsistent (sehr wünschenswert!), d.h.

P

p̂ −→ p

für n −→ ∞.

Dies folgt unmittelbar aus dem schwachen Gesetz der großen Zahlen. Es bedeudet, dass eine Abweichung der Schätzfunktion vom

wahren Wert p mit wachsendem Stichprobenumfang n immer unwahrscheinlicher wird.

3. Unter allen erwartungstreuen Schätzfunktionen ist p̂ diejenige mit

der kleinsten Varianz (ohne Beweis). Es ist

σ 2 (p̂) =

1

1

p(1 − p) ≤

.

n

4n

2.1.3 Konfidenzintervalle für p

Für den wahren Parameter p und jede Realisierung u = U (x1 , . . . , xn )

von p̂ ist

(p, u) ∈ Q = [0, 1] × [0, 1].

2 ELEMENTE DER SCHÄTZTHEORIE

4

Wir geben B ⊂ Q an, sodass (p, p̂) ∈ B mit statistischer Sicherheit 1 − 2β

gilt (β vorgegeben, z.B. β = 0.025). Zu p ∈ [0, 1] sei Ip das Intervall mit

Mittelpunkt p, für das

Pp (p̂ ∈ Ip ) = 1 − 2β

(möglichst genau!) gilt. Der Index p bei P bedeutet, dass p der Parameterwert zur Berechnung der Wahrscheinlichkeit ist. Für

[

B =Q∩

{p} × Ip

p∈[0,1]

gilt dann

P ((p, p̂) ∈ B)) = 1 − 2β.

(1)

Durch die Funktionen f1 und f2 sei der linke bzw. rechte Rand der

Menge B parametrisiert. Dann kann die Beziehung (1) auch geschrieben werden als

P (f1 (p̂)) ≤ p ≤ f2 (p̂)) = 1 − 2β.

Interpretation: Mit statistischer Sicherheit (Konfidenzwahrscheinlichkeit) 1 − 2β wird für eine Realisierung u = U (x1 , . . . , xn ) von p̂ der wahre

Parameter p zwischen f1 (u) und f2 (u) eingeschlossen.

Das Intervall [f1 (u), f2 (u)] heißt Konfidenzintervall (auch Mutungsintervall), f1 (u) und f2 (u) heißen Vertrauensgrenzen, die Zahl 2β Fehlerwahrscheinlichkeit.

2.1.4 Approximative Konfidenzintervalle

Wir betrachten den Fall, dass n und p eine Approximation durch die

Normalverteilung erlauben. Mit Φ(−h) = β gilt dann

!

np̂ + 21 − np

≤h

≈ Φ(h) − Φ(−h)

P −h ≤ p

np(1 − p)

= 1 − 2β.

Daraus erhält man

h2 p(1 − p)

1

≈ 1 − 2β.

− p)2 ≤

P (p̂ +

2n

n

Die Gleichung der Randkurve von B lautet daher näherungsweise

(u +

woraus man

herleiten kann.

1

h2 p(1 − p)

− p)2 =

,

2n

n

h p

1

u(1 − u) + O( )

f1,2 (u) = u ± √

n

n

2 ELEMENTE DER SCHÄTZTHEORIE

5

2.2 Konfidenzintervalle

Als Beispiel für die Vorgehensweise haben wir Konfidenzintervalle für

den Anteil an einer Grundgesamtheit konstruiert. Wir werden nun angeben, wie man für andere Größen (z.B. für den Mittelwert einer N (µ, σ)verteilten Grundgesamtheit) Konfidenzintervalle bestimmt.

Generell gilt (wie im Speziallfall 2.1.3):

• Erhöhung der Konfidenzwahrscheinlichkeit vergrößert die Konfidenzintervalle: Sichere Aussagen sind unscharf und scharfe Aussagen sind unsicher.

• Erhöhung des Stichprobenumfangs verkleinert die Konfidenzintervalle.

2.2.1 K.-I. für p (Normalverteilungsapproximation)

Seien x1 , . . . , xn die Stichprobenergebnisse einer B(1, p)-verteilten Grundgesamtheit. Für die Schätzgröße

p̂ =

1 X

xi

n

1≤i≤n

gelte min{np̂, n(1 − p̂)} > 5 (somit ist eine Approximation durch die Normalverteilung vertretbar). Mit Konfidenzwahrscheinlichkeit 1−2β überdeckt dann das Konfidenzintervall

#

"

r

r

p̂(1 − p̂)

p̂(1 − p̂)

1

1

−z

, p̂ +

+z

p̂ −

2n

n

2n

n

den wahren Parameter p (dabei ist z das rechte β-Quantil der N (0, 1)Verteilung).

Beispiel 1 Bei einer Blitzumfrage waren 45 von 225 befragten wahlberechtigten Personen der Überzeugung, daß die gegenwärtige Regierung

vor Ablauf der Legislaturperiode abgelöst wird. Zwischen welchen Grenzen wird der Anteil p der Wahlberechtigten, die diese Überzeugung haben, mit 90% Konfidenzwahrscheinlichkeit liegen?

p̂ =

45

= 0.2 .

225

Wegen np̂ = 45 > 5 und n(1 − p̂) = 180 > 5 kann man die Normalverteilung

zur Approximation heranziehen und erhält als Grenzen des Konfidenzintervalls

!

r

0.16

1

+ 1.64

0.2 ∓

450

225

und damit das Konfidenzintervall

[0.154 , 0.246] .

Also liegt mit statistischer Sicherheit von 90% der Anteil zwischen 15.4%

und 24.6%.

2 ELEMENTE DER SCHÄTZTHEORIE

6

2.2.2 K.-I. für p (exakt)

Exakte Vertrauensgrenzen,Pauch falls sich np̂ ≤ 5 oder n(1 − p̂) ≤ 5

n

für den Schätzwert p̂ = n1 i=1 xi ergibt, erhält man mit Hilfe der F Verteilung. Mit Konfidenzwahrscheinlichkeit 1 − 2β ist

np̂

(np̂ + 1)F2

,

np̂ + (n − np̂ + 1)F1 n − np̂ + (np̂ + 1)F2

ein Konfidenzintervall, das p enthält.

Dabei sind F1 und F2 rechte β-Quantile der F -Verteilung mit Freiheitsgraden ν1 und ν2 :

F1

F2

= Fν1 ;ν2 ;β

= Fν1 ;ν2 ;β

mit ν1 = 2(n − np̂ + 1) und ν2 = 2np̂,

mit ν1 = 2(np̂ + 1) und ν2 = 2(n − np̂).

Beispiel 2 Bei einer Blitzumfrage waren 45 von 225 befragten wahlberechtigten Personen der Überzeugung, daß die gegenwärtige Regierung

vor Ablauf der Legislaturperiode abgelöst wird. Zwischen welchen Grenzen wird der Anteil p der Wahlberechtigten, die diese Überzeugung haben, mit 90% Konfidenzwahrscheinlichkeit liegen? Man berechne die Vertrauensgrenzen exakt. Mit ν1 = 2 · (225 − 45 + 1) = 362 und ν2 = 2 · 45 ist

F1 = F362 ; 90 ; 0.05 = 1.3. Mit ν1 = 2 · (45 + 1) = 92 und ν2 = 2 · (225 − 45) = 360

45

46·1.22

ist F2 = F92 ; 360 ; 0.05 = 1.22. Die Werte 45+181·1.3

= 0.161 und 180+46·1.22

=

0.237 sind die exakten Grenzen des Konfidenzintervalls. Also liegt mit

statistischer Sicherheit von 90% der Anteil zwischen 16.1% und 23.7%.

2.2.3 K.-I. für µ einer N (µ, σ)-Verteilung (σ bekannt)

Mit Konfidenzwahrscheinlichkeit 1 − 2β ist

–

»

σ

σ

µ̂ − z √ , µ̂ + z √

n

n

P

n

mit der Schätzfunktion µ̂ = n1 i=1 xi ein Konfidenzintervall zur Stichprobe

x1 , . . . , xn einer N (µ, σ)-verteilten Grundgesamtheit, das µ überdeckt. Dabei ist

z das rechte β-Quantil der N (0, 1)-Verteilung.

Beispiel 3 Aus einer N (µ, 12)-verteilten Grundgesamtheit wird eine Stichprobe

mit Umfang n = 36 gezogen, die für µ̂ den Wert 26 liefert. Für 1 − 2β = 0.95 erhält

man das Konfidenzintervall

»

–

12

12

26 − 1.96 √ , 26 + 1.96 √

.

36

36

2.2.4 K.-I. für µ einer N (µ, σ)-Verteilung (σ unbekannt)

Mit Konfidenzwahrscheinlichkeit 1 − 2β ist

σ̂

σ̂

µ̂ − t √ , µ̂ + t √

n

n

2 ELEMENTE DER SCHÄTZTHEORIE

7

mit den Schätzfunktionen

µ̂ =

1 X

xi

n

1≤i≤n

und

σ̂ =

sP

1≤i≤n (xi

n−1

− µ̂)2

ein Konfidenzintervall zur Stichprobe x1 , . . . , xn einer N (µ, σ)-verteilten

Grundgesamtheit, das µ überdeckt.

Dabei ist t das rechte β-Quantil der t-Verteilung (Student-Verteilung)

mit n − 1 Freiheitsgraden.

Beispiel 4 Eine aus einer normalverteiltenPGrundgesamtheit gezogene

Stichprobe vom Umfang 17 ergibt µ̂ = 5 und 1≤i≤17 (xi − µ̂)2 = 25. Welche

Vertrauensgrenzen ergeben sich für den Mittelwert µ bei einer geforderten Konfidenzwahrscheinlichkeit von 99%?

Der benötigte Wert der t-Verteilung ist in der Tabelle der zweiseitigen

1%-Schranken (oder einseitigen 0.5%-Schranken) der t-Verteilung mit 16

Freiheitsgraden nachzuschlagen. Man findet den Wert 2.921.

Damit ergeben sich die Grenzen

r

25

,

5 ∓ 2.921 ·

16 · 17

also 4.11 und 5.89.

2.2.5 K.-I. für den Median µ̃ (Stichprobenumfang n ≥ 9)

Bei nicht normalverteilten Grundgesamtheiten gibt man meist einen

Vetrauensbereich für den Median anstatt für den Mittelwert an (a heißt

Median, wenn P (x ≤ a) ≥ 21 und P (x ≥ a) ≥ 21 gilt).

Ordnet man die Werte x1 , . . . , xn einer Stichprobe aufsteigend an,

so erhält man eine neue Folge x(1) , . . . , x(n) . Mit diesen Werten ist (falls

n ≥ 9)

x(h+1) , x(n−h)

ein Konfidenzintervall, das mit Konfidenzwahrscheinlichkeit 1 − 2β den

Median µ̃ überdeckt. Dabei ist

√

n−1−z n

c

h=b

2

(mit der floor-Funktion bxc = max {m ∈ Z|m ≤ x}) und z das rechte βQuantil der N (0, 1)-Verteilung.

Beispiel 5 Ausgehend von den Werten einer Stichprobe vom Umfang n =

50 soll ein Konfidenzintervall angegeben werden, das mit statistischer

Sicherheit von 95% den Median der Grundgesamtheit überdeckt.

Als 2.5%-Quantil der Normalverteilung erhält man den Wert 1.96. Damit ergibt sich

√

50 − 1 − 1.96 50

h=b

c = b17.570c = 17 .

2

3 ELEMENTE DER TESTTHEORIE

8

Die Vertrauensgrenzen sind auf der Grundlage der geordneten Werte

x(1) , . . . , x(50)

der Stichprobe zu bilden. Man erhält als linke Grenze x(17+1) = x(18) und

als rechte Grenze x(50−17) = x(33) .

3 Elemente der Testtheorie

3.1 Ein Beispiel

3.1.1 Testen der Hypothese “die Münze ist fair”

Von einer Münze mit den Seiten A und Z wird angenommen, dass sie

“fair” ist in dem Sinne, dass nach zufälligem Werfen die A-Seite mit

Wahrscheinlichkeit 0.5 oben liegt.

Wir nehmen uns folgenden Test der Hypothese H0 “die Münze ist

fair” vor: Wir werfen die Münze fünfmal. Wenn dabei das Ereignis AAAAA

oder ZZZZZ eintritt, verwerfen wir H0 , ansonsten nehmen wir H0 an.

Kurz: Über die B(1, p)-verteilten Zufallsvariablen X1 , . . . , X5 wird die

Hypothese H0 : p = 0.5 aufgestellt. Zur Testvariablen

U (X1 , . . . , X5 ) =

5

X

Xi

i=1

geben wir uns die Entscheidungsvorschrift: Verwirf H0 , wenn die Realisierung von U den Wert 0 oder 5 ergibt.

3.1.2 α-Fehler und β-Fehler

Mögliche Entscheidungsverläufe dieses Tests:

1. (Berechtigte) Ablehnung von H0 , wenn H0 nicht zutrifft.

2. (Unberechtigte) Ablehnung von H0 , wenn H0 zutrifft (α-Fehler oder

5

Fehler 1. Art); Wahrscheinlichkeit hierfür: 2 · 21 = 0.0625.

3. (Berechtigte) Annahme von H0 , wenn H0 zutrifft.

4. (Unberechtigte) Annahme von H0 , wenn H0 nicht zutrifft (β-Fehler

oder Fehler 2. Art); Wahrscheinlichkeit hierfür: 1 − p5 − (1 − p)5 mit

dem (wahren) Parameter p 6= 21 .

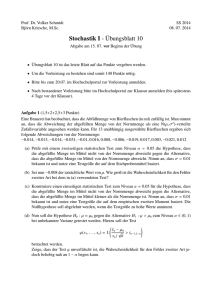

3.1.3 Gütefunktion des Tests

Die Gütefunktion

G(p) = p5 + (1 − p)5

(Abbildung 1) des Tests zeigt die Ablehnwahrscheinlichkeit von H0 als

Funktion von p. An ihr kann man die Wahrscheinlichkeit für den αFehler (G(p), p = 21 ) und für den β-Fehler (1 − G(p), p 6= 12 ) ablesen.

Man erkennt: die Ablehnwahrscheinlichkeit von H0 wird erst groß,

wenn p stark von 21 abweicht.

3 ELEMENTE DER TESTTHEORIE

9

1.00 r

r

r

r

r

0.75

r

r

r

r

r

r

r

r

r

r

0.50

r

r

r

r

r

r

r

r

r

r

0.25

0.00

0.00

r

rr

rr

rr

rr

0.25

rr

rrr

rrrrrr

rrrrrrrrr

0.50

rrr

r

r

rr

rr

r

0.75

1.00

p

Abbildung 1: Gütefunktion des Tests “die Münze ist fair”

3.1.4 Kritische Bereich und Annahmebereich

Unser Test unterscheidet zwei Teilmengen des Wertebereichs der Testfunktion U :

• Führt die Realisierung von U zu den Werten 0 oder 5, so verwerfen

wir H0 : Die Menge {0, 5} heißt kritischer Bereich des Tests.

• Führt die Realisierung von U zu einem Wert der Menge {1, 2, 3, 4},

so behalten wir H0 (bis auf weiteres) bei. Die Menge {1, 2, 3, 4} heißt

Annahmebereich des Tests.

3.1.5 Vergrößerung des kritischen Bereichs

Durch Vergrößerung des kritischen Bereichs wird der β-Fehler kleiner,

der α-Fehler dagegen größer.

Abbildung 2 zeigt die Gütefunktionen des Münzwurftests für Stichprobenumfang n = 10 und die kritischen Bereiche K1 = {0, 1, 9, 10},

K2 = {0, 1, 2, 8, 9, 10}, K3 = {0, 1, 2, 3, 7, 8, 9, 10}.

3.1.6 Erhöhung des Stichprobenumfangs

Durch Erhöhung des Stichprobenumfangs wird der α-Fehler kleiner,

der β-Fehler dagegen größer.

Abbildung 3 zeigt die Gütefunktionen Gn des Münzwurftests zum

kritischem Bereich K = {0, 1, 2, 3, n − 3, n − 2, n − 1, n} und Stichprobenumfang n = 10, 13, 16.

3 ELEMENTE DER TESTTHEORIE

rb r r r s s s s

1.00 rbsssss

b r s

b

0.75

0.50

0.25

0.00

0.00

10

r r rb rb

s s ssr ssss

s ss r r r b b

s

K1 b

r ss

b

b

ss r r

s

b r r ss

b

K2 r

s

r

s

s

b

b

r

r

K3 s

s

s

r

r

s

s

b

b

r

r

s

s

b

b

s

s

r

r

s

s

b

b

r

r

s

s

r

r

b

b

ss

ss

r

r

b

b

s

s

r

r

s

s

b

b

ss

s

r

r

s s ss s s s

b

b

r

r

b

b

r

r

b

b

rr

rr

b

b

rr

r

bb

b

r

rrr

r

bb

bb

rrrrrrrr

bbb

bb

b

b

bbbbb

b

bbbbbbbbbb

rr

ss

0.25

0.50

0.75

1.00

p

Abbildung 2: Gütefunktion für verschiedene kritische Bereiche

rb rb rb rbs rbs rb br b b

1.00 sss

s r b

0.75

0.50

0.25

0.00

0.00

rb rb rb

b b rb srb srb sss

s r bb

b b br r rs s

b

s r b

s

b r

G10 b

s r bb

b b r r ss

s r b

G13 r

b

r

b

s rr bb

G16 s

b r s

s r

s

b

b

b rr s

s r bb

b

b

b

s r

r s

b

b

r s

s r

bb

b

r

s rr

bb

bb

r ss

bb

bb

s r

b

r s

bbbbbb

s r

r

s r

r s

r

s rr

r ss

s

r

ss r r r

s

r

ss r r r r r r r r r ss s

s ss

s

s ss sss s s s s

0.25

0.50

0.75

p

Abbildung 3: Gütefunktion für verschiedene Stichprobenumfänge

1.00

3 ELEMENTE DER TESTTHEORIE

11

rb rb rb r s s

1.00 sssss

r s

0.50

0.05

r r rb rb

s s sssss

ss r r b b

b r ss

s

r

r

b

b

b

G9

s

s

b rr s

s r b

G12 r

b r s

s rr b

G17 s

b

b r s

s

b r s

s rr b

b r s

s r b

b

s

s r b

r

b

s r bb

b r ss

s

r

r b

b

s r b

b r s

b r s

s r b

b r s

s rrbb

b r s

s

bbr s

s r b

b rb r s

s r rb b b

s

s

r

rb

bbr s

b rb rb sr s s

srb srb rb rb b

s

s

b rb rb srb ss

s

r

b

rb rb rb rb

0.00

0.25

0.50

0.75

1.00

p

Abbildung 4: Gütefunktionen zum Signifikanzniveau α = 0.05

3.1.7 Kontrolle des α-Fehlers

α-Fehler wiegen schwerer als β-Fehler. Deshalb gestaltet man Tests so,

dass die Wahrscheinlichkeit für einen α-Fehler unterhalb eines vorgebenen Signifikanzniveaus α bleibt (übliche Werte: α = 0.05, 0.01, 0.001).

Abbildung 4 zeigt die Gütefunktionen Gn der Tests zum Niveau α = 0.05

mit Stichprobenumfang n = 9, 12, 17 und kritischen Bereichen K9 =

{0, 1, 9, 10}, K12 = {0, 1, 2, 10, 11, 12} bzw. K17 = {0, 1, 2, 3, 4, 13, 14, 15, 16, 17}.

3.1.8 Trennschärfe

Eine wünschenswerte Eigenschaft eines Tests ist die Trennschärfe. Darunter versteht man die Eigenschaft, dass ein Test (neben der Einhaltung der α-Schranke für den Fehler 1. Art) möglichst kleine Werte für

die Wahrscheinlichkeit des Fehlers 2. Art aufweist. Damit “trennt” der

Test die Hypothese H0 möglichst “scharf” von den Alternativen zu H0 .

Im Fall des Münzwurfs heißt dies, dass die Gütefunktion des Tests

für p 6= 21 möglichst große Werte annehmen soll.

Man kann zeigen, dass man “beliebig trennscharfe” Tests erhält,

wenn der Stichprobenumfang entsprechend erhöht werden kann.

3.1.9 Einseitige Alternative H1

Der soeben betrachtete Münzwurftest war symmetrisch in dem Sinn,

dass als Alternative zur Nullhypothese H0 : p = 21 (stillschweigend) die

Hypothese H1 : p 6= 12 betrachtet wurde.

Es kann jedoch in manchen Situationen sinnvoll sein, die Alternative H1 einseitig zu formulieren.

3 ELEMENTE DER TESTTHEORIE

12

1.00

s

s

s

s

s

s

s

s

0.50

s

s

s

s

s

ss

0.05

sssssssssssssssssssss ssss ss ss

0.00

ss s

ss s s s s s

0.25

0.50

ss s

s

s

ss

ss

s

0.75

1.00

p

Abbildung 5: Gütefunktion für den einseitigen Test (n = 5)

Beispiel 6 S1 fordert S2 zu einer Wette auf. S1 setzt auf A einen gewissen Betrag, S2 soll auf Z einen ebenso großen Betrag setzen. Die Münze

gehört S1 . S2 hat Zweifel, ob die Münze fair ist und vermutet, dass A öfter

fällt als Z.

S2 erhält Gelegenheit für einen Test. S2 nimmt sich vor, die Münze

fünfmal zu werfen und sie zu beanstanden, wenn AAAAA eintritt.

Formale Beschreibung des einseitigen Tests

• H0 : p ≤ 21 , H1 : p > 21 ,

• Testvariable U (X1 , . . . , X5 ) =

• kritischer Bereich K = {5}.

P

1≤i≤5

Xi ,

• Signifikanzniveau α = 0.05

• Gütefunktion: Abbildung 5

Steigerung der Trennschärfe

• H0 : p ≤ 12 , H1 : p > 21 ,

• Testvariable U (X1 , . . . , X16 ) =

P

1≤i≤16

Xi ,

• kritischer Bereich K = {12, 13, 14, 15, 16}.

• Signifikanzniveau α = 0.05

• Gütefunktion: Abbildung 6

3 ELEMENTE DER TESTTHEORIE

13

1.00

ss

s ss

ss ssss

s

s

s

s

s

s

s

0.50

s

s

s

s

s

s

s

0.05

ss s

sssssssssssssssssssssssss ss ss s s

0.00

0.25

ss

s

ss

0.50

0.75

1.00

p

Abbildung 6: Gütefunktion für den einseitigen Test (n = 16)

Beispiel 7 (Einseitiger Zeichentest) Zwei Lehrmethoden, A und B, sollen verglichen werden (angeblich ist B besser als A). Von 16 Zwillingspaaren soll dazu jeweils eine Person mit A, die andere mit B geschult und

dann der Lehrerfolg anhand eines einheitlichen Tests festgestellt werden.

Ist B besser als A, dann ist der Anteil p der Zwillingspaare, bei denen

mit B ein besseres Resultat als mit A erzielt worden ist, größer als 12 .

Man testet H0 : p ≤ 12 einseitig gegen H1 : p > 21 zum Niveau α = 0.05.

Die Durchführung ergibt: 13 mal hat B zu einem besseren Resultat

geführt als A.

Man kann damit H0 auf dem 5%-Niveau ablehnen und sagen, dass B

besser als A ist.

3.2 Grundsätzliches zum statistischen Test

3.2.1 Hat ein statistischer Test Beweiskraft?

Eine möglicherweise wahre Hypothese über eine statistische Grundgesamtheit wird als H1 -Hypothese, die Gegenhypothese als H0 -Hypothese formuliert. Mit statistischen Tests kann aber eine Hypothese H 1 ,

auch wenn sie zutrifft, nicht bewiesen und eine Hypothese H0 , auch

wenn sie falsch ist, nicht einwandfrei widerlegt werden.

Ähnlich wie indirekte mathematische Beweise zielen statistische Tests

darauf ab, die möglicherweise falsche Hypothese H0 zugunsten der Hypothese H1 zu verwerfen, und zwar auf der Grundlage von Testresultaten, die der Hypothese H0 widersprechen. Anstatt auf absolute Beweiskraft kann man sich aber nur auf eine kontrollierbar kleine (aber

positive) Irrtumswahrscheinlichkeit (Signifikanzniveau) berufen.

3 ELEMENTE DER TESTTHEORIE

14

3.2.2 Asymmetrie zwischen α- und β-Fehler

Statistische Test können versagen, sowohl wenn H0 wirklich falsch ist

und H0 dennoch nicht abgelehnt wird (β-Fehler), als auch wenn H0

zutrifft und trotzdem abgelehnt wird (α-Fehler).

Die Tatsache, dass grundsätzlich bei keinem Test die Wahrscheinlichkeit für beide Fehler gleichzeitig minimimal sein kann, ist der Grund

für die ungleichen Rollen des durch ein vorgegebenes Signifikanzniveau

kontrollierten α-Fehlers und des β-Fehlers, der nur in Teilbereichen

durch Steigerung der Trennschärfe noch verringert werden kann.

3.2.3 Struktur eines statistischen Tests

Über die (teilweise) unbekannte Verteilung einer statistischen Grundgesamtheit sind alternative Hypothesen H0 (möglicherweise falsch) und

H1 (möglicherweise wahr) formuliert.

Stichprobenvariablen X1 , . . . , Xn zur Grundgesamtheit bilden eine

Testgröße Tn (X1 , . . . , Xn ), deren theoretische Verteilungseigenschaften

in Abhängigkeit von den Hypothesen bekannt sind.

Stichprobenumfang und kritischer Bereich für die Ablehnung von

H0 sind so festgelegt, dass eine vorgegebene Irrtumswahrscheinlichkeit

für eine fälschliche Ablehnung von H0 nicht überschritten wird.

Liegt der Wert von Tn bei Realisierung der Stichprobe im kritischen

Bereich, wird H0 zugunsten H1 verworfen, sonst angenommen.

3.2.4 Korrektes statistisches Testen

Das zu untersuchende Testproblem ist stets vor der Durchführung des

Tests zu formulieren und darf keinesfalls nachträglich zu Stichprobendaten gewählt werden.

Gelingt es anhand eines geeigneten Tests mit vorgegebener Irrtumswahrscheinlichkeit α nicht, H0 abzulehnen, ist es unzulässig

• andere Tests auszuprobieren,

• α nachträglich zu erhöhen,

• so lange Stichproben zu ziehen, “bis H0 schließlich doch noch

abgelehnt wird”.

3.3 Einige statistische Tests

3.3.1 Test auf den Anteilswert p (zweiseitig, exakt)

Hypothesen:

Testgröße:

H0 : p = p0 , H1 : p 6= p0 .

Tn (X1 , . . . , Xn ) =

X

1≤i≤n

(mit B(1, p)-verteilten Zufallsvariablen Xi ).

Xi

3 ELEMENTE DER TESTTHEORIE

15

Untere und obere Grenzen Au , Ao des Annahmebereichs für die B(n, p)verteilte Testgröße Tn bei Test auf dem Niveau α:

n

αo

Au = min k ∈ N Pp0 (Tn ≤ k) >

,

2

n

αo

.

Ao = min k ∈ N Pp0 (Tn ≤ k) ≥ 1 −

2

3.3.2 Test auf den Anteilswert p (einseitig, exakt)

Hypothesen:

Testgröße:

H0 : p ≤ p 0 , H 1 : p > p 0 .

Tn (X1 , . . . , Xn ) =

X

Xi

1≤i≤n

(mit B(1, p)-verteilten Zufallsvariablen Xi ).

Untere und obere Grenzen Au , Ao des Annahmebereichs für die B(n, p)verteilte Testgröße Tn bei Test auf dem Niveau α:

Au = 0 ,

Ao = min {k ∈ N |Pp0 (Tn ≤ k) ≥ 1 − α} .

3.3.3 Test auf den Anteilswert p (zweiseitig, approximativ)

Die Normalverteilungs-Approximation ist anwendbar, wenn np0 > 5

und n(1 − p0 ) > 5 ist.

H0 : p = p0 , H1 : p 6= p0 .

Tn (X1 , . . . , Xn ) =

1 X

Xi

n

1≤i≤n

(mit B(1, p)-verteilten Zufallsvariablen Xi ).

Untere und

Grenzen

Au , Ao des Annahmebereichs für die an obere

q

0)

nähernd N p0 , p0 (1−p

-verteilte Testgröße Tn bei Test auf dem Nin

veau α:

1

Au = p 0 −

−z

2n

r

p0 (1 − p0 )

,

n

r

p0 (1 − p0 )

1

+z

.

Ao = p 0 +

2n

n

Hierbei ist z das obere α2 -Quantil der N (0, 1)-Verteilung.

3 ELEMENTE DER TESTTHEORIE

16

3.3.4 Test auf den Anteilswert p (einseitig, approximativ)

Die Normalverteilungs-Approximation ist anwendbar, wenn np0 > 5

und n(1 − p0 ) > 5ist.

H0 : p ≤ p 0 , H 1 : p > p 0 .

Tn (X1 , . . . , Xn ) =

1 X

Xi

n

1≤i≤n

(mit B(1, p)-verteilten Zufallsvariablen Xi ).

Untere und

Grenzen

Au , Ao des Annahmebereichs für die an obere

q

0)

nähernd N p0 , p0 (1−p

-verteilte Testgröße Tn bei Test auf dem Nin

veau α:

Au = 0 ,

r

1

p0 (1 − p0 )

+z

.

Ao = p 0 +

2n

n

Hierbei ist z das obere α-Quantil der N (0, 1)-Verteilung.

Beispiel 8 Eine studentische Organisation behauptet, bei den kommenden Senatswahlen seien ihr mindestens 30% der Stimmen sicher (ein historisches Beispiel, wie man sieht). Diese Behauptung soll statistisch widerlegt werden (α = 0.05), und zwar auf der Basis einer Wählerumfrage

bei 65 Wählern.

Wegen 65 · 0.3 > 5 und 65 · 0.7 > 5 ist eine Normalverteilungs-Approximation vertretbar.

H0 : p ≥ 0.3 , H1 : p < 0.3 .

1 P

Der Annahmebereich für die Testgröße Tn = 65

1≤i≤65 Xi hat die Grenzen

r

0.3 · 0.7

1

Au = 0.3 −

− 1.64 ·

= 0.199 ,

130

65

Ao = 1 .

Umfrageergebnis: Nur 12 Wähler wollen für die Organisation stimmen.

12

= 0.185 liegt im kritischen Bereich, H0 wird

Der Wert der Testgröße 65

verworfen.

3.3.5 Überprüfen einer Hypothese über p1 , . . . , pn

Die Zufallsvariable X besitze die Ausprägungen 1, . . . , m mit unbekannten Wahrscheinlichkeiten pi = P (X = i).

H0 : pi = p0i für alle i, H1 : pi 6= p0i für mindestens ein i.

n unabhängigen Wiederholungen X1 , . . . , Xn der Zufallsvariablen X

liefern absolute Häufigkeiten ni für die i-te Merkmalsausprägung. Damit bildet man die Testgröße

2

X

1

ni

−n.

Tn =

n

p0i

1≤i≤m

3 ELEMENTE DER TESTTHEORIE

17

Annahmebereich für Tn : 0 bis oberes α-Quantil der χ2 -Verteilung mit

m − 1 Freiheitsgraden.

Der Test ist anwendbar, wenn np0i > 1 für alle i und np0i > 5 für

mindestens 80% der i gilt.

Beispiel 9 Ein Würfel soll daraufhin geprüft werden, ob alle Augenzahlen gleich wahrscheinlich sind (p0i = 16 ). Es wird 300 mal gewürfelt. Es

soll auf dem Niveau α = 0.05 getestet werden.

Obergrenze des Annahmebereichs (α-Quantil der χ2 -Verteilung mit 5

Freiheitsgraden): 11.07.

Die Würfelserie bringt die Ergebnisse n1 = 45, n2 = 60, n3 = 55, n4 =

40, n5 = 40, n6 = 60. Der χ2 -Anpassungstest

ist anwendbar.

1

T300 = 50

(452 + 2 · 602 + 552 + 2 · 402 ) − 300 = 9 ≤ 11.07.

Die Nullhypothese kann nicht verworfen werden und ist beizubehalten.

3.3.6 Test auf Poissonverteilung

Die Zufallsvariable X besitze die Ausprägungen 0, 1, 2, . . .. Frage: Ist X

poissonverteilt?

H0 : X ist poissonverteilt,

d.h. es gibt ein λ > 0 mit P (X = i) =

λi

i!

· e−λ für i ∈ N0 ,

H1 : X ist nicht poissonverteilt.

Mit den absoluten Häufigkeiten n0 , . . . , nm−1 für die i-te Merkmalsausprägung

P

bei n unabhängigen Wiederholungen von X bildet man λ̂ = n1 0≤i≤m−1 i·

ni und damit die Testgröße

λ̂

X n2 · i!

e

i

−n.

Tn =

n

λ̂i

0≤i≤m−1

Annahmebereich für Tn : 0 bis oberes α-Quantil der χ2 -Verteilung mit

m − 2 Freiheitsgraden.

λ̂m−1

·e−λ̂ > 1; ggf. fasse man die oberen Klassen

(Anwendbar, falls n· (m−1)!

zusammen.)

3.3.7 Test auf Normalverteilung

Die n-fache unabhängige Wiederholung einer Zufallsvariablen X liefere

Werte in den Klassen Ki =]ei−1 , ei ], i = 1, . . . , m. Frage: Ist X normalverteilt?

H0 : x ist N (µ, σ)-verteilt mit bestimmten Parametern (µ, σ),

H1 : X ist nicht normalverteilt.

3 ELEMENTE DER TESTTHEORIE

Mit µ̂ =

1

n

P

1≤j≤n Xj und σ̂ =

q

18

1

n−1

·

P

1≤j≤n (Xj

− µ̂)2 und den Besetzungs-

zahlen n1 , . . . , nm der Klassen Ki bildet man die Größen p̂i = Φ( eiσ̂−µ̂ ) −

Φ( ei−1σ̂−µ̂ ) für i = 1 . . . , m und die Testgröße

X n2

1

i

Tn =

−n.

n

p̂i

1≤i≤m

Annahmebereich für Tn : 0 bis oberes α-Quantil der χ2 -Verteilung mit

m − 3 Freiheitsgraden.

(Anwendbar, falls n · p̂i > 1 für alle i und n · p̂i > 5 für mindestens 80%

aller i gilt.)

3.3.8 Test auf Unabhängigkeit zweier Merkmale

Zwei Merkmale (Zufallsvariablen) X und Y einer Grundgesamtheit haben die Ausprägungen {1, . . . , r} bzw. {1, . . . , s}.

Hypothesen:

H0 : X und Y sind unabhängig.

H1 : X und Y sind nicht unabhängig.

Nach N unabhängigen Wiederholungen des Zufallsexperiments (X, Y )

sei nij die jeweilige

Anzahl des Auftretens

des Ausprägungspaares (i, j),

P

P

sowie n.j = 1≤i≤r nij und ni. = 1≤j≤s nij die entsprechenden Marginalhäufigkeiten.

Darstellung der gezählten Häufigkeiten in einer Kontingenztafel:

X=1

X=2

..

.

X=r

Y =1

n11

n21

..

.

Y =2

n12

n22

..

.

...

...

...

..

.

Y =s

n1s

n2s

..

.

n1.

n2.

..

.

nr1

n.1

nr2

n.2

...

...

nrs

n.s

nr.

n.. = N

Mit diesen Häufigkeiten bildet man die Testgröße

X 1 X n2ij

− 1

TN = N ·

ni.

n.j

1≤i≤r

1≤j≤s

Der Annahmebereich für TN erstreckt sich von 0 bis zum oberes αQuantil der χ2 -Verteilung mit (r − 1)(s − 1) Freiheitsgraden (bei vorgegebenem Signifikanzniveau α).

(Anwendbar, falls ni. n.j > N für alle i, j und ni. n.j > 5N für mindestens 80% aller i, j gilt).

Beispiel 10 Es ist zu untersuchen, ob die Religionszugehörigkeit irgendeinen Einfluß auf die Wahl des Ehepartners hat (α = 0.05).

Eine Stichprobenerhebung über die Religionszugehörigkeit der Partner ergibt (mit den Abkürzungen rk: röm.-kath., ev: evangelisch, so: sonstige Bekenntnisse, bl: bekenntnislos, m: männlich, f: weiblich):

3 ELEMENTE DER TESTTHEORIE

m/rk

m/ev

m/so

m/bl

f/rk

9919

782

248

812

11761

f/ev

693

344

27

108

1172

19

f/so

97

22

134

31

284

f/bl

293

44

22

197

556

11002

1192

431

1148

13773

Der Annahmebereich ist [0, 16.92] (0 bis oberes 5%-Quantil der χ2 -Verteilung

mit 9 Freiheitsgraden). Da der Wert für TN im kritischen Bereich (Ablehnungsbereich) liegt, ist H0 (“Unabhängigkeit”) zu verwerfen.

3.3.9 Vorzeichentest (Mediantest)

Es soll (ohne Annahme über den Verteilungstyp) die relative Lage der

Mediane µ̃x , µ̃y zweier Zufallsvariablen X, Y geprüft werden (“verteilungsfreies” oder “nichtparametrisches” Testverfahren).

Dazu werden Stichproben (Xi , Yi ) vom Umfang n gezogen (Stichproben mit Xi = Yi läßt man unberücksichtigt und reduziert n entsprechend). Man setzt Di = 1, falls Xi > Yi ist und Di = 0, falls Xi < Yi ist.

Damit bildet man die B(n, p)-verteilte Testgröße

X

Di .

Tn =

1≤i≤n

Je nach Testproblem werden für Tn geeignete Hypothesen formuliert

(z.B. H0 : p ≤ 21 stellvertretend für H0 : µ̃x ≤ µ̃y beim entsprechenden

einseitigen Problem).

Beispiel 11 Es ist statistisch abzusichern (α = 0.05), dass man bei Verwendung eines Düngemittels A unter gleichen Bedingungen einen besseren Ertrag erzielt als mit einem Düngemittel B. Dazu werden n = 20

Kontrollflächen gebildet, die je zur Hälfte mit A und mit B gedüngt werden.

Die Erträge (ai , bi ) der i-ten Kontrollfläche bewertet man mit

P Di = 1

für ai > bi und mit Di = 0 für ai < bi . Für die Testgröße T20 = 1≤i≤20 Di

erhält man den Annahmebereich {0, . . . , 14} bei H0 : p ≤ 12 .

Die Durchführung des Tests liefere für (ai , bi ) die Werte (46, 48), (58, 49),

(50, 49), (50, 48), (52, 45), (46, 47), (46, 42), (58, 56), (55, 56), (45, 50), (48, 40),

(60, 55), (52, 49), (40, 38), (44, 47), (50, 45), (50, 49), (56, 54), (44, 42), (60, 50).

Wegen T20 = 15 ist damit auf dem Niveau α = 0.05 die Überlegenheit von

A statistisch nachgewiesen.

3.3.10 Erwartungswert einer normalverteilten Größe

Von der Zufallsvariablen X sei bekannt, dass sie (näherungsweise) N (µ, σ)verteilt ist (mit unbekannten µ und σ). Es sollen Nullhypothesen der

Form µ = µ0 (bzw. µ ≥ µ0 oder µ ≤ µ0 ) anhand einer Stichprobe

x1 , . . . , xn geprüft werden.

Hierzu ist die Testgröße

√

(µ̂ − µ0 ) n

Tn =

σ̂

3 ELEMENTE DER TESTTHEORIE

20

q

P

1 P

2

mit µ̂ = n1 1≤j≤n Xj und σ̂ =

1≤j≤n (Xj − µ̂) zu bilden. Tn ist

n−1

t-verteilt mit n − 1 Freiheitsgraden (für n > 30 näherungsweise auch

N (0, 1)-verteilt).

Je nach Testproblem (einseitig, zweiseitig) ist ein entsprechender

Annahmebereich zum vorgegebenen Signifikanzniveau zu konstruieren.

Beispiel 12 Das Nettoeinkommmen von Studenten sei annähernd normalverteilt. Auf dem Signifikanzniveau α = 0.05 soll getestet werden, ob

die Behauptung widerlegt werden kann, das durchschnittliche monatliche Nettoeinkommen von Studenten betrage mindestens 1625 DM (auch

dies also ein historisches Beispiel). Dazu soll eine Stichprobe mit Umfang

n = 20 herangezogen werden.

√

20

Testproblem: H0 : µ ≥ 1625, H1 : µ < 1625. Testgröße: T20 = (µ̂−1625)

.

σ̂

Das untere 5%-Quantil der t-Verteilung mit 19 Freiheitsgraden ist −1.729.

Der Annahmebereich für T20 ist daher [−1.729, ∞[.

√

20

=

Die Stichprobe ergebe µ̂ = 1600 und σ̂ = 42. T20 = (1600−1625)

42

−2.662 ist damit im Ablehnungsbereich und H0 wird zugunsten von H1

verworfen.

3.3.11 Varianz einer normalverteilten Größe

Von der Zufallsvariablen X sei bekannt, dass sie (näherungsweise) N (µ, σ)verteilt ist (mit unbekannten µ und σ). Es sollen Nullhypothesen der

Form σ 2 = σ02 (bzw. σ 2 ≥ σ02 oder σ ≤ σ02 ) anhand einer Stichprobe

X1 , . . . , Xn geprüft werden.

Hierzu ist die Testgröße

Tn = (n − 1) ·

mit µ̂ =

1

n

P

1≤j≤n

Xj und σ̂ =

q

1

n−1

P

σ̂ 2

σ02

1≤j≤n (Xj

− µ̂)2 zu bilden.

Tn ist χ2 -verteilt mit n − 1 Freiheitsgraden.

Je nach Testproblem (einseitig, zweiseitig) ist ein entsprechender

Annahmebereich zum vorgegebenen Signifikanzniveau zu konstruieren.

Beispiel 13 In der Massenproduktion eines Industrieprodukts sei das

Merkmal X annähernd normalverteilt (z.B. Wandstärke von Glasröhren).

Wenn im Produktionsprozeß größere Störungen (z.B. Verschleiß von Maschinen) auftreten, wird sich zusätzlich zum Mittelwert µ von X auch die

Varianz σ 2 ändern.

Neben µ wird daher meist auch σ 2 als Maß für die Homogenität der

Produktion überprüft. Da sich σ 2 durch Verschleiß meist vergrößert, testet

man die Hypothese H0 : σ 2 ≤ σ02 gegen H1 : σ 2 > σ02 in regelmäßigen

Abständen, um rechtzeitig auf Verschleiß der Werkzeuge aufmerksam zu

werden.

3 ELEMENTE DER TESTTHEORIE

21

3.4 Korrelationsanalyse

Bei der Korrelationsanalyse betrachtet man einen zweidimensionalen

Zufallsvektor (X, Y ), der aus normalverteilten Zufallsvariablen X und

Y besteht. Dabei geht man von folgenden Annahmen aus:

1. X ist N (µ1 , σ1 )-verteilt, Y ist N (µ2 , σ2 )-verteilt. µ1 , µ2 und σ1 , σ2 seien fest, aber unbekannt.

2. Unter der Bedingung X = x ist die Zufallsvariable Y normalverteilt

mit Erwartungswert µ(x) = µ2 + ρ · σσ21 · (x − µ1 ) und Varianz σ 2 =

(1 − ρ2 )ρ22 .

Die Konstante ρ heißt Korrelationskoeffizient von X und Y . Durch die

Angabe von µ1 , µ2 , σ1 , σ2 , ρ ist die gemeinsame zweidimensionale Normalverteilung von X und Y eindeutig bestimmt.

3.4.1 Bedeutung des Korrelationskoeffizienten

Fall ρ = 0 Die Zufallsvariablen X und Y sind unabhängig.

Fall 0 < ρ < 1 Die Zufallsvariablen X und Y sind positiv korreliert,

d.h. große X-Werte treten im Mittel mit großen Y -Werten auf. Die Regressionsgerade ist fallend.

Fall −1 < ρ < 0 Die Zufallsvariablen X und Y sind negativ korreliert,

d.h. große X-Werte treten im Mittel mit kleinen Y -Werten auf. Die Regressionsgerade ist fallend.

Fall ρ = 1 oder ρ = −1 Die Werte von (X, Y ) liegen auf einer Geraden,

die mit der Regressionsgeraden identisch ist. In diesem Fall bestimmt

der Wert der Variablen X = x vollständig den Wert von Y , nämlich

Y (x) = µ(x). Y ist in diesem Fall keine “echte” Zufallsvariable.

3.4.2 Zwei Testprobleme der Korrelationsanalyse

Die bei der Korrelationsanalyse verwendeten Größen sind zu denen der

Regressionsanalyse ähnlich. Bei der Korrelationsanalyse kann man allerings nicht davon ausgehen, dass zu festen x-Werten mehrere y-Werte

gemessen werden, da die Ausprägungen von X zufällig sind. Man geht

deshalb einfach von einer Stichprobe (x1 , y1 ), . . . , (xn , yn ) aus und bildet

die Größen

• n Stichprobenumfang

P

P

1

• s2x = n−1

( ni=1 x2i − n1 ( ni=1 xi )2 ),

Pn

Pn

1

( i=1 yi2 − n1 ( i=1 yi )2 ),

• s2y = n−1

Pn

Pn

Pn

1

( i=1 xi yi − n1 ( i=1 xi ) · ( i=1 yi )),

• sxy = n−1

3 ELEMENTE DER TESTTHEORIE

• r=

sxy

sx sy

• byx =

sxy

s2x

22

(Stichprobenkorrelationskoeffizient),

und ayx =

1

n

Pn

i=1

xi − byx ·

1

n

Test auf Unabhängigkeit von X und Y

Pn

i=1 .

• Testproblem: H0 : ρ = 0, H1 : ρ 6= 0.

• Testgröße: Tn = (n − 2) ·

s2xy

2

sx s2y −s2xy

• Verteilung: F1,n−2

Test für den Korrelationskoeffizienten

• Testprobleme:

– H 0 : ρ ≤ ρ 0 , H1 : ρ > ρ 0

– H 0 : ρ ≥ ρ 0 , H1 : ρ < ρ 0

– H0 : ρ = ρ0 , H1 : ρ 6= ρ0

q

q

√

1+ρ0

• Testgröße: Tn = n − 3 ln 1+r

1−r − ln

1−ρ0

• Verteilung: N (0, 1) für n > 30.

3.5 Nichtparametrische Tests

Bei den bisher besprochenen Tests wurden fast immer Annahmen über

die Verteilung der Grundgesamtheit getroffen, wie z.B. die, dass eine

normalverteilte Grundgesamtheit vorliegt. In der Praxis kann es vorkommen, dass solche Annahmen nicht nachgeprüft werden können

und zweifelhaft sind. Für solche Fälle gibt es nichtparametrische Tests,

die unabhängig von Verteilungsannahmen sind. Wir stellen exemplarisch zwei solche Tests vor.

3.5.1 Vorzeichentest

Der Vorzeichentest ist ein einfacher Test für eine quantitative Messgröße bei zwei verbundenen Beobachtungen. Es seien X und Y zwei

Merkmale einer Grundgesamtheit, die gemeinsam die zweidimensionale Zufallsvariable (X, Y ) bilden. Sei S die daraus konstruierte eindi−X

mensionale Zufallsvariable S = |YY −X|

(“Vorzeichen von Y −X”). Die i-ten

Realisierungen der Zufallsvariablen seien xi , yi bzw. si . Realisierungen

mit yi − xi = 0 lässt man weg (der Stichprobenumfang reduziert sich

dadurch ggf.).

• Testgröße: S

• Verteilung: B(n, p) mit p = P (S = 1)

• Idee: X und Y sind genau dann gleich verteilt, wenn p =

• Testproblem: H0 : p = 12 , H1 : p 6=

1

2

1

2

ist.

3 ELEMENTE DER TESTTHEORIE

23

3.5.2 U-Test nach Mann-Whitney-Wilcoxon

Der U-Test nach Mann-Whitney-Wilcoxon ist ein nichtparametrischer

Test für zwei unverbundene Stichproben. Es seien X und Y unverbundene Zufallsvariablen und x1 , . . . , xN1 bzw. y1 , . . . , yN2 die zugehörigen

Stichprobenwerte, wobei N1 ≤ N2 sei. Die beiden Stichproben werden

gemeinsam zur aufsteigenden Folge z1 , . . . , zN geordnet (N = N1 + N2 )

und folgendermaßen mit Rangzahlen r1 , . . . , rN versehen: Falls zi−1 <

zi < zi+1 ist, sei ri = i. Falls zi−k < zi−k+1 = . . . = zi = . . . = zi+l−1 < zi+l

ist, sei ri = 2i−k+l

. Dadurch erhält man für jedes P

xi eine Rangzahl

2

r(xi ) und

für

jedes

y

eine

Rangzahl

r(y

).

Seien

R

=

i

i

1

1≤i≤N1 r(xi ) und

P

R2 = 1≤i≤N2 r(yi ).

• Testgröße: U = N1 N2 + N1 (N21 +1) −R1 mit Erwartungswert µU =

(N +1)

2

.

und Varianz σU

= N1 N212

N1 N2

2

• Verteilung: N (µU , σU )(näherungsweise, falls N1 ≥ 8 und N2 ≥ 8)

• Idee: X und Y sind genau dann gleich verteilt, wenn U nahe bei

µU liegt.

• Testproblem: H0 :

U −µU

σU

= 0, H1 :

U −µU

σU

6= 0.

LITERATUR

24

Literatur

[1] http://wiwi.uni-giessen.de/home/rinne/statwas

[2] NIST/SEMATECH

e-Handbook

of

Statistical

http://www.itl.nist.gov/div898/handbook

Methods

Inhaltsverzeichnis

1 Stichproben und deren Verwendung

1.1 Stichproben . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.2 Schätzen . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.3 Testen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2

2

2

2

2 Elemente der Schätztheorie

2.1 Ein Beispiel . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.1.1 Schätzung eines Fehleranteils . . . . . . . . . . . .

2.1.2 Eigenschaften der Schätzfunktion p̂ . . . . . . . . .

2.1.3 Konfidenzintervalle für p . . . . . . . . . . . . . . .

2.1.4 Approximative Konfidenzintervalle . . . . . . . . . .

2.2 Konfidenzintervalle . . . . . . . . . . . . . . . . . . . . . .

2.2.1 K.-I. für p (Normalverteilungsapproximation) . . . .

2.2.2 K.-I. für p (exakt) . . . . . . . . . . . . . . . . . . . .

2.2.3 K.-I. für µ einer N (µ, σ)-Verteilung (σ bekannt) . . .

2.2.4 K.-I. für µ einer N (µ, σ)-Verteilung (σ unbekannt) .

2.2.5 K.-I. für den Median µ̃ (Stichprobenumfang n ≥ 9)

.

.

.

.

.

.

.

.

.

.

.

3

3

3

3

3

4

5

5

6

6

6

7

3 Elemente der Testtheorie

3.1 Ein Beispiel . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.1.1 Testen der Hypothese “die Münze ist fair” . . . . . .

3.1.2 α-Fehler und β-Fehler . . . . . . . . . . . . . . . . . .

3.1.3 Gütefunktion des Tests . . . . . . . . . . . . . . . . .

3.1.4 Kritische Bereich und Annahmebereich . . . . . . .

3.1.5 Vergrößerung des kritischen Bereichs . . . . . . . . .

3.1.6 Erhöhung des Stichprobenumfangs . . . . . . . . . .

3.1.7 Kontrolle des α-Fehlers . . . . . . . . . . . . . . . . .

3.1.8 Trennschärfe . . . . . . . . . . . . . . . . . . . . . . .

3.1.9 Einseitige Alternative H1 . . . . . . . . . . . . . . . .

3.2 Grundsätzliches zum statistischen Test . . . . . . . . . . .

3.2.1 Hat ein statistischer Test Beweiskraft? . . . . . . . .

3.2.2 Asymmetrie zwischen α- und β-Fehler . . . . . . . .

3.2.3 Struktur eines statistischen Tests . . . . . . . . . . .

3.2.4 Korrektes statistisches Testen . . . . . . . . . . . . .

3.3 Einige statistische Tests . . . . . . . . . . . . . . . . . . . .

3.3.1 Test auf den Anteilswert p (zweiseitig, exakt) . . . . .

3.3.2 Test auf den Anteilswert p (einseitig, exakt) . . . . .

3.3.3 Test auf den Anteilswert p (zweiseitig, approximativ)

3.3.4 Test auf den Anteilswert p (einseitig, approximativ) .

3.3.5 Überprüfen einer Hypothese über p1 , . . . , pn . . . . .

8

8

8

8

8

9

9

9

11

11

11

13

13

14

14

14

14

14

15

15

16

16

ABBILDUNGSVERZEICHNIS

3.3.6 Test auf Poissonverteilung . . . . . . . . . . .

3.3.7 Test auf Normalverteilung . . . . . . . . . . .

3.3.8 Test auf Unabhängigkeit zweier Merkmale . .

3.3.9 Vorzeichentest (Mediantest) . . . . . . . . . . .

3.3.10Erwartungswert einer normalverteilten Größe

3.3.11Varianz einer normalverteilten Größe . . . . .

3.4 Korrelationsanalyse . . . . . . . . . . . . . . . . . . .

3.4.1 Bedeutung des Korrelationskoeffizienten . . .

3.4.2 Zwei Testprobleme der Korrelationsanalyse .

3.5 Nichtparametrische Tests . . . . . . . . . . . . . . . .

3.5.1 Vorzeichentest . . . . . . . . . . . . . . . . . .

3.5.2 U-Test nach Mann-Whitney-Wilcoxon . . . . .

25

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

17

17

18

19

19

20

21

21

21

22

22

23

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

9

10

10

11

12

13

Abbildungsverzeichnis

1

2

3

4

5

6

Gütefunktion des Tests “die Münze ist fair” . . . . .

Gütefunktion für verschiedene kritische Bereiche .

Gütefunktion für verschiedene Stichprobenumfänge

Gütefunktionen zum Signifikanzniveau α = 0.05 . . .

Gütefunktion für den einseitigen Test (n = 5) . . . .

Gütefunktion für den einseitigen Test (n = 16) . . . .

Index

F -Verteilung, 6

H0 -Hypothese, 13

H1 -Hypothese, 13

α-Fehler, 8

β-Quantil der N (0, 1)-Verteilung,

5

β-Fehler, 8

β-Quantil der F -Verteilung, 6

β-Quantil der t-Verteilung, 7

t-Verteilung, 7

Nullhypothese, 11

Punktschätzung, 2

Realisierung, 3

schätzen, 2

Schätzfunktion, 3

Schätztheorie, 2

Schätzung, 2

Schätzwert, 3

Signifikanzniveau, 11

statistische Sicherheit, 4

statistischer Test, 2

Stichprobe, 2

Stichprobenumfang, 2

Student-Verteilung, 7

Ablehnwahrscheinlichkeit, 8

Annahmebereich, 9

einseitig, 11

einseitiger Test, 12

Entscheidungsvorschrift, 8

erwartungstreu, 3

Testgrose, 14

Testtheorie, 2

Testvariable, 8

Trennschärfe, 11

Fehler 1. Art, 8

Fehler 2. Art, 8

Fehleranteil, 3

Fehlerwahrscheinlichkeit, 4

floor-Funktion, 7

unbiased, 3

unverzerrt, 3

Gütefunktion, 8

verteilungsfreie Tests, 19

Vertrauensgrenzen, 4

verwerfen, 2

Hypothese, 2

Hypothese H0 annehmen, 8

Hypothese H0 testen, 8

Hypothese H0 verwerfen, 8

Zufälligkeit, 2

Intervallschätzung, 2

Irrtumswahrscheinlichkeit, 14

Konfidenzintervall, 4

Konfidenzwahrscheinlichkeit, 4

konsistent, 3

Korrelationsanalyse, 21

Korrelationskoeffizient, 21

korreliert, negativ, 21

korreliert, positiv, 21

kritischer Bereich, 9

Median, 7

Mutungsintervall, 4

nichtparametrische Tests, 19

26