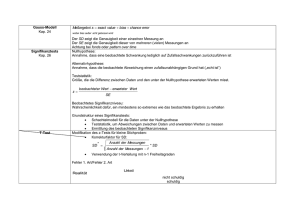

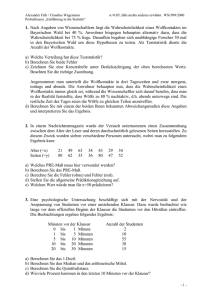

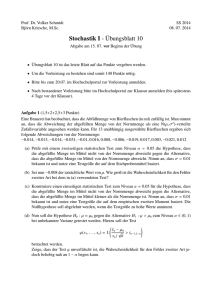

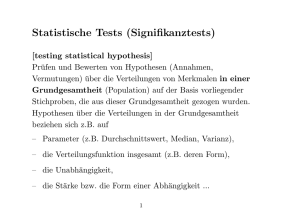

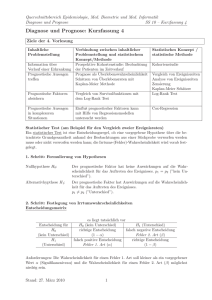

Kapitel 5 Intervallschätzer, einfache Hypothesentests und Prognosen

Werbung