Syntax, Semantik, Bedeutung: hat Goedel bewiesen, dass es nur

Werbung

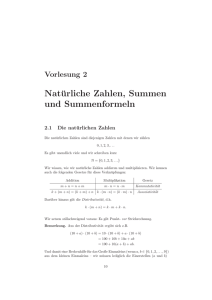

Syntax, Semantik, Bedeutung

oder

hat Gödel bewiesen, dass es nur übernatürliche

Intelligenz gibt?

Thomas Letschert

FH Giessen–Friedberg

Künstliche Intelligenz, der Frankenstein der Informatik

HAL: Hör auf Dave, ich habe Angst.

... Dave entfernt weitere Module ...

HAL: Hänschen klein, ging allein, ...

aus: S. Kubrick, 2001 Odyssee im Weltraum.

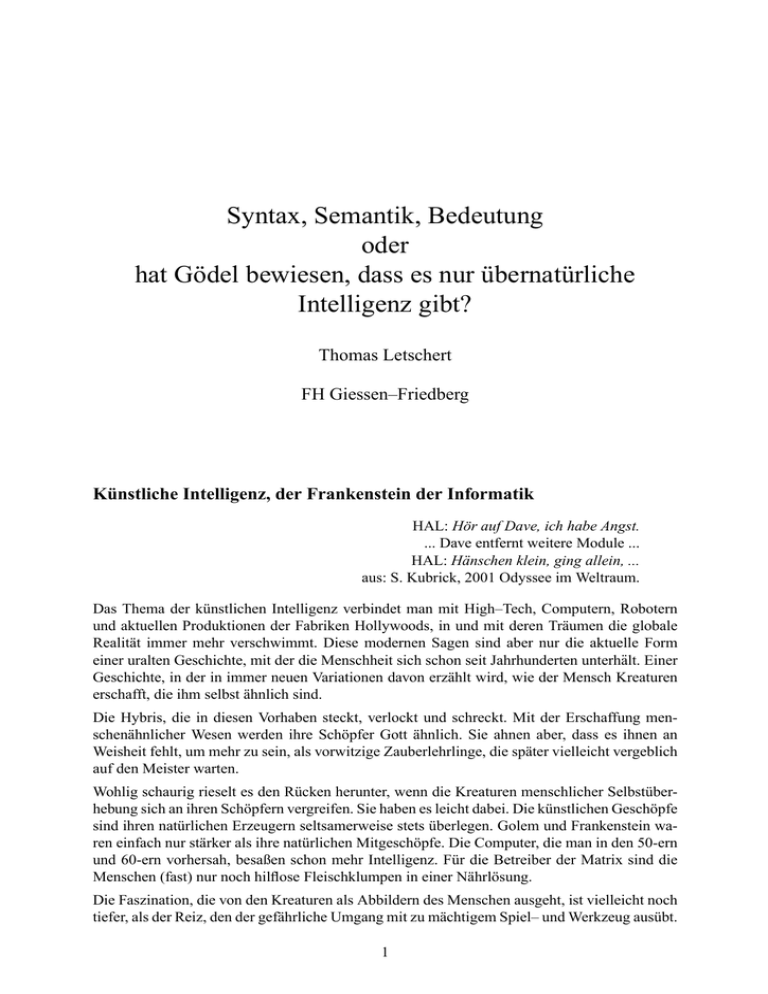

Das Thema der künstlichen Intelligenz verbindet man mit High–Tech, Computern, Robotern

und aktuellen Produktionen der Fabriken Hollywoods, in und mit deren Träumen die globale

Realität immer mehr verschwimmt. Diese modernen Sagen sind aber nur die aktuelle Form

einer uralten Geschichte, mit der die Menschheit sich schon seit Jahrhunderten unterhält. Einer

Geschichte, in der in immer neuen Variationen davon erzählt wird, wie der Mensch Kreaturen

erschafft, die ihm selbst ähnlich sind.

Die Hybris, die in diesen Vorhaben steckt, verlockt und schreckt. Mit der Erschaffung menschenähnlicher Wesen werden ihre Schöpfer Gott ähnlich. Sie ahnen aber, dass es ihnen an

Weisheit fehlt, um mehr zu sein, als vorwitzige Zauberlehrlinge, die später vielleicht vergeblich

auf den Meister warten.

Wohlig schaurig rieselt es den Rücken herunter, wenn die Kreaturen menschlicher Selbstüberhebung sich an ihren Schöpfern vergreifen. Sie haben es leicht dabei. Die künstlichen Geschöpfe

sind ihren natürlichen Erzeugern seltsamerweise stets überlegen. Golem und Frankenstein waren einfach nur stärker als ihre natürlichen Mitgeschöpfe. Die Computer, die man in den 50-ern

und 60-ern vorhersah, besaßen schon mehr Intelligenz. Für die Betreiber der Matrix sind die

Menschen (fast) nur noch hilflose Fleischklumpen in einer Nährlösung.

Die Faszination, die von den Kreaturen als Abbildern des Menschen ausgeht, ist vielleicht noch

tiefer, als der Reiz, den der gefährliche Umgang mit zu mächtigem Spiel– und Werkzeug ausübt.

1

2

Die Menschenähnlichkeit der Affen im Zoo lässt uns zwischen Amüsiertheit und Zuneigung

schwanken. Unsere künstlichen Wesen sehen wir ernster an. Ihre Menschenähnlichkeit ist von

uns geschaffen. Das setzt voraus und impliziert, dass wir wissen und verstehen, was der Mensch

im tiefsten Innern eigentlich ist. Mit den künstlichen Wesen, die uns ähnlich sind, halten wir

uns einen Spiegel vor und kaum ein Blick fesselt Menschen mehr, als der in einen Spiegel.

Mittelalterliche Uhrwerke hauchten Figuren Bewegung, damit Leben und ihren Zuschauern

Staunen und Ehrfurcht ein. Das mechanische Zeitalter beschäftigte sich ausgiebig mit den verschiedensten Automaten. Seien es nun Enten mit “natürlicher” Verdauung, oder, wenn auch

gefälscht, künstliche Schachspieler. Später erschienen die Menschen sich selbst als Dampfmaschinen, dann als elektrische Maschinen, schließlich als Computer, die man nachbauen kann.

Jede Zeit hat ihre Vision von Frankenstein, die, so harmlos skurril sie im Rückblick erscheinen

mag, den Zeitgenossen sehr ernst war. Immer ist es die neueste Technik, die das Potential zu

bieten scheint, mit dem der letzte Schritt von der Maschine zur Kreatur gegangen werden kann.

Hat man sich aber an die Technik und ihre Möglichkeiten gewöhnt, dann sind ihre Fähigkeiten

nicht mehr “menschlich” oder “natürlich”. Schach spielenden Computern, die praktisch jeden

Großmeister schlagen, begegnet inzwischen die gleiche achselzuckende Verachtung gegenüber

dem rein Mechanischen wie sie der hölzerne Tanz der Figuren in mittelalterlichen Uhrwerken

schon seit Jahrhunderten erfährt.

Der Blick in den Spiegel, den die Technik immer wieder aufs Neue bietet, ist im Fall der Informatik besonders tief ausgefallen. Ihr Frankenstein, die künstliche Intelligenz, bietet besonders

reichhaltigen Stoff für scheinbare oder tatsächliche Einsichten in das Wesen des Menschen.

Kein Wunder, sind ihre Maschinen doch mit Informationsverarbeitung beschäftigt, einer Tätigkeit, die früher einmal einfach und pauschal “Denken” genannt wurde und lange als feste Bastion im Rückzugsgefecht des Natürlichen und Menschlichen erschien.

Das alte, das mythische Thema dessen, was wir heute künstliche Intelligenz nennen, ist die

Frage, was ist Tod und was ist Leben, was ist menschlich und was nicht. Autonome Bewegung

galt solange als Zeichen alles Lebendigen, bis jeder die plump oder fein tickenden Uhrwerke

gesehen hatte, die sie als erste erzeugten. Die Fähigkeit, komplexe arithmetische Operationen

ausführen zu können, war ein Zeichen überlegenen menschlichen Intellekts, bis Rechenmaschinen sie durch ihre schiere Existenz als stupide maschinelle Routine entlarvten.

Die Frage bleibt die gleiche, auf der Suche nach der Antwort führen uns Wissenschaft und

Technik in Landschaften, deren Luft stetig dünner und deren Charakter immer wüstenhafter

wird. Landschaften, die sich, nach dem Durchzug der Techniker mit den gedankenschweren

Philosophen im Tross, oft in üppig blühende Ebenen verwandeln, in denen sich viele fröhlich

einrichten und erstaunlich schnell und problemlos mit bockigen Computern, sympathischen

Robotern und überdrehten Handys koexistieren. Die anderen ziehen weiter in neue Steppen

der Wissenschaft und Technik und bestaunen die bizarre Schönheit der ariden Gewächse des

Geistes, die sie dort vorfinden.

3

Gödels Theoreme und ihre Fans

Du kannst deine eigene Sprache

in deiner eigenen Sprache beschreiben:

aber nicht ganz.

Du kannst dein eigenes Gehirn

mit deinem eigenen Gehirn erforschen:

aber nicht ganz.

aus [4]

Unter den spröden Schachtelhalmen und Kakteen der Mathematik und theoretischen Informatik hat ein Exemplar besonders fasziniert und dazu verleitet, es als Totempfahl oder Litfaßsäule

diverser Ideen zu verwenden. Es ist Gödels Unvollständigkeitstheorem. Aus diesem Theorem

leiten die einen ab, dass Menschen nichts als Maschinen sind und die anderen, dass der menschliche Geist jenseits aller algorithmischen Modelle und Methoden steht und damit letztlich etwas

Übermechanisches oder gar Übernatürliches ist.

Genau genommen hat Gödel um 1930 ein Vollständigkeitstheorem und zwei Unvollständigkeitstheoreme bewiesen. Populär sind die beiden Unvollständigkeitstheoreme und unter ihnen

vor allem das zweite. Das erste Unvollständigkeitstheorem sagt

In jedem korrekten logischen Formalismus, der mindestens in der Lage ist, die Gesetze der einfachen Arithmetik herzuleiten, sind Aussagen formulierbar, die wahr,

aber in eben diesem Formalismus nicht herzuleiten sind.

Dieses Theorem lieferte einen wichtigen Beitrag zur mathematischen Logik und ist jedem bekannt, der sich mit dieser Thematik auch nur oberflächlich beschäftigt. Gleichzeitig ist es, zusammen mit dem zweiten Theorem, ein Allzeit–Hit der Pop(ulärwissenschaftlichen) Kultur. Es

hat ja auch alles, was zu einem solchen Hit gehört. Da ist zunächst einmal Gödel, der Autor.

Sein bizzarer Charakter passt so wundervoll zu einem Logik–Genie. Schon auf Photos ist es zu

erkennen und kontrastiert so herrlich zu dem knuffigen Physik–Genie seines Freundes Einstein.

Dann die Aussage, in der streng wissenschaftlich mit exaktem Formalismus die Unvollständigkeit, also das Unvollkommene, das Defizitäre, eben all dieser Formalismen nachgewiesen wird.

Die kalte Logik windet sich gedemütigt im Staub, nachdem sie erfolglos versuchte sich auf

unsere Stufe zu erheben und sich dabei selbst in den Hals biss.

Schließlich der Beweis, der mit einer Formel G arbeitet, die als

G: Ich bin keine beweisbare Aussage!

interpretiert werden kann. Das verdreht den Kopf und ist doch irgendwie intuitiv zu verstehen.

Etwas nüchterner wird eine Unvollständigkeit festgestellt, die allen logischen Formalismen eigen ist. Der Begriff “Unvollständigkeit” bezieht sich auf den Beweis– oder Ableitungsmechanismus der in einem logischen Formalismus steckt. Ein solcher Mechanismus ist unfähig, alle

wahren Aussagen herzuleiten, sobald er so ausdrucksstark ist, dass in ihm Gesetze der einfachen Arithmetik, mit den Grundrechenarten auf natürlichen Zahlen, formuliert werden können.

Wenn er zu mehr als absoluten Trivialitäten taugt, dann ist er schon unvollkommen.

4

Dieses Theorem beeindruckt zunächst durch seinen philosophischen Gehalt, indem es zeigt,

dass Wahrheit und Beweisbarkeit in allen nicht-trivialen Fällen nicht identisch sind. Jeder Begriff von Beweisbarkeit ist zwangsläufig unvollständig, wenn man ihn an dem misst, was wahr

ist.

Zu der beeindruckenden Aussage kommt aber noch ein Beweis, der mit einer Variante des

alten Lügner-Paradoxons “Alle Kreter lügen, sagte der Kreter” arbeitet. Mit G ist ein wahrer

aber nicht beweisbarer Satz gefunden. Entweder ist G im Formalismus herleitbar, dann ist eine

falsche Aussage herleitbar und der Formalismus nicht korrekt, oder G ist nicht herleitbar, dann

gibt es eine wahre aber im Formalismus nicht herleitbare Aussage.

Der Beweis fasziniert nicht nur durch die Verwendung eines logischen Paradoxons. Erstaunlich

ist auch, dass eine solche rückbezügliche Aussage in einem Formalismus ausgedrückt werden

kann, der nicht mehr als die Grundrechenarten beherrscht. Gödel verwendet dazu eine Technik,

die nach als “Gödelnummerierung” oder “Gödelisierung” bekannt und in das Repertoire der

logischen Beweismittel übernommen wurde, und in das der allgemeinen Informatik–Kultur –

aber hat die sich nicht schon überall breit gemacht:

Frage: Wieviele Glühbirnen braucht man um eine Glühbirne zu wechseln?

Antwort: Eine, falls sie ihre Gödelnummer kennt. [5]

Das zweite Unvollständigkeitstheorem lässt sich mit Hilfe des ersten beweisen. Es lautet wieder

etwas informal ausgedrückt:

Mit keinem korrekten logischen Formalismus, der mindestens in der Lage ist, die

Gesetze der einfachen Arithmetik herzuleiten, kann die Widerspruchsfreiheit eben

dieses Formalismus’ bewiesen werden.

Auch dieses Theorem enthält einen Selbstbezug. Diesmal noch expliziter in seiner Behauptung, dass kein korrekter und halbwegs aussagekräftiger Formalismus in der Lage ist, eine sehr

wichtige Aussage über sich selbst zu machen, nämlich die, kein kompletter Unsinn zu sein!

Widerspruchsfreiheit in einem logischen Kalkül bedeutet nämlich nichts anderes, als dass mit

ihm nicht jede sinnige oder auch unsinnige Aussage bewiesen werden kann. Ein logischer Formalismus der nicht widerspruchsfrei ist, ist völlig wertlos. Der “Trick” der Gödelisierung erlaubt, dass bereits innerhalb einfachster Formalismen fundamentale Aussagen über diese Formalismen selbst formuliert können. Die Korrektheit dieser Aussagen aber kann nicht innerhalb

des Formalismus bewiesen werden; nicht einmal dann, wenn es sich um die fundamentalste

Aussage über den Formalismus handelt: die nicht unsinnig zu sein.

Das zweite Theorem schlägt also in die gleiche Kerbe wie das erste, nur noch etwas heftiger.

Im ersten wird festgestellt, dass es Wahrheiten gibt die Formalismen nicht erkennen können, im

zweiten wird dies verschärft zu der Aussage, dass sie ganz und gar fundamentale Wahrheiten

über sich selbst nicht erkennen können.

Es muss allerdings betont werden, dass dies keine Aussage über die Beschränktheit aller Formalismen ist. Zwar können in keinem Formalismus fundamentale Aussagen über den Formalismus selbst bewiesen werden. Andere, mächtigere Formalismen sind dazu aber sehr wohl in

5

der Lage. So kann sehr wohl formal bewiesen werden, dass der Formalismus, der die Gesetze der einfachen Arithmetik enthält, widerspruchsfrei ist. Dieser Beweis kann aber nicht mit

den “Bordmitteln” des arithmetischen Formalismus geführt werden. Man muss schon aus dem

System heraus und auf eine höhere Stufe treten. Auf dieser Stufe gilt dann wieder das Gleiche.

Es bedeutet auch nicht, dass ein Formalismus keinerlei Aussagen über sich selbst herleiten kann.

Es kann nur nicht alles über ein System innerhalb des Systems hergeleitet werden. Ab einer

gewissen Ausdrucksfähigkeit des Systems auch nicht die seiner Konsistenz. Um bestimmte

wichtige Aussagen über dieses System herzuleiten, muss man wieder eine Stufe höher in der

Ausdrucksmächtigkeit gehen. Fundamentale Aussagen über ein System erfordern also einen

Blick von außen und weiter oben. Das ist nicht wirklich überraschend, oder?

Unterbrechen wir hier unsere Spekulation über die Gödelschen Theoreme und wenden

uns der Frage zu, wie es zu der intensiven Beschäftigung mit logischen Formalismen

kam.

Die Wiederentdeckung der Logik – Aussagenlogik

Die alte Logik legte das Denken in Fesseln, die neue Logik gibt ihm Flügel. Sie hat

meiner Meinung nach, denselben Fortschritt in die Philosophie eingeführt, den

Galilei in der Physik einführte.

B. Russel (nach [6])

Ab dem 18–ten bis ins 19–te Jahrhundert entwickelten sich Mathematik und Naturwissenschaften in rasanter Weise. Dabei wurde eine Fülle neuer Erkenntnisse gewonnen, die sehr

erfolgreich, aber gleichzeitig auch oft genug vage und umstritten waren. Selbst in der scheinbar

so exakten Mathematik wurden von wenigen Großmeistern wie Euler, den Bernoulis, Fermat,

etc. beachtliche Fortschritte erzielt, indem sie in virtuoser Genialität mit irrationalen und imaginären Zahlen rechneten, unendliche Reihen aufaddierten oder mit unendlich kleinen Größen

hantierten. Diese obskuren Geschöpfe des menschlichen Geistes waren dabei nicht nur mathematischen Laien wie Musils verwirrtem Zögling Törleß suspekt. Verwundert über Rechnungen

mit imaginären Zahlen, die von soliden Zahlen zu soliden Zahlen führen und dabei über etwas

gehen, das es nicht gibt, fragt er sich:

“Ist das nicht wie eine Brücke, von der nur Anfangs– und Endpfeiler vorhanden

sind und die man dennoch so sicher überschreitet, als ob sie ganz dastünde?” [13]

Die imaginären Zahlen erinnern ihn an die dunklen geheimnisvollen Kräfte, die unter der ruhig–

soliden Oberfläche der Gesellschaft des bürgerlichen Zeitalters lauern.

Mit seiner 1903 geschriebenen Novelle hat Musil erstaunliche Hellsicht bewiesen und die Mathematik war dabei nicht nur Symbol. Das zu Bändigende waren zwar nicht die imaginären

Zahlen und die Bändigung ist auch nicht so blutig abgelaufen, wie im gesellschaftlichen Bereich, aber ab dem späten 19–ten Jahrhundert es war an der Zeit das Dunkle aufzuhellen.

Speziell der Begriff des Unendlichen war klärungsbedürftig. Schon die Infinitesimalrechnung,

ein essenzielles Hilfsmittel der modernen Naturwissenschaften, beruhte auf vagen ungeklärten

6

unendlichen Summen unendlich kleiner Werte. Geniale Mathematiker konnten mit solchen Dingen intuitiv korrekt umgehen. Aber der Kreis der Tätigen hatte sich dramatisch erweitert. Jetzt

waren sich lawinenartig vermehrende Heerscharen von Lehrern, Ingenieuren und Technikern

am wissenschaftlichen Prozess beteiligt. Eine Systematisierung und Grundlegung der Mathematik war unumgänglich – aber so wenig einfach oder klar, dass man eine Grundlagenkrise der

Mathematik diagnostizieren musste.

In dieser Krise ging es um das Wesen mathematischer Erkenntnis, um die Frage, was erkennbar

ist und unter welchen Voraussetzungen mathematische Erkenntnisse und Schlussfolgerungen

als “wirklich wahr” anzuerkennen seien. Das Fundament der Mathematik am Ende des 19–ten

Jahrhundert enthielt zu viele unsichere Wände. Da war eine problematische Mengenlehre, aber

auch schon der elementare Begriff des korrekten Schlussfolgerns erwies als erstaunlich untrivial

und als unsicherer Bestandteil des mathematischen Fundaments.

Wie kommt man von gegebenen Aussagen zweifelsfrei zu daraus abgeleiteten neuen Aussagen.

Auch wenn man nicht so weit gehen will, Schlussfolgern generell mit dem Denken zu identifizieren, so spielt es doch im Denkprozess sicher eine wichtige Rolle. Tagtäglich folgern wir aus

vorliegenden Informationen abgeleitete Fakten. Ein typisches Beispiel ist etwa:

Ich habe die Garagentür und ein Motorengeräusch gehört, also ist unser Auto weg

und ich muss wohl mit dem Bus fahren.

Wir sind dabei intuitiv zu respektablen Leistungen fähig, aber gelegentlich werden auch Fehler gemacht. Im Alltagsleben werden solche Irrtümer im Allgemeinen schnell aufgedeckt und

meist sind sie auch harmlos. Wissenschaftliche Erkenntnisse und die auf ihnen basierenden

technischen Konstrukte brauchen aber eine sicherere Basis als die Intuition.

Mathematische Gesetze werden in einer formalen Sprache formuliert und man beweist Aussagen, indem man von einer Grundmenge an vorgegebenen Axiomen ausgehend mit anerkannten

Regeln des Schlussfolgerns zu neuen Aussagen kommt. Hierbei sind drei prinzipielle Fragen zu

klären:

• In welchem Formalismus, welcher “Sprache”, werden Axiome, Aussagen und Regeln des

Schlussfolgerns formuliert.

• Wann ist eine Aussage wahr.

• Welche Regeln des Schlussfolgerns führen von wahren zu wahren Aussagen.

Nicht, dass Mathematiker solche trockenen Formelspiele betreiben würden, aber im Prinzip

sollte jedes Argument auf eine sichere und zweifelsfrei prüfbare formale Basis gestellt werden

können. Alle strittigen mathematischen Begriffsbildungen, Schlussfolgerungen und Berechnungen wären damit objektiv bewertbar.

Die Frage des korrekten Schlussfolgerns ist Thema der Logik. Aristoteles begann mit deren

systematischem Studium und formulierte seine Syllogismen als die Regeln, auf die sich alle

gültigen Schlussfolgerungen seiner Meinung nach reduzieren lassen. Im gesamten Mittelalter

wurde die aristotelische Logik eifrig studiert. Dabei ging es zwar nicht um eine Fundierung

7

der Mathematik oder der auf ihr aufbauenden Naturwissenschaften, sondern um die Rhetorik

theologischer Debatten. Die Fortschritte dieses ausdehnten Studiums waren auch so gering, dass

der Logiker mit seinen Syllogismen zur Witzfigur des blutleeren Dogmatikers geriet, der seine

Umwelt mit aufgeblasenen Nichtigkeiten und Unsinn langweilt.

Logiker: [...] Alle Katzen sind sterblich. Sokrates ist gestorben.

Also ist Sokrates eine Katze.

Älterer Herr: Und hat vier Pfoten. Richtig, ich habe eine Katze

die heißt Sokrates.

Logiker: Sehen Sie ...

Älterer Herr: Sokrates war also eine Katze!

Logiker: Die Logik hat es uns eben bewiesen.

aus [10]

Nicht dass hier ein gültiger Syllogismus dargelegt würde, aber der Ruf der Logik war in der

Neuzeit soweit dahin, dass sie für viele nur noch gut für solche Scherze war.

Eine gute Logik wurde aber dringend gebraucht. In der Grundlagenkrise der Mathematik zeigte

sich, dass die Frage, welche Schlussfolgerungen zulässig sind und welche nicht, nicht einfach

intuitiv entschieden werden kann. Und da die Mathematik die Grundlage aller modernen Naturwissenschaft und Technik ist, haben Fragen ihrer Grundlage fundamentale Bedeutung.

Die Hauptprobleme der aristotelischen Logik sind die mangelnde Ausdruckskraft und der informale Charakter ihrer Sprache. Nicht einmal einfachste Sachverhalte der Geometrie und Arithmetik können in ihr formuliert werden. Um zu einem aussagekräftigeren Kalkül zu kommen,

über dessen Regeln und Ergebnisse exakte Aussagen gemacht werden können, war es dringend notwendig, ihre Sprache zu formalisieren und und ihre Ausdruckskraft zu steigern. Nur

durch eine Formalisierung kann die Logik vom Subjekt zum gleichzeitigen Objekt des Denkens

werden. Nur durch eine Steigerung der Ausdrucksfähigkeit der Formalismen sind relevante

Aussagen möglich.

Den ersten Schritt nach einem Jahrtausende langen Dämmerschlaf der Logik ging G. Boole

mit seiner Mathematical Analysis of Logic von 1847, mit der er die Aussagenlogik in der heute bekannten Form einführte. Die atomaren Elemente der Aussagenlogik sind Aussagen, also

Behauptungen, die entweder wahr oder falsch sein können. Aussagen können mit Hilfe von

Verneinung und Verknüpfungen wie und, oder zu neuen Aussagen zusammengefügt werden,

deren Wahrheitswert sich im Kalkül der Aussagenlogik aus dem seiner Bestandteile herleiten

lässt. Die Aussagenlogik lehrt etwa, dass A oder B wahr ist, wenn die Aussage A, oder die Aussage B, oder beide wahr sind. Und das ist völlig unabhängig davon, was A und B nun konkret

bedeuten. So beschäftigt sich die Aussagenlogik bei der zusammengesetzten Aussage

Der Mond ist aus günem Käse (A), oder nachts sind alle Katzen grau (B).

weder mit dem Mond noch mit Katzen, sondern nur damit, wie Gesamtaussage von ihren Teilaussagen abhängt, was immer sie sie nun genau bedeuten. Das mag jetzt nicht besonders beeindruckend klingen, aber das Prinzip kann auf beliebig komplexe Konstruktionen ausgedehnt

werden und schon bei der Feststellung, dass Wenn A dann B genau dann wahr ist, wenn A falsch

oder A und B wahr sind, muss man schon ein wenig mitdenken.

8

Der Zweck des Formalismus besteht nun genau darin, das Mitdenken soweit wie möglich zu

eliminieren, um auf bequeme und sichere Art “automatisch” zu richtigen Ergebnissen zu kommen. Man unterscheidet dabei die, Axiome genannten Grundannahmen, und die Schlussregeln.

Die Axiome werden als gegeben angenommen und durch Anwendung der Schlussregeln kommt

man zu neuen gültigen Aussagen. Das Schließen erfolgt dabei rein mechanisch, ohne jede Beachtung des Inhalts der Aussagen.

Ein Beispiel für eine Schlussregel ist1

A`A∨B

Mit ihr soll ausgedrückt werden, dass aus der Wahrheit einer beliebigen Aussage A die Wahrheit von A oder B (∨ = oder) geschlussfolgert werden kann. Das Zeichen ` steht für folgt

(syntaktisch) und ∨ ist eine Kurzform von oder. Ein anderes Beispiel ist:

A, B ` A ∧ B

Wenn A und B wahr sind, dann ist auch die Aussage A und B wahr (∧ = und). Manche Folgerungen sind Tautologien, sie sind ohne Voraussetzungen gültig, z.B.:

` A ∨ ¬A

D.h. A oder nicht A ist immer wahr (¬ = nicht). Eine etwas kompliziertere Regel war schon den

Scholastikern unter dem Namen Modus Ponens bekannt:

A, A → B ` B

Wenn A wahr ist und aus der Wahrheit von A die von B folgt (→ = folgt), dann kann man

schlussfolgern dass B wahr ist.

Die Schlussregeln sollten von ewiger unverrückbarer Wahrheit sein – logisch eben. Die Axiome

dagegen stellen unser aktuelles Wissen über die Welt dar. Angenommen die moderne Raumfahrt

hätte herausgefunden, dass der Mars aus alten Schokoriegeln besteht, und die theoretische Biologie postulierte, dass in alten Schokoriegeln neues Leben entsteht, dann wäre sicher, dass der

Mars von lebenden Wesen bewohnt ist.

Die Schlussregeln definieren einen Kalkül der von wahren zu wahren Aussagen führt. Ein

Kalkül kann als Maschine betrachtet werden, die wahlweise dazu benutzt werden kann,

um die Gültigkeit einer Aussage zu bestätigen, oder auch um alle Wahrheiten zu generieren.

Prädikatenlogik

Die Ausdruckskraft des Kalküls der Aussagenlogik ist zwar beschränkt, aber mit ihr war Mitte

des 19–ten Jahrhunderts eine Basis für eine wiederbelebte moderne Logik geschaffen. Die Weiterentwicklung der Notation und die Formulierung des weiteren Prädikatenkalküls hat ab Mitte

des 19–ten bis zum Beginn des 20–sten Jahrhunderts noch viele Jahre der Logik–Forschung in

Anspruch genommen.

Eine wirklich nützliche Logik kann sich nicht mit Aussagen als atomaren Einheiten begnügen.

1

Im Sinne der Lesbarkeit und Kürze haben wir auf exakte Definitionen und eine strenge Unterscheidung der

Begriffe verzichtet.

9

Sie muss auch deren innere Struktur betrachten können. Für die Aussagenlogik sind Sätze wie

Alle Zahlen sind Primzahlen oder Der Mars ist unbewohnt einfach nur entweder wahr oder

falsch. Sie kann nicht erkennen und unterscheiden, dass hier jeweils allen Elementen einer Menge bzw. einem bestimmten Element eine Eigenschaft, ein Prädikat zugeschrieben wird.

In der Sprache der Aussagenlogik können nur vorgegebene elementare Aussagen zu neuen Aussagen kombiniert werden. Die Prädikatenlogik erlaubt es dagegen, elementare Aussagen aus

Prädikaten (Eigenschaften und verallgemeinert Funktionen) zu konstruieren. Wenn P ein beliebiges Prädikat darstellt, z.B. P(x) = x ist eine Primzahl, dann ist

P (x)

eine prädkatenlogische Aussage. Dazu kommt noch die Möglichkeit der Quantifizierung, also

die Möglichkeit, Aussagen über alle oder ein bestimmtes Element machen zu können. Beispielsweise bedeutet

∀x∃y : P (x, y)

dass es für alle x (im Zeichen ∀x) ein y gibt (∃y), derart, dass P (x, y) wahr ist. Falls P das

Prädikat “größer” ist kann man so sagen, dass es für Elemente ein Element gibt, das größer ist.

Auf diese Art können aus Variablen, Namen für Elemente und Prädikaten Aussagen zusammengestellt werden. Dazu kommen dann noch die Mittel der Aussagenlogik, z.B.:

∀x∃y : (y > x) ∨ (y > x)

Die Sprache der Prädikatenlogik ist also eine Erweiterung der Sprache der Aussagenlogik. Entsprechendes gilt für ihre Schlussregeln. Sie sind reichhaltiger als die der Aussagenlogik. Ein

Beispiel für einen gültigen Schluss ist:

∀x : P (x) → Q(x), P (a) ` Q(a)

Mit P (x) als x ist eine Katze, Q(x) als x hat 4 Pfoten und a ist Sokrates können ihn als klassischen – und diesmal korrekten – Syllogismus konkretisieren:

Alle Katzen haben vier Pfoten, Sokrates ist eine Katze; also hat Sokrates vier Pfoten.

Euklid und die beste aller Welten

Mais Dieu a choisi celuy qui est le plus

parfait, c’est-à-dire celuy qui est en

même temps le plus simple en hypotheses

et le plus riche en phenomenes, ...

Leibniz in [11]

Mathematiker räsonieren selten über die Zahl der Pfoten von Sokrates, sie haben Probleme

in anderen Welten. Seit gut 2000 Jahren beschäftigen sie sich beispielsweise mit einfachen

geometrischen Figuren: Kreisen, Dreiecken und so weiter. So formulierte Euklid schon ca. 300

v.C. in seinem Buch der Elemente alles Wesentliche über die Geometrie der Ebene. Das Werk

ist Langzeit–Bestseller der Weltliteratur und vorbildlich für die Mathematik. Ein kleiner Satz

10

von Axiomen beschreibt unmittelbar einleuchtend die grundlegenden Fakten über geometrische

Figuren:

1. Zwei Punkte legen eine Gerade fest.

2. Eine Gerade hat keinen Endpunkt.

3. Jedes Segment einer Geraden definiert eindeutig einen Kreis mit diesem Segment als

Radius.

4. Alle rechten Winkel sind gleich.

5. Durch einen Punkt geht genau eine Gerade, die eine vorgegebene andere Gerade nicht

schneidet. (Parallelenaxion: Jede Gerade hat genau eine durch einen Punkt gehende Parallele.)

Aus diesen Axiomen leitete Euklid eine Vielzahl geometrischer Aussagen ab, nicht formal, sondern in natürlicher Sprache. Das war das Vorbild der mathematischen Arbeit. Wenn die Regeln

des Schlussfolgerns korrekt sind, so können alle (mathematischen) Wahrheiten erkannt werden.

Axiome, die offensichtlich mit der Wirklichkeit übereinstimmen, und korrekte überprüfbare

Schlussregeln (ein Kalkül) liefern alle und nur die wahren Fakten einer mathematischen Welt.

Die “geometrische Methode” war beständiges und weitgehend unerreichtes Vorbild für den Rest

der Mathematik. Die, je weiter sie sich im 17–ten und 18–ten Jahrhundert entwickelte, sich

um so weiter von ihr entfernte. Es war aber nicht nur die damals neue Infinitesimalrechnung,

auf die “Geometer” nur mit leichter Verachtung sehen konnten, bereits die simple Arithmetik

war ohne axiomatische Grundlage und wurde damit nicht wirklich als seriöse mathematische

Wissenschaft angesehen.

Aber auch das hehre Vorbild musste sich Zweifel und kritische Mäkeleien gefallen lassen. Ein

Axiomensystem sollte gewissen ästhetischen Ansprüchen genügen und nicht aus einem Sammelsurium zufällig zusammengetragener Fakten bestehen:

• Widerspruchsfreiheit (Konsistenz): Kein Axiom widerspricht einem anderen.

• Unabhängigkeit: Kein Axion ist aus einem anderen ableitbar.

• Vollständigkeit: Aus den Axiomen sollten alle Fakten ableitbar sein.

Wären Euklids Axiome nicht in jedem dieser Punkte vorbildlich, so hätten sich die Mathematiker nicht über so viele Generationen damit beschäftigt. Aber waren sie perfekt?

Das fünfte Axiom, das Parallelenaxiom, kam bereits den Schülern Euklids verdächtig vor. Im

Vergleich zu den anderen Axiomen ist es auffällig komplex und stört damit das Gesamtbild.

Vielleicht war Euklid einfach nicht in der Lage zu zeigen, dass es aus den anderen Axiomen abgeleitet werden kann. In der Folge haben Generationen von Mathematikern vergeblich versucht

zu zeigen, dass sie besser als Euklid sind, indem sie es beweisen, d.h. aus den anderen Axiomen

ableiten. – Natürlich waren sie nicht besser, alle diese Beweise waren falsch.

11

Bei den Versuchen, den Status des Parallelenaxioms zum Rest der Axiome zu klären, fanden Mitte des 19–ten Jahrhunderts mehrere Forscher unabhängig voneinander heraus, dass es

tatsächlich von den anderen Axiomen unabhängig war. Man kann eine konsistente Geometrie

betreiben, ohne das umstrittene Axiom zu verwenden. Man kann sogar sein Gegenteil annehmen, sowohl in der Form, dass es zu jeder Geraden mehrere Parallelen gibt, als auch in der, dass

es keine Parallele gibt. Beides führt zu keinerlei Widerspruch.

Natürlich hat in der Geometrie der Ebenen in der wirklichen Welt jede Gerade eine Parallele,

die Geometrie, in der dies nicht der Fall ist, muss eine andere sein, eine astrale Geometrie2 .

Das Parallenaxiom stellte sich nicht nur als unabhängig von den anderen heraus, es war in einer

ganz überraschenden Weise unabhängig. Man hatte erwartet, dass es entweder aus den anderen ableitbar ist, oder dass die anderen allein zu schwach sind, um eine sinnvolle Geometrie zu

definieren. Statt dessen zeigte sich, dass die ersten vier Axiome ein nahezu3 vollständiges geometrisches System definierten. Nimmt man das Parallelenaxiom hinzu, dann wird aus ihm eine

Beschreibung der Geometrie unserer Anschauung, nimmt man eine beliebige andere Variante

dieses Axioms hinzu, dann wird daraus die Beschreibung uns fremder Welten. Deren Fremdheit

wird zwar ein wenig dadurch gemildert, dass sie teilweise noch der Vorstellung zugänglich sind,

so kann die “Ebene” als Kugeloberfläche und die Gerade als Großkreis interpretiert werden, in

einer Welt in der es keine Parallelen gibt.

Wenn, wie Leibniz meint, Gott die beste aller Welten als die gewählt hat, in der die größte

Vielzahl an Phänomenen aus den einfachsten Hypothesen folgt, dann leben wir offensichtlich

nicht in der besten aller Welten, sondern in einer von vielen Welten. Eine die eine gewichtige

und recht unelegante Hypothese braucht, um das Phänomen von genau einer Parallelen pro

Punkt und Gerade zu erzeugen. – So viel an Axiom–Text für so wenig an Phänomenen.

Es war an der Zeit genauer darüber nachzudenken, was mathematische Theorien eigentlich bedeuten und in welcher Beziehung sie zu den “wirklichen” Wahrheiten stehen.

Hilbert und sein Programm

Wir müssen wissen,

wir werden wissen.

David Hilbert, nach [3]

Die Geometrie Euklids war das Vorbild bei der Entwicklung einer sauber fundierten Mathematik. Wenn die Axiome erst einmal in zufriedenstellender Weise formal exakt definiert sein sollten und der allgemeine logische Kalkül endlich einmal festliegt, dann kann sie als geklärt und

abgeschlossen betrachtet werden – und andere, schwierigere mathematische Theorien können

folgen.

Da gab es genug zu tun. Beispielsweise waren die reellen Zahlen, mehr intuitiv als mathematisch exakt gefasst, aber schon die simplen natürlichen Zahlen harrten einer axiomatischen–

2

F.K. Schweikart in einem Brief an Gaus, zitiert nach[8], Seite 92

Die Axiome Euklids sind nicht vollständig. Es gibt geometrische Fakten, die sich nicht aus ihnen ableiten

lassen. Hilbert hat allerdings ein im wesentlichen äquivalentes vollständiges und formales Axiomensystem angegeben.

3

12

deduktiven Behandlung. Dazu kam dann noch die Mengenlehre, die sich als fundamentaler

Grundbaustein der Mathematik erwies. Der Kampf um die Grundlagen der Mathematik wurde

also Mitte bis Ende des 19–ten Jahrhunderts an folgenden Fronten geführt:

• Logik: wie lassen sich wahre aus wahren Aussagen korrekt und vollständig schlussfolgern; in welcher Sprache und Notation lassen die Fakten sich ausdrücken?

• Grundlegende Mathematische Theorien, wie etwa:

– Geometrie: Welchen Status haben die Euklidschen Axiome, was ist mit dem Parallelenaxiom?

– Zahlen: Wie sieht eine axiomatische Fundierung der natürlichen und der reellen

Zahlen aus?

– Mengenlehre: Welchen Beitrag liefert die Mengenlehre zu einer Fundierung der Mathematik und wie kann sie selbst formal exakt nach der axiomatischen Methode

definiert werden.

Es war Zeit im üppig zugewucherten Garten der Mathematik geordnete Pfade und Rabatte anzulegen. Das Ziel war klar und der Weg dahin auch. Die gesamte Mathematik sollte auf Axiome

und ein Kalkül begründet werden.

• Ein formales Axiomensystem beschreibt die mathematischen Grundfakten.

• Ein Kalkül (Deduktionsregeln) formalisiert die Logik und erlaubt es

– jede korrekte mathematische Aussage herzuleiten (Aufzählbarkeit aller Wahrheiten), sowie

– zu jeder mathematischen Aussage angeben zu können, ob sie wahr ist oder nicht

(Entscheidbarkeit).

• Der Kalkül sollte natürlich konsistent sein und nur wahre Aussagen herleitbar machen

(Korrektheit) und

• er sollte alle wahren Aussagen herleiten können (Vollständigkeit).

Der Plan war ehrgeizig, aber sinnvoll und hatte gute Aussichten zu gelingen. David Hilbert

formulierte ihn im Jahre 1900 noch einmal explizit in einem Vortrag vor dem internationalen

Mathematikerkongress in Paris, damit war er zu Hilberts Programm geworden.

Hilbert war berufen ihn zu verkünden und ergdies tat auf der Basis wesentlicher Fortschritte

in der mathematischen Grundlagenforschung. Zunächst war es ihm selbst, in seinen Grundlagen der Geometrie, gelungen die Euklidsche Geometrie mit einem formalen, konsistenten und

vollständigen Axiomensystem auszustatten. Damit hat er den Maßstab gesetzt – den Maßstab

des Formalen.

Man muss jederzeit an Stelle von “Punkten”, “Geraden”, “Ebenen”, auch “Tische”, “Stühle”, “Bierseidel” sagen können.

13

empfahl er4 um Missverständnisse auszuschließen, die durch intuitive und alltägliche Interpretation der Begriffe entstehen können. In drastischer Weise brachte er damit den formalistischen

Standpunkt zum Ausdruck:

Die Bedeutung mathematischer Begriffe ist nicht relevant, es kommt nur auf ihre

Beziehungen zueinander an und die werden durch Axiome und logische Kalküle

bestimmt.

Er und die anderen Formalisten waren sicher nicht der Meinung, dass mathematische Begriffe keine Bedeutung hätten. Nur war diese für sie kein Thema der Mathematik, sondern bestenfalls philosophische Spekulation. Der formalistische Standpunkt hatte um die Jahrhundertwende einige Argumente für sich. Mit Boole und seiner Aussagenlogik hatte die Entwicklung

einer modernen mathematischen Sprache der Logik gut begonnen. Forscher wie Peirce und

Frege entwickelten danach den Kalkül der Prädikatenlogik.Innerhalb weniger Jahre hatte die

Logik damit mehr Fortschritte gemacht, als in Jahrtausenden zuvor. Peano hatte eine Axiomatisierung der natürlichen Zahlen gefunden, Cantor den Grundstein einer Mengenlehre gelegt,

...

Antinomien und die Grundlagenkrise

Diesen Hinweis bitte nicht beachten!

Um die Jahrhundertwende traten dann plötzlich die sogenannten Antinomien oder Paradoxien

auf. Es zeigte sich, dass bei einem naiven Gebrauch der formalen Sprache widersprüchliche

Aussagen möglich sind. Cantor selbst entdeckte die Problematik seiner Allmenge

X = {x | x ist eine M enge}

(enthält X sich selbst als Element?)

Er berichtete Hilbert, dem damaligen Papst der Mathematik, schon vor 1900 darüber. Cantor

und wohl auch Hilbert nahmen das nicht sonderlich ernst. Sie erwarteten, dass es sich um ein

lösbares Problem handelte.

Die Alarmglocken schrillten erst, als der sprach– und publikationsgewaltige Russel 1902 eine

griffigere Form solcher Antinomien publizierte und mit ihnen die Grundfesten der Logik und

Mathematik erschüttert sah. Am bekanntesten ist B. Russels “Menge aller Mengen, die sich

nicht selbst als Element enthalten.”:

{X|X 6∈ X}

(Russels Antinomie)

Die Frage, ob diese Menge sich selbst als Element enthält führt unweigerlich zu einem Widerspruch:

X ∈ X ⇔ X 6∈ X

Wenn X sich selbst nicht enthält, dann muss sie sich, per Definition enthalten. Wenn sie sich

nicht enthält, dann muss sie sich, wieder per Definition, enthalten. Die Definition von X ist eine

Variante des klassischen Barbierparadoxons:

4

zitiert nach [7], Seite 26

14

Im alten Theben (manchmal auch Sevilla) gab es einen Barbier der alle rasiert, die sich nicht

selbst rasieren.

Rasiert er sich selbst, dann rasiert er sich nicht selbst. Rasisert er sich nicht selbst, dann muss

er sich selbst rasieren. Die alten Griechen grübelten über dem Lügnerparadoxon

Alle Kreter lügen, sagte der Kreter.

Mit solchen Spielereien kann man ganze Bücher füllen ([9]). Für Oscar Wild waren sie nur

Wahrheiten, die einen Kopfstand machen, um mehr Aufmerksamkeit zu erregen5 und man ist

durchaus versucht sie als Kindereien abzutun, die keinen Bezug zu einer ernsthaften Wissenschaft haben. Aber andererseits: können Formalismen, in denen solche widersprüchlichen Aussagen möglich sind, die Basis der Mathematik und damit aller Naturwissenschaften bilden? Das

Problem musste unbedingt gelöst werden.

In ihrem monumentalen Werk Principia Mathematica (3 Bände 1910 – 1913) konnte Russel

dann zusammen mit A. Whitehead zeigen, wie mit Hilfe von Typen zulässige von unzulässigen

Aussagen getrennt und wie, auf Basis der zulässigen, ein Logikkalkül entwickelt werden kann,

indem die Gesetze der Arithmetik formuliert werden können. Statt der Typtheorie Russels und

Whiteheads verwendet man heute die axiomatische Mengenlehre nach Zermelo und Fraenkel,

doch das ist nicht weiter relevant, da beide äquivalent sind.

In der Typtheorie unterscheidet man Typen und verbietet deren Vermischung in mathematischen

Aussagen. So gehören beispielsweise Objekte, Mengen von Objekten und Mengen von Mengen

von Objekten zu unterschiedlichen Typen. Auch Relationen und Funktionen sind von anderem

Typ, als die Objekte auf denen sie operieren. Im Russelschen Paradoxon werden die Typen

vermischt, es ist damit nicht zulässig.

Das ist das Prinzip der Typisierung, wie man es bei modernen Programmiersprachen wie C++,

Java findet. Auch dort kann man an einen Parameter kein Argument vom falschen Typ übergeben. Der Test x 6∈ x in

{X|X 6∈ X}

kann beispielsweise als Aufruf not enthaelt(x,x) einer Funktion

bool enthaelt (Element e, Menge m) { .... }

angesehen werden. Ein solcher Aufruf ist immer ein Typfehler, da die beiden Argumente

von enthaelt unterschiedliche Typen haben müssen und darum niemals die Gleichen sein

können.

Die Typtheorie legt nahe, zwischen Objekten sowie Relationen und Funktionen auf diesen Objekten zu unterscheiden. In der Stufeneinteilung der Prädikatenlogik wird diesem Unterschied

Beachtung geschenkt. In der ersten Stufe sind nur solche Aussagen erlaubt, in denen Quantifizierungen sich ausschließlich auf Elemente beziehen. Quantifizierungen über Relationen oder

Funktionen sind nicht erlaubt. In der Prädikatenlogik erster Stufe ist es also beispielsweise erlaubt zu sagen “Jedes x mit der Eigenschaft P hat auch die Eigenschaft Q.”, aber es ist nicht

erlaubt zu sagen “Für jede Eigenschaft P gilt, x hat die Eigenschaft P oder es hat sie nicht.”

5

nach [9]

15

Kronecker und die bescheidene Rolle Gottes in der Mathematik

Die natürlichen Zahlen hat der liebe Gott gemacht,

alles andere ist Menschenwerk.

Leopold Kronecker

Die Antinomien bzw. Paradoxien waren zwar die publikumswirksamsten Querelen der Grundlagenkrise, aber es waren nicht die einzigen. Einer prominenten Schule von Mathematikern

passte die gesamte Richtung nicht, die die moderne Mathematik nahm, sie misstrauten dabei

grundsätzlich vielen Ergebnissen und hielten sie für nicht korrekt und vertrauenswürdig hergeleitet.

Speziell die Mengenlehre Cantors zog die Abscheu Kroneckers und anderer Vertreter dieser

Schule auf sich und das brachte den tief verletzten Cantor dazu, sich aus der mathematischen

Gemeinschaft zurück zu ziehen. Diese Reaktion war sicher übertrieben und ein Verlust für die

Mathematik, aber um Cantors psychische Gesundheit war es auch nicht besonders gut bestellt.

Ob dies Ursache oder Folge seiner Profession war sei, genau wie bei Gödel, dahingestellt.

Kroneckers Ausspruch über die natürlichen Zahlen, die – als einzige (!) – von Gott gemacht

wurden, ist Bestandteil des universellen Zitatenschatzes. Er wollte damit nicht etwa ausdrücken,

dass die natürlichen Zahlen etwas besonders verehrungswürdiges sind. Die Betonung liegt auf

dem anderen und dem Menschenwerk. Es ist ein Leitspruch der Konstruktivsten, die das Konstruierte der mathematischen Dinge betonten. Alle mathematischen Objekte sind konstruiert

und nur das explizit Konstruierte ist als “richtiges” mathematisches Objekt zu akzeptieren. Von

dieser Regel kann man bestenfalls die natürlichen Zahlen ausnehmen, die “irgendwie” schon da

sind – vielleicht durch Gottes Wille.

Den Unwillen der Konstruktivsten an der modernen, in ihrer Sicht zu spirituellen Mathematik

kann man leicht an dem berühmten Auswahlaxiom darlegen. In diesem Axiom wird behauptet,

dass es zu jedem System nicht-leerer Mengen eine Funktion f gibt, die aus jeder dieser Mengen

ein Element auswählt. Das Auswahlaxiom kann in mathematischen Beweisen häufig eingesetzt

werden und klingt auch sehr überzeugend: Warum sollte man nicht innerhalb einer Kollektion

von nicht–leeren Mengen, jeder dieser Mengen ein Element auswählen können?

Was Kronecker und die anderen Konstruktivsten daran stört ist, dass hier nur die reine Existenz

von etwas behauptet wird, aber nicht angegeben wird, wie es denn im Zweifelsfall zu konstruieren wäre. Bei endlichen Mengen ist die Konstruktion kein Problem. Man gibt aus jeder Menge

einfach ein Element an. Bei unendlichen Mengen von unendlichen Mengen kann aber mit dem

Auswahlaxiom die Existenz von abenteuerlichen Gebilden erschlossen werden, von denen niemand weiß, wie sie zu konstruieren wären und die darum durchaus mit Recht ein gewisses

Misstrauen auf sich ziehen.

In der sogenannten Grundlagenkrise der Mathematik haben wir es also mit einer Gemengelage

zu tun

• aus mächtigen und produktiven neuen mathematischen Ergebnissen, die auf ungeklärten

Prinzipien basieren,

• vermischt mit großen Fortschritten in den “Grundlagenfächern” Logik und Mengenlehre,

16

• die sich aber überraschend als durchaus problematisch herausstellten

• und einer prinzipiellen Diskussion zwischen diversen Varianten an Formalisten und Konstruktivisten darüber, was das Wesen der Mathematik ist und wie man schlüssig argumentieren kann.

Syntax, Semantik und Bedeutung in der Welt der Logik

Die Bedeutung eines Wortes ist das, was die Erklärung der Bedeutung erklärt.

L. Wittgenstein, Philosophische Untersuchungen

Der Charakterisierung von Hilbert und anderen als “Formalisten” haftet etwas Negatives an,

das relativiert werden muss. Sie waren weder der Meinung, dass es keine wirklichen mathematischen Objekte gibt, noch empfahlen sie, dass die Mathematiker aller Intuition entsagen,

und nur noch öde Spiele mit drögen Formeln spielen sollten. Sie waren aber der Meinung, dass

Spekulieren über die Existenz oder Nicht–Existenz für Mathematiker nur nach Feierabend und

sonntags nach der Frühmesse erlaubt ist. Ebenso sollten intuitive Argumente zwar weiterhin wie

üblich verwendet werden, aber im Zweifelsfall sollte jeder Beweis akribisch in einem logischen

Kalkül nachvollziehbar sein.

Hilbert vertrat dabei durchaus eine respektable Meinung. Die Rolle der Kalküle würde man

heute einem Computerprogramm zuweisen. Dieses Programm – einmal als korrekt bewiesen –

könnte dann bei der Eingabe eines Beweises akribisch entscheiden, ob der Beweis korrekt ist.

Weiter könnte es in einer endlosen Folge alle nur möglichen korrekten Beweise und damit alle

nur möglichen korrekten Behauptungen produzieren. Oder, es könnte auch, durch systematischen Vergleich mit dieser Liste von Wahrheiten herausfinden, ob eine vorgelegte Behauptung

korrekt ist. Das ist das Entscheidungsproblem, das – lange unter diesem (deutschen) Namen –

einen wesentlichen Einfluss auf Turing und andere Pioniere der Informatik hatte.

Das Ziel war also die automatische Kontrolle der Wahrheit mathematischer oder auch beliebiger

anderer formalisierbarer Aussagen. – Ein Projekt der Logik und der Mathematik, aber auch

eins der Informatik. Das Problem war nicht nur die Ungeheuerlichkeit des Plans – es musste ja

das gesamte mathematische Wissen in ein Axiomensystem gepresst werden. Die Formalisten

hatten auch ein mentales Problem. Sie wollten ein System zur Prüfung und Erzeugung von

Wahrheiten, aber sie scheuten sich wie der Teufel vor dem Weihwasser davor, so etwas wie den

Begriff “Wahrheit” ernsthaft zu untersuchen.

Erst als die Hemmschwelle überwunden und eine saubere Definition der Semantik in Angriff

genommen war, konnten die nächsten substanziellen Fortschritte erzielt werden. Werfen wir

also einen etwas genaueren Blick darauf, was die Logiker mit korrekt und vollständig genau

meinen, denn es ist ihre Art über die Wirklichkeit und deren geistige Abbilder zu reden. Sie

unterscheiden formale Systeme und die wirklichen Dinge. Das Wirkliche nennen sie Strukturen.

Eine Struktur ist so etwas wie die natürlichen Zahlen, oder die Menge aller Punkte in einer

Ebene, oder sonstige mathematische Objekte die miteinander in Beziehung stehen.

17

Syntax und Semantik Man unterscheidet also sauber zwischen Syntax und Semantik. Die Syntax basiert auf den Zeichen formaler Sprachen L. Eine solche “Sprache” enthält Zeichen. Die

Sprache der Aussagenlogik enthält Zeichen für Aussagen. Bei der ausdruckstärkeren Prädikatenlogik sind es Zeichen für Objekte, sowie für Funktionen und Relationen auf diesen Objekten.

Den syntaktischen Gebilden stehen auf Seiten der Semantik Strukturen gegenüber. Eine Struktur ist also eine Menge von realen (?) mathematischen Objekten zwischen denen bestimmte

reale Beziehungen bestehen. Objekte sind Werte bestimmter Funktionen, die auf andere Objekte angewendet werden, etc.

• Welt der Syntax: Sprachen die aus Zeichen bestehen, wobei Zeichen unterschieden werden als solche für Objekte, Funktionen und Relationen. Die Zeichen können nach bestimmten Regeln zusammengesetzt werden.

• Welt der Semantik: Strukturen jeweils bestehend aus Objekten, Funktionen, Relationen,

die in einer realen Beziehung zueinander stehen.

In der Welt der Syntax hat beispielsweise eine Sprache L mit den Zeichen a, b und f, wobei

a und b Objektzeichen sind und f ein Funktionszeichen ist. Nach den syntaktischen Regeln

ist es dann erlaubt f(a,b) oder f(a,f(b,a)) zu bilden. In der semantischen Welt haben

wir dagegen beispielsweise die Struktur der natürlichen Zahlen mit den Objekten 1 und 2 die

Funktion + und können 1 + 2 oder 1 + (2 + 1) bilden.

Bedeutung Den syntaktischen Objekten einer Sprache L kann in einer Struktur A eine Bedeutung zugewiesen werden, indem jedem Objekt–Zeichen ein Objekt und jedem Funktions– und

Relationszeichen eine Funktion bzw. eine Relation in A zugewiesen wird. Man spricht dann

von einer L–Struktur. Eine L–Struktur A ist also eine “Welt” mathematischer Objekte, über die

man in der Sprache L reden kann.

Bedeutung (Interpretation): Abbildung einer Sprache (Syntax) auf eine Struktur

(Semantik)

Beispielsweise könnten a, b und f die Bedeutung 1, 2 und + haben.

Gültigkeit Die Sprache L kann man um logische Formeln erweitern. Eine solche Formel ist

etwa

(P (a) ∧ P (b)) → P (f (a, b)).

Eine Formel φ kann, bei einer bestimmten Interpretation ihrer Zeichen, nun in einer L–Struktur

A gültig (wahr) sein oder nicht. Im ersten Fall schreibt man:

A |= φ

(φ ist wahr in A)

Beispielsweise ist die Formel

∀x.f (x, 1) > x

in der Struktur der natürlichen Zahlen N gültig (wenn f als Addition interpretiert wird), oder

kurz:

N |= ∀x.f (x, 1) > x

(x + 1 > x ist in N gültig; N ist Modell von x + 1 > x)

18

Modell Wenn eine Formel φ in A gültig (wahr) ist, dann sagt man auch, dass A ein Modell

von φ ist. Ein Modell ist in der Logik also etwas aus der semantischen, der “wirklichen” Welt,

das einen Sachverhalt “modelliert”! Man lasse sich nicht von dieser Umkehrung der üblichen

Interpretation des Wortes “Modell” irritieren.

Manche Formeln sind in allen Strukturen gültig. Man nennt sie dann allgemeingültig. Beispielsweise ist φ ∨ ¬φ allgemeingültig. In dem Fall schreibt man

|= φ

(φ ist allgemeingültig)

Eine allgemeingültige Formel im Kalkül der Aussagenlogik nennt man Tautologie. Allgemeingültige Formeln sind ewige, logische, von der Wirklichkeit unabhängige Wahrheiten.

Die exakte Definition der Semantik der Kalküle war aber Voraussetzung für ein sinnvolles Reden über deren Korrektheit und Vollständigkeit. Erst mit dem Sich–Einlassen auf diese “philosophischen Definitionen” war nicht nur ein Fortschritt in der Logik möglich, es hat auch innerhalb

kurzer Zeit zu einem reichhaltigen neuen mathematischen Gebiet, der Modelltheorie, geführt.

Syntaktisches und semantisches Schlussfolgern

Captain Kirk: Analyse Mr. Spock!

Dem semantischen Begriff der Wahrheit/Gültigkeit kann man den syntaktischen der Ableitbarkeit, bzw. des syntaktischen Schlussfolgerns gegenüber stellen. Das syntaktische Schlussfolgern

ist ein mechanischer Prozess. Er führt durch quasi automatisch von Aussagen zu neuen Aussagen. Ein solcher Mechanismus des Schlussfolgerns ist ein erstrebenswertes Ideal, denn mit ihm

können wissenschaftliche oder sonstige Aussagen objektiv geprüft, bzw. generiert werden, ohne

dass ein Rückgriff auf eine irgendwie geartete Begabung, Intuition oder Genialität notwendig

ist, deren Vorhandensein ja stets angezweifelt werden kann.

Syntaktisches Schlussfolgern Eine Formel φ folgt aus einer Menge von Axiomen F (φ ist aus

F ableitbar), wenn sie nach den Regeln des Kalküls aus F generiert werden kann. Man schreibt

dann

F `φ

(φ folgt syntaktisch aus F )

Hier steht ` für den syntaktischen Prozess des Schlussfolgerns, der es erlaubt φ zu beweisen.

Oder, prosaisch auf der syntaktischen Ebene formuliert: Es gibt eine korrekte Anwendung der

Ableitungsregeln von `, die von F zu φ führt.

Die moderne Logik hat diesem klassischen Begriff eine Semantik gegenüber gestellt, die es

erlaubt von Gültigkeit oder Wahrheit zu reden:

A |= φ

φ ist gültig in A

Zu diesem Gültigkeitsbegriff definieren wir eine passende inhaltliche Ableitung.

Semantisches Schlussfolgern Eine Aussage φ folgt semantisch aus einer Formelmenge F ,

wenn in jeder Welt, in der die Aussagen aus F wahr sind, auch φ wahr ist. Man schreibt dann:

F |= φ

(φ folgt semantisch/logisch aus F )

19

Etwas präziser wird das über den (logischen) Modellbegiff von oben ausgedrückt: Eine Formel

φ folgt semantisch aus einer Formelmenge F , wenn jedes Modell von F auch ein Modell von

φ ist.

(F |= φ) ⇔ (A |= F ⇒ A |= φ)

Je kleiner die Formelmenge F ist, um so größer ist die Zahl der “Welten” in denen sie gültig ist.

Verschiedene Welten haben natürlich um so weniger Gemeinsamkeiten, je größer ihre Zahl ist.

Der semantische Folgerungsbegriff erfasst das Gemeinsame dieser Welten. Aus einer kleinen

Formelmenge kann man wenige Fakten φ ableiten.

F klein

⇒ Viele A mit A |= F

⇒ Wenige φ mit A |= φ für alle diese A

⇒ Wenige φ mit F |= φ.

Wenn F beispielsweise die Euklidschen Axiome ohne das Parallelenaxiom sind, dann beschreibt F mehr Welten, als nur die Geometrie unserer Anschauung. Das aus F Ableitbare

ist auch in unserer Geometrie gültig, aber auch noch in anderen seltsamen Welten ohne Parallenen oder solchen mit vielen Parallen. Nehmen wir das Parallelenaxiom hinzu, dann schränken

wir die Modelle auf die uns bekannte Geometrie ein.

Vielleicht treffen wir dann “unsere Geometrie” genau, vielleicht auch nicht. Nun bei der Geometrie ist das so, zumindest mit den Hilbertschen, statt den Euklidschen Axiomen. Generell

stellt sich aber die Frage, ob mit irgendeinem (endlichen) Axiomensystem eine mathematische

Welt unserer Anschauung genau (!) charakterisiert werden kann.

Insgesamt haben die mathematischen Logiker zwei Begriffe des Folgerns definiert, einen syntaktischen “Was kann ich ableiten” und einen semantischen “Welche Wahrheiten folgen”, wobei der zweite über den Gültigkeitsbegriff, “Was ist in welcher Welt wahr” eingeführt wird:

F ` φ φ kann aus F syntaktisch abgeleitet werden

A |= φ φ ist gültig (wahr) in A

F |= φ Wo auch immer F wahr ist, ist auch φ wahr

Das syntaktische Schlussfolgern ist das seit Aristoteles Untersuchte. Sehr lange war es der einzige Begriff des Schlussfolgerns, den ernsthafte Mathematiker betrachtet haben. Ohne einen

Bezug auf auf die Wahrheit, oder bescheidener, auf eine semantische Komponente, sind alle

syntaktischen Ableitungen sinnlose Formelspielereien. Das wussten natürlich auch die mathematischen Logiker aller Zeiten. Trotzdem hat es bis zu Beginn des 20–sten Jahrhunderts gedauert, bis man sich an eine präzise Definition dieser Komponenten herangetraut hat, möglicherweise aus Angst vor allzu philosophischen Spekulationen, oder allzu spekulativer Philosophie.

Korrektheit und Vollständigkeit des Schlussfolgerns

Der ideale syntaktische Prozess zur Prüfung oder gar Generierung von Wahrheiten sollte

natürlich korrekt sein und diese Korrektheit sollte idealerweise auch bewiesen werden können.

Die Korrektheit des Schlussfolgerns lässt sich nur durch einen Bezug auf die “reale” Welt, die

Semantik, die Wahrheit der bewiesenen Aussagen definieren.

20

Die Korrektheit des syntaktischen Schließens zeigt sich, wenn es am semantischen Schließen

gemessen wird. Wenn also alles aus wahren Formeln Abgeleitete auch wahr ist.

Korrektheit des syntaktischen Schlussfolgerns Ein syntaktischer Ableitungsmechanismus

ist korrekt, wenn jedes Modell der Voraussetzungen F einer Schlussfolgerung auch ein Modell

der gefolgerten Aussage φ ist. Kurz:

Aus F ` φ folgt F |= φ

(Korrektheit von `)

Man kann auch kürzer sagen, ` ist korrekt, wenn alles Abgeleitete wahr ist.

Der komplementäre Begriff zur Korrektheit ist die Vollständigkeit. Bei der Korrektheit geht

es darum, ob das formal Abgeleitete wahr ist. Bei der Vollständigkeit eines Kalküls geht es

umgekehrt darum, ob das Wahre auch abgeleitet werden kann. Auch dies kann mit Hilfe des

Modellbegriffs formuliert werden.

Vollständigkeit des syntaktischen Schlussfolgerns Ein syntaktischer Ableitungsmechanismus ist vollständig, wenn jede Aussage A, die in jedem Modell der Voraussetzungen F gültig

ist, syntaktisch aus F gefolgert werden kann:

Aus F |= A folgt F ` A

(Vollständigkeit von `)

Man kann auch kürzer sagen, ` ist vollständig, wenn alles Wahre ableitbar ist.

Der Kalkül der Aussagenlogik ist korrekt. Dies nachzuweisen bereitet Logikern keine Mühe.

Auch die Korrektheit der Prädikatenlogik lässt sich einfach beweisen. Vor den harschen Aufforderungen zur Bescheidenheit durch seine Unvollständigkeitstheoreme, spendierte Gödel

den formalen Systemen ein positives Ergebnis. Er zeigte in seiner Dissertation von 1929 die

Vollständigkeit des Kalküls der Prädikatenlogik. Dieser Beweis ist als Gödels Vollständigkeitssatz bekannt geworden und in die Geschichte der Logik eingegangen. Dies war ein wichtiger

Schritt im Programm Hilberts, auch wenn er kurz darauf mit seinem Unvollständigkeitstheorem

diesem Programm seine Grenzen aufzeigte.

Genau gesagt, bewies Gödel nicht die Vollständigkeit der Prädikatenlogik sondern die

Vollständigkeit der Prädikatenlogik erster Stufe. Verschiedene Kalküle unterscheiden sich in

der Ausdruckskraft ihrer Sprache. Eine alte Unterscheidung ist die zwischen Aussagenlogik

und Prädikatenlogik. In der Aussagenlogik werden Aussagen, die als Ganzes wahr oder falsch

sein können, zu neuen Aussagen verknüpft. Die Prädikatenlogik enthält dazu noch Prädikate (Eigenschaften) und Funktionen und kann quantifizierende Aussagen machen, etwa solche

von der Art, dass eine Eigenschaft auf alle oder mindestens ein Ding zutrifft. Die Stufen sind

Verfeinerungen in der Einteilung der logischen Kalküle.

In der Prädikatenlogik der zweiten Stufe sind Quantifizierungen von Prädikaten und Funktionen erlaubt. Die Prädikate und Funktionen müssen allerdings auf Elementen operieren. In

der nächsten, der dritten Stufe können dann Prädikate quantifiziert werden, die Aussagen über

Prädikate machen und so weiter.

Die Vollständigkeit und Korrektheit der Prädikatenlogik kann man so interpretieren, dass die

Welten, in denen die Gesetzte der Prädikatenlogik gelten, durch deren Kalkül exakt charakterisiert werden. Jedes Faktum, das in all diesen Welten gilt, kann abgeleitet werden, jedes ableitete

Faktum gilt in all diesen Welten.

Der pure Prädikatenkalkül ist nun aber noch keine Mathematik. Mathematik betreiben wir erst,

21

wenn es so etwas wie geometrische Figuren oder Zahlen oder Sonstiges gibt. Dinge also die

durch zusätzliche Axiome definiert werden. Die Axiome der Mengenlehre definieren die Welt

der Mengen, die Axiome der natürlichen Zahlen charakterisieren die natürlichen Zahlen. Setzen

wir den richtigen logischen Kalkül auf diese Axiome an, dann bekommen wir eben alle und nur

die Aussagen, die in den Mengen, den natürlichen Zahlen, etc. gelten.

Das ist das Hilbertsche Programm: finde die richtigen Axiome für die diversen mathematischen

Welten, finde den richtigen Kalkül, dann kannst du alle und genau die Fakten ableiten, die in

diesen Welten gelten. Nun hat Gödel bewiesen, dass genau dies prinzipiell nicht möglich ist. –

Welche philosophischen Konsequenzen das nun auch haben mag, für den “Unterhaltungswert”

der Mathematik – für Mathematiker – ist es ein Glück.

Kalküle die rechnen können, sind nicht vollständig

Die Prädikatenlogik der ersten Stufe ist vollständig. Alles, was in allen Welten gilt, die ihren

logischen Gesetzen gehorchen, kann syntaktisch abgeleitet werden. Man kann dies auch algorithmisch fassen: Die Prädikatenlogik erster Stufe ist aufzählbar, oder, was damit äquivalent

ist, sie ist semi–entscheidbar. Die Aufzählbarkeit bedeutet, dass man einen Algorithmus angeben kann, der alle wahren Sätze systematisch produziert. Die Semi–Entscheidbarkeit sagt, dass

wir einen Algorithmus konstruieren können, der die Wahrheit jeder wahren Aussage feststellen kann, aber nicht unbedingt die Falschheit einer falschen Aussage. Die Prädikatenlogik der

ersten Stufe ist nur semi–entscheidbar, nicht entscheidbar.

Damit ist eine Brücke geschlagen zwischen den logischen Kalkülen und der Theorie der Algorithmen. Das formal Beweisbare entspricht dem Berechenbaren. Die Arbeit Gödels ist um so

bemerkenswerter, als er seine Ergebnisse mit quasi algorithmischen Methoden fand, ohne die

später von Turing und anderen entwickelte, leichter handhabbare Theorie der Berechenbarkeit

zu kennen.

Die Vollständigkeit der Prädikatenlogik ist schön, aber noch nicht ganz das Gewünschte. Wir

interessieren uns ja nicht in erster Linie für Welten in denen nur die Gesetzte der Logik gelten,

es sollen ja auch andere Gesetze gelten, z.B.: das Gesetz, dass 2+2 gleich 4 ist. Dazu werden

weitere Axiome benötigt, die so zu justieren sind, dass mit ihnen und dem logischen Kalkül

genau die mathematische Welt, etwa der natürlichen Zahlen, getroffen wird. Gödel zeigte nun,

dass genau dies nicht so wie erwartet gehen kann.

Gödel veröffentliche sein Unvollständigkeitstheorem unter dem Titel “Über formal unentscheidbare Sätze der Principia Mathematica und verwandter Systeme”. Mit Principia Mathematica und denen verwandten Systemen waren alle Logikkalküle gemeint, die “rechnen

können”, in den sich also die elementaren Gesetze der Arithmetik, die natürlichen Zahlen

mit Addition und Multiplikation, ausdrücken lassen. Hilberts Programm und Traum einer

vollständigen formalen Erfassung der Mathematik war damit am Ende.

Die mathematische Welt der natürlichen Zahlen ist nicht übermäßig anspruchsvoll, trotzdem

ist es unmöglich, sie mit Axiomen und einem logischen Kalkül exakt in den Griff zu kriegen.

Entweder bricht das ganz zusammen und alles lässt sich beweisen (dann ist vielleicht die Hölle

ein Modell des Systems), oder wir formulieren zu weit. Beispielsweise indem wir die unserer

22

Anschauung nach wahre Gödelsche Aussage G (“ich bin nicht beweisbar”, siehe oben) nach

dem Vorbild des Parallelenaxioms als Grundaxiom annehmen. Dann finden wir in den, von

unserem System beschriebenen Welten nicht nur natürliche Zahlen, sondern auch solche, in

denen absonderliche Wesen wie übernatürliche Zahlen ihr Wesen treiben. Das sind Zahlen, die

sich nicht durch Addition von 1 aus der Null bilden lassen.

Die Prädikatenlogik der ersten Stufe ist vollständig. Sobald man aber ein wenig Arithmetik hineinstreut wird die Sache unvollständig. Kalküle, die die Arithmetik über den natürlichen Zahlen

beherrschen, erfordern eine Prädikatenlogik der zweiten Stufe. Dieser Kalkül ist zwar korrekt,

aber nicht mehr vollständig. In seiner Sprache können “Welten” beschrieben und unterschieden

werden, ohne dass alle Gesetze, die in ihnen gelten formal syntaktisch ableitbar wären.

Der Grund dafür, dass ein Rechnen über natürlichen Zahlen zur zweiten Stufe führt, liegt im

Induktionsprinzip. Nach diesem Prinzip gilt ein Prädikat für alle natürlichen Zahlen, wenn es

für die Null gilt, sowie wenn seine Gültigkeit für x die Gültigkeit für x + 1 impliziert.

∀P : (P (0) ∧ (P (x) → P (x + 1))) → ∀x : P (x)

Das Induktionsprinzip ist eine Aussage über alle Prädikate und gehört damit der zweiten Stufe

an.

Sobald das Induktionsprinzip in einem Kalkül zugelassen ist, können in ihm Algorithmen in

Form sogenannter (primitiv) rekursiver Funktionen definiert werden, wie beispielsweise die

Addition und Multiplikation. In einem solchen Kalkül sind Aussagen über beliebige in ihm

selbst formulierbare Algorithmen möglich. Ein solcher Kalkül hat damit genug Ausdruckskraft

um ihn in die Falle von Gödels Selbstbezug laufen zu lassen und damit seine Unvollständigkeit

zu zeigen. Umgekehrt ist jeder Kalkül mit geringer Ausdruckskraft schon aus Schwachheit

“unvollständig”.

Folgerungen

Q: Aren’t computability theory and computational

complexity the keys to AI?

A: No. These theories are relevant but don’t address

the fundamental problems of AI.

John MacCarthy in [12]

Hilberts optimistisches “Alle Probleme sind lösbar, fangen wir an!” war wichtig. Es hat

nicht zu dem Erwarteten geführt, sondern zu dem wesentlich interessanteren Ergebnis, dass

es tatsächliche Grenzen der (mechanischen ?) Erkenntnis gibt. Zunächst von den Logikern

wie Gödel in Form seiner Unvollständigkeitsergebnisse, dann in der Nachfolge Turings am

Berechenbarkeits– und Komplexitätsbegriff. In der zweiten Variante, der von der Möglichkeit

und der Komplexität von Berechnungen, könnte die Geschichte von den Grenzen genauso, wenn

nicht noch reichhaltiger und spannender erzählt werden, mit dem Halteproblem als der moderneren Variante der Unvollständigkeit. Diese Hinweise auf die Grenzen des prinzipiell Erkenn–

23

und Berechenbaren werden noch weiter von aktuellen Arbeiten auf dem Gebiet der Komplexitätstheorie gestützt.6

Die ganz Geschichte würde damit noch interessanter, aber auch deutlich länger und komplexer.

Die prinzipiellen Ergebnisse wären aber die gleichen. Es gibt Dinge, die von Maschinen nicht

getan werden können. Ob diese Maschinen nun logische Kalküle, Turingmaschinen, aktuell

verfügbare Computer oder sonstige Mechanismen sind. Die Definition von Mechanismus oder

Kalkül ist dabei so robust, und die erzielten Ergenbnisse trotz unterschiedlicher und unabhängig

von einander entwickelter Ansätze so äquivalent, dass von der Existenz einer prinzipiellen Grenze ausgegangen werden kann und auch einiges dafür spricht, dass auch wir uns innerhalb dieser

Grenzen befinden.

Was hat dies nun mit Intelligenz zu tun, sei sie nun künstlich oder natürlich? Intelligenz lässt

sich, nicht völlig unstrittig, als Fähigkeit definieren, Phänomene und Objekte der äußeren Welt

durch innere Modelle so zu repräsentieren, dass deren Analyse eine Steuerung des eigenen und

fremden Verhaltens ermöglicht. Intelligenz konstruiert Modelle aus der Welt und rekonstruiert

umgekehrt die Welt als Bedeutung der Modelle. Akzeptieren wir die These, dass unsere Abbilder der Welt mit den formalen Systemen der Logik und Mathematik zumindest verwandt sind,

dann sind die Probleme der Logiker mit ihren formalen Systemen Probleme der Intelligenz.

Das zweite Unvollständigkeitstheorem Gödels postuliert nicht mehr und nicht weniger, als dass

die Fähigkeit formaler Systeme zur Introspektion beschränkt ist. Die moderne Logik hat aber

noch mehr und eigentlich Interessanteres zu bieten, als dieses Ergebnis. Welche mathematischen

Welten gibt es, in welcher Beziehungen stehen sie, wie genau können wir sie mit Axiomen

und Kalkülen charakterisieren. Wie wirklich sind sie wirklich? Die Definition der Logiker von

Syntax und Semantik ist recht einfach, manche würden sogar naiv sagen. Trotzdem hat sich

daraus ein komplexes Szenario an Modellen ergeben, die ganz sicher aber nicht einfach als

“reale Welten” angenommen und auf die Wirklichkeit übertragen werden können.

Wir können alles Maschinelle als formales System im Sinne Gödels verstehen, unsere durchaus

vorhandene Fähigkeit zur Introspektion dagegen setzen und dann schlussfolgern, dass wir, mit

unserer natürlichen Intelligenz, “mehr” sind als die Maschinen. Wir sehen beispielsweise, dass

die Gödelsche Aussage G wahr ist, aber die dummen Maschinen können es nicht sehen, damit

ist scheinbar bewiesen, dass wir über einen nicht–algorithmischen Erkenntnisapparat verfügen.

Das ist das alte Argument von Lucas.7 Aber erstens können reichhaltigere Kalküle die Dinge tatsächlich auch erkennen und zweitens ist die Natur des menschlichen Erkenntisprozesses

unbekannt und möglicherweise (wahrscheinlich/sicher?) genauso unvollständig. Zumindest hat

noch niemand die Vollständigkeit des menschlichen Erkenntnisprozesses erforscht.

Penrose8 liefert in einem Berg von Gelehrsamkeit ein, im Vergleich zu Lucas, umgekehrtes

“Gödel–Argument”, das ihn quasi zum Hilbert der natürlichen Intelligenz macht. Das Argument

ist folgendes: Angenommen, der menschliche Geist wäre nicht über–algorithmisch. Dann gäbe

es es einen Kalkül / Algorithmus A, der ihn codieren könnte. Nach Gödel gäbe es dann auch den

entsprechenden Gödelsatz G für A, der wahr, aber, in A nicht beweisbar ist. In A nicht beweisbar

bedeutet, dass seine Wahrheit für Menschen nicht erkennbar ist – wir glauben es einfach nicht.

6

siehe die Arbeiten über algorithmische Komplexität, [2]

nach [8]

8

in [14], auf 3 von ca. 600 Seiten.

7

24

Anderseits wurde G ja genau mit dieser Eigenschaft konstruiert und wir sind darum natürlich

der festen Überzeugung, dass es war ist. Ein Widerspruch! Die Hypothese, dass menschliches

Denken algorithmisch bzw. ein formales System ist, hat zum Widerspruch geführt und ist darum

falsch!

Überzeugt? – Penrose selbst wohl auch nicht so ganz, denn er führt noch den nicht–

algorithmischen Charakter des Bewußtseins und quantenmechanische Effekte im Gehirn ein.

Das Bewußtsein wurde von der Evolution erschaffen und muss darum notwendiges Element

natürlicher Intelligenz sein. Die Natur erschafft nichts Überflüssiges. Maschinen haben aber

kein Bewußtsein. Die gesamte Argumentation ist sehr gebildet, ausserordentlich länglich und

letztlich nicht überzeugend.

Der einzige Grund, aus dem die Grenzen der Maschinen für Menschen nicht gelten sollten, wäre, dass unser Geist nicht–algorithmisch ist. Dies kann mit Rückgriff auf Gödel nicht

schlüssig nachgewiesen werden. Aber ist es denn notwendig? Warum ist die Frage wichtig?

Die Grenzen der Berechenbarkeit als die Grenzen des menschlichen Geistes anzuerkennen ist

alles andere als ehrenrührig. Daran ändert auch die Tatsache nichts, dass Berechenbarkeit durch

die primitiven Turing–Maschinen definiert werden kann. Das ist nur psychologisch problematisch: Wer sie nicht, oder nur als Zerrbild kennt, mag keine Turing–Maschine oder ein logischer

Kalkül sein. Warum hat er aber kein Problem damit, aus Atomen zusammengesetzt zu sein?

Ob die Grenzen, die mathematische Logik und theoretische Informatik dem Erkenntnis–Prozess

prinzipiell gesetzt haben, auch für die natürliche Intelligenz gelten, ist letztlich ohne praktischen

Belang. Die Grenzen haben offensichtlich fundamentalen Charakter, der Raum der Möglichkeiten innerhalb dieser Grenzen ist groß und die Argumente, dass wir uns ausserhalb befinden, sind

schwach und viel zu kompliziert und konstruiert um eine so fundamentale Wahrheit ausdrücken

zu können.

Einen Beleg, dass die Grenzen für uns nicht gelten, kann keine Wissenschaft und kein Gödel–

Mystizismus liefern, dazu werden andere – nicht–algorithmische – Quellen der menschlichen

Erkenntnis benötigt. Aber gibt es die? – Hmm, ... hat nicht Gödel etwas in dieser Richtung

bewiesen?

Literatur

[1] Gregory Chaitin

Grenzen der Berechenbarkeit

Spektrum der Wissenschaft, Februar 2004, Seite 86ff

[2] Gregory Chaitin

On the intelligibility of the universe and the notions of simplicity, complexity and irreducibility

verfügbar auf Chaitins Homepage

http://www.cs.auckland.ac.nz/CDMTCS/chaitin/

25

[3] John Dawson

Kurt Gödel: Leben und Werk

Springer Verlag 1999

[4] Hans Magnus Enzensberger:

Hommage an Gödel

in Elexire des Teufels, Suhrkamp, 2002

[5] Glühbirnen–Witze

übersetzt aus http://www.informatik.uos.de/elmar/Fun/light2.html

[6] Freimut Hauk

Lust an der Erkenntnis

dtv, 2003

[7] Hans Hermes

Einführung in die mathematische Logik

Teubner, 1972

[8] Douglas Hofstadter

Gödel Escher Bach: an Eternal Golden Braid

Basic Books, 1979

[9] P. Hughes, G. Brecht

Die Scheinwelt des Paradoxons

Vieweg, 1978

[10] Eugène Ionescu

Die Nashörner

[11] Gottfried Wilhelm von Leibniz

Discours de Metaphysique

1686, online verfügbar unter:

http://www.ac-nice.fr/philo/textes/Leibniz-Discours.htm

[12] John McCarthy

What is Artifical Intelligence

URL: http://www-formal.stanford.edu/jmc/whatisai

[13] Robert Musil

Die Verwirrungen des Zöglings Törleß

Rowohlt 1959

[14] Roger Penrose

The Emperors new Mind

Oxford University Press, 1989

Nachdruck Vintage–Books, 1990