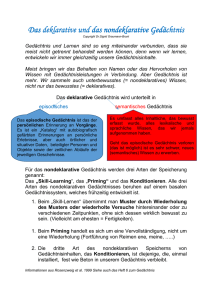

Lernvorlage Eysenck and Kean Cognitive Psychology

Werbung