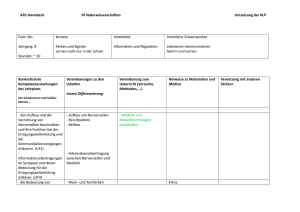

neuronale Grundlagen

Werbung

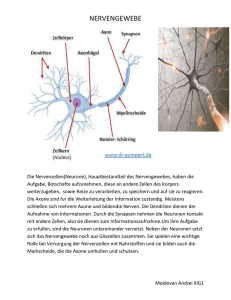

Lernpsychologische Theorien 16. September 2015 Neuropsychologie • Das menschliche Hirn besteht aus 100 Milliarden bis zu 1 Billion Nervenzellen (1012) • Diese Zellen sind grösstenteils hochgradig miteinander verbunden • Das riesige Netzwerk ist nicht statisch, sondern ist ständigen Veränderungen unterworfen 16.09.2015 Ruedi Stüssi 2 Eine typische Nervenzelle Synapsen Axon Zellkern Dendriten 16.09.2015 Ruedi Stüssi 3 Wo befinden sich die Informationen? • • • • • • • Man kann heute mit Sicherheit ausschliessen, dass es so etwas wie eine ‚Grossmutter‘-Hirnzelle gibt Der Zellkörper ist also keine Speicherzelle Die Informationen sind über weite Bereiche verteilt Sie ergeben sich aus der Vielzahl und der Durchlässigkeit der Verbindungen zwischen den einzelnen Nervenzellen Die ‚Grossmutter‘ ist also über eine Vielzahl von Zellverbindungen verteilt Deshalb bleiben Informationen auch nach dem Ausfall einzelner Nervenzellen zum Teil erhalten Die Funktion von Nervenzellen kann sich verändern, so dass auch nach relativ massiven Schädigungen eine Chance besteht, dass ausgefallene Funktionen von anderen Zellen übernommen werden 16.09.2015 Ruedi Stüssi 4 Neuronale Netze als Nachbild des Gehirns • • • • • • Künstliche neuronale Netze bestehen aus einer Vielzahl von Neuronen und einer zugehörigen Vernetzungsstruktur. Nach der Konstruktion eines Netzes muss es in einer Trainingsphase zunächst angelernt werden. Prinzipiell kann ein Netz durch folgende Maßnahmen lernen: Ausbilden neuer Verbindungen, bzw. löschen bestehender Verbindungen Anpassen der Gewichte von Neuron zu Neuron Anpassen der Schwellwerte der Neuronen Hinzufügen oder löschen von Neuronen Praktisch gesehen ‚lernt‘ ein Netz hauptsächlich durch Modifikation der Gewichte der Neuronenverbindungen 16.09.2015 Ruedi Stüssi 5 Vorzüge und Schwächen des Modells Es lassen sich selbstlernfähige Systeme entwickeln, die aber jeweils nur für einen sehr eingeschränkten Funktionsbereich tauglich sind Die Architektur des Netzes ist entscheidend für dessen Gebrauchswert Heute gebräuchliche neuronale Netze haben eine vorgegebene Architektur, die sich nicht dynamisch verändern kann Übertragen auf Computersysteme müsste ein Simulationscomputer folgende Merkmale aufweisen: • 1 Billion einfache Prozessoren • hochgradige Vernetzung der Prozessoren untereinander • unterschiedlich leitfähige Verbindungen unter den Prozessoren • die Verbindungen müssten sich dynamisch verändern können 16.09.2015 Ruedi Stüssi 6 Ein Vergleich … Es braucht einen Input, der dem System zur Verfügung steht Es braucht Lerninhalte Dem System muss ein Ziel bekannt sein Leistungsziele müssen bekannt sein Das System muss Informationen darüber erhalten, ob es sich beim Lerndurchgang dem Ziel angenähert hat Feedback ist unabdinglich und sollte kontinuierlich verfügbar sein Schnelle Veränderung der Gewichtung führt zu schnellem Lernen aber auch zu schnellem Vergessen Oberflächliches Lernen führt zu schnellen aber instabilen Erfolgen Langsame Veränderungen führen zu stabilerem Wissen Vertieftes Lernen führt zu stabilerem Wissen 16.09.2015 Ruedi Stüssi 7