Business-Intelligence-Werkzeuge

Werbung

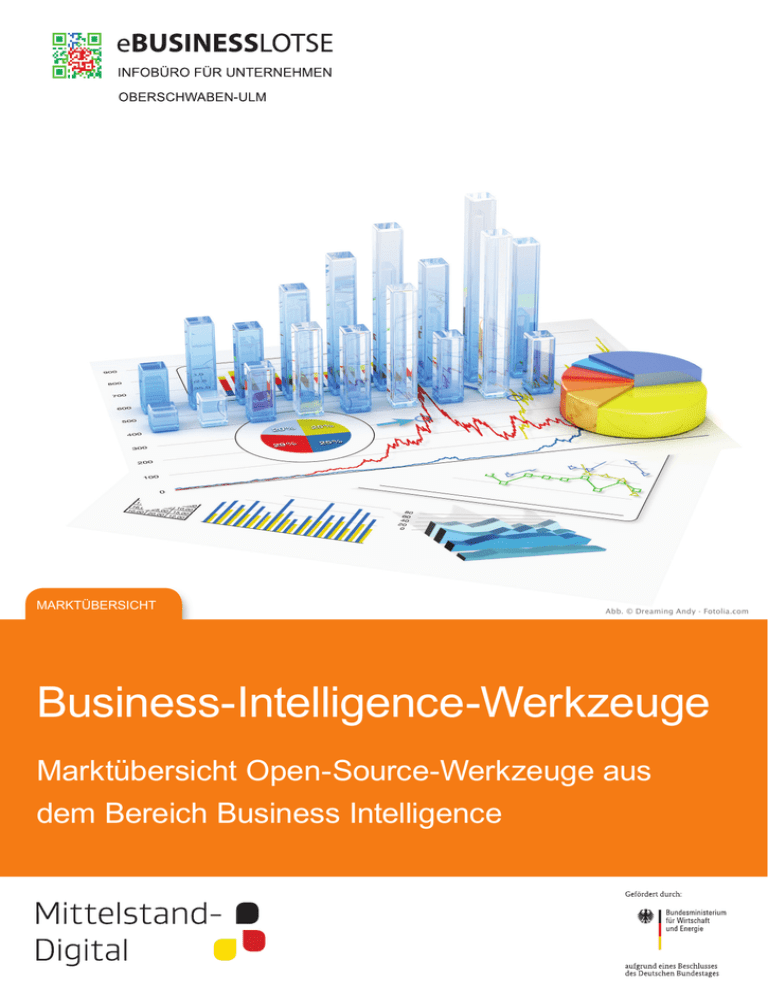

MARKTÜBERSICHT Abb. © Dreaming Andy - Fotolia.com Business-Intelligence-Werkzeuge Marktübersicht Open-Source-Werkzeuge aus dem Bereich Business Intelligence Träger Impressum Herausgeber eBusiness-Lotse Oberschwaben-Ulm www.eloum.net c/o Hochschule Ravensburg-Weingarten Doggenriedstraße 88250 Weingarten Telefon: +49 (0) 751 501-0 Verantwortlicher Redakteur Prof. Dr. Wolfram Höpken Lazarettstr. 1 88250 Weingarten Telefon: +49 (0) 751 4917 [email protected] Autor Dimitri Keil Stand Januar 2015 2 Partner Inhalt 1. Einleitung................................................................... 4 2. Vorauswahl................................................................ 6 3. Überblick................................................................... 7 4. Berichtswesen........................................................... 9 4.1 BIRT................................................................11 4.2 SQL Power Wabit...........................................12 5. ETL...........................................................................14 5.1 Pentaho Data Integration (Pentaho DI)...........15 5.2 Talend Open Studio........................................16 5.3 Jaspersoft ETL...............................................16 6. OLAP........................................................................17 6.1 Mondrian.........................................................18 6.2 Jedox..............................................................19 7. Data Mining.............................................................. 20 7.1 KNIME.............................................................21 7.2 RapidMiner..................................................... 22 7.3 Weka.............................................................. 23 8. Integrierte BI-Lösungen......................................... 24 8.1 Jaspersoft...................................................... 24 8.2 Pentaho......................................................... 25 8.3 SpagoBI......................................................... 26 9. Fazit......................................................................... 27 eBusiness-Lotse Oberschwaben-Ulm........................ 28 3 1. Einleitung Abb. © NAN - Fotolia.com Business Intelligence (BI) ist heute ein vielfach verwendeter Begriff in der Wirtschaft. Er fasst die Analyse geschäftsrelevanter Daten zur Verbesserung operativer und strategischer Entscheidungen zusammen. Es geht also um das Sammeln, Auswerten und Darstellen von entscheidungsrelevanten Daten. Dieses Dokument soll kleinen und mittelständischen Unternehmen (KMU) dabei helfen, sich einen Überblick über die für sie geeigneten Werkzeuge im Bereich Business Intelligence zu verschaffen. Schritt für Schritt werden die Werkzeuge in den folgenden Kapiteln in derselben Reihenfolge vorgestellt, wie sie auch in einem konkreten BI-Projekt eingesetzt werden. Abgeschlossen wird die Marktübersicht mit einer kurzen Vorstellung von Anbietern von integrierten BI-Lösungen, welche das gesamte BI-Spektrum abdecken. Die einzelnen Kapitel hängen hierbei nicht zwangsläufig voneinander ab, sondern können auch separat gelesen werden. Sind also Vor- 4 kenntnisse vorhanden bzw. besteht beispielsweise der Wunsch, lediglich Unterstützung bei der konkreten Auswahl einer Software-Lösung in einer der Teildisziplinen zu erhalten, so ist es ohne weiteres möglich, direkt in dem entsprechenden Kapitel einzusteigen. Für einen leichteren Einstieg in das Thema BI sowie die einzelnen Teildisziplinen wird Lesern ohne Vorkenntnisse jedoch die Orientierung entlang der Kapitelstruktur empfohlen. BI beginnt schon bei der Datenintegration, also dem Zusammenführen der Daten aus allen möglichen Quellen. Zunächst besteht die größte Herausforderung darin, überhaupt Datenquellen im Unternehmen zu identifizieren, deren Auswertung einen ganz konkreten Nutzen generiert. Das automatische und unternehmensweit einheitliche Erfassen geschäftsrelevanter Daten mittels komplexer IT-Systeme ist für kleine und mittelständische Unternehmen nicht bezahlbar. Einleitung Häufig werden diese Informationen stattdessen von mehreren Mitarbeitern separat unter Verwendung unterschiedlicher Software erfasst. In der Folge unterscheiden sich die abgelegten Informationen in Form und Inhalt. Durch die manuelle Erfassung sind die Informationen außerdem oft unvollständig und fehlerhaft. Die Bereinigung und Zusammenführung solcher Datenbestände ist sehr aufwändig und verursacht hohe Kosten. Es ist daher zwingend erforderlich, sich im Einzelfall für jedes Unternehmen genau zu überlegen, welche Daten für die Geschäftstätigkeit wichtig sind und in welcher Form diese in Zukunft erfasst und gespeichert werden sollen. Hierfür sollten aber zunächst die Geschäftsprozesse sowie die unterstützenden Informationsund Kommunikationssysteme analysiert und bei Bedarf entsprechend angepasst werden. Neben Informationen zu internen Geschäftsprozessen wie der Produktion oder dem Vertrieb können hier auch externe Informationen wie Veränderungen von Rohstoffpreisen an der Börse relevant sein. Neben der reinen Verfügbarkeit der Daten ist aber auch deren Qualität eine entscheidende Voraussetzung für die erfolgreiche Durchführung eines BI-Projekts und auch diese muss gegebenenfalls durch Anpassungen in den IT-Systemen sichergestellt werden. Stehen nun die Daten in hinreichend guter Qualität zur Verfügung, können diese je nach eingesetzter BI-Software direkt für die Analyse verwendet werden. Dazu müssen diese zunächst aus den IT-Systemen extrahiert, in ein einheitliches Format gebracht und in einen zentralen Datenbestand, ein Data Warehouse, geladen werden. Sogenannte ETL-Werkzeuge unterstützen den Nutzer dabei, genau diese Herausforderungen erfolgreich zu meistern. Erst nach einer solchen Integration der Quelldaten in einen zentralen Datenbestand können Berichts- sowie kennzahlengetriebene Planungs-, Kontroll- und Entscheidungsunterstützungssysteme auf den Daten aufsetzen und für den entscheidenden Wissensvorsprung sorgen. Neben Übersichten der wichtigsten Kennzahlen ermöglichen BI-Werkzeuge über das sogenannte OLAP dann auch die flexible Analyse der verfügbaren Quelldaten. So lassen sich 5 beispielsweise Umsätze gruppiert nach unterschiedlichen Merkmalen (z.B. Produktgruppen oder Regionen) sowie über einen festgelegten Zeitraum übersichtlich und schnell anzeigen. Darüber hinaus bietet das sogenannte Data Mining tiefergehende Analysemöglichkeiten auf Basis der vorhandenen Daten. So lassen sich beispielsweise Cross-Selling-Potenziale identifizieren oder auch Kundensegmente auf Basis der Verkaufsvorgänge erstellen. Diese Art der Datenauswertung ermöglicht kürzere Reaktionszeiten auf Änderungen am Markt und stellt somit einen deutlichen Wettbewerbsvorteil dar. Ein Data Warehouse ist eine Sammlung von Daten aus unterschiedlichen Quellen, die in einer vordefinierten Struktur abgespeichert werden und so einen einheitlichen Zugriff auf die vorhandenen Daten erlaubt. Unter ETL (Extraction, Transformation und Load) versteht man einen Prozess, bei dem Daten aus einem oder mehreren Quellsystemen in das entsprechende Format und die Struktur einer Zieldatenbank (meist ein Data Warehouse) transformiert und geladen werden. Beispiele können die Datumsformatierung oder Umrechnung von Maßeinheiten sein. Auch die Anreicherung von Daten wie etwa Schufa-Auskunftsdaten fallen in diesen Bereich. Unter OLAP (On-Line Analytical Processing) versteht man das flexible Betrachten einer oder mehrerer Kennzahlen gruppiert nach beliebig vielen Merkmalen. Mehr Informationen zum Thema erhalten Sie in Kapitel 5 dieser Marktübersicht. Unter Data Mining versteht man die tiefergehende Analyse von Daten hinsichtlich der Erkennung von Mustern oder Trends. Mittels Methoden des Data Mining lassen sich Wechselwirkungen und Beziehungen innerhalb der Daten ermitteln. So kann beispielsweise erklärt werden, warum Kunden einen Vertrag kündigen oder mit einem Produkt unzufrieden sind oder welche Produkte von Kunden häufig gemeinsam gekauft werden (Warenkorbanalyse). 2.Vorauswahl Mittlerweile wird eine Vielzahl von Werkzeugen im Bereich BI eingesetzt. Im folgenden Abschnitt wird deshalb eine Auswahl von Werkzeugen vorgestellt, die sich für KMU bzw. einen ersten Einsatz besonders eignen. Ein geringer Einarbeitungsaufwand und Komplexitätsgrad stehen hierbei bei der Auswahl im Vordergrund. Software im Bereich BI steht sowohl als kommerzielle als auch als Open Source-Variante zur Verfügung. Dabei gibt es Anbieter, die von einzelnen Schwerpunktthemen bis hin zu umfangreichen Komplettlösungen alle Bereiche abdecken. In einigen Branchen ist aber auch der Einsatz unternehmensweiter oder gar unternehmensübergreifender Software weit verbreitet. Ein Beispiel für ein solches Produkt stellen die Enterprise-Ressource-Planning-Systeme (ERP) dar. Diese meist modular aufgebauten Lösungen bieten heute zusätzliche Funktionalitäten im Bereich BI an bzw. verfügen zumindest über Schnittstellen zur Integration verschiedenster Zusatzmodule desselben Herstellers, aber auch von Drittanbietern. Diese Lösungen sowie kommerzielle BI-Werkzeuge allgemein haben allerdings eine Gemeinsamkeit: die Lizenzkosten für den Betrieb sowie die regelmäßig anfallenden Zusatzkosten in Form von Release-Wechseln, Wartung und Support bewegen sich oft in Regionen, die für KMU nicht bezahlbar sind. 6 über kommerzieller Software schnell zunichte. Bei der Auswahl eines Open-Source-Werkzeugs sollte man sich deshalb immer vorab informieren, inwieweit eine vollständige Dokumentation zur aktuell verfügbaren Version der Software vorliegt. Auch für den Bereich BI existiert eine Vielzahl an Open Source Software, sowohl für einzelne Themenbereiche wie beispielsweise die Datenintegration, das Data Warehousing oder Data Mining als auch integrierte Gesamtlösungen. Die Basisvarianten decken überwiegend alle Grundfunktionalitäten im jeweiligen Themengebiet ab und sind meist um Spezialmodule für besondere Aufgabenstellungen erweiterbar. Zusammenfassend lässt sich festhalten, dass etablierte kommerzielle Software im Bereich BI zwar durchaus seine Vorzüge hat (mehr Funktionen, verlässlichere Verfügbarkeit), allerdings durch die hohen Kosten nur für wenige KMU infrage kommt. Open-Source-Lösungen hingegen bieten für KMU den idealen Einstieg in das BI-Umfeld, da Basisfunktionalitäten kostenlos zur Verfügung stehen und somit die Einstiegshürden minimal ausfallen. Die vorliegende Marktübersicht beschränkt sich daher auf gängige Open-Source-Software im Bereich BI und wird kommerzielle Software nicht berücksichtigen. Kommerzielle Software versus Open Source Open-Source-Software im Bereich BI Etablierte kommerzielle Software zeichnet sich in der Regel durch eine hohe Beständigkeit und Zuverlässigkeit aus, ist aber oftmals mit hohen Kosten verbunden. Open-Source-Produkte hingegen stehen typischerweise kostenlos zur Verfügung, können jedoch jederzeit aufgekauft und kommerzialisiert oder durch die Einstellung der Weiterentwicklung auch komplett vom Markt verschwinden. Unzureichende oder auch veraltete Dokumentation führt darüber hinaus beim Einsatz von Open-Source-Software oftmals zu Problemen und kann im Einzelfall sogar die geplante Realisierung der eigenen Anwendung unmöglich machen. Der in der Regel angebotene Premium-Support als „letzte Rettung“ des eigenen Projekts ist meist relativ teuer und macht die beabsichtige Kostenersparnis gegen- ►► Im vollen Funktionsumfang ohne zeitliche Beschränkung kostenlos nutzbar ►► Alle Schwerpunktthemen im Bereich BI abgedeckt ►► Oftmals Erweiterungen für spezielle Aufgabenstellungen vorhanden ►► Community-Forum für Fragen und Antworten verfügbar ►► In der Regel gut integrierbar in bestehende IT-Infrastruktur ►► Open Source Werkzeuge für unterschiedliche Themenbereiche können in der Regel flexibel kombiniert werden 3. Überblick Die Funktionsmatrix in Tabelle 1 gibt einen Überblick über die Einsatzmöglichkeiten verschiedener BI-Werkzeuge. In den folgenden Kapiteln werden die Open-Source-Werkzeuge vorgestellt und weiterführende Informationen zu den BI-Themen ETL, OLAP, DataMining und dem Berichtswesen sowie zu integrierten BI-Lösungen gegeben. Neben der Funktionsmatrix sollen zusätzliche, allgemeine Hinweise den Einstieg erleichtern. Diese umfassen neben allgemeinen Systemanforderungen auch eine Bewertung wichtiger anderer Faktoren wie unter anderem den Umfang der Dokumentation oder auch den Grad an Aktivität innerhalb der User-Communities einzelner Werkzeuge. Software OLAP Rohdaten extrahieren Pentaho DI X Rohdaten transformieren X Talend OS X X X Jasper ETL X X X Mondrian X X Jedox X X BIRT X SQL Power W X Data Mining KNIME X X X X X RapidMiner X X X X X Weka X X JasperSoft X X X X Pentaho X X X X SpagoBI X X X X Dashboards Berichte X X Tabelle 1: Funktionsmatrix - Übersicht BI-Werkzeuge 7 Transformierte Daten laden X X X X X X X X X X X X X X X X X X X X Überblick Bewertung Es folgt eine Bewertung der einzelnen BI-Werkzeuge anhand wichtiger Kriterien, die neben der reinen Funktionalität für die Auswahl eines Werkzeugs entscheidend sein können. Als Nutzerprofil wird von einem IT-affinen Mitarbei- Software ter ausgegangen, der sicher im Umgang mit gängigen Büroanwendungen ist und darüber hinaus über grundlegende Erfahrungen im Bereich Datenbanken verfügt. Community Dokumentation Installation Usability *** *** *** * * * *** * ** ** ** ** ** * *** * *** * *** *** * * * * *** *** ** *** *** ** * *** * *** *** *** * * * *** *** *** * * * *** * *** ** ** ** ETL Pentaho DI Talend OS Jasper ETL OLAP Mondrian Jedox Berichtswesen BIRT SQL Power W Data Mining KNIME RapidMiner Weka Integrierte BI-Lösungen JasperSoft Pentaho SpagoBI *) Bewertungskriterien für Sternevergabe in aufsteigender Reihenfolge: Community: Forum vorhanden, Wiki vorhanden, Zahl der diskutierten Beiträge im Forum, zusätzliche Funktionalität im Werkzeug (Marketplace etc.) Dokumentation: Handbuch (u.a. auf Deutsch) verfügbar, Tutorials als Video vorhanden, Tutorials vom Hersteller oder anderen Personen vorhanden Installation: Manuelle Installation und Konfiguration bzw. Installationsroutine mit entsprechenden Bildschirmanweisungen vorhanden Usability: Hilfe- und HinweisFunktionen vorhanden, gute Benutzerführung, für BusinessAnwender geeignet *) Siehe Talend OS Dokumentation Tabelle 2: Bewertungsmatrix der ausgewählten Open Source BI-Tools Die Bewertungsmatrix zeigt deutlich, dass fast alle aufgeführten Werkzeuge durch eine starke und aktive Community begleitet werden. In Wikis und Foren findet man schnell Antworten auf die häufigsten Fragen. Der Punkt Dokumentation hingegen ist bei fast allen Werkzeugen schlecht bewertet worden. Dies ist vor dem Hintergrund wichtig, dass die Dokumentation 8 alle wichtigen Einstiegsinformationen für Nutzer des Werkzeugs enthalten sollte. Oft sind diese Dokumentationen nur auf Englisch verfügbar und erhöhen somit den Einarbeitungsaufwand. Bei der Installation und bei dem Punkt Usability schneiden die Werkzeuge meist gut bis sehr gut ab und sind somit auch für Einsteiger in das Thema Business Intelligence zu empfehlen. 4.Berichtswesen Im Berichtswesen werden Daten übersichtlich dargestellt. Neben klassischen Monats-, Quartals- und Jahresberichten schließt dieser Bereich auch das ad-hoc-Berichtswesen ein. Dabei können nicht nur relevante Informationen in Echtzeit bereitgestellt, sondern über Filteroptionen auch tiefergehende Details dargestellt werden. Abb. 1a zeigt einen einfachen Bericht zu Umsätzen je Produkt. In der Darstellung Abb. 1b auf der nächsten Seite ist ein Dashboard zu sehen, das wesentliche Kennzahlen zur Unternehmenssteuerung in verschiedenen Diagrammen zusammenfasst. Abb. 1a: Beispiele für einfache Berichte 9 ad-hoc Berichtswesen: Über ein ad-hoc Berichtswesen werden dem Nutzer nicht nur die für ihn relevanten Informationen in Echtzeit bereitgestellt, sondern er kann über Filteroptionen auch ins Detail gehen und so Zusammenhänge zügig erschließen. Solche Systeme erlauben oft das IT-unterstützte Verteilen der Informationen, egal ob über eine E-MailPush-Funktion, eine Exportfunktion der Daten in andere Office-Programme oder auch in andere Formate wie PDF. (mit freundlicher Genehmigung der Eclipse Foundation) Berichtswesen Abb. 1b: Beispiel eines Dashboards In einem Dashboard werden alle Informationen, die zur Planung, Steuerung und Kontrolle eines Unternehmens notwendig sind, in geeigneter Form zusammengefasst. Analog zur Instrumententafel von Maschinenanlagen oder auch dem Armaturenbrett in einem Kraftfahrzeug sollte ein Dashboard demnach neben gängigen finanzorientierten Kennzahlen alle weiteren Schlüsselindikatoren beinhalten, um ein Unternehmen weiter ‚auf Kurs‘ zu halten. Wie ein solches Dashboard gestaltet ist, wem es zur Verfügung steht und ob es lediglich statische Informationen enthält oder sich durch Nutzerinteraktion dynamisch verändert, das hängt am Ende von den Wünschen und Bedürfnissen der jeweiligen Unternehmensführung ab. 10 (mit freundlicher Genehmigung der Eclipse Foundation) Berichtswesen 4.1 BIRT Die gemeinnützige Gesellschaft Eclipse stellt mit BIRT (Business Intelligence and Reporting Tools) ein Open-Source-Werkzeug für den Bereich Berichtswesen bereit. Über den „BIRT Report Designer“ lassen sich Berichte jeder Art erstellen. Zunächst müssen Datenquellen konfiguriert werden. Hier können alle gängigen Datenbanksysteme oder Dateiformate wie z.B. CSV-Dateien als Datenbasis dienen (Abb. 2/1). Das Design des Berichtes kann beliebig auf das Unternehmen angepasst werden (Farben, Abstände, Rahmen etc.). Der konkrete Bericht wird dann erstellt, in dem die gewünschten Bausteine wie Tabellen oder Grafiken (Abb. 2/2) im Arbeitsbereich wie gewünscht angeordnet werden (Abb. 2/3). Abb. 2: BIRT Oberfläche 11 Die Pflichtparameter für jeden Baustein des Berichtes werden nach deren Platzierung über eine unmittelbare Eingabeaufforderung durch das Programm erfragt, was nur ein Beispiel für die gute Nutzerführung in der Software darstellt. Neben klassischen Berichten mit Firmenlogo, Adressbereich und tabellarischer Darstellung von Inhalten lassen sich auch ganze Dashboards mit Grafiken auf Basis von Inhalten aus einem Data Warehouse erzeugen (vgl. Fehler! Verweisquelle konnte nicht gefunden werden.). Exportieren lassen sich die Berichte am Ende natürlich auch, so zum Beispiel als Word-, Powerpoint- und PDF-Dokument oder als HTML-Dokument zur Einbettung in Webseiten (Abb. 2/4). (mit freundlicher Genehmigung der Eclipse Foundation) Berichtswesen 4.2. SQL Power Wabit Das Reporting-Werkzeug SQL Power Wabit dient primär der intuitiven Erstellung von Berichten auf Basis von Datenbankabfragen. Hierfür sollte im besten Fall eine Verbindung zum eigenen Data Warehouse hergestellt werden. SQL Power Wabit kommt aber auch mit OLAP-Würfeln zurecht. Voraussetzung ist, dass neben der Datenbankverbindung eine Beschreibung der Datenstruktur bereitgestellt wird. Anschließend lassen sich beliebige Datenbanktabellen aus einem Auswahlbereich heraus (Abb. 3/1) per Drag&Drop in den Arbeitsbereich ziehen (Abb. 3/2). Dort wird dem Nutzer grafisch angezeigt, über welche Attribute die einzelnen Tabellen verfügen und wie diese miteinander verknüpft sind. Nun können genau die Attribute ausgewählt werden, welche später auch im Bericht dargestellt werden sollen. Zusätzlich lassen sich Filter für die Attributswerte setzen, wahlweise wiederum innerhalb der grafischen Darstellung oder über einen Editor. Die Syntax innerhalb des Editors richtet sich nach dem je- Abb. 3: SQL Power Wabit Oberfläche 12 weils vorliegenden Datenbankmanagementsystem (Beispiel MySQL). Unter der Arbeitsfläche werden dem Nutzer die ausgewählten Daten in Form einer Ergebnistabelle angezeigt (Abb. 3/3). Die Ergebnistabelle reagiert dabei automatisch auf jede Änderung durch den Nutzer. Möchte man abschließend die Ergebnistabelle direkt in einen Bericht umwandeln bzw. daraus eine Grafik erstellen, nutzt man eine der Schaltflächen über dem Arbeitsbereich (Abb. 3/4). Neue Elemente wie z.B. Berichte oder Diagramme werden über einen Rechtsklick auf den jeweiligen Ordner (Bsp. ‚Templates‘ für Berichtsvorlagen) angelegt (Abb. 3/5). Alle Ergebniselemente – also Datenbankabfragen als Tabellen, daraus erzeugte Grafiken sowie eigene Bilder – können innerhalb der Berichtserstellung per Drag&Drop in den Bericht gezogen werden. (mit freundlicher Genehmigung der SQL Power Group Inc.) Berichtswesen Die Inhalte sowie eigene Grafiken können dabei bearbeitet und angepasst werden. Neben der Position und Größe der Inhaltselemente können Ergebnisse aus Datenbankabfragen durch Filter ergänzt werden. Umsatzzahlen lassen sich auf diese Weise zusätzlich nach dem Geschäftsjahr bzw. anderen Kriterien filtern. Die entspre- Abb. 4: SQL Power Wabit - Beispiel-Bericht in Form einer PDF-Datei 13 chende Information muss in diesem Fall natürlich über die Datenbank hinterlegt sein. Ist man mit dem Ergebnis zufrieden, können die Berichte gedruckt bzw. als PDF-Datei exportiert werden. (mit freundlicher Genehmigung der SQL Power Group Inc.) 5.ETL Unter ETL (Extraction, Transformation und Load) sind alle Werkzeuge für das Extrahieren, Transformieren und Laden von Roh- bzw. Quelldaten zusammengefasst. Diese Teildisziplinen sollen kurz näher beschrieben werden, da sie in der Übersichtsmatrix separat aufgeführt sind. Extrahieren Der erste Schritt des ETL-Prozesses befasst sich mit dem Extrahieren relevanter Daten aus unterschiedlichen Datenquellen, um diese für weitere Schritte verfügbar zu machen. Dies können strukturierte Datenquellen wie Datenbanken (z.B. MySQL, MS SQL Server, Oracle) oder verschiedene Dateiformate (z.B. CSV, Excel, XML, usw.) sein, oder auch unstrukturierte bzw. teilweise strukturierte Datenquellen in Form von Freitexten oder HTML-Dokumenten. Laden Das Laden befasst sich schließlich mit der Ablage der transformierten Quelldaten in den Datenbankstrukturen des Data Warehouses. Hierbei werden üblicherweise nur neue oder geänderte Daten berücksichtigt und das Data Warehouse entsprechend aktualisiert. Die im Data Warehouse bereitgestellten Daten sind die Basis für alle weiteren Schritte im BI-Prozess. Die Qualität dieser Daten bestimmt im wesentlichen Maße auch die Qualität der anschließenden Auswertungen. Somit wird dem ETL-Prozess und den entsprechenden Werkzeugen ein großer Stellenwert beigemessen. Transformieren Die Transformation hat zum Ziel, die zu analysierenden Daten in eine Form zu bringen, in der sie später durch Analysewerkzeuge bestmöglich ausgewertet werden können. Dies schließt neben der Beseitigung von Fehlern oder Ausreißern die Aufspaltung der Daten in möglichst viele Einzelinformationen sowie deren Anpassung an den jeweils gewünschten Datentyp ein. Abb. © deusexlupus - Fotolia.com 14 ETL 5.1 Pentaho Data Integration (Pentaho DI) Bei Pentaho DI handelt es sich um ein reines ETL-Werkzeug aus dem BI-Portfolio des Software-Anbieters Pentaho. Über einen visuellen Editor können die jeweiligen ETL-Prozesse ohne Programmierkenntnisse erstellt werden (siehe Abbildung 1). Hierzu wählt man die jeweiligen Bausteine aus der Auswahlpalette (Abb. 5/1), platziert sie auf der Arbeitsfläche (Abb. 5/2) und definiert das konkrete Verhalten des Bausteins über entsprechende Einstellungen (Abb. 5/3). Ein Baustein übernimmt jeweils einen Arbeitsschritt des ETL-Prozesses wie beispielsweise das Einlesen einer Quelldatei, das Umbenennen von Attributen, das Löschen von Ausreißern usw. Als Quelldaten werden neben CSV- oder Textdateien alle gängigen Datenbanksysteme unterstützt. Zudem gibt es Schnittstellen zu Systemen wie SAS, SAP, Google Analytics, Salesforce usw. sowie die Möglichkeit, Inhalte aus Emails zu importieren. Unterhalb der Arbeitsfläche (Abb. 5/4) befindet sich ein Bereich mit Informationen zum aktuellen ETLProzess. Neben der Anzeige des Ereignisprotokolls oder der Ausführungshistorie können hier beispielsweise über einen Klick auf den jewei- Abb. 5: Pentaho Data Integration Oberfläche 15 ligen Baustein die Daten eingesehen werden, welche an den nächsten Baustein weitergegeben werden. So lässt sich zügig ermitteln, ob in den einzelnen Bearbeitungsschritten alles korrekt ausgeführt worden ist. Wenn größere Datenmengen betrachtet und weiterverarbeitet werden sollen, ist die Analyse des grundsätzlichen Aufbaus der Daten interessant (Data Profiling). Nach der Installation einer kostenlosen Erweiterung können verschiedene Informationen zu den Daten berechnet werden. Neben dem Hinweis, wie viele Einträge innerhalb der Daten gänzlich fehlen, bekommt der Nutzer auf diese Weise zusätzliche Informationen, die er zur Optimierung der Datenstruktur heranziehen kann. Zudem gibt die Analyse Aufschluss über die allgemeine Datenqualität. Mit Data Profiling ist die (meist) automatisierte Analyse grundlegender Eigenschaften von Datenbeständen gemeint. Neben der Gesamtzahl der Einträge je Spalte (einer Tabelle) kann auch die Anzahl der leeren Einträge, Durchschnitts-, Minimum- und Maximum-Werte, das Zeitfenster (von-bis) für Datumsfelder sowie die Häufigkeit einzelner Werte angezeigt werden. (mit freundlicher Genehmigung von Pentaho) ETL 5.2. Talend Open Studio Der Anbieter Talend bietet verschiedene Werkzeuge im Bereich Datenintegration an, insbesondere das Werkezeug Talend Open Studio. Ähnlich wie bei der Lösung von Pentaho sind die „Jobs“ – so werden Datenintegrationsprozesse bei Talend genannt – Prozesse, die aus bis zu 450 verschiedenen (parametrisierbaren) Bausteinen bestehen können. Es werden Konnektoren zum Einlesen aller gängigen Datenquellen bereitgestellt sowie unzählige Bausteinen für die Datentransformation angeboten. Über den sogenannten „Map Editor“ lassen sich Datenelemente aus verschiedenen Datenquellen einer vorher festgelegten Zielstruktur zuordnen. Ohne jeglichen Programmieraufwand lassen sich ETL-Prozesse auf diese Weise mit überschaubarem Aufwand umsetzen. was als Vorlage für die spätere Implementierung des ETL-Prozesses dienen soll. So erhalten auch nicht IT-affine Personen im Unternehmen einen Überblick über die Funktionsweise einzelner Prozesse, ohne tiefer mit der Funktionsweise des Werkzeuges vertraut zu sein. 5.3 Jaspersoft ETL Jaspersoft ETL stellt bei der Datenintegration keine wirklich neue Alternative dar, sondern ist als Community-Version eine angepasste Version von Talend Open Studio. Der Einsatz dieser leicht angepassten Version macht aber nur dann Sinn, wenn in anderen Bereichen der BI-Landschaft ebenfalls Werkzeuge des BI-Anbieters Jaspersoft eingesetzt werden. Abbildung 6 zeigt die Arbeitsoberfläche von Talend Open Studio. Im Arbeitsbereich ist ein vereinfachtes Modell des Datenflusses dargestellt, Abb. 6: Talend Open Studio Oberfläche 16 (mit freundlicher Genehmigung der Public Footprint GmbH) 6.OLAP Unter OLAP (on-line analytical processing) werden alle Werkzeuge zusammengefasst, die bei großen Datenmengen das flexible Betrachten betriebswirtschaftlicher Kennzahlen (z.B. die Anzahl verkaufter Produkte oder der Umsatz) gruppiert nach beliebig vielen Merkmalen (z.B. Datum/Monat, Region oder Produkt) ermöglichen. Oft wird auch von sogenannten OLAP-Würfeln gesprochen (siehe dazu auch Abb. 7). Derartige Software bietet unter anderem die Möglichkeit, über verschiedene Hierarchieebenen hinweg (z.B. Jahr-Monat-Tag) sowie gefiltert nach mehreren Attributen Daten zu betrachten. Abb. 7: OLAP, tabellarisch und als sogenannter OLAP-Würfel (mit freundlicher Genehmigung des Urhebers Tobias Wäschle) Drill-Down bzw. Drill-Up sind gängige Filteroperationen in meist hierarchisch aufgebauten OLAP-Würfeln. Drill-Down bezeichnet demnach das Betrachten der Ergebnisse auf der nächstniedrigeren Hierarchieebene. Am Beispiel der Zeitdimension lässt sich dies einfach erklären. Werden beispielsweise Umsatzzahlen nach Monaten dargestellt, wäre eine mögliche Drill-Down-Option die Anzeige der Umsätze nach Kalenderwochen oder Tagen im jeweiligen Monat. Der Nutzer kann also über Drill-Down immer mehr ins Detail gehen. Drill-Up steht im Gegensatz dazu für eine Betrachtung der Daten auf einer abstrakteren Ebene. Im Falle der Anzeige von Umsätzen nach Monaten wäre eine mögliche Drill-Up-Option somit die Anzeige nach Geschäftsjahren. 17 OLAP 6.1 Mondrian Mondrian ist das OLAP-Modul im BI-Portfolio von Pentaho. Es handelt sich hierbei um eine Sammlung verschiedener Funktionen, die in Summe ein recht umfangreiches OLAP-Werkzeug bilden. Bevor diese Funktionen aber anwendbar sind, müssen die zugrundeliegenden Datenelemente zuvor in Kennzahlen (sog. Fakten) und Dimensionen unterteilt werden. Informationen zum Aufbau und zur Funktionsweise von Business Intelligence finden Sie im Leitfaden „Business Intelligence - Architekturüberblick“. Hierzu liefert Pentaho ein zusätzliches Werkzeug, um den Nutzer bei der Erstellung dieser Metainformationen zu unterstützen. können. Die einzelnen Funktionen von Mondrian werden über Schaltflächen aktiviert bzw. deaktiviert (Abb. 8/1). Neben klassischen OLAP-Funktionen findet man dort Schaltflächen zur Anpassung bzw. Erweiterung der Ergebnisdarstellung oder auch Exportfunktionen im PDF oder Excel-Format. Direkt darunter findet sich die Ergebnistabelle, die je nach Benutzerinteraktion und vorhergehender Anpassung der Darstellungs- und sonstiger Einstellungen die gewünschten Informationen anzeigt (Abb. 8/2). Die Darstellung der Ergebnistabelle als Grafik erfolgt separat unterhalb der Ergebnistabelle (Abb. 8/3) Abb. 8 zeigt beispielhaft, wie Daten mit Hilfe von Mondrian im Browser angezeigt werden Abb. 8: Mondrian als Java-Web-Applikation 18 (mit freundlicher Genehmigung von Pentaho) OLAP 6.2 Jedox Jedox bietet eine komplette BI-Suite an, die alle Bereiche von ETL über OLAP bis hin zu Dashboards (siehe Kap. 6) und Berichten umfasst. Das Steckenpferd war und ist aber das mächtige OLAP-Modul Jedox. Durch die Integration in Excel bietet Jedox für viele KMU einen großen Mehrwert, da verschiedenste Daten oft bereits Excel-Tabellen gepflegt werden. Jedox lässt sich in Excel integrieren und ersetzt die Pivot-Funktion, bietet aber viele zusätzliche Funktionen wie beispielsweise die Anzeige von Soll-Ist-Abweichungen. Der große Vorteil der Integration in Excel liegt vor allem in der „gewohnten“ Umgebung, denn Office-Anwendun- Abb. 9: Jedox Beispiel Spreadsheet 19 gen sind in KMUs weit verbreitet. Dadurch fällt der Einarbeitungsaufwand hier insgesamt relativ niedrig aus. Abb. 9 zeigt, dass die Optik der eigenständigen Jedox-Oberfläche starke Parallelen zu Excel aufweist. Zu verschiedenen Produktgruppen erhält der Anwender hier die wichtigsten Kennzahlen beispielhaft für ein fiktives Unternehmen übersichtlich dargestellt. Neben den Zahlenwerten heben zusätzliche Diagramme die derzeitige Situation wie auch die Entwicklung hervor. (mit freundlicher Genehmigung der Jedox AG) 7. Data Mining Unter Data Mining werden Werkzeuge zusammengefasst, die tiefergehende Analysen auf Daten jeglicher Art ermöglichen. Ein Beispiel hierfür ist die Kundensegmentierung (Abb. 10a). Typische Merkmale zur Marktsegmentbildung sind in Abb. 10b zu sehen. Ein anderes Beispiel sind Entscheidungsbäume. Abb. 11 zeigt auf stark vereinfachte Weise, ob ein Kunde kreditwürdig ist. Derartige Verfahren nutzen mathematische Algorithmen für die Berechnung von Mustern innerhalb der Datenbasis und übernehmen damit die Aufgabe, Trends und Zusammenhänge in großen Datenmengen zu ermitteln. Abb. 10a: Beispiel für eine Kundensegmentierung Abb. 10b: Typische Merkmale zur Marktsegmentbildung (© eBusiness-Lotse Oberschwaben-Ulm) (© thingamajiggs - Fotolia.com) Abb. 11: Beispiele zum Einsatz von Entscheidungsbäumen (© eBusiness-Lotse Oberschwaben-Ulm) 20 Abschließend seien noch die Warenkorbanalysen erwähnt (Abb. 12), anhand derer ermittelt werden kann, welche Warengruppen häufig zusammen gekauft werden. Abb. 12: Warenkorbanalysen (© Olivier Le Moal - Fotolia.com) Data Mining 7.1 KNIME Das Data-Mining-Werkzeug namens „Konstanz Information Miner“ wurde ursprünglich an der Universität Konstanz entwickelt. Heute bietet die KNIME.com AG mit Sitz in Zürich zusätzlich professionelle technische Unterstützung und Beratungsdienstleistungen für die KNIME-Plattformen. Das in Java entwickelte Projekt wird zudem als Plugin für das Programmierwerkzeug Eclipse angeboten. KNIME kann alle gängigen Datenformate und Datenbanken als Quelle für Rohdaten anbinden und bietet zudem eine Vielzahl von Bausteinen für die Datenmanipulation und Bereinigung. Der Schwerpunkt liegt allerdings in der Analyse von Datenbeständen. Hier bietet das Werkzeug neben eigenen Analysemöglichkeiten die Integration zahlreicher anderer Algorithmen aus der Software Weka (näheres dazu in 7.3) oder auch der Statistiksoftware „R“. Abschließend bietet das Werkzeug neben einer integrierten Möglichkeit zur Visualisierung der Ergebnisse den Export der Daten zur Weiterverarbeitung oder Veröffentlichung. Abb. 13: KNIME Oberfläche und Analysevarianten 21 Die einzelnen Bausteine stehen in einer sortierten Liste zur Verfügung (Abb. 13/1). Sie können per Drag&Drop in den Arbeitsbereich gezogen und einfach miteinander verbunden werden. Eine Art Ampelsystem zeigt dabei dem Nutzer an, ob ein Baustein noch konfiguriert werden muss (Abb. 13/2). Spezielle Bausteine zur Visualisierung der Daten können hierbei genutzt werden, um erste manuelle Analysen der Daten durchzuführen (Abb. 13/3). Ein möglicher Baustein ist hier z.B. der ‚Interactive Table‘, der die Daten, welche ihm übergeben werden, in einer interaktiven Tabelle verfügbar macht. Gängige Verfahren für tiefergehende Analysen wie Entscheidungsbäume oder auch Warenkorbanalysen können anschließend automatisch komplexe Muster in den Daten erkennen und liefern so relevantes Wissen zur Entscheidungsunterstützung. Analyseergebnisse können nach Abschluss der Analyse wiederum in gängige Formate exportiert werden (Abb. 13/4). (mit freundlicher Genehmigung von KNIME) Data Mining 7.2 RapidMiner RapidMiner ist ein in Java geschriebenes Werkzeug für maschinelles Lernen und Data Mining. Alle Algorithmen aus dem Projekt der Software Weka sowie der Statistiksoftware „R“ sind als Erweiterung über den RapidMiner Marketplace kostenlos verfügbar. Es wurden weitere Bausteine zur Datenmanipulation und -auswertung integriert, die RapidMiner zum derzeit wohl umfangreichsten Open-Source-Werkzeug im Bereich Data Mining machen. Über den Marketplace lässt sich die Software unter anderem um Lösungen im Bereich Text- oder Web Mining sowie um ein Berichts-Plugin erweitern. Ähnlich wie die Lösungen zur Datenintegration oder KNIME folgt auch RapidMiner dem Workflow-Prinzip. Über die Benutzeroberfläche können alle verfügbaren Bausteine aus der linken Spalte (Abb. 14/1) über Drag&Drop in den Arbeitsbereich (Abb. 14/2) in der Mitte gezogen werden. In der rechten Spalte werden alle Parameter für den gesamten Prozess oder aber einzelne Bausteine gesetzt (Abb. 14/3). Abb. 14: RapidMiner Oberfläche 22 Unter dem Arbeitsbereich befindet sich noch ein Ereignisprotokoll (Abb. 14/4), welches einzelne Arbeitsschritte im Prozessablauf erfasst und anzeigt. Rechts daneben erhält der Nutzer zusätzliche Informationen je Baustein (Abb. 14/5). Für den leichteren Einstieg bietet RapidMiner kostenlose Schulungsvideos an. Text Mining fasst Algorithmen zusammen, die über statistische und linguistische Verfahren Informationen aus unstrukturierten Texten generieren. So lassen sich beispielsweise Texte einem konkreten Themenbereich zuordnen oder Kundenfeedback in positive oder negative Aussagen unterteilen. Web Mining ist eine Teildisziplin des Data Mining, die sich auf Inhalte aus dem Internet beschränkt. Neben der allgemeinen Analyse von Internetinhalten (Web Content Mining) schließt es auch das Nutzerverhalten (Web Usage Mining) sowie die Beziehung zwischen Webseiten (Web Structure Mining) ein. So lassen sich z.B. Stimmungen von Kunden oder der Fachpresse zu Produkten eines Unternehmens einfangen oder die eigene Unternehmenswebseite auf Basis des Klickverhaltens der Besucher optimieren. (mit freundlicher Genehmigung von RapidMiner) Data Mining 7.3 Weka Weka ist ein Projekt der „Machine Learning Group“ an der Universität von Waikato, Neuseeland. Die gleichnamige Software umfasst eine Sammlung verschiedenster Algorithmen zum maschinellen Lernen. Diese Algorithmen können über das Werkzeug direkt auf verfügbaren Rohdaten oder aber über die Einbindung in den Java-Code innerhalb einer eigenen Softwarelösung ausgeführt werden. Neben klassischen Verfahren wie der Klassifikation, Regressions- und Cluster-Analyse sowie der Ermittlung von Assoziationsregeln bietet das Werkzeug zusätzlich Bausteine zur Datenvorverarbeitung wie auch zur Visualisierung von Analyseergebnissen. Das Werkzeug wird an der Waikato-Universität ständig weiterentwickelt und als losgelöstes, eigenständiges Produkt angeboten. Die Oberfläche zum Workflow-Design ist bei Weka im Vergleich zu anderen vorgestellten Werkzeugen weniger benutzerfreundlich. So ist beispielsweise nur wenig oder gar keine Dokumentation zu einzelnen Bausteinen sowie deren Parametern verfügbar. Auch die Regeln für der Anordnung und Verknüpfung von einzelnen Bausteinen sind oftmals unklar. Dem Nutzer werden zudem keine Hinweise für mögliche Fehler vor Ausführung eines Prozesses angezeigt und so bleibt das Werkzeug Experten vorbehalten, die sich damit bereits umfassend auskennen. Alle Algorithmen aus dem Weka-Projekt können jedoch - wie weiter oben schon erwähnt - in benutzerfreundlichere Anwendungen wie KNIME oder RapidMiner eingebunden werden. Abb. 15: Weka Oberfläche: KnowledgeFlow (mit freundlicher Genehmigung der Machine Learning Group an der University of Waikato) 23 8. Integrierte BI-Lösungen Integrierte BI-Lösungen sind meist modulare Systeme, die das gesamte Leistungsspektrum im Bereich BI abdecken. In der kostenlosen Variante dieser Systeme fehlt jedoch eine übergreifende Installationsroutine und die einzelnen Module müssen separat installiert werden. Auf Basis entsprechender Schnittstellen lassen sich unterschiedliche Module aber im Rahmen eines Gesamtprojekts einsetzen und die Ergebnisse eines Moduls können in der Regel ohne Probleme in den anderen Modulen weiterverarbeitet werden. In den sogenannten ‚Enterprise‘-Varianten werden die einzelnen Module oft als Komplettpaket angeboten, sowohl in Bezug auf die Installationsroutine als auch Bedienoberfläche. Da der Fokus dieser Marktübersicht jedoch auf kostenlosen Produkten liegt, wird auf diese Varianten nicht näher eingegangen. 8.1 Jaspersoft Jaspersoft ist einer der großen Anbieter integrierter BI-Lösungen. Es werden verschiedene Module für die einzelnen Teilaufgaben ange- Abb. 16: Beispiel-Bericht - Jaspersoft Reports Server, Community-Version 24 boten, die über Schnittstellen ohne großen Aufwand miteinander verbunden werden können. Es folgt eine Liste der einzelnen Module: ►► Jaspersoft ETL (siehe 4.2) ►► JasperReports Server (Berichts-Server) mit - JasperReports Library (Java-Bibliothek zur Erstellung von Berichten) - Jaspersoft OLAP (angepasste MondrianLösung, siehe 5.1) ►► Jaspersoft Studio (Editor zum Erstellen von Berichten) Im Bereich ETL und OLAP setzt Jaspersoft auf Drittanbieter, passt die Module allerdings auf die eigene Produktlinie an. Alle Teilmodule können auch getrennt voneinander genutzt werden. Jaspersoft legt den Fokus auf die Berichtserstellung sowie -verteilung. Der Berichtsserver stellt damit das Herzstück der Lösung dar. Beispielberichte zeigt Abb. 16. (mit freundlicher Genehmigung der TIBCO Software Inc.) Integrierte BI-Lösungen 8.2 Pentaho Pentaho setzt ähnlich wie Jaspersoft auf angepasste, teils bestehende Open-Source-Projekte, die von Pentaho aufgekauft worden sind. Die Schwerpunkte liegen in der Datenintegration sowie der Berichtsautomatisierung. Das Produktportfolio besteht aus: ►► Business Analytics Platform Eigenentwickelte Webapplikation zur zentralen Zusammenführung aller Informationen auf einer Plattform. Möglichkeit zur Integration zusätzlicher Erweiterungen. ►► Data Integration ETL-Werkzeug (siehe 4.1). ►► Report Designer Weiterentwicklung des aufgekauften Projekts JFreeReport. Kann separat oder als Erweiterung der ETL-Lösung von Pentaho eingesetzt werden. Abb. 17: Beispiel-Bericht - Pentaho BI Server 25 ►► Aggregation Designer & Schema Workbench Zwei Werkzeuge zur Erstellung und Optimierung der Datenbankinhalte. Als Basis hierfür dient Mondrian (siehe 5.1). ►► Metadata-Editor Mit ihm lassen sich die zugrundeliegenden Datenstrukturen mit Hilfe einer XML-Datei detaillierter beschreiben. Diese Meta-Beschreibung dient den anderen Werkzeugen als Input für weitergehende Auswertungen der Daten. So lassen sich hier die Dimensionen selbst sowie die beinhaltenden Hierarchien beschreiben. Die XML-Datei dient am Ende Mondrian (siehe 5.1) als Basis für weitere Operationen auf den Daten. Abb. 17 zeigt ein Dashboard mit verschiedenen Diagrammen zu einem fiktiven Unternehmen (z.B. Umsatz nach Region). Kommen neue Daten hinzu, aktualisieren sich die Diagramme automatisch. (mit freundlicher Genehmigung von Pentaho) Integrierte BI-Lösungen 8.3 SpagoBI Als einziger Anbieter integrierter BI-Lösungen bietet SpagoBI alle Module nur in einer Open-Source-Variante an. Es gibt keine ‚Enterprise‘-Version von SpagoBI. Das Geschäftsmodell besteht darin, Dienstleistungen im Bereich der Einrichtung und Anpassung der Module auf kundenspezifische Anforderungen anzubieten. Im Wesentlichen bietet SpagoBI den Vorteil, dass alle angebotenen Software-Lösungen über eine zentrale Plattform über den Browser verwaltet werden können. So kann eine Lösung, die mit SpagoBI entwickelt worden ist, in den BI-Schwerpunktthemen ETL, OLAP, Data Mining sowie Berichtswesen unter anderem aus den folgenden Werkzeugen zusammengesetzt sein: ►► ETL - Talend (siehe 4.2) ►► OLAP - Jedox (siehe 5.2) - Mondrian (siehe 5.1) ►► Data Mining - Weka (siehe 7.3) - Statistiksoftware R ►► Berichtswesen - BIRT (siehe 6.1) - JasperReports Library (siehe 8.1) Darüber hinaus bietet SpagoBI noch weitere Module an. Sie dienen vor allem zur Optimierung der Darstellung von BI-Ergebnissen auf mobilen Endgeräten oder auch zur Unterstützung der Verbindung von geographischen Daten mit geschäftsrelevanten Daten. Abb. © SpagoWorld Communications 26 Abb. © DOC RABE Media - Fotolia.com 9.Fazit Die Auswahl an brauchbaren Open Source Werkzeugen für jeden Einsatzzweckim Bereich BI ist mittlerweile recht groß. Der Einarbeitungsaufwand ist bei den meisten Werkzeugen überschaubar. Wenn hierfür die Dokumentation des Anbieters selbst nicht ausreichen sollte, wird der Einstieg in nahezu jedes Software-Produkt durch zusätzliche Inhalte aus den sozialen Medien unterstützt. Ist man auf professionelle Hilfe angewiesen, besteht immer die Möglichkeit, kostenpflichtigen Support in Anspruch zu nehmen bzw. auf eine ‚Enterprise‘-Version der jeweiligen Lösung umzusteigen. Der Einstieg in die BI-Welt wird über die vorgestellten Werkzeuge im Bereich des Berichtswesens empfohlen, da sich auf diese Weise erste Mehrwerte durch die Zusammenführung der bestehenden Daten erzielen lassen. 27 Anschließend können Lücken innerhalb der nun verfügbaren Berichte durch eine Reorganisation der Datenerfassung geschlossen werden. Hierfür kommen Werkzeuge aus dem Bereich ETL zum Einsatz. Gleichzeitig kann das Berichtswesen um spezifische OLAP-Auswertungen auf der Basis der vorgestellten Werkzeuge ergänzt werden. Sollen weitergehende Analysen wie Cluster-Analysen oder Warenkorbanalysen zur Unterstützung von Entscheidungen beitragen, können Data Mining Werkzeuge zum Einsatz kommen. So kann das unternehmenseigene BI-Portfolio sukzessive auf die jeweiligen Anforderungen angepasst werden. © Yuri Arcurs - Fotolia.com eBusiness-Lotse Oberschwaben-Ulm Der eBusiness-Lotse Oberschwaben-Ulm ist Teil der Förderinitiative „eKompetenz-Netzwerk für Unternehmen“, die im Rahmen des Förderschwerpunkts „Mittelstand-Digital – IKT-Anwendungen in der Wirtschaft“ vom Bundesministerium für Wirtschaft und Energie (BMWi) gefördert wird. Der Förderschwerpunkt unterstützt gezielt kleine und mittlere Unternehmen (KMU) sowie das Handwerk bei der Entwicklung und Nutzung moderner Informations- und Kommunikationstechnologien (IKT). „Mittelstand-Digital“ setzt sich zusammen aus den Förderinitiativen ►► „eKompetenz-Netzwerk für Unternehmen“ mit 38 eBusiness-Lotsen, ►► „eStandards: Geschäftsprozesse standardisieren, Erfolg sichern“ mit derzeit 16 Förderprojekten, und ►► „Einfach intuitiv – Usability für den Mittelstand“ mit zurzeit 14 Förderprojekten. Weitere Informationen finden Sie unter www.mittelstand-digital.de.