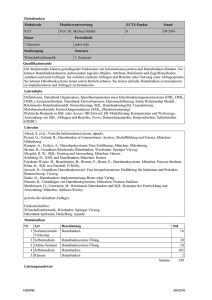

Skript Relationale Datenbanken

Werbung