8b Bedingte Erwartung, Bedingte Varianz, bedingte Verteilung

Werbung

Vorlesung 8b

Bedingte Erwartung,

bedingte Varianz,

bedingte Verteilung,

bedingte Wahrscheinlichkeiten

1

Wie gehabt, denken wir uns ein zufälliges Paar

X = (X1, X2)

auf zweistufige Weise zustande gekommen:

P(X1 = a1, X2 = a2) = P(X1 = a1) Pa1 (X2 = a2) .

h

i

Ea1 h(X1, X2) :=

X

a2∈S2

h(a1, a2)Pa1 (X2 = a2)

nennen wir den

bedingten Erwartungswert von h(X1, X2),

gegeben {X1 = a1}.

2

h

i

E h(X1, X2)

=

X

X

h(a1, a2) P(X1 = a1, X2 = a2)

a1∈S1 a2∈S2

=

X

X

a1∈S1 a2∈S2

=

h(a1, a2) P(X1 = a1) Pa1 (X2 = a2)

X

a1∈S1

=

X

a1∈S1

h

i

h

i

P(X1 = a1)Ea1 h(X1, X2)

P(X1 = a1)Ea1 h(a1, X2)

h

i

= E EX1 [h(X1, X2)] .

“Zerlegung des Erwartungswertes nach der ersten Stufe”

3

Merke: Der bedingte Erwartungswert

h

i

Ea1 h(X1, X2)

ist eine Zahl.

h

i

EX1 h(X1, X2)

ist eine Zufallsvariable.

Wir sprechen von der

bedingten Erwartung von h(X1, X2) gegeben X1.

4

Die bedingte Erwartung als

beste Prognose im quadratischen Mittel:

Satz:

Sei X2 reellwertige Zufallsvariable mit E[X22] < ∞.

Dann minimiert die bedingte Erwartung EX1 [X2]

unter allen reellwertigen Zufallsvariablen der Form h(X1)

den erwarteten quadratischen Abstand

E (X2 − h(X1))2 .

h

i

5

Beweis:

h

Wir zerlegen E (X2 − h(X1

))2

i

nach X1:

E (X2 − h(X1))2 = E EX1 (X2 − h(X1))2

h

i

X

2

P(X1 = a1)Ea1 (X2 − h(a1))

=

h

i

h

i

a1

Wir wissen schon (aus Vorlesung 7b):

h

Ea1 (X2 − h(a1

))2

i

wird minimal für

h(a1) := Ea1 [X2].

6

Fazit:

Unter allen Zahlen h(a1)

ist der bedingte Erwartungswert Ea1 [X2]

diejenige Zahl, für die Ea1 [(X2 − h(a1))2] minimal wird.

Unter allen Zufallsvariablen der Form h(X1)

ist die bedingte Erwartung EX1 [X2]

diejenige, für die

E[EX1 [(X2 − h(X1))2]] = E[(X2 − h(X1))2]

minimal wird.

7

Definieren wir die

bedingte Varianz von X2, gegeben {X1 = a1}:

h

Vara1 [X2] := Ea1 (X2 − Ea1 [X2

])2

i

Die Zerlegung

E[(Z − c)2] = Var[Z] + (EZ − c)2

überträgt sich

auf den bedingten Erwartungswert und die bedingte Varianz:

2

Ea1 (X2 − h(a1))2 = Vara1 [X2] + Ea1 [X2] − h(a1)

h

i

8

2

h

Ea1 (X2 − h(a1))

i

2

= Vara1 [X2] + Ea1 [X2] − h(a1)

Ersetzen wir a1 durch die Zufallsvariable X1:

2

EX1 (X2 −h(X1))2 = VarX1 [X2]+ EX1 [X2]−h(X1)

und bilden den Erwartungswert, dann bekommen wir

h

i

2

h

E (X2 − h(X1))

h

i

h

i

2 i

= E VarX1 [X2] + E EX1 [X2] − h(X1)

.

Wählen wir speziell h(X1) := E[X2], dann ergibt sich

h

i

h

i

Var[X2] = E VarX1 [X2] + Var EX1 [X2]

“Zerlegung der Varianz nach der ersten Stufe”

9

Beispiel: Zufällige Anzahl unabhängiger Summanden.

Y :=

N

X

i=1

Zi

mit Z1, Z2, . . . unabh., ident. vert. und unabhängig von N .

µ := E[Z1], σ 2 := Var[Z1]

En[Y ] = nµ ,

Varn[Y ] = nσ 2 .

E[Y ] = E[EN Y ] = E[N µ] = E[N ] · µ.

h

i

h

Var[Y ] = E VarN [Y ] + Var EN [Y ]

= E[N ] · σ 2 + Var[N ] · µ2.

i

10

Bedingte Verteilungen

und

bedingte Wahrscheinlichkeiten

11

Bisher:

Aufbau der gemeinsamen Verteilung von X1 und X2

aus der Verteilung ρ von X1

und Übergangswahrscheinlichkeiten P (a1, .):

P(X1 = a1, X2 = a2) := ρ(a1)P (a1, a2)

12

Jetzt:

Zerlegung der gemeinsamen Verteilung von X1 und X2

in die Verteilung von X1

und die bedingte Verteilung von X2 gegeben X1

13

Sei X1 eine diskrete Zufallsvariable mit Zielbereich S1

und X2 eine Zufallsvariable mit Zielbereich S2.

Dann ist die

bedingte Wahrscheinlichkeit von {X2 ∈ A2},

gegeben {X1 = a1}

definiert als

P(X1 = a1, X2 ∈ A2)

P(X2 ∈ A2 | X1 = a1) :=

.

P(X1 = a1)

14

Die Verteilung P(X2 ∈ · | X1 = a1)

heißt die bedingte Verteilung von X2, gegeben {X1 = a1}.

15

Definieren wir Übergangswahrscheinlichkeiten durch

Pa1 (X2 ∈ A2) := P(X2 ∈ A2 | X1 = a1)

dann bekommen wir die schon aus der vorigen Vorlesung

vertraute Dreiheit zurück:

P(X1 = a1, X2 ∈ A2) = P(X1 = a1) Pa1 (X2 ∈ A2).

16

Bei der Untersuchung von zwei Zufallsvariablen X1, X2

kann man immer

zu einer 2-stufigen Betrachtungsweise übergehen.

Man kann dabei wählen,

ob man X1 in die erste Stufe aufnimmt oder in die zweite.

17

Beispiel: Addieren von unabhängigen ZV’en

– zweistufig aufgefasst

X1 := Y , X2 := Y + Z

P(X1 = a, X2 = b)

= P(Y = a, a + Z = b)

= P(Y = a) P(a + Z = b) = P(X1 = a) P(Z = b − a)

Dies führt zu den Übergangswahrscheinlichkeiten

P (a, b) := P(Z = b − a)

18

P(Y + Z = b) =

X

a

P(Y = a) P(Z = b − a)

Beispiel

Y , Z unabhängig und Geom(p)-verteilt

P(Y + Z = b) =

=

b−1

X

pq a−1pq b−a−1

a=1

(b − 1)p2q b−2, b

= 2, 3, . . .

Die negative Binomialverteilung mit Parametern 2, p

ist die Verteilung der Anzahl der Versuche

in einem p-Münzwurf bis einschließlich zum zweiten Erfolg.

19

P(Y = a, Y + Z = b = P(Y = a) P(a + Z = b)

Fazit:

Die bedingte Verteilung von Y + Z, gegeben {Y = a},

ist gleich der Verteilung von a + Z.

Was ergibt sich für die bedingte Verteilung von Y ,

gegeben {Y + Z = b}?

“Wie war der erste Schritt?”

20

Die bedingte Verteilung von Y , gegeben Y + Z = b, ist

P(Y = a) P(Z = b − a)

.

P(Y = a | Y + Z = b) =

P(Y + Z = b)

21

Ein instruktiver Spezialfall:

Y und Z seien unabhängig und Geom(p)-verteilt. Dann ist

P(Y = a) P(Z = b − a) = q a−1p q (b−a)−1p = p2q b−2 .

Dieses hängt nicht von a ab.

Also ist die bedingte Verteilung

die uniforme auf {1, . . . , b − 1}

22

Das ist auch ohne Rechnung plausibel:

Gegeben, dass in einem p-Münzwurf

der zweite Erfolg beim b-ten Versuch kommt,

ist der Zeitpunkt des ersten Erfolges

uniform verteilt auf {1, . . . , b − 1}.

23

Alte Regeln (für zweistufige Experimente) im neuen Gewand:

Formel für die totale Wahrscheinlichkeit:

P(X2 ∈ A2) =

X

a1∈S1

P(X1 = a1)P X2 ∈ A2 | X1 = a1

24

Bedingter Erwartungswert von h(X1, X2),

gegeben {X1 = a1}:

h

:=

X

i

E h(X1, X2) | X1 = a1

h(a1, a2) P X2 = a2 | X1 = a1

a2∈S2

Bedingte Erwartung von h(X1, X2), gegeben X1:

h

i

E h(X1, X2) | X1 = e(X1),

mit

h

i

e(a1) := E h(X1, X2) | X1 = a1 .

25

Definition.

Seien E1, E2 Ereignisse. Dann ist die

bedingte Wahrscheinlichkeit von E2, gegeben E1,

definiert als

P(E2 ∩ E1)

P(E2 | E1) :=

= P(IE2 = 1 | IE1 = 1)

P(E1)

. . . die Wahrscheinlichkeit von E2, wenn man schon weiß,

dass E1 eingetreten ist.

26

Beispiel:

Gedächtnislosigkeit der geometrischen Verteilung:

P(T > k + l | T > k) = q k+l /q k = q l .

Die Kenntnis, dass T einen Wert größer als k annimmt,

ändert also die Verteilung für die “restliche Wartezeit” nicht.

P(T − k > l | T > k) = P(T > l)

27

Zweistufigkeit - Spieß umgedreht:

1 =a1)P(X1 =a1)

P(X1 = a1 | X2 = a2) = P(X2=a2P| X

(X2 =a2)

Formel von Bayes

P(X1 = a1 | X2 = a2) =

PP(X2 =a2 | X1 =a1)P(X1 =a1)

b∈S1 P(X2 =a2 | X1=b)P(X1 =b)

′ | E)P(E)

P

(E

P(E | E ′) =

P(E ′ | E)P(E) + P(E ′ | E c)P(E c)

28

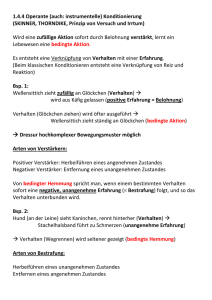

Beispiel: Reihenuntersuchungen:

Eine kranke Person wird in 100% der Fälle positiv getestet,

eine gesunde Person in 1%.

Wie groß ist die Wahrscheinlichkeit, dass eine positiv

getestete Person wirklich krank ist?

Der Prozentsatz der kranken Personen sei 0.1% .

P(E) = 0.001, P(E ′ | E) = 1, P(E ′ | E c) = 0.01.

Bayes: P(E | E ′) = 0.091.

Die Wahrscheinlichkeit, bei positivem Testbefund wirklich krank zu sein,

liegt also bei nur 9%!

29

0.999

g

0.01

0.001

k

p

1

0.001 · 1

P(X1 = k, X2 = p)

=

P(X2 = p)

0.999 · 0.01 + 0.001 · 1

1

≈

11

30