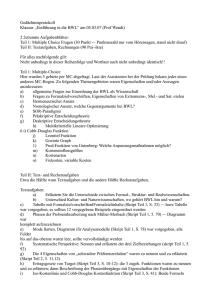

Nebenläufige Programmierung - Goethe

Werbung