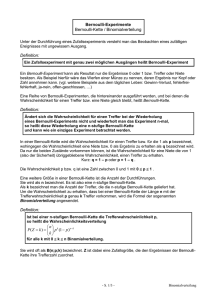

Statistik II Induktive Statistik - Ruhr

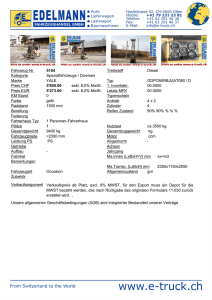

Werbung