Ein Leitfaden zu cloudbasierten HPC-Lösungen und Big Data

Werbung

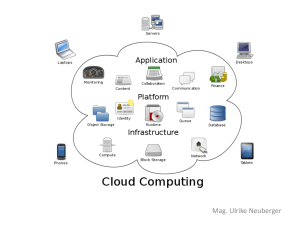

Ein Leitfaden zu cloudbasierten HPC-Lösungen und Big Data-Analysen Ein Leitfaden zur Hochleistungsdatenverarbeitung (HPC) „Die HPC-Community hat ein seit langem bestehendes Interesse an der Erstellung von Umgebungen mit horizontaler Skalierung zum Ausführen von durchsatzorientierten und parallel verwalteten Rechenlasten. Sowohl große Umgebungen (z. B. Cloud-Computing-Einrichtungen) als auch Rechenlasten mit horizontaler Skalierung (z. B. Big Data) werden immer wichtiger im Unternehmen. Mit dem Zuwachs an Big Data sowie dem Aufkommen von erschwinglichen, leistungsstarken Clustern und Strategien, die CommoditySysteme für Anwendungen mit horizontaler Skalierung nutzen, schaut die Enterprise-Datenverarbeitungsumgebung heute stark nach HPC aus.“ – Andrew Nelson, VMware bei VMworld 2014* * VMworld 2014: Virtualized HPC as a Service, Andrew Nelson, Referent. http://www.youtube.com/watch?v=ssAOdZehULU. 2 Mit der Nutzung von Big Data liefert Dell Cloud Solutions Antworten auf viele Fragen von Unternehmen und Forschern. HPC hilft beim Entwerfen, Testen und Fliegen von Flugzeugen, bevor sie physisch gebaut werden. Wir können gefährliche Wetterkonstellationen simulieren und Leben retten, indem wir Frühwarnsysteme erstellen. Wir können sogar virtuelle Crash-Tests für Automobile durchführen, mit Wänden voller Monitore und Computeralgorithmen. Die Hochleistungsdatenverarbeitung (High Performance Computing, HPC) ist inzwischen zum Rückgrat der Wissenschaft und Produktentwicklung geworden. Diese bahnbrechende Datenverarbeitungsleistung ist ein absolut unerlässliches Tool für Wissenschaftler, Akademiker und moderne Forscher. Überall auf der Welt verwenden IT-Abteilungen cloudbasierte HPCLösungen von Dell Services, um eine maximale Datenverarbeitungsleistung durch die Nutzung von standardbasierten getesteten und validierten Technologien zu ermöglichen. Geschäftszweigen erschwingliche HPCTools und strategische Vorteile. Der Ansatz von Dell Services für Hochleistungsdatenverarbeitung Dell ist sich der Tatsache bewusst, dass jeder Kunde einzigartige Bedürfnisse und Anforderungen hat. Unser individuell angepasster HPC-Ansatz ist auf drei Bereiche ausgerichtet, um Folgendes zu ermöglichen: Schnellere Erzielung von Ergebnissen durch Unterstützung von Forschungasktivitäten und Fördern der Entwicklung geistigen Eigentums mithilfe von Bare-Metal-Systemen. Cloudbasierte Bare-Metal-Konfigurationen, virtualisierte cloudbasierte Lösungen, die AWS oder Google Cloud Platform verwenden. Wir bieten einen Mehrwert, indem wir hoch flexible Bedingungen, Support und Dell Cloud Manager für Google und Amazon Web Services (AWS) für hybrides CloudManagement bieten. Dell Cloud Manager Auf diese Weise können sich visionäre Wissenschaftler weltweit auf ihre Arbeit konzentrieren: Entdeckungen machen, die die Welt verändern. HPC-Technologie jetzt für jeden erschwinglich Bis vor Kurzem war die Hochleistungsdatenverarbeitung noch ausschließlich Spezialisten mit entsprechend teuren, proprietären Systemen vorbehalten. Mittlerweile bieten Commodity-basierte Infrastrukturlösungen und cloudbasierte Lösungen allen Forschungsorganisationen oder Dell Cloud Manager ist Software zur Verwaltung von Cloud-Infrastrukturen, die Ihnen dabei hilft, den Verbrauch Ihrer Cloud-Services zu verwalten und gleichzeitig Enterprise-Anwendungen in der Cloud bereitzustellen und zu verwalten. Cloud Manager stellt eine Verbindung zu Ihren bestehenden CloudKonten her und bietet eine einheitliche zentrale Verwaltungskonsole, über die Sie alle Aktionen innerhalb der Cloud Ein Leitfaden zur Hochleistungsdatenverarbeitung (HPC) steuern können. Cloud Manager bietet die sichere Verwaltung Ihrer CloudRessourcen, einschließlich differenzierter rollenbasierter Zugriffssteuerungen und Budgetkontrollen für alle Ressourcen, mit der Fähigkeit, Quoten zur Beschränkung von Budgets festzulegen. Bestehende GovernanceRichtlinien können über unsere Anwendungsprogrammierschnittstelle (API), Schlüsselverwaltung und Verschlüsselung auf einfache Weise auf die Cloud erweitert werden, einschließlich Integration in Lightweight Directory Access Protocol (LDAP), Active Directory und Security Assertion Markup Language (SAML). Und die zentralisierte Verwaltung von Ressourcen über alle Clouds oder Cloud-Konten hinweg macht die Überwachung und Berichterstattung wesentlich einfacher als die Nachverfolgung in verteilten Systemen. Sicherheit Cloudbasierte HPC- und Big DataAnalysen von Dell sind sicher. Wir arbeiten mit jedem Kunden zusammen, um diese Probleme zu beheben und für die Sicherheit ihrer Daten zu sorgen. Sichere Datenmigration R Systems kann Daten vom Datenträger oder Band laden. Die Zusammenarbeit mit Google stellt eine ausgezeichnete Methode dar, um große Datenmengen global über Googles Dark-Fiber-Backbone zu verschieben. Datenmigration an Amazon Web Services (AWS) kann mithilfe unterschiedlicher Methodologien erreicht werden. 3 Beantwortete Fragen zur HPC-Technologie von Dell Probleme Wahrnehmung Überlastung der Datenverarbeitungsressourcen bei saisonalen Nachfragespitzen • Negative Kundenerfahrung aufgrund von langsamen Reaktionszeiten der Webseite • An Wettbewerber entgangene Geschäftsabschlüsse • Systemausfälle belasten IT-Personal aufgrund von überlasteten ServerRechenlasten Zeitaufwendige Bereitstellung von IT-Ressourcen • Verzögerte Markteinführungszeit für Anwendungen reduziert den Wettbewerbsvorteil • Vom Unternehmen wahrgenommene Ineffizienzen von IT-Mitarbeitern Schwache Nutzung von virtualisierten Servern Einfrierung oder Kürzungen von ITInvestitionen Cloudbasierte Hochleistungsdatenverarbeitung von Dell • Schnelles Erhöhen oder Reduzieren der Kapazität • Senkung der anwendungsbezogenen Betriebskosten • Schneller Zugriff auf alternative Rechenzentrumsressourcen, wenn zusätzliche Kapazitäten erforderlich sind • Automatisierung wichtiger Bereitstellungsaufgaben • Ermöglichen der Self-ServiceBereitstellung von Servern durch die Geschäftsendbenutzer • Hohe Infrastrukturkosten, die dem Unternehmen in Rechnung gestellt werden oder sich direkt auf das CIOBudget auswirken • Schnellere Anwendungsbereitstellung • Suboptimale Preise/Leistung der Datenverarbeitung • Minimieren von vorab anfallenden Investitionsanforderungen und Risikoressourcen • Unflexible Infrastruktur erfordert Images zur Wahrung der Konsistenz • Begrenzte Funktionen verhindern eine dynamische Neuzuordnung • Verwaltungs- und Überwachungstools zur automatischen Neuzuweisung der Leistung und Nutzung von Serverbereitstellungen • U nfähigkeit, neue Server und Storage zu beschaffen, um die Datenverarbeitungsanforderungen zu erfüllen • Hilft Ihren Kunden beim Übergang von einem Investitionskosten- zu einem Betriebskostenmodell • Fehlende Geldmittel zur Untersuchung neuer Technologien, die zu einem Wettbewerbsvorteil führen können • Nutzen von öffentlichen CloudRessourcen zur Bereitstellung größerer Rechenzentrumskapazitäten und/oder zur Notfall-Wiederherstellung • Verlagerung der Kosten-NutzenEntscheidungen auf das Unternehmen • Ermöglicht Ressourcenumverteilung von betriebsbezogenen Aufgaben auf strategische Geschäftsziele • Förderung der Umweltagenda durch erhöhte Energieeffizienz im Rechenzentrum Leistungsstarke Maximierung der Rechenressourcen • Datenverarbeitungsressourcen sind kostenintensiv und erfordern hohe Investitionen und einen hohen Wartungsaufwand Ein Leitfaden zur Hochleistungsdatenverarbeitung (HPC) • Profitieren von den Vorteilen einer leistungsstarken und schnellen Datenverarbeitung ohne Ausgaben • Fokus auf das eigentliche Geschäft, nicht auf die Wartung von Hardware 4 Dell Bare-Metal-Hochleistungsdatenverarbeitung mit R Systems Dell HPC Cloud mit R Systems Service wurde für die Bereitstellung einer sicheren, privaten Cloud-Umgebung entworfen, gehostet und verwaltet von Dell und R Systems, einem HPC Solutions Partner. Die HPCInfrastruktur besteht aus Dell Kapazitäten für Verarbeitung, Leistung, Storage und Speicher. R Systems bietet einwandfreie HP Services mit benutzerdefinierten Lösungen an von Ihnen gewünschten Standorten, einschließlich unternehmenseigenen Rechenzentren in Champaign, Illinois, an der Universität von Illinois Research Park. R Systems bietet vollständige hardwarebasierte Dell Systeme sowie kundenspezifische Projekte/ Konfigurationen basierend auf individuellen Geschäftsanforderungen. Dell Bare-MetalService ist nur in Nordamerika verfügbar. • Große Kern-Cluster mit der Option einer Infiniband-Verbindung • Große Speicherkonfigurationen, verfügbar für speicherintensive Rechenlasten • Benutzersupport für alle Wissensebenen (von Anfänger bis erfahren) Umfang dieses Service • Unterstützen von Forschern und verbesserte Zusammenarbeit Wenn Sie ein Forschungs- oder Geschäftsunternehmen sind, das vertrauliche Daten oder Hochleistungsanwendungen bei einem Cloud-Anbieter hosten möchte, benötigen Sie architektonische Optionen, die nicht über standardmäßige öffentliche oder mandantenfähige Cloud-Services verfügbar sind. Unser Service bietet eine höhere Flexibilität als die öffentliche Cloud, da er Ihre Fähigkeit zum Betreiben von Produktionsrechenlasten verbessert, die anderenfalls auf den maßgeschneiderten VorOrt-Betrieb in einer gehosteten privaten Cloud begrenzt wäre. Serviceumfang: • Individuell anpassbare Burst-Kapazität oder kurzfristige HPC-Kapazität, die als Betriebsausgabe in 24-Stunden-Schritten bereitgestellt wird. • Anpassbare Sicherheit für öffentliche und private Cloud • Einfach einzurichtender Zugriff • Verfügbar für Linux und Windows • Fundierte Erfahrung mit einer Vielzahl von unabhängigen Softwareanbietern (ISV), wie z. B. ANSYS, CD- adapco, Milliman und Simulia Vorteile: • Niedrige technische Barriere zur Hochleistungsdatenverarbeitung über Burst-Modelle • Eine einzige Schnittstelle für mehrere Cluster verwenden. Die Bursting-Fähigkeit Öffentliche Cloud-Ressourcen helfen Ihnen beim: • Beheben von sporadischen Verarbeitungsspitzen, die die lokale Kapazität übersteigen. • Verwenden von mehreren Beriebssystemen und Anwendungen. Hosting und Verwaltung • Domänenspezifisch (z. B. eine GenomCloud) für Forscher, die: • Ihre Daten, die Daten ihrer Mitarbeiter und Referenzdaten an einem zentralen Standort zur Verarbeitung haben möchten. • Zugriff auf Hochleistungsdatenverarbeitung benötigen. • Intensivieren der Nutzung von CloudRessourcen in Institutionen • Nutzungsbasierte Bezahlung für Ressourcen durch On-Demand-CloudComputing • Reduzieren des Kapitaleinsatzes und der Gesamtbetriebskosten (TCO) • Nutzen der Agilität und der Effizienzen der Cloud • Profitieren von einem ausgezeichneten Benutzersupport mit erstklassig ausgebildeten und erfahrenen Technikern von R Systems Die Services Wenn Sie eine private Cloud über bestehende individuelle Cluster erstellen, können Sie: • Ressourcen zusammenlegen. • Ungenutzte Zyklen auf separaten Clustern freigeben. Ein Leitfaden zur Hochleistungsdatenverarbeitung (HPC) Weitere Informationen zu R Systems und deren „White Glove“-Ansatz für Hochleistungsdatenverarbeitung finden Sie unter Dell bare metal hpc auf youtube.com 5 Google Cloud Platform Google Cloud Platform basiert auf 14 Jahren Erfahrung, in denen Google die schnellste, leistungsstärkste und hochwertigste CloudInfrastruktur auf dem Planeten geschaffen hat. Google unterstützt Google – und das bedeutet einige der größten, hochverfügbarsten Softwareprodukte, die jemals entwickelt wurden. Mit der Cloud-Plattform können auch Sie von dieser Leistung profitieren. Durch Verwendung der Cloud-Plattform nutzen Sie die gleiche Infrastruktur, die Google zur Ausführung von kritischen Aufgaben verwendet, wie z. B. Suchvorgänge, Dokumente und Gmail. Falls Sie dieses Angebot noch nicht kennen – es ist extrem einfach strukturiert. Es werden eine Vielzahl von Methoden zur effektiven Durchführung von Datenverarbeitungsaufgaben bei hoher Skalierung, Speicherung von Daten und Entwicklung von Software zur Verfügung gestellt. Google Cloud Platform besitzt die Fähigkeit, Daten innerhalb von Millisekunden zu verarbeiten. Google Cloud Platform besteht aus einer Reihe von Produkten, je jeweils eine Webschnittstelle, ein Befehlszeilentool und eine REST-API umfassen. • Google App Engine ist eine Platformas-a-Service-Komponente für isolierte Webanwendungen. App Engine ermöglicht eine automatische Skalierung, indem Ressourcen entsprechend der Serverlast erhöht werden. • Google Compute Engine ist die Infrastructure-as-a-Service-Komponente von Google Cloud Platform, die es Benutzern ermöglicht, virtuelle Maschinen (VMs) bei Bedarf zu starten. • Google Cloud Storage ist ein OnlineStorage-Service für Dateien. • Google Cloud Datastore ist ein vollständig verwalteter, hoch verfügbarer NoSQL-DatenStorage für nicht-relationale Daten, der eine REST-API umfasst. • Google Cloud SQL ist eine vollständig verwaltete MySQL-Datenbank, die in der Google Cloud-Infrastruktur enthalten ist. • Google BigQuery ist ein Datenanalysetool, das SQL-ähnliche Fragen zum Verarbeiten von großen Datensätzen in Sekunden verwendet. • Google Cloud Endpoints ist ein Tool zum Erstellen von Services innerhalb von App Engine, das auf einfache Weise über iOS, Android und JavaScript-Clients verbunden werden kann. Google Cloud DNS ist ein Domain Name System (DNS)-Service, der in der Google Cloud-Infrastruktur gehostet wird. Ein Leitfaden zur Hochleistungsdatenverarbeitung (HPC) Beispielsweise bietet Google Genomics eine API zum Speichern, Verarbeiten, Untersuchen und Freigeben von DNA-Sequenz-Lesevorgängen, referenzbasierten Alignments und Variant Calls über die Cloud-Infrastruktur von Google. Google Genomics hilft Forschern bei folgenden Aufgaben: • Speichern von Alignments und Variant Calls für einen oder eine Million Genome • Stapelweise Verarbeitung von Genomdaten durch die Ausführung einer prinzipalen Komponentenanalyse oder eines HardyWeinberg-Gleichgewichts, in Minuten oder Stunden, indem parallele ComputingFrameworks wie MapReduce verwendet werden. • Untersuchen von Daten durch die Segmentierung von Alignments und Varianten nach Genombereich über ein oder mehrere Muster hinweg – für Ihre eigenen Algorithmen oder zur Visualisierung. Sie können mithilfe von BigQuery auch ganze Gruppen verarbeiten, um Transitions-/ Transversionsverhältnisse, allelische Frequenzen, genomweite Zuordnungen usw. zu ermitteln. • Freigeben von Genomdaten an Ihre Forschungsgruppe, Ihre Mitarbeiter, der breiten Community oder der Öffentlichkeit. Sie haben die Wahl. 6 Google Genomics implementiert die von der Global Alliance for Genomics and Health definierte API für Virtualisierung, Analyse usw. Über kompatible Software kann auf Google Genomics, lokale Server oder sonstige Implementierungen zugegriffen werden. Aus einer geschäftlichen Perspektive aus betrachtet analysiert die Lösung Big Data, um einen Überblick über Data Warehouses oder andere Speicherorte zu erlangen, an denen sich die Daten befinden. Google Cloud Plattform ist ein Payas-you-go-Service. BigQuery wird projektbasiert abgerechnet, wodurch Geschäftsbereiche einfach verrechnet werden können. Google bietet einen Preisrechner, der die Kosten in Verbindung mit Google Cloud Platform veranschaulicht. Dell Cloud Manager ist Voraussetzung für die Verwendung von Google Cloud Manager. Es ist eine umfassende Präsentation zu Google Cloud Manager und Dell verfügbar. C3-Instanzen bieten Ihnen im Vergleich zu allen anderen Amazon EC2-Instanzen die Prozessoren mit der höchsten Leistung und dem niedrigsten Preis pro Datenverarbeitungsleistung. I2-Instanzen sind für äußerst E/Aintensive Rechenlasten konzipiert. Der größte I2-Instanzentyp kann über 365.000 zufällige Lesevorgänge pro Sekunde und über 315.000 zufällige Schreibvorgänge pro Sekunde liefern. AWS empfiehlt die Verwendung von C3-Instanzen für rechenintensive Anwendungen und I2-Instanzen für transaktionale Systeme. Google Cloud Platform Datenverarbeitungslösungen • Compute Engine: Ausführen von großen Rechenlasten auf virtuellen Maschinen mithilfe von Infrastructure-as-a-Service (IaaS) • App Engine: Einfaches Entwickeln Ihrer Anwendungen mithilfe von integrierten Services in Ihrem Platform-as-aService-Tool StorageLösungen • Cloud SQL: Speichern und Verwalten von Daten mithilfe einer vollständig verwalteten, relationalen MySQL-Datenbank • Cloud Storage: Verwenden eines beständigen und hoch verfügbaren Objektspeicherservice • Cloud Datastore: Bietet eine verwaltete schemalose NoSQLDatenbank zum Speichern von nicht-relationalen Daten Ein Leitfaden zur Hochleistungsdatenverarbeitung (HPC) Big DataLösungen • BigQuery: Analysieren von Big Data in der Cloud. Senden von schnellen SQL-Abfragen an Datensätze mit mehreren Terabyte in Sekunden. EntwicklerTools • Cloud SDK: Enthält Tools und Bibliotheken, mit denen Sie Ressourcen in unserer Cloud-Plattform erstellen und verwalten können • Push to Deploy: Verwenden des Git-Version-Kontrollsystems zur automatischen Bereitstellung Ihrer Anwendung in unserer App Engine • Cloud Playground: Ausführen von Services wie App Engine, Cloud Storage und Cloud SQL über Ihren Browser • Android Studio: Hinzufügen unserer Cloud-Plattform als Backend zu Ihrer Anwendung – direkt über Android Studio IDE • Plugin für Eclipse: Bietet Tools, API-Unterstützung und einfache Bereitstellung für App Engine Java-Entwicklern. 7 Amazon Web Services – Hochleistungsdatenverarbeitung Uneingeschränkte Infrastruktur Niedrige Kosten bei flexiblen Preisen Beschleunigte Bereitstellung von Lösungen TOP500: Platz 76 der schnellsten bedarfsorientierten Supercomputer Effiziente Cluster Hun 2014 Liste der Top 500 484,2 FLOPS 26,496 Kerne in einem Cluster von EC2 C3 Instanzen Intel Xeon E5-2680v2 10C Prozessoren mit 2,800 GHz LinPack Benchmark Verstärkte Kooperation Datenverarbeitungsservices Elastic Compute Cloud (EC2) Basiseinheit der Datenverarbeitungskapazität, CPUBereiche virtueller Maschinen. Auswahl c3 8x groß von Arbeitsspeicher- und lokalen g2. mittel Festplattenoptionen von Instanztypen, m3. groß von Mikro- bis Clustercomputer Gleichzeitige bedarfsorientierte Cluster Amazon Web Services ist eine Lösung zum Beheben von komplexen wissenschaftlichen, technischen und geschäftlichen Problemen anhand von Anwendungen, die eine hohe Bandbreite, Netzwerke mit niedriger Latenz und sehr hohen Datenverarbeitungsfähigkeiten erfordern. Mit Amazon Web Services können Forschungaktivitäten durch Ausführung von Hochleistungsdatenverarbeitung in der Cloud und Kosten reduziert werden, indem Cluster-Datenverarbeitung oder Cluster-GPU-Server bedarfsgemäß und ohne große Anfangsinvestitionen bereitgestellt werden. Der Zugriff auf ein Netzwerk mit hoher Bandbreite für eng aneinander gekoppelte E/O-intensive Rechenlasten ermöglicht Ihnen die Skalierung von Tausenden von Kernen für durchsatzorientierte Anwendungen. Hochleistungsdatenverarbeitung (HPC) unter Amazon Elastic Ein Leitfaden zur Hochleistungsdatenverarbeitung (HPC) Compute Cloud (EC2) wird durch die Cluster-Computing-optimierten and GPU-Instanztypen (virtuellen Maschinen) ermöglicht. Sie können sie genauso wie andere EC2Instanzen verwenden, doch wurden sie speziell zur Bereitstellung von Hochleistungsnetzwerken entwickelt, sodass bei Bedarf auf Tausende von Instanzen skaliert werden kann. 8 GPU-Instanzen eignen sich hervorragend für Folgendes: • Grafische Anwendungen zur Hochleistungsdatenverarbeitung, einschließlich 3D-Modellierung und -Simulation • Datenverarbeitungs-Rechenlasten, einschließlich Computerchemie, Finanzanalysen und technisches Design • Allgemeiner Zweck der GPUDatenverarbeitung GPU-Instanzen von Amazon Web Services bieten Zugriff auf NVIDIA-GPUs, jeweils mit bis zu 1.536 Compute Unified Device Architecture (CUDA)-Kernen und 4-GB-Videospeicher. Mit den neuesten Treiberversionen bieten diese GPUs Unterstützung für OpenGL, DirectX, CUDA, OpenCL und GRID SDK. Cluster-Gruppen können in einer Platzierungsgruppe gestartet werden. Alle innerhalb einer Platzierungsgruppe gestarteten Instanzen haben eine niedrige Latenz, volle Halbierung und 10 Gbit/s Bandbreite zwischen Instanzen. Platzierungsgruppen sind wie viele andere Amazon EC2Ressourcen dynamisch und bei Bedarf flexibel skalierbar. Sie können auch mehrere Platzierungsgruppen miteinander verbinden, um sehr große Computing Cluster für eine massive parallele Verarbeitung zu erstellen. AWS unterstützt derzeit erweiterte Netzwerkfunktionen mithilfe von Single-Root-E/A-Virtualisierung (SR-IOV) für die C3- und I2Instanztypen. SR-IOV ist eine Methode der Gerätevirtualisierung, die eine höhere E/A-Leistung und niedrigere CPU-Auslastung im Vergleich zu herkömmlichen Implementierungen bietet. Für unterstütze Amazon EC2Instanzen bietet diese Funktion eine höhere PPS-Leistung, eine niedrigere Latenz zwischen Instanzen und minimale Netzwerkschwankungen. AWS bietet zahlreiche Preismodelle zur Unterstützung unterschiedlicher Rechenlasten, wie z. B. „Bedarfsorientiert“, „Reserviert“, „Kassapreis“ und „Dediziert“. Erhalten Sie weitere Informationen zur cloudbasierten Hochleistungsdatenverarbeitung von HPC. Klicken Sie hier, um eine vollständige Einführung in Amazon Web Services zu lesen. Viele Preismodelle zur Unterstützung unterschiedlicher Rechenlasten Bedarfsorientiert Reserviert Kassapreis Dediziert Zahlen Sie nur für die pro Stunde genutzte Datenverarbeitungskapazität ohne langfristige Verpflichtungen. Tätigen einer niedrigen einmaligen Zahlung und Erhalten eines bedeutenden Preisnachlasses auf die stündlichen Gebühren Bieten auf ungenutzte Kapazität, verrechnet zu einem Kassapreis, der basierend auf Angebot und Nachfrage fluktuiert Starten von Instanzen mit Amazon VPC auf Hardware, die für einen einzelnen Kunden dediziert ist Für Rechenlasten mit Spitzenlasten oder zum Definieren von Anforderungen Für eine feste Nutzung Für zeitintensive oder vorübergehende Rechenlasten Für hochsensible oder Compliance-bezogene Rechenlasten Ein Leitfaden zur Hochleistungsdatenverarbeitung (HPC) 9 Dell Partner-Garantie Dell ist sich bewusst, dass Cloud-Preise veränderlich sind. Und wenn der Preis einer Komponente des von einem Partner bereitgestellten Service fällt, spiegeln sich diese Kosteneinsparungen umgehend in Ihrer Rechnung wider. Unabhängig davon, welche Partner verwendet werden, erhalten Sie alle 30 Tage eine einzige Rechnung über die genutzten Dell Services. Bietet das umfangreichste Cloud-Ökosystem der Branche Globale Präsenz Mehrere CloudPlattformen Proprietär | Microsoft | VMware | OpenStack | CloudStack Die bekanntesten Anwendungsfälle Vertikale Anwendungen | NotfallWiederherstellung | ERP und CRM | Webinfrastruktur mit horizontaler Skalierung| Testen und Entwicklung| Produktivitätsanwendungen | Datenverarbeitungsanalyse Dell Cloud Services vor Ort und dedizierte Services Weitere Informationen zu den Service-Angeboten finden Sie unter Dell.com/services oder beim zuständigen Dell Mitarbeiter. Scannen Sie diesen Code oder klicken Sie darauf, um zu erfahren, wie Dell Services Ihr Unternehmen unterstützen kann. Die Verfügbarkeit der Produkte und Services ist je nach Land unterschiedlich. Weitere Informationen erhalten Kunden und Dell Channel-Partner von dem für sie zuständigen Vertriebsmitarbeiter. Alle Angaben sind zum Zeitpunkt der Veröffentlichung korrekt, können jedoch jederzeit ohne Vorankündigung geändert werden und unterliegen der Verfügbarkeit. Dell und Tochterunternehmen von Dell haften nicht für Druckfehler, fehlerhafte Abbildungen oder Auslassungen. Es gelten die allgemeinen Verkaufs- und Servicebedingungen von Dell, die auf Anfrage erhältlich sind. Dell und das Dell Logo sind Marken von Dell Inc. Alle anderen in diesem Dokument verwendeten Marken und Handelsnamen stehen entweder für den jeweiligen Eigentümer oder für dessen Produkte. Dell erhebt keinerlei Anspruch auf Eigentumsrechte an den Marken und Handelsnamen Dritter. © 2014 Dell Inc. Alle Rechte vorbehalten. Oktober 2014 | D468-A Guide to HPC Cloud based solutions.indd | Rev. 1.0