Verwaltung von Zeitreihen in datenbank-basierten

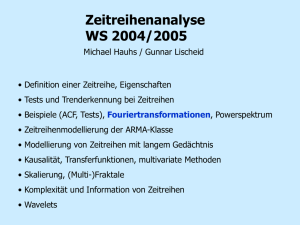

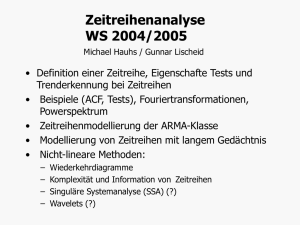

Werbung

FRIEDRICH-SCHILLER-UNIVERSITÄT JENA

Chemisch-Geowissenschaftliche Fakultät

Institut für Geographie

Verwaltung von Zeitreihen

in datenbank-basierten Informationssystemen

am Beispiel von RBIS

(River Basin Information System)

Diplomarbeit

eingereicht von Franziska Zander

geb. am 14. August 1982 in Karl-Marx-Stadt jetzt Chemnitz

Gutachter: Prof. Dr. Wolfgang-Albert Flügel

Dr. Sven Kralisch

November 2007

Danksagung

Ich möchte mich an dieser Stelle bei allen Personen herzlichen bedanken, die mich

während meiner Diplomarbeit unterstützt haben.

Insbesondere danke ich Dr. Sven Kralisch, der mein Interesse für das Datenbankumfeld

sowie die Anwendungsentwicklung weckte und förderte, diese Diplomarbeit fachlich

betreute und mir stets beratend zur Seite stand.

Bedanken möchte ich mich ebenfalls bei Prof. Dr. Wolfgang-Albert Flügel, an dessen

Lehrstuhl ich diese Arbeit verfassen durfte und allen Mitarbeitern des Lehrstuhls für

Geoinformatik, Geohydrologie und Modellierung für ihre Unterstützung.

Mein Dank gilt auch den Mitarbeitern des Lehrstuhls für Datenbanken und

Informationssysteme in Jena für die abwechslungsreiche Ausbildung in meinem

Nebenfach Informatik.

Bei Thomas Erb, Christian Fischer, Torsten Sauer und meinem lieben Freund Thomas

Meyer möchte ich mich für die vielen Denkanstöße und das Korrekturlesen bedanken.

Ebenfalls möchte ich meinen Eltern danken, die mir das Studium und damit auch diese

Diplomarbeit erst ermöglicht haben.

Inhaltsverzeichnis

Verzeichnisse

Abkürzungsverzeichnis

Abbildungsverzeichnis

III

III

IV

1 Einführung und Problemstellung

1

2 Grundlagen

4

2.1 Einordnung von RBIS

2.1.1 IWRM – Integrated Water Resources Management

2.1.2 AIDIS – Adaptive Integrated Data Information System

2.1.3 RBIS – River Basin Information System

2.2 Datenhaltung und -verwaltung

2.2.1 Informationssystem

2.2.2 Datenhaltung und Anwendung

2.2.3 Einsatz von Open-Source

2.3 Meta- und Zeitreiheninformationssysteme

2.3.1 Metadaten für räumliche Informationen

2.3.1.1 Metadatenstandards

2.3.1.2 Metadateneditoren

2.3.1.3 Metainformationssysteme für Geodaten

2.3.2 Verwaltung von raum-zeitlichen Informationen

2.3.2.1 Standards für Zeitreihen und Sensoren

2.3.2.2 Zeitreiheninformationssysteme

2.4 Zeitreihen und Datenlücken

2.4.1 Zeitreihenarten

2.4.2 Ursachen für Datenlücken in Zeitreihen

2.4.3 Umgang mit Datenlücken

2.4.4 Interpolationsverfahren

2.4.4.1 Zeitliche Interpolationsverfahren

2.4.4.2 Räumliche Interpolationsverfahren

3 Metadaten- und Zeitreihenverwaltung in RBIS

3.1 Datenbankschema

3.2 Grundlegende interne Funktionsweise

3.2.1 XML-Dokumente

3.2.2 Sicherheit

3.2.3 Datenintegrität

3.3 Funktionsumfang aus der Sicht der Anwender

3.4 Aktueller Datenbestand im RBIS-IMTIS

3.5 Anforderungen für zukünftige Erweiterungen

4 Verwaltung und Interpolation von Zeitreihen in RBIS

4.1 Problemstellung und Ausgangssituation

4

4

5

6

7

7

8

10

12

13

13

15

16

18

18

21

22

23

24

25

26

26

28

32

33

35

35

37

38

39

40

41

42

42

I

4.2 Metadaten über Zeitreihen

4.2.1 Anpassung des Datenmodells für die Verwaltung

4.2.2 Erweiterung des Import-Formulares

4.2.3 Überarbeitung der Upload-Funktion

4.2.3.1 Transaktionen

4.2.3.2 Qualitätsprüfung

4.2.3.3 Datenlückenanalyse

4.3 Bereitstellung verschiedener Datenanalysemöglichkeiten

4.3.1 Allgemeine Funktionsweise und Voraussetzungen

4.3.2 Anwendung durch RBIS-Nutzer

4.4 Implementierung und Anwendung verschiedener Interpolationsverfahren

4.4.1 Datenmodell und Datenhaltung

4.4.1.1 Datenmodell für die Metadaten

4.4.1.2 Speicherung der berechneten Werte

4.4.2 Interpolationsvorgang und technische Umsetzung

4.4.2.1 Berechnungsansatz

4.4.2.2 Umsetzung und Ablauf von Interpolationen

4.4.2.3 Implementierte Interpolationsverfahren

4.4.2.4 Prüfen und Korrigieren der interpolierten Messwerte

4.4.3 Anwendung durch RBIS-Nutzer

4.4.3.1 Verwendung interner Verfahren

4.4.3.2 Verwendung externer Verfahren

4.5 Export und Darstellung von Zeitreihendaten

4.5.1 Export

4.5.2 Darstellung

4.6 Einbindung der entwickelten Funktionen in RBIS

4.7 Aufgetretene Probleme

43

44

46

46

47

49

49

51

52

55

58

58

59

60

61

62

63

65

70

71

71

73

74

74

76

78

78

5 Zusammenfassung und Ausblick

80

Anhang A: Datenmodelle

82

DS_Station – konzeptionelles Modell

TS_TimeSeries – konzeptionelles Modell

82

83

Anhang B: XML-Schema von RBIS (rbis.xsd)

84

Anhang C: Auszüge aus dem Quellcode

87

create_query_linear_interpolation()

interpolation_set()

Literatur

87

88

92

II

Verzeichnisse

Abkürzungsverzeichnis

ACID

Atomicity, Consistency, Isolation, Durability

AIDIS

Adaptive Integrated Data Information System

CeGi

Center for Geoinformation GmbH

CEN

Comite Europeen de Normalisation

CSDGM

CSW

Content Standard for Digital Geospatial Metadata

Catalog-Service-Web

DBMS

Datenbank-Management-System

DBS

Datenbanksystem

DCMI

Dublin Core Metadata Initiative

FGDC

Federal Geographic Data Committee

FOSS

GDI-DE

Freie und Open-Source-Software

Geodateninfrastruktur - Deutschland

GeoMIS.Bund

Metainformationssystem für Geodaten des Bundes

GIS

Geoinformationssystem

GWP

Global Water Partnership

IDW

Inverse Distanzwichtung

ILMS

IMTIS

Integriertes Landschafts-Managementsystem

Integrated Metadata (and) Time series Information System

ISO

International Standards Organization Integrated

IWRM

Integrated Water Resources Management

JAMS

Jena Adaptable Modelling System

NOKIS

Nord-Ostsee-Küsten-Informations-System

O&M

OGC

Observation and Measurement

Open Geospatial Consortium

OWS

OGC Web Service

PortalU

Umweltportal Deutschland

RBIS

River Basin Information System

RDBMS

relationale Datenbank-Management-System

SensorML

SWE

Sensor Model Language

Sensor Web Enablement

TRIS

Tisza River Information System

UDK

Umweltdatenkatalog

III

Abbildungsverzeichnis

Abbildung 1: Aufbau von RBIS mit den Anwendungen Metadaten- und

Zeitreihenverwaltung und Kartenserver sowie den Datenbanken .........................................6

Abbildung 2: ISO 19115 Profil für bestimmte Nutzergruppen oder Länder „community

profile“ (Quelle: ISO 19115:2003).......................................................................................14

Abbildung 3: Grundelemente Observation und Event in O&M (Cox 2006:13)..................20

Abbildung 4: Kontinuierliche Zeitreihe mit Lücke..............................................................23

Abbildung 5: Intervall-Zeitreihe mit Lücken.......................................................................23

Abbildung 6: Momentan-Zeitreihe mit Lücke.....................................................................24

Abbildung 7: RBIS-IMTIS: Übersichtsansicht (Metadaten für Zeitreihen)........................32

Abbildung 8: Übersicht zur zentralen Rolle der Metadaten-ID (konzeptionelles Modell)..33

Abbildung 9: Bedeutung von XML-Dokumenten im RBIS-IMTIS....................................35

Abbildung 10: Übersicht XML-Schema von RBIS-IMTIS ................................................36

Abbildung 11: RBIS-IMTIS: Oberfläche zur Rechteverwaltung.........................................37

Abbildung 12: Erfassung aller Schreibenden Zugriffe in Logs...........................................39

Abbildung 13: tägliche Temperaturwerte (Minimalwert (value1), Durchschnittswert

(value2) und Maximalwert (value3)) ..................................................................................41

Abbildung 14: Tabelle „ts_timeser“ (physisches Datenmodell)..........................................49

Abbildung 15: Datenzuverlässigkeitsmodul (physisches Datenmodell)..............................50

Abbildung 16: Import-Formular für Zeitreihendaten...........................................................51

Abbildung 17: Transaktionen innerhalb eines Import (Upload)-Vorgangs.........................53

Abbildung 18: Lücken der Niederschlagszeitreihe Eich......................................................55

Abbildung 19: Beispiel SQL-Abfrage für das in Abbildung 22 dargestellte Suchergebnis 64

Abbildung 20: Benutzerschnittstelle mit Informationen über den Niederschlag an der

Station Frauensee und umliegende Stationen.......................................................................66

Abbildung 21: Darstellung der Lücken für zuvor ausgewählte Stationen...........................68

Abbildung 22: Abfrageergebnis für das Lückenintervall vom 1.2.1993 bis 31.3.1993 der

Zeitreihe „Niederschlag Frauensee“.....................................................................................69

Abbildung 23: Konzeptionelles Datenmodell: Interpolation und Interpolationsvorgang...71

Abbildung 24: Beispiel für Tabelle (calc_504) mit berechneten Werten ...........................74

Abbildung 25: Temporäre Tabelle (temp_113312812) mit dem Zeitstempel (timestamp),

den Mittelwerten der Werte (avg_val) und der Höhe (avg_elevat) und die Höhen (elevat_)

und Werte (value_) der Quellstationen................................................................................92

Abbildung 26: Übersicht der Grenzwerte für Messgrößen und Einheiten...........................94

Abbildung 27: Auswahl einer Zusammenstellung von Interpolationsverfahren..................95

Abbildung 28: Interpolationsregeln für IDW (5-3)..............................................................95

Abbildung 29: Informationen zu einem Interpolationsprozess............................................96

Abbildung 30: Importieren von extern gefüllten Datenlücken............................................97

Abbildung 31: Dateianfang einer exportierten Datei ..........................................................98

Abbildung 32: Übersichtsansicht für die Daten vom Metadatensatz „Niederschlag

Frauensee“..........................................................................................................................101

Abbildung 33: konzeptionelles Modell für DS_Station.....................................................106

Abbildung 34: konzeptionelles Modell für TS_TimeSeries...............................................107

Abbildung 35: XML-Schema von RBIS............................................................................110

Abbildung 36: Quellcode der Funktion: create_query_linear_interpolation()...................111

Abbildung 37: Quellcode der Funktion: interpolation_set()..............................................115

IV

1 Einführung und Problemstellung

1 Einführung und Problemstellung

In den letzten Jahrzehnten haben Naturkatastrophen, Ressourcenmangel und das gestiegene

Umweltbewusstsein des Menschen dazu geführt, dass die Erhebung von umweltbezogenen

Daten verstärkt in das öffentliche und wirtschaftliche Interesse gerückt ist. So werden zum

Beispiel möglichst viele und genaue Messwerte für die Erstellung zuverlässiger

Hochwasservorhersage- oder Klimaprognosemodelle benötigt um sowohl die Folgen für

den natürlichen Haushalt als auch für die Wirtschaft besser abschätzen zu können. In

Bezug auf die lebenswichtige Ressource Wasser können auf der Grundlage von Daten aus

verschiedenen Disziplinen, wie Fernerkundung, GIS-Analysen, Modellierungen und

sozioökonomischen Bewertungen sowie dem Fachwissen aus der Forschung, u. a.

Konzepte für ein Integriertes Wasserressourcen-Management (IWRM) (GWP 2000)

entwickelt und umgesetzt werden. Diese sollen den Umgang mit Wasser zu einem

möglichst großen sozialen und ökonomischen Nutzen fördern. Das IWRM erfordert eine

ganzheitliche Herangehensweise bei der Betrachtung des Wasserkreislaufes und seinen

Wechselwirkungen mit anderen Ressourcen des Ökosystems. Um all diese

Zusammenhänge, Prozesse und Interaktionen erfassen und beschreiben zu können sowie

darauf aufbauend grundlegende Informationen für Entscheidungsträger in Bezug auf ein

IWRM zu schaffen, müssen Daten nicht nur aus vielen verschiedenen Disziplinen

gesammelt, sondern auch integriert ausgewertet werden.

Erfolgte die Erhebung von Daten vor ein paar Jahrzehnten noch manuell, zeichnen heute

meist Datalogger über längere Zeiträume hinweg kontinuierlich erheblich größere Mengen

an Daten auf. Um dieser Datenflut gerecht zu werden, ist es notwendig, geeignete Systeme

und Anwendungen zu entwickeln, die diese verwalten können. Hierbei geht es nicht nur

um ein strukturiertes Abspeichern, sondern viel mehr um die Erhöhung der

Wiederauffindbarkeit und Nutzbarkeit dieser Daten. Zu diesem Zweck müssen zu den

Datensätzen Informationen erfasst werden, welche sie beschreiben. Diese Daten über

Daten (Metadaten) gewannen in den letzten Jahren immer mehr an Bedeutung und sind

heute auch im Bereich der Geowissenschaften ein fester Bestandteil der Aufgabe zur

Beschreibung großer Datenmengen. Um eine einheitliche Erfassung von Metadaten

voranzutreiben und somit den Austausch und eine effiziente Nutzung der Datenbestände zu

ermöglichen, wurden und werden Standards entwickelt. Im Bezug auf geografische

Informationen existiert der ISO-Standard 19115. Die Entwicklung eines Standards für die

Verwaltung von Sensoren und Zeitreihen ist in Vorbereitung, jedoch noch nicht

abgeschlossen. Nicht nur die Verwaltung von großen Datenmengen und Metadaten,

sondern auch der Austausch und die Präsentation von Ergebnissen sind Anforderungen, die

sich aus Forschungsprojekten im Bereich des Integrierten Wasserressourcen-Managements

ergeben. Um diesem gerecht zu werden, können Informationssysteme zum Einsatz

kommen.

1

1 Einführung und Problemstellung

Ein Informationssystem für die Verwaltung von Geodaten und (derzeitig vorrangig)

meteorologischer und hydrologischer Zeitreihen wurde am Lehrstuhl für Geoinformatik,

Geohydrologie und Modellierung des Instituts für Geographie der Universität Jena

entwickelt. Das River Basin Information System (RBIS) ist eine Web-Anwendung, die die

Möglichkeit bietet, Geodaten und Zeitreihen bzw. deren Metadaten über das Internet zu

verwalten, zu visualisieren und abzurufen. Im Datenbankmodell der Metadaten ist der

ISO 19115 Standard vollständig umgesetzt. Es enthält außerdem Ergänzungen für die

Verwaltung von Messstationen und Zeitreihen. Die Datenhaltung erfolgt hierbei im

Datenbank-Management-System PostgreSQL in mehreren Datenbanken.

Im Rahmen dieser Diplomarbeit wurde die Web-Anwendung im Bereich der Verwaltung,

Analyse und Abfrage von Zeitreihen erweitert und verbessert. Dazu gehören neben

Anpassungen des Datenbankschemas auch die Identifikation von in Zeitreihen vorhanden

Datenlücken des Datenbestandes. Außerdem sollte dem Anwender die Möglichkeit

geschaffen werden diese mit einem Interpolationsverfahren eigener Wahl zu schließen.

Die berechneten Werte sollten temporär oder permanent in der Datenbank für den Export

vorgehalten werden.

Folgende Ausgangssituation lieferte die Motivation für diese Aufgabenstellung. Daten für

die Verwendung in hydrologischen Modellen müssen stets lückenlos vorliegen. Dies ist

jedoch in der Praxis oft nicht der Fall. Die eingesetzte Software zur Simulation der

hydrologischen Modelle kann – muss aber nicht – die notwendigen Funktionalitäten

bereitstellen um Datenlücken zu schließen. Aus diesem Grund müssen Lücken häufig von

Hand geschlossen werden. Dabei wird die Herkunft der berechneten Werte gar nicht oder

nur unzureichend dokumentiert. Das kann dazu führen, dass die Daten unter falschen

Voraussetzungen in Berechnungen einbezogen werden. Das Ergebnis des Prozesses des

Schließens der Lücken ist abhängig vom jeweiligen Bearbeiter. Dieser Missstand sollte

beseitigt werden. Gleichzeitig sollte der Prozess zum Schließen von Lücken standardisiert

und durch die Dokumentation der angewendeten Verfahren die Transparenz dieses

Prozesses erhöht werden. Dies führt dazu, dass die Datenqualität besser bewertet werden

kann. Um nicht nur eine lückenlose Zeitreihe, sondern auch eine lückenlose

Dokumentation über Veränderungen der Daten zu erhalten, zählte nicht nur die Umsetzung

von Interpolationsverfahren zur Aufgabenstellung, sondern insbesondere auch die

Entwicklung eines Dokumentationsverfahrens, das es ermöglicht, alle Veränderungen am

Datenbestand zu erfassen.

Im theoretischen Teil der Aufgabenstellung sollten Grundlagen von RBIS, existierende

Standards zur Verwaltung von Metadaten und Zeitreihen sowie die existierenden

Interpolationsverfahren und deren Verwendung untersucht und beschrieben werden. Die

Basis für eine Erweiterung bildet das RBIS selbst. Die Aufgabenstellung sah vor, an die

bestehenden Funktionalitäten anzuknüpfen und eine geeignete Lösung für die

Implementierung und Umsetzung der Anforderungen zu finden. Zu diesem Zweck sollte

2

1 Einführung und Problemstellung

für den praktischen Teil der Aufgabe zunächst geklärt werden, welche zusätzlichen

Metadaten benötigt werden, um überhaupt in der Lage zu sein Informationen über

Datenlücken abzuspeichern. Ebenso mussten Informationen den Metadaten hinzugefügt

werden, die für die Suche nach Zeitreihendaten erforderlich sind. Darauf aufbauend

konnten Funktionen entwickelt werden, die Datenlücken identifizieren und zusätzliche

Metadaten automatisch erfassen. Als Teilaufgabe ergab sich daraus, dass der gesamte

Importvorgang grundlegend überarbeitet werden musste. Mit diesen zusätzlich erfassten

Informationen konnten verschiedene Möglichkeiten zur Datenanalyse unter verschiedenen

Gesichtspunkten geschaffen werden. Im Vordergrund stand dabei die Darstellung der

räumlichen Verteilung und Verfügbarkeit von Zeitreihen. Zum Schließen der Lücken, wie

in der Aufgabenstellung gefordert, waren verschiedene Interpolationsverfahren zu

implementieren. Als weitere Teilaufgabe konnte identifiziert werden, dass eine einfache

und flexible Lösungen für den Zugriff auf die Zeitreihendaten aus der Anwendung heraus,

für die Speicherung der Metadaten zu den verwendeten Interpolationsverfahren und der

Dokumentation dieser Verfahren gefunden werden musste. Da vorher ein Zugriff auf

Zeitreihen mit geschlossenen Lücken nicht vorgesehen war, mussten abschließend die

Verfahren zum Export der Daten überarbeitet und angepasst werden.

3

2 Grundlagen

2 Grundlagen

In diesem Kapitel wird ein Überblick über die Grundlagen im Bezug auf das RBIS sowie

den entwickelten Erweiterungen und Anpassungen gegeben. Hierbei wird zunächst auf die

fachlichen Konzepte und Ideen, auf denen RBIS beruht eingegangen. Anschließend folgen

die technischen Grundlagen in Bezug auf Datenhaltung und -verwaltung. Anhand von

RBIS werden die Vorteile einer zentralen Datenhaltung, sowie Vor- und Nachteile einer

Umsetzung als Web-Anwendung diskutiert. Auch der Einsatz von Open-Source-Software

wird behandelt. Abschnitt 2.3 beschäftigt sich allgemein mit Informationssystemen, die

den Fokus auf die Verwaltung von Metadaten und Zeitreihen unter der Berücksichtigung

von Standards richten, sowie mit konkreten Beispielen aus dem geowissenschaftlichen

Umfeld Deutschlands. Der folgende Abschnitt umfasst die Gründe für und den Umgang

mit Datenlücken in umweltbezogenen Zeitreihen, sowie eine Auswahl verschiedener

Interpolationsverfahren, die zum Schließen von Datenlücken verwendet werden können.

2.1

Einordnung von RBIS

Im Rahmen der am Lehrstuhl laufenden Forschungen für ein Integriertes

Wasserressourcen-Management (Integrated Water Resources Management, IWRM) wurde

das so genannte Adaptive Integrated Data Information System (AIDIS) für die

Informationsverwaltung entwickelt. AIDIS bildet mit seinem Datenbankmodell den

konzeptionellen Rahmen für das River Basin Information System (RBIS). RBIS selbst ist

eine konkrete Umsetzung von AIDIS und besteht aus einer Web-Anwendung sowie

einigen Datenbanken. Was unter IWRM, AIDIS und RBIS genau zu verstehen ist, soll im

Folgenden erläutert werden.

2.1.1

IWRM – Integrated Water Resources Management

IWRM wurde im Jahr 2000 vom Global Water Partnership (GWP), einem internationalen

Netzwerk, welches Ministerien, UN-Behörden, Entwicklungsbanken, Forschungsinstitutionen, NGOs und private Institutionen umfasst,wie folgt definiert:

IWRM ist ein Prozess zur ganzheitlichen Entwicklung und Bewirtschaftung von

Wasser-, Land- und damit zusammenhängenden Ressourcen, mit dem Ziel einer

Maximierung des sozialen und ökonomischen Nutzens unter fairen Bedingungen

und ohne die Nachhaltigkeit vitaler Ökosysteme zu gefährden (GWP 2000).

4

2 Grundlagen

Die Grundprinzipien von IWRM folgen im Grundsatz den vier Dublin-Prinzipien. Diese

wurden 1992 in Dublin auf einer internationalen Umweltkonferenz unter Beteiligung von

mehr als 100 Staaten verabschiedet und sollen zur Verbesserung der weltweiten Wasserversorgung beitragen:

1. Süßwasser ist eine begrenzte und gefährdete Ressource, die unentbehrlich für

das Leben, die Entwicklung und die Umwelt ist.

2. Wassererschließung und -management sollten auf einem partizipativen Ansatz

basieren, der Nutzer, Planer und politische Entscheidungsträger aller Ebenen

einbezieht.

3. Frauen spielen eine zentrale Rolle bei der Versorgung mit Wasser, seinem

Management und Schutz.

4. Wasser hat einen wirtschaftlichen Wert in allen seinen Nutzungsmöglichkeiten und sollte als wirtschaftliches Gut angesehen werden. (GWP

2000)

Die Konzepte von IWRM gelten mit den Dublin-Prinzipien (1992) und der Agenda 21

(1992) als wasserpoltischer Konsens auf internationaler Ebene und verankern ein Leitbild

zur nachhaltigen Entwicklung und dem Umgang mit der Resource Wasser. Die Agenda 21

selbst ist ein entwicklungs- und umweltpolitisches Aktionsprogramm für das 21.

Jahrhundert, das 1992 in Rio de Janeiro auf der „Konferenz für Umwelt und Entwicklung“

der Vereinten Nationen von 179 Staaten beschlossen wurde (AGRAR 2007).

2.1.2

AIDIS – Adaptive Integrated Data Information System

AIDIS (FLÜGEL 2006) wurde den Anforderungen eines IWRM folgend zur

Entscheidungsunterstützung am Lehrstuhl für Geoinformatik, Geohydrologie und

Modellierung der Universität Jena entwickelt. Grundlage bilden ein gutes

Datenmanagement und Strategien zur gemeinsamen Informationsnutzung. Dies beinhaltet

neben anderen Informationen die Sammlung und Verwaltung von Zeitreihen in Bezug auf

Wassermenge und -qualität, sozioökonomische Daten sowie digitale Karten, welche die

räumliche Verteilung dieser Informationen zeigen. Das objekt-relationale Datenmodell von

AIDIS, in dem der Metadatenstandard für geografische Informationen, ISO 19115 (ISO

19115:2003), vollständig umgesetzt wurde, lässt sich durch seine modulare Struktur leicht

an die Anforderungen regionaler, sowie internationaler Forschungsprogramme anpassen.

Eine der ersten erfolgreichen Umsetzungen einer internetbasierten Projektdatenbank

erfolgte im Rahmen des von der Europäischen Union finanzierten Tisza River Projektes

durch das Tisza River Information System (TRIS)(FLÜGEL ET AL. 2005). In einer

weiterentwickelten Version kommt es nun als River Basin Information System (RBIS) in

verschiedenen Forschungsprojekten zum Einsatz.

5

2 Grundlagen

2.1.3

RBIS – River Basin Information System

Das River Basin Information System (RBIS) wurde in den letzten Jahren am Lehrstuhl

entwickelt und geht aus den Entwicklungen für das TRIS hervor. Es wird zur Verwaltung

aller Informationen bzw. Daten über ein bestimmtes Flusseinzugsgebiet eingesetzt,

angefangen von Dokumenten über Zeitreihen bis hin zu GIS-Daten. Es setzt sich aus den

zwei eigenständigen Komponenten Metadaten- und Zeitreihenverwaltung, die in Kapitel 3

näher beschrieben wird, und dem Kartenserver zusammen. Beide können auch unabhängig

voneinander zum Einsatz kommen. Aus technischer Sicht werden die Informationen in drei

Datenbanken gespeichert. In einer Datenbank werden die Metadaten, in einer weiteren die

Zeitreihendaten und in einer dritten die GIS-Daten verwaltet (Abbildung 1).

Abbildung 1: Aufbau von RBIS mit den Anwendungen Metadaten- und

Zeitreihenverwaltung und Kartenserver sowie den Datenbanken

RBIS kommt in verschiedenen Forschungsprojekten zum Einsatz, wobei die Oberfläche,

die Datenbanken und die Anwendungen der jeweiligen Aufgabenstellung durch den

modularen Aufbau des Datenmodells leicht angepasst werden können. Beispiele hierfür

sind die Installationen für das Einzugsgebiet des Brahmaputra (BrahmaRBIS) und der

Donau (DanubeRBIS) im EU-Forschungsprojekt Brahmatwinn. In diesem Forschungsprojekt geht es um eine Erweiterung des Wissens für den harmonischen Umgang mit den

Wasserressourcen großer alpiner Flusssysteme, deren Quelleinzugsgebiete vom Klimawandel beeinflusst sind. Umzusetzen ist dies über einen multilateralen Wissenstransfer,

Erfahrungsaustausch, sowie die Entwicklung und Anpassung bestehender Flussgebietsmanagementwerkzeuge zwischen europäischen und asiatischen Partnern (FSU 2007b). Ein

weiteres Beispiel ist die Verwaltung der Daten aus dem Einzugsbereich der Saale

(SaaleRBIS), in welchem die Daten für das vom BMBF geförderte Forschungsprojekt für

ein Integriertes Landschafts-Managementsystem für Wasserwirtschaft, Kommunal- und

Regionalplanung (ILMS) verwaltet werden sollen (FSU 2007a).

6

2 Grundlagen

2.2

Datenhaltung und -verwaltung

Die Verwaltung der verschiedenen Daten eines IWRM Systems kann innerhalb eines

Informationssystems wie dem RBIS erfolgen. Hier werden Metadaten, Zeitreihendaten und

GIS-Daten verwaltet und den Projektpartnern und Entscheidungsträgern bereitgestellt.

Anhand der Umsetzung von RBIS und den gesammelten Erfahrungen soll auf

konzeptionelle Grundlagen der Datenhaltung und -verwaltung eingegangen werden. Dabei

wird zunächst der Begriff Informationssystem definiert bevor die Vor- und Nachteile einer

zentralen Datenhaltung diskutiert und Web- und Desktop-Anwendungen gegenüber gestellt

werden. Abschließend wird der Einsatzes von Open-Source allgemein und in Bezug auf

RBIS aufgegriffen und thematisiert.

2.2.1

Informationssystem

Informationssysteme (IS) allgemein bestehen aus:

„Menschen und Maschinen, die Informationen erzeugen und/oder benutzen und

die durch Kommunikationsbeziehungen miteinander verbunden sind“

(HANSEN & NEUMANN 2001:132).

Aus Sicht der Informatik ist ein Informationssystem

„ein (rechnergestütztes) System zur Beschaffung, Verarbeitung, Übertragung,

Speicherung und/oder Bereitstellung von Informationen“ (SCHWARZE 2000:46),

das aus „Hardware, Software, Daten und den Anwendungen besteht“ (BILL

1999:4).

Es gibt viele Ausprägungen von Informationssystemen. Eine Art der Untergliederung kann

nach dem Typ der bereitgestellten Informationen erfolgen. Dabei wird zwischen

betrieblichen,

analytischen,

raumbezogenen

oder

personenbezogenen

Informationssystemen unterschieden. Weitere Einordnungen sind z. B. nach der Art der

Anwendung (Auskunftssystem, Buchungssystem,...) oder nach ihrer fachlichen

Ausrichtung möglich. Ein Beispiel eines Fachinformationssystems ist ein GeoInformationssystem mit dem

„raumbezogene Daten digital erfasst und redigiert, gespeichert und

reorganisiert werden, modelliert und analysiert sowie alphanumerisch und

graphisch präsentiert werden“ (BILL 1999:4) können.

Für die Realisierung eines Informationssystems spielen Internet- und Datenbanktechnologien eine zentrale Rolle. In der Regel werden alle Operationen, welche die Daten

betreffen, von einem Datenbanksystem (DBS) übernommen. Ein DBS setzt sich aus einem

Datenbank-Management-System (DBMS) und einer Datenbank zusammen. Unter einem

DBMS wird hierbei „die Gesamtheit der Software-Module, die die Verwaltung einer

7

2 Grundlagen

Datenbank übernehmen“ (HEUER & SAAKE 2000:8) verstanden. Der Unterschied zwischen

einem DBS und einem Informationssystem besteht darin, dass in einem

Informationssystem meist unterschiedliche Datenbestände in einen größeren thematischen

Zusammenhang gebracht und die Metadaten (Daten über Daten) hier intensiv für die

Recherche in den Datenbeständen genutzt werden. Weiterhin werden anwendungsnahe

Auswertungsmethoden und Visualisierungsmöglichkeiten dem Nutzer zur Verfügung

gestellt (STREIT 1998).

Viele Informationssysteme werden durch den Einsatz von Internettechnologien für einen

breiten Nutzerkreis zugänglich gemacht. Ein Beispiel aus dem täglichen Leben sind die

Fahrgastinformationssysteme für Fahrgäste des öffentlichen Personennah- und

-fernverkehrs, die über das Internet oder andere Medien benutzt werden können. Sie

umfassen u. a. Liniennetzpläne, Fahrplanbücher und -karten, Verspätungs-, Anschluss- und

Tarifinformationen.

RBIS kann als ein raumbezogenes Informationssystem bezeichnet werden. In Bezug auf

die Verwaltung von Zeitreihen und räumlichen Daten besitzt es sowohl Eigenschaften

eines Meta- als auch eines Zeitreiheninformationssystems (siehe Abschnitt 2.3).

2.2.2

Datenhaltung und Anwendung

Grundlage für den Betrieb eines Informationssystems ist der Datenbestand selbst, der

immer so abgespeichert sein muss, dass über klar definierte Schnittstellen darauf

zugegriffen werden kann. Dies ist zum Beispiel bei der Datenhaltung über ein DBMS in

einer Datenbank der Fall, wobei sich hier die Daten selbst auch auf (räumlich) verteilten

Systemen befinden können. Unabhängig von der Art der Daten oder Verwendung in einem

Informationssystem sind mit einer zentralen Datenhaltung - im Vergleich zur dezentralen

Speicherung der Daten ohne eine gemeinsame übergeordnete Verwaltung - eine Reihe von

Vorteilen verbunden. So kann durch zentral durchgeführte und im Bedarfsfall auch zentral

eingespielte Backups eine hohe Datensicherheit erreicht werden. Darüber hinaus erfolgt

die Speicherung der Daten in einem einheitlichen Format und eine aufwendige

Konvertierung zwischen verschiedenen Datenformaten entfällt. Die Plausibilität der Daten

kann über Formulare mit Validierungsfunktionen bereits bei der Eingabe überprüft werden.

Beim Zugriff über das Intranet oder Internet können sensible Daten vor unberechtigtem

Zugriff über Firewalls, Zugriffskontrollen, Verschlüsselung usw. geschützt werden

(KLOSSEK 2004). In Bezug auf das RBIS bedeutet eine zentrale Datenhaltung die

Speicherung der Daten in einer Datenbank und nicht nur lokal auf dem Rechner der

zuständigen Mitarbeiter innerhalb eines Forschungsprojektes. Die Vorteile kommen

besonders dann zum tragen, wenn die Projektpartner räumlich sehr weit voneinander

entfernt sind und auf Informationen zugreifen müssen. Alle Projektpartner können sich

schnell einen Überblick über vorhandene Daten verschaffen und diese gegebenenfalls

herunterladen. Somit entfällt das Versenden der Daten per E-Mail oder CD. Auch ein

8

2 Grundlagen

Fortbestand der Informationen über die Projektlaufzeit hinaus oder die Nutzung in

Folgeprojekten wird durch eine zentrale Datenhaltung begünstigt.

Um die gesammelten Datenmengen den Nutzern zur Verfügung zu stellen, müssen

Anwendungen entwickelt werden. Diese können grundsätzlichen als Web- oder DesktopAnwendung konzipiert sein. Unter Web-Anwendungen fallen all jene Computerprogramme, bei der die Interaktion mit dem Benutzer ausschließlich über einen Webbrowser

erfolgt. Der Computer des Benutzers (Client) ist dabei über ein Netzwerk mit einem

Server verbunden. Ein solches Netzwerk kann das Internet oder ein Intranet sein. DesktopAnwendungen sind hingegen Programme die lokal auf einem Rechner installiert sind und

über eine eigene Benutzerschnittstelle verfügen. Das RBIS ist eine Web-Anwendung.

Die Verwendung einer Web-Anwendung hat zahlreiche Vorteile. Zu diesen zählt, dass

lediglich ein Webbrowser benötigt wird und keine weitere Installation von Software wie

bei Desktop-Anwendungen, benötigt wird. Damit wird ein hoher Grad an Plattformunabhängigkeit erreicht. Auch die Hardwareanforderungen an die einzelnen Arbeitsplätze

werden gering gehalten, da aufwendige Berechnungen vom Webserver ausgeführt werden.

Ein weiterer entscheidender Vorteil ist, dass bei Änderungen der Anwendungslogik die

Änderungen nur an einer Stelle ausgeführt werden müssen, sich dadurch der Wartungsaufwand minimiert und dementsprechend damit verbundene Kosten verringert werden

können. Weiterhin kann dadurch sichergestellt werden, dass alle Anwender zu einem

bestimmten Zeitpunkt immer mit der gleichen Programmversion arbeiten (KLOSSEK 2004).

Dies ist bei Anwendungen wie dem RBIS, die in der Praxis eingesetzt und permanent

weiterentwickelt werden, sehr vorteilhaft. Hier kann bei auftretenden Problemen und

Fehlern sofort wirksam reagiert werden. Für die Arbeit mit Zeitreihen kommt ein weiterer

bedeutender Aspekt hinzu. Werden Daten zentral über einen Webserver in eine Datenbank

eingefügt, gilt stets ein Datum bzw. eine Uhrzeit als Bezugspunkt und nicht die lokale Zeit

des Benutzers, der die Daten in das System einpflegt. Insbesondere falsch eingestellte

Rechneruhren könnten hier bei der Umrechnung in UNIX-Zeit und wieder zurück in ein

lesbares Datumsformat zu Problemen führen. Neben der Ortsunabhängigkeit der Benutzer

zählen auch die preiswerte Pflege und Entwicklung und die zentrale Datenhaltung und

-verwaltung zu den Vorteilen.

Web-Anwendungen besitzen gegenüber Desktop-Anwendungen mit einer lokalen

Datenhaltung auch Nachteile. Zu diesen zählt an erster Stelle die benötigte TCP/IP

Verbindung zwischen Client und Server. Somit wird bei einer Web-Anwendungen über

das Internet immer eine Internetanbindung mit ausreichend großer Bandbreite

vorausgesetzt, die die Anforderungen der Anwendung erfüllt. Dieses Kriterium stellt in

entwickelten Industrienationen kein großes Problem dar. In den vielen Ländern Afrikas

oder Asiens hingegen ist ein schneller Internetzugang keine Selbstverständlichkeit und

selbst bei einer bestehenden guten Internetanbindung werden unter Umständen die

Anforderungen der Web-Anwendung durch begrenzte Kapazitäten der interkontinentalen

9

2 Grundlagen

Verbindungen nicht erfüllt. Dies stellt derzeit den effizienten und uneingeschränkten

Einsatz von RBIS im Forschungsprojekt Brahmatwinn in Frage. Innerhalb der

europäischen Partner ist der Einsatz unproblematisch. Jedoch ist des Einfügen und

Auslesen größerer Datenmengen ab einer Dateigröße von 10 Mega Byte durch die

asiatischen Partner teilweise durch eine zu geringe Bandbreite nicht möglich. Generell

können sich durch eine TCP/IP Verbindung auch Sicherheitsprobleme ergeben, da es eine

Vielzahl verschiedener Angriffsmöglichkeiten im Zusammenhang mit Web-Anwendungen

gibt. Dies gilt jedoch auch für Desktop-Anwendungen. Ein weiterer Nachteil gegenüber

von Desktop-Anwendungen ist die Tatsache, dass alle Browser den Quellcode

unterschiedlich interpretieren und sich somit geringe Abweichungen in der Darstellung und

dem zur Verfügung stehenden Funktionsumfang ergeben können. Allgemein gehören zu

den Nachteilen noch der erhöhte Sicherheitsbedarf des Webservers, der bei der Verwaltung

vieler sensitiver Daten entsteht, die proportional steigende benötigte Rechenleistung pro

Nutzer sowie eine ansteigende Netzlast, die sich allerdings im Fall von RBIS durch die

insgesamt geringe Benutzeranzahl kaum bemerkbar machen wird.

Das Beispiel RBIS zeigt, dass hier die Vorteile einer Web-Anwendung überwiegen.

Nachteile, wie etwa eine unzureichende Internetanbindung, werden in Zukunft eine

untergeordnete Rolle spielen.

2.2.3

Einsatz von Open-Source

Im RBIS wird ausschließlich Freie und Open-Source-Software (FOSS) eingesetzt. Für den

generellen Einsatz von Open-Source-Lösungen sind verschiedene Gründe ausschlaggebend. Dazu gehören die im Vergleich zu kommerziellen Produkten geringeren Lizenzund Anschaffungskosten. Dieser Aspekt gewinnt vor allem in öffentlichen Einrichtungen

an Bedeutung, da hier die Finanzmittel in vielen Fällen gekürzt werden. Nach einer Studie

der EU (GHOSH 2006) sparen Unternehmen rund ein Drittel ihrer Investitionen mit der

Verwendung von Open-Source Produkten bei der Entwicklung eigener Software. Dadurch

werden andere Entwicklungen und Innovationen möglich oder die Profitabilität wird

gesteigert. Durch die Unabhängigkeit der eingesetzten Software von einzelnen Herstellern

wird die Investitionssicherheit in Projekten und in der zukünftigen Betriebsphase erhöht.

Bei der Auswahl der eingesetzten Software wird auf umgesetzte Standards sowie die

Erweiterbar- und Austauschbarkeit von Komponenten geachtet. Wie eine Studie (STOLL

2006) zeigt, findet etwa 40% der Entwicklung von Open-Source-Software durch bezahlte,

professionelle Entwickler in kommerziell tätigen Unternehmen statt. Somit ist davon auszugehen, dass die Qualität von FOSS der Qualität kommerzieller Software nicht unterlegen

sein muss. Im Gegenteil entsteht durch die Öffnung des Quellcodes für Anwender und

Experten ein höherer Anspruch an die Umsetzung und ein stärkeres Kontrollpotential,

welches in der Regel der Qualität des Produktes förderlich ist. Zudem konnte in der Studie

eine deutlich höhere Akzeptanz des Open-Source-Gedankens bei den betroffenen

10

2 Grundlagen

Entwicklern und in Folge dessen eine deutlich höhere Motivation bei der Arbeit an OpenSource-Projekten festgestellt werden, als bei der Arbeit an klassischer closed-Source

Software.

Im Umfeld der Datenbank-Management-Systeme gibt es fünf größere Open-Source

-Datenbankensysteme. Zu diesen zählen MySQL, PostgreSQL, Firebird, Ingres und

MaxDB (HORSTMANN 2006). Für die Anwendung in RBIS wird die Unterstützung von

geographischen bzw. raumbezogenen Datentypen für die Speicherung der GIS-Daten

benötigt, die zurzeit von den drei Produkten MySQL, PostgreSQL und Ingres zur

Verfügung gestellt werden.

Ingres von der Ingres Corporation ist die älteste der fünf genannten Open-SourceDatenbanksystemen. MySQL der schwedischen Firma MySQL AB wurde im Jahre 1995

veröffentlicht. Bekannte Nutzer sind Yahoo, SourceForge, NASA, Lycos, Wikipedia

(Wikimedia) und T- Systems. Mit der Version 5.0 gibt es viele Neuerungen. Es stehen elf

verschiedene Tabellentypen (Datenbanktreiber) zur Verfügung, mit denen unterschiedliche

Funktionen verknüpft sind. Die beiden wichtigsten Typen sind MyISAM und InnoDB

(HORSTMANN 2006). PostgreSQL ist ein objektrelationales Datenbanksystem. Anwendung

findet es zum Beispiel bei BASF und Fujitsu (HORSTMANN 2006). Die aktuelle Version ist

PostgreSQL 8.2. Die Verarbeitung von geografischen Objekten wird durch die

Erweiterung PostGIS realisiert. Sie versetzt damit PostgreSQL in die Lage als Datenserver

für ein Geoinformationssystem (GIS) zu dienen (RAMSEY 2007).

Die drei DBMS MySQL, PostgreSQL und Ingres unterscheiden sich in ihren Grundfunktionalitäten nur geringfügig. Vor allem die Unterschiede zwischen MySQL und

PostgreSQL sind gering. Galt MySQL als schneller aber mit einem geringeren Funktionsumfang und PostgreSQL als langsamer jedoch mit einem größeren Funktionsumfang, so

haben beide ihren Rückstand zum einen durch neue Funktionen mit MySQL 5.0 und zum

anderen durch wesentlichen Performace-Gewinne bei PostgreSQL aufgeholt (HORSTMANN

2006).

Im RBIS kommt PostgreSQL mit PostGIS als DBMS zum Einsatz. Die Wahl wurde

anhand der verfügbaren Funktionen für die Verarbeitung von räumlichen Objekten der

verschiedenen Open-Source-Datenbanksystem getroffen. Hier war der zur Verfügung

stehende Umfang bei PostgreSQL / PostGIS im Vergleich zu MySQL höher. Inzwischen

wurde MySQL um eine eigene GIS-Lösung erweitert. Daher können heute beide Lösungen

als gleichwertig betrachtet werden. Dieser Entwicklung wurde in der Art vorausschauend

Rechnung getragen, als bei der Umsetzung darauf geachtet wurde, so weit wie möglich auf

die Verwendung proprietärer Funktionen des DBMS zu verzichten und das Datenmodell

unabhängig vom eingesetzten DBMS zu modellieren. Insgesamt wurde RBIS für das

Betriebssystem Linux, dem Apache-Webserver, dem DBMS PostgreSQL und PHP (LAPP

stack) realisiert, wobei ausschließlich Open-Source-Produkte eingesetzt werden.

11

2 Grundlagen

2.3

Meta- und Zeitreiheninformationssysteme

Ganz allgemein werden Geoinformationen (raumbezogene Informationen), die durch Geodaten repräsentiert werden, dazu verwendet, um Menschen bei Entscheidungsprozessen zu

unterstützen. Da nicht jedes Unternehmen seine eigenen Geodaten produzieren kann und

dies auch eine Verschwendung von Ressourcen darstellen würde, werden Informationen,

welche die Daten selbst beschreiben (Metainformationen) benötigt. Sie ermöglichen die

Verwendung außerhalb des Entstehungskontextes und dienen zum einen dazu die

Geodaten so zu beschreiben, dass sie sachgemäß eingesetzt werden können. Zum anderen

ermöglichen sie, dass Datensuchende diese finden, ohne von ihrer Existenz zu wissen. Der

Zugriff auf die in einem Geodatenkatalog enthaltenen Geodaten erfolgt über verschiedene

Dienste. Dies gilt ebenfalls für raum-zeitliche Informationen (gemessene oder simulierte

Werte). Ein komplexes Netzwerk in dem der Austausch von Geodaten zwischen GeodatenProduzenten, Dienstleistern sowie Geodatennutzern unterstützt wird, wird als Geodateninfrastruktur bezeichnet. Dabei erfolgt der Datenaustausch meist über das Internet.

Die Erfassung, Speicherung und Präsentation von Metainformationen ist die Aufgabe eines

Metainformationssystems. Für die Suche und den Austausch von Metadaten aus verschiedenen Quellen ist es notwendig, bestimmte Normen und Standards einzuführen. Die

Normierung und Standardisierung für Geoinformationen erfolgt durch die International

Standards Organization (ISO) (Normen) und das Open Geospatial Consortium (OGC)

(Standards) (MÜLLER ET AL. 2005:126f). Für Metadaten raumbezogener Informationen gibt

es

bereits

einige

Metadatenstandards.

Für

zeitliche

Informationen

im

geowissenschaftlichen Umfeld, die immer einen räumlichen Bezug aufweisen, gibt es noch

keine Standards. Aufgrund dieses räumlichen Bezugs von Zeitreihendaten und ihren

Metadaten können diese nicht ganz unabhängig von den bestehenden Metadatenstandards

für Geoinformationen betrachtet werden. Die Metadaten raum-zeitlicher Informationen

werden daher zum Teil in Erweiterungen zu bestehenden Metadatenstandards in

Metainformationssystemen verwaltet. Informationssysteme, die sich auf die Speicherung,

Analyse und Bereitstellung von Zeitreihendaten konzentrieren, können als Zeitreiheninformationssysteme bezeichnet werden. Diese besitzen häufig eine GIS-Erweiterung, um

der räumlichen Verortung der Daten Rechnung zu tragen.

Im Folgenden sollen die bestehen Metadatenstandards, verschiedene Metadateneditoren,

die für die Erstellung der Metadaten verwendet werden können, und einige Beispiele für

Metainformationssysteme, die in Deutschland im Einsatz sind, vorgestellt werden. Der

Abschnitt über die Standards für raum-zeitliche Informationen gibt einen kleinen Einblick

in aktuelle Standardisierungsvorhaben des OGC und Parallelen oder mögliche

Schnittpunkte mit dem Datenmodell von RBIS. Es gibt auch einen Überblick über

ausgewählte Zeitreiheninformationssysteme, vorrangig aus dem deutschsprachigen Raum,

mit einer hydrologischen Ausrichtung.

12

2 Grundlagen

2.3.1

Metadaten für räumliche Informationen

Metadaten für räumliche bzw. geografische Informationen spielen eine wichtige Rolle bei

der Veröffentlichung, der Weitergabe und dem Vertrieb von Geodaten. Sie sollten

möglichst immer die Fragen nach dem Was (Titel und Beschreibung), Wann (Datum der

Erstellung und Änderung), Wer (Ersteller und Vertreiber der Daten), Wo (räumliche

Ausdehnung und Ort) und dem Wie (Verfügbarkeit der Daten) beantworten können. Als

internationaler Standard für die Beschreibung von geografischen Informationen gilt der

ISO-Standard ISO 19115. Neben diesem weltweit gültigen Standard existieren auch noch

weitere Metadatenstandards. Für die Verarbeitung und Speicherung von Metadaten gibt es

mehrere verschiedene Metadateneditoren, die unterschiedliche Standards unterstützten.

Eine Auswahl wird im Folgenden benannt. Die Suche nach, aber auch die Verwaltung von

Geodaten kann über so genannte Metainformationssysteme für geografische Informationen

erfolgen. Exemplarisch werden hier fünf dieser Informationssysteme, die ein Teil der

Geodateninfrastruktur in Deutschland sind, vorgestellt.

2.3.1.1

Metadatenstandards

Für Geodaten gibt es mehrere Dokumentationsstandards. Der wichtigste Standard für

Metadaten im Geoinformationswesen ist ISO 19115. Neben diesem gibt es auf

verschiedenen Ebenen eine Vielzahl weiterer Metadatenstandards. Dazu gehört zum einen

der Dublin Core Standard, der allgemein zur Beschreibung von Dokumenten und anderen

Objekten im Internet dient. Zum anderen wird der in den USA vom Federal Geographic

Data Committee (FGDC) entwickelte Content Standard for Digital Geospatial Metadata

(CSDGM) dazu gezählt. Ein Beispiel für einen fachlichen Standard in Deutschland ist der

Umweltdatenkatalog (UDK), der Metadaten zum Nachweis umweltrelevanter

Datenbestände in den öffentlichen Verwaltungen enthält. Die Anzahl der zu

dokumentierenden Attribute reicht von 15 bis weit über 300 (MÜLLER ET. AL 2005:130).

FGDC-CSDGM

Der Content Standard for Digital Geospatial Metadata (CSDGM) oder kurz auch FGDCStandard wurde erstmals 1994 vom 1990 gegründeten Federal Geographic Data Comitee

(FGDC) veröffentlicht. Er ist seit 1998 verbindlicher Standard für die Dokumentation

raumbezogener Daten für Behörden in den USA. Der FGDC-Standard besteht, ähnlich

ISO 19115, aus verschiedenen Metadaten-Kategorien, die untereinander in Verbindung

stehen und alle von der Oberkategorie Metadata ausgehen. Für die meisten ISO-Elemente

gibt es eine Entsprechung im CSDGM (FDGC 1998, FDGC 2007a).

13

2 Grundlagen

Dublin-Core Standard

Der Dublin-Core Standard wurde von der Dublin Core Metadata Initiative (DCMI) 1995

ursprünglich für das Bibliothekswesen entwickelt. Er wurde unter der Bezeichnung ISO

15836:2003 Information and documentation - The Dublin Core metadata element set 2003

als internationale Norm veröffentlicht. Diese Norm bietet einfache Elemente zur

Beschreibung von Ressourcen im Internet. Dublin-Core Metadaten können z. B. im Header

von HTML-Dateien als Meta-Element angeben werden. Sie sind alle optional und können

beliebig oft und in beliebiger Reihenfolge verwendet werden (HILLMAN 2005). Dublin-Core

wird zum Beispiel als Minimalsatz an Metadaten in der OGC Catalogue Services

Specification 2.0 verwendet, die eine offene Standardschnittstelle zum Auffinden,

Durchsuchen und Aufrufen von beliebig, verteilt vorliegenden Georessourcen beschreibt

(CON TERRA 2004).

ISO 19115

ISO 19115 Geographic information – Metadata ist eine internationale Metadaten-Norm,

welche die Struktur für die Beschreibung von Geodaten vorgibt. Die Arbeiten unter diesem

Namen (früher ISO 15046) begannen 1996 und endeten 2003, als das Dokument durch die

ISO zum internationalen Standard wurde. Eine der Grundlagen bildete zum Beispiel der

FDGC-Metadatenstandard von 1994. Aus diesem Grund sind diese auch recht ähnlich,

jedoch nicht gleich, da sie sich auseinander entwickelten. Weiterhin flossen unter anderem

die Ergebnisse des technischen Komitees 287 des Comite Europeen de Normalisation

(CEN) ein. Dieses entwickelte in den Jahren 1997 und 1998 eine europäische MetadatenNorm (ENV 12657:1998 - Geographic Information - Data description – Metadata). Die

Arbeiten wurden eingestellt, und die ISO-Norm wurde unter dem Namen

EN ISO 19115:2005 als CEN-Norm übernommen (CEN 2007, ISO/TC 211 2007, FDGC

2007b).

Abbildung 2: ISO 19115 Profil für bestimmte Nutzergruppen oder

Länder „community profile“ (Quelle: ISO 19115:2003)

14

2 Grundlagen

ISO 19115:2003 beinhaltet 409 Metadatenelemente, die in Metadatenentitäten gruppiert

sind. Diese wiederum sind nach ihrem Zweck zu 15 Hauptmetadatenpaketen zugeordnet.

Ausgangspunkt bildet dabei die Klasse Metadata entity set information. Es gibt 22 so

genannte core metadata elements (components), welche einen Minimalsatz an Elementen

bilden, den nach ISO 19115:2003 jede Umsetzung beinhalten sollte (Abbildung 2). Sie

sollen sicherstellen, dass die Fragen über das Was, Wo, Wann und Wer eines Datensatzes

immer beantwortet werden können. Die restlichen Metadatenelemente können optional

umgesetzt werden. Durch die Vorgabe von Codelisten wird die Anzahl der Felder, die mit

freiem Text belegt werden können, reduziert, was eine einheitliche Interpretation zwischen

verschiedenen Metadateninformationssystemen ermöglicht. Weiterhin ist es erlaubt eigene

Erweiterungen einzubinden oder zu erstellen (siehe extended metadata in Abbildung 2).

Damit wird eine wesentliche Voraussetzung für die Integration bzw. nachträgliche

Anpassung an die ISO-Norm geschaffen (ISO 19115:2003).

2.3.1.2

Metadateneditoren

Mit der zunehmenden Bedeutung von Metadaten für die Bereitstellung von Geodaten im

Internet und bei der Vernetzung von Informationssystemen wurden neben Standards auch

eine Reihe von Metadateneditoren entwickelt. Zum gegenwärtigen Zeitpunkt unterstützen

fast alle aktuellen Anwendungen ISO 19115. Zu den Desktop-Anwendungen zählt der

kommerzielle ArcCatalog und die ArcView Metadata Extension von der Firma ESRI, die

den FGDC-Standard und ISO 19115 abdecken. Ein weiteres kommerzielles Produkt ist

Infopath von Microsoft. Zu den kommerziellen Web- und Desktop-Anwendungen, die

ISO 19115 unterstützen, zählen z. B. Authentic (Bestandteil von XMLSpy), PubliStar,

Geometa-Editor (Teil der Geo-Metadata Network Suite), sdi.suite terraCatalog und

GeoKey. Die Produkte CatMDE, disy Preludio und GeoNetwork sind hingegen als

Freeware verfügbar (GISPUNKT 2007, BEHRENDS ET AL. 2006).

Ein Problem liegt in der Breite der potenziellen Anwendungsmöglichkeiten der

Programme. Oft ist diese Software nur für einen bestimmten Anwendungszweck geeignet.

Daher ist die Integration in die Prozesse eines Unternehmens bzw. eines

Forschgungsprojektes oft mit einem höheren Anpassungsaufwand verbunden, als für die

Einarbeitung, Schulung und Programmierung aufgebracht werden müsste. Der Trend geht

dahin, dass Editoren an spezielle Dienstleistungen oder Komponenten größerer

Softwarelösungen gebunden sind. Auch die Kopplung an Onlinedienste und Webangebote

scheint nach BEHRENDS ET AL. (2006:45f) aufgrund der Komplexität der Sachverhalte eine

praktikable Lösung zu sein.

15

2 Grundlagen

2.3.1.3

Metainformationssysteme für Geodaten

Metainformationssysteme für Geodaten dienen der Erfassung, Verwaltung und Recherche

von Geodaten, Geodiensten und Geoanwendungen. Sie sind als Suchmaschine nach

KAZAKOS (2006) ein wichtiger Bestandteil einer Geodateninfrastruktur und bilden die

Grundlage zur Mehrfachnutzung von Geodaten in den öffentlichen Verwaltungen sowie

die Basis für die Vermarktung von Geodaten. Allgemein können Kosten gespart werden,

wenn die Daten in Folgeprojekten wiederverwendet und nicht neu erhoben werden müssen.

Auch kann die Qualität von schlecht dokumentierten Daten z. B. bei einem Mitarbeiterwechsel möglicherweise nicht mehr beurteilt werden. In besonders schwerwiegenden

Fällen können Kosten entstehen, weil Entscheidungen auf der Grundlage von fehlerhaften

Daten getroffen werden. Das Ziel beim Einsatz eines Metainformationssystems für

Geodaten ist daher, Auskunft über Art, Verfügbarkeit und Qualität der Geodaten zu geben.

In Deutschland wird die Schaffung einer Geodateninfrastruktur (GDI-DE) seit 2003

verstärkt vorangetrieben und gefördert. Beispiele aus Deutschland sind das nationale

GeoMIS.Bund (BKG 2007), das PortalU (KRUSE 2007), der CeGi GEOcatalog (CEGI

2007), das NOKIS (KAZAKOS 2006) und der Umweltdatenkatalog (UDK) (KRUSE 2007).

GeoMIS.Bund

GeoMIS.Bund ist das Metainformationssystem für Geodaten des Bundes. Es ist im

GeoPortal.Bund als Geodatensuchmaschine integriert und beruht auf dem ISO-Standard

ISO 19115. Es war der erste Schritt zur Schaffung der nationalen Geodateninfrastruktur

GDI-DE. GeoMIS.Bund ermöglicht die Suche in verteilten Geokatalogen. Ziel ist es, alle

Fachinformationssysteme der Bundesbehörden daran anzuschließen, sowie die Länder und

die Privatwirtschaft einzubeziehen. GeoMIS ist als Dienst für Behörden, Wirtschaft und

die breite Öffentlichkeit verfügbar (BKG 2007).

Aus technischer Sicht kommuniziert das GeoMIS über einen oder mehrere Web Catalog

Services (CSW) mit den angeschlossenen Metadatenbanken. Es gibt zwei Varianten, zu

welchem Zeitpunkt die Abfrage zwischen GeoMIS und CSW erfolgt. Das GeoMIS des

Bundes erfragt alle angeschlossenen Kataloge zum Zeitpunkt der Kundenanfrage und

erhält damit immer die aktuellsten Metadaten. Das zukünftige GeoMIS der GDI

Berlin/Brandenburg wird im Vorfeld die Metadaten aller angeschlossenen Stellen in das

eigene relationale Datenbankmanagementsystem (RDBMS) integrieren. Dies führt zu einer

höheren Verfügbarkeit, birgt aber auch die Gefahr von Mehrfacheinträgen durch

Rekursionen von verketten Katalogdiensten (WIKIPEDIA 2007).

PortalU

Das PortalU (Umweltportal Deutschland) ist ein gemeinsames Internetportal des Bundes

und der Länder. Es bietet über einen zentralen Zugang Zugriff auf die Internetseiten,

Datenkataloge und Datenbankeinträge von öffentlichen Institutionen und Organisationen

16

2 Grundlagen

des Bundes und der Länder. Es können gezielt aktuelle Umweltnachrichten und

-messwerte, detaillierte Informationen zu verschiedenen Umweltthemen, Hinweise auf

Veranstaltungen und neue Publikationen, sowie Informationen über historische

Umweltereignisse abgerufen werden. Über PortalU kann auch auf die Daten des UDK

zugegriffen werden. Die Koordinierungsstelle PortalU ist beim Niedersächsischen

Umweltministerium in Hannover angesiedelt (KRUSE 2007).

CeGi GEOcatalog

Der CeGi GEOcatalog ist ein webbasiertes Metadateninformationssystem, das auf

internationalen Standards des OGC und ISO (19115, 19119) basiert. Hierbei handelt es

sich um ein Gemeinschaftsprodukt der Center for Geoinformation GmbH (CeGi) und der

ConTerra GmbH. Mit seiner Hilfe kann über verteilte registrierte Kataloge und getrennt

nach Geodaten oder Geodiensten gesucht werden (CEGI 2007).

NOKIS

Das Nord-Ostsee-Küsten-Informations-System (NOKIS) ist ein Informationssystem für die

Nord- und Ostseeküste, über das Geodaten aber auch Zeitreihen und Forschungsprojekte

zu deutschen Küstengebieten recherchiert werden können. Es ist eine der größten

Metadatenquellen von GeoMIS.Bund. NOKIS unterstützt nicht nur den ISO 19115

Standard, sondern auch standardkonforme Erweiterungen wie küstenspezifische Elemente

(z. B. Informationen über Gezeiten). Aufbauend auf den Technologien von disy Preludio,

bildet NOKIS inzwischen einen wichtigen Baustein für die Metadaten-Infrastruktur der

meisten Institutionen an der deutschen Küste. Über die OGC Catalog-Service-WebSchnittstelle (CSW) wird ein verteilter Zugriff realisiert. Ebenso können Daten auch mit

dem Umweltdatenkatalog (UDK) ausgetauscht werden (KAZAKOS 2006).

UDK

Das Grundkonzept sowie die Anwendungssoftware des Umweltdatenkataloges (UDK)

wurden im Zeitraum von 1991 bis 1995 im Niedersächsischen Umweltministerium

entwickelt. Die weitere Entwicklung und Einführung der Software beruhte auf der am

1.1.1996 in Kraft getretenen Verwaltungsvereinbarung UDK (seit 1.1.2003:

Verwaltungsvereinbarung UDK/GEIN). Der UDK enthält Metainformationen über die in

den Umweltverwaltungen der Bundesländer und des Bundes vorhandenen

umweltrelevanten Datenbestände und dient der Beschreibung von Umweltdaten bzw. der

Auffindung umweltrelevanter Datenquellen im Internet. In Deutschland setzen heute das

Umweltbundesamt und das Bundesamt für Naturschutz sowie alle Bundesländer mit

Ausnahme von Berlin den UDK als Metainformationssystem ein (KRUSE 2007).

17

2 Grundlagen

2.3.2

Verwaltung von raum-zeitlichen Informationen

Für die Verwaltung von raum-zeitlichen Informationen, wie beispielsweise

Abflusszeitreihen eines Pegels oder Temperaturzeitreihen einer Klimastation, gibt es noch

keine Standards, wie sie etwa für räumliche Daten zur Verfügung stehen. Welchen Stand

der Standardisierungsprozess hat und welche Parallelen zu dem Datenmodell von RBIS

gezogen werden können, wird nachfolgend behandelt. Im Anschluss werden verschiedene

Zeitreiheninformationssysteme, die als eine weitere Art von Informationssystemen

angesehen werden können, vorgestellt. Sie verfolgen im Vergleich zu den

Metainformationssystemen ein anderes Ziel, da sie sich mehr auf die Daten selbst und ihrer

Verarbeitung und weniger auf ihre Metadaten konzentrieren, wenngleich auch hier

Metadaten, wie etwa die Position der Messstelle, unerlässlich sind.

2.3.2.1

Standards für Zeitreihen und Sensoren

Konzentrierte sich die Entwicklung von Anwendungen und Standards zunächst auf

räumliche Informationen, so rückten in den letzten Jahren Anwendungen und

Informationssysteme, die Daten mit einem raum-zeitlichen Bezug verwalten, in den

Vordergrund. Auch die Entwicklung von Standards wurde von verschiedenen Stellen

vorangetrieben. So wurde infolge der Ereignisse des 11. September 2001 in New York die

OGC Web Service (OWS)-Initiative gegründet, die u. a. zum Ziel hat, Standards für die

Verwaltung von verschiedenen Sensoren und deren Daten über das Internet zu entwickeln,

um im Katastrophenfall besser agieren zu können. Das Open Geospatial Consortium

(OGC), früher Open GIS Consortium, wurde 1994 gegründet und ist ein internationales,

nicht gewinnorientiertes und freiwilliges Industriekonsortium mit derzeit 349 Mitgliedern

aus Industrie, Behörden, öffentlicher Verwaltung und Universitäten. Ziel dieses

Konsortiums ist es, Grundlagen für einheitliche und interoperable Zugriffsmethoden auf

raumbezogene Informationen zu entwickeln (OGC 2007c). Im Rahmen der OGC Web

Service Testbeds (OWS) 1 und 1.2 des OGC wurde u. a. die Sensor Web Enablement

Initiative (SWE) für die interoperable Steuerung und Abfrage von Sensoren gegründet

(OGC 2007a). Im Rahmen der SWE-Initiative wurden OGC Spezifikationen für eine Reihe

von Diensten und dazugehöriger Beschreibungssprachen erarbeitet, die neben der Abfrage

durch Sensoren erfasster raum- und zeitrelevanter Messdaten auch die interoperable

webbasierte Steuerung von Messvorrichtungen vorsehen. Mit der Sensor Model Language

(SensorML) werden alle Arten von Sensoren unterstützt, die sich ruhend oder in

Bewegung befinden können, angefangen bei Pegelmessstationen über Webcams bis hin zu

satellitengestützten Sensoren. Mit der Verwaltung von Messwerten befasst sich

Observation and Measurement (O&M) (WYTZISK & SIMONIS 2005:235ff).

18

2 Grundlagen

Eine Übersicht der verschiedenen Teilprojekte von SWE und deren Status innerhalb des

OGC ist in Tabelle 1 zusammengetragen. Einige dieser Dokumente besitzen schon den

Status eines offiziellen OGC Standards, andere befinden sich auf dem Weg dahin und sind

daher noch möglichen Änderungen unterlegen.

Tabelle 1: Übersicht der Teilprojekte des OGC Sensor Web Enablement (SWE)

Name

Inhalt

Status (OGC)

Sensor Observation

Service (SOS)

Bereitstellung von Messergebnissen

(standardisierte, webbasierte Schnittstelle für Zugriff

auf Sensoren und Sensordatenarchive)

13.02.2006

(Draft OpenGIS®

Implementation

Specification)

Observations &

Measurements (O&M)

Modellierung und Codierung von Messergebnissen

(Modell zur Abbildung räumlich und zeitlich varianter

Größen; XML basiertes encoding)

21.09.2006

(Draft OpenGIS® Best

Pratices Document)

Sensor Model Language Beschreibung der Sensoren

17.07.2007

(SensorML)

(Beschreibungssprache zur eindeutigen Referenzierung (OpenGIS®

und Definition von Sensoren)

Implementation

Specification )

Transducer Markup

Language (TML)

Charakterisierung der Sensoren

(Modellierung und Codierung für Datenströme von

Sensoren; Beschreibung von System und Daten

encoding)

02.07.2007

(OpenGIS®

Implementation

Specification )

Sensor Alert Service

(SAS)

Alarmmeldungen der Sensoren

(Anzeigen, Abonnieren und Veröffentlichen von

Warnungen)

13.05.2006

(Candidate OpenGIS®

Implementation

Specification

Sensor Planning Service Planung von Messexperimenten

(SPS)

(standardisierte Schnittstelle zur Informationsbeschaffung für Mess- und Simulationsaufgaben)

01.12.2005

(Request for

Comments OpenGIS®

Best Pratices

Document)

Web Notification

Service (WNS)

18.11.2006

(Draft OpenGIS® Best

Pratices Document)

Benutzerbenachrichtigung

(Schnittstelle zur Kapselung von Funktionen für

Benachrichtigung von Nutzern und Diensten)

(Quellen: OGC 2007b, WYTZISK & SIMONIS 2005:235ff, Stand: 27.07.2007)

Im Teilprojekt O&M wird ein konzeptionelles Modell, sowie auch eine Kodierung für

Beobachtungen und Messungen entwickelt. Die Grundelemente sind in Abbildung 3

dargestellt. In der aktuellen Version steht die Observation, als ein spezielles Event mit

einem Wert, der ein Phänomen beschreibt, im Mittelpunkt. Ein Event wird durch eine Zeit

oder ein Zeitintervall und optional durch eine semantische Beschreibung des Wertes

definiert. Jedem Event können Qualitätsmerkmale zugeordnet werden. Für jede

Observation ist eine Organisation oder Person (CI_ResponsiblePerson – ISO 19115)

zuständig. Jeder Observation muss zugeordnet sein, was für ein Phenomenon (z. B.

Abfluss) beobachtet wurde. Über die Zuordnung von Procedure wird beschrieben, wie der

19

2 Grundlagen

Wert zustande gekommen ist. Alle Observations können ein bestimmtes Ziel oder Objekt

der Beobachtung haben (feature of interest). Hierzu zählen Flüsse, Straßen, Personen,

Fahrzeuge, Gebäude, Berge, Aquifere genauso wie einzelne Proben, Stationen,

Geländemessungen oder Bildausschnitte. Die räumliche Referenzierung geschieht

entweder über die Beschreibung des Vorgangs (procedure), oder über das Ziel oder Objekt

der Beobachtung (feature of interest). Die Beschreibungen der einzelnen Sensoren, mit

denen die Werte erfasst werden, gehören nicht zu O&M und werden von anderen

Teilprojekten in SWE abgedeckt (COX 2006).

Abbildung 3: Grundelemente Observation und Event in O&M (COX 2006:13)

Das aktuell frei verfügbare Entwurf mit dem Stand vom 21.09.2006 enthält eine offizielle

Position des OGC, wurde jedoch noch nicht endgültig als OGC Standard anerkannt und

unterliegt daher noch Veränderungen. Aus diesem Grund wurden bei der Erweiterung des

Datenmodells des RBIS für die Verwaltung von Zeitreihen und Stationen diese Entwürfe

nicht verwendet (ZANDER 2006). Eine Anpassung des Datenmodells von RBIS könnte sich

als problematisch erweisen, da der OGC Standard mehr von einzelnen Messwerten (COX

2006) als von ganzen Zeitreihen ausgeht, wenngleich auch hier die Möglichkeit besteht

mehrere Messwerte zusammenzufassen. Im aktuelle RBIS-Datenmodell wird immer von

ganzen Zeitreihen beliebiger Länge ausgegangen. Die Metadaten der Zeitreihen im RBIS

verweisen ebenfalls auf Responsible Parties aus ISO 19115. Auch die Angaben von

Beginn und Ende einer Zeitreihe sieht O&M vor. Genaue Aussagen über die Verwaltung

der Datenqualität gibt es in O&M noch nicht. COX (2006) schlägt in diesem

Zusammenhang eine Verknüpfung mit bestehenden Data Quality Elementen in ISO

Standards vor. Im RBIS wird hierfür eine eigene Erweiterung verwendet.

20

2 Grundlagen

2.3.2.2

Zeitreiheninformationssysteme

Die Verwaltung von Zeitreihen, u. a. für die hydrologische Modellierung, kann unter

Verwendung so genannter Zeitreiheninformationssysteme erfolgen. Diese können als eine

mögliche Spezialisierung eines Fachinformationssystems gesehen werden. Die

Zeitreihenverwaltung, sowohl von gemessenen, als auch simulierten Messwerten in einem

Informationssystem, stellt im weitesten Sinne das Gegenstück zu einem geographischen

Informationssystem mit seinen flächenbezogenen Daten dar. Ein klassisches Beispiel sind

Pegelinformationssysteme, über die auf aktuelle oder vergangene Messwerte zugegriffen

werden kann. Ein Beispiel hierfür ist das gewässerkundliche Informationssystem der

Wasser- und Schifffahrtsverwaltung des Bundes (Pegelonline), das interessierten Bürgern

Zugriff auf den tagesaktuellen Wasserstand ausgewählter Binnenpegel der Wasserstraßen

des Bundes gewährt. Mitarbeitern und autorisierten Personen steht ein noch größeres

Informationsangebot zur Verfügung (WSV 2007). In den hydrologisch geprägten

Ingenieurswissenschaften spielt die Verwaltung von Zeitreihen eine große Rolle. Im

deutschsprachigen Raum gibt es mehrere Unternehmen, die Zeitreiheninformationssysteme

mit hydrologischer Ausrichtung selbst oder innerhalb von Forschungsprojekten entwickelt

haben. Darunter zählt die Ingenieurgesellschaft aqua_plan, die unter dem Namen AquaZIS

ihre bisherigen Produkte AquaRell, AquaCoup und AquaLog (wasserwirtschaftliche

Informationssysteme im Sachgebiet Niederschlag, Pegelwesen und Grundwasser ) vereint

(AQUAPLAN 2007). Eine andere Ingenieurgesellschaft (SYDRO) entwickelte die Anwendung

WELLE zur Erfassung, Verwaltung, Visualisierung und Analyse von Zeitreihen (SYDRO

2007). Die Gesellschaft für Logistik & Gewässermanagement (Gelog mbH) vertreibt das

Programmsystem HydroZIS, welches für die Erfassung, Speicherung, Verwaltung,

Prüfung, Pflege, Visualisierung und Auswertung hydrologischer Zeitreihen ausgelegt ist

(GELOG 2006). Beim Bundesamt für Wasserbau ist WISKI (ein Produkt der Firma

Kisters) im Einsatz. WISKI ist ein umfangreiches wasserwirtschaftliches Informationssystem mit zahlreichen Komponenten und Modulen für spezielle wasserwirtschaftliche

Anwendungsgebiete (KISTERS AG 2007). Über WISKI werden auch die Daten für

Pegelonline bereitgestellt. Über NOKIS wiederum können die Metadaten der Pegel von

Pegelonline abgefragt werden.

Alle genannten Zeitreiheninformationssysteme sind mit einem GIS verknüpft und

ermöglichen auch eine räumliche Darstellung und Auswahl der Messstationen. Dies

verdeutlicht noch einmal die enge Verzahnung zwischen den verschiedenen Ausprägungen

von Fachinformationssystemen im geowissenschaftlichen Umfeld.

RBIS selbst ist zum Teil ein Metainformationssystem mit einem geringeren

Funktionsumfang (es werden keine Dienste angeboten) gegenüber den oben beschriebenen

Produkten. Zusätzlich erfüllt es die Aufgaben eines Zeitreiheninformationssystems. An

dieser Stellte sollte lediglich aufgezeigt werden, welche zwei generell voneinander

unterscheidbaren Informationssysteme mit ähnlichen Aufgabenstellungen wie RBIS vor

dem Hintergrund möglicher Standards existieren.

21

2 Grundlagen

2.4

Zeitreihen und Datenlücken

Umweltbezogene Zeitreihen weisen recht häufig aus verschiedenen Gründen Lücken auf.

Diese müssen aufgefüllt werden, wenn auf diesen Zeitreihen statistische Analysen

durchgeführt werden oder sie zum Beispiel in hydrologischen Modellen als Ausgangsdaten

verwendet werden sollen. In der Literatur gibt es viele Arbeiten, die sich mit den

verschiedenen Methoden zum Füllen fehlender Messwerte in umweltbezogenen Zeitreihen

befassen. Die Klasse von Verfahren und Problemen aus der numerischen Mathematik, bei

der zu gegebenen diskreten Daten eine kontinuierliche Funktion gefunden werden soll,

wird als Interpolation bezeichnet. Viele Methoden, die bei der Übertragung von

Punktdaten in die Fläche (Regionalisierung) angewendet werden, können auch zum

Schließen einzelner Datenlücken verwendet werden. Ferner gibt es noch andere

Einsatzmöglichkeiten dieser Verfahren, wie die Prüfung der Daten auf ihre Plausibilität.

Ein Beispiel wird von YOU ET AL. (2004) beschrieben. Hierbei werden die Ergebnisse

zweier räumlicher Interpolationsverfahren miteinander verglichen, um mögliche Fehler in

maximalen und minimalen Temperaturwerten zu finden.

Im Folgenden wird zunächst definiert, was Zeitreihen sind und wie sie sich untergliedern

lassen, bevor auf die Ursachen von Datenlücken eingegangen wird und allgemeine

Verfahrensweisen zum Auffüllen von Lücken beschrieben werden. Diese sind nicht nur auf

umweltbezogene Daten anwendbar, sondern auch auf Zeitreihendaten allgemein.

Anschließend wird auf die einzelnen Interpolationsverfahren eingegangen, die zum

Schließen von Datenlücken verwendet werden können. An dieser Stelle soll nur eine

Auswahl mit möglichen Anwendungsbereichen und Varianten sowie Beispielen oder

Empfehlungen von Autoren für die Anwendung betrachtet werden. Der Schwerpunkt liegt

hierbei auf den Interpolationsverfahren, die in der RBIS-Erweiterung realisiert wurden.

Eine allgemeine Definition von Zeitreihen gibt HERZOG (2005):

„Zeitreihen sind ganz allgemein Sammlungen von Messwerten, die zu bestimmten

Zeitpunkten aufgenommen wurden.“

Eine Zeitreihe setzt immer voraus, dass die Daten nicht kontinuierlich, sondern in diskreten

bzw. endlichen Abständen vorliegen. Zeitreihen können, wie zum Beispiel bei der

kontinuierlichen Aufzeichnung von Pegelständen, durch Abtastung der Messreihe zu

bestimmten Zeitpunkten erzeugt werden. In Zeitreihen können die Zeitpunkte äquidistant,

d. h. mit festem Zeitabstand, oder in unregelmäßigen zeitlichen Abständen vorliegen, wenn

zum Beispiel nur die Veränderung eines Messwertes registriert wird. Zeitreihen gibt es in

vielen Bereichen, wie etwa in der Form von Börsenkursen in der Finanzmathematik, der

Arbeitslosenquote in der Ökonomie oder von Abflussdaten in der Hydrologie. Die

Disziplin, die sich mit der mathematisch-statistischen Analyse und der Vorhersage von

Zeitreihen beschäftigt, ist die Zeitreihenanalyse (HERZOG 2005).

22

2 Grundlagen

2.4.1

Zeitreihenarten

Generell lassen sich drei Zeitreihenarten unterscheiden, nämlich kontinuierliche, Intervallund Momentan-Zeitreihen, die sich auch in der Definition von Datenlücken unterscheiden.

Kontinuierliche Zeitreihen

Hydrologische Parameter werden häufig mit Schreibstreifen oder Dataloggern

kontinuierlich aufgezeichnet. Auch wenn Datalogger dabei meistens in einem festen

Zeitintervall oder bei einer festen Änderung des Messwertes aufzeichnen, werden diese

Daten kontinuierlich interpretiert. Der Graph besitzt jedoch keine geschlossene

Darstellung, da die Anzahl der Stützstellen begrenzt ist. Hier wird meist zwischen zwei

Stützstellen linear interpoliert. Ein Beispiel sind Messungen an einem Abflusspegel. Liegt

zu einem bestimmten Zeitpunkt kein Wert vor, so ist dies eine Lücke (Abbildung 4).

(AQUAPLAN 2002:15ff).

Abbildung 4: Kontinuierliche Zeitreihe mit Lücke

Intervall-Zeitreihen

Bei einer Intervall-Zeitreihe liegen die Werte für ein bestimmtes Zeitintervall vor. Diese

Zeitintervalle können, müssen aber nicht, äquidistant sein. Ein Beispiel für eine

äquidistante Intervall-Zeitreihe sind Niederschlagstagessummen, die jeweils einen

Zeitraum von 24 Stunden repräsentieren. Nicht äquidistante Intervall-Zeitreihen entstehen,

wenn zum Beispiel nur wochentags die Daten eines Niederschlagsmessers abgelesen

werden. Am Montag enthält dieser dann die Niederschlagsmenge seit der letzten Ablesung

am Freitag. Lücken in einer äquidistanten Intervall-Zeitreihe können ein oder mehrere

Intervalle umfassen (Abbildung 5)(AQUAPLAN 2002:15ff).

Abbildung 5: Intervall-Zeitreihe mit Lücken

23

2 Grundlagen

Momentan-Zeitreihen

Momentan-Zeitreihen sind nur für eine diskrete Zeitpunkt definiert. Zwischen diesen

Zeitpunkten ist nichts bekannt. Eine Interpolation zwischen diesen Werten ist nicht

sinnvoll, weil hier keine aussagekräftigen Daten ermittelt werden können. Ein Beispiel für

eine solche Reihe sind alle lokalen Maxima einer Niederschlagszeitreihe. Als MomentanZeitreihen können auch Zeitreihen betrachtet werden, die Aufgrund ihres großen

Zeitintervalls die zugrunde liegende Dynamik nicht widerspiegeln, wie etwa die Messung

der Temperatur aller 3 Monate. Ein weiteres Beispiel sind 14tägig gemessene

Gewässergüteparameter. Lücken in Momentan-Zeitreihen sind nur Zeitpunkte, die einen

undefinierten Wert liefern (Abbildung 6)(AQUAPLAN 2002:15ff).

Abbildung 6: Momentan-Zeitreihe mit Lücke

2.4.2

Ursachen für Datenlücken in Zeitreihen

Die Gründe für fehlerhafte oder fehlende Messwerte sind breit gefächert und reichen von

routinemäßigen Wartungen über systematische Messfehler bis hin zu ungeplanten

Totalausfällen. Generell können eine temporäre Schließung, Umsetzung, ein Neubau oder

Zerstörung von Teilen oder der gesamten Station Datenlücken in den Zeitreihen

verursachen. Auch einfache bauliche Veränderungen können die Zuverlässigkeit der

Messwerte beeinträchtigen. Eine weitere Quelle für Datenlücken ist in den Sensoren selbst

zu suchen. Sind die Messinstrumente einer hohen Beanspruchung durch

Starkniederschläge, Hochwasser, Frost (Eisbildung), Trockenheit und Hitze ausgesetzt,

liefern diese keine oder fehlerhafte Werte. Auch Alterung, Verschmutzung, Schwankungen

in der Stromversorgung oder in dem Verhalten elektronischer Geräte können für den

Ausfall von Messstationen verantwortlich sein. Eine ungenaue Kalibrierung der

Messgeräte kann ebenfalls zu Fehlern innerhalb der Zeitreihe führen. Das Fehlen von

Messwerten kann auch durch das Über- oder Unterschreitung der Messgrenzen des

Messinstrumentes erklärt werden, wie zum Beispiel bei einer automatische

Pegelmessstation, die bei Hochwasser per Hand abgelesen werden muss. Neben all den

technischen Gründen kommen auch andere Ursache für unzuverlässige Daten in Frage.

Hierzu gehört der Wechsel des Beobachters, eine Zeitänderung der Beobachtung oder bei

einer Klimastation das Baumwachstum in unmittelbarer Umgebung, die Veränderung des

24

2 Grundlagen

Wasserangebotes oder der Vegetation in unmittelbarer Nähe der Messstation (vgl. ALLEN ET

AL. 1998). Auch die Tatsache, dass die Daten noch nicht digitalisiert verfügbar sind, kann

ein Grund für Datenlücken sein. Die Folge von systematischen Messfehlern sind

Inhomogenitäten in den Zeitreihen, die durch verschiedene Homogenitäts- und

Plausibilitätstests erkannt und durch spezielle Verfahren ausgebessert oder als Fehlwert

markiert werden können.

Auch politische oder gesellschaftliche Ereignisse können zu größeren Lücken innerhalb