Entwurf, Realisierung und Betrieb einer temporalen Erweiterung von

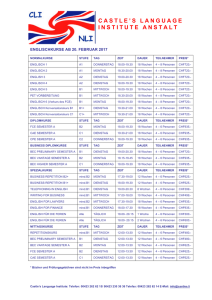

Werbung

Fakultät für Elektrotechnik und Informatik

Institut für Praktische Informatik

Fachgebiet Datenbanken und Informationssysteme

Entwurf, Realisierung und Betrieb

einer temporalen Erweiterung

von relationalen Datenbanken

Masterarbeit

im Studiengang Informatik

Marcell Salvage

Matrikelnummer: 2946190

Prüfer: Prof. Dr. Udo Lipeck

Zweitprüfer: Dr. Hans Hermann Brüggemann

Betreuer: Prof. Dr. Udo Lipeck

20.04.2015

Inhaltsverzeichnis

1 Einleitung

1.1 Motivation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.2 Ziel und Aufbau . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2 Grundlagen

2.1 Temporale Daten . . . .

2.1.1 Zeitmodelle . . .

2.1.2 Zeitpunkte . . . .

2.1.3 Zeitintervalle . .

2.1.4 Zeitspannen . . .

2.1.5 Zeitdimensionen .

2.2 PostgreSQL . . . . . . .

2.2.1 Extensions . . . .

2.2.2 Datentyp Range .

2.3 Bison & Flex . . . . . .

1

1

2

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4

4

4

5

6

12

12

13

13

16

19

3 Temporale Tabellen

3.1 Valid Time-Tabellen . . . . . . . . . . . .

3.1.1 Anforderungskatalog: Constraints .

3.1.2 Anforderungskatalog: Anfragen . .

3.1.3 Anforderungskatalog: Modifikation

3.2 Transaction Time-Tabellen . . . . . . . . .

3.3 Bitemporale Tabellen . . . . . . . . . . . .

3.4 Herausforderungen & Probleme . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

24

24

25

28

30

34

36

36

4 Temporale Datenbanksprachen

4.1 TSQL2 . . . . . . . . . . . . . . .

4.2 SQL:2011 . . . . . . . . . . . . .

4.2.1 Valid Time-Tabellen . . .

4.2.2 Transaction Time-Tabellen

4.2.3 Bitemporal-Tabellen . . .

4.3 VTSQL2+ . . . . . . . . . . . . .

4.4 Evaluation . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

38

38

41

42

45

48

48

52

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

III

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

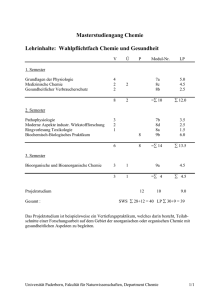

5 Entwurf und Implementierung

5.1 SQL-Erweiterung . . . . . . . . . . . .

5.1.1 DDL/DML-Kommandos . . . .

5.1.2 Anfragen . . . . . . . . . . . . .

5.2 Funktionen der PostgreSQL Extension

5.2.1 Allen-Relationships-Funktionen

5.2.2 Funktionen für DDL/DML . . .

5.2.3 Trigger . . . . . . . . . . . . . .

5.2.4 Anfrage-Hilfsfunktionen . . . .

5.3 Übersetzung der SQL-Erweiterung . . .

5.3.1 Parser . . . . . . . . . . . . . .

5.3.2 Abstract Syntax Tree (AST) . .

5.3.3 Übersetzung . . . . . . . . . . .

5.4 PHP-Interface . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

54

55

55

58

59

60

61

62

66

67

68

68

69

78

6 Beispieldatenbank Modulkatalog

6.1 Datentyp Semester . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.2 Studiengänge und Kompetenzbereiche . . . . . . . . . . . . . . . . . . . .

6.3 Lehrveranstaltungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

81

82

83

85

7 Fazit & Ausblick

87

A PostgreSQL-Extension:

Datentyp Semester

89

Abbildungsverzeichnis

95

Tabellenverzeichnis

97

Literaturverzeichnis

99

IV

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Kapitel 1

Einleitung

Entwurf, Realisierung und Betrieb einer temporalen Erweiterung; das sind 3 Aufgaben,

welche historisch bereits viele Male angegangen wurden. In der Einleitung soll zunächst

mithilfe der Motivation dargestellt werden, warum vorliegende Ausarbeitung dieses Thema

aufgreift. Nach der Motivation wird die Struktur in kurzen Sätzen dargestellt. Dadurch

wird ersichtlich, in welchem Kapitel die Aufgaben aufgegriffen und gelöst werden.

1.1

Motivation

Die Vergangenheit und Zukunft gehören zu Datenbanken wie die Gegenwart, jedoch

liefern die üblichen relationalen DBMS kaum Unterstützung, temporale Datenbanken

zu pflegen. Versuche, temporale Elemente in den SQL-Standard zu integrieren, gab es

schon vor 20 Jahren, genauer genommen seit 1994. Es wurde eine Initiative gegründet,

angeführt von Snodgrass, um SQL mit temporalen Elementen zu erweitern. 1992 gab es

bereits Diskussionen in der Community und nach einem Vorschlag von Snodgrass wurde

ein Komitee gegründet, welches mit der Entwicklung von TSQL21 beauftragt wurde. Die

Sprache versank etwas in Vergessenheit, bis der SQL-Standard SQL:2011 das Thema

erneut aufgegriffen hat, jedoch gibt es immer noch keine Einigung über die tatsächliche

Realisierung der einzelnen Bestandteile. Viele Unternehmen speichern historische Daten

auf ihre eigene Weise, so dass Interoperabilität zwischen den Daten ausgeschlossen ist. Es

besteht ein großer Markt für die Verwaltung temporaler Daten aller Art, insbesondere,

wenn sie transparent und über einen langen Zeitraum geschehen soll.

Ein Beispielszenario für temporale Daten ist, wie in der Literatur oft erwähnt, eine Datenbank über Beschäftigungsverhältnisse. Beschäftigungsverhältnisse verändern

sich über einen Zeitraum, Mitarbeiter wechseln ihre Position im Unternehmen und es

verändern sich Arbeitsumstände, wie Gehalt oder auch Beziehungen wie der Manager

einer Abteilung, der für diverse Angestellte verantwortlich ist. Ein anderes Szenario

fernab der gängigen Literatur, auf das in dieser Ausarbeitung eingegangen wird, ist

die Verwaltung von Veranstaltungen in Studiengängen in einem Online-Modulkatalog.

Dort wird festgehalten, welche Veranstaltungen in dem aktuellen Semester angeboten

1

Eine SQL-92 Erweiterung, näher beschrieben in Kapitel 4.1

1

werden, einschließlich ihrer Eigenschaften, wie Semesterwochenstunden, Leistungspunkte,

Beschreibung, Lehrkraft und vielen weiteren. Jedoch interessiert häufig nicht nur der

aktuelle Zustand. Studenten in späteren Semestern referenzieren ältere Veranstaltungen,

spätestens bei ihrem Abschluss auf dem Abschlusszeugnis. Oft wechseln angebotene

Veranstaltungen oder sie verschwinden gar vollständig. Trotzdem dürfen Informationen

über sie nicht verloren gehen, sie bleiben historisch relevant. Außerdem interessieren

Veranstaltungen aus dem vorherigen Semester, wenn Nachholtermine für Prüfungen

angeboten werden. Andere Beispiele für temporale Daten sind Data Warehouses und

das Bankenwesen. Dort werden sie auch regelmäßig für Analyseverfahren angefragt und

ausgewertet.

Diese Ausarbeitung befasst sich mit den Forschungsergebnissen der letzten Jahre im

Zusammenhang mit aktuellen Erkenntnissen und Technologien, um eine Schnittstelle zu

erstellen, welche die genannte Erfassung und Verwaltung temporaler Daten vereinfacht

und unterstützt. Zusätzlich soll sie ohne große Schwierigkeiten in ein bestehendes Datenbanksystem integriert werden können und Abwärtskompatibilität zu der bisherigen

Schnittstelle gewährleisten. So soll es einfach möglich sein, ein bisheriges Schema mit

wenigen Modifikationen zu temporalisieren und, wenn nötig, temporale Daten abzufragen,

wenn diese benötigt werden. Das gewährleistet höchste Kompatibilität mit bekannten

Schnittstellen und trotzdem Flexibilität. Dafür werden PostgreSQL-Extensions verwendet,

welche mit einem Parser eine abwärtskompatible Erweiterung von SQL lesen und mit der

Extension Informationen austauschen.

1.2

Ziel und Aufbau

Nach der Einleitung im ersten Kapitel werden im zweiten Kapitel die nötigen Grundlagen

erläutert, die eine temporale Datenhaltung erst möglich machen. Zu den Grundlagen

gehören zunächst Grundbegriffe der temporalen Datenhaltung wie die existierenden

Zeitmodelle, verschiedene Zeittypen wie beispielsweise Zeitpunkte und Zeitintervalle

sowie die Zeitdimensionen, das heißt Valid Time und Transaction Time. Zusätzlich

werden in den nachfolgenden Unterkapiteln die verwendeten Technologien beschrieben,

PostgreSQL sowie die Entwicklung von Extensions und Bison und Flex für die Erstellung

eines Parsergenerators.

Das dritte Kapitel bespricht die verschiedenen Arten von temporalen Tabellen und

welche Probleme und Herausforderungen dazukommen, wenn die Entscheidung für eine

temporale Datenbasis getroffen wird. Anhand von Beispielen werden temporale Aktionen

gezeigt und die Lösung in SQL implementiert dargestellt. Das gilt als Grundlage für die

im Kapitel 5 gezeigte Implementierung.

Im vierten Kapitel werden vergangene temporale SQL-Erweiterungen des SQLStandards betrachtet, um eine Basis für die in der Ausarbeitung entwickelte SQLErweiterung zu schaffen. Dafür werden Beispiele für übliche Aktionen dargestellt und

anschließend die Sprachen in ihrer Funktionalität evaluiert. Die Erkenntnisse aus diesem

Kapitel fließen in die Entwicklung der SQL-Erweiterung dieser Ausarbeitung mit ein.

Anschließend wird im fünften Kapitel der Entwurf der drei Bestandteile der ent-

2

wickelten DB-Erweiterung erklärt. Als erstes wird der Aufbau der Erweiterung des

SQL-Standards vorgestellt. Dafür wird gezeigt, welche neuen Schlüsselwörter hinzugekommen sind und wie die neue Semantik der einzelnen SQL-Anfragen ist. Danach wird

die PostgreSQL-Extension entworfen, welche die benötigten Funktionen und Trigger

erklärt. Dabei wird dargestellt, welche Methoden in welchem Teil der SQL-Erweiterung

benutzt werden und anhand von Beispielen ihre Funktionalität beschrieben. Im letzten

Teil des Kapitels wird die Übersetzung der SQL-Erweiterung in Standard-SQL anhand

von Beispielen gezeigt. Dafür wird der benötigte abstrakte Syntaxbaum und wie er in

der Übersetzung benutzt wird beschrieben.

Im sechsten Kapitel findet eine Testimplementierung einer temporalen Datenbank mit

Hilfe der entwickelten Bausteine statt. Dafür wird der momentan vorhandene Modulkatalog der Fakultät mit den entwickelten Konzepten neu aufgebaut. Anschließend werden

die Unterschiede analysiert und die Daten überführt. An die entstehende Datenbank

werden analog passende Anfragen gestellt, die den Anforderungen an den Modulkatalog

angepasst sind.

Den Abschluss der Arbeit bildet das Fazit, welches die Ergebnisse zusammenfasst

und auf mögliche weitere Bestandteile der Erweiterung von SQL hinweist.

3

Kapitel 2

Grundlagen

Im folgenden Kapitel werden nötige Grundlagen für den Aufbau der Erweiterung beschrieben. Dabei ist es wichtig zunächst die Bestandteile von temporalen Daten im Allgemeinen

kennen zu lernen, um den Aufbau von temporalen Datenbanken und Datenbanksprachen

verstehen zu können. Anschließend wird eine kleine Einführung in PostgreSQL mit Fokus

auf Extensions und dem Datentyp Range gegeben.

2.1

Temporale Daten

Temporale Daten sind Informationen, welche mit Zeitangaben abgespeichert werden.

Dieser Vorgang, Daten mit einem Zeitstempel zu versehen und anschließend mit dieser

Angabe abzuspeichern, klingt vorerst einfach. Dabei entstehen jedoch zusätzliche Anforderungen und Probleme. Nachfolgend wird zunächst die Zeit im Allgemeinen erklärt; welche

Formen von Zeit existieren? Anschließend werden die verschiedenen Zeitdimensionen

betrachtet. Dadurch entsteht ein Überblick der Arten von temporalen Tabellen, die in

der Literatur besprochen werden.

2.1.1

Zeitmodelle

Zeitmodelle sind ein Bestandteil von temporalen Informationen. Sie beschreiben die

Beschaffenheit von Zeit in den Daten. In [TYT11] wird zwischen drei verschiedenen

Modellen unterschieden. Das Modell, welches der Realität am nächsten kommt, ist das

kontinuierliche Modell. Dort ist jeder Zeitpunkt mit einer reellen Zahl dargestellt. Dieses

Modell hat eine hohe Genauigkeit, ist jedoch dank der Gegebenheit von Computern

immer mit Verlust verbunden. In der Realität wird dieses Modell selten eingesetzt. Im

diskreten Modell wird die Zeit in Chronons (näher beschrieben in Kapitel 2.1.2) unterteilt,

zum Beispiel Kalendermonate oder Jahre. So gibt es in diesem Modell für jedes Chronon

genau einen Abschnitt. Ein drittes Modell ist das nicht-temporale Modell, welches Daten

mit Zeit beinhaltet, die nicht durch ihre Zeit identifiziert werden, zum Beispiel das

Geburtsdatum. In temporalen Datenbanken beschäftigen wir uns mit dem diskreten

Modell, da es sich für die Abbildung von Daten mit temporalen Eigenschaften am besten

4

eignet und Anfragen sich logischer gestalten lassen, wie man in den nächsten Kapiteln

über die Zeitpunkte und Zeitintervalle sehen kann.

2.1.2

Zeitpunkte

Zeitpunkte, wie in [JW10] beschrieben, sind eine Momentaufnahme der Zeit. Sie beschreiben ein Chronon in der Zeitlinie. Verschiedene Zeitpunkte können nicht nur unterschiedliche Punkte in der Zeitlinie darstellen, es gibt auch Optionen, die bestimmen wie fein die

Zeit abgebildet wird. Diese Feinheit der Zeit bezeichnet man als Granularität. Beispiele

für solche Granularitäten sind Tage, Kalendermonate oder Jahre. So wäre ein Zeitpunkt

2012 mit der Granularität Jahr behaftet, 2012-04-04 12:30:50 hätte die Granularität

Sekunde. Die kleinste darstellbare Zeit, die sich mit einer angegebenen Granularität

darstellen lässt, heißt Chronon. So ist das Chronon vom gegebenen Zeitpunkt 2012 genau

ein Jahr. Dieses Jahr lässt sich nicht teilen, das heißt, wenn zwei Ereignisse in 2012

passiert sind, lassen sie sich nicht mit unterschiedlichen Zeitpunkten in der Granularität

Jahr darstellen. Es existieren auch Granularitäten, die nur in bestimmten Domänen

sinnvoll sind. So wird im Modulkatalog die Granularität eines Semesters gewählt, da

die Gültigkeit der einzelnen Elemente sich innerhalb eines Semesters nicht verändern.

Weitere Beispiele für ungewöhnliche, aber dennoch mögliche Granularitäten, wären eine

Dekade (10 Jahre) oder ein Trimester, welches auch im akademischen Raum benutzt

wird.

Zu den Zeitpunkten mit Granularitätsangaben kommt zudem noch das Problem

der Konvertierung zwischen verschiedenen Granularitäten. In welcher Beziehung stehen

zwei Zeitpunkte mit unterschiedlicher Granularität? Ist der Zeitpunkt 2014-03-20 in der

Granularität Tag vor oder nach dem Zeitpunkt 2014 mit der Granularität Jahr? Auch

die Frage, wie man eine Konvertierung bei kleiner werdender Granularität vornimmt,

kommt dabei auf. Wenn man genau definieren würde, dass bei der Konvertierung von

Jahr zu Tag der Zeitpunkt 2012 den Zeitpunkt 2012-01-01 repräsentieren würde, wäre

das vorher genannte Problem gelöst. Verschiedene DBMS verfahren in diesem Fall jedoch

unterschiedlich. Interessant wird es auch bei ungewöhnlichen Granularitäten, wie dem

zuvor genannten Semester, da der Semesteranfang sowohl von Hochschule zu Hochschule,

als auch von Jahr zu Jahr unterschiedlich ist. Es gibt somit keine genaue Einteilung

und es kann nicht mit Sicherheit gesagt werden, dass ein Semester exakt 6 Monate nach

dem letzten startet. Es ist nicht einmal klar, an welchem Wochentag es startet. In dem

Fall müsste man eine Interoperabilität mit Zeitpunkten mit anderen Granularitäten wie

beispielsweise einem Tag ausschließen.

Doch das ist nicht das einzige Problem. Zusätzlich kommen noch die Zeitzonen hinzu,

die insbesondere beim Austausch von Daten mit einer Granularität von Stunden und

feiner eine große Rolle spielen. So gelten zwischen Zeitzonen verschiedene Konventionen

und es existieren verschiedene Annahmen über die Zeit in einem Jahr, wie die Sommerzeit

und Winterzeit. Des Weiteren enthalten Zeitberechnungen wesentlich größere Probleme

als man zunächst annimmt Als Beispiel sei ein astronomisches Element in einer Datenbank

5

vermerkt, von dem wir wissen, dass es nach exakt einem Sonnenjahr1 erneut auftreten

wird. So würde es nicht reichen, lediglich das Jahr um eins zu erhöhen, da ein Sonnenjahr

länger als ein Jahr, approximiert etwa 365.242190417 Tage, lang ist. Zeitberechnungen

sind genau deshalb nicht trivial und man sollte bei der Implementierung solcher Systeme

auf domänenspezifische Anforderungen an die Zeit Rücksicht nehmen. Beispielsweise

sollte man sich beim Austausch zwischen Zeitzonen auf eine Zeitzone festlegen, die in

der Datenbank physikalisch gespeichert wird und bei der Ausgabe bei Bedarf zurück

konvertiert wird.

2.1.3

Zeitintervalle

Zeitintervalle eignen sich für die Beschreibung von zeitlich verankerten Zeiträumen, die

Vergangenheit, Gegenwart oder Zukunft umfassen. Sie beinhalten einen Anfangs- und

einen Endzeitpunkt. Dabei gibt es 4 verschiedene Arten, ein Zeitintervall darzustellen; [],

[), (] und (), wobei eine runde Klammer ein offenes Ende symbolisiert, das heißt,

dass der angegebene Zeitpunkt nicht im Intervall enthalten ist. Analog stehen eckige

Klammern für ein geschlossenes Ende, welches den angegeben Zeitpunkt miteinbezieht.

Als Beispiel würde das Zeitintervall [2014-01-01,2015-01-01) das ganze Jahr

2014 beschreiben, wohingegen [2014-01-01,2015-01-01] das ganze Jahr 2014 mit

zusätzlich dem 01.01.2015 beschreiben würde.

Für diese Ausarbeitung sind [) oder (]-Intervalle am besten geeignet, da sie die Darstellung von mehreren benachbarten Intervallen vereinfachen. Bei der Intervalldarstellung

gilt: wenn der Endzeitpunkt vom ersten Intervall identisch mit dem Anfangszeitpunkt

des zweiten Intervalls ist, lassen sich beide zu einem zusammenfassen. So ergeben die

Intervalle [2014-01-01,2014-06-01) und [2014-06-01,2015-01-01) zusammengefasst [2014-01-01,2015-01-01). Dieses Beispiel zeigt ein weiteres Problem

der []-Notation; ergeben zwei benachbarte Intervalle ein zusammengefasstes Intervall oder

existieren zwischen ihnen noch relevante Zeitpunkte? Es lässt sich nicht mit Bestimmtheit sagen, dass [2014-01-01,2014-05-31] und [2014-06-01,2015-01-01]

zusammengefasst [2014-01-01,2015-01-01) ergeben, da zwischen den Intervallen

noch Zeit liegt. [) oder (]-Intervalle erleichtern somit Operationen für den Zusammenschluss von Intervallen und die Temporalisierung von Daten. Zur Vereinfachung wird

in den folgenden Kapiteln ausschließlich [) verwendet, obwohl (] analog funktioniert.

Bis zum Ende der Zeit, oder auch 9999-12-31

In Zeitintervallen wird zusätzlich ein Konstrukt benötigt, das einen Zeitraum beschreibt,

welcher sich von einem festen Zeitpunkt aus erstreckt und bis an das Ende der Zeit

reicht. Das heißt, jeder Zeitpunkt ab dem Startzeitpunkt ist in diesem Intervall enthalten.

Dieses Konstrukt wird benötigt, wenn ein Zustand eines Objektes beschrieben wird,

von dem nicht bekannt ist, wann er ungültig ist. Es ist nicht bekannt, wann sich dieses

Objekt verändern wird. Darüber hinaus ist nicht bekannt, ob sich das Objekt jemals

1

Zeitraum, innerhalb dessen die Erde alle Jahreszeiten durchläuft

6

verändern wird. Deshalb wird ein Endzeitpunkt eingeführt, der eben dies bedeuten

soll. In der Literatur wird dieser Endzeitpunkt unterschiedlich genannt; in [JW10] wird

9999-12-31 benutzt, das heißt das Ende dieses Dekamillenniums. In [TYT11] wird dieser

Endzeitpunkt mit UC gekennzeichnet. Auch der Begriff FOREVER tritt in einigen Werken

auf. In PostgreSQL ist es möglich, den Start- und/oder Endzeitpunkt leer zu lassen, um

ebendies zu erreichen.

Now

Now beschreibt den Zeitpunkt, in dem die Funktion aufgerufen wird. So würde der

Zugriff auf Now am 2015-04-20 um 13:50:34 genau diesen Zeitpunkt ausgeben und eine

Sekunde später den selben Zeitpunkt um eine Sekundenzahl erhöht. Die Funktion ist

also vom Zeitpunkt des Aufrufes abhängig. Verschiedene DBMS nennen diese Funktion

unterschiedlich, so ist in PostgreSQL ein Now() üblich, der SQL Standard beschreibt

die Funktion mit CURRENT_TIMESTAMP und diversen anderen Funktionen seit der

Standardversion SQL2008. So gibt CURRENT_TIMESTAMP den momentanen Zeitpunkt

mitsamt Zeitzonen-Informationen zurück. Zusätzlich existiert CURRENT_DATE, welches

das Datum ohne Tageszeitangabe zurückgibt. Die Funkion LOCAL-TIME stellt dagegen

den Zeitpunkt ohne Zeitzonen-Informationen dar. In älteren DBMS nannte man diese

Funktion auch getdate().

Die Now-Funktion wird in der temporalen Datenhaltung für mehrere Aspekte benötigt.

So müssen in der Transaktionszeit bei einer erfolgreich abgeschlossenen Transaktion die

Tabellenspalten, die verändert oder gelöscht wurden, archiviert werden. Dabei wird bei

der Transaktionszeit angegeben, dass die Tabellen nun nur noch bis Now gelten und

gegebenenfalls die neuen Spalten zum Zeitpunkt der Transaktion ab dem Zeitpunkt Now

gelten. Auch bei der Gültigkeitszeit benötigt man das, wenn man ausdrücken will, dass

ein bestimmter Umstand ab jetzt nicht mehr gilt.

Die bereits im Kapitel für die Zeitintervalle 2.1.3 besprochenen Zeitzonen stellen auch

für Now ein Problem dar. So muss, je nach Implementierungsentscheidung, Now stets in

eine vorher definierte Zeitzone umgewandelt werden, um mit dem Rest der Datenbank

konform zu sein, insbesondere wenn die gewählte Granularität sehr fein ist.

Allen-Relationen zwischen Zeitintervallen

Allen-Relationships wurden zuerst 1983 im Artikel [All83] von James F. Allen erläutert.

Sie beschreiben die Beziehungen zwischen Zeitintervallen auf einer gemeinsamen Zeitlinie.

In der Tabelle 2.1 werden die 11 Beziehungen erläutert. Dabei sind t1 und t2 Zeitintervalle. Die linke Spalte zeigt eine Funktion mit zwei Zeitintervallen als Argumente, die

einen Wahrheitswert zurückgibt. Die rechte Spalte beschreibt, wann die Funktion den

Wahrheitswert true oder false zurückgibt.

In der Abbildung 2.1 findet sich eine grafische Erklärung der Beziehungen. Auf dieser

Grafik sind auch die Paare der Relationen R, S mit R(t1 , t2 ) ⇔ S(t2 , t1 ) zu erkennen. So

gilt, dass Before mithilfe des Vertauschens von Argumenten After darstellen kann. Es

7

gilt somit Before(t1 , t2 ) ⇔ After(t2 , t1 ). Analog gilt dasselbe für die anderen gegenübergestellten Beziehungen. Equals ist kommutativ, also Equals(t1 , t2 ) ⇔ Equals(t2 , t1 ).

In der Abbildung 2.2 wird eine Einteilung mittels einer Baumstruktur vorgenommen.

Dabei sind die Blätter des Baums die in der Tabelle 2.1 vorgestellten Relationships

(jeweils eine übersetzbare Relationship pro Paar). Die restlichen Knoten sind von [JW10]

zusätzlich hinzugefügte allgemeine Beziehungen zwischen Zeitintervallen. Entweder sie

schneiden sich und besitzen somit eindeutige gemeinsame Punkte, oder sie schneiden

sich nicht und es besteht kein gemeinsamer Punkt. Bei zwei nicht schneidenden gibt es

außerdem die Unterscheidung zwischen berührenden und nicht berührenden Intervallen.

Bei geschnittenen Intervallen gibt es die Unterscheidung, ob sie auch noch nicht gemeinsame Punkte haben. Wenn sie nur noch gemeinsame Punkte haben, kann zusätzlich

unterschieden werden, ob sie identisch sind und eines der Intervalle lediglich ein Teil des

anderen ist. Bei Teilintervallen wird außerdem danach unterschieden, ob sie am Anfang

oder Ende des Intervalls oder irgendwo in der Mitte liegen.

Before(t1 , t2 )

After(t1 , t2 )

During(t1 , t2 )

Contains(t1 , t2 )

Overlaps(t1 , t2 )

Overlapped-by(t1 , t2 )

Meets(t1 , t2 )

Met-by(t1 , t2 )

Starts(t1 , t2 )

Started-by(t1 , t2 )

Finishes(t1 , t2 )

Finished-by(t1 , t2 )

Equals(t1 , t2 )

t1 tritt vor t2 auf und die Zeitintervalle haben keine gemeinsamen Zeitpunkte

t2 tritt vor t1 auf und die Zeitintervalle haben keine gemeinsamen Zeitpunkte

Intervall t1 startet nach dem Anfangszeitpunkt von t2 und

endet vor dem Endzeitpunkt von t2

Intervall t2 startet nach dem Anfangszeitpunkt von t1 und

endet vor dem Endzeitpunkt von t1

Intervall t1 startet vor dem Anfangszeitpunkt von t2 und endet

zwischen dem Anfangs- und Endzeitpunkt von t2

Intervall t2 startet vor dem Anfangszeitpunkt von t1 und endet

zwischen dem Anfangs- und Endzeitpunkt von t1

Endzeitpunkt von t1 ist identisch mit dem Anfangszeitpunkt

von t2

Endzeitpunkt von t2 ist identisch mit dem Anfangszeitpunkt

von t1

t1 und t2 haben den gleichen Anfangszeitpunkt und t1 endet

vor t2

t1 und t2 haben den gleichen Anfangszeitpunkt und t2 endet

vor t1

t1 und t2 haben den gleichen Endzeitpunkt und t1 startet nach

t2

t2 und t1 haben den gleichen Endzeitpunkt und t2 startet nach

t1

t2 und t1 haben den gleichen Anfangs- und Endzeitpunkt

Tabelle 2.1: Die 13 Relationen zwischen Zeitintervallen nach James F. Allen

8

Abbildung 2.1: Darstellung der Relationen in Tabelle 2.1 (Grafik entnommen aus [TYT11])

Relationen zwischen Punkt und Intervall

Neben den Relationen zwischen Zeitintervallen sind auch Relationen zwischen Zeitpunkten

und Intervallen für die Entwicklung der temporalen Datenbank von Interesse. Diese sind

beschrieben in [TYT11]. Dabei sind diese Relationen eine Spezialisierung der gegebenen

13 Relationships nach Allen. Ein Punkt ist lediglich ein Intervall mit der Größe eines

Chronons seiner Granularität. Das heißt ein Intervall [2014-03-20, 2014-03-21)

oder auch [2014-03-20, 2014-03-20], gegeben die Granularität eines Tages, ist

gleichbedeutend mit dem Zeitpunkt 2014-03-20. Wenn nun die 13 Relationships auf ein

Intervall mit einer Größe > 1 angewendet werden, bleiben nur noch wenige übrig, da

andere niemals erfüllt werden können. So gibt es kein Overlaps und Overlapped-by, da

dafür ein Intervall außerhalb und innerhalb des anderen vorhanden sein muss. Das ist

bei einem Intervall mit der Größe 1 nicht möglich. Started-by und Finished-by haben

ebenfalls keinen Nutzen mehr, da ein Zeitpunkt nicht von einem Intervall gestartet

beziehungsweise abgeschlossen werden kann. Contains ist zusätzlich ausgeschlossen, da

ein größeres Intervall nicht in ein kleineres passt. Zudem ist Equals ausgeschlossen, da

die beiden Intervalle nicht die gleiche Größe besitzen können. In der Tabelle 2.2 sind

9

Abbildung 2.2: Taxonomie der Allen-Relationships (Grafik entnommen aus [JW10])

alle übrigen Relationships vermerkt. Dabei fällt auf, dass nun auch einige Relationships

durch die Einschränkung eines Intervalls identisch sind; so ist Meets dasselbe wie Starts

und analog Met-by dasselbe wie Finishes. In der Abbildung 2.3 findet sich eine grafische

Veranschaulichung, ähnlich wie bei der Abbildung 2.1, für die Relationen zwischen den

Intervallen.

Diese werden benötigt, um Anfragen an die Datenbank zu stellen. Eine häufige Anfrage an eine Valid Time-Tabelle ist: Welche Daten galten zum Zeitpunkt t? Dafür eignet

sich During, da es genau das beschreibt; ist der Zeitpunkt im gegebenen Zeitintervall

enthalten? Wenn er enthalten ist, so war der Datensatz zu diesem Zeitpunkt gültig und

kann ausgegeben werden. Andere Anfragen benutzen die beschriebenen Relationships

analog; auch bei Transaction Time-Tabellen. So lässt sich die Frage Welche Datensätze

wurden exakt zum Zeitpunkt t ungültig gemacht? mithilfe der Finishes-Relation ausdrücken. Weitere Einsatzzwecke für die Relationen finden sich im Kapitel Entwurf und

Implementierung.

Before(p, t)

After(p, t)

Meets(p, t)

Starts(p, t)

Met-by(p, t)

Finishes(p, t)

During(p, t)

Punkt p ist vor dem Anfangszeitpunkt von t

Punkt p ist nach dem Endzeitpunkt von t

Der Anfangszeitpunkt von t und Punkt p sind identisch

Der Endzeitpunkt von t und Punkt p sind identisch

Punkt p ist zwischen dem Anfangs- und Endzeitpunkt von t

Tabelle 2.2: Temporale Relationen zwischen Zeitpunkt und Zeitintervall

10

Abbildung 2.3: Darstellung der Relationen in Tabelle 2.2 (Grafik entnommen aus [TYT11])

Relationen zwischen zwei Punkten

Die Relationen lassen sich noch weiter spezialisieren, indem man die Einschränkungen aus

dem vorherigen Unterkapitel auf beide Intervalle anwendet, so dass beide Intervalle die

Größe 1 haben. Dadurch entsteht eine Gruppe von Relationen zwischen zwei Zeitpunkten.

Diese sind recht mühelos zu verstehen, da sie identisch zu den üblichen Vergleichsoperatoren sind; =, <, >. Sie lassen sich ähnlich wie die Relationen aus dem vorherigen

Unterkapitel ableiten, indem in die Relationen zwei Intervalle der Länge 1 eingesetzt

werden. In der Tabelle 2.3 sind die drei Relationen analog beschrieben. Dabei sind p und

q jeweils Zeitpunkte. Die Abbildung 2.4 zeigt eine grafische Veranschaulichung.

Before(p, q)

After(p, q)

Equals(p, q)

Punkt p ist vor dem Punkt q

Punkt p ist nach dem Punkt q

Punkt p und Punkt q sind identisch

Tabelle 2.3: Temporale Relationen zwischen zwei Zeitpunkten

Abbildung 2.4: Darstellung der Relationen in Tabelle 2.3 (Grafik entnommen aus [TYT11])

11

2.1.4

Zeitspannen

Eine Zeitspanne beschreibt einen nicht verankerten Zeitraum wie 1 Tag oder 4 Wochen.

Mit ihnen lässt sich der Unterschied zwischen zwei Zeitpunkten feststellen oder aus

einem bestehenden Zeitpunkt ein neuer Zeitpunkt erstellen. So ergibt der Zeitpunkt

2014-04-01 mit der Zeitspanne 1 Tag den Zeitpunkt 2014-04-02. Im SQL-92 wurde

ein Datentyp verabschiedet, der einer Zeitspanne entsprechen sollte; das INTERVAL.

Das sei nicht mit dem zuvor besprochenen Zeitintervall zu verwechseln. Der Datentyp

wurde mit einer ganzen Reihe anderer Datentypen eingeführt, beispielsweise dem DATE,

TIME und TIMESTAMP, alles Datentypen, welche die Abspeicherung von Zeit über den

Standard ermöglichen.

2.1.5

Zeitdimensionen

In der temporalen Datenhaltung existieren unterschiedliche Zeitdimensionen, die jeweils

eine andere Bedeutung im Kontext der Speicherung, Verwaltung und Abfrage der Daten

haben. Zuerst vorgestellt wurden die Begriffe der Zeitdimension im Artikel [SA86].

Die Implementierung und Verwaltung der verschiedenen Zeitdimensionen und ihrer

Kombinationen unterscheidet sich untereinander erheblich und muss deshalb gesondert

betrachtet werden.

Valid Time

Valid Time, auch Application Time oder Effective Time2 in Englisch oder Gültigkeitszeit

in Deutsch, beschreibt die Gültigkeit von Objekten in der entworfenen Welt. Valid Time

beschreibt das, was wir glauben, was in der modellierten Welt zu den abgebildeten Zeiten

wahr ist. Bei dem Entwurf einer Datenbank, wo sich Objekte und ihre Beziehungen über

die Zeit hinweg verändern, ist oft die Vergangenheit und Zukunft genauso interessant wie

die Gegenwart. Daher werden Objekte mit ihrer Valid Time abgespeichert und das heißt

auch, dass sie nun mehrmals in einer Tabelle, für verschiedene Zeiträume, vorkommen

können.

Transaction Time

Transaction Time, auch System Versioned oder Asserted Versioning in Englisch oder

Transaktionszeit in Deutsch, wird, ähnlich wie die Valid Time, in Tabellen mithilfe eines

Versionsstempels an den Datensätzen abgebildet. Sie bedeuten jedoch etwas anderes; sie

bilden ab, wie die Datenbank zu den angegeben Zeitpunkten beschaffen war. Transaktionszeit erläutert demnach, was wir glaubten, was für die modellierte Welt wahr war. Bei

der Valid Time ist es möglich, auch zukünftige und vergangene Datensätze zu editieren,

um Annahmen zu korrigieren oder zu erweitern, wohingegen dies bei der Transaktionszeit

nicht erlaubt ist. Die vergangenen Datensätze werden erschaffen, wenn aktuelle verändert

werden. Eine Ausnahme stellt dabei die in [JW10] beschriebene Asserted Versioning

2

in [JW10]

12

dar, welche auch DEFERRED TRANSACTION zulässt. Damit werden Transaktionen

bezeichnet, deren Zeitintervall in der Zukunft liegen. Dies ist von Nutzen, wenn wir

abbilden wollen, dass sich unser Wissen in der Zukunft verändert, jedoch die aktuellen

Daten nicht geändert werden dürfen, auch wenn sie nicht zwangsweise korrekt sind.

Bitemporal

Bitemporal heißen Tabellen, die sowohl die Valid Time als auch die Transaction Time

eines Objekts abspeichern.

2.2

PostgreSQL

PostgreSQL ist ein quelloffenes objekt-relationales Datenbanksystem, entwickelt seit

01.05.1995. Die Software wird mit C entwickelt und wird unter der selbst entwickelten

PostgreSQL-Lizenz vertrieben. Die vorliegende Ausarbeitung wird PostgreSQL in der

Version 9.2 verwenden. PostgreSQL wurde auf einige Betriebssysteme portiert, darunter

die üblichen Linux-Distributionen, Microsoft Windows und andere Unix-Klone wie Mac

OS X3 und BSD-Derivate. Das Projekt wird auch im kommerziellen Betrieb zahlreich

verwendet, zum Beispiel im U.S. State Department und bei Red Hat4 .

Zum Support von SQL:2011, welches im Kapitel ?? näher betrachtet wird, steht in

der Dokumentation von PostgreSQL 9.3.5 folgende Bemerkung im Kapitel Appendix D.

SQL Conformance 5 :

PostgreSQL supports most of the major features of SQL:2011. Out of 179

mandatory features required for full Core conformance, PostgreSQL conforms

to at least 160. In addition, there is a long list of supported optional features.

It might be worth noting that at the time of writing, no current version of

any database management system claims full conformance to Core SQL:2011.

Es fehlen jedoch alle im Kapitel 4.2 genannten Features. Periods lassen sich dennoch

mithilfe des Range-Datentyps simulieren.

2.2.1

Extensions

PosgreSQL ermöglicht die Programmierung von selbst definierten Funktionen und Datentypen, die in SQL benutzt werden können. Dabei werden verschiedene Programmiersprachen unterstützt, darunter C, welches die Programmiersprache ist, mit der

PostgreSQL implementiert wurde. Zusätzlich bietet PostgreSQL mithilfe von Modulen

weitere Programmiersprachen für die Entwicklung von Erweiterungen an: PL/pgSQL,

einer Sprache, die Oracles PL/SQL ähnelt, PL/TCL, PL/Python und PL/Perl. Diese

3

Seit Mac OS X 10.7 Lion sogar die Standard-Datenbank für die Server Edition und installiert auf

allen Desktop Versionen.

4

siehe http://www.postgresql.org/about/users/

5

http://www.postgresql.org/docs/9.3/static/features.html

13

Sprachen werden im Kontext der Erweiterungen prozedurale Programmiersprachen genannt und werden durch zusätzlich installierte Module gelesen, übersetzt und verarbeitet,

um für die Entwicklung zur Verfügung zu stehen. In dieser Ausarbeitung werden SQL,

C und PL/pgSQL als Programmiersprachen benutzt. Diese haben den Vorteil, dass

sie keinen zusätzlichen Interpreter auf dem Server benötigen und damit leichter auf

verschiedene PostgreSQL-Installationen zur Verfügung zu stellen sind, da C, SQL und

PL/pgSQL auf jedem PostgreSQL-System ab der Version 9.0 verfügbar sind.

Nachdem einige logisch zusammenhängende6 Funktionen, Objekte und Operatoren

geschrieben wurden, bietet PostgreSQL die Möglichkeit, diese Objekte in eine Extension

zusammenzufassen. Das hat den Vorteil, dass sie mit wenigen Befehlen auf eine andere

PostgreSQL-Installation übertragen werden kann. Man kann sie zudem leichter dokumentieren und warten und auch besser in ihren Rechten bei der Installation einschränken.

Zusätzlich ist es möglich die definierte Extension mitsamt ihrer Definitionen mit einem

einzigen Statement entfernen.

Für eine Extension werden zunächst mindestens zwei Dateien benötigt, eine Datei in

der Form <name>-<version>.sql und eine weitere in der Form <name>.control.

Diese beiden werden in das Extension-Verzeichnis von PostgreSQL verschoben und

können anschließend mit CREATE EXTENSION <name>; geladen werden. Mit einem

DROP EXTENSION <name>; kann die Extension entfernt werden. Um die Installation

zu vereinfachen, bietet sich ein Makefile an.

Das folgende Beispiel stammt aus der offiziellen Dokumentation von PostgreSQL.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

CREATE TYPE pair AS ( k text, v text );

CREATE OR REPLACE FUNCTION pair(anyelement, text)

RETURNS pair LANGUAGE SQL AS ’SELECT ROW($1, $2)::pair’;

CREATE OR REPLACE FUNCTION pair(text, anyelement)

RETURNS pair LANGUAGE SQL AS ’SELECT ROW($1, $2)::pair’;

CREATE OR REPLACE FUNCTION pair(anyelement, anyelement)

RETURNS pair LANGUAGE SQL AS ’SELECT ROW($1, $2)::pair’;

CREATE OR REPLACE FUNCTION pair(text, text)

RETURNS pair LANGUAGE SQL AS ’SELECT ROW($1, $2)::pair;’;

CREATE OPERATOR ˜> (LEFTARG = text, RIGHTARG = anyelement,

PROCEDURE = pair);

CREATE OPERATOR ˜> (LEFTARG = anyelement, RIGHTARG = text,

PROCEDURE = pair);

CREATE OPERATOR ˜> (LEFTARG = anyelement,

RIGHTARG = anyelement, PROCEDURE = pair);

CREATE OPERATOR ˜> (LEFTARG = text, RIGHTARG = text,

PROCEDURE = pair);

Quelltext 2.1: Datei: pair–1.0.sql

6

Logisch zusammenhängende Objekte sind beispielsweise eine Objektdefinition mitsamt selbstentwickelter Operatoren und Hilfsfunktionen

14

1

2

3

4

# pair extension

comment = ’A key/value pair data type’

default version = ’1.0’

relocatable = true

Quelltext 2.2: Datei: pair.control

1

2

3

4

5

6

EXTENSION = pair

DATA = pair−−1.0.sql

PG CONFIG = pg config

PGXS := $(shell $(PG CONFIG) −−pgxs)

include $(PGXS)

Quelltext 2.3: Datei: Makefile

In der pair-1.0.sql-Datei wird ein neuer Typ Pair erzeugt, der ein Paar aus

Text-Variablen als eine Einheit darstellt, das heißt ein Zweier-Tupel aus Texten. Diese

Art von Typen nennt man Composite-Types, weil sie genau das darstellen; eine Zusammensetzung aus Variablen. Für diesen Typ sind zusätzlich noch vier Funktionen

in SQL definiert worden, die als Konstruktor gelten. Mit ihnen lassen sich neue Paare

erzeugen. In den Funktionsargumenten findet man den Typ anyelement. Dies ist ein

Pseudo-Typ7 , der polymorphe Programmierung erlaubt. Damit lassen sich Funktionen

programmieren, die für mehr als einen bestimmten Datentyp gelten. Es wird erst zur

Laufzeit überprüft, ob die übergebenen Argumente mit den benutzten Operationen in der

definierten Funktion kompatibel sind und gegebenenfalls eine Fehlermeldung geworfen. Es

existieren noch weitere Pseudo-Types wie anyarray und anyrange; letzteres wird in

dieser Ausarbeitung mehrmals benutzt. Die definierten Funktionen werden anschließend

in der Datei zu überladenen Operatoren zugewiesen. Das erleichtert den Umgang mit

dem Datentyp.

In der pair.control-Datei ist ein Kommentar über die Extension vermerkt, sowie

die neueste stabile Version. Das Argument relocatable gibt an, ob sich eine Extension

ohne Probleme in ein anderes Schema verschieben lässt. Das ist nur möglich, wenn

die definierten Objekte in der Extension unabhängig vom gegebenen Schema sind. In

diesem Beispiel ist dies der Fall, dementsprechend gilt relocatable = true. Weitere

Angaben sind in der Dokumentation vermerkt.

Die dritte Datei ist der Makefile, der mithilfe der PostgreSQL-Mechanismen pg_config

die Installation von Extensions vereinfacht.

Extensions eignen sich damit für die Verteilung von Objekten mit ihren Funktionen

zwischen verschiedenen PostgreSQL-Systemen. Es ermöglicht dabei eine einfache Installation und Deinstallation. Außerdem bietet der Mechanismus noch weitere Optionen für

vereinfachte Updates an, so dass Abwärtskompatibilität gewährleistet wird. So lassen

sich mehrere Versionen einer Extension auf dem System installieren und die Datenbank

oder das Schema kann angeben, welche Version zwingend benötigt wird.

7

http://www.postgresql.org/docs/9.3/static/datatype-pseudo.html

15

2.2.2

Datentyp Range

Range ist ein in PostgreSQL integrierter Datentyp zur Darstellung von Intervallen. Diese

Intervalle haben dabei einen Start- und Endpunkt. Es ist möglich, Intervalle in den im

Kapitel 2.1.3 vorgestellten Möglichkeiten anzugeben, das heißt [], [), (] und ().

Der zugrundeliegende Datentyp kann dabei unterschiedlich sein, in PostgreSQL selbst

sind sechs Typen vordefiniert:

int4range Intervall aus Ints

(ganze Zahlen zwischen -2147483648 und +2147483647)

int8range Intervall aus Bigints

(ganze Zahlen zwischen -9223372036854775808 und 9223372036854775807)

numrange Intervall aus Numerics

(reelle Zahlen zwischen 131072 Vorkommastellen und 16383 Nachkommastellen)

tsrange Intervall aus Zeitstempeln ohne Zeitzonenangabe

tstzrange Intervall aus Zeitstempeln mit Zeitzonenangaben

daterange Intervall aus Daten

Es lassen sich mit CREATE TYPE <name> AS RANGE (<Typbeschreibung>)

weitere Range-Typen aus bestehenden Basisdatentypen definieren, da die bereits angebotenen Range-Typen nicht für jeden Einsatzzweck geeignet sind. So existieren in

temporalen Datenbanken mehr Granularitäten als die Zeitstempel und das Datum; es

existiert beispielsweise die Granularität Monat, welche mit den gegebenen Typen nicht

dargestellt werden können. In diesem Fall lassen sich selbst definierte Range-Datentypen

nutzen.

Es gibt hierbei verschiedene Möglichkeiten, eine Range zu erstellen; die erste Möglichkeit ist, die entsprechende Konstruktorfunktion aufzurufen. Diese heißt identisch

zur Bezeichnung der Range und nimmt mindestens 2, jedoch höchstens 3 Argumente

entgegen. Das erste Argument ist die untere Grenze des Intervalls, das zweite die obere

Grenze. Bei der Angabe von NULL wird der Start- oder Endpunkt auf unendlich gesetzt.

Im dritten optionalen Argument lässt sich angeben, von welcher Form das Intervall ist,

das heißt, ob der Start oder das Ende geschlossen oder offen ist. Standardmäßig hat es

die Form [). So erstellt der Aufruf int8range(3, 6) ein Intervall zwischen 3 und 6,

wobei 6 nicht enthalten ist. Dieser Aufruf ist identisch mit int8range(3, 6, ’[)’).

Für ein Intervall, in dem die 6 enthalten ist, wäre ein Aufruf mit int8range(3, 6,

’[]’) nötig. Neben dieser Möglichkeit lässt sich auch die Syntax :: von PostgreSQL

verwenden. Der ::-Operator konvertiert alles vor :: in den Typ, der nach :: angegeben

wird. So wird mit 2::float der Integer 2 in einen float 2.0 umgewandelt. Dasselbe

funktioniert auch mit Range, da dies eine Konvertierung von Strings zu Range ermöglicht.

So erstellt der Befehl ’[3, 6)’::int8range das zuerst genannte Beispiel. PostgreSQL übernimmt zusätzlich noch eine Konvertierung von [] zu [), falls der Datentyp es

16

zulässt, er also diskret ist. So wird ’[3, 6]’::int8range automatisch zu [3, 7),

wohingegen dasselbe Beispiel mit numrange statt int8range nicht dazu in der Lage

wäre, da es keine direkt benachbarte Zahl über 6 gibt, die dasselbe ausdrücken würde.

Wenn eine Range erstellt wird, können der Anfangs- und Endzeitpunkt weggelassen

werden. Sie definiert ein Intervall, bei dem entweder alle Punkte vor dem Endpunkt

oder alle Punkte nach dem Startpunkt im Intervall enthalten sind. Möglich ist auch ein

Intervall, in dem sowohl Anfangs- als auch Endpunkt weggelassen werden. Dieses Intervall

enthält alle möglichen Elemente, abhängig vom definierten Range-Typ. Es ist auch

möglich, statt dem weggelassenen Start- und Endpunkt ein infinity oder -infinity

anzugeben, wenn der Datentyp der Range so eine Notation enthält. Dabei gibt es jedoch

Unterschiede; so sind [today,] und [today,) identisch, [today,infinity] und

[today,infinity) aber unterschiedlich, da im letzteren der Wert infinity enthalten

ist, in dem davor jedoch nicht.

Für die Ausarbeitung sind insbesondere tsrange, tstzrange und daterange

interessant, da sie ein wie in Kapitel 2.1.3 besprochenes Zeitintervall darstellen und

zusätzlich noch Operationen und Indexe anbieten. So übernimmt PostgreSQL viele

Vorgänge, die sonst mühsam mithilfe von mehreren Spalten realisiert werden müssen,

wie beispielsweise den Schnitt von zwei Intervallen.

Beispiel

Es folgen nun einige Beispiele. Zunächst wird eine Tabelle erstellt, die eine Daterange

erstellt. Dabei wird ein übliches Beispiel einer Employee-Tabelle genommen, die eine

Validtime-Historie enthält. Zusätzlich existieren als Spalten der Vor- und Nachname

sowie das Jahresgehalt.

1 CREATE TABLE employee (

2 e id SERIAL,

3 first name TEXT,

4 last name TEXT,

5 salary NUMERIC,

6 vt DATERANGE,

7 PRIMARY KEY (e id, vt)

8 );

Quelltext 2.4: Employee-Tabelle mit Daterange für Validtime

Zu beachten ist dabei, dass e_id und vt den Primärschlüssel bilden, da in dieser

Tabelle mehrmals dasselbe Objekt auftreten kann, das jedoch zu unterschiedlichen Zeiträumen gilt. Nun werden einige Daten in die Tabelle eingefügt; zwei Mitarbeiter mitsamt

ihres Gehaltes, bei einem Mitarbeiter soll jedoch das Gehalt ab heute etwas höher sein.

1

2

3

4

5

INSERT INTO employee

(e id, first name, last name, salary, vt) VALUES

(1, ’Max’, ’Mustermann’, 2000, daterange(’2013−01−01’,NULL)),

(2, ’Susi’, ’Kaufgern’, 2000, ’[2013−01−01,today)’::daterange),

(2, ’Susi’, ’Kaufgern’, 3000, ’[today,)’::daterange);

Quelltext 2.5: Inserts in employee

17

Dabei sind die zwei verschiedenen Arten der Definition von Ranges zu beobachten. In

den Ranges selbst wird zusätzlich die Variable today verwendet. Diese gibt das aktuelle

Datum zurück. Nun noch eine einfache Anfrage, welche alle Mitarbeiter zurück gibt, die

momentan gültig sind.

1 SELECT e id, first name, last name, salary

2 FROM employee

3 WHERE vt @> date(’today’);

Quelltext 2.6: Snapshot von employee

Dafür wird der @>-Operator verwendet, welche überprüft, ob ein Objekt in einem

Intervall vorhanden ist. Damit lässt sich ausdrücken, ob der jetzige Zeitpunkt im Intervall

enthalten ist.

PostgreSQL bietet auch eine einfache Syntax zur Definition von Zeitpunkten an. So

lässt sich ein Datum-Intervall zwischen heute und in 12 Tagen leicht ausdrücken.

1 SELECT daterange(’today’, (now() + ’12 day’)::DATE);

2

3 Ausgabe: [2014−11−28,2014−12−10)

Quelltext 2.7: Range und Intervall

Liste der Operationen

PostgreSQL bietet mit dem Range-Datentyp noch eine Reihe nützlicher Funktionen und

Operatoren an, die sich auch für die Verarbeitung von Ranges mit Zeitpunkten eignen.

Mit ihnen lassen sich die Allen-Relationships effizient programmieren, da die Operatoren

mit optimiertem C implementiert und dabei auch Indexe beachtet wurden. In der Tabelle

2.4 sind die vordefinierten Operatoren zu entnehmen. Zusätzlich zu den Operatoren bietet

PostgreSQL noch Funktionen an, die es ermöglichen, auf die einzelnen Elemente der

Range zuzugreifen. Diese Funktionen sind in der Tabelle 2.5 vorgestellt.

18

Operator

=

<>

<

>

<=

>=

@>

@>

<@

<@

&&

<<

>>

&<

&>

-|+

*

-

Beschreibung

Gleich

Ungleich

kleiner als

größer als

kleiner gleich

größer gleich

enthält range

enthält element

range ist enthalten in

element ist enthalten in

überlappen

strikt links von

strikt rechts von

erweitert nicht rechts von

erweitert nicht links von

angrenzend

union

intersection

difference

Beispiel

int4range(1,5) = ’[1,4]’::int4range

numrange(1.1,2.2) <>numrange(1.1,2.3)

int4range(1,10) <int4range(2,3)

int4range(1,10) >int4range(1,5)

numrange(1.1,2.2) <= numrange(1.1,2.2)

numrange(1.1,2.2) >= numrange(1.1,2.0)

int4range(2,4) @>int4range(2,3)

int4range(1,55) @>42

int4range(2,4) <@ int4range(1,7)

42 <@ int4range(1,7)

int8range(3,7) && int8range(4,12)

int8range(1,10) << int8range(100,110)

int8range(50,60) >> int8range(20,30)

int8range(1,20) &<int8range(18,20)

int8range(7,20) &>int8range(5,10)

numrange(1.1,2.2) -|- numrange(2.2,3.3)

numrange(5,15) + numrange(10,20)

int8range(5,15) * int8range(10,20)

int8range(5,15) - int8range(10,20)

Ausg.

t

t

t

t

t

t

t

t

t

f

t

t

t

t

t

t

[5,20)

[10,15)

[5,10)

Tabelle 2.4: Range-Operatoren

2.3

Bison & Flex

GNU Bison ist ein quelloffener Parsergenerator, welcher mit dem älteren Yacc kompatibel

ist.8 Mit Bison lassen sich kontextfreie Grammatiken in einen Parser kompilieren. Dieser

Parser kann in den Programmiersprachen C, C++ oder Java erzeugt werden. Bison

wurde als Parsergenerator für dieses Projekt benutzt, weil ein Teil der Erweiterung in

C geschrieben ist, und Bison sich in Projekten, die in C geschrieben sind, bewährt hat.

So wird es von Ruby, PHP und von PostgreSQL selbst benutzt. Das Projekt wird Bison

benutzen, um die SQL-Erweiterung in einen abstrakten Syntaxbaum (kurz AST) zu

parsen und anschließend den AST in SQL zu übersetzen.

Zusammen mit Bison wird häufig flex benutzt, um einen Lexer9 für den Parser zu

erzeugen. flex übersetzt eine Definitionsdatei in einen Lexer in C, welcher die von Bison

benötigte yylex-Funktion zur Verfügung stellt. Die yylex-Funktion soll dabei das nächste

Token von einer Datei zurückgeben.

8

siehe https://www.gnu.org/software/bison/

Lexikalischer Scanner oder auch Tokenizer; zerlegt die Quelldatei in Token, das heißt in zusammenhängende Elemente

9

19

Funktion

lower(anyrange)

upper(anyrange)

isempty(anyrange)

lower inc(anyrange)

upper inc(anyrange)

lower inf(anyrange)

upper inf(anyrange)

Beschreibung

Startpunkt

Endpunkt

Intervall leer?

Links geschlossen?

Rechts geschlossen?

Startpunkt unendlich?

Endpunkt unendlich?

Beispiel

lower(numrange(1.1,2.2))

upper(numrange(1.1,2.2))

isempty(numrange(1.1,2.2))

lower inc(numrange(1.1,2.2))

upper inc(numrange(1.1,2.2))

lower inf(’(,)’::daterange)

upper inf(’(,)’::daterange)

Erg.

1.1

2.2

false

true

false

true

true

Tabelle 2.5: Range-Funktionen

Beispiel

In dem Beispiel wird ein Parser für eine Programmiersprache definiert, die arithmische

Ausdrücke der Form 1+1 liest und direkt auswertet. Dabei wird zunächst ein Lexer

benötigt, welcher die verschiedenen Tokens des Parsers definiert.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

%option noyywrap

%{

#include <stdlib.h>

#include <stdio.h>

#include ”calc.tab.h”

%}

%%

/∗ integers ∗/

[0−9]+ {

yylval.intval = atoi(yytext);

return NUM;

}

/∗ End of line and expression ∗/

[\n] { return END; };

/∗ operators ∗/

[+−/∗()] { return yytext[0]; }

/∗ skip whitespace and tabs ∗/

[ \t] { }

/∗ unknown characters produce error messsage ∗/

. { yyerror(”unknown character”); }

%%

Quelltext 2.8: Datei: calc.l

Die Definition eines Lexers in flex besteht aus drei Teilen, die jeweils mit %% getrennt

sind. Im Quelltext 2.8 von Zeile 1-8 ist der erste Block. Er enthält zunächst einen Abschnitt

20

welcher mit %{ eingeleitet und mit %} geschlossen wird. In ihm werden die benötigten

Header-Dateien und damit auch Bibliotheken aufgezählt, die für den Lexer benötigt

werden. In Zeile 5 ist der Header, der von Bison erstellt wird, eingebunden. Im zweiten

Block, welcher von der Zeile 9 bis zum Ende des Quelltextes reicht, werden die Regeln

der Tokens aufgezählt. Die Definition eines jeden Tokens passiert in zwei Teilen: zunächst

ein regulärer Ausdruck, welcher beschreibt, wie der Token aufgebaut ist. Als zweites ein

Codeblock, welcher aufgerufen wird, wenn der Lexer auf den Token trifft. Die Regel dieses

Lexers enthält diesmal 5 Definitionen, wovon jedoch nur 3 tatsächlich Token sind. Die

erste Definition ist ein Token, welcher ganze Zahlen repräsentiert. Eine ganze Zahl besteht

aus mindestens einer Zahl. Im Codeblock wird der Text dieses Tokens via atoi in eine

ganze Zahl umgewandelt und anschließend einer Variable, auf die Bison zugreifen kann,

zugewiesen. Nun wird noch der Typ des Tokens zurückgegeben, damit Bison zwischen

den Tokens unterscheiden kann. Die nächsten beiden Definitionen sind analog, nur dass

diesmal kein Wert benötigt wird, da auf diese Tokens nur symbolisch in Bison zugegriffen

wird. Die vorletzte Definition überspringt lediglich alle Tabs und Leerzeichen, da diese

im Parsen nicht signifikant sind. (Das ist nicht in jeder Programmiersprache der Fall;

so symbolisieren in der Programmiersprache Python die Leerzeichen, in welchem Block

sich der Code befindet, ähnlich wie { und } in anderen Programmiersprachen wie C und

Java). Die letzte Definition sammelt jedes andere Zeichen auf um eine Fehlermeldung

auszuwerfen. Diese Definition hilft beim Debuggen des Lexers. Der dritte Block ist

in diesem Fall leer; in ihm würde man zusätzliche Funktionen definieren, welche zu

der erzeugten C-Datei hinzugefügt werden. Es ist möglich, dort eine Main-Funktion

hinzuzufügen, falls man nur einen Lexer benötigt. In diesem Fall wird die Main-Funktion

jedoch in der Bison-Datei definiert.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

%{

#include <stdio.h>

int yyerror(const char ∗p) {

fprintf(stderr, ”%s\n”, p); // print the error message

}

%}

%union {

int intval;

};

%type <intval> expr

%token <intval> NUM

%token END

%left ’+’ ’−’

%left ’∗’ ’/’

%start input

%%

Quelltext 2.9: Datei: calc.y (Block 1)

Der Übersichtlichkeit halber wird die Bison-Datei aufgespalten. Im ersten Block

(Quelltext 2.9) ist ähnlich wie bei der Lexer-Definition eine Aufzählung aller verwendeten

Bibliotheken sowie einer Hilfsmethode yyerror in einem Codeblock angegeben. In Zeile 7-9

werden die Hilfsvariablen für den Lexer genannt. Anschließend werden noch die Typen,

21

Tokens und Operatoren definiert. Die Typendefinition bestimmt den Rückgabewert der

Regeln. Via %left wird die Operatorenreihenfolge definiert. Die Reihenfolge der Regeln hier

bestimmt auch, welche Operatoren zuerst ausgeführt werden, wenn der Parser ausgeführt

wird. Da + und - zuerst angegeben sind, werden diese zuerst geparst und damit als letztes

ausgeführt. Damit erreichen wir, dass Punkt- vor Strichrechnung evaluiert passiert. Mit

%start wird bestimmt, welche Regel im Parser zuerst ausgeführt wird.

1 input: /∗ nil ∗/ | input line ;

2

3 line: END | expr END {

4

printf(”=> %d\n”, $1);

5

};

6

7 expr: NUM {

8

$$ = $1;

9

} | expr ’+’ expr {

10

$$ = $1 + $3;

11

} | expr ’−’ expr {

12

$$ = $1 − $3;

13

} | expr ’∗’ expr {

14

$$ = $1 ∗ $3;

15

} | expr ’/’ expr {

16

$$ = $1 / $3;

17

} | ’−’ expr {

18

$$ = −$2;

19

} | ’(’ expr ’)’ {

20

$$ = $2;

21

};

Quelltext 2.10: Datei: calc.y (Block 2)

Im zweiten Block im Quelltext 2.10 werden die Regeln der kontextfreien Grammatik

angegeben. Die Codeblöcke hinter den Regeln werden ausgeführt, wenn der Parser die

Regel parst. Da expr den Typ int besitzt, kann die Regel line am Ende das Ergebnis von

expr als int via printf ausgeben. Es wäre auch möglich, mit den Codeblöcken einen AST

anzulegen.

1 %%

2 int main() {

3

return yyparse();

4 }

Quelltext 2.11: Datei: calc.y (Block 3)

Der letzte Block im Quelltext 2.11 ermöglicht es, ähnlich wie schon bei flex, Funktionen

in C anzugeben. In diesem Fall soll die Main-Funktion angegeben werden, da der Parser

bereits alles tut, was für das Beispielprogramm benötigt wird. Die Main-Funktion führt

lediglich die yyparse() Funktion aus, welche den Parsevorgang startet, indem es von der

Standardeingabe liest. Nun können die Bison-Datei und Flex-Datei mit dem Bison- und

dem Flex-Befehl kompiliert werden. Dabei sollte beim Bison-Befehl die Zusatzoption

-d angegeben werden, um zusätzlich einen Header anzulegen. Dieser Header ist für den

22

Lexer notwendig. Anschließend können die erzeugten C-Dateien mit einem C-Compiler

wie gcc kompiliert werden. Die Main-Datei stammt dabei von der C-Datei von Bison.

Wenn das kompilierte Programm ausgeführt wird, liest es von der Standardeingabe

Ausdrücke, die der Parser dann auswertet. Dabei wird automatisch während des Parsevorgangs via den Codeblöcken der Ausdruck ausgewertet und via dem printf() Befehl

in Zeile 4 vom Quelltext 2.10 ausgegeben. Durch die Definition der Regeln input und

line können auch weitere Ausdrücke angegeben werden, die in der line-Regel ausgegeben

werden. Im Quelltext 2.12 ist eine Beispielausführung des Programms zu sehen.

1

2

3

4

5

6

100

=> 100

1+2∗2

=> 5

(1+2)∗2

=> 6

Quelltext 2.12: Ausführung des Beispielparsers

23

Kapitel 3

Temporale Tabellen

Temporale Tabellen sind eine konkrete Realisierung der in 2.1.5 beschriebenen Zeitdimensionen. Sie unterscheiden sich von nicht temporalen Tabellen in einigen Punkten und

erzeugen dadurch neue Probleme, die es zu lösen gilt. Einige Lösungen dieser Probleme

sind mithilfe des Buchs [Sno00] entwickelt worden. In den folgenden Abschnitten werden

Beispiele für die verschiedenen Arten von temporalen Tabellen vorgestellt. Die Basis

stellt dabei das folgende Datenbankschema dar.

ANG (Nr, Name, Gehalt)

ARBEITET (Angestellter → ANG, Projekt → PROJEKT)

PROJEKT (Name, Budget, Projektleiter → ANG)

Nr

1

2

Name

Max

Bob

Gehalt

2500

2600

Ang.

1

1

2

Prj.

P1

P2

P2

Name

P1

P2

Budget

100

200

PLeiter

1

2

Tabellen 3.1: Beispielausprägungen

Die drei Relationen besitzen eine Beispielausprägung, die in den Tabellen 3.1 dargestellt

wird. Dieses Schema besitzt dabei noch keine temporalen Tabellen; wir werden sie in

den folgenden Abschnitten mit temporalen Attributen erweitern. Anschließend werden

übliche zeitbezogene Anfragen ausgeführt und die Daten manipuliert.

3.1

Valid Time-Tabellen

Im Kapitel 2.1.5 wurde die Valid Time als Konzept vorgestellt. Konkret im Datenbankmodell wird sie mit Zeitstempeln umgesetzt. Um eine Tabelle mit einer Valid TimeZeitdimension zu erweitern, fügen wir einen Zeitraum zu den Tupeln in der Datenbank

hinzu. Dafür wird die Datenbank um zwei (Anfangszeitpunkt und Endzeitpunkt) oder,

falls das Datenbanksystem einen Datentyp für Zeiträume besitzt, eine Spalte erweitert.

Die Datenbank muss zusätzlich noch notieren, welche Intervallnotation die Zeiträume

24

benutzen (siehe Kapitel 2.1.3). Diese temporale Tabelle und auch die gesamte Datenbank

benutzt die [)-Notation. Nun wird die Tabelle ARBEITET aus dem Beispielschema um

Valid Time erweitert. Dafür wird eine Spalte hinzugefügt, welche den im Kapitel 2.2.2

vorgestellten Range-Datentyp verwendet.

Ang.

1

1

2

Prj.

P1

P2

P2

VT

[2013-01-01,)

[2013-01-01,)

[2013-01-01,)

Tabelle 3.2: Relation ARBEITET mit Valid Time

In der Tabelle 3.2 ist nun die Beispielausprägung mit zusätzlicher Gültigkeitszeit

versehen. Jeder Tupel ist seit 2013-01-01 gültig und der Endzeitpunkt ist leer, demnach

gelten die Tupel für immer. Alle drei Tupel sind somit zum jetzigen Zeitpunkt gültig (vorausgesetzt, die Datenbank wird nach dem Zeitpunkt 2013-01-01 betrieben). Die Tabelle

hat demzufolge keine zusätzlichen Informationen zu seinem vorherigen Zustand. Jetzt ist

es jedoch möglich geworden, die Geschichte eines Mitarbeiters und seiner Projektzugehörigkeit aufzuzeichnen. Für diese Definition gibt es nun bestimmte Anforderungen, die ein

gutes temporales Datenbanksystem erfüllen sollte, um dem User maximale Flexibilität

im Umgang mit zeitbehafteten Daten zu geben.

3.1.1

Anforderungskatalog: Constraints

Eine Anforderung die auch bei nicht-temporalen Tabellen existiert sind Constraints,

welche die Ausprägungen der Tabellen einschränken; so existieren Bedingungen, welche

garantieren, dass für ein eindeutig identifiziertes Objekt nicht mehrere Ausprägungen

existieren oder das ein referenziertes Objekt via Fremdschlüsselbedingung existiert. Diese

Constraints gelten in dieser Form für temporale Tabellen nicht mehr so wie vorher. Zuerst

werden die Primärschlüssel betrachtet.

Angenommen, vom Zeitraum 2012-01-01 bis 2013-01-01 sei der Mitarbeiter 1 im

Projekt P1 tätig gewesen. Diese Daten würden jedoch das PRIMARY KEY-Constraint

der nicht-temporalen Version verletzen, da nun der Schlüssel (1, P1) zweimal in der

Ausprägung auftaucht. Das führt zum ersten Problem der temporalen Tabellen: Temporale

Schlüssel.

Temporaler Schlüssel

In relationalen Datenbanken erlauben Primärschlüssel eine eindeutige Identifizierung

eines Tupels über einen spezifizierten Wert. Dafür muss in den Objekten der Welt, die

über die Datenbank festgehalten werden, eine Eigenschaft gefunden werden, die bei einer

Instanz eines Objekts einzigartig ist. Diese Logik ist jedoch bei temporalen Tabellen nicht

mehr anzuwenden. Dort gilt für eine Tabelle, dass zu einem Zeitpunkt nicht mehr als eine

Ausprägung zu einem Objekt existieren darf. Der bestehende Primary Key-Constraint

löst dieses Problem nicht, wie das zuvor genannte Beispiel zeigt.

25

Naiv wäre die Lösung, den Zeitraum als Primärschlüssel hinzuzufügen. Das würde

jedoch das genannte Problem nicht lösen, sondern nur einige Spezialfälle ausschließen.

So wäre, wenn nur der Zeitraum Teil des Schlüssels ist, die Ausprägung in Tabelle 3.3

erlaubt.

Ang.

1

1

1

2

Prj.

P1

P1

P2

P2

VT

[2013-01-01,)

[2013-06-01,2014-01-01)

[2013-01-01,)

[2013-01-01,)

Tabelle 3.3: Ausprägung, die den temporalen Schlüssel verletzt

Jedoch gibt es zu dem Zeitraum [2013-06-01, 2014-01-01) für den Primärschlüssel

(1, P1) zwei Tupel, was den temporalen Schlüssel verletzt. Demnach gilt, dass eine

Operation, welche die obige Ausprägung erzeugen würde, abgelehnt werden muss. Es

muss demnach bei jeder Datenbankoperation überprüft werden, ob bereits ein Datensatz

mit dem gleichen nicht-temporalen Schlüssel existiert, wo sich die Zeitpunkte schneiden.

Wenn dies der Fall ist, muss die Operation abgelehnt werden, da sie sonst die Integrität

der temporalen Tabelle verletzen würde. Eine Möglichkeit, dieses Constraint zu erzwingen

ist via DBMS-Mitteln wie Trigger und Assertions.

Temporale referentielle Integrität

Nun soll zusätzlich zu der ARBEITET-Relation die Geschichte der Angestellten aufgezeichnet werden, da die Gehaltsänderungen verfolgt werden sollen. Dabei passiert dasselbe

wie zuvor bei der ARBEITET-Relation. Das Resultat ist in der Tabelle 3.4 zu sehen.

Nr

1

2

Name

Max

Bob

Gehalt

2500

2600

VT

[2013-01-01,)

[2013-01-01,)

Tabelle 3.4: Relation ANGESTELLTE mit Valid Time

Nun soll zur Tabelle ARBEITET noch etwas Historie hinzugefügt werden. So hat

der Mitarbeiter 2 von 2012-01-01 bis 2013-01-01 beim Projekt P1 gearbeitet. Danach

wurde er jedoch aus dem P1 entlassen und hat das Projekt P2 zugewiesen bekommen.

Die Tabelle 3.5 zeigt diese temporalen Daten.

Dadurch entsteht jedoch ein neues Problem; im dritten Tupel der ARBEITETRelation wird der Angestellte 2 zum Zeitraum [2012-01-01, 2013-01-01) referenziert.

Dieser Angestellte hat aber laut der Datenbank zu diesem Zeitpunkt gar nicht existiert!

Das führt zum nächsten Problem im Entwurf der Datenbank: Temporale referentielle

Integrität.

Demnach muss eine Überprüfung stattfinden, dass zu jedem Zeitpunkt, in dem eine

fremde Tabelle referenziert wird, auch tatsächlich ein Objekt mit dem entsprechenden

26

Ang.

1

1

2

2

Prj.

P1

P2

P1

P2

VT

[2013-01-01,)

[2013-01-01,)

[2012-01-01,2013-01-01)

[2013-01-01,)

Tabelle 3.5: Mitarbeiter 2 wurde versetzt

Primärschlüsselattribut existiert. Das heißt, dass bei jeder Veränderung der referenzierten

Tabelle sowie der referenzierenden Tabelle eine Überprüfung stattfinden muss. Falls

die veränderten Daten dieser Bedingung nicht entsprechen, so muss die Operation, wie

bei dem temporalen Schlüssel, abgelehnt werden. Eine solche Überprüfung kann wie

der temporale Primärschlüssel durch einen Trigger geklärt werden. Wie diese Trigger

programmiert werden und in einem dynamischen Kontext funktionieren, wird im Kapitel

5 gezeigt.

Temporale Vollständigkeit

Als drittes Constraint auf temporalen Tabellen existiert die Vollständigkeit. Sie garantiert,

dass ein Objekt über die Zeit hinweg niemals Lücken enthält, demnach zwischen dem

ersten Anfangszeitpunkt und dem letzten Endzeitpunkt kein Zeitpunkt existiert, der

nicht in einem der Tupel des Objektes enthalten ist. So würde die folgende Ausprägung

der Tabelle 3.6 ANGESTELLTE den Constraint verletzen.

Nr

1

2

2

Name

Max

Bob

Bob

Gehalt

2500

2600

2800

VT

[2013-01-01,)

[2013-01-01,2014-01-01)

[2014-06-01,)

Tabelle 3.6: Relation ANGESTELLTE mit Valid Time

Bob ist definiert vom 2013-01-01 bis zum Ende der Zeit, jedoch existiert eine

Lücke zwischen dem 2014-01-01 bis 2014-06-01. Eine gültige korrigierte Ausprägung

der ANGESTELLTE-Relation ist in Tabelle 3.12 zu sehen. Dort ist die Lücke gefüllt.

Nr

1

2

2

2

Name

Max

Bob

Bob

Bob

Gehalt

2500

2600

2700

2800

VT

[2013-01-01,)

[2013-01-01,2014-01-01)

[2014-01-01,2014-06-01)

[2014-06-01,)

Tabelle 3.7: Relation ANGESTELLTE mit Valid Time

27

Coalesce

Als letzte mögliche Integritätsbedingung der temporalen Tabellen wird das Coalescing

betrachtet. Falls zeitlich benachbarte Daten die gleichen Tupelwerte besitzen, sollen

sie zu einem Tupel verschmolzen werden, der den gesamten Zeitraum umfasst. Falls

demnach nun die Ausprägung 3.8 existiert, wird sie automatisch zu der Ausprägung 3.9

transformiert.

Nr

1

2

2

2

Name

Max

Bob

Bob

Bob

Gehalt

2500

2600

2600

2600

VT

[2013-01-01,)

[2013-01-01,2014-01-01)

[2014-01-01,2014-06-01)

[2014-06-01,)

Tabelle 3.8: Relation ANGESTELLTE mit Valid Time

Nr

1

2

Name

Max

Bob

Gehalt

2500

2600

VT

[2013-01-01,)

[2013-01-01)

Tabelle 3.9: Relation ANGESTELLTE mit Valid Time

3.1.2

Anforderungskatalog: Anfragen

Neben den besprochenen Unterschieden im Entwurf einer Valid Time-Tabelle und den

Constraints gibt es auch Unterschiede in den Anfragen. Da Anfragen an nicht temporale

Tabellen immer von einem jetzt gültigen Zustand ausgehen, ist es nicht möglich, die alten

Anfragen zu übernehmen. In diesem Kapitel soll anhand von Beispielen repräsentiert

werden, welche Arten von Anfragen existieren und wie sie sich von den nicht-temporalen

Varianten unterscheiden.

Temporale Schnappschussanfrage

Als Anfang sei die Anfrage aus dem Quelltext 3.1 gegeben.

1 SELECT ∗

2 FROM ang;

Quelltext 3.1: Nicht temporale Anfrage an ANG

Zuvor hat die Anfrage lediglich die beiden Mitarbeiter mit ihrem jetzigen Gehalt

ausgegeben. Nach der Transformation in eine Valid Time-Tabelle ist nun die Ausgabe

nicht mehr wie gewünscht der jetzige Zustand, sondern die Vergangenheit des Mitarbeiters

Max ist zusätzlich mit angegeben. Wenn eine Anfrage für den jetzigen Zustand gewünscht

ist, so muss dies zusätzlich angegeben werden.

28

1 SELECT Nr, Name, Gehalt

2 FROM ang a1

3 WHERE a1.vt <@ now();

Quelltext 3.2: Anfrage für momentane Angestellte

Besonders ist im Quelltext 3.2 auf die Zeile 3 zu achten, da der <@-Operator verwendet

wird, welcher überprüft, ob ein Element in einem gegebenen Intervall vorhanden ist.

Wenn der jetzige Zeitpunkt im Zeitraum VT existiert, ist der Tupel jetzt gültig und

damit bei einer Schnappschussanfrage auszugeben.

Temporaler Join

Bei einem temporalen Join wird, im Unterschied zu einem gewöhnlichen Join, die Zeit

eines jeden Objekts berücksichtigt. So gilt, wenn zwei Tupel aus temporalen Tabellen

durch die gegebene Join-Bedingung in Beziehung stehen, dass zusätzlich beachtet werden

muss, ob beide einen gemeinsamen Zeitraum haben und wenn, wie dieser aussieht.

Als Beispiel wird der natürliche Verbund zwischen ARBEITET und ANG betrachtet.

Angenommen, Bob habe 2014 eine Gehaltserhöhung erhalten (siehe Tabelle 3.10).

Nr

1

1

2

2

Name

Max

Max

Bob

Bob

Gehalt

2000

2500

2600

3000

VT

[2010-01-01,2013-01-01)

[2013-01-01,)

[2010-01-01,2014-01-01)

[2014-01-01,)