Statistische Physik

Werbung

Statistische Physik

Barbara Drossel, Technische Universität Darmstadt

Sommersemester 2011

Inhaltsverzeichnis

1 Wahrscheinlichkeiten

1.1 Einführung . . . . . . . . . . . . . . . . . . . .

1.2 Hintergründe . . . . . . . . . . . . . . . . . . .

1.3 Interpretationen von Wahrscheinlichkeiten . . .

1.4 Mathematische Formulierung . . . . . . . . . .

1.5 Einige wichtige Wahrscheinlichkeitsverteilungen

1.5.1 Die Binomialverteilung . . . . . . . . . .

1.5.2 Gauß-Verteilung . . . . . . . . . . . . .

1.5.3 Poissonverteilung . . . . . . . . . . . . .

1.6 Zentraler Grenzwertsatz . . . . . . . . . . . . .

1.7 Information . . . . . . . . . . . . . . . . . . . .

1.8 Das Prinzip der maximalen Ignoranz . . . . . .

1.9 Zusammenhang mit dem Entropiesatz . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4

4

5

6

7

8

8

10

12

13

15

16

18

2 Von

2.1

2.2

2.3

2.4

2.5

2.6

der klassischen Mechanik zur statistischen Mechanik

Die Aufgabe . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Die Liouville-Gleichung . . . . . . . . . . . . . . . . . . . . .

Langzeitverhalten und Ergodizität . . . . . . . . . . . . . . .

Irreversibilität . . . . . . . . . . . . . . . . . . . . . . . . . . .

Die Boltzmann-Gleichung . . . . . . . . . . . . . . . . . . . .

Wo die klassische Mechanik außerdem noch an Grenzen stößt

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

21

21

21

23

24

26

28

3 Von

3.1

3.2

3.3

3.4

der Quantenmechanik zur statistischen Mechanik

Schrödingergleichung für N Teilchen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Fermionen und Bosonen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Beschreibung eines Gases als isoliertes quantenmechanisches N -Teilchensystem . . . . . .

Beschreibung eines Gases als mit der Umgebung über ein Potenzial wechselwirkendes quantenmechanisches N -Teilchensystem . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Beschreibung durch den Dichteoperator . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Explizite Modellierung des Wärmebads: Das Phänomen der Dekohärenz . . . . . . . . . .

3.6.1 Ein einfaches Beispiel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.6.2 Diskussion . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Schlussbemerkungen . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3.5

3.6

3.7

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4 Gleichgewichtsensembles

4.1 Das mikrokanonische Ensemble . . . . . . . . . . . . . . . . . . . .

4.2 Das kanonische Ensemble . . . . . . . . . . . . . . . . . . . . . . .

4.2.1 Systeme in thermischem Kontakt . . . . . . . . . . . . . . .

4.2.2 Die kanonische Zustandssumme und der Boltzmann-Faktor

4.2.3 Bezug zur Thermodynamik . . . . . . . . . . . . . . . . . .

1

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

32

32

33

35

35

37

39

41

41

42

45

45

46

46

47

49

4.2.4

4.3

4.4

Äquipartitionstheorem, Energiefluktuationen und Äquivalenz der statistischen

sembles . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2.5 Vom Nutzen der Zustandssumme . . . . . . . . . . . . . . . . . . . . . . . . .

Das großkanonische Ensemble . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3.1 Systeme mit Teilchenaustausch . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3.2 Bezug zur Thermodynamik . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Der Druck . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.4.1 Systeme, die miteinander Arbeit austauschen können . . . . . . . . . . . . . .

4.4.2 Gibbs-Duhem-Relation in homogenen Systemen . . . . . . . . . . . . . . . . .

5 Ideale Quantengase

5.1 Fermi-Dirac und Bose-Einstein-Verteilung . . .

5.1.1 Fermi-Dirac-Verteilung . . . . . . . . . .

5.1.2 Bose-Einstein-Verteilung . . . . . . . . .

5.1.3 Klassischer Grenzfall . . . . . . . . . . .

5.2 Fermi-Gas bei tiefen Temperaturen . . . . . . .

5.3 Bose-Einstein-Kondensation . . . . . . . . . . .

5.4 Photonengas und Planck-Verteilung . . . . . .

5.5 Debye-Gesetz und Phononen in Festkörpern . .

5.5.1 Phononen als harmonische Oszillatoren

5.5.2 Die Debye-Näherung . . . . . . . . . . .

5.5.3 Thermodynamische Größen . . . . . . .

En. . .

. . .

. . .

. . .

. . .

. . .

. . .

. . .

50

51

52

52

54

55

55

57

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

59

59

59

60

61

62

64

66

68

68

69

69

6 Reale Gase, Flüssigkeiten und Lösungen

6.1 Virialentwicklung und van der Waals-Gas . . . . . . . . .

6.2 Verdünnte Lösungen . . . . . . . . . . . . . . . . . . . . .

6.2.1 Zustandssumme, Druck und chemisches Potenzial .

6.2.2 Der osmotische Druck . . . . . . . . . . . . . . . .

6.2.3 Gefrierpunktserniedrigung . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

72

72

75

75

77

77

7 Phasenübergänge

7.1 Phasengleichgewichte . . . . . . . . . . . . . . . . . . . . . . . . . . .

7.1.1 Extremalbedingungen . . . . . . . . . . . . . . . . . . . . . .

7.1.2 Phasengrenzkurven . . . . . . . . . . . . . . . . . . . . . . . .

7.1.3 Clausius-Clapeyron-Gleichung . . . . . . . . . . . . . . . . . .

7.1.4 Gibbs-Phasenregel und Phasengleichgewicht . . . . . . . . . .

7.2 Einführung in Phasenübergänge . . . . . . . . . . . . . . . . . . . . .

7.3 Mean-Field-Theorie . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7.3.1 Landau-Theorie für Phasenübergänge . . . . . . . . . . . . .

7.3.2 Kritische Exponenten . . . . . . . . . . . . . . . . . . . . . .

7.4 Das eindimensionale Ising-Modell und die Transfer-Matrix-Methode

7.5 Das zweidimensionale Isingmodell und die Ortsraumrenormierung . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

80

80

80

80

81

82

84

86

87

89

90

93

2

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

Quellenangaben und Danksagung

Die folgenden Lehrbücher wurden bei der Erstellung des Skripts zu Rate gezogen:

• C. Kittel, Thermal Physics

• F. Schwabl, Statistische Mechanik

• F. Reif, Statistical and Thermal Physics

• L. Reichl, A Modern Course in Statistical Physics

• M. Kardar, Statistical Physics of Particles

Weitere Anregungen kamen aus den hilfreichen Vorlesungsskripten von Heinz Horner (www.tphys.uniheidelberg.de/∼horner/Stat.Mech.pdf) und Friederike Schmid

(www.physik.uni-bielefeld.de/∼schmid/Lehre/Thermo WS03/script.html).

Ein herzlicher Dank geht an alle, die Korrekturen zum Skript vorgeschlagen haben: Eva Gehrmann,

Michael Harrach, Lotta Heckmann, Timm Plefka, Sebastian Plitzko, Simon Quittek, Yixian Song, Felix

Wissel.

Einführung

Statistische Physik befasst sich mit Systemen, die aus sehr vielen Teil(ch)en bestehen. Beispiele sind

Gase, Flüssigkeiten, Magnete, Sandhaufen, Pudding, Zivilisationen, Verkehr, die Wirtschaft, etc. Das

Ziel der statistischen Physik ist es, die makroskopischen Eigenschaften des Systems aus den Eigenschaften seiner Teile und ihrer Wechselwirkungen abzuleiten. Diese mikroskopischen Eigenschaften einzelner

Teilchen sind oft recht einfach und im Prinzip verstanden. Die Bewegungen von Atomen und Molekülen

und ihre Wechselwirkungen untereinander werden durch die Quantenmechanik beschrieben. Daraus die

Eigenschaften eines Gases (Druck, Temperatur, Kondensation zu einer Flüssigkeit) abzuleiten, ist jedoch

eine höchst nichttriviale Aufgabe. Dies liegt zum einen daran, dass die Teilchenzahl so groß ist, dass

man selbst mit dem modernsten Computer unmöglich die Bewegungsgleichungen für das gesamte System

auswerten kann. Zum anderen liegt es daran, dass auf der makroskopischen Ebene qualitativ neue Eigenschaften zu Tage treten, die selbst bei genauer Kenntnis der Wechselwirkungen der einzelnen Teilchen

nur schwer zu verstehen sind. Beispiele sind Phasenübergänge, die elektrische Leitfähigkeit eines Materials, die viskoelastischen Eigenschaften gewisser Kunststoffe, das Auftreten eines Verkehrsstaus oder

eines Börsenkrachs. Systeme, die nicht im thermodynamischen Gleichgewicht sind, hängen außerdem oft

empfindlich von ihren Randbedingungen ab. Das Verhalten solcher Systeme wird also nicht nur durch

ihre Bestandteile bestimmt, sondern zusätzlich auch durch ihre Umgebung. Diese Vorlesung befasst sich

aber hauptsächlich mit Gleichgewichtssystemen.

In der statistischen Physik spielen Wahrscheinlichkeiten eine zentrale Rolle. Dies liegt an der Unvorhersagbarkeit der detaillierten zeitlichen Entwicklung eines Systems aus vielen Teilchen. Wir beginnen

deshalb die Vorlesung mit einer Behandlung von Wahrscheinlichkeiten, Wahrscheinlichkeitsverteilungen

und Information. Da die durch die statistische Physik beschriebenen Systeme sich auf mikroskopischer

Ebene im Prinzip durch die klassische Mechanik oder die Quantenmechanik beschreiben lassen, befassen

wir uns als nächstes mit der Frage, wie die statistische Physik mit diesen beiden anderen Gebieten zusammenhängt. Wir werden sehen, dass sie nicht vollständig aus ihnen ableitbar ist. Um die statistische

Physik zu begründen, ist eine neue Grundannahme nötig, nämlich dass alle Zustände gleicher Energie im Gleichgewicht gleich wahrscheinlich sind. Die statistische Physik hat ihre eigene Naturkonstante,

nämlich die Boltzmann-Konstante kB . Auch dies weist darauf hin, dass sich die statistische Physik nicht

vollständig auf die klassische Mechanik oder die Quantenmechanik reduzieren lässt. Nach diesem grundlegenden Teil kommen wir zu verschiedenen Anwendungen der Statistischen Physik. Dies ist zunächst die

statistische Physik von Gleichgewichtssystemen, im Rahmen derer die aus der Thermodynamik bekannten Größen und Beziehungen abgeleitet werden. Dann werden Quantengase behandelt, und wir werden

die spezifische Wärme von Metallen und Festkörpern, die Bose-Einstein-Kondensation und das Plancksche Strahlungsgesetz herleiten. Das van-der-Waals-Gas und die Theorie von Lösungen sind das Thema

des nächsten Kapitels. Am Schluss des Semesters gibt es eine Einführung in Phasengleichgewichte und

Phasenübergänge.

3

Kapitel 1

Wahrscheinlichkeiten

1.1

Einführung

In der Praxis arbeitet man in der Physik immer dann mit Wahrscheinlichkeiten, wenn man Ereignisse

nicht mit Sicherheit vorhersagen kann, aber trotzdem quantitative Aussagen treffen will. Als Erstes muss

man den Raum der möglichen Ereignisse festlegen, um die es geht. Beim Münzwurf sind dies “Kopf” und

“Zahl”, beim Würfeln die Zahlen 1 bis 6, beim Fußball “Gewinnen”, “Verlieren” und “Unentschieden”

(oder das genaue Torverhältnis), bei der Klausur am Ende dieses Semesters die Noten 1.0, 1.3, 1.7, etc.

Es gibt mehrere Möglichkeiten, diesen Wahrscheinlichkeiten Werte zuzuweisen.

1. Wenn man die Prozesse, die zum Ergebnis führen, oder die Prinzipien, die hinter den Wahrscheinlichkeiten stecken (wie z.B. Symmetrien und Invarianzen) genügend gut versteht, kann man aufgrund

dieser Kenntnis Wahrscheinlichkeiten zuweisen. Bei einem Würfel sind alle sechs Seiten gleichberechtigt (wenn der Würfel gut hergestellt ist), und deshalb weiß man, dass die Wahrscheinlichkeit

für jede Zahl 1/6 beträgt. Bei der Messung der z-Komponente des Spins eines Spin-1/2-Teilchens,

das man vorher in x-Richtung polarisiert hat, weiß man aus den Gesetzen der Quantenmechanik,

dass jedes der beiden Ergebnisse die Wahrscheinlichkeit 1/2 hat.

2. Wenn man eine genügend gute Statistik hat, kann man aus dieser Statistik Wahrscheinlichkeiten

ableiten, indem man die gemessenen Häufigkeiten mit den zugrunde liegenden Wahrscheinlichkeiten

identifiziert. Davon leben die Versicherungen. Sie wissen nicht, wessen Haus als nächstes Feuer fängt,

aber sie wissen, wie häufig im Durchschnitt Brände auftreten und können auf dieser Basis die

Versicherungsprämie berechnen. Um aus Statistiken Wahrscheinlichkeiten abzuleiten, müssen zwei

Voraussetzungen erfüllt sein. Zum ersten muss das Ensemble, für das die Statistik erhoben wird, klar

definiert werden. So ist zum Beispiel die Häufigkeit von Krebserkrankungen verschieden für Raucher

und Nichtraucher, für Personen unter und über 50 Jahren, für Personen, die Sport treiben und für

Couchpotatoes. Entsprechend gelten die aus der Statistik abgeleiteten Wahrscheinlichkeitsaussagen

unter der Voraussetzung, dass man über die Person, deren Krebsrisiko man angeben will, nicht

mehr Information berücksichtigt als die Zugehörigkeit zum gewählten Ensemble. Zweitens muss

die aus der Statistik resultierende Häufigkeitsverteilung immer genauer werden, je größer man die

Stichprobe wählt. Nur dann sind die aus der Häufigkeitsverteilung abgeleiteten Wahrscheinlichkeiten

zuverlässig. Deshalb schließen übrigens Versicherungen die ganz seltenen katastrophalen Ereignisse

wie Krieg, Erdbeben, etc. als Versicherungsfälle aus, da diese die Häufigkeitsverteilung von einem

Moment auf den anderen total verändern.

3. Für theoretische und mathematische Überlegungen werden die Wahrscheinlichkeiten oft einfach

postuliert. Man schafft ein fiktives oder modellhaftes Szenario, für das man dann seine Überlegungen anstellt. Ein Beispiel hierfür sind mathematische Modelle für biologische Evolution, in denen

Wahrscheinlichkeiten für Mutationen oder für das Überleben eine wichtige Rolle spielen. Diese

4

Wahrscheinlichkeiten sind variable Modellparameter, und man untersucht das Verhalten des Modells in Abhängigkeit von den Werten dieser Parameter, wobei man für die tatsächlichen Werte

dieser Parameter nur grobe Anhaltspunkte hat.

4. Bei einmaligen Zufallsereignissen kann man deren Wahrscheinlichkeit nur schätzen. Solche Wahrscheinlichkeiten sind subjektiv und hängen sehr von der Erfahrung und dem Wissen, aber auch

von Vorurteilen oder Wunschdenken ab. Beispiele hierfür sind die Wahrscheinlichkeit, dass die Renovierung des großen Physikhörsaals tatsächlich zum WS 2011 abgeschlossen sein wird, oder die

Wahrscheinlichkeit, dass Borussia Dortmund dieses Jahr Deutscher Meister werden wird.

Um mit Wahrscheinlichkeiten naturwissenschaftlich zu arbeiten, benötigt man Wahrscheinlichkeiten

der ersten drei dieser vier Sorten. Nur mit den ersten beiden lassen sich zusätzlich quantitative Aussagen

über die Realität machen. Allerdings versuchen auch Wissenschaftler manchmal, Wahrscheinlichkeitsaussagen ohne diese Voraussetzungen zu machen. Ich möchte hier zwei Beispiele nennen. Das erste ist die

Feinabstimmung der physikalischen Konstanten. Wenn ihre Werte nur minimal anders wären, könnten

sich keine Sterne und Planeten formen, keine schweren Elemente und kein Leben bilden. Aus dieser Beobachtung wird oft gefolgert, dass es sehr unwahrscheinlich ist, dass ein Universum genau diese Werte

der Naturkonstanten besitzt. Also, meinen manche, ist unser Universum nur eines von vielen, ist Teil eines “Multiversums”. Jedes dieser vielen Universen habe einen zufällig gewählten Satz von physikalischen

Konstanten, und folglich gibt es auch irgendwann ein Universum, dass die für Leben richtigen Voraussetzungen erfüllt. Derartige Aussagen haben keine solide Grundlage. Wir kennen weder die Prozesse, durch

die einem Universum bei seiner Entstehung die Werte der Naturkonstanten zugewiesen werden, noch

verfügen wir über eine gute Statistik über die Häufigkeitsverteilung dieser Konstanten in den Universen.

Die unausgesprochene Annahme hinter diesen Überlegungen ist, dass einem Universum bei seiner Entstehung die Werte der Naturkonstanten aus einem größeren Intervall möglicher Werte zufällig zugewiesen

werden. Dies ist aber reine Spekulation.

Das zweite Beispiel ist die Entstehung des Lebens. Hier ist die Situation zur Zeit noch ähnlich wie bei

der Feinabstimmung der Naturkonstanten. Es fehlen bisher wichtige Informationen, die nötig wären, um

die Wahrscheinlichkeit für die Entstehung von Leben auf der Erde abzuschätzen. Wir haben weder eine

gute Statistik auf der Basis vieler erdähnlicher Planeten, noch verstehen wir bisher die Prozesse, die die

ersten Zellen hervorgebracht haben.

1.2

Hintergründe

Wenn wir ein Ereignis nicht vorhersagen können und deshalb mit Wahrscheinlichkeiten operieren müssen,

gibt es zwei mögliche Erklärungen dafür: Entweder wissen wir einfach nicht genügend über die Ursachen

des Ereignisses oder über die Faktoren, die bei seinem Zustandekommen mitwirken. In diesem Fall liegt

im Prinzip der Ausgang des Ereignisses aufgrund der Naturgesetze im Voraus schon fest, aber wir kennen

ihn aufgrund unserer mangelnden Einsicht nicht.

Oder der Ausgang des Ereignisses liegt tatsächlich vorher nicht fest. In diesem Fall hilft selbst eine

vollständige Kenntnis der Ausgangssituation nicht, da sie das Ereignis nicht eindeutig festlegt. In diesem

Fall ist die Zukunft nicht vollständig in der Gegenwart enthalten.

In einer deterministischen Weltsicht liegt grundsätzlich immer die erste Situation vor. Diese Sichtweise

führt allerdings auf eine Reihe von Problemen, da dann immer die Ausgangssituation verbunden mit den

Naturgesetzen vollständig die zeitliche Entwicklung eines Systems bestimmen würde. Dies würde zum

Beispiel bedeuten, dass der Zustand des Universums kurz nach dem Urknall alle Information darüber

enthalten hätte, was sich später im Universum ereignet hat, einschließlich der Tatsache, dass Sie jetzt

gerade diese Zeilen lesen....

Wir diskutieren das Zusammenwirken von deterministischen und nicht deterministischen Faktoren am

Beispiel eines Münzwurfs. Sobald die Münze die Hand verlassen hat, wirken die Gesetze der Mechanik:

Die Münze hat eine bestimmte Geschwindigkeit und Richtung, sie dreht sich mit einer bestimmten Rotationsgeschwindigkeit, und sie spürt den Luftwiderstand und die Schwerkraft. Wenn man die Flug- und

5

Rotationsgeschwindigkeit schnell und genau genug messen könnte, könnte man im Prinzip ausrechnen,

wie die Münze am Boden aufkommt und ob Kopf oder Zahl das Ergebnis sein wird. – Ist das wirklich so?

Was ist, wenn die Münze mit ihrem Rand auf dem Boden aufkommt und dann eine leichte Vibration des

Bodens durch den draußen vorbeifahrenden Verkehr oder kaum wahrnehmbare kleine Luftbewegungen

entscheidet, wie die Münze endgültig landet? Was ist, wenn ich die Flug- und Rotationsgeschwindigkeit

nur auf 6 Stellen hinter dem Komma genau bestimmen kann, aber bei manchen Münzwürfen erst die siebte Stelle hinter dem Komma entscheidet, wie die Münze endgültig landen wird? Immer dann, wenn eine

winzige Änderung der Anfangbedingungen oder eine winzige äußere Störung den Ausgang des Münzwurfs

ändern kann, ist dieser Ausgang nicht mehr mit Sicherheit aus der Kenntnis der Anfangsbedingungen

vorhersagbar. Die Aussage, dass sich der Ausgang eines Münzwurfs “im Prinzip” berechnen lässt, müssen

wir daher vorsichtiger formulieren: Viele Münzwürfe sind so, dass sich ihr Ausgang im Prinzip mit Sicherheit vorhersagen lässt (weil eine kleine Störung am Ausgang nichts ändern würde), der Ausgang

anderer Münzwürfe lässt sich zwar nicht sicher, aber mit großer Wahrscheinlichkeit vorhersagen (wenn

es eine kleine Störung gerade so schaffen könnte, die Münze beim Aufkommen in die andere Richtung zu

kippen), und bei manchen Münzwürfen ist der Ausgang ganz unsicher, so dass die Wahrscheinlichkeit für

Kopf oder Zahl jeweils ungefähr 50 Prozent beträgt. Dieses Beispiel zeigt, dass eine genauere Kenntnis

der Anfangssituation und der Naturgesetze die Unvorhersagbarkeit reduzieren kann, doch sie kann sie im

Allgemeinen nicht auf Null reduzieren. Wo die Grenzen der Vorhersagbarkeit liegen, werden wir in den

nächsten beiden Kapiteln diskutieren.

Bisher haben wir noch nicht gefragt, was passiert, bevor die Münze die Hand verlässt. Wovon hängt

es ab, welche Anfangsgeschwindigkeit etc. die Münze hat? Das Gehirn, die Nerven und die Muskeln des

Werfenden sind am Werfen der Münze beteiligt. Nur wenn man den Anfangszustand des Werfenden

vor dem Wurf genügend genau beschreiben und daraus das Auslösen des Münzwurfs vorherberechnen

könnte, könnte man auch schon vor dem Wurf sagen, wie die Münze landen wird. Dies ist aber bisher

völlig unmöglich, und es gibt gute Gründe anzunehmen, dass dies prinzipiell unmöglich ist.

1.3

Interpretationen von Wahrscheinlichkeiten

1. Wahrscheinlichkeiten als Tendenzen: Die Interpretation von Wahrscheinlichkeiten als Tendenzen

wurde zum Beispiel von Karl Popper vertreten. In dieser Sichtweise hat das betrachtete System

eine Tendenz (englisch “propensity”) zu jedem der möglichen Resultate, quantifiziert durch die

Wahrscheinlichkeiten dieser Resultate. Quantenmechanische Wahrscheinlichkeiten sind ein gutes

Beispiel für solche Tendenzen. Diese Interpretation setzt voraus, dass der Ausgang des betrachteten Prozesses nicht im Voraus festliegt. Bei einer exakten Wiederholung der Ausgangssituation

würden dann die möglichen Ergebnisse mit den entsprechenden Wahrscheinlichkeiten auftreten.

Durch häufiges Wiederholen derselben Situation kann man diese Wahrscheinlichkeiten in Form von

Häufigkeiten messen.

2. Wahrscheinlichkeiten als Häufigkeiten: In dieser Interpretation sind Wahrscheinlichkeiten der Grenzwert, dem die Häufigkeiten zustreben, wenn man die Zahl der Wiederholungen derselben Ausgangssituation oder die Stichprobengröße gegen unendlich streben lässt. Vertreter dieser Interpretation

nennt man “Frequentisten”. Diese Interpretation ist eine pragmatische, da sie im Wesentlichen eine

Messvorschrift für Wahrscheinlichkeiten angibt, ohne Aussagen über die Hintergründe zu machen.

3. Wahrscheinlichkeiten aufgrund von fehlendem Wissen: Wer eine deterministische Weltsicht vertritt,

betrachtet alle Wahrscheinlichkeiten als subjektiv: Nur weil der Betrachter keine vollständige Information über die Ausgangssituation oder die Abläufe hat, kann er das Ergebnis nicht mit Sicherheit

vorhersagen. Die Wahrscheinlichkeit, die der Beobachter einem Ereignis zuweist, ist dann ein Maß

für seine Überzeugung, dass dieses Ereignis eintreten wird. Über sinnvolle und konsistente Vorgehensweisen, derartige Wahrscheinlichkeiten (auch “Bayessche Wahrscheinlichkeiten” genannt) zu

ermitteln, wurde viel nachgedacht. Der Physiker Edwin Thompson Jaynes hat mit seinem Buch

6

“Probability Theory” die beste Abhandlung über die Ermittlung von Bayesschen Wahrscheinlichkeiten verfasst.

1.4

Mathematische Formulierung

Der russische Mathematiker Andrey Kolmogorov baute die Wahrscheinlichkeitstheorie ausgehend von

Axiomen auf. Im folgenden werden einige wichtige Eigenschaften von Wahrscheinlichkeiten und einige

wichtige Definitionen aufgezählt.

Sei x eine Zufallsvariable, die die möglichen Werte S ≡ {x1 , x2 , . . .} annehmen kann. Die Werte können

diskret sein, so wie beim Würfeln, S = {1, 2, 3, 4, 5, 6}, oder kontinuierlich, wie z.B. die Geschwindigkeiten

der Moleküle in einem Gas, S = {−∞ < vx , vy , vz < ∞}. In dem letzten Beispiel ist die Zufallsvariable

ein Vektor aus drei Komponenten. Ein Ereignis ist eine Teilmenge E ⊂ S, und ihr wird eine Wahrscheinlichkeit p(E) zugewiesen. Beim Würfeln ist z.B. p({2, 5}) = 1/3. Wahrscheinlichkeiten erfüllen die

folgenden Bedingungen und Rechenregeln:

1. Positivität: p(E) ≥ 0

2. Normierung: p(S) = 1

3. Wahrscheinlichkeit für A oder B: p(A ∪ B) = p(A) + p(B) − p(A ∩ B)

4. Bedingte Wahrscheinlichkeit für A, wenn man weiß, dass B eintritt: p(A|B) =

p(A∩B)

p(B)

Für kontinuierliche Zufallsvariablen benötigt man die Wahrscheinlichkeitsdichte P (x). Wenn die Werte

von x reelle Zahlen sind, dann ist

P (x)dx = prob(E ⊂ [x, x + dx])

(1.1)

Ein Beispiel aus der Quantenmechanik für eine Wahrscheinlichkeitsdichte ist das Betragsquadrat der Wellenfunktion |ψ(x)|2 , das die Wahrscheinlichkeitsdichte dafür angibt, bei einer Ortsmessung das Teilchen

an der Position x zu finden. Wir werden im Folgenden Wahrscheinlichkeitsdichten mit dem großen Buchstaben P und Wahrscheinlichkeiten mit dem kleinen Buchstaben p notieren. Integriert man P (x) über

ein Intervall [a, b], erhält man die Wahrscheinlichkeit dafür, dass die Zufallsvariable in diesem Intervall

liegt. Man kann auch für diskrete Zufallsvariablen eine Wahrscheinlichkeitsdichte formulieren. Wenn die

Werte xi der Zufallsvariablen reell sind, ist

X

p(xi )δ(x − xi ) .

(1.2)

P (x) =

i

Wir bleiben zunächst bei reellen Zufallsvariablen und definieren bzw. wiederholen einige viel verwendete

Größen:

1. Kumulative Verteilungsfunktion: Sie ist die Wahrscheinlichkeit dafür, dass die Zufallsvariable y

nicht größer als ein Wert x ist:

Z x

F (x) =

P (y)dy

(1.3)

−∞

2. Erwartungswert einer Funktion f (x) der Zufallsvariable:

Z ∞

f (x)P (x)dx

hf (x)i =

(1.4)

−∞

3. Momente hxn i der Wahrscheinlichkeitsverteilung P (x):

Z

hxn i = xn P (x)dx

7

(1.5)

4. Varianz der Zufallsvariable x:

σx2 = h(x − hxi)2 i = hx2 i − hxi2

(1.6)

5. Charakteristische Funktion: Sie ist die Fouriertransformierte der Wahrscheinlichkeitsdichte:

Z

X (−ik)n

χ(k) = dxe−ikx P (x) = he−ikx i =

hxn i

n!

n

Umgekehrt ist

P (x) =

dk ikx

e χ(k) .

2π

Z

(1.7)

(1.8)

Für mehrdimensionale Verteilungen gelten analoge Beziehungen. Ein Beispiel ist die Geschwindigkeitsverteilung P (~v ) = P (vx , vy , vz ) der Moleküle eines Gases. Mehrdimensionale Verteilungen faktorisieren

nur dann, wenn die verschiedenen Variablen voneinander unabhängig sind. Dies ist normalerweise für

das Beispiel der Geschwindigkeitsverteilung der Fall, so dass gilt P (vx , vy , vz ) = P1 (vx )P2 (vy )P3 (vz ).

Außerdem gilt

Z Z

P1 (vx ) =

dydzP (vx , vy , vz ) .

(1.9)

Für mehrdimensionale Verteilungen werden noch zwei wichtige Größen definiert, die wir hier für zwei

Zufallsvariablen x und y formulieren: Die Kovarianz von x und y ist

Cov(x, y) = h(x − hxi)(y − hyi)i = hxyi − hxihyi ;

(1.10)

Wenn man die Kovarianz durch die beiden Standardabweichungen teilt, bekommt man die Korrelationsfunktion

h(x − hxi)(y − hyi)i

Cov(x, y)

=

.

(1.11)

Cor(x, y) =

σx σy

σx σy

Sie gibt an, inwieweit x und y voneinander abhängig sind und liegt zwischen −1 und 1.

1.5

1.5.1

Einige wichtige Wahrscheinlichkeitsverteilungen

Die Binomialverteilung

Beginnen wir mit einem Beispiel: N verschiedene Elementarmagnete, nummeriert mit dem Index i, sind an

N festen Positionen längs einer Linie angeordnet. Jeder Elementarmagnet hat ein magnetisches Moment

mi vom Betrag 1, das nur nach oben oder unten zeigen kann. Wenn es nach oben zeigt, habe es den Wert

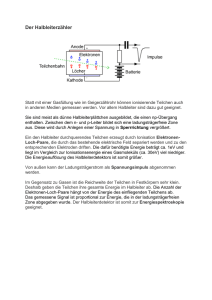

+1, wenn es nach unten zeigt, den Wert −1. (Siehe Abb. 1.1)

i=1

2

3

4

5

6

7

Abbildung 1.1: Das Modellsystem aus magnetischen Momenten.

Dieses System hat insgesamt 2N verschiedene mikroskopische Zustände. Ein makroskopischer Zustand

ist durch den Wert des gesamten magnetischen Momentes

M=

N

X

i=1

8

mi

mit mi = ±1 gegeben. Wir gehen davon aus, dass die Elementarmagnete voneinander unabhängig sind

und fragen, wieviele mikroskopische Zustände es gibt, die dem selben makroskopischen Zustand entsprechen.

Die möglichen Werte von M sind

M = N, (N − 2), (N − 4), . . . , −N.

Wenn das gesamte magnetische Moment M ist, zeigen N +M

magnetische Momente nach oben und N −M

2

2

magnetische Momente nach unten. Es gibt also

N!

N

Ω(N, M ) = N +M = N +M N −M (1.12)

!

!

2

2

2

verschiedene mikroskopische Konfigurationen, die ein Gesamtmoment M haben. Das Maximum von

Ω(N, M ) ist bei M = 0. Da zeigen je die Hälfte der magnetischen Momente nach oben und nach unten.

Als Nächstes wollen wir Wahrscheinlichkeiten für die verschiedenen Werte des Gesamtmoments bestimmen. Dazu müssen wir wissen, mit welchen Wahrscheinlichkeiten die verschiedenen Werte der einzelnen Momente auftreten. Wir betrachten den Fall, dass die einzelnen Momente voneinander unabhängig

sind und dass sie alle dasselbe Magnetfeld und dieselbe Temperatur sehen. Also hat jedes magnetische

Moment unabhängig von den anderen Momenten mit der Wahrscheinlichkeit w den Wert +1 und mit

der Wahrscheinlichkeit q = 1 − w den Wert −1. (Wie w vom Magnetfeld und der Temperatur abhängt,

interessiert uns an dieser Stelle nicht.) Die Wahrscheinlichkeit, dass das Gesamtmoment den Wert M hat,

ist folglich

N +M

N −M

N

p(M ) = N +M w 2 q 2 .

2

Dies ist eine Binomialverteilung

B( N +M

2 , N ).

Eine Binomialverteilung ist allgemein durch die Formel

N

B(n, N ) =

wn (1 − w)N −n

(1.13)

n

definiert. Sie tritt immer dann auf, wenn jedes von N unabhängigen Elementen einen von zwei möglichen

Werten annehmen kann. Sie gibt die Wahrscheinlichkeit dafür an, dass genau n Elemente den einen Wert

und N − n Elemente den anderen Wert haben. Ein anderes Beispiel ist das Werfen einer Münze, wobei

die Elemente die einzelnen Würfe sind und die beiden Werte “Kopf” und “Zahl”. Ein weiteres Beispiel

ist ein Zufallsweg, bei dem jeder Schritt unabhängig vom vorhergehenden Schritt mit Wahrscheinlichkeit

w nach rechts und mit Wahrscheinlichkeit 1 − w nach links geht. Für w = q = 12 vereinfacht sich die

Binomialverteilung zu

1 N

B(n, N ) = N

.

(1.14)

2

n

Der Mittelwert und die Standardabweichung des Gesamtmoments lassen sich aufgrund der Unabhängigkeit der einzelnen magnetischen Momente durch eine einfache Berechnung bestimmen, ohne auf die Binomialverteilung zurückzugreifen.

Der Mittelwert des Gesamtmoments ist durch

+

*N

X

X

mi

hM i =

p(M )M =

i=1

M

gegeben. Da die einzelnen magnetischen Momente voneinander unabhängig sind, ist dies identisch mit

hM i =

N

X

i=1

hmi i = N (w − q) = N (2w − 1).

9

(1.15)

Die Varianz des Gesamtmoments ist

+

!2 + *

* N

X

X

2

(mi − hmi i)(mj − hmj i)

(mi − hmi i)

=

=

(M − hM i)

i,j

i=1

=

X

i,j

=

h(mi − hmi i)(mj − hmj i)i =

2

N

X

(mi − hmi i)2

i=1

N w[1 − (2w − 1)] + q[−1 − (2w − 1)]2 = 4N wq.

(1.16)

Hierbei haben wir wieder die Unabhängigkeit der einzelnen Momente berücksichtigt, also hmi mj i =

hmi i hmj i für i 6= j. Damit ergibt sich für die Standardabweichung des Gesamtmoments

q

p

∆M = hM 2 i − hM i2 = 4N wq .

Wir haben damit gezeigt, dass der Mittelwert und die Varianz des Gesamtmoments wegen der Unabhängigkeit der Einzelmomente mit der Summe der Mittelwerte und der Varianzen der Einzelmomente

identisch sind. Da die Einzelmomente identischen Bedingungen ausgesetzt sind (also dasselbe w haben),

sind alle Mittelwerte und alle Varianzen jeweils gleich. Also ist der Mittelwert des Gesamtmoments N

mal der einzelne Mittelwert und die Varianz des Gesamtmoments N mal die einzelne Varianz.

Das Verhältnis zwischen Standardabweichung und Mittelwert ist (für w 6= q)

s

4wq

∆M

.

=

hM i

N (w − q)2

Für diejenige Sorte von Systemen, um die es in dieser Vorlesung meistens geht, sind typische Werte von

N von der Größenordnung 1023 , so dass dieses Verhältnis von der Größenordnung 10−11 , also winzig ist.

Aus diesem Grund kann man in vielen Fällen eine Größe durch ihren Mittelwert ersetzen, was wir im

Laufe der Vorlesung öfters tun werden.

Schließlich wollen wir noch die Energie des Systems in einem äußeren Magnetfeld ~h angeben, da wir

sie später benötigen. Wenn das Feld nach oben gerichtet ist, ergibt sich

E=−

N

X

i=1

hmi = −M h .

(1.17)

Jedem Wert von M entspricht also ein Wert von E, den man durch Multiplikation mit −h erhält.

1.5.2

Gauß-Verteilung

Die Gauß-Verteilung ist eine kontinuierliche Wahrscheinlichkeitsverteilung. Aufgrund des zentralen Grenzwertsatzes (siehe 1.5) tritt sie immer dann auf, wenn die betrachtete Zufallsvariable die Summe vieler

voneinander unabhängiger und identisch verteilter Zufallsvariablen ist. So ergibt sie sich auch aus der

Binomialverteilung im Grenzfall großer Teilchenzahlen N . Im folgenden zeigen wir explizit, wie die GaußVerteilung aus der Binomialverteilung abgeleitet werden kann. Wir können die Ausdrücke für Ω(N, M )

und p(M ) mit Hilfe der Stirling-Formel

√

N ! ≃ N N e−N 2πN

für große N und N − |M | vereinfachen. Für Ω(N, M ) ergibt sich

Ω(N, M )

=

N +M

2

N!

N −M !

!

2

10

s

NN

2N

N −M

N +M N +M

π(N − M )(N + M )

2

2

( N −M

(

)

)

2

2

r

1

2

q

= 2N

2

πN (1 − M ) N −M

M N +M

2

2

1− M

(1

+

)

N

N

N2

r

M

2

(1 − 2 M

2

N

N)

q

≃ 2

N

2

πN (1 − M ) 2 1 − M 2

≃

N2

N2

r

2 N2 M22 − M 2M M 22

e N e 2 N e 2N

πN

r

2 − M2

≃ 2N

e 2N .

πN

≃ 2N

(1.18)

Hier haben wir angenommen, dass M

N klein ist (weil Ω eine schmale, um Null zentrierte Verteilung ist) und

in führender Ordnung

in

dieser

Größe

entwickelt. Wir haben also eine Gaußverteilung mit dem Mittelwert

√

Null und der Breite N erhalten. Für große N ist das Maximum dieser Verteilung sehr scharf verglichen

mit der Gesamtbreite der möglichen M -Werte.

Zur näherungsweisen Berechnung von p(M ) verwenden wir ebenfalls die Stirling-Formel. Im Anschluss

M

daran entwickeln wir aber nicht in M

N , da der Bereich kleiner N viel weniger interessant ist als die

Umgebung des Mittelwertes hM i = N (2w − 1). (Nur für w = q = 21 ist der Mittelwert bei M = 0 und

kann die obige Rechnung übernommen werden.) Wir schreiben δM = M − hM i und entwickeln in δM

N ,

wobei wir am Schluss nur den ersten nichtverschwindenden Term in der Exponenzialfunktion behalten,

nämlich den Term proportional zu (δM )2 /N . Wir erhalten also (indem wir mit der dritten Zeile von

δM

δM

und y = 2wN

benützen)

(1.18) beginnen und die Abkürzung x = 2qN

p(M ) =

≃

N +M

=

2N

=

r

≃

≃

N −M

Ω(N, M ) w 2 q 2

! N −M

r

2

q

2

N

2

πN 1 − M

N

r

r

2

πN

1

2πN wq

wq

2

1− M

N2

! N2

w

1+ M

N

w(1 − M

N)

M

q(1 + N )

1

1 − x + y − xy

2

2

1

x−y+ x +y

2

e

2πN wq

r

(δM )2

1

e− 8wqN .

2πN wq

! N +M

2

N

2

N2+1

e

! M2

1

q

1−

1

q

1−

M2

1−x

1+y

M2

N2

M2

N2

2

2

M

−x−y+ y −x

2

2

Dies ist eine Gauß-Verteilung um den Mittelwert hM i = N (2w − 1) mit der Breite ∆M =

ist (wie es für eine Wahrscheinlichkeit sein muss) auf 1 normiert:

Z

X

1

1X

p(M )δM ≃

p(M )dM = 1 .

p(M ) =

2

2

M

(1.19)

√

4N wq. Sie

(1.20)

M

Der Faktor 21 kommt daher, dass der Abstand zwischen zwei aufeinander folgenden M -Werten δM = 2

beträgt. Die Näherung der Summe durch ein Integral wird im Limes N → ∞ exakt. Abbildung 1.2 auf

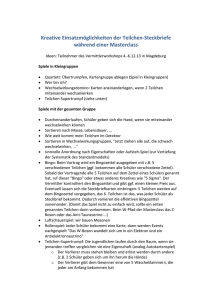

der nächsten Seite zeigt den exakten und genäherten Ausdruck für Ω(N, M ) für N = 30.

11

8

2×10

8

10

Ω(30,Μ)

6

10

8

1×10

4

10

2

10

0

10 -30

-20

-10

0

M

10

20

30

0

-30

-20

-10

0

M

10

20

30

Abbildung 1.2: Der exakte Ausdruck für Ω(N, M ) (durchgezogene Linie) und der genäherte Ausdruck

(gestrichelte Linie) für N = 30, einmal mit logarithmischer und einmal mit linearer Achsenskalierung.

1.5.3

Poissonverteilung

Die Poissonverteilung ist ein Grenzfall der Binomialverteilung, wenn die Gesamtzahl der Ereignisse, N ,

sehr groß ist, aber die Zahl der ”Treffer”, k (sie wurde vorher mit n bezeichnet), relativ klein. Hier sind

ein paar Beispiele:

• Es hat angefangen zu regnen, und man betrachtet die Regentropfenflecken auf den Fliesen der

Veranda. Sei N die Gesamtzahl der Regentropfen, die bisher in der Umgebung des Hauses gefallen

sind, und k die Zahl der Tropfen auf einer bestimmten Fliese. Wenn wir davon ausgehen dürfen,

dass jeder Tropfen mit derselben Wahrscheinlichkeit auf jedem Flächenelement von der Größe einer

Fliese landet, ist die Wahrscheinlichkeitsverteilung für k eine Poisson-Verteilung.

• Wenn eine menschliche Zelle sich teilt, müssen 6 Milliarden DNA-Buchstaben kopiert werden. Bei

jedem dieser Buchstaben werde in einer gewissen Zellkultur mit einer Wahrscheinlichkeit 10−9 ein

Kopierfehler gemacht. Die Zahl der daraus resultierenden Punktmutationen k in einer Zelle ist

Poisson-verteilt.

• In Deutschland sterben jedes Jahr 60000 Personen am Herzinfarkt, das ist einer von 1300. Die Zahl

der Personen, die in einem Ort mit 5000 Einwohnern in einem Jahr an einem Herzinfarkt sterben,

ist Poisson-verteilt. (Wenn wir davon ausgehen dürfen, dass das Risiko unabhängig vom Wohnort

ist.)

• Gegeben seien N Atome eines radioaktiven Materials, z.B. Uran-238. Die Halbwertszeit dieser Atome beträgt 4,5 Milliarden Jahre. Die Zahl der Atome, die in einer Probe aus 1018 Atomen in einer

Sekunde zerfallen, ist durchschnittlich 5 (wenn ich mich nicht verrechnet habe), und sie folgt einer

Poissonverteilung.

Ein wichtiger Parameter der Poisson-Verteilung ist der Mittelwert k̄ von k. Er hängt mit der Trefferwahrscheinlichkeit p (wurde vorher w genannt) zusammen über p = k̄/N . Damit beträgt die Wahrscheinlichkeit, genau k Treffer zu haben

N k

pk̄ (k) =

p (1 − p)N −k

k

N −k

N (N − 1)(N − 2) . . . (N − k + 1) k̄ k

k̄

k̄

=

1−

1−

k!

Nk

N

N

12

−k

k̄

1−

N

−k

N (N − 1)(N − 2) . . . (N − k + 1)

k̄

1−

Nk

N

N (N − 1)(N − 2) . . . (N − k + 1)

Nk

=

≃

k̄ k

k!

N

k̄

1−

N

k̄ k −k̄

e

k!

k̄ k −k̄

e

k!

≃

(1.21)

N

k̄

= e−k̄ verwendet, und im letzten Schritt haben

Im vorletzten Schritt haben wir wieder limN →∞ 1 − N

wir die ersten beiden Faktoren durch ihren Grenzwert 1 ersetzt, den sie im Limes N → ∞ annehmen.

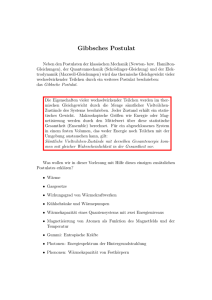

Abbildung 1.3 zeigt eine Poissonverteilung für k̄ = 7.

0

0,15

10

-3

10

P(k)

0,10

-6

10

0,05

-9

10

-12

10

0

5

10

15 20

k

25

0,00

30

0

10

k

5

15

20

Abbildung 1.3: Poissonverteilung P (k) für k̄ = 7.

Der Mittelwert von k beträgt

hki =

X

kpk̄ (k) = k̄

∞

X

k̄ k−1 −k̄

e = k̄

(k − 1)!

k=1

k

und der Mittelwert von k 2 ist

hk 2 i =

=

X

k 2 pk̄ (k) =

k

k̄ 2

X

k

k(k − 1)pk̄ (k) +

∞

X

k̄ k−2 −k̄

e + k̄ = k̄ 2 + k̄ .

(k − 2)!

X

kpk̄ (k)

k

k=2

Damit beträgt die Varianz von k

hk 2 i − hki2 = k̄ ,

√

und die Standardabweichung ist k̄.

Für große k̄ lässt sich pk̄ (k) so wie in der Rechnung (1.18) durch eine Gauß-Funktion nähern:

2

pk̄ (k) ≃

1.6

e−(k−k̄) /2k̄

√

2π k̄

Zentraler Grenzwertsatz

Das Ergebnis (1.19) für p(M ) des vorletzten Teilkapitels ist ein Beispiel des zentralen Grenzwertsatzes.

Er lautet in seiner für diese Vorlesung relevanten Form folgendermaßen: Gegeben seien N voneinander

13

unabhängige, identisch verteilte Zufallsvariablen xi (i = 1, . . . , N ), von denen jede den Mittelwert hxi

Pund

die Standardabweichung σx > 0 hat. Dann ist die Wahrscheinlichkeit, dass sich die Summe X = i xi

im Intervall [X, X + dX] befindet, gegeben durch

2

hxi)

1

− (X−N

2

2N σx

P (X)dX = p

e

dX .

2πN σx2

P (X) ist eine Wahrscheinlichkeitsdichte. Im Beispiel mit den Elementarmagneten ist die Zufallsgröße das

einzelne magnetische Moment, und die Größe X das gesamte magnetische Moment.

Für den Beweis führen wir die Variable

X

√

(xi − hxi)/ N

(1.22)

Z=

i

ein und notieren die Wahrscheinlichkeitsdichten für die einzelnen Zufallsvariablen xi mit P1 (xi ). Die

Wahrscheinlichkeitsdichte für Z ergibt sich dann zu

Z

x1 + . . . + xN √

√

+ N hxi

PZ (Z) =

dx1 . . . dxN P1 (x1 ) . . . P1 (xN )δ Z −

N

Z

Z

√

−ik(x1 +...xN )

dk ikZ

√

+ik N hxi

N

e

dx1 . . . dxN P1 (x1 ) . . . P1 (xN )e

=

2π

N

Z

k

dk ikZ+ik√Nhxi

χ √

e

=

2π

N

Z

dk ikZ+ik√Nhxi+N ln χ(k/√N )

,

(1.23)

=

e

2π

√

wobei χ(q)

√die charakteristische Funktion zu P1 (x) ist. Wenn wir im Exponenten die Funktion ln χ(k/ N )

in q = k/ N Taylor-entwickeln, werden in Verbindung mit dem Faktor N davor alle Terme jenseits des

quadratischen Terms in Limes N → ∞ gegen Null gehen. Die Koeffizienten, die in dieser Taylorentwicklung auftreten, nennt man die Kumulanten Cn , also

ln χ(q) =

∞

X

(−iq)n

Cn

n!

n=1

(1.24)

Die Kumulanten hängen eng mit den Momenten zusammen, und durch Einsetzen der Momentenentwicklung aus (1.7) auf der linken Seite von (1.24) erhalten wir die folgenden Ausdrücke für die ersten drei

Kumulanten:

C1

=

C2

C3

=

=

So erhalten wir schließlich

hxi

hx2 i − hxi2 = σx2

hx3 i − 3hx2 ihxi + 2hxi3

(1.25)

dk ikZ− 1 k2 σx2 +iC3 k3 /6√N+...

2

.

(1.26)

e

2π

Im Limes N → ∞ bleiben nur die ersten beiden Terme im Exponenten übrig, und Ausführen des Integrals

ergibt

2

1

−Z

(1.27)

PZ (Z) = p

e 2σx2 .

2πσx2

PZ (Z) =

Z

Wenn wir von der Variable Z zur Variable X wechseln und dabei berücksichtigen, dass PZ (Z)dZ =

P (X)dX sein muss, erhalten wir

2

hxi)

1

− (X−N

2N

2σx

P (X) = p

.

e

2πN σx2

14

(1.28)

Dies ist der√zentrale Grenzwertsatz. Das Gleichheitszeichen in der letzten Gleichung gilt für festes Z =

(X − hXi)/√ N im Limes N → ∞. Es gilt darüber hinaus aber auch für Abstände (X − hXi), die mit N

stärker als N anwachsen, solange der größte vernachlässigte Term immer noch gegen 0 geht. Um seine

Größenordnung abzuschätzen, formen wir den vernachlässigten Faktor um,

√

√

3

eiC3 k /6 N ≃ 1 + iC3 k 3 /6 N ,

(1.29)

und wir berücksichtigen, dass der Hauptbeitrag zu dem Integral (1.23) von k-Werten der Größenordnung

2iZ/σx2 kommt (weil dort der Exponent Null wird). Also wird der vernachlässigte Faktor zu

1+

4C3 (X − hXi)3

4Z 3 C3

√ =1+

.

3N 2 σx6

3σx6 N

Dieser Faktor darf in der Tat vernachlässigt werden, wenn |X − hXi| sich in einem Intervall befindet, das

mit wachsendem N langsamer als N 2/3 ansteigt. Im Grenzfall N → ∞ geht dieser Faktor dann gegen

1/3

Null. Für Werte |X − hXi|, die die Größenordnung N 2/3 σx2 /C3 übersteigen, gilt also die Gaußsche

Näherung nicht mehr, und diese Abweichung im Schwanz der Verteilung sieht man sehr schön in Abb.1.2.

Dort ist N nur 30, und 302/3 ≃ 10. Also werden die Abweichungen sichtbar, wenn M die Größenordnung

10 erreicht. (Da bei dieser Überlegung konstante Faktoren weggelassen wurden, ist es überhaupt kein

Problem, dass die Abweichung erst jenseits von 15 gesehen werden kann.)

Als weiteres Anwendungsbeispiel des Zentralen Grenzwertsatzes betrachten wir noch einmal das System aus unabhängigen Elementarmagneten und fragen nach der Wahrscheinlichkeit dafür, dass der Anteil

γ aller Elementarmagnete den Wert +1 hat. Wir nennen N+ = γN die Zahl der Magnete, die den Wert +1

haben. Also ist p(γ) = B(N+ , N ). Dies ist ein Beispiel, für das der zentrale Grenzwertsatz vewendet werden kann: Jeder Elementarmagnet trägt mit Wahrscheinlichkeit w mit einem Summanden 1 zu N+ bei und

mit Wahrscheinlichkeit 1 − w mit dem Summanden 0. Also trägt jeder Elementarmagnet im Durchschnitt

einen Summanden w zu N+ bei. Die Varianz jedes Einzelbeitrags ist w(1 − w)2 + qw2 = w(1 − w) = wq.

Also gilt nach dem zentralen Grenzwertsatz

P (N+ ) = √

(N+ −wN )2

1

e− 2wqN = p(N+ ) .

2πN wq

(1.30)

Weil der Abstand zweier benachbarter N+ -Werte 1 ist, tritt beim Wechsel von P zu p kein weiterer Faktor

auf. Für P (γ) ergibt sich

s

P (γ) =

2

N − (γ−w)

e 2wq/N .

2πwq

Dieses letzte Ergebnis kann man auf zwei Arten begründen: Erstens dadurch, dass jeder Elementarmagnet

wq

w

im Durchschnitt einen Summanden N

zu γ und einen Summanden N

2 zu seiner Varianz beiträgt, und

zweitens dadurch, dass man in (1.30) einen Variablenwechsel N+ = N γ macht und dafür sorgt, dass die

neue Verteilung wieder richtig normiert ist. (Es muss gelten P (γ)dγ = P (N+ )dN+ .)

1.7

Information

Der in der Thermodynamik eingeführte und in späteren Kapiteln wichtige Begriff der Entropie hängt

eng mit dem Begriff der Information zusammen. Entropie ist ein Maß für unsere Unkenntnis des genauen

mikroskopischen Zustands, in dem das System sich befindet, wenn wir nur die makroskopischen Variablen

kennen. Information ist ein Maß für unseren Kenntnisgewinn, wenn wir erfahren, in welchem mikroskopischen Zustand sich das System befindet. Dieser entspricht natürlich dem Ausmaß der Unkenntnis, die

wir vorher hatten.

Allerdings ist “Information” ein Konzept, das viel breiter angewandt wird als nur in der statistischen

Mechanik. Allgemein ist Information ein Maß für unseren durchschnittlichen Kenntnisgewinn, wenn wir

erfahren, welches Ereignis aus einer Menge von möglichen Ereignissen tatsächlich eingetreten ist. Sei x

15

eine Zufallsvariable, die die Werte xi jeweils mit der Wahrscheinlichkeit pi annimmt, wobei

Die mit dieser Wahrscheinlichkeitsverteilung verbundene Information ist

X

pi log2 pi .

I({pi }) = −

P

i

pi = 1.

(1.31)

i

Um diese Definition zu verstehen, betrachten wir zunächst den Fall dass die pi = 2−n sind. Dann ist

I({pi }) = n. Das ist die Zahl von Ja/Nein-Fragen, die man benötigt, um herauszufinden, welches Ereignis

eingetreten ist. Anders formuliert ist es die Zahl von Bits, die man benötigt, um das Ereignis eindeutig zu

spezifizieren. Wenn die Ereignisse verschiedene Wahrscheinlichkeiten haben, ist der Informationsgewinn

niedrig, wenn ein Ereignis eintritt, dessen Wahrscheinlichkeit hoch ist, und hoch, wenn ein Ereignis

eintritt, dessen Wahrscheinlichkeit niedrig ist. Wenn ein Ereignis eintritt, das die Wahrscheinlichkeit pi

hat, ist unser Informationsgewinn − log2 pi , unabhängig davon, wie sich der Rest der Wahrscheinlichkeit

auf die übrigen Ereignisse aufteilt. Wenn wir diesen Informationsgewinn über alle Ereignisse mitteln

(dabei müssen sie jeweils mit ihrer Wahrscheinlichkeit gewichtet werden), erhalten wir die Definition

(1.31).

Ursprünglich wurde das Konzept der Information von Shannon im Zusammenhang mit der Datenübertragung eingeführt. Wir betrachten einen Datensatz, der aus den Zeichen {xi } aufgebaut ist,

die jeweils die Häufigkeit pi haben. Dieser Datensatz soll binär kodiert werden. Die kürzeste Kodierung

bekommt man, wenn man für häufige Zeichen wenig Bits und für seltene Zeichen mehr Bits verwendet,

also für ein Zeichen der Häufigkeit pi eine AnzahlPvon − log2 pi Bits. Um eine Botschaft aus N Zeichen

zu kodieren, benötigt man also mindestens −N i pi log2 pi Bits. Dies ist der Informationsgehalt der

Botschaft.

Wie oben erwähnt, hängen Entropie und Information eng miteinander zusammen. Die beiden Formeln

sind proportional zueinander. In der Formel für die Entropie steht statt dem log2 ein kB ln, wobei kB die

Boltzmann-Konstante ist.

1.8

Das Prinzip der maximalen Ignoranz

In der statistischen Physik ist es oft nicht möglich, die Wahrscheinlichkeiten der verschiedenen mikroskopischen Zustände dadurch zu bestimmen, dass man die Häufigkeit ihres Auftretens misst. Also müssen

die Werte für diese Wahrscheinlichkeiten zunächst postuliert werden. Anschließend kann man testen, ob

die aus diesen postulierten Werten resultierenden Eigenschaften des Systems mit der Beobachtung übereinstimmen. Wenn sie es nicht tun, hat man bei den Überlegungen eine wichtige Eigenschaft der Systeme

nicht berücksichtigt. Die Regel für das Postulieren der Werte der Wahrscheinlichkeiten ist folgende: man

geht davon aus, dass es zusätzlich zu dem, was man schon weiß, nichts gibt, was sich auf die Werte

der Wahrscheinlichkeiten auswirkt. Diese Art von Zugang zur statistischen Physik wurde sehr schön von

E.T. Jaynes im Jahr 1957 ausgearbeitet (Phys. Rev. 106, 620-630 und Phys. Rev. 108, 171-190). Wir

betrachten 3 Fälle, die später bei der Behandlung der statistischen Ensembles wichtig werden.

Wenn wir keinen Grund wissen, einen Zustand gegenüber einem anderen zu bevorzugen, postulieren

wir gleiche Wahrscheinlichkeiten pi = 1/N für alle Zustände. Dies können wir aus dem Prinzip der maximalen Ignoranz formal herleiten. Dieses Prinzip besagt, dass die “Ignoranz”, also die für die Spezifizierung

eines Mikrozustandes

benötigte Information I({pi }) maximal sein soll, unter Verwendung der NebenbeP

dingung i pi = 1 und eventuell weiterer bekannter Nebenbedingungen. In dem hier betrachteten Fall

gibt es keine weiteren Nebenbedingungen. Formal wird eine Maximierung mit Nebenbedingungen mit

Hilfe von Lagrange-Multiplikatoren durchgeführt. Es ist also der Ausdruck

!

X

X

pi − 1

pi log2 pi − λ

−

i

i

zu maximieren bezüglich der Wahl der pi und von λ, d.h. die Ableitung dieses Ausdrucks nach all diesen

Größen muss verschwinden. Damit gewährleisten wir gleichzeitig, dass die Nebenbedingung erfüllt ist und

16

dass I({pi }) den größten mit der Nebenbedingung verträglichen Wert annimmt. Ableitung nach pi gibt

die Bedingung

−1 − ln pi − λ ln 2 = 0

oder

pi = e−1−λ ln 2 .

Alle pi sind also gleich, und ihr Wert (bzw. der von λ) ist durch die Normierungsbedingung festgelegt.

Wir betrachten als nächstes die Situation, dass sich die Mikrozustände des Systems in den Werten

einer Variable x unterscheiden können. Sie nimmt im Zustand Nummer i (mit i = 1, . . . N ) den Wert xi

an. Es sei der Mittelwert hxi der Variable gegeben, was eine zweite Nebenbedingung an die pi ist. Dann

benötigt man zwei Lagrange-Parameter, und es ist der Ausdruck

!

!

X

X

X

pi xi − hxi

pi − 1 − µ

pi log2 pi − λ

−

i

i

i

zu maximieren bezüglich der Wahl der pi und von λ und µ. Ableitung nach pi gibt die Bedingung

−1 − ln pi − λ ln 2 − xi µ ln 2 ≡ −1 − ln pi − λ̃ − µ̃xi = 0

oder

pi = e−1−λ̃−µ̃xi .

Die Werte von λ und µ sind so zu wählen, dass die beiden Nebenbedingungen erfüllt sind. Der Wert von

λ wird durch die Normierung der Wahrscheinlichkeiten festgelegt. Mit der Umformung e1+λ̃ = Z erhalten

wir

e−µ̃xi

pi =

(1.32)

Z

woraus

X

(1.33)

e−µ̃xi

Z=

i

folgt. Der Wert von µ ist so festzulegen, dass der Mittelwert von x den vorgegebenen Wert hxi hat. Der

Zusammenhang zwischen µ und hxi ist

d ln Z

.

(1.34)

hxi = −

dµ̃

Wenn es zwei Zufallsvariablen x und y gibt, die im Zustand Nummer i die Werte xi bzw. yi annehmen,

und wenn die Mittelwerte von beiden vorgegeben sind, ist der Ausdruck

!

!

!

X

X

X

X

pi yi − hyi

pi xi − hxi − ν

pi − 1 − µ

pi log2 pi − λ

−

i

i

i

i

zu maximieren. Der Index i zählt jetzt alle möglichen Kombinationen der Werte von x und y durch, und

xi bzw. yi bezeichnen den Wert von x und y im Zustand i. Es ergibt sich

pi =

mit

Z=

e−µ̃xi −ν̃yi

Z

X

e−µ̃xi −ν̃yi

(1.35)

(1.36)

i

und ν̃ = ν ln 2. Der Wert von µ ergibt sich aus der Bedingung

hxi = −

d ln Z

,

dµ̃

(1.37)

d ln Z

.

dν̃

(1.38)

und der Wert von ν ergibt sich aus der Bedingung

hyi = −

17

1.9

Zusammenhang mit dem Entropiesatz

Aus dem Prinzip der maximalen Ignoranz folgt der Entropiesatz. Das Prinzip der maximalen Ignoranz

besagt, dass in einem abgeschlossenen System alle durch die Dynamik erreichbaren Zustände gleich wahrscheinlich sind. Wir können die verschiedenen Zustände des Systems in Gruppen zusammenfassen, die

jeweils mit denselben makroskopischen Eigenschaften einhergehen. Für unser Beispiel mit den Elementarmagneten ist diese makroskopische Eigenschaft das gesamte magnetische Moment. Es gibt also zu

jedem “Makrozustand” viele “Mikrozustände”. Aus dem Prinzip der maximalen Ignoranz folgt, dass die

Wahrscheinlichkeit, im System einen bestimmten Makrozustand zu beobachten, gleich dem Anteil der

Mikrozustände ist, die zu diesem Wert der makroskopischen Beobachtungsgröße gehören. In Systemen

aus ca. 1023 Teilchen unterscheiden sich diese Wahrscheinlichkeiten normalerweise so krass, dass fast alle

Mikrozustände in einem schmalen Bereich um den wahrscheinlichsten Wert der Beobachtungsgröße liegen.

Die Zahl der Mikrozustände, die zu anderen Werten der Beobachtungsgröße gehören, ist deutlich geringer. Im Gleichgewicht wird also derjenige Makrozustand angenommen, der die meisten Mikrozustände

hat, also die größte Entropie. Wenn das System in einem anderen Makrozustand initialisiert wird, wird

die Entropie also zunehmen, bis sie ihren Maximalwert erreicht, also bis die Beobachtungsgröße ihren

wahrscheinlichsten Wert annimmt.

Die Wahrscheinlichkeit, dass ein System den Mikrozustand Nummer i annimmt, sei pi . Die Entropie

ist dann definiert als

X

pi ln pi

(1.39)

S = −kB

i

−23

mit der Boltzmannkonstanten kB = 1, 38 × 10 J/K. Wenn alle pi identisch sind, vereinfacht sich diese

Formel zu

S = kB ln Ω ,

(1.40)

wobei Ω = 1/pi die Zahl der Mikrozustände ist.

Wir konkretisieren die obige Überlegungzum Entropiesatz am Beispiel des Systems aus Elementarmagneten. In unserem Modellsystem aus magnetischen Momenten (Abschnitt 1.4.1.) sind die Mikrozustände

die verschiedenen Kombinationen von Spineinstellungen. Wir betrachten die Situation, dass kein Magnetfeld angelegt wurde. Dann haben alle 2N Konfigurationen dieselbe Energie. Das Prinzip der maximalen

Ignoranz besagt nun, dass wir keinen Grund haben, einen dieser Mikrozustände zu bevorzugen, und

dass deshalb alle Mikrozustände gleich wahrscheinlich sind. Wir können nun fragen, welchen Wert der

Gesamtmagnetisierung wir beobachten werden. Es gibt Ω(N, M ) Mikrozustände mit derselben Gesamtmagnetisierung M/N . Die Wahrscheinlichkeit, die Magnetisierung M/N zu beobachten, beträgt für große

N

r

2 − M2

N

e 2N .

Ω(N, M )/2 ≃

(1.41)

πN

Dies ist eine sehr

√ scharf um Null zentrierte Gaußverteilung. Die Standardabweichung ∆M/N ist

proportional zu 1/ N . Für einen makroskopischen Festkörper ist N von der Größenordnung 1023 und

die Standardabweichung der Magnetisierung ist daher von der Größenordnung 10−11 , also winzig.

Nun ordnen wir den Zuständen mit der verschiedenen Magnetisierung eine Entropie zu. Sie beträgt

S(M, N ) = kB ln Ω(N, M ) .

(1.42)

Sie hat also ihr Maximum dort, wo Ω(N, M ) sein Maximum hat, und das ist bei M = 0. Wenn wir am

Anfang unser System so präparieren, dass alle Elementarmagneten in dieselbe Richtung zeigen, haben wir

einen Anfangszustand mit Entropie S = 0. Durch die Dynamik in dem System werden nun alle Spins hinund herflippen, so dass über längere Zeit alle Spinkonfigurationen gleich häufig sind. M wird abnehmen

und schließlich den Wert Null erreichen.

Wir betrachten noch ein zweites Beispiel, das für die Überlegungen der nächsten beiden Kapitel wichtig

ist. In einer Kammer seien N Atome eines idealen Gases. Diese Atome können sich nicht durchdringen

und führen miteinander elastische Stöße aus. Es gibt sonst keine Wechselwirkung zwischen den Atomen.

In einem abgeschlossenen System ist dann die Gesamtenergie durch die gesamte kinetische Energie der

18

Atome gegeben. Das Prinzip der maximalen Ignoranz besagt nun wieder, dass alle Zustände zur gleichen

Energie gleich wahrscheinlich sind. Da die Position eines Atoms keinen Einfluss auf seine Energie hat,

sind also auch alle Positionen eines Atoms gleich wahrscheinlich (wir gehen davon aus, dass die Atome

nur einen sehr kleinen Anteil des Gesamtvolumens einnehmen, so dass ein Überlapp unwahrscheinlich ist,

wenn wir die Positionen zufällig wählen). Wir unterteilen das Volumen in n gleich große Teilvolumina,

und unsere Beobachtungsgröße, also unser Makrozustand, sei die Atomdichte in diesen Teilvolumina.

Jedes Atom ist mit gleicher Wahrscheinlichkeit in jedem dieser Teilvolumina. Die mittlere Anteil von

Atomen in einem Teilvolumen ist 1/n, und die Varianz dieses Anteils ist ungefähr 1/N n. Diese Varianz

berechnet man folgendermaßen: Wir verteilen die Atome zufällig auf die Teilvolumina, indem wir jedes

Atom mit derselben Wahrscheinlichkeit in jedes der n Teilvolumina setzen. Wir betrachten ein bestimmtes

Teilvolumen. Die Wahrscheinlichkeit, dass ein gegebenes Atom in diesem Teilvolumen landet, beträgt

1/n. Wenn es dort landet, macht es einen Beitrag 1/N zu unserer Messgröße (Anteil der Atome in diesem

Teilvolumen), im anderen Fall macht es den Beitrag Null. Die Varianz dieses Beitrags ist

1

n

1

1

−

N

nN

2

2

1

1

1

+ 1−

≃

.

n

nN

nN 2

Im letzten Schritt haben wir angenommen, dass n viel größer als 1 ist. Nach dem zentralen Grenzwertsatz

ist die gesamte Varianz N mal die Varianz eines Teilchens, also 1/nN . Wenn N von der Größenordnung

1023 ist, ist die Schwankung um die mittlere Dichte extrem klein.

Im Gleichgewicht ist also die Atomdichte in jedem Teil des Volumens gleich. Wenn wir das System mit

einer ungleichen Verteilung starten, wird die Entropie solange zunehmen, bis die gleichmäßige Verteilung

erreicht ist.

Übungsaufgaben zu Kapitel 1

1. In einem Gefängnis sitzen drei zum Tode verurteilte Gefangene: Anton, Brigitte und Clemens. Genau

einer von ihnen soll begnadigt werden. Dazu wird ein Los gezogen, das allen die gleiche Chance gibt,

begnadigt zu werden. Der Gefangene Anton, der also eine Überlebenswahrscheinlichkeit von 1/3

hat, bittet den Wärter, der das Ergebnis des Losentscheids kennt, ihm einen seiner Leidensgenossen

Brigitte oder Clemens zu nennen, der oder die sterben muss. Der Wärter antwortet “Brigitte”. Wie

hoch ist nun Antons Überlebenswahrscheinlichkeit? Wie hoch ist nun die Überlebenswahrscheinlichkeit von Clemens? (Lösung auf http://de.wikipedia.org/wiki/Gefangenenparadoxon)

2. Im Folgenden ist ein Argument von Gegnern der Evolutionstheorie wiedergegeben. Finden Sie dieses

Wahrscheinlichkeitsargument überzeugend? Consider the alpha chain of human hemoglobin - a key

component of blood which serves as a transfer agent for oxygen. The alpha hemoglobin molecule is a

protein chain based on a sequence of 141 amino acids, and the hemoglobin of virtually every human

has the same sequence. There are 20 different amino acids common in living systems. Thus the

number of different chains (141 amino acids long) is 20141 , or roughly 10183 . If 5 billion years ago,

as many as 1040 amino-acid molecule generators, each producing a different randomly chosen 141

amino-acid sequence one billion times per second, began generating sequences, then at the present

point in time only about 1066 sequences would have been generated. Thus the probability that human

alpha hemoglobin would have been produced is about 1066 /10183 = 10−117 , a fantastically small

number. Thus no conventional theory of molecular evolution can account for the origin of human

alpha hemoglobin.

3. Random Walk: Ein Besoffener hat völlig die Orientierung verloren und überlegt nach jedem Schritt

neu, in welcher Richtung der nächste Schritt gehen soll. Er entscheidet sich jedes Mal mit Wahrscheinlichkeit 1/2 für einen Schritt nach rechts und mit Wahrscheinlichkeit 1/2 für einen Schritt

nach links. Wenn die Schrittgröße einen Meter beträgt, was ist dann die Abstandverteilung vom

Ausgangsort nach N Schritten? Was ergibt sich nach dem zentralen Grenzwertsatz für große N ?

Mit welcher Potenz von N wächst demnach die mittlere Entfernung vom Ausgangsort?

19

4. Punktmutationen, die beim Duplizieren der DNA entstehen, werden durch ausgeklügelte Korrekturmechanismen so gut korrigiert, dass pro Generation nur eine Punktmutation in 50 Millionen

Basenpaaren entsteht. Das Chromosom Nummer 10 des Menschen hat 135 Millionen Basenpaare. Was sind die Wahrscheinlichkeiten dafür, dass ein Chromosom 10 des Kindes keine, eine, zwei

Punktmutationen gegenüber dem elterlichen Chromosom 10 bekommt?

5. Auf einer Single-Party sind 64 Männer und 128 Frauen. Am Ende der Party ist jeder Mann mit

einer der Frauen befreundet. Das ist die einzige Information, die ich bis jetzt von der Party habe.

Was ist mein Informationsgewinn (in Bit), wenn ich erfahre, dass Silke seit der Party mit Erwin

befreundet ist? Was ist mein Informationsgewinn (in Bit), wenn ich nur erfahre, dass Silke auf der

Party einen Freund gefunden hat?

6. Von einer Zufallsvariable x ist nur bekannt, dass ihr Mittelwert x̄ ist und die Varianz σ 2 . Leiten

Sie mit Hilfe des Prinzips der maximalen Ignoranz die Wahrscheinlichkeitsverteilung p(xi ) ab. Berechnen Sie explizit die Werte der Lagrange-Parameter für den Fall, dass die möglichen Werte von

x äquidistant den Bereich von −∞ bis ∞ abdecken. Nehmen Sie dabei an, dass der Abstand benachbarter xi -Werte sehr viel kleiner als σ ist, so dass Sie die auftretenden Summen durch Integrale

ersetzen können.

20

Kapitel 2

Von der klassischen Mechanik zur

statistischen Mechanik

2.1

Die Aufgabe

Bevor es die Quantenmechanik gab, versuchte man, die statistische Mechanik auf die klassische Mechanik

zurückzuführen. Man stellte sich zum Beispiel ein ideales Gas als viele kleine harte Kügelchen vor, die

den Newtonschen Gesetzen folgen und miteinander und mit den Wänden elastische Stöße ausführen. Da

jeder dieser Stöße reversibel ist und auch die Bewegung zwischen den Stößen reversibel ist, stellt sich

die Frage, woher die Irreversibilität der Thermodynamik kommt, die sich zum Beispiel im Entropiesatz

manifestiert. Da die klassische Mechanik deterministisch ist, stellt sich weiterhin die Frage, wo der Zufall

ins Spiel kommt, der in der statistischen Mechanik eine so wichtige Rolle spielt. Um diesen Fragen nachzugehen, beschreiben wir zunächst die Dynamik des “Gases” aus harten Kugeln durch die Hamiltonschen

Bewegungsgleichungen und gehen in den Phasenraum. Wir werden dann überlegen, wie ein Ensemble von

anfangs sehr ähnlichen Systemen sich mit der Zeit entwickelt.

2.2

Die Liouville-Gleichung

Wir betrachten ein “Gas” aus N Teilchen, das in eine Kammer eingesperrt ist. Der Bewegungszustand

jedes der N Teilchen wird durch drei Ortskoordinaten und drei Impulskomponenten festgelegt. Wir nummerieren die 3N Ortskoordinaten qi und die 3N Impulskoordinaten pi entsprechend von 1 bis 3N . Sie

genügen den Hamiltonschen Bewegungsgleichungen

∂H

∂qi

∂H

,

∂pi

ṗi

= −

q̇i

=

(2.1)

wobei H die Hamiltonfunktion ist. Die Dynamik des gesamten Teilchengases lässt sich also durch die

Trajektorie eines Punktes im 6N -dimensionalen Phasenraum darstellen. Wir schreiben

~x = (p1 , . . . , p3N , q1 , . . . , q3N ) .

(2.2)

Die Bewegungsgleichungen (2.1) lassen sich also zusammenfassen als

ẋi = fi (~x)

mit der durch die rechte Seite von (2.1) gegebenen Funktion f~.

21

(2.3)

Um die Brücke zwischen der klassischen Mechanik und der statistischen Mechanik zu bauen, betrachtet man nun nicht ein einzelnes System, sondern ein ganzes Ensemble von solchen Systemen. Da man

die Anfangsbedingung sowieso nicht mit beliebiger Genauigkeit angeben kann, betrachtet man das Ensemble von Systemen, deren Anfangszustand im Rahmen einer gewählten Genauigkeit übereinstimmt.

Im Phasenraum füllen all diese Anfangszustände des Ensembles ein kleines endliches Volumen aus. Wir

wählen das Ensemble so, dass die Dichte der Systeme in diesem kleinen Volumen einen konstanten Wert

̺0 hat und außerhalb verschwindet. Nun betrachtet man die zeitliche Entwicklung all dieser Systeme

gleichzeitig im Phasenraum. Jeder Punkt des anfänglich gewählten Volumenelements bewegt sich gemäß

Gleichung (2.3). Das Volumenelement bewegt sich also und deformiert sich dabei. Wir zeigen zunächst,

dass sich das Gesamtvolumen dabei nicht ändert. Hierzu machen wir den Ansatz V = l1 l2 . . . l6N (mit

infinitesimalen li ), wir gehen also davon aus, dass das Volumenelement ein 6N -dimensionaler “Quader”

(i)

(i)

ist, dessen Kanten sich in jeder der 6N Dimensionen von xa bis xe erstrecken. Durch Taylorentwicklung

(1)

(1)

erhalten wir l˙1 = ẋe − ẋa ≃ l1 ∂f1 /∂x(1) . Damit folgt

V̇

= l˙1 l2 . . . l6N + l˙2 l1 l3 . . . l6N + . . .

∂f1

∂f2

=

l1 l2 . . . l6N + (2) l2 l1 l3 . . . l6N + . . .

(1)

∂x

∂x

X ∂fi

=

l1 l2 . . . l6N

∂x(i)

i

~ · f~ .

= V∇

(2.4)

Die Divergenz der Funktion f~ entscheidet also, wie sich das Phasenraumvolumen unter der Dynamik

ändert. Für unsere Hamiltonschen Bewegungsgleichungen gilt

~ · f~ =

∇

3N X

∂ ∂H

∂ ∂H

−

= 0.

+

∂pi ∂qi

∂qi ∂pi

i=1

(2.5)

Das Phasenraumvolumen ändert sich also nicht, sondern deformiert sich nur.

Wir bezeichnen mit ̺(~x, t) die Dichte der Zustände unseres Ensembles im Phasenraum. Sie ist am

Anfang ̺0 innerhalb des gewählten Volumenelements, und außerhalb ist sie 0. Wir haben eben gezeigt,

dass sich das Phasenraumvolumenelement unter der Hamiltonschen Dynamik deformiert, aber dass es

nicht sein Volumen ändert. Also gibt es auch zu späteren Zeiten nur Bereiche mit Dichte ̺0 und 0, die

aber immer feiner verwoben werden. Die Bewegungsgleichung, der die Dichte ̺(~x, t) genügt, nennt man

Liouville-Gleichung. Sie gilt natürlich nicht nur für den von uns betrachteten Fall, dass alle Dichtewerte

̺0 oder 0 sind, sondern auch für allgemeine Dichtewerte. Wir betrachten im Folgenden daher allgemeine

Funktionen ̺(~x, t). Wir leiten die Liouville-Gleichung aus den Hamiltonschen Gleichungen her, indem

wir mit der Kontinuitätsgleichung starten und die rechte Seite mit Hilfe der Hamiltonschen Gleichungen

umformen:

∂̺

~ ̺~x˙

= −∇

∂t

X ∂ ∂H ∂

∂H

̺

−

̺

=

∂pi

∂qi

∂qi

∂pi

i