Medienvergessenheit. Über Gedächtnis und Erinnerung in

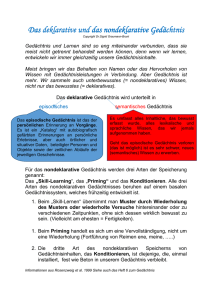

Werbung