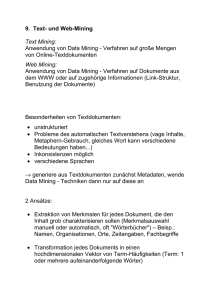

Data Warehousing und Data Mining

Werbung