Wahrscheinlichkeitsrechnung

Werbung

Wahrscheinlichkeitsrechnung

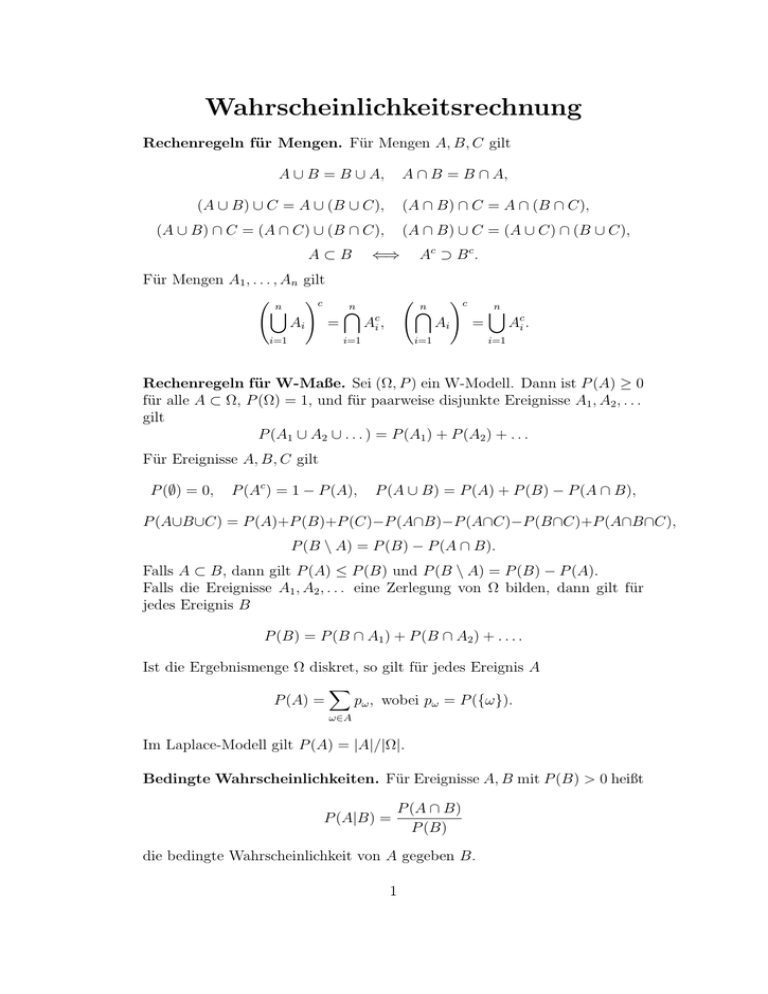

Rechenregeln für Mengen. Für Mengen A, B, C gilt

A ∪ B = B ∪ A,

A ∩ B = B ∩ A,

(A ∪ B) ∪ C = A ∪ (B ∪ C),

(A ∩ B) ∩ C = A ∩ (B ∩ C),

(A ∪ B) ∩ C = (A ∩ C) ∪ (B ∩ C),

A⊂B

(A ∩ B) ∪ C = (A ∪ C) ∩ (B ∪ C),

⇐⇒

Für Mengen A1 , . . . , An gilt

!c

n

n

[

\

Ai =

Aci ,

i=1

Ac ⊃ B c .

n

\

i=1

!c

Ai

=

i=1

n

[

Aci .

i=1

Rechenregeln für W-Maße. Sei (Ω, P ) ein W-Modell. Dann ist P (A) ≥ 0

für alle A ⊂ Ω, P (Ω) = 1, und für paarweise disjunkte Ereignisse A1 , A2 , . . .

gilt

P (A1 ∪ A2 ∪ . . . ) = P (A1 ) + P (A2 ) + . . .

Für Ereignisse A, B, C gilt

P (∅) = 0,

P (Ac ) = 1 − P (A),

P (A ∪ B) = P (A) + P (B) − P (A ∩ B),

P (A∪B∪C) = P (A)+P (B)+P (C)−P (A∩B)−P (A∩C)−P (B∩C)+P (A∩B∩C),

P (B \ A) = P (B) − P (A ∩ B).

Falls A ⊂ B, dann gilt P (A) ≤ P (B) und P (B \ A) = P (B) − P (A).

Falls die Ereignisse A1 , A2 , . . . eine Zerlegung von Ω bilden, dann gilt für

jedes Ereignis B

P (B) = P (B ∩ A1 ) + P (B ∩ A2 ) + . . . .

Ist die Ergebnismenge Ω diskret, so gilt für jedes Ereignis A

X

P (A) =

pω , wobei pω = P ({ω}).

ω∈A

Im Laplace-Modell gilt P (A) = |A|/|Ω|.

Bedingte Wahrscheinlichkeiten. Für Ereignisse A, B mit P (B) > 0 heißt

P (A|B) =

P (A ∩ B)

P (B)

die bedingte Wahrscheinlichkeit von A gegeben B.

1

Multiplikationssatz. Für Ereignisse A1 , . . . , An mit P (A1 ∩ · · · ∩ An−1 ) > 0

gilt

P (A1 ∩A2 ∩· · ·∩An ) = P (A1 )P (A2 |A1 )P (A3 |A1 ∩A2 ) · · · P (An |A1 ∩· · ·∩An−1 ).

Satz von der totalen Wahrscheinlichkeit. Bilden die Ereignisse A1 , . . . , An

eine Zerlegung von Ω mit P (Ai ) > 0 für alle i = 1, . . . , n, dann gilt für jedes

Ereignis B

n

X

P (B) =

P (B|Ai )P (Ai ).

i=1

Satz von Bayes. Bilden die Ereignisse A1 , . . . , An eine Zerlegung von Ω mit

P (Ai ) > 0 für alle i = 1, . . . , n, dann gilt für jedes Ereignis B mit P (B) > 0

P (B|Ak )P (Ak )

,

P (Ak |B) = Pn

i=1 P (B|Ai )P (Ai )

k = 1, . . . , n.

Unabhängigkeit. Ereignisse A, B heißen unabhängig, wenn P (A ∩ B) =

P (A)P (B). Die Ereignisse aus einer beliebigen Menge M von Ereignissen heißen unabhängig, falls für jede endliche Auswahl von verschiedenen

Ereignissen A1 , . . . , An ∈ M gilt

P (A1 ∩ · · · ∩ An ) = P (A1 ) · · · P (An ).

Zufallsvariable X1 , . . . , Xn heißen unabhängig, falls für alle a1 , . . . , an ∈ R

gilt

P (X1 ≤ a1 , . . . , Xn ≤ an ) = P (X1 ≤ a1 ) · · · P (Xn ≤ an ).

Falls X1 , . . . , Xn unabhängig sind, dann gilt für alle B1 , . . . , Bn ⊂ R

P (X1 ∈ B1 , . . . , Xn ∈ Bn ) = P (X1 ∈ B1 ) · · · P (Xn ∈ Bn ).

Sind X1 , . . . , Xn diskrete Zufallsvariable, dann sind X1 , . . . , Xn genau dann

unabhängig, wenn für alle b1 , . . . , bn ∈ R gilt

P (X1 = b1 , . . . , Xn = bn ) = P (X1 = b1 ) · · · P (Xn = bn ).

Eigenschaften der Verteilungsfunktion. Sei F die Verteilungsfunktion

einer Zufallsvariablen X, also F (t) = P (X ≤ t). Dann gilt

0 ≤ F (t) ≤ 1,

t ∈ R,

P (s < X ≤ t) = F (t)−F (s),

P (X > t) = 1 − F (t),

lim F (t) = 0,

t→−∞

s < t,

lim F (t) = 1,

t→∞

P (X = t) = F (t)−F (t−),

P (X ≥ t) = 1 − F (t−),

2

t ∈ R.

t ∈ R,

Rechenregeln für den Erwartungswert. X, Y seien Zufallsvariable.

E(aX + bY ) = aE(X) + bE(Y ) für alle a, b ∈ R.

E(XY ) = E(X)E(Y ), falls X und Y unabhängig sind.

E(X) ≤ E(Y ), falls X ≤ Y.

Ist X diskret mit möglichen Werten a1 , a2 , . . . , dann gilt für jede Funktion

g:R→R

X

E[g(X)] =

g(ai )P (X = ai ).

i

Ist X eine Zufallsvariable mit Dichte f , dann gilt für jede Funktion g : R → R

Z ∞

g(x)f (x) dx.

E[g(X)] =

−∞

Rechenregeln für die Varianz. X, Y seien Zufallsvariable.

Var(X) = E[(X − E(X))2 ] = E(X 2 ) − [E(X)]2 .

Var(a + bX) = Var(bX) = b2 Var(X) für alle a, b ∈ R.

Var(X + Y ) = Var(X) + Var(Y ), falls X und Y unabhängig sind.

Tschebyscheff-Ungleichung. Für jede Zufallsvariable X und alle δ > 0

gilt

Var(X)

.

P (|X − E(X)| ≥ δ) ≤

δ2

Schwaches Gesetz der großen Zahlen. Seien X1 , X2 , . . . unabhängige,

identisch verteilte Zufallsvariable. Dann gilt für alle δ > 0

1

lim P (X1 + · · · + Xn ) − E(X1 ) ≥ δ = 0.

n→∞

n

Starkes Gesetz der großen Zahlen. Seien X1 , X2 , . . . unabhängige, identisch verteilte Zufallsvariable. Dann folgt

1

P lim (X1 + · · · + Xn ) = E(X1 ) = 1.

n→∞ n

Zentraler Grenzwertsatz. Seien X1 , X2 , . . . unabhängige, identisch verteilte Zufallsvariable mit µ = E(X1 ) und σ 2 = Var(X1 ) > 0. Sei Sn =

X1 + · · · + Xn . Dann gilt für alle a < b

Z b

Sn − nµ

1

2

lim P a ≤ √

≤b = √

e−x /2 dx.

n→∞

2π a

nσ 2

3

Diskrete Verteilungen

Bernoulli-Verteilung. X ∼ BER(p), 0 ≤ p ≤ 1,

P (X = 1) = p,

P (X = 0) = 1 − p,

E(X) = p,

Var(X) = p(1 − p).

Binomialverteilung. X ∼ BIN(n, p), n ∈ N, 0 ≤ p ≤ 1,

n k

P (X = k) =

p (1 − p)n−k , k = 0, 1, . . . , n,

k

Var(X) = np(1 − p).

E(X) = np,

Geometrische Verteilung. X ∼ GEO(p), 0 < p ≤ 1,

P (X = k) = (1 − p)k−1 p,

1

E(X) = ,

p

k = 1, 2, . . . ,

Var(X) =

1−p

.

p2

Poisson-Verteilung. X ∼ POI(λ), λ ≥ 0,

P (X = k) =

λk −λ

e ,

k!

k = 0, 1, . . . ,

E(X) = Var(X) = λ.

Stetige Verteilungen

Gleichverteilung. X ∼ UNI(a, b), a < b,

0,

x < a,

x − a

, a ≤ x ≤ b,

VF: F (x) =

b−a

1,

x > b,

1 , x ∈ [a, b],

Dichte: f (x) = b − a

0,

x∈

6 [a, b],

a+b

(b − a)2

,

Var(X) =

.

2

12

Exponentialverteilung. X ∼ EXP(λ), λ > 0,

(

(

0,

x < 0,

0,

x < 0,

Dichte: f (x) =

VF: F (x) =

−λx

−λx

λe , x ≥ 0,

1 − e , x ≥ 0,

E(X) =

1

1

, Var(X) = 2 .

λ

λ

2

2

Normalverteilung. X ∼ N(µ, σ ), µ ∈ R, σ > 0,

1

(x − µ)2

Dichte: f (x) = √

exp −

,

2σ 2

2πσ 2

E(X) =

Var(X) = σ 2 .

E(X) = µ,

4

x ∈ R,

Schließende Statistik

Gegeben seien Stichprobenvariablen X1 , . . . , Xn , die jeweils dieselbe Verteilung haben wie X. Stichprobenmittel und Stichproben-Standardabweichung sind gegeben durch

v

u

n

n

X

u 1 X

1

t

Xi ,

S(n) =

(Xi − X n )2 .

Xn =

n i=1

n − 1 i=1

Schätzfunktionen

X n ist erwartungstreue Schätzfunktion für ϑ = E(X).

Erwartungstreue Schätzfunktion für ϑ = Var(X):

( P

n

1

2

i=1 (Xi − µ) , falls E(X) = µ bekannt,

n

2

,

falls E(X) unbekannt.

S(n)

ML-Schätzfunktion für

• unbekannten Parameter λ einer POI(λ)-Verteilung: X n ,

• unbekannten Parameter a > 0 einer UNI(0, a)-Verteilung: max{X1 , . . . , Xn },

• unbekannten Parameter µ einer N(µ, σ 2 )-Verteilung: X n ,

• unbekannten Parameter σ 2 einer N(µ, σ 2 )-Verteilung:

( P

n

1

2

falls µ bekannt,

i=1 (Xi − µ) ,

n

P

n

1

2

i=1 (Xi − X n ) , falls µ unbekannt.

n

Konfidenzintervalle

Konfidenzintervall für den Erwartungswert

bekannter Varianz σ 2 > 0, Konfidenzniveau

cσ

Xn − √ , Xn +

n

µ einer N(µ, σ 2 )-Verteilung mit

1 − α:

cσ

√ ,

n

wobei c das (1 − α2 )-Fraktil der N(0, 1)-Verteilung ist.

Konfidenzintervall für den Erwartungswert µ einer N(µ, σ 2 )-Verteilung mit

unbekannter Varianz σ 2 > 0, Konfidenzniveau 1 − α:

aS(n)

aS(n)

Xn − √ , Xn + √

,

n

n

wobei a das (1 − α2 )-Fraktil der t(n − 1)-Verteilung ist.

5

Testverfahren

Einstichproben-Gaußtest. X ∼ N(µ, σ 2 ), µ unbekannt, σ 2 > 0 bekannt,

Signifikanzniveau α.

H0

H1

Lehne H0 genau dann ab, wenn

µ ≤ µ0

µ > µ0

σ

X n > µ0 + √ u1−α

n

µ ≥ µ0

µ < µ0

σ

X n < µ0 − √ u1−α

n

µ = µ0

µ 6= µ0

X n − µ0 > √σ u1− α

2

n

Dabei ist u1−x das (1 − x)-Fraktil der N(0, 1)-Verteilung.

Einstichproben-t-Test. X ∼ N(µ, σ 2 ), µ und σ 2 unbekannt, Signifikanzniveau α.

H0

H1

Lehne H0 genau dann ab, wenn

µ ≤ µ0

µ > µ0

S(n)

X n > µ0 + √ v1−α

n

µ = µ0

µ 6= µ0

X n − µ0 > S√(n) v1− α

2

n

Dabei ist v1−x das (1 − x)-Fraktil der t(n − 1)-Verteilung.

χ2 -Anpassungstest. P (X = ai ) = pi , i = 1, . . . , m, wobei a1 , . . . , am

bekannt und p1 , . . . , pm unbekannt sind, Signifikanzniveau α. Für vorgegebene nicht-negative Werte p1 , . . . , pm mit p1 + · · · + pm = 1 betrachte

Hypothese

H0 : pi = pi für alle i = 1, . . . , m.

Es gelte npi ≥ 5 für alle i = 1, . . . , m. Es bezeichne Ni die absolute Häufigkeit

des Wertes ai in der Stichprobe und es sei

V =

m

X

(Ni − np )2

i

npi

i=1

.

Lehne H0 genau dann ab, wenn

V > x1−α ,

wobei x1−α das (1 − α)-Fraktil der χ2 (m − 1)-Verteilung ist.

6