Computerunterstützte Chemie EINFACHE STATISTISCHE TESTS

Werbung

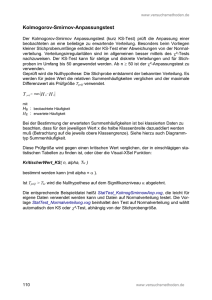

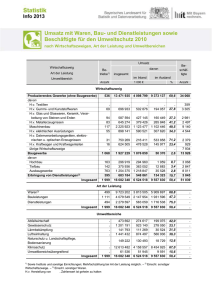

Chemometrie - Computerchemie - Chemoinformatik Chemometrics - Computer Chemistry - Chemoinformatics Ergänzende Unterlagen zu den Lehrveranstaltungen Informationsverarbeitung in der Chemie und Computerunterstützte Chemie EINFACHE STATISTISCHE TESTS Kurt VARMUZA Labor Chemometrie Institute of Chemical Engineering, Technische Universität Wien 2010 Copyright: Univ.Prof. Dr. Kurt Varmuza, c/o Labor Chemometrie, Institute for Chemical Engineering, Technische Universität Wien, Getreidemarkt 9/166, A-1060 Wien. [email protected], www.lcm.tuwien.ac.at cm_Statistik_100311.doc 1 1. Mittelwert, Standardabweichung, Varianz klassische Schätzung des Zentralwertes (central value) klassische Schätzung der Streuung (spread) 2. Empirische Häufigkeitsverteilungen DATEN: n Werte xi (i = 1 ... n) Stichprobe (sample) aus einer Grundgesamtheit (population) Einteilung der Daten in k Klassen (Intervalle) und Angabe der Anzahl Werte pro Klasse (Häufigkeit) Faustregeln für k: (a) 5 bis 20 (b) ( n )0.5 (c) 90 % der Daten in 7 Klassen Häufigkeit (Anzahl Werte) in Klasse j (frequency) Hj hj = Hj / n Shj = Σhl relative Häufigkeit, eventuell in % als 100 Hj / n mit l = 1 ... j Häufigkeits-Verteilung: Summenhäufigkeit (cumulative frequency) Histogramm mit Hj (od. hj) als Funktion von j Wahrscheinlichkeitsdichte: normiert auf Fläche = 1 (probability density function) Summenhäufigkeits-Verteilung: cm_Statistik_100311.doc Histogramm mit Shj als Funktion von j 2 n = 100 normalverteilte Werte simuliert (m = 8, s = 2) Häufigkeits-Histogramm und Wahrscheinlichkeitsdichte (geglättet) Hj 0.20 0.15 30 0.10 20 0.05 10 0 0.00 2 4 6 8 10 12 14 x 5%-Percentile = 0.05 Quantile 95%-Percentile = 0.95 Quantile Shj Summenhäufigkeit (cumulative frequency) 1.0 Verteilung der Summenhäufigkeit (Fläche der Wahrscheinlichkeitsdichte von - 4 bis x) 0.8 0.6 0.4 0.2 0.0 2 4 min x = 3.11 6 8 10 12 14 x max x = 13.47 n = 100 x-Werte aufsteigend sortiert, bei jeder Stufe um 1/n = 0.01 nach oben (gleiche Stufenhöhen, ungleiche Stufenbreiten) cm_Statistik_100311.doc 3 3. Normalverteilung "Gauss'sche Glockenkurve", bell-shaped distribution y = y = 1 s (2π)0.5 - (x - m)2 e 2s2 N(m, s) - x2 1 e 2 (2π)0.5 N(0, 1) Standard-Normalverteilung Als Wahrscheinlichkeitsdichte: Fläche unter der Gesamtkurve = 1 Transformation: normalverteilt x z standard-normalverteilt normalverteilte Zufallszahl, Mittelwert m, Standardabweichung s standard-normalverteilte Zufallszahl, m = 0, s = 1 z = (x - m) / s bzw. x = sz+m Autoskalierung (autoscaling), z-Transformation zentriert (mittelwerts-bereinigt, mean-centered) und Varianz-skaliert (variance scaled) cm_Statistik_100311.doc 4 Beispiel: Annahme: Frage: normalverteilte Daten x, m = 5.0 und s = 0.3, also N(5, 0.3) wie groß ist die Wahrscheinlichkeit für Werte x > 5.8 ? (1) Manuelle Lösung unter Verwendung der Tabellen-Daten einer Standard-Normalverteilung Autoskalieren (z-Transformation): z = (5.8 - 5) / 0.3 = 2.67 D.h.: wie groß ist die Fläche unter der Standardnormalverteilung mit z > 2.67 ? lt. Tabelle: 0.4962 daher: 0.5 - 0.4962 = 0.0038 z = 2.67 Antwort: Die Wahrscheinlichkeit für Werte x > 5.8 ist 0.0038 ≈ 0.4%. (2) Mit R Relevante Funktionen: pnorm(x, mean = <Mittelwert>, sd = <Standardabweichung>) liefert die Wahrscheinlichkeit (Fläche unter der Normalverteilung) zwischen -∞ und x d.h. die Antwort ergibt sich mit (oder: 1 - pnorm(5.8, 5, 0.3) 1 - pnorm(5.8, mean=5, sd=0.3) qnorm(p, mean = <Mittelwert>, sd = <Standardabweichung>) liefert den Quantilenwert (Grenzwert) für eine Fläche p unter der Normalverteilung zwischen -∞ und dem Quantilenwert z.B.: Der Grenzwert (Quantile) für 95% der Werte x ist qnorm(0.95, mean=5, sd=0.3) = 5.4935 (95% aller x-Werte sind < 5.4935) dnorm(x, mean = <Mittelwert>, sd = <Standardabweichung>) liefert die Dichte (probability density, Funktionswert) der Normalverteilung an der Stelle x cm_Statistik_100311.doc 5 Zentraler Grenzwertsatz (central limited theorem) Als Begründung warum viele (aber nicht alle !) Daten normalverteilt sind. Wenn a1, a2, ... ai , ... ag voneinander unabhängige Zufallsvariable sind mit beliebigen (!) Verteilungen, den Mittelwerten mi, den Standardabweichungen si , dann ist x = a1 + a2 ... + ag normalverteilt mit dem Mittelwert Σmi (i = 1 ... g) und der Varianz Σ vi (i = 1 ... g) D.h.: In Summe liefern viele, von einander unabhängige Einflüsse (ai) eine normalverteilte Variable x. Viele statistische Tests und Auswerteverfahren setzen (mehr oder weniger strikt) eine Normalverteilung der Daten voraus. Test auf Vorhandensein einer Normalverteilung: Kolmogorov-Smirnov-Test. Simulation normalverteilter Zufallszahlen 1. Gleichverteilte Zufallszahlen [0 ... 1] haben einen Mittelwert von 0.5 und eine Varianz von 1/12. 2. Wenn man 12 gleichverteilte Zufallszahlen addiert, erhält man eine neue Zufallszahl, die nach dem zentralen Grenzwertsatz normalverteilt ist, mit Mittelwert = 12 * 0.5 = 6 Varianz = 12 * (1/12) = 1 3. Durch Mittelwertsbereinigung (Subtraktion von 6) erhält man eine standard-normalverteilte Zufallszahl (z). Zusammengefaßt: cm_Statistik_100311.doc z = Σ (RNDi) - 6 i = 1 ... 12 (RNDi) gleichverteilt [0 ...1] 6 (Pseudo-) Zufallszahlen mit R Normalverteilte Zufallsszahlen > random_n = rnorm(1000, mean=0, sd=3) # # > summary(random_n) Min. 1st Qu. -11.77000 -2.07600 # Statistik 3rd Qu. Max. 1.89500 8.19900 Median 0.01395 Mean -0.09356 > hist(random_n) 1000 Zufallszahlen m = 0, s = 3 # Histogramm Gleichverteilte Zufallsszahlen (uniformly distributed random numbers) > random_u = runif(1000, 5, 10) # # > summary(random_u) Min. 1st Qu. Median 5.008 6.231 7.484 # Statistik Max. 9.995 Mean 3rd Qu. 7.501 8.782 1000 Zufallszahlen gleichverteilt zw. 5 und 10 > > hist(random_u, breaks=5) # Histogramm mit 5 Intervallen Gleichverteilte Integer-Zufallsszahlen zwischen A und B (inkl.) > random_i = round(runif(1000, A-0.5, B+0.5),0) # 1000 ganzzahlige # Zufallszahlen, gleichverteilt zw. A (z.B. 1) und B (z.B. 6) cm_Statistik_100311.doc 7 Verteilung von Mittelwerten Population N(μ, σ) μ wahrer Mittelwert (geschätzt als m) σ wahre Standardabweichung (geschätzt als s) Stichprobe aus Einzelwerten: Einzelwerte sind annährend normalverteilt: N(m, s) Stichproben aus jeweils n Einzelwerten und daraus den Mittelwert berechnen: 0.5 Mittelwerte sind annährend normalverteilt: N(m, s/n ) Engere Verteilung als bei Einzelwerten! Standardabweichung der Mittelwerte ist s/n0.5 Vertrauensintervall Verteilung der Einzelwerte oder Mittelwerte m Vertrauensintervall (confidence interval) = m + t * (Stand.abw. der Verteilung) s für Einzelwerte s/n0.5 für Mittelwerte aus n Einzelwerten Quantile (percentile) für 95%, 99%, 99.9% Flächenanteil cm_Statistik_100311.doc 8 4. Grundprinzip statistischer Tests Am Beispiel des F-Tests: Test ob sich die Standardabweichungen von 2 Stichproben signifikant unterscheiden. population N(m, s) normal distribution two randomly selected data sets data set no of data mean variance 1 n1 m1 v1 2 n2 m2 v2 in general: v1 is not equal v2 A test quantity (q) is defined: q = F = v1 / v2 H0 (zero hypothesis): both random samples are from the same population (v1 >= v2 and F >= 1) Assume many different pairs of random samples are tested by calculating F: most often F = approx. 1 (> 1) seldom F >> 1 if H0 is true very seldom F >>> 1 Probability density function (pdf) of F (parameters are n1 and n2): 0 .8 n1 = 11; n2 = 11 f1 = 10, f2 = 10 0 .6 0 .4 0 .2 0 .0 0 1 2 3 4 5 F critical value for a certain significance level (e.g. 2.98 for p = 0.05) Conclusion: IF actual value of F > critical value, THEN data sets are probably NOT from the same population, and variances differ significantly (H0 is rejected); ELSE H0 cannot be rejected, differences of variances are accidentally. cm_Statistik_100311.doc 9 H0 (Null-Hypothese): Die (2) verglichenen Datensätze stammen aus der selben Population. Die auftretenden Unterschiede bei einer Prüfgröße (q) sind zufallsbedingt. Wenn q <= Grenzwert q > Grenzwert Hohe Wahrscheinlichkeit, daß die Unterschiede zufällig sind. H0 kann nicht verworfen werden. So große Unterschiede treten nur sehr selten auf. H0 wird verworfen. Diese Aussage ist mit einer Irrtumswahrscheinlichkeit (5%, 1%, ... 0.01%) falsch. = Fehler 1. Art: H0 wird verworfen, obwohl sie richtig ist. Grenzwert = f (Größe der Datensätze, Irrtumswahrscheinlichkeit) Irrtumswahrscheinlichkeit, statistische Signifikanz, ... (p, α, ...) Bsp.: "Die Wahrscheinlichkeit, daß die beiden untersuchten Datensätze aus der selben Population stammen ist 0.002." Interpretiert heißt das, daß sie sich signifikant unterscheiden." Fehler 2. Art (β): H0 wird angenommen, obwohl sie falsch ist (die dazu erforderliche AlternativHypothese H1 ist jedoch meist schwer definierbar). Wenn α klein ist, wird β groß, und umgekehrt. Einseitiger/zweiseitiger Test One-sided (-tailed) / two-sided (-tailed) test pdf zweiseitig p = 0.05 Summe der beiden Flächen außerhalb der Grenzwerte = 5% (Bsp.: Ist m1 größer oder kleiner als m2 ?) q pdf einseitig p = 0.05 Fläche außerhalb des Grenzwertes = 5% (Bsp.: Ist m1 größer als m2 ?) q cm_Statistik_100311.doc 10 5. Verteilungen statistischer Prüfgrößen (theoretische Verteilungen) Dichtefunktion der Verteilung (probability density function, pdf ) Quantile: Grenzwerte für bestimmten Flächenabschnitt (statistische Signifikanz p). 5.1. t-Verteilung Auch Student-Verteilung, nach einer Publikation des englischen "Bierbrauers" William Gossett (bei Guiness) unter dem Pseudonym "Student" (siehe nächste Seite). Ein Parameter: Anzahl Freiheitsgrade, degree of freedom (f, ν). Ähnlich Standardnormalverteilung, jedoch breiter und flacher; für hohe Anzahl Freiheitsgrade nahezu ident mit der Standardnormalverteilung. Anwendung: Vergleich von Mittelwerten mit dem t-Test. pdf N(0, 1), f > 100 0.4 f = 10 f=4 0.3 f=2 0.2 0.1 t 0.0 -6 -4 -2 0 2 4 Quantile (beidseitiger Test) f p = 0.10 p = 0.05 p = 0.01 2 2.92 4.30 9.92 4 2.13 2.78 4.60 10 1.81 2.23 3.17 20 1.72 2.09 2.84 100 1.66 1.98 2.63 cm_Statistik_100311.doc 11 5.2. F-Verteilung Nach dem Statistiker Ronald Fisher benannt. Zwei Parameter: Anzahl Freiheitsgrade f1 und f2. Anwendung: Vergleich von Varianzen mit dem F-Test. pdf 0.8 f1 = f2 = 4 f1 = f2 = 10 0.6 f1 = 10; f2 = 4 0.4 0.2 F 0.0 0 1 2 3 4 5 5.3. chi2-Verteilung Definition: chi2 = χ2 = z12 + z22 ... + zk2 zi standard-normalverteilte Zufallszahl N(0, 1) k Parameter der Verteilung (Anzahl der Summanden = Freiheitsgrade) Anwendung: Vergleich von Verteilungen (chi2-Test), Bartlett-Test. Verteilung der Zufallszahlen chi2 : pdf 0.5 f = 2 0.4 f = 5 f = 10 0.3 0.2 0.1 0.0 0 5 10 15 20 chi-squared cm_Statistik_100311.doc 12 6. Robuste Tests Viele statistische Test setzen voraus, daß die Daten aus einer Normalverteilung stammen. Robuste Tests setzen keine Normalverteilung voraus ("nicht parametrische" / "verteilungsfreie" Tests), sind unempfindlich gegen Ausreißer, sind auch für kleinere Datensätze anwendbar. MEDIAN Anstelle des Mittelwertes (der insbesondere bei kleinen Datensätzen von Ausreißern stark beeinflußt wird). Ist jener Wert, für den es gleich viele größere und kleinere Werte gibt. Ist eine robuste Schätzung des Zentralwertes. Wenn n eine gerade Zahl ist: Median = arithmetisches Mittel der beiden "in der Mitte liegenden" Werte 2 3 5 7 12 Median = 5 Mittelwert = 5.8 2 3 5 7 50 Median = 5 Mittelwert = 13.4 2 3 5 7 12 15 Median = (5 + 7) / 2 = 6 QUARTILEN-BEREICH Anstelle der Standardabweichung (die insbesondere bei kleinen Datensätzen von Ausreißern stark beeinflußt wird). Die durch den Median gebildeten Hälften werden nochmals mittels Median-Bildung halbiert. Man erhält: unteres Quartil (lower quartile, Q1): oberes Quartil (upper quartile, Q3): Median der unteren Hälfte Median der oberen Hälfte Interquartilabstand = oberes Quartil - unteres Quartil = Q3 - Q1 = IQR (robustes Maß für die Streuung der Daten, interquartil range, measure of dispersion). Robuste Schätzung der Standardabweichung für normalverteilte Daten: sIQR = 0.7413 IQR Den Median kann man als 2. Quartil (Q2) auffassen. cm_Statistik_100311.doc 13 RANGNUMMERN (ranking) Die Werte werden aufsteigend sortiert und von 1 bis n durchnummeriert. Zur weiteren Auswertung werden nur die so erhaltenen Rangnummern verwendet (z.B.: MannWhitney-U-Test benützt Rangnummern-Summen beim Vergleich von Datensätzen) . Wenn 2 oder mehrere Werte gleich sind (engl.: tie), so erhalten diese den arithmetische Mittelwert der Rangnummern. Beispiel: Für die Werte 3, 4, 8, 8, 100 werden die Rangnummern 1, 2, 3.5, 3.5, 5 vergeben. 3.5 = Mittel aus Rangnummern 3 und 4 NACHTEIL ROBUSTER TESTS Wenn keine Verteilung vorausgesetzt wird, sind mehr Daten erforderlich um eine vorgegebene statistische Signifikanz zu erreichen. BEISPIELE ROBUSTER TESTS Test auf Normalverteilung Ausreißer-Test statt Vergleich von Mittelwerten Kolmogorov-Smirnov Dixon-Q Mann-Whitney-U BOX-and-WHISKER PLOT Graphische Darstellung von Median, unteres und oberes Quartil, Minimum, Maximum (und eventuell Ausreißer als * markiert) eines Datensatzes. Maximum Q3 Q2 = Median Q1 Minimum Milder Ausreißer (mild outlier): im Bereich 1.5 IQR bis 3 IQR unterhalb von Q1 oder oberhalb von Q3 Starker Ausreißer (extreme outlier): kleiner als Q1 - 3 IQR oder größer als Q3 + 3 IQR cm_Statistik_100311.doc 14 cm_Statistik_100311.doc 15 7. Test von Verteilungen Experimentelle Daten: Empirische Verteilung, die einer theoretischen Verteilung ähnlich sein kann (Normalverteilung, Poissonverteilung). Viele statistische Test setzen voraus, daß die Daten aus einer Normalverteilung stammen, daher sind Tests auf Vorhandensein einer Normalverteilung wichtig. Bei kleinen Datensätzen wird H0 (Daten stammen aus Normalverteilung) meist nicht verworfen. Überblick z Histogramm und visuelle Beurteilung ob annähernd normalverteilt z Summenhäufigkeit auf "Wahrscheinlichkeitspapier" z Kolmogorov-Smirnov-Test z chi2-Test Wenn die Daten vermutlich nicht normalverteilt sind: mathematische Transformation (z.B. Logarithmus) robuste Tests anwenden Aussage der Tests nur zur Orientierung Häufigkeitsdichte x Logarithmische Normalverteilung: log x ist normal verteilt "Wahrscheinlichkeitspapier" % cumulative frequency F(z) (special scaling gives straight line for normal distribution) F(z) F(z) cm_Statistik_100311.doc 16 7.1. Kolmogorov-Smirnov-Test auf Normalverteilung PRINZIP: Ein robuster Test, der auch für kleine Datensätze geeignet ist. Das Histogramm der Summenhäufigkeit (der autoskalierten Daten) wird mit der Summenhäufigkeit der StandardNormalverteilung verglichen. H0: Daten stammen aus einer Normalverteilung. n Werte x1, x2, ... xn DATEN DURCHFÜHRUNG 1. m s Mittelwert Standardabweichung 2. z-Transformation (autoscaling): 3. z-Werte aufsteigend sortieren. Treppenkurve der Summenhäufigkeiten H(i) mit Stufenhöhe = 1 / n 4. Summenhäufigkeit der Standard-Normalverteilung N(0,1) an den Stellen zi aus einer Tabelle entnehmen. 5. Prüfgröße q = m, s aus den Daten berechnet oder vermutete Werte zi = (xi - m) / s für alle i = 1 ... n | maximale Differenz | zwischen der Treppenkurve und der Summenhäufigkeit der N(0,1). 6. Tabellenwert K (n) 7. Antwort wenn q > K --> keine Normalverteilung (H0 verwerfen) Kolmogorov-Smirnov-Test (p = 0.05, zweiseitig) TABELLE n K(n) n K(n) n K(n) 3 4 5 6 7 8 0.376 0.375 0.343 0.323 0.304 0.288 9 10 11 12 13 14 0.274 0.262 0.251 0.242 0.234 0.226 15 16 17 18 19 20 0.219 0.213 0.207 0.202 0.197 0.192 Lit.: Miller J.C., Miller J.N.: Statistics for Analytical Chemistry, 3rd ed., Ellis Horwood, New York (1993) cm_Statistik_100311.doc 17 Beispiel Daten: n = 5 (aufsteigend sortiert) i 1 2 3 4 5 xi 2.00 3.00 5.00 6.00 8.00 zi - 1.17 - 0.75 0.08 0.50 1.34 F(zi) 0.1210 0.2266 0.5319 0.6915 0.9099 H(i) 0.2 0.4 0.6 0.8 1.0 | H(z) - F(zi )| 0.1210 0.1734 0.0681 0.1085 0.0901 max Weitere Werte der Summenhäufigkeitskurve F(z) der N(0,1) zum besseren Zeichnen z - 2.0 - 1.5 - 1.0 - 0.5 0 0.5 1.0 1.5 2.0 F(z) 0.023 0.067 0.159 0.308 0.500 0.692 0.841 0.933 0.977 H(i) = 0.4 F(zi) = 0.2266 Prüfgröße q = max (| H(i) - F(zi )|) = 0.1734 Tabellenwert K (n=5) = 0.343 (p = 0.05, zweiseitig) Ergebnis: q < K, daher wird H0 (Normalverteilung) nicht verworfen cm_Statistik_100311.doc 18 7.2. Chi-Quadrat-Test zum Vergleich von Verteilungen PRINZIP: Die Daten werden in Klassen eingeteilt (Histogramme für die zu vergleichenden Datensätze). Die Häufigkeiten der Klassen werden verglichen. Für beliebige Verteilungen. H0: Die beiden Verteilungen stammen aus der selben Population. DATEN k Oi Ei Anzahl Klassen "observed" Häufigkeit der Klasse i "expected" Häufigkeit der Klasse i Oi, Ei k=6 Häufigkeiten in beliebigen Einheiten. Mehr als ca 50 Werte pro Verteilung notwendig. 1 2 3 4 5 6 i DURCHFÜHRUNG Σ [(Oi - Ei )2/ Ei ] Prüfgröße q = Tabellenwert Percentile der chi2-Verteilung mit f = k - 1 Freiheitsgraden. Antwort wenn q > Grenzwert, dann wird H0 verworfen i = 1 ... k BEISPIEL i 1 2 3 4 5 6 Summe Oi 3 5 10 4 1 1 24 Ei 4 6 8 3 2 1 24 (Oi - Ei )2 1 1 4 1 1 0 - (Oi - Ei )2/ Ei 0.2500 0.1667 0.5000 0.3333 0.5000 0.0000 1.75 = q Tabellenwert für k = 6 (f = 5) und p = 0.05 (χ20.95 ) = 11.1 Daher keine Ablehnung von H0. cm_Statistik_100311.doc 19 LOTTO-BEISPIEL: Chi-Quadrat-Test auf Gleichverteilung Wert (i) Oi Ei (Oi - Ei) (Oi-Ei)2/Ei -7,667 1,037 1 49 56,667 2 58 56,667 1,333 0,031 3 56 56,667 -0,667 0,008 4 59 56,667 2,333 0,096 5 68 56,667 11,333 2,267 6 49 56,667 -7,667 1,037 7 69 56,667 12,333 2,684 8 57 56,667 0,333 0,002 9 49 56,667 -7,667 1,037 10 62 56,667 5,333 0,502 11 55 56,667 -1,667 0,049 12 57 56,667 0,333 0,002 13 53 56,667 -3,667 0,237 14 47 56,667 -9,667 1,649 15 48 56,667 -8,667 1,326 16 59 56,667 2,333 0,096 17 58 56,667 1,333 0,031 18 51 56,667 -5,667 0,567 19 51 56,667 -5,667 0,567 20 59 56,667 2,333 0,096 21 56 56,667 -0,667 0,008 22 58 56,667 1,333 0,031 23 58 56,667 1,333 0,031 24 55 56,667 -1,667 0,049 25 53 56,667 -3,667 0,237 26 73 56,667 16,333 4,708 27 63 56,667 6,333 0,708 28 59 56,667 2,333 0,096 29 60 56,667 3,333 0,196 30 66 56,667 9,333 1,537 31 55 56,667 -1,667 32 51 56,667 -5,667 0,049 0,567 33 64 56,667 7,333 0,949 34 48 56,667 -8,667 1,326 35 50 56,667 -6,667 0,784 36 70 56,667 13,333 3,137 37 56 56,667 -0,667 0,008 38 48 56,667 -8,667 1,326 39 66 56,667 9,333 1,537 40 53 56,667 -3,667 0,237 41 51 56,667 -5,667 0,567 42 58 56,667 1,333 43 65 56,667 8,333 0,031 1,225 44 51 56,667 -5,667 45 49 56,667 -7,667 sum= 2550 2550,015 0,567 1,037 Tabellenwert: p = 0.01 f = 40 (statt genau 45-1 = 44) = 63.7 Daher wird die Nullhypothese (Gleichverteilung) nicht abgelehnt. = Prüfgröße q sum = 34,270 Expected: 425 Ziehungen * 6 Zahlen = 2550 Werte, daher expected = 2550 / 45 verschiedene Zahlen = 56,667 cm_Statistik_100311.doc 20 8. Ausreißer-Tests Eliminierung von Ausreißern (outlier) ist problematisch, insbesondere bei kleinen Datensätzen. Triviale Methode: Werte außerhalb Mittelwert + 3s werden als Ausreißer betrachtet. 8.1. Ausreißertest nach Grubbs DATEN n Werte x1, x2, ... xn DURCHFÜHRUNG 1. m s x* Mittelwert aller n Werte Standardabweichung aus allen n Werten ausreißerverdächtiger Wert (H0: x* ist kein Ausreißer) 2. Prüfgröße q = | x* - m | / s 3. Tabellenwert aus Tabelle für Grubbs-Test (Parameter = n) 4. Antwort Wenn q > Grenzwert, dann wird x* als Ausreißer aufgefaßt. (Autoskalierung!) TABELLE of H0 Lit.: J.K. Taylor: Quality assurance of chemical measurements, Lewis Publishers (1987) cm_Statistik_100311.doc 21 8.2. Ausreißertest nach Dixon (einfache Version) Ein robuster Test. Wird nicht von allen Experten empfohlen. DATEN n Werte x1, x2, ... xn DURCHFÜHRUNG 1. xmax xmin Maximalwert von x1, x2, ... xn Minimalwert von x1, x2, ... xn 2. Δ Δ = xmax - xmin 3. Prüfgröße für alle i = 1 ... n qi = | xi - xnext,i | / Δ xnext,i = der zu xi (= verdächtiger Wert) nächst-liegende Wert 6. Tabellenwert aus Dixon-Q-Test-Tabelle (Parameter = n) 7. Antwort Wenn qi > Grenzwert, dann wird xi als Ausreißer aufgefaßt. TABELLE n 4 5 6 (Spannweite der Daten) Dixon-Q-Test (p = 0.05, zweiseitig) Grenzwert 0.831 0.717 0.621 n 7 8 9 Grenzwert 0.570 0.524 0.492 n 10 Grenzwert 0.464 Lit.: Miller, Miller (1984) und E.P. King, J. Am. Statist. Assoc. 48 (1958) 531. HINWEIS Wenn zwei Ausreißer nahe beisammen liegen (oder weit auseinander), dann werden sie nicht als Ausreißer erkannt. cm_Statistik_100311.doc 22 9. Vergleich von Mittelwerten und verwandte Tests 9.1. t-Test zum Vergleich von Mittelwerten DATEN Daten von 2 Meßreihen (Indizes: 1 und 2) n1, n2 Anzahl Werte m1, m2 Mittelwerte Standardabweichungen s1 , s2 VORAUSSETZUNGEN (Annähernd) normalverteilte Daten. Kein signifikanter Unterschied der Standardabweichungen s1, s2 . Je größer dieser Unterschied ist, desto unschärfer wird das Ergebnis des t-Tests. DURCHFÜHRUNG 1. c = [ (n1 - 1) s12 + (n2 - 1) s22 ] / [ n1 + n2 - 2 ] pooled variance s = c0.5 2. k = [ n1 . n2 / ( n1 + n2 ) ]0.5 3. Prüfgröße q = (m1 - m2 ) . k / s Anzahl Freiheitsgrade f = n1 + n2 - 2 4. Tabellenwert Percentile der t-Verteilung 5. Antwort cm_Statistik_100311.doc Wenn |q| > Grenzwert, dann unterscheiden sich die Mittelwerte "signifikant". 23 9.2. t-Test zum Vergleich von Mittelwert und Sollwert DATEN m0 n Sollwert Anzahl Parallelmessungen xi (n > 2) VORAUSSETZUNGEN (Annähernd) normalverteilte Daten. DURCHFÜHRUNG 1. m = Mittelwert der xi 2. s = Standardabweichung der xi 3. Prüfgröße q = n0.5 (m - m0) / s Anzahl Freiheitsgrade f = n-1 4. Tabellenwert Percentil der t-Verteilung mit f Freiheitsgraden 5. Antwort Wenn |q| > Grenzwert, dann unterscheidet sich der Mittelwert der Meßwerte "signifikant" vom Sollwert 9.3. Toleranzbereich für den Mittelwert Für Mittelwert m, Standardabweichung s, aus n Parallelmessungen. mmax/min = m0 + (qmax . s) / n0.5 Aus der Formel für die Prüfgröße beim Vergleich von Mittelwert und Sollwert. Beispiel n = 5 (f = 4) statistisches Risiko (p) = 0.05 m0 = 100 s = 2 % von m0 = 2 n=5 Zweiseitiger Test: (zweiseitig) qmax = 2.78 2.13 (einseitig, Wert in der Tabelle!) +2.78 * 2 [%] / (5)0.5 = + 2.49 [%] mmax/min = 100 + 2.5 Im Durchschnitt liegt jeder 20. Fall außerhalb dieses Bereichs obwohl der Mittelwert dem Sollwert "entspricht". cm_Statistik_100311.doc 24 9.4. Differenzen-t-Test (Paired t-Test) DATEN Paarweise Daten von 2 Meßreihen (Indizes: 1 und 2). D.h.: zu jedem Wert x1i (aus der Meßreihe 1) gibt es einen Vergleichswert x2i (aus der Meßreihe 2). n1 = n2 = n Anzahl Werte (gleich in beiden Meßreihen) m1, m2 Mittelwerte VORAUSSETZUNGEN Im Gegensatz zum t-Test eher unempfindlich auf Unterschiede in den Standardabweichungen. DURCHFÜHRUNG 1. Δi = x1i - x2i 2. m = (1/n) . Σ Δi 3. Sxx = Σ (Δi - m)2 Differenzen, für alle i = 1 ... n (i = 1 ... n) Mittelwert der Differenzen (H0: Datensätze stammen aus der selben Population; m = 0) (i = 1 ... n) 0.5 s = [Sxx / (n - 1) ] Standardabweichung der Differenzen Prüfgröße q = (m / s) . n 0.5 Anzahl Freiheitsgrade f = n-1 4. Tabellenwert Percentil der t-Verteilung mit f Freiheitsgraden 5. Antwort 4. Wenn |q| > Grenzwert, dann unterscheidet sich der Mittelwert der Differenzen "signifikant" von Null. Der Differenzen-t-Test ist schärfer als der einfache t-Test. Die Daten innerhalb der Meßreihen dürfen nicht gemischt sein. Der Differenzen-t-Test eignet sich zum Vergleich von zwei Verfahren, wenn die Standardabweichungen groß sind und der einfache t-Test nicht eingesetzt werden kann. Beispiel i 1 2 3 4 5 6 m s x1i 20 40 15 80 35 50 40 23.5 x2i 22 50 14 100 40 60 47.7 30.8 Δi = x2i - x1i 2 10 -1 20 5 10 7.67 7.45 (1) t-Test: c = 749.7 s = 27.38 k = 1.73 f = 10 q = 0.48 Tabellenwert für p = 0.05 und f = 10 ist 1.81 Daher kein signifikanter Unterschied der Mittelwerte. (2) Differenzent-t-Test: n = 6 f = 5 (!)q = 2.52 Tabellenwert für p = 0.05 und f = 5 = ist 2.02 Daher signifikanter Unterschied der Mittelwertsdifferenzen von Null. cm_Statistik_100311.doc 25 9.5. Mann-Whitney-Test (U-Test) Ein robuster Test. Wichtig für die Praxis, da oft nur kleine Datensätze zur Verfügung stehen. Hypothese H0: beide Meßreihen stammen aus der gleichen Population. Äquivalent zum WilcoxonRangsummentest. DATEN Daten von 2 Meßreihen (Indizes: 1 und 2) n1, n2 Anzahl Werte (Meßreihen so zuordnen, daß n1 <= n2 ) DURCHFÜHRUNG 1. Alle Werte (1. und 2. Meßreihe zusammen) aufsteigend sortieren. Dabei jedoch vermerken, zu welcher Meßreihe jeder einzelne Wert gehört. 2. Rangnummern vergeben von 1 bis (n1 + n2). Für gleiche Werte (engl.: tie) wird die selbe Rangnummer vergeben, und zwar der Mittelwert der entsprechenden "Rangnummern" (kann auch nicht-ganzzahlig sein). 3. S1 = Summe der Rangnummern für die Werte der 1. Meßreihe S2 = Summe der Rangnummern für die Werte der 2. Meßreihe Kontrolle: S1 + S2 = n(n+1)/2 (mit n = n1 + n2) 4. T1 = T2 = S1 - n1 (n1 + 1) / 2 S2 - n2 (n2 + 1) / 2 5. Prüfgröße q = min ( T1, T2 ) 4. Tabellenwert Tabelle für U-Test (Parameter: n1, n2) 5. Antwort Wenn q <= Grenzwert dann unterscheiden sich die Rangnummernsummen signifikant. (Mediane unterscheiden sich signif.). BEISPIEL Daten: Meßreihe 1: n1 = 4 Werte: 3, 2, 6, 5 Meßreihe 2: n2 = 5 Werte: 4, 8, 5, 8, 6 Aufsteigend sortieren und Rangnummern vergeben: Meßreihe 1 1 2 1 2 1 Wert 2 3 4 5 5 6 Rangnummer 1 2 3 4.5 4.5 6.5 2 6 6.5 2 8 8.5 2 8 8.5 S1 = 14 S2 = 31 T1 = 1 T2 = 16 Prüfgröße q = 4 Tabellenwert = 1 daher: q > Grenzwert Ergebnis: "Kein signifikanter Unterschied" der beiden Meßreihen; H0 wird nicht verworfen. cm_Statistik_100311.doc 26 10. Vergleich von Varianzen 10.1. F-Test zum Vergleich von Varianzen DATEN Daten von 2 Meßreihen (Indizes: 1 und 2) n1, n2 s1, s2 Anzahl Werte Standardabweichungen VORAUSSETZUNGEN (Annähernd) normalverteilte Daten. DURCHFÜHRUNG 1. Zuordnung der beiden Meßreihen so daß: s1 >= s2 2. Prüfgröße q = s12 / s22 Anzahl Freiheitsgrade f1 = n1 - 1 f2 = n2 - 1 3. Tabellenwert Percentile der F-Verteilung (Parameter: f1, f2) Achtung: f1, f2 nicht vertauschen. 4. Antwort Wenn q > Grenzwert (q >= 1) dann unterscheiden sich die Standardabweichungen signifikant. HINWEIS Bei signifikantem Unterschied der Standardabweichungen: Vergleich der Mittelwerte mit dem t-Test problematisch. Zusammenfassung der Meßreihen nicht gestattet. 10.2. Bartlett-Test zum Vergleich von Varianzen Zum Vergleich von 2 oder mehreren Varianzen. Der Bartlett-Test ist weniger scharf als der F-Test. Hypothese H0: alle Varianzen gleich. DATEN Daten von 2 oder mehr Meßreihen (Indizes: 1, 2, ... p) n1, n2, ... np s1, s2, ... sp cm_Statistik_100311.doc Anzahl Werte Standardabweichungen 27 DURCHFÜHRUNG 1. 2. fi = ni - 1 vi = si 2 für alle i = 1 ... p Freiheitsgrade für alle i = 1 ... p Varianzen v = ( f1.v1 + f2.v2 + ... fp.vp ) / ( f1 + f2 + ... fp) pooled variance (gewichtetes Mittel) 3. Z = v (f1 + f2 + ... + fp) N = (v1 f1) . (v2 f2) . ... . ( vp fp) wenn v1 = v2 = ... = vp = v dann ist Z = N 4. Prüfgröße q = ln (Z / N) Anzahl Freiheitsgrade f = p-1 wenn v1 = v2 = ... = vp = v dann ist q = ln 1 = 0 5. Tabellenwert Percentile der chi2-Verteilung mit f Freiheitsgraden 6. Antwort Wenn q > Grenzwert cm_Statistik_100311.doc dann unterscheiden sich die Standardabweichungen signifikant. 28 11. ANOVA - Einfache Varianzanalyse 11.1. Aufgabenstellung ANOVA = ANALYSIS OF VARIANCE Vergleich von mehreren Meßreihen (Labors, Methoden). Typische Daten (Vereinfachung: gleiche Anzahl Meßwerte pro Labor): Meßwert-Nr. Labor 1 Labor 2 1 x11 x12 ... Labor q x1q 2 ... n xn1 LaborMittelwerte LaborVarianzen xnq m1 m2 mq v1 v2 vq H0: Alle Daten stammen aus der selben Population. ANOVA: Untersuchung ob neben den zufälligen Fehlern (random errors) auch systematische Unterschiede (Einflußfaktoren, systematic error) zwischen den Labors auftreten und die Mittelwerte beeinflussen. "Labors" können auch unterschiedliche (neue) Methoden sein. Einfache Varianzanalyse (one-way ANOVA): Untersuchung von nur einem Einflußfaktor. 11.2. Methode μ (unbekannter) Mittelwert der Population σ (unbekannte) Standardabweichung der Population Die Varianz (v) der Population wird aus den vorhandenen Daten auf zwei Arten geschätzt: vr "random error"-Varianz (within-sample-variation, Zufallsfehler, kein systematischer Einfluß, vertikale Auswertung der Tabelle) = Mittelwert der Labor-Varianzen vs "systematic influence"-Varianz (between-sample-variation, Varianz durch systematischen Einfluß bzw. Unterschiede zwischen den Labors, "kontrolliert", horizontale Auswertung der Tabelle) = abgeleitet aus der Varianz der Labor-Mittelwerte cm_Statistik_100311.doc 29 Wenn sich vr und vs signifikant unterscheiden (F-Test), dann ist ein systematischer Einfluß anzunehmen (dann gibt es signifikante Unterschiede zwischen den Labors). 11.3 Durchführung Vereinfachte Version: gleiche Anzahl Meßwerte pro Labor. DATEN q n Anzahl Labors (Meßreihen, Anzahl Spalten) Anzahl Meßwerte pro Labor (Anzahl Zeilen) n.q Gesamtzahl der Meßwerte mj vj Mittelwert für Labor j (j = 1 ... q) Varianz für Labor j (j = 1 ... q) VORAUSSETZUNGEN (a) Varianzen der Labors dürfen sich nicht stark unterscheiden (Prüfen mit Bartlett-Test). Wenn sie sich signifikant unterscheiden, dann eventuell Ausreißer entfernen. (b) Daten innerhalb eines Labors müssen normalverteilt sein. Jedoch: ANOVA ist nicht sehr empfindlich gegen Verletzungen dieser Bedingungen. 1. Within-sample variance vr vr = (1/q) Σ vj j = 1 ... q (Mittelwert der Labor-Varianzen) fr 2. = q (n - 1) Freiheitsgrade Between-sample variance vs m = (1/q) Σ mj 3. j = 1 ... q (m: Gesamt-Mittelwert, grand mean) vs = n Σ (mj - m)2/ (q - 1) j = 1 ... q fs = q-1 Freiheitsgrade F-Test Prüfgröße Anzahl Freiheitsgrade 4. Tabellenwert 5. Antwort q = vs / v r f1 = fs f2 = fr Percentile der F-Verteilung (Parameter: f1 , f2 ) Achtung: f1, f2 nicht vertauschen. wenn q > Grenzwert dann gibt es einen signifikanten Unterschied der Varianzen vs und vr und daher einen signifikanter Unterschied zwischen den Labors. HINWEIS cm_Statistik_100311.doc 30 Bei signifikantem Unterschied der Varianzen sollen die Ursachen gesucht werden (sie werden nicht direkt durch ANOVA erhalten). Mögliche Ursachen sind beispielsweise: (a) (b) (c) (d) Ein oder mehrere Mittelwerte der Labors sind stark unterschiedlich. Die Mittelwerte fallen in 2 oder mehrere Gruppen. Es gibt ein oder mehrere "schlechte" Labors. Die verwendete Methode ist nicht ausreichend standardisiert. Die Unterschiede können auch "erwünscht" sein, wenn beispielsweis die "Labors" unterschiedliche Versuchsmethoden oder Prozessführungen darstellen. 11.4 Beispiel n = 4, q = 3 Labor 1 Labor 2 Labor 3 44.7 41.1 37.0 44.0 41.7 41.7 46.9 42.8 41.0 38.7 38.7 41.0 Alle Daten stammen aus einer Normalverteilung N(40.3, 2.93), also aus der selben Population. 43.275 6.11 2.47 39.85 1.76 1.33 Labor-Mittelwerte Labor-Varianzen Labor-Standardabweichungen Gesamt-Varianz (aus allen Daten) 7.62 (= 2.762) vr 6.71 vs 11.76 Daraus ergeben sich: 41.70 12.25 3.50 q = 11.76 / 6.71 = 1.75 (Freiheitsgrade: 2 und 9) Tabelle: F(2, 9, p = 0.025 einseitig entspricht p = 0.05 zweiseitig) = 5.71 (= Grenzwert) Ergebnis: q < Grenzwert; daher bleibt H0 aufrecht. cm_Statistik_100311.doc 31 Funktionswerte der Standard-Normalverteilung Spiegel M.R.: Statistik. McGraw-Hill, Düsseldorf, 1976 cm_Statistik_100311.doc 32 Fläche unter der Standard-Normalverteilung Spiegel M.R.: Statistik. McGraw-Hill, Düsseldorf, 1976 cm_Statistik_100311.doc 33 Grenzwerte für die t-Verteilung Spiegel M.R.: Statistik. McGraw-Hill, Düsseldorf, 1976 cm_Statistik_100311.doc 34 Grenzwerte für die F-Verteilung p = 0.05 zweiseitiger Test Massart D.L. et al: Chemometrics: a textbook. Elsevier, Amsterdam 1988 cm_Statistik_100311.doc 35 Grenzwerte für den Mann-Whitney-U-Test p = 0.05 zweiseitiger Test Massart D.L. et al: Chemometrics: a textbook. Elsevier, Amsterdam 1988 cm_Statistik_100311.doc 36 Grenzwerte für die chi2-Verteilung 99 Spiegel M.R.: Statistik. McGraw-Hill, Düsseldorf, 1976 Letzte Seite "Einfache statistische Tests" cm_Statistik_100311.doc 37