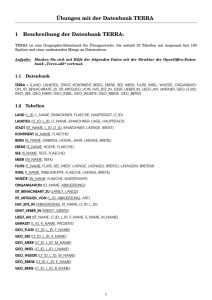

Skriptum

Werbung