4. Vorlesung - Martin-Luther-Universität Halle

Werbung

4. Vorlesung

• Relevance Feedback

• Dokument Clustering

– hierarchisch

– partitionierend

•

•

•

•

Cluster-Retrieval

Probabilistisches Clustering

Cluster-Browsing

Scatter/Gather-Browsing

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 86

Relevance Feedback (1/6)

• Idee

– Anwender markiert einige relevante/nichtrelevante Dokumente

– System verbessert das Ergebnis

• Vorteile

– Dialogartig => einfacher zu verstehen

– Betonen/Abschwächen von Termen

• Nachteile

– Nutzer sind oft nicht zur Interaktion bereit

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 87

Relevance Feedback (2/6)

• Vektorraum-Modell

– suche Anfragevektor um relevante und nichtrelevante Dokumente besser zu trennen

– Vektor verbindet Zentriod der

Nicht-Relevanten mit Zentriod

der Relevanten Dokumente

o Relevant

x Nicht-Relevant

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 88

Relevance Feedback (3/6)

• Vektorraum-Modell

• Optimaler Anfragevektor [Rocchio 66]

– Finde einen Vektor q, s.d.

– Nebenbedingung: Betrag von q ist beschränkt

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 89

Relevance Feedback (4/6)

• Optimale Lösung:

• Praxis

– Original Anfragevektor soll auch mit eingehen

– Stärkere Gewichtung der relevanten Dok.

– alpha=0.75, beta=0.25

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 90

Relevance Feedback (5/6)

1. Retrieval mit dem Fragevektor q vom Benutzer.

2. Relevanzbeurteilung der obersten Dokumente

der Rangordnung.

3. Berechnung eines verbesserten Fragevektors q

aufgrund der Feedback-Daten.

4. Retrieval mit dem verbesserten Vektor.

5. Evtl. Wiederholung der Schritte 2-4.

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 91

Relevance Feedback (6/6)

• Praktische Ergebnisse, [Salton & Buckley 90]

• Bewertung durch „residual Collection“

• Feedback*

– Nur häufige Terme wurden bei der Anfrageerweiterung genutzt.

• Vektorraum Relevance Feedback

– heuristischer Ansatz, kein direkter Bezug zur

Retrieval Qualität

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 92

Dokument Clustering

•

Cluster Hypthese

– Ähnlichkeit der relevanten Dokumente untereinander bzw. der

irrelevanten Dokumente untereinander ist größer, als die

zwischen anderen (zufälligen) Teilmengen der

Dokumentenkollektion.

•

Prinzipielle Vorgehensweise

1. Festlegung eines Ähnlichkeitsmaßes (z.B. Cosinus-Maß) .

2. Berechnung der Ähnlichkeitmatrix für alle möglichen

Dokumentenpaare.

3. Berechnung der Cluster.

4. Physisch gemeinsame Abspeicherung der Dokumente eines

Clusters. (Durch diese Form der Speicherung werden I/OZugriffe beim Retrieval gespart.)

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 93

Dokument Clustering

• Partitionierendes Clustering

– k Means

• Hierarchisches agglomeratives Clustering

– Single Linkage

– Complete Linkage

– Average Linkage

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 94

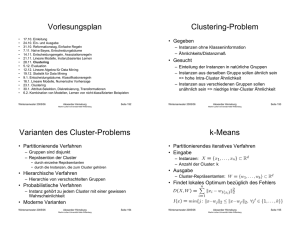

Clustering-Problem

• Gegeben

– Dokumente (Instanzen) ohne Klasseninformation

– Ähnlichkeits/Distanzmaß

• Gesucht

– Einteilung der Dokumente in natürliche Gruppen

– Instanzen aus derselben Gruppe sollen ähnlich sein

=> hohe Intra-Cluster Ähnlichkeit

– Instanzen aus verschiedenen Gruppen sollen

unähnlich sein => niedrige Inter-Cluster Ähnlichkeit

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 95

Verwendung von

Dokument Clustern

• Zur Suche ähnlicher Dokumente zu einem

bereits bekannten relevanten Dokument

• Wenn man noch kein relevantes

Dokument kennt, wird zunächst ClusterRetrieval durchgeführt. Hierbei wird ein

anderes Retrievalmodell (üblicherweise

VRM) angewendet, um Cluster mit

potentiell relevanten Dokumenten zu

lokalisieren.

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 96

Varianten des Cluster-Problems

• Partitionierende Verfahren

– Gruppen sind disjunkt

– Repräsention der Cluster

• durch einzelne Repräsentanten

• durch die Instanzen, die zum Cluster gehören

• Hierarchische Verfahren

– Hierarchie von verschachtelten Gruppen

• Probabilistische Verfahren

– Instanz gehört zu jedem Cluster mit einer gewissen

Wahrscheinlichkeit

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 97

k-Means

• Partitionierendes iteratives Verfahren

• Eingabe

– Instanzen:

– Anzahl der Cluster: k

• Ausgabe

– Cluster-Repräsentanten:

• Findet lokales Optimum bezüglich des Fehlers

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 98

k-Means Algorithmus

1. Initialisiere

2. Berechne für alle

3.

4. Stop falls

Sonst t=t+1 und gehe zu 2.

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 99

Beispiel

• Instanzen werden Repräsentanten mittels

Nächster-Nachbar-Regel zugeordnet

3

3

3

2.5

2.5

2.5

2

2

2

1.5

1.5

1.5

1

1

1

0.5

0.5

0.5

0

0

0.5

1

1.5

2

2.5

3

3.5

0

0

0.5

1

1.5

2

2.5

3

3.5

0

0

0.5

1

1.5

2

2.5

3

3.5

• Ergebnis hängt von der Initialisierung ab

• Laufzeit: Iterationen * O(kn)

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 100

Verbesserung, LBG-U

• Idee

– verschiebe schlecht plazierte Repräsentanten mit nicht lokalen

Sprüngen in Gebiete mit hohem Fehler

Utility U ( w j ) = D( X , W \ {w j }) − D ( X , W )

= ∑ d ( w j ' , x) −d ( w, x)

1

Fehler E ( w j ) =

Rj

x∈R j

∑ x−w

x∈R j

j

– Wähle den Repräsentant w mit der kleinsten Utility (Nützlichkeit)

und verschiebe ihn in die Nähe des Repräsentanten w’ mit dem

größten Fehler.

•

Wende k-Means wiederholt an bis zur Konvergenz

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 101

Beispiel

Fehlermaß

http://www.neuroinformatik.ruhr-uni-bochum.de/ini/VDM/research/gsn/DemoGNG/GNG.html

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 102

Diskussion k-Means

• Vorteile

– schnelle Laufzeit

– klare Optimierungsfunktion

• Ziel: reduziere die Daten auf Repräsentanten

• Nachteile k-Means

– kompakte Cluster, natürliche Cluster können

geteilt werden

– Anzahl der Cluster k ist vorgegeben

– keine theoretischen Grundlagen

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 103

Cluster Retrieval

• Idee

– Bestimmung der Zentroiden mit den höchsten

Retrievalgewichten.

– Ranking der Dokumente in den zugehörigen Clustern.

• Diskussion

– Die Abhängigkeiten zwischen Dokumenten werden

berücksichtigt. Fast alle anderen IR-Modelle nehmen dagegen

die Dokumente als voneinander unabhängig an, was natürlich in

der Realität nicht stimmt.

– Im Vergleich zu anderen Retrievalverfahren reduziert sich der

I/O-Aufwand.

– Soweit experimentelle Ergebnisse zum Cluster-Retrieval

vorliegen, zeigen diese eine deutlich schlechtere

Retrievalqualität im Vergleich zu anderen Verfahren.

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 104

Single Linkage

• Single Linkage (partitionierend)

– Instanzen sind Knoten eines Graphen

– Kante existiert, falls

– Cluster sind die Zusammenhangskomponenten (ZHK) des Graphen

• Eigenschaften

– Cluster nur durch Instanzen beschrieben

– erkennt geformte Cluster

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 105

Problem

• Verkettungseffekt

• Abhilfe

– entferne alle Punkte x mit weniger als k Punkten in

ihrer Epsilon Nachbarschaft:

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 106

Beispiel

• Wisharts Methode (k=4, epsilon=d)

Reduziere die Daten

Wende Single Linkage an

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 107

Diskussion Single-Linkage

• Vorteile

– erkennt natürliche geometrisch geformte Cluster

– Anzahl der Cluster wird vom Verfahren bestimmt

• Nachteile

– Laufzeit ist quadratisch

• bei niedrig-dimensionalen Instanzen kann ein Suchindex

(z.B. R*-Baum) zur Beschleunigung genutzt werden

– Verkettungseffekt

– Cluster sind keine homogene Gruppe

– keine theoretischen Grundlagen

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 108

Hierarchische Verfahren

• Ziel

–

Konstruktion einer Hierarchie von Clustern (Dendrogramm), so

daß immer die Cluster mit minimaler Distanz verschmolzen

werden

• Dendrogramm

– ein Baum, dessen Knoten die Cluster repräsentieren, mit

folgenden Eigenschaften:

• die Wurzel repräsentiert die ganze DB

• die Blätter repräsentieren einzelne Objekte

• ein innerer Knoten repräsentiert die Vereinigung aller

Objekte, die im darunterliegenden Teilbaum repräsentiert

werden

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 109

Hierarchische Verfahren

• Beispiel eines Dendrogramms

2

7

5

1

1

1

8 9

1

2 4

6

3

5

Distanz zwischen

den Clustern

0

5

1

2

3

4

5

6

7

8

9

• Typen von hierarchischen Verfahren

• Bottom-Up Konstruktion des Dendrogramms

(agglomerative)

• Top-Down Konstruktion des Dendrogramms (divisiv)

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 110

Agglomeratives hierarchisches

Clustering (bottom up)

1. Bilde initiale Cluster, die jeweils aus einem Objekt

bestehen und bestimme die Distanzen zwischen allen

Paaren dieser Cluster.

2. Bilde einen neuen Cluster aus den zwei Clustern,

welche die geringste Distanz zueinander haben.

3. Bestimme die Distanz zwischen dem neuen Cluster und

allen anderen Clustern.

4. Wenn alle Objekte sich in einem einzigen Cluster

befinden: Fertig,

andernfalls wiederhole ab Schritt 2.

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 111

Distanzfunktionen für Cluster

• Gegeben Distanzfunktion dist(x,y) für Paare von

Objekten

• Seien X, Y Cluster, d.h. Mengen von Objekten.

• Centroid-Link

1

1

centroidLinkDist( X , Y ) = dist( x, y ), x =

x

,

y

=

y

∑

∑

X

Y

• Single-Link

x∈X

y∈Y

singleLinkDist( X , Y ) = min dist ( x, y )

x∈X , y∈Y

• Complete-Link

completeLinkDist( X , Y ) = max dist( x, y )

• Average-Link

averageLinkDist( X , Y ) =

WS 2006/07

x∈X , y∈Y

1

⋅ ∑ dist ( x, y )

| X | ⋅ | Y | x∈X , y∈Y

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 112

Eingabe

• Daten-Matrix (N x d)

– große Datenmengen

– Eigenschaften repräsentieren das Objekt nicht

vollständig

– Explizite Ähnlichkeitsfunktion (Distanzfkt.) notwendig

• Ähnlichkeits/Distanz-Matrix, (N x N)

– kleine Datenmengen

– Ähnlichkeitsfunktion nicht notwendig, da alle WertePaare schon gegeben sind.

– Sehr komplexe Beziehungen zwischen den Objekten

möglich

• N... Anzahl der Datenobjekte, d ... Eigenschaften

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 113

Diskussion: Hierarchische Verfahren

• Vor- und Nachteile

+ erfordert keine Kenntnis der Anzahl k der Cluster

+ findet nicht nur ein flaches Clustering, sondern verschachtelte Cluster

+ ein einzelnes Clustering kann aus dem Dendrogramm gewonnen

werden, z.B. mit Hilfe eines horizontalen Schnitts durch das

Dendrogramm (erfordert aber wieder Anwendungswissen)

+ geeignet für komplexe Objekte mit aufwändigen Distanzfunkionen

-

Ineffizienz Laufzeitkomplexität von mindestens O(n2) für n Objekte

Auswahl der Distanzfunktion

• Software:

– http://www-users.cs.umn.edu/~karypis/cluto/ (Linux, Sun, Windows)

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 114

Probabilistisches Dokument

Clustering

• Unscharfe Aufteilung der Dokumente

• Ein Dokument gehört zu jedem Cluster mit einer

Wahrscheinlichkeit

• Vereinfachung

– binäre Dokumentrepräsentation

• Aufgabe

– seien

die k Cluster

– gesucht werden die Wahrscheinlichkeiten

dass Dok. x zur Cluster j gehört, mit

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 115

EM Algorithmus

1.

2.

3.

4.

5.

6.

7.

Wähle die Anzahl k der zu bildender Cluster.

Bestimme k seed-Dokumente, die hinreichend

unterschiedlich sind. Diese bilden jeweils den Kern

eines der Cluster C1,...,Ck

Initialisierung der Parameter: Setze nj = 1 und pj = 1/k.

Ferner sei

Berechne daraus initiale Werte für die qij

Für alle Dokumente dm aus D: Berechne P(Cj|xm) für

j=1,...,k.

Berechne neue Parameter nj , pj und qij

Wiederhole die letzten beiden Schritte, bis die Cluster

stabil sind.

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 116

Cluster Retrieval

• Idee

– Bestimmung der Zentroiden mit den höchsten

Retrievalgewichten.

– Ranking der Dokumente in den zugehörigen Clustern.

• Diskussion

– Die Abhängigkeiten zwischen Dokumenten werden

berücksichtigt. Fast alle anderen IR-Modelle nehmen dagegen

die Dokumente als voneinander unabhängig an, was natürlich in

der Realität nicht stimmt.

– Im Vergleich zu anderen Retrievalverfahren reduziert sich der

I/O-Aufwand.

– Soweit experimentelle Ergebnisse zum Cluster-Retrieval

vorliegen, zeigen diese eine deutlich schlechtere

Retrievalqualität im Vergleich zu anderen Verfahren.

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 117

Cluster Browsing

• Alternative Suchstrategie

– genaue Anfrageformulierung ist nicht nötig

– Clusterbestand direkt durchsehen

• Hierarisches Clustering

– Starte mit allgemeinen Clustern nahe der Wurzel und

verfolge die Aufteilungspfade der relevanten Cluster

• Anzeige der Cluster

– häufige Terme in dem Cluster

– Titel repräsentativer Dokumente

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 118

Scatter/Gather Browsing

• Cluster werden nicht statisch

berechnet, sondern während

der Suche

• Suchphasen

– Scatter

• die Dokumentmenge wird

in Cluster zerlegt

– Gather

• Relevante Cluster

werden ausgewählt

WS 2006/07

Alexander Hinneburg,

Martin-Luther-Universität Halle/Wittenberg

Seite 119