Statistische Begriffe

Werbung

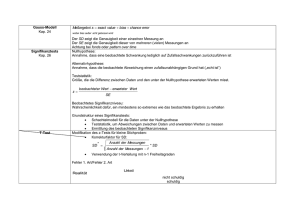

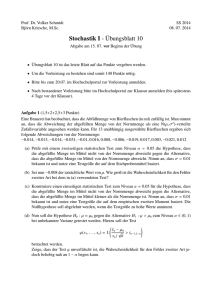

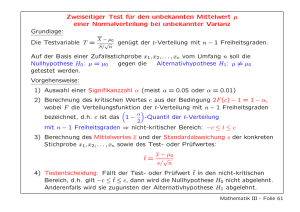

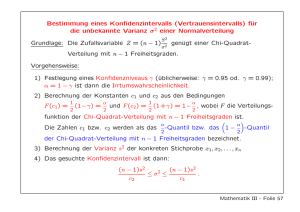

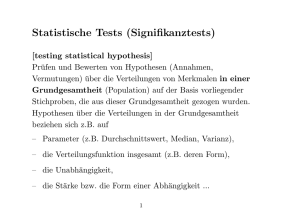

Statistik-Weiterbildung „Methoden und statistische Verfahren der empirischen Sozialforschung“ Themen: 1. z-Transformation............................................................................................................... 2 1.1 Einführung (zentrale Tendenz und Dispersion)............................................... 2 1.2 Welche Maße gibt es für die Streuung? ......................................................... 3 1.3 Verteilungsformen..................................................................................... 4 1.4 Was aber versteht man unter einen standardisierten Verteilung?........................ 6 1.5 Zu welchem Zweck werden Verteilungen standardisiert? .................................. 6 1.6 Praktische Anwendung .............................................................................. 7 2. Unterschiedshypothesen.................................................................................................... 8 2.1 Konfidenzintervalle ................................................................................... 8 2.2 Logik von Signifikanztests .......................................................................... 9 2.3 Was sind Null- und Alternativhypothese? ...................................................... 9 2.4 Was versteht man nun unter Signifikanzniveau? ........................................... 11 2.5 Die Logik des Signifikanztests an einem Beispiel ........................................... 11 2.6 Parametrische Testverfahren..................................................................... 12 2.7 Effektstärke: die angemessene Variante ....................................................... 13 3 Zusammenhangshypothesen............................................................................................. 15 3.1 Korrelation bei metrischen Merkmalen........................................................ 16 1. z-Transformation 1.1 Einführung (zentrale Tendenz und Dispersion) Es wird ein bestimmtes Merkmal wie z.B. Körpergröße in cm oder Intelligenz (IQ) gemessen. Die zentrale Tendenz dieses Merkmal für n Personen lässt sich nicht immer gleich charakterisieren. Am geläufigsten ist es, das arithmetische Mittel zu bestimmen, um die Gruppe zu charakterisieren: n M=x= ∑x i i =1 n Weitere Möglichkeiten sind (u.a.!) der Median, der Modalwert und das geometrische Mittel. Der Median besagt, über und unter welchem Wert 50% aller weiteren Werte liegen. Liegt der Wert zwischen zwei Werten, so wird exakt die Mitte zwischen diesen beiden Werten angegeben. Wann welches Kennzeichen am günstigsten ist, hängt v.a. von dem Skalenniveau des Merkmals ab. n − f kumu 2 Md = u + × Kb f krit Wenn z.B. die Abstände zwischen den Merkmalsabstufungen (vermutlich) nicht äquidistant sind, so sollte der Median verwendet werden, bei Äquidistanz kann das arithmetische Mittel verwendet werden. Zu beachten ist, dass diese Kennwerte der zentralen Tendenz erheblich voneinander abweichen können. Weist Schüler A die Noten 1, 2, 3 und 4 auf, so ist das arithmetische Mittel 2.5; und auch der Median beträgt 2.5. Schüler B dagegen erhält die Noten 1, 2, 3 und 6. Das arithmetische Mittel beträgt in diesem Fall 3.0, während der Median auch für Schüler B den Wert 2.5 angibt. Wie verteilen sich aber die Werte um diese zentrale Tendenz? Es ist äußerst selten, dass alle Werte gleich sind, meistens auch gar nicht gewünscht oder dies wird künstlich erzeugt (wenn z.B. nur Frauen betrachtet werden, variiert das Merkmal „Geschlecht“ natürlich nicht mehr). Diese Variation der Werte wird auch als Streuung bezeichnet, und die Maße, welche diese Streuung quantitativ beschreiben, als Streuungsoder Dispersionsmaße. Dispersionsmaße kennzeichnen die Breite oder Ausdehnung einer Verteilung. Copyright Dr. Uwe Neugebauer 2005 2 Die Dispersion ist ein Maß für die Abweichungen der einzelnen Maßzahlen voneinander. Sie ist damit ein Maß für die Homogenität (Gleichheit, innere Übereinstimmung) einer Stichprobe, bzw. wie ähnlich die Mitglieder hinsichtlich des gemessenen Merkmals sind. Sie informieren also über die Unterschiedlichkeit der Werte und charakterisieren die Variabilität eines Merkmals. Dispersionsmaße können zudem die Zuverlässigkeit einer Messung/Prognose oder die Größe eines Messfehlers bestimmen helfen. Die Maße der Dispersion werden formal analog zu den Maßen der Zentraltendenz definiert. Sie entsprechen diesen hinsichtlich Informationsgehalt und Anwendungsvoraussetzungen: Jedoch: ähneln sich zwei Verteilungen hinsichtlich ihrer zentralen Tendenz, können sie dennoch auf Grund unterschiedlicher Streuungen der einzelnen Werte stark voneinander abweichen (sog. Varianzeninhomogenität) 1.2 Welche Maße gibt es für die Streuung? 1) Variationsbreite („absoluter Streubereich“) (R, „range“) (S „Spannweite“) 2) Quartilabstand (Q) (Interquartilbereich) 3) AD- Streuung 4a) Varianz (s², σ²) 4b) Standardabweichung (s, σ) Am häufigsten wird die Standardabweichung σ angegeben. Diese berechnet sich aus der Wurzel der Varianz: n s2 = ∑ (x i =1 i − M )2 n Die Varianz ist definiert als die Summe der quadrierten Abweichungen der Einzelwerte von ihrem arithmetischen Mittel. Varianz ist neben der Standardabweichung das gebräuchlichste Maß zur Kennzeichnung der Dispersion einer Verteilung. Die Varianz wird von jedem Messwert der Gruppe beeinflusst: - sämtliche Werte werden einzeln berücksichtigt - größere Abweichungen werden durch die Quadrierung stärker berücksichtigt, als kleinere Abweichungen (ist somit empfindlich gegen Ausreißerwerte) Die Standardabweichung oder Streuung (s, σ) ist die positive Quadratwurzel aus der Varianz (= Maß für die Stärke der Variabilität der Rohwerte). Sie gibt an, wie weit die einzelnen Werte im Durchschnitt vom Mittelwert abweichen. Copyright Dr. Uwe Neugebauer 2005 3 Somit sind zwei Kennzeichen einer Verteilung in den meisten Fällen ausreichend, um eine Verteilung zu charakterisieren; die zentrale Tendenz und die Dispersion (Streuung) der Verteilung. Zu beachten ist, dass beide unabhängig voneinander sind und entsprechend sich in beiden Kennzeichen bedeutsame Unterschiede zeigen können. So mag der Mittelwert zwischen zwei Gruppen nahezu identisch sein, die Streuung aber signifikant unterschiedlich (sog. Varianzinhomogenität). Dies wäre ein Beleg für die Unterschiedlichkeit zweier Verteilungen, der gleich stark ist wie ein Unterschied in der zentralen Tendenz! So ist es z.B. denkbar, dass zwei Gruppen zwei unterschiedliche Lernstrategien anwenden sollen. Im abschließenden Test weisen beide Gruppen den gleichen Lernerfolg auf, die Gruppe B hat aber eine wesentlich niedrigere Varianz. Dies kann dahin gehend interpretiert werden, dass der Lerneffekt von Methode B wesentlich homogener ist als der von Methode A (also auch „schlechte“ Lerner von Methode B stark profitieren). Entsprechend sollte Methode A insbesondere von „guten“ Lernern verwendet werden, Methode B von „schlechten“ Lernern (da Methode B allen gleich stark etwas bringt). 1.3 Verteilungsformen Sind zentrale Tendenz und Streuung einer Verteilung bekannt, kann die Verteilung betrachtet werden. Es werden immer wieder vier Prototypen von Verteilungen gefunden: • Gleichverteilung • Normalverteilung • Linksschiefe Verteilung • Rechtsschiefe Verteilung Copyright Dr. Uwe Neugebauer 2005 4 Die meisten brechen in der Mitte des Studiums ab: Normalverteilung Die Studienabbrüche verteilen sich gleichmässig: Gleichverteilung 42 39 36 33 27 Häufigkeiten Häufigkeiten 30 24 21 18 15 12 9 6 3 0 80 76 72 68 64 60 56 52 48 44 40 36 32 28 24 20 16 12 8 4 0 Semester Semester Die meisten brechen am Anfang ab: Linksschiefe Verteilung Die meisten brechen zum Ende ab: Rechtsschiefe Verteilung 126 126 117 117 108 108 99 99 90 90 Häufigkeiten Häufigkeiten 81 72 63 54 81 72 63 54 45 45 36 36 27 27 18 18 9 9 0 0 Semester Semester In den Sozialwissenschaften findet man am häufigsten die sogenannte Normalverteilung. Diese wurde von Gauß „entdeckt“ und als erstes angewendet. Er hatte die Aufgabe, verschiedene Strecken in ihrer Länge zu bestimmen. Ihm war klar, dass bei jeder Messung ein gewisser Fehler enthalten ist, dass also mal etwas zu viel für eine Strecke gemessen wird, mal etwas zu wenig. Statt den Fehler zu minimieren, versuchte er stattdessen, den Fehler so zufällig wie möglich zu halten. Er nahm an, dass somit der zufällige Fehler mal den wahren Wert über-, mal unterschätzen lassen würde. Wird über alle Werte gemittelt, so würde sich dieser Fehler eliminieren (Da sein Erwartungswert null ist). Exkurs: Warum findet man diese Verteilung so häufig? Sie entsteht bei vielen Durchgängen aus der sog. Binomialverteilung. Copyright Dr. Uwe Neugebauer 2005 5 Nehmen wir an, wir werfen vier Würfel gleichzeitig und betrachten die gesamte Punktzahl. Es gibt verdammt viele mögliche Resultate bei einem solchen Wurf, und zwar 6 hoch 4, also 1296 Möglichkeiten. Auf der anderen Seite gibt es nur 20 verschiedene mögliche Punktzahlen, da es minimal 4 Punkte sind (alle Würfel eine „1“) und maximal 24 (alle Würfel eine „6“). Entsprechend sind bestimmte Punktezahlen wahrscheinlicher als andere, die Extreme „4 Punkte“ oder „4 Punkte“ können nur durch eine mögliche Würfelkombination zustande kommen, haben also jeweils die Wahrscheinlichkeit 1/1296 bzw. 0.08%, dagegen gibt es bereits vier mal mehr Möglichkeiten, die Punktzahl „5“ zu erreichen (da ein beliebiger Würfel die „2“ anzeigen darf) und eine Vielzahl von Möglichkeiten, die Punktzahl „16“ zu erhalten. Trägt man diese Wahrscheinlichkeiten für das jeweilige Ereignis (Punktzahl) auf, so ist ersichtlich, dass bei 6 Würfeln bereits eine recht hohe Ähnlichkeit zur Normalverteilung besteht. Relevanz für statistische Auswertungen: Es konnte gezeigt werden, dass eine Binomialverteilung hinreichend genau in eine Normalverteilung übergeht, wenn n * p > 9 gegeben ist (n= Anzahl Durchgänge bzw. Versuchspersonen; p= Anzahl der Antwortalternativen) 1.4 Was aber versteht man unter einen standardisierten Verteilung? Eine standardisierte Verteilung ist eine (Normal-) Verteilung, deren Werte z- transformiert wurden und die den Mittelwert 0 und die Standardabweichung 1 hat. zi = xi − x s Beispiel: Es wurde für eine Person ein IQ von 120 errechnet. Der Mittelwert beträgt 100 IQ, die Standardabweichung 15. Eingesetzt in obige Formel ergibt sich daraus ein ztransformierter Wert von zi = (120-115)/15 = 1.3 1.5 Zu welchem Zweck werden Verteilungen standardisiert? Eine Verteilung wird standardisiert, um verschiedene Gruppen oder Populationen vergleichbar zu machen. Dies wird durch eine Relativierung der individuellen Leistungen an denen der Gruppe erreicht. a) Die einfachste Art ist, den Prozentrang zu bilden: es wird für jede Person ermittelt wie viel Prozent aller Mitglieder der Population einen größeren bzw. kleineren Wert erhalten. Der Prozentrang wird dann anhand kumulierter Prozentwertverteilungen bestimmt. Copyright Dr. Uwe Neugebauer 2005 6 b) Eine andere Möglichkeit ist der Vergleich der Abweichungen der individuellen Leistung von den Durchschnittsleistungen der Gruppe. Um die Abweichungen zweier Leistungen vom Mittelwert besser vergleichbar machen zu können, müssen sie zuvor an der Unterschiedlichkeit aller Werte in der jeweiligen Gruppe relativiert werden. Dabei werden die Abweichungen durch die Standardabweichung der jeweiligen Gruppe dividiert und man erhält somit den z- Wert. 1.6 Praktische Anwendung Es wurde z.B. ein Fragebogen vorgegeben. In diesem sollte angegeben werden, wie stark man Erdbeereis mag. Vorgegeben waren die Möglichkeit „sehr stark“, stark“, „wenig“ und „gar nicht“, das Merkmal ist also vierfach abgestuft. Personen bekommen entsprechend einen numerischen Wert zwischen 1 und 4 zugewiesen. In einem anderen Abschnitt des Fragebogens wurde nach der Häufigkeit von Kinobesuchen gefragt. Die Personen geben zwischen 0-18 Kinobesuche pro Monat an. Nun möchte man diese beiden Werte vergleichen können. Wie aber, da der Mittelwert für Erdbeereis z.B. 1.2 beträgt, die der Kinobesuche aber 7.1 und somit beide von der Skalierung her nicht vergleichbar erscheinen? Wandelt man beide Skalen um in z-transformierte, so ist diese Vergleichbarkeit gewährleistet! Damit wird ein überdurchschnittlicher Erdbeereis-Möger nach wie vor einen hohen Wert aufweisen wie auch ein überdurchschnittlicher Kinobesucher. Dieses Verfahren ist insbesondere dann von Interesse, wenn eine Subskala gebildet werden soll, die aus zwei oder mehr unterschiedlich skalierte Items besteht. Auf obiges Beispiel bezogen: Es erscheint nicht zweckmäßig, einfach die Werte beider Items zu addieren (z.B. „10 [Kinobesuche]“ plus „2 [Stärke der Erdbeereispräferenz]“. Statt dessen werden die Werte an ihrem jeweiligen Mittelwert und Streuung relativiert bzw. standardisiert, was eine Additivität ermöglicht. Copyright Dr. Uwe Neugebauer 2005 7 2. Unterschiedshypothesen Häufig werden bei einer deskriptiven Auswertung Unterschiede zwischen Gruppen gefunden, so z.B. bei einer Untersuchung von Männern und Frauen bei ihrer Einstellung zur Homosexualität. Es seien (fiktiv) 51 Frauen und 53 Männer befragt worden sein. Der Fragebogen ergab einen Wert von m = 17.6 für Frauen mit einer Standardabweichung von 5.6; Männer hingegen wiesen einen Wert von 14.2 auf (s = 4.1). Wie kann ich diesen Unterschied auf entweder eine nur zufällige Schwankung/Differenz bzw. auf seine NichtZufälligkeit hin überprüfen? Zum Anfang muss natürlich meine Hypothese stehen; ich vermute, dass Frauen toleranter gegenüber Homosexualität sind als Männer, was ich aus Freud´s Theorie der latenten Homosexualität und der daraus entstehenden Angst ableite. Im zweiten Schritt operationalisiere ich dies und sehe die eine Erhebung als aus zwei Gruppen mit jeweils getrennten Verteilungen an. Die jetzt zu beantwortende Frage ist: wurden diese beiden Verteilungen aus der gleichen Grundgesamtheit gezogen (sind also „in Wahrheit“ identisch), oder sind es zwei getrennte Verteilungen? 2.1 Konfidenzintervalle Eine visuelle Unterstützung zur Beantwortung dieser Frage ermöglichen die sog. Konfidenz- oder Vertrauensintervalle. Diese geben an, in welchem Bereich der „wahre“ Mittelwert liegt. Will man diesen erhalten, muss zuvor festgelegt werden, wie hoch die Irrtumswahrscheinlichkeit sein darf; Konvention sind z.B. 10%, 5% oder 1%, manchmal auch 0.1%. Aus der Darstellung ist zumeist relativ direkt ersichtlich, ob ein Unterschied besteht oder nicht; wenn beide Konfidenzintervalle stark überlappen, so ist der Unterschied mit hoher Wahrscheinlichkeit zufällig; überlappen die beiden Konfidenzintervalle nur gering/gar nicht, so ist davon auszugehen, dass sich die beiden Verteilungen unterscheiden. Ein Nachteil ist, dass zwar Unterschiede in der zentralen Tendenz der Verteilungen so aufgedeckt werden können, nicht aber ohne weiteres Unterschiede in der Streuung ersichtlich sind. Ein zweiter Nachteil ist es, dass die Irrtumswahrscheinlichkeit nicht quantifiziert wird, d.h. keine Angaben gemacht werden, wie wahrscheinlich es ist, dass diese Differenz zufällig entstanden ist. Wie hängt die Breite des Konfidenzintervalles bei Mittelwerten und Proportionen mit der Stichprobengröße zusammen? Als Faustregel kann angenommen werden: Je größer die untersuchte Stichprobe, um so kleiner ist das Konfidenzintervall. Es sollte deshalb vor der Durchführung einer Untersuchung entschieden werden, wie viele Personen benötigt werden, um Aussagen mit der gewünschten Genauigkeit machen zu können. Copyright Dr. Uwe Neugebauer 2005 8 Der Stichprobenumfang berechnet sich nach der Gleichung n = 4 ⋅ z (2α / 2 ) ⋅ P ⋅ Q KIB 2 Generell gilt, daß bei konstantem Konfidenzkoeffizienten mit kleiner werdendem Konfidenzintervall der benötigte Stichprobenumfang quadratisch anwächst. So macht eine Halbierung des Konfidenzintervalls einen vierfachen Stichprobenumfang erforderlich. 2.2 Logik von Signifikanztests Tests zur statistischen Überprüfung von Hypothesen heißen Signifikanztests. Der Signifikanztest ermittelt die Wahrscheinlichkeit, mit der das gefundene empirische Ergebnis sowie Ergebnisse, die noch extremer sind als das gefundene Ergebnis, auftreten können, wenn die Populationsverhältnisse der Nullhypothese entsprechen. Ist diese Wahrscheinlichkeit kleiner als α%, wird das Stichprobenergebnis als statistisch signifikant bezeichnet. Für α sind per Konvention die Werte 5% bzw. 1% festgelegt. Stichprobenergebnisse, deren bedingte Wahrscheinlichkeit bei Gültigkeit der H0 kleiner als 5% ist, sind auf dem 5%-(Signifikanz-) Niveau signifikant (kurz: signifikant) und Stichprobenergebnisse mit Wahrscheinlichkeiten kleiner als 1% sind auf dem 1%-Niveau signifikant (kurz: sehr signifikant oder hochsignifikant). 2.3 Was sind Null- und Alternativhypothese? Alternativhypothese: - beschreibt eine Erweiterung oder Alternative zum bestehenden Wissen - stellt inhaltlich das dar, was man vermutet und finden will Nullhypothese: - unterstellt, dass es keinen Zusammenhang gibt, die Alternativhypothese ist „Null und nichtig“ - komplementär zur Alternativhypothese Können keine Angabe über die Richtung der Abweichung des Stichproben-mittelwertes gemacht werden, wird eine ungerichtete Hypothese formuliert. Nullhypothese (H0) Alternativhypothese (H1) : μ0 = μ1 : μ0 ≠ μ1 Die statistische H1 behauptet, dass die untersuchte Stichprobe einer Population angehört, deren Parameter μ1 vom Parameter μ0 der Referenzpopulation abweicht. Oder sie kann gerichtet formuliert werden: Copyright Dr. Uwe Neugebauer 2005 9 : μ0 > μ1 Alternativhypothese (H1) : μ0 < μ1 Nullhypothese : μ0 < μ1 : μ0 > μ1 Nullhypothese (H0) oder: (H0) Alternativhypothese (H1) Woher hat man dieses Hypothesenpaar? Einer allgemeinen Forschungshypothese ist die operationale Hypothese bzw. empirische Vorhersage nachgeordnet. Mit der operationalen Hypothese prognostiziert der Forscher den Ausgang einer konkreten Untersuchung nach den Vorgaben der allgemeinen Forschungshypothese. Zur Überprüfung werden die statistischen Hypothesen aufgestellt, wobei die Nullhypothese komplementär zur Alternativhypothese ist. Die Entscheidungsregel lautet: Ist die Wahrscheinlichkeit des empirisch gefundenen Mittelwerts der Stichprobe unter Annahme der Nullhypothese kleiner als das vorgegebene Signifikanzniveau, so wird die Nullhypothese verworfen. H0 ablehnen: Nullhypothese wird verworfen, Alternativhypothese wird angenommen, wenn die Prüfgröße außerhalb der kritischen Werte liegt (= α) H0 nicht ablehnen: Nullhypothese wird beibehalten, wenn die Prüfgröße zwischen den kritischen werten liegt. Ein (sehr) signifikantes Ergebnis ist also ein Ergebnis, das sich mit der Nullhypothese praktisch nicht vereinbaren lässt. Man verwirft deshalb die Nullhypothese und akzeptiert die Alternativhypothese. Andernfalls, bei einem nicht-signifikanten Ergebnis, wird die Nullhypothese beibehalten und die Alternativhypothese verworfen (BORTZ & DÖRING, 1995). Warum basiert der Test auf der Nullhypothese, obwohl man sich doch wissenschaftlich für die Alternativhypothese interessiert? Die Nullhypothese ist konkret formuliert, z.B. μ0 = μ1. Die Alternativhypothese μ0 ≠ μ1 ist (fast immer) nicht konkret formuliert. Copyright Dr. Uwe Neugebauer 2005 10 Hinter ihr verbergen sich eine Vielzahl von Möglichkeiten, wie stark sich μ1 und μ0 unterscheiden. Die Irrtumswahrscheinlichkeit kann nur für falsches Annehmen der Alternativhypothese (α-Fehler ) angegeben werden, nicht für falsches Verharren auf der Nullhypothese (β-Fehler). (Da man die H1 nicht direkt beweisen kann, versucht man durch „Widerlegen“ der H0 die H1 zu bestätigen. D.h. man testet mit welcher Wahrscheinlichkeit das gefundene Ergebnis unter Annahme der H0 aufgetreten wäre.) 2.4 Was versteht man nun unter Signifikanzniveau? y Grenz-, Irrtums-, Überschreitungswahrscheinlichkeit: Wahrscheinlichkeit, bei einer statistischen Entscheidung einen Fehler erster Art (α-Fehler) zu begehen. Die Irrtumswahrscheinlichkeit bezeichnet die Wahrscheinlichkeit, dass das gefundene Ergebnis oder extremere Ergebnisse bei Gültigkeit von H0 eintreten. y Signifikanzniveau (α-Fehler-Niveau): Die Irrtumswahrscheinlichkeit, die ein Untersuchungsergebnis maximal aufweisen darf, damit die Alternativhypothese als bestätigt gelten kann. Im allgemeinen spricht man von einem signifikanten Ergebnis, wenn die Irrtumswahrscheinlichkeit höchstens 5%, von einem sehr signifikanten Ergebnis, wenn sie höchstens 1% beträgt. 2.5 Die Logik des Signifikanztests an einem Beispiel Zur Logik des Signifikanztests siehe oben, wobei hier geschaut wird, ob die zwei Mittelwerte der zwei Stichproben aus einer Population kommen oder ob der Mittelwertsunterschied überzufällig ist, d.h. ob die Stichproben „in Wahrheit“ aus zwei verschiedenen Populationen stammen. Werden zwei voneinander unabhängige Stichproben des Umfangs n1 und n2 aus zwei Grundgesamtheiten gezogen, überprüft der t-Test für unabhängige Stichproben die Nullhypothese, dass die beiden Stichproben aus Populationen stammen, deren Parameter μ1 und μ2 identisch sind: Null- und Alternativhypothese: H0: μ1-μ2 = 0 H1 : μ1-μ2 ≠ 0 (ungerichtet) Die Entscheidungsregel lautet: Copyright Dr. Uwe Neugebauer 2005 11 Ist die Wahrscheinlichkeit des empirisch gefundenen Mittelwertsdifferenz der Stichproben unter Annahme der Nullhypothese kleiner als das vorgegebene Signifikanzniveau, so wird die Nullhypothese verworfen. Das in der Einführung skizzierte Beispiel: Es seien (fiktiv) 51 Frauen und 53 Männer befragt worden sein. Der Fragebogen ergab einen Wert von m = 17.6 für Frauen mit einer Standardabweichung von 5.6; Männer hingegen wiesen einen Wert von 14.2 auf (s = 4.1). Somit wollen wir wissen: Ist –statistisch gesehen- der Mittelwert der Frauen (17.6) von dem der Männer (14.2) abweichend? Hierzu legen wir ein Signifikanzniveau von 1% fest. Die Differenz zwischen beiden Werten ist 3.4, geteilt durch die Varianz der Differenzen (z.B. t= μ1 − μ 0 σ ( x1− x 2 ) 4.9) ergibt sich ein t-Wert von 0.69. Bei Nachschlagen in einer Tabelle der t-Verteilung ergibt sich, dass bei 103 Freiheitsgraden (degrees of freedom, df: N-1) und alpha= 1% der tWert ca. 2.358 beträgt; der Unterschied ist insignifikant! 2.6 Parametrische Testverfahren Der bereits erwähnte T-Test ist ein sogenanntes parametrisches Testverfahren. Was heißt dies? Es wird davon ausgegangen, dass der Merkmalsverteilung eine Normalverteilung zugrunde liegt. Das Gleiche wird bei sogenannten X²-Test (oder auch chi² genannt) unterstellt. Im Auswertungsalltag wird diese Voraussetzung allerdings häufig ignoriert bzw. es wird davon ausgegangen, dass diese Voraussetzung erfüllt ist, obwohl häufig viele theoretische oder auch empirische Belege dagegen existieren. Als heftigstes Beispiel seien hier Reaktionszeitdaten genannt. Diese sind zumeist nicht normalverteilt, sondern linksschief. Ein besonderes Problem ergibt sich, wenn viele Einzelvergleiche gerechnet werden sollen; so z.B. die Unterschiede zwischen Männern und Frauen in einer Vielzahl von einzelnen Aspekten wie z.B. ihre Einstellung zur Chemie, ihrem durchschnittlichen Einkommen, ihrer Mobilität (Auto: ja vs. Nein) sowie ihre Präferenz von Erdbeereis berechnet werden sollen. Aus dem bisher gesagten ist deutlich, dass die Signifikanz auch als Wahrscheinlichkeit, dass die Differenz zufällig ist, verstanden werden kann. Dies impliziert, dass z.B. bei einem 5%Niveau jede zwanzigste Mittelwert-Differenz zufällig signifikant sein wird! Dennoch möchte man gerne die Behauptung aufstellen, dass es generelle Unterschiede zwischen Männern und Frauen gibt. Copyright Dr. Uwe Neugebauer 2005 12 Dieses Problem wird durch zwei Möglichkeiten gelöst; entweder wird das alpha-Niveau adjustiert, d.h. wenn diese Aussage auf 5%-Niveau getan werden soll, muss jeder Einzelvergleich ein deutlich niedrigeres alpha-Niveau aufweisen (damit sich über alle Einzelvergleiche hinweg ein alph-Niveau von 5% ergibt). Die Formel hierfür ist trivialerweise Alpha(Einzelvergleich) = alpha(Gesamtaussage)*Anzahl Einzelvergleiche Oder -als zweite Möglichkeit ist eine Einfaktorielle Varianzanalyse- indiziert. Hier wird ein Hauptfaktor (Geschlecht) als Verursacher der Varianz in den abhängigen Variablen/Merkmalen angenommen. Aber Achtung: die Abhängigen Variablen des Beispiels weisen unterschiedliche Skalenniveaus auf! 2.7 Effektstärke: die angemessene Variante Tja, und somit können die verschiedenen Gruppen nach Unterschieden untersucht werden. Insbesondere, wenn große Stichproben vorliegen, werden auch in der Tat viele Differenzen gefunden, die signifikant von Zufall verschieden sind. Wird dann aber die Größe der Mittelwertsdifferenz betrachtet, so ist häufig ersichtlich, dass sich beide Gruppen nur marginal voneinander unterscheiden. Daraus ergibt sich die Frage nach der „Bedeutsamkeit“ von signifikanten Mittelwertsunterschieden. Zum einen wird diese Bedeutsamkeit als „Varianzaufklärung“ durch einen Faktor bezeichnet, oder auch allgemeiner als „Effektstärke“, in der Literatur meistens als d bezeichnet. Auf die Varianzaufklärung wird noch im Abschnitt Zusammenhangshypothesen genauer eingegangen. Die Effektstärke besagt, wie stark der Effekt des gruppierenden Merkmals oder z.B. einer Behandlungsmethode ist. Er sagt also nicht, ob die Differenz signifikant ist, sondern, wie groß die Mittelwertsunterschiede (relativ zu ihrer Varianz) sind, wobei sich daraus auch ableiten lässt, ab wie vielen Personen dieser Unterschied signifikant wäre. Praktische Relevanz erhält diese Berechnung dadurch, wenn entschieden werden soll, welches Medikament besser ist. Medikament A und auch Medikament B bewirken signifikante Verbesserungen. Die Berechnung der Effektstärke wäre in diesem Fall eine Möglichkeit, zu einer Entscheidung zu kommen. Die Berechnung der Effektstärke ist sehr ähnlich der Berechnung des t-Wertes: d= μ1 − μ 2 σ Copyright Dr. Uwe Neugebauer 2005 13 Effektgrößen können auch klassifiziert werden, ähnlich wie bei Korrelationen von niedrigen (r<0.3), mittleren (0.3<r<0.6) und hohen (r>0.6) Korrelationen gesprochen wird. So wird ab d > 0.5 von einer mittleren Effektstärke gesprochen, ab 0.8 ist diese hoch. Für eine weiterführende Behandlung dieses und verwandter Themen ist das (kostenlose!) Programm „G-Power“ von Buchner, Faul und „Eddy“ Erdfelder sehr zu empfehlen. Erdfelder ist im übrigen einer meiner wenigen (n<12) musikalischen Fans... Copyright Dr. Uwe Neugebauer 2005 14 3 Zusammenhangshypothesen Im bisherigen ist bereits die Frage aufgekommen, wie Unterschiede über die Signifikanz hinaus quantifizierbar sind. Das eine war die sog. Effektstärke d. Eine zweite Möglichkeit besteht darin, die Varianzaufklärung durch das Quadrat des Korrelationskoeffizienten zu bestimmen. Wurde z.B. zwischen der Körpergröße von Personen und der Intelligenz (rein fiktiv!) ein Zusammenhang (Korrelation) von r=0.3 nachgewiesen, so folgt daraus, dass das Merkmal Körpergröße 0.3²= 9% der Varianz bei der Intelligenz aufklärt. Was habe ich hier getan? Ich habe von Merkmal A (Körpergröße) auf Merkmal B (Intelligenz) geschlossen, also einen Zusammenhang ausgenutzt. Im Folgenden soll dies von seinen Grundlagen noch einmal aufgearbeitet werden. Im ersten Schritt kann ein vermuteter Zusammenhang zwischen zwei Merkmalen grafisch betrachtet werden. Zusammenhang zwischen der Anzahl Störche und Geburten (fiktiv!) y= 347,196 + 5,384*x 680 640 GEBURTEN 600 560 520 480 440 20 25 30 35 40 45 50 55 60 STORCH In der Abbildung wurde auf der X-Achse die Anzahl der Störche eingetragen, auf der YAchse die Anzahl der Geburten. Es besteht die Vermutung, dass (wie immer erzählt wurde), dass ein Zusammenhang besteht zwischen den Störchen und den Babys. Im Grunde glauben wir sogar aufgrund der skizzierten Theorie, dass eine Voraussage (Prognose) möglich ist von Merkmal X (Anzahl Störche) auf Merkmal Y (Anzahl Geburten/Babys). Die Grafik zeigt zum einen die Messwerte, zum anderen deutet sie mit der roten Linie an, wie dieser Zusammenhang aussehen könnte: ein linearer Zusammenhang zwischen diesen beiden Merkmalen. Oben in der Grafik ist zudem die sog. Regressionsgleichung angegeben: Die Anzahl der Geburten ergibt sich aus der Formel y=347.2 + (5.4 * Anzahl der Störche). Aus diesem Beispiel und seinen empirischen Daten folgt allerdings auch direkt, dass die Theorie falsch sein muss: Zwar finden wir erst einmal einen Zusammenhang, der vermutet wurde. Bei Betrachten der Regressionsgleichung fällt aber auf, dass selbst bei Null Störchen Copyright Dr. Uwe Neugebauer 2005 15 immer ca. 347 Geburten zu erwarten sind. Dies steht im Widerspruch zur Theorie, dass der Storch die Babys bringt! Wie aber kann die Enge des Zusammenhanges zwischen zwei Merkmalen quantifiziert werden? Über die Angabe eines Korrelationskoeffizienten, üblicherweise mit „r“ abgekürzt. Dieser kann sich zwischen –1 und +1 bewegen, wobei • Null keinerlei Zusammenhang bedeutet, • -1 bedeutet: Immer wenn Merkmal A, dann nicht Merkmal B • +1 bedeutet: Immer wenn Merkmal A, dann auch Merkmal B 3.1 Korrelation bei metrischen Merkmalen r= ∑ x × y − ( x × y) s(x ) × s( y ) Copyright Dr. Uwe Neugebauer 2005 16