Swiss BPM Forum Dossier 2013 netzwoche

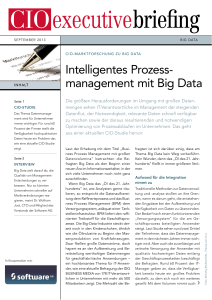

Werbung

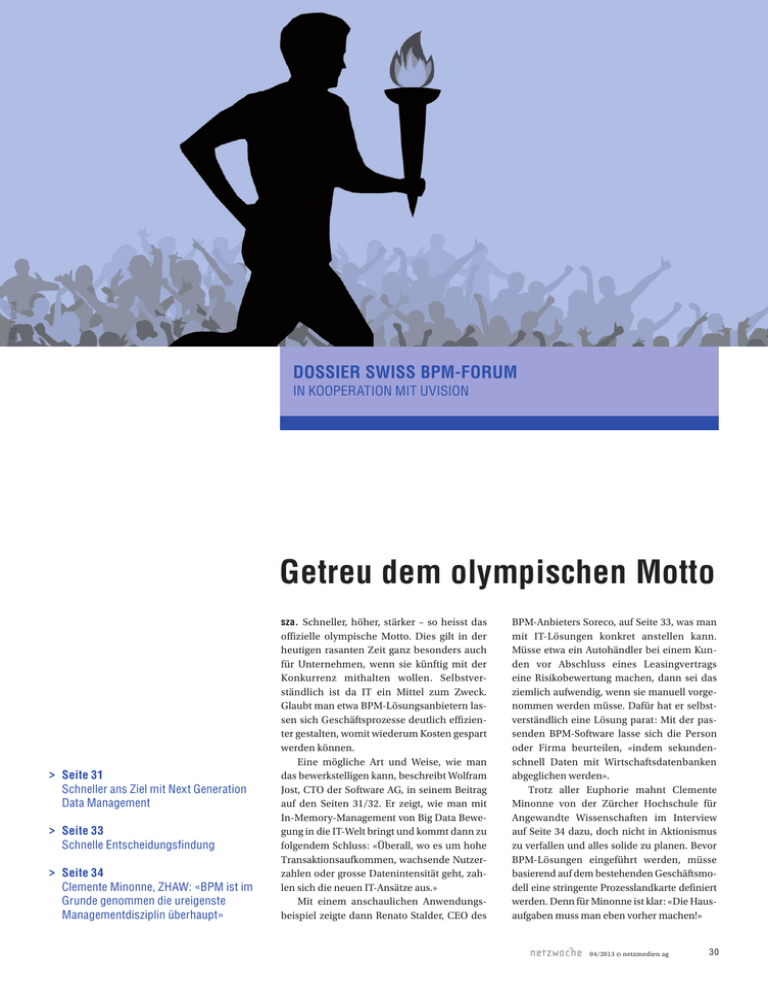

Bild: Fotolia Dossier Swiss BPM-Forum in Kooperation mit Uvision Getreu dem olympischen Motto sza. Schneller, höher, stärker – so heisst das >Seite 31 Schneller ans Ziel mit Next Generation Data Management >Seite 33 Schnelle Entscheidungsfindung >Seite 34 Clemente Minonne, ZHAW: «BPM ist im Grunde genommen die ureigenste Managementdisziplin überhaupt» offizielle olympische Motto. Dies gilt in der heutigen rasanten Zeit ganz besonders auch für Unternehmen, wenn sie künftig mit der Konkurrenz mithalten wollen. Selbstverständlich ist da IT ein Mittel zum Zweck. Glaubt man etwa BPM-Lösungsanbietern lassen sich Geschäftsprozesse deutlich effizienter gestalten, womit wiederum Kosten gespart werden können. Eine mögliche Art und Weise, wie man das bewerkstelligen kann, beschreibt Wolfram Jost, CTO der Software AG, in seinem Beitrag auf den Seiten 31/32. Er zeigt, wie man mit In-Memory-Management von Big Data Bewegung in die IT-Welt bringt und kommt dann zu folgendem Schluss: «Überall, wo es um hohe Transaktionsaufkommen, wachsende Nutzerzahlen oder grosse Datenintensität geht, zahlen sich die neuen IT-Ansätze aus.» Mit einem anschaulichen Anwendungsbeispiel zeigte dann Renato Stalder, CEO des BPM-Anbieters Soreco, auf Seite 33, was man mit IT-Lösungen konkret anstellen kann. Müsse etwa ein Autohändler bei einem Kunden vor Abschluss eines Leasingvertrags eine Risikobewertung machen, dann sei das ziemlich aufwendig, wenn sie manuell vorgenommen werden müsse. Dafür hat er selbstverständlich eine Lösung parat: Mit der passenden BPM-Software lasse sich die Person oder Firma beurteilen, «indem sekundenschnell Daten mit Wirtschaftsdatenbanken abgeglichen werden». Trotz aller Euphorie mahnt Clemente Minonne von der Zürcher Hochschule für Angewandte Wissenschaften im Interview auf Seite 34 dazu, doch nicht in Aktionismus zu verfallen und alles solide zu planen. Bevor BPM-Lösungen eingeführt werden, müsse basierend auf dem bestehenden Geschäftsmodell eine stringente Prozesslandkarte definiert werden. Denn für Minonne ist klar: «Die Hausaufgaben muss man eben vorher machen!» 04/2013 © netzmedien ag 30 Dossier Swiss BPM-Forum in Kooperation mit Uvision Schneller ans Ziel mit Next Generation Data Management Unternehmen häufen massenweise Daten an. Mit herkömmlichen Methoden und Werkzeugen können diese nicht mehr verarbeitet werden. Für Abhilfe soll das In-Memory-Management von Big Data sorgen. Nebenbei bringt diese Technologie neue Bewegung in die IT-Welt. Wolfram Jost Die wirtschaftliche Relevanz von Big Data Bild 1: Beispiel einer Next-Generation-Data-Management-Plattform Grafik: Software AG Von 45 Minuten auf 4 Sekunden! Dank dieser rekordverdächtigen Beschleunigung bewahrt ein renommiertes Kreditkartenunternehmen seine Kunden vor Vermögensverlusten in der Höhe von hunderten Millionen Dollar. Im Vier-Sekunden-Takt prüft der Finanzdienstleister jede Transaktion auf das Risiko einer betrügerischen Handlung. Solche Analysen aus gewaltigen Datenmengen sind es, die Big Data zu einem heissen Thema machen. Es geht um ausgefeilte Datenanalysen, auf deren Basis Entscheidungen getroffen werden. Auch die Kunden eines australischen Telekommunikationsanbieters profitieren vom Geschwindigkeitsrausch in der Datenverarbeitung. Innerhalb von 30 Millisekunden stehen ihnen die Rechnungsdaten zur Verfügung und sie kön- Dr. Wolfram Jost ist Chief Techno­ logy Officer bei der Software AG. nen erkennen, wie viel ihr Telefongespräch, ihre Datenübertragung oder das Versenden der Fotos vom Smartphone gerade kostet. Hier ist nicht die Rede von ein paar Millionen Kundendatensätzen. Bei Big Data geht es um gewaltige Mengen laufend produzierter Informationen. Nach Angaben von IBM wurden 2012 täglich 2,5 Trillionen Bytes produziert. Statt von Mega- und Gigabytes sprechen die Experten deshalb auch von Tera-, Peta- und Exabyte (eine Milliarde Gigabyte). Experten sind sich einig, dass herkömmliche Standarddatenbanken oder Datenmanagement-Werkzeuge bei diesen Datenmengen versagen. Um das Phänomen «Big Data» zu beherrschen, werden die Leistungen einer neuen Generation zum Data Management benötigt. Diese Next-Generation-Data-Management-Plattformen stossen einen umfassenden ArchitekturShift an, in dessen Folge so manches etablierte Designprinzip in der Softwareentwicklung neu überdacht wird: Die zentrale relationale SQL-Datenbank für alle betriebswirtschaftlichen Aufgaben, die bislang ein quasi ehernes Gesetz war, wird von den neuen Big-Dataaffinen Technologien zur Disposition gestellt (siehe Bild 1). Für Manager sind Kenntnisse über Big Data wichtig, denn es geht um die wertvollsten Rohstoffe jedes Unternehmensbereichs: Daten und Informationen. In dem 2011 veröffentlichten Report des McKinsey Global Institute (MGI) «Big data: The next frontier for innovation, competition, and productivity» betonen die Autoren, dass Innovationen und Wachstum in immer stärkerem Masse von der Qualität und Auswertung der Daten abhängt. Den Nutzen der Big-Data-Technologien machen die MGI-Autoren an fünf Eigenschaften fest. An erster Stelle steht die Transparenz, die Organisationen gewinnen, wenn Informationen besser und schneller verfügbar sind. Zweitens können Unternehmen dank detaillierterer Informationsversorgung verschiedene Kriterien kombinieren und Entscheidungen testen. Die personenbezogenen Informationen eröffnen drittens Möglichkeiten, eine Kunden- und Marktsegmentierung vorzunehmen, deren Zusammensetzung kontinuierlich an aktuelle Bedingungen angepasst wird. Viertens kann Big Data in der Prozesssteuerung oder -automatisierung herangezogen werden, um etwa mit einer automatisierten Analyse von Wetterdaten den Materialeinsatz und Produktionsdurchsatz in der Getränkeherstellung zu optimieren. Fünftens führt der Einsatz von Big Data in den Unternehmen zu neuen innovativen Geschäftsmodellen oder Services, zur Optimierung von Massnahmen durch die zeitnahe Auswertung von Webstatistiken, persönlichen Standortinformationen etc. Nur wenn Firmen die Rohstoff-«Ver­ edelung» gelingt, winkt eine Produktivitätsdividende, die erfreulich hoch ausfallen kann. Die Autoren des MGI-Reports errechneten, dass durch Einsatz von Big-Data-Technologien im US-amerikanischen Gesundheitssystem jährlich 300 Milliarden US-Dollar, in der Behördenlandschaft der EU jährlich 250 Milliarden USDollar gespart werden könnten. Weiter werden in den USA ein 60-prozentiger Zuwachs bei der operativen Marge im Einzelhandel oder eine 7-prozentige Verbesserung der Liquidität in der Fertigung in Aussicht gestellt. 4 04/2013 © netzmedien ag 31 Dossier Swiss BPM-Forum in Kooperation mit Uvision mehr, mit Fantasie und Innovationselan neue Wege zu entdecken, um den neuen Anforderungen bezüglich Datenmenge, Formatvielfalt und Verarbeitungstempo gerecht zu werden. Unabhängig von der Herangehensweise ist allen Ansätzen die konsequente Ausrichtung auf Skalierbarkeit und Verarbeitungsgeschwindigkeit als oberstes Designprinzip gemeinsam, das die bislang vorherrschende Dominanz des strikten Konsistenzgebots aufhebt. Ebenso herrscht Einigkeit, dass der einzig erfolgreiche und letztlich auch bezahlbare Weg zu einer beliebigen Skalierbarkeit das Konzept der Rechnernetzverbünde ist – von Fachleuten auch als Clusterverbund oder in Anlehnung an das Stromnetz als Data Grid bezeichnet. Reichhaltigkeit dominiert die IT-Welt Bild 2: Beispiel für In-Memory-Datenmanagement in Echtzeit Grafik: Software AG Volume, Variety, Velocity und Value Auffällig an den im Report genannten Einsatzfeldern und Nutzenpotenzialen ist vor allem, dass sie weder neu noch spektakulär klingen. Sie greifen letztlich schon seit Jahren ins Auge gefasste IT-gestützte Strategien unter neuen inhaltlichen und technischen Rahmenbedingungen auf. Doch die Messlatte für die Leistungsfähigkeit ist mit Blick auf das Datenvolumen, die Komplexität der Daten und das Bearbeitungstempo höher gelegt. Im internationalen Fachjargon sind diese Charakteristika umschrieben mit Volume, Variety und Velocity. Die hieraus abgeleiteten technologischen Forderungen an die zugehörige Data-Management-Plattform heissen: erstklassige Skalierungsmöglichkeiten, ein flexibles Management von Daten beliebigen Formats sowie die Verarbeitung komplexer Ereignisströme. Eine solche Big-Data-Umgebung muss sich gleichzeitig komfortabel in die vorhandene ITLandschaft einbinden, um den Wert der Daten aus allen Anwendungen eines Unternehmens vollständig auszuschöpfen – das vierte und wichtigste V, den Value. SQL? NoSQL? Not only SQL! Heute können entsprechende Technologien diese Wünsche erfüllen. Die rasante Entwicklung in der Prozessoren- und Speichertechnik, mit der ein gewaltiger Preisverfall einhergeht, eröffnet aussergewöhnliche Chancen. Auf Basis preiswerter Standard-Hardwarekomponenten lassen sich moderne Infrastrukturen realisieren, die immer grös­sere Datenmengen direkt im Hauptspeicher (scale-up) als auch verteilt über mehrere Prozessoren (scale-out) bearbeiten und verwalten. SQL-Datenbanken sind für den Umgang mit grossen Daten- mengen unterschiedlicher Herkunft schlecht geeignet. Amazon, Google, Facebook & Co. mit ihren Millionen von Nutzern hätten mit dem limitierten Scale-up-Vermögen der relationalen Datenbanktechnik ihre Web-2.0Anwendungen niemals realisieren können. Der Geschwindigkeitszuwachs im Onlinezugriff beim eingangs erwähnten Telko beruht gerade darauf, dass Terabytes an Kundendaten in zweistelliger Grössenordnung direkt im Hauptspeicher bereitgestellt werden, ohne dass die RDBMS der Kundenverwaltung im Backend beansprucht wird. Nahezu jeder Anbieter von Softwareplattformen arbeitet heute mit Hochdruck an innovativen Architekturprinzipien, um die Enge des relationalen Modells hinter sich zu lassen. Mit dem Begriff NoSQL werden diese Versuche für ein alternatives Data Management bezeichnet. Abhängig vom Marktauftritt unterscheiden sich die Schwerpunkte der Aktivitäten von Anbieter zu Anbieter zum Teil deutlich. Hersteller, die sich auf komplexe Analysen und Simulationen fokussieren, präferieren das Designprinzip einer spaltenorientierten Anordnung. Geht es um Auswertungen für wenig strukturierte Daten beispielsweise von Warenkörben, die für eine Analyse nicht mehr eigens überarbeitet werden, steht meist die Verarbeitung enormer Datenberge im Vordergrund. Andere Ansätze sind Graphendatenbanken, die Beziehungen modellieren und insbesondere für Hersteller interessant sind, die Empfehlungsfunktionen in sozialen Netzen entwickeln. Für komplexe Datenstrukturen wiederum werden dokumentenorientierte Datenbanken bevorzugt. Es gibt eine Vielzahl an Modellansätzen für eine neue Datenbanktechnologie. Für Entwickler existieren anscheinend keine Grenzen Die Idee einer Datenbank für alles, die in der Vergangenheit zur Dominanz des relationalen Datenbankmodells führte, ist definitiv vorbei. Dass NoSQL-Systeme nun die RDBMs als führende Datenbanktechnologie ablösen, wäre jedoch der falsche Schluss. Denn Konsistenz – eine der zentralen Stärken des relationalen Datenmodells – ist keinesfalls obsolet, sondern zählt im betrieblichen Umfeld weiterhin zu den wichtigsten Forderungen. Die Auseinandersetzung SQL versus NoSQL hat deshalb wenig Relevanz. Vielmehr geht es um die Wahlfreiheit für den Anwender. Mit neuen Data-Management-Plattformen rücken Anwendungen, Daten beliebigen Formats und Ereignis-Datenströme wieder enger zusammen. Die Next-Generation-DataManagement-Plattform ebnet damit den Weg zu einem neuen IT-Design von Unternehmensanwendungen. Firmen gewinnen mit den technologischen Weiterentwicklungen mehr an Agilität und Kollaboration, zentrale Forderungen in der globalen Wirtschaftswelt. Die In-Memory-Technologie (Bild 2) befeuert diese Entwicklung zusätzlich. Anwendungen, Datenobjekte und Ereignis­ströme können nun gemeinsam im Hauptspeicher des Application Server verwaltet werden. Lese- und Schreiboperationen lassen sich direkt auf den Daten ausführen. Weil Daten aus verschiedenen Quellen in eine Anwendung integriert werden können, werden diese äusserst schnell und skalierbar. Der Nutzer hat unmittelbaren Zugriff auf Ereignisdaten, die er in Echtzeit auswerten und die Erkenntnisse wiederum sofort weiterverarbeiten kann. Das Management gewinnt damit das, was es für Entscheidungen am meisten benötigt: mehr Transparenz. Überall, wo es um hohe Transaktionsaufkommen, wachsende Nutzerzahlen oder grosse Datenintensität geht, zahlen sich die neuen IT-Ansätze aus. < 04/2013 © netzmedien ag 32 Dossier swiss BPM-Forum in Kooperation mit Uvision Schnelle Entscheidungsfindung Operative Entscheidungsprozesse bedürfen einer verlässlichen Aufbereitung von Informationen und können mit der richtigen Technologie standardisiert, beschleunigt und qualitativ verbessert werden. Renato Stalder Die Optimierung von Geschäftsprozessen gehört heute zu den Schlüsselaufgaben jedes Unternehmens. Wer Prozesse richtig managt, kann diese nicht nur effizienter gestalten, sondern auch deren Qualität verbessern und obendrein noch Kosten sparen. In die Kategorie der anspruchsvollen Abläufe gehören zweifelsohne Entscheidungsprozesse, insbesondere dann, wenn sie an Risiken gebunden sind. Solche Prozesse wollen nicht nur optimal gestaltet sein, sie basieren auch auf der Aufbereitung und Auswertung von Informationen, ohne die der Prozess selbst nicht abgeschlossen werden kann. Der Schlüssel zum Erfolg liegt dabei in der geeigneten Kombination von Softwaresystemen, die Prozesse optimal abbilden und automatisiert operative (nicht strategische) Entscheidungen treffen. Solche Decision Support Systems (DSS) können nicht mehr bloss wie in den Anfängen der Informatik Daten sortieren, filtern und darstellen. Heutzutage sind DSS aufgrund komplexer Optimierungsalgorithmen in der Lage, Daten zu interpretieren, zu bewerten und Beurteilungen vorzunehmen – kurz, Entscheidungen aufgrund verlässlicher Daten selbstständig zur treffen. Der Mensch wird dabei aber nicht überflüssig, gibt es doch auch bei jeder automatisierten Entscheidung eine gewisse Unschärfe, also Fälle, die weder mit Ja noch mit Nein beantwortet werden können. Ein «Jein» kommt in der Praxis häufiger vor, als man denkt. Ein «Jein» beinhaltet überdies die Möglichkeit, die zur Entscheidung nötigen Grundlagen gegebenenfalls anzupassen und so ein Nein zugunsten eines Ja abzuwenden. In solchen Fällen kommt der Anwender zum Zug, indem er die gesammelten Informationen und Grenzwertüberschreitungen prüft, neue Daten einholt und hinzufügt, um schliesslich zu einer klaren Antwort zu kom- men. Der Vorteil der Automatisierung liegt somit darin, dass sich der Mensch bei einem Grossteil der auftretenden Abfragen und Beurteilungen auf das Urteil eines DSS verlassen und auf die Beantwortung der komplexen («Jein»-)Fälle konzentrieren kann. Im Folgenden soll ein Praxisbeispiel die Verheissungen der Softwaretechnologie veranschaulichen. Entscheidungsprozesse sind vielschichtig Jeder Autohändler kennt das Problem: Ein ­Leasingvertrag mit einem neuen Kunden kann nur abgeschlossen werden, wenn die Risikobewertung der betreffenden Privatperson oder Firma positiv ausfällt. Doch die Beurteilung der Kreditwürdigkeit eines Antragstellers ist aufwendig und benötigt Zeit, müssen doch Wirtschaftsdatenbanken abgefragt, Details geprüft, Bewertungen vorgenommen und gegebenenfalls Zusatzinformationen angefordert werden, bevor es zur Unterzeichung des Vertrags kommen kann. Normalerweise werden heutzutage solche Anträge von Sachbearbeitern in einzelnen Schritten manuell bearbeitet. Die Abfrage von Budgetzahlen, Sicherheiten oder der Zahlungsmoral des Kunden muss einzeln vorgenommen, die Resultate bewertet und in eine Datenbank respektive eine Vertragssoftware übertragen werden – oft manuell. Die Beurteilung des Antrags ist dabei nicht nur von den vorliegenden Informationen, sondern auch von der richtigen Vorgehensweise und vom Wissen des Mitarbeiters abhängig, der den Antrag bearbeitet. Die Bearbeitung eines Leasingantrags ist also nicht bloss aufwendig und zeitintensiv, sondern auch mit gewissen Risiken behaftet. Risiken wie Zahlungsverzug oder –ausstände, die man durch den Prüfprozess ja gerade vermeiden will. Deshalb kommt normalerweise immer auch noch das Vier-Augen-Prinzip zum Einsatz. Standardisierung und Automatisierung Renato Stalder ist CEO des BPM-Herstellers Soreco und Verwaltungsrat des DSS-Spezialisten Axon Active Holding. Geeignete Softwarelösungen schaffen hier Abhilfe. So kann mittels eines Softwareservices einer Business-Process-Management-Lösung die Identifikation der Person oder Firma erfolgen, indem sekundenschnell Daten mit Wirtschaftsdatenbanken abgeglichen werden. Das Eingreifen eines Sachbearbeiters ist lediglich dann nötig, wenn die Daten nicht korrekt sind. Andernfalls werden, basierend auf einem komplexen Regelwerk, das mehrere Dutzend oder hunderte Regeln beinhalten kann, die Daten einer Risikobewertung unterzogen. Das DSS wiederum prüft den Antrag beispielsweise auf Kreditwürdigkeit oder Kreditfähigkeit und führt ihn in einen von drei Zuständen über: Grün für bewilligt, Rot für abgelehnt oder Gelb, wenn ein manueller Eingriff nötig ist. Letzterenfalls werden dem Sachbearbeiter sämtliche Daten, die für die Beurteilung nötig sind, über eine Prozessebene direkt zur Verfügung gestellt. Jetzt können, egal in welchem vor- oder nachgelagerten System die Informationen vorhanden sind, Daten mutiert, berechnet oder ergänzt werden. So kann der Antrag dergestalt modifiziert werden, dass dem Kunden vom Verkäufer ein Vorschlag für einen günstigeren Wagen unterbreitet werden kann. Schliesslich erfolgt bei einem bewilligten Antrag die automatisiert Produktion der Vertragsdokumente und die regelkonforme Archivierung aller Daten, Entscheidungs­ informationen und Dokumente. Kosten, Zeit und Umsatz Softwaresysteme können Entscheidungen also nicht nur unterstützen, sondern sie sogar dem Menschen abnehmen. Der grosse Vorteil liegt dabei in zwei Dingen: Eine positive Entscheidung wird sicherer, weil sie standardisiert und automatisiert vonstatten geht. Ebenso wichtig ist aber auch die Geschwindigkeit, mit der der Kunde eine Antwort erhält. Anstatt wie oft einen oder gar mehrere Tage auf eine Antwort zu warten, kann diese in Minutenschnelle erfolgen. Ein Vorteil, der für Verkäufer von unschätzbarem Wert ist, erhält der Kunde doch gleich die Gewissheit, dass das Autohaus mit ihm den Vertrag abschlies­ sen will. Sind (bei Antwort «Gelb») Anpassungen oder Zusatzinformationen notwendig, so kann dies ebenfalls sofort im Gespräch geklärt werden. Denn egal ob Auto, Heimelektronik oder Abteilungsdrucker, jeder Verkäufer weiss: Zeigt ein Kunde Interesse, darf man ihn nicht warten lassen. Kombinierte Systeme zur Prozessoptimierung und Entscheidungsfindung sparen also nicht nur Zeit und Kosten, sie bieten auch sehr viel Potenzial für höhere Umsätze. < 04/2013 © netzmedien ag 33 Dossier swiss BPM-Forum in Kooperation mit Uvision «BPM ist im Grunde genommen die ureigenste Managementdisziplin überhaupt» Dr. Clemente Minonne von der Zürcher Hochschule für Angewandte Wissenschaften sagt im Interview, wie gross die Kluft zwischen Forschung und Praxis beim Thema BPM wirklich ist. Er sieht ausserdem Anzeichen, dass sich nicht mehr nur primär IT-, sondern auch BWL-Studenten für das Thema interessieren. Interview: Simon Zaugg Herr Minonne, was beschäftigt Sie derzeit am meisten im BPM-Umfeld? Vielerorts sind Forscher der Meinung, dass das Thema schon längst durch sei und fragen mich, weshalb ich noch Energie in BPM investiere. Da bin ich anderer Meinung. Wenn ich Unternehmen besuche, dann zeigt sich nämlich genau jenes Bild, das sich auch in unserer Studie «BPM 2011: Status quo und Zukunft» widerspiegelt, die wir bei über 200 Unternehmen im deutschsprachigen Raum durchgeführt haben. Demnach gehören lediglich 7 Prozent der Unternehmen bezüglich BPM zu den sogenannten «World Champions». 32 Prozent sind auf gutem Wege. Weit über die Hälfte steht jedoch noch ziemlich am Anfang. Die Forschung sieht dagegen verschiedene weitere Trends: Die besagen, dass BPM im Kontext von cloudbasierten Diensten ein riesiger Trend sein wird. Weiter kommt die Einbettung der Social-Media-Plattformen in den BPMLifecycle dazu. Zu Big-Data-Analytics wird zudem gesagt, dass man neue Intelligenz aus den Prozesskennzahlen erzeugen und proaktiv prozessbezogene Initiativen starten kann. Die Forscher scheinen es dagegen überhaupt nicht interessant zu finden, zum Beispiel auf dem Gebiet der «Prozesskostenanalyse» weiterführende praxisorientierte Grundlagen und Modelle zu schaffen. Manchmal vergessen sie, welche Unterstützung die Praxis wirklich benötigt. Wie gut ist BPM denn eigentlich an den Hochschulen verankert? Man darf heute mit gutem Gewissen sagen, dass das Thema auch im Hochschulumfeld völlig vernachlässigt wird. Das Prozessmanagement ist zwar Teil diverser Studiengänge. Ganze Module zum Thema gibt es jedoch eher selten und komplette Studiengänge sind die Ausnahme. BPM scheint ein analytisches Thema zu sein, das vorab ITler interessiert – Betriebswirte finden daran eher weniger Gefallen. Erfreulich ist jedoch, dass es immer mehr BWLer gibt, die mich anfragen, Semester- oder Diplomarbeiten zum angewandten Prozess- men eine Organisationsstrategie entwickle, dann gehe ich drei Phasen durch: die Analyse, die Entwicklung sowie die Umsetzung der Strategie. Der Analyseteil ist Fleissarbeit. Der Entwicklungsteil ist eine Frage der Kreativität und der Umsetzungsteil bleibt dann eine ziemliche Knochenarbeit. Dasselbe gilt es auch zu tun, bevor überhaupt BPM-Lösungen eingeführt werden. Basierend auf dem bestehenden Geschäftsmodell muss zum Beispiel eine stringente Prozesslandkarte definiert werden. Darunter werden die Geschäftsprozesse bis auf die Ebene der Elementarprozesse zerlegt, bis sie nicht mehr weiter zerlegt werden können. Die Hausaufgaben muss man eben vorher machen! Dr. Clemente Minonne erforscht an der Zürcher Hochschule für Angewandte Wissenschaften die neusten Trends im Business Process Management. management zu betreuen. Das zeigt, dass sie dort Potenzial sehen. Was sind denn im Kontext von BPM konkrete Bedürfnisse von Unternehmen? Für sie gilt es, primär dafür zu sorgen, dass sie nicht ins Straucheln geraten. Das heisst, sie müssen Methoden und Systeme entwickeln, um in erster Linie adäquate Prozesskostenanalysen durchzuführen. In vielen Branchen, die einem Verdrängungsmarkt ausgesetzt sind, kann mit dem aktuellen Geschäftsmodell nur noch erfolgreich bleiben, wer bei ganz bestimmten Prozessen erfolgreich Kostensenkungsmassnahmen umsetzt. Dann kann man trotz stagnierendem Umsatz mehr Gewinn erzielen; eine Kunst! Entgegen der vielerorts herrschenden Hochschulsicht wird es künftig so sein, dass die Praxis-Trends in Richtung Effektivitätssteigerung gehen werden, bei der es um Qualität und Innovation geht – und nicht in Richtung Effizienzsteigerung, bei der es um die Produktivität geht. Man darf ganz grundsätzlich nicht vergessen, dass BPM im Grunde genommen die «ureigenste» Managementdisziplin überhaupt ist. Wenn ich als Unterneh- Falls ein Unternehmen BPM ernsthaft umsetzen will, woran mangelt es denn meistens? Ich wurde gerade kürzlich von einem Mitglied einer Geschäftsleitung kontaktiert. Der Grund war, dass sie zwar auf bestem Wege sind, BPM im professionellen Sinne zu implementieren, jedoch nach der Erarbeitung der Prozesslandkarte und der Modellierung ausgewählter Prozessketten nun irgendwie feststecken. Sie haben erkannt, dass zwischen ihrer neuen strategischen Intention und dem, was konsequenterweise im Bereich des Prozessmanagements gemacht wird, nur ein gering nachvollziehbarer Link existiert. Das bedeutet, dass es eben unsere Aufgabe sein muss, diesen Führungskräften zu erklären, wie dieser Link zustande kommt und operationalisiert werden kann. Wie beurteilen Sie die Chancen für neue ­Player mit BPM-Dienstleistungen? Man wird künftig ganz neuartige Firmen am Markt antreffen. Es wird Unternehmen geben, die im Mandatsverhältnis die volle Verantwortung für die Durchführung hochspezialisierter und branchenspezifischer Prozesse übernehmen. Da wird es auch sehr grosses Potenzial für Lösungsanbieter geben. Insgesamt ist es jedoch ganz wichtig, dass man zwischen BPM-as-a-Service und BP-as-a-Service unterscheidet. Viele machen heute diese Unterscheidung kaum. < 04/2013 © netzmedien ag 34 Die themenführende B2B-Plattform zu Business Process Management 25. April 2013 | 08.00 – 17.00 Uhr Mövenpick Hotel Zürich-Regensdorf Platin Partner: Business Process Management – Kernkompetenz erfolgreicher Unternehmen Gold Partner: Die Management-Plattform für Entscheidungsträger von Anwenderunternehmen Prof. Dr. Mark Dambacher Kjell A. Nordström Stv. CEO, InCore Bank Professor at the Institute of International Business, Stockholm School of Economics Daniel Hüppi CEO, AMAG Leasing AG Karl Unger Strategischer Berater des Vorstands und ehem. Vorstandsmitglied, UNIQA, Österreich Versicherungen AG Rosmarie Widmer Gysel Regierungspräsidentin und Finanzdirektorin, Kanton Schaffhausen Daniel Zurlinden Leiter IT und Logistik, Mitglied der Geschäftsleitung, fenaco Genossenschaft www.sgo.ch Zeit Programm 08.30 Registration und Networking 09.20 Eröffnung Forum: CEO’s Soreco AG, Software AG und ZHAW School of Management and Law 09.30 Schwerpunkte und Herausforderungen BPM: Studie 2013 & Einstiegsthesen Dr. Clemente Minonne, Head of Research Group for Knowledge and Information Management, ZHAW School of Management and Law Prof. Dr. Thomas Allweyer, Professor für Unternehmensmodellierung, FH Kaiserslautern 10.00 Pause & Networking 10.30 Digitalisierung: Vom elektronischen Belegfluss zum intelligenten Workflow Karl Unger, Strategischer Berater des Vorstands und ehem. Vorstandsmitglied, UNIQA Österreich Versicherungen AG 11.00 AMAG Leasing-Prozess: Kreditentscheide in Echtzeit dank Prozessautomation Daniel Hüppi, CEO, AMAG Leasing AG 11.30 Anforderungen der Politik und der Verwaltungspraxis an optimierte Geschäftsprozesse durch gezielten Einsatz des E-Governments Rosmarie Widmer Gysel, Regierungspräsidentin und Finanzdirektorin, Kanton Schaffhausen 12.00 Executive Plenardiskussion mit den Referenten 12.20 Business Lunch & Networking 13.30 Best-Practice- und Expertengespräche Session A: Enterprise Accounts Einstiegsthese durch Dr. Clemente Minonne 13.40 Silber Partner: Session B: Top SMB Accounts Einstiegsthese durch Stefan Studer Roundtables Leitung Roundtables Prof. Dr. Thomas Allweyer Geschäftsprozess-Management als Basis für die Transformation der Schweizer Armee Markus Kress, Unternehmensentwicklung, Schweizer Armee BPM: Nutzen erkennen, Nutzer überzeugen Urs Salzmann, Leiter Kommunikation, Stadt Gossau SG 14.00 Professionelle Kundenberatung mit BPM-Unterstützung: Digitalisierung des Client-Onboardingund des Client-Annual-Review-Prozesses Anna Roth, IT Project Manager, Coutts & Co Ltd. Kreditanträge mittels Workflow steuern und überwachen Daniel Zurlinden, Leiter IT und Logistik, Mitglied der Geschäftsleitung, fenaco Genossenschaft Roundtables zu den Schwerpunktthemen BPM-Innovationen, -Operations, -Strategien und -Management 14.20 Kontinuierliche Prozessoptimierung dank Fokussierung auf Kundenbedürfnisse Manuel Joos, Leiter Softwareentwicklung, UBS Card Center AG Business Process Outsourcing – Trends Mark Dambacher, Stv. CEO, InCore Bank 14.40 Experten Paneldiskussion Experten Paneldiskussion 15.00 Pause & Networking 15.30 Radical Change – Challenges and Choices Prof. Dr. Kjell A. Nordström, Professor at the Institute of International Business, Stockholm School of Economics 16.10 Fazit und Ausblick 16.20 Community-Apéro BUSINESS IN MOTION Media Partner: Veranstalter: branded marketplaces Anmeldung: www.bpm-forum.ch (Eintrittspreis für Anwender CHF 390.–, für Anbieter CHF 2590.–) Informationen: [email protected], Tel. +41 44 260 10 60