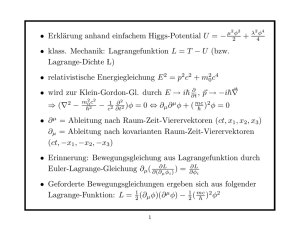

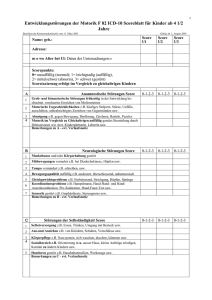

Simulation und Bewertung alternativer Konfigurationen für den

Werbung