Entwurf und Implementierung eines Clojure

Werbung

Entwurf und Implementierung

eines Clojure-Treibers für ArangoDB

Peter Fessel

Matrikel-Nr.: 772676

Medieninformatik Bachelor

Beuth Hochschule für Technik Berlin

Betreuer: Prof. Dr. Stefan Edlich

Gutachter: Prof. Dr. Löser

0. Abstract

The following thesis deals with the design and implementation of

a driver for the multimodel NoSQL database ArangoDB. The

driver is written in the programming language Clojure and makes

use of ArangoDB's HTTP-Interface to send requests to the

database.

The goal for the driver is a simple and effective API design and a

lightweight implementation, that adds as little overhead as

possible to the database requests.

Topics in this thesis include the functional JVM language Clojure,

an examination of the field of NoSQL databases and the HTTP

protocol and its origins in the REST architectural style.

Peter Fessel, Berlin, April 2014

E-Mail: peter.fessel[at]rwth-aachen.de

www.peterfessel.com

www.github.com/lepetere

Inhalt

0. Abstract.......................................................................................................................... 2

1. Einleitung.......................................................................................................................5

2. Fachliche u. technische Grundlagen.............................................................................. 8

2.1 Clojure.....................................................................................................................8

2.1.1 Eigenschaften von Clojure und Lisp............................................................... 8

2.1.2 Funktionale Programmierung und Clojure......................................................9

2.2 NoSQL.................................................................................................................. 12

2.2.1 Polyglot Persistence...................................................................................... 12

2.2.2 Definition...................................................................................................... 13

2.2.3 Dokumentbasierte Datenbanken................................................................... 15

2.2.4 Key/Value Datenbanken................................................................................16

2.2.5 Graphdatenbanken.........................................................................................17

2.2.6 Wide Column Stores..................................................................................... 18

2.2.7 Multimodel-Datenbanken............................................................................. 18

2.2.8 Zusammenfassung.........................................................................................19

2.3 REST und HTTP...................................................................................................20

2.3.1 REST Einführung..........................................................................................20

2.3.2 Ressourcen und Repräsentationen.................................................................21

2.3.3 Die Bestandteile von REST.......................................................................... 21

2.3.4 REST, HTTP und die HTTP-Methoden........................................................ 23

2.3.5 HTTP-Header................................................................................................ 25

2.3.6 REST und NoSQL.........................................................................................26

2.4 ArangoDB............................................................................................................. 27

2.4.1 Eigenschaften und Designziele..................................................................... 27

2.4.2 Speichereffizienz und Performance.............................................................. 28

2.4.3 Concurrency, Transaktionen, Skalierbarkeit und Replikation.......................29

2.4.4 ArangoDBs HTTP/REST-Interface...............................................................31

2.4.5 Datenbanken, Collections, Dokumente und Graphen in ArangoDB.............31

2.4.6 Querying........................................................................................................34

2.4.7 Indizierung.................................................................................................... 35

2.4.8 Die Bestandteile von ArangoDB................................................................... 35

3. Aufgabenstellung......................................................................................................... 38

4. Entwurf und Implementierung.....................................................................................39

4.1 Werkzeuge.............................................................................................................40

4.1.1 Versionsverwaltung....................................................................................... 40

4.1.2 Clojure Projektmanagement..........................................................................40

4.2 verwendete Libraries.............................................................................................41

4.2.1 clj-http........................................................................................................... 41

4.2.1 Cheshire.........................................................................................................41

4.3 Versionierung........................................................................................................ 42

4.4 Vergleich von APIs anderer Clojure Datenbanktreiber.........................................43

4.4.1 Monger für MongoDB.................................................................................. 43

4.4.2 Clutch für CouchDB..................................................................................... 47

4.4.3 Elastisch für Elasticsearch.............................................................................48

4.4.4 clj-orient für OrientDB..................................................................................49

4.4.5 Carmine für Redis......................................................................................... 51

4.4.6 Neocons für Neo4J........................................................................................ 52

4.4.7 Zusammenfassung.........................................................................................53

4.5 grundsätzliche Überlegungen................................................................................54

4.5.1 ähnliche Methoden........................................................................................ 54

4.5.2 Angabe von Verbindungsdaten......................................................................54

4.5.3 Überprüfung der Eingabedaten..................................................................... 55

4.5.4 Methodenbenennung..................................................................................... 56

4.5.5 Gliederung der Funktionalitäten in eigene Funktionsräume vs. Gliederung

der ArangoDB HTTP-API......................................................................................57

4.6 Clarango API.........................................................................................................58

4.6.1 Clarango Core............................................................................................... 58

4.6.2 Document API............................................................................................... 59

4.6.3 Collection API............................................................................................... 60

4.6.4 Datenbank API.............................................................................................. 60

4.6.5 Query API......................................................................................................60

4.6.6 Graph API......................................................................................................61

4.6.7 Flexible Funktionssignaturen........................................................................ 61

4.7 Implementierungsdetails....................................................................................... 63

4.7.1 Error-Handling.............................................................................................. 63

4.7.2 Rückgabewerte.............................................................................................. 63

4.7.3 „klassische“ Datenbank-Methoden vs. „clojuresque“ Methoden.................65

4.7.4 Batch Requests.............................................................................................. 67

4.7.5 Allgemein verwendbare unterliegende Methoden.........................................67

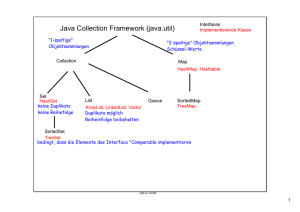

4.8 Clarango System-Architektur............................................................................... 69

4.8.1 Clarango Namespaces................................................................................... 69

4.8.2 Diagramm......................................................................................................71

4.9 Exemplarische Untersuchung: Aufbau und Aufruf einer Clarango Methode ......72

5. Testing / Qualitätssicherung........................................................................................ 78

6. Anwendungsdemo....................................................................................................... 80

7. Fazit und Ausblick....................................................................................................... 83

8. Abbildungsverzeichnis.................................................................................................88

9. Quellenverzeichnis...................................................................................................... 89

9.1 Buchquellen.......................................................................................................... 89

9.2 Internetquellen...................................................................................................... 90

10. Anhang.......................................................................................................................96

10.1 Ausgaben des Anwendungsbeispiels aus Kapitel 6............................................96

10.2 Vollständige Clarango API Dokumentation...................................................... 104

10.2.1 Core API....................................................................................................104

10.2.2 Document API........................................................................................... 105

10.2.3 Collection API........................................................................................... 109

10.2.4 Datenbank API.......................................................................................... 113

10.2.5 Query API..................................................................................................114

10.2.6 Graph API..................................................................................................116

10.2.7 collection-ops API..................................................................................... 122

10.3 ArangoDB API Checkliste................................................................................ 124

4

1. Einleitung

Mit dem Aufkommen des Web 2.0 und seinen sich schnell verändernden dynamischen

Web-Anwendungen sowie großen und untereinander vernetzten Datenmengen ist eine

neue Datenbank-Generation entstanden. Diese wird unter dem Label „NoSQL“

zusammengefasst. Nach Jahren der einseitigen Nutzung von relationalen Datenbanken in

Softwareprojekten steht diese Bewegung für eine freie Auswahl verschiedener

Datenbankmodelle.

Ein Vertreter dieser neuen Gruppe von Datenbanken ist ArangoDB 1. ArangoDB wird seit

2011 von dem Unternehmen triAGENS aus Köln entwickelt und ist als Open Source

Software frei verfügbar. Dort wo sich die meisten anderen Vertreter der NoSQL-Fraktion

auf ein bestimmtes Datenmodell wie Dokumente oder Graphen festgelegt haben, deckt

ArangoDB gleich drei verschiedene Datenmodelle ab: Dokumente, Graphen und

Key/Value. Der Gedanke dahinter ist, dass sich die Datenbank fexibel an eine WebAnwendung während ihrer Entwicklung anpassen kann. Wenn sich in der

Entwicklungsphase neue Anforderungen ergeben, so ist es nicht notwendig, gleich das

ganze Datenbanksystem zu wechseln oder ein zusätzliches System zum Technologiestack

hinzuzufügen. Stattdessen vereint ArangoDB viele Funktionen unter einem Dach, sodass

bei Bedarf zusätzliche oder andere Funktionen genutzt werden können. Um diese

vielseitigen Anwendungsmöglichkeiten zu erreichen, werden leichte Abstriche bei der

Performance und bei der Skalierbarkeit gemacht.

Mit diesem breiten Ansatz hat sich das Team von ArangoDB zum Ziel gesetzt, „das MySQL

in NoSQL“ zu werden2. ArangoDB soll also zur quasi-Standard-Datenbank unter den

NoSQL-Datenbanken werden, so wie es MySQL faktisch im Bereich der relationalen

Datenbanken ist. Da die Datenbank sich in stetiger Weiterentwicklung befindet, ist es

wahrscheinlich, dass sie in Zukunft zu einer breiteren Verwendung gelangt.

Die Nähe von ArangoDB zum Web wird deutlich durch die Verwendung einer

REST/HTTP-Schnittstelle zur Kommunikation mit seinen Clients. Ebendiese Schnittstelle

soll zur Entwicklung des Clojure Treibers in dieser Bachelorarbeit genutzt werden. Der

Treiber dient dazu, die Sprache Clojure mit der Datenbank ArangoDB kommunizieren zu

lassen, sodass Daten ausgetauscht werden können.

1 http://www.arangodb.org/

2 „we want to become the MySql in nosql – without MySql’s annoyances of course ;-)“

[wwwArangoBlog1]

5

Bei Clojure handelt es sich um eine vornehmlich funktionale Programmiersprache. Der

Ansatz der funktionalen Programmierung versucht mit der Komplexität von

Softwareanwendungen umzugehen, indem Zustände und veränderliche Variablen aus der

Programmierung verbannt werden. Da es sich bei REST/HTTP ebenfalls um ein

zustandsloses Konzept handelt, bietet sich eine Kombination dieser beiden Ansätze an. Als

die Idee zu dieser Arbeit entstand, gab es noch keinen ArangoDB Treiber für Clojure3. Das

Ziel dieser Arbeit ist daher die Entwicklung eines solchen Treibers.

Der Treiber soll in Zusammenarbeit mit dem Betreuer Prof. Dr. Stefan Edlich entstehen.

Prof. Dr. Edlich wird sich hierbei vornehmlich auf das Erstellen einer Test-Infrastruktur

konzentrieren, während der Verfasser dieser Arbeit den Entwurf, und soweit es geht, auch

die Implementierung des eigentlichen Treibers übernimmt. Der Treiber wird als Open

Source Projekt unter dem Namen „Clarango“ realisiert. „Clarango“ setzt sich aus den

Anfangsbuchstaben der Namen Clojure und ArangoDB zusammen.

Mit Hilfe einer HTTP-Library ist es theoretisch möglich, direkt HTTP Anfragen aus einer

Anwendung an die Datenbank zu senden. In der Praxis ist dies jedoch keine gute Lösung,

da es die Komplexität der Anwendung unnötig erhöht. Die Verwendung eines Clojure

Treibers bietet den Vorteil, dass das Senden der HTTP-Anfragen vollständig ausgelagert

wird. Der Treiber übernimmt dann die Aufgabe des Zusammensetzens der HTTP-Anfragen

im von der Datenbank erwarteten Format.

Durch die Möglichkeit der Java-Interoperabilität bei Clojure bietet sich zwar die

Verwendung des bereits verfügbaren Java Treibers für ArangoDB 4 in direkter Weise oder

mittels eines Clojure-Wrappers an. Dies ist allerdings umständlich, denn unter anderem

müssen bei der Verwendung des Java Treibers Objekte erzeugt werden, um mit der

Datenbank zu arbeiten (z.B. Instanzen des Treibers selbst). In der funktionalen und

zustandsarmen Clojure-Programmierung ist dies jedoch nicht erwünscht und Zustände

sollten so weit es geht vermieden werden. Ein nativer Clojure Treiber lässt sich weitaus

besser in die Clojure-übliche Programmierweise integrieren. Für die Verwendung von

Clojure spricht außerdem, dass die Programmiersprache nativ die Datenstruktur der Maps

unterstützt. Diese ist dem JSON-Format, das von ArangoDB verwendet wird, ähnlich und

kann leicht in dieses übersetzt werden.

Im Laufe dieser Arbeit wird zunächst eine Einführung in die verwendeten Technologien

und zugehörigen Themengebiete gegeben. Hierbei wird ein besonderer Schwerpunkt auf

3 Eine offizielle Liste der verfügbaren Treiber kann hier eingesehen werden:

https://www.arangodb.org/drivers

4 https://github.com/tamtam180/arangodb-java-driver

6

das Thema NoSQL gelegt. Anschließend wird die Datenbank ArangoDB in Bezug zu

bereits existierenden Datenbanken gestellt und in das Feld der NoSQL-Datenbanken

eingeordnet. Nach einer genaueren Beschreibung der Aufgabenstellung werden die

Befehlssätze einiger anderer Treiber für NoSQL-Datenbanken untersucht, um eine

Entscheidungsgrundlage für ein möglichst gutes Design der Clarango API 5 zu erhalten.

Anschließend wird dann auf grundsätzliche Designüberlegungen in Kombination mit

konkreten Implementierungsdetails eingegangen und das Design der Clarango API sowie

die Architektur der Anwendung erläutert. Zum Schluss werden die zur Qualitätssicherung

verwendeten Maßnahmen beschrieben und einige Codebeispiele zur möglichen

Verwendung von Clarango aufgeführt.

5 API steht für „Application Programming Interface“ und bezeichnet eine Schnittstelle eines

Programms, die von anderen Programmen benutzt wird um auf Dienste des Programmes zugreifen zu

können. Siehe hierzu auch http://de.wikipedia.org/wiki/Programmierschnittstelle.

7

2. Fachliche u. technische Grundlagen

Die folgenden Abschnitte sollen eine Einleitung bieten in für diese Arbeit verwendete und

grundlegende Technologien.

2.1 Clojure

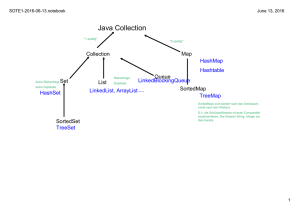

Bei der Programmiersprache Clojure handelt es sich um einen Dialekt der

Programmiersprache Lisp6 und um eine Sprache, die den Einsatz funktionaler

Programmiermodelle fördert. Clojure wird auf der Java Virtual Machine (JVM) 7

ausgeführt, der Laufzeitumgebung in der auch die Programmiersprache Java ausgeführt

wird. Clojure Code wird nach JVM-Bytecode kompiliert, bietet jedoch alle Features auch

zur Laufzeit an und bleibt damit vollständig dynamisch.

Clojure wurde von Rich Hickey als „general-purpose language“ geschaffen [wwwClojure]

und erstmals im Jahr 2007 veröffentlicht. Ohne dass besondere Mittel des Marketings

eingesetzt wurden, hatte die Sprache schnell einen größeren Kreis von Anhängern und eine

lebendige Community8.

2.1.1 Eigenschaften von Clojure und Lisp

Clojure ist eine dynamisch und stark typisierte Sprache. Es handelt sich um einen Dialekt

von Lisp, einer der ersten Programmiersprachen überhaupt, die auch heute noch

Verwendung findet. Clojure gehört dabei genau wie der heute noch verwendete Dialekt

Scheme zur Familie der „lisp-1“ Dialekte [Tate2011]. Durch den Verzicht auf die

Abwärtskompatibilität schlägt die Sprache jedoch, verglichen mit anderen Dialekten, eine

neue Richtung ein. Diese äußert sich unter anderem in der Erweiterung der verfügbaren

Datenstrukturen um Vektoren und Maps und der dazugehörigen Einführung von

zusätzlichen Klammer-Typen, die die Lesbarkeit erhöhen sollen, sowie der Einführung der

standardmäßigen Unveränderlichkeit der Datenstrukturen [wwwClojureRatio]. Clojure

versteht sich laut Rich Hickey auch als ein „praktisches“ Lisp, denn die bisherigen LispDialekte wurden hauptsächlich in der Forschung verwendet und sind nie richtig in der

produktiven Programmierung der Industrie angekommen [Tate2011].

Lisp steht für „LISt Processing“ und der Name rührt daher, dass der gesamte Code aus

Listen besteht. Funktionsaufrufe verwenden das erste Element einer Liste als

6 http://de.wikipedia.org/wiki/Lisp

7 http://de.wikipedia.org/wiki/Java_Virtual_Machine

8 Vgl. „Interview with Rich Hickey“: https://www.ugtastic.com/rich-hickey/

8

Funktionsnamen und die restlichen Elemente als deren Argumente. Da Lisp seine eigenen

Datenstrukturen verwendet um Programme auszudrücken, lautet eine wichtige Strategie

der Sprache „Daten als Code“ (code-as-data). Durch dieses Konzept ist die Sprache auch

insbesondere gut zur Metaprogrammierung geeignet. Letztere stellt auch eine der Stärken

von Clojure dar.

Wie bereits erwähnt wird Clojure auf der Java Virtual Machine ausgeführt. Dies verschafft

der Sprache einen infrastrukturiellen Vorteil einerseits durch die Verfügbarkeit der

Plattform auf vielen (Betriebs-)Systemen und der bereits vorhandenen breit gestreuten

Akzeptanz dieser Plattform; andererseits durch die Möglichkeit der Einbindung der vielen

bereits existierenden Java-Bibliotheken (Java-Interoperabilität). Die Vielseitigkeit von

Clojure wird noch vergrößert durch einen existierenden Clojure-nach-JavaScript Compiler

namens ClojureScript9, der die Ausführung in JavaScript-Umgebungen erlaubt.

2.1.2 Funktionale Programmierung und Clojure

Bei Clojure handelt es sich um eine Programmiersprache, die teilweise auch imperative

Programmierung zulässt [Tate2011]. In erster Linie ist Clojure jedoch eine funktionale

Programmiersprache und die funktionale Programmierung wird von Clojure stark

gefördert. Daher soll dieses Programmierparadigma und damit weitere wichtige

Eigenschaften der Sprache Clojure hier kurz erläutert werden.

Eine sehr gute Definition der funktionalen Programmierung findet sich auf S.13 in

[Edlich2011]:

„Das Konzept einer Funktion im Sinne der Mathematik ist in der funktionalen

Programmierung am klarsten umgesetzt. Hier stellen die Funktionen

Abbildungsvorschriften dar. Eine Funktion besteht dann aus einer Reihe von

Definitionen, die diese Vorschrift beschreibt. Ein funktionales Programm besteht

ausschließlich aus Funktionsdefinitionen und besitzt keine Kontrollstrukturen wie

Schleifen. Wichtigstes Hilfsmittel für die funktionale Programmierung ist daher die

Rekursion. Funktionen sind in funktionalen Programmiersprachen Objekte, mit

denen wie mit Variablen gearbeitet werden kann. Insbesondere können Funktionen

als Argument oder Rückgabewert einer anderen Funktion auftreten. Man spricht

dann von Funktionen höherer Ordnung.“

Folgende Eigenschaften und Ideen zeichnen sowohl die funktionale Programmierung als

auch die Programmiersprache Clojure aus:

9 https://github.com/clojure/clojurescript

9

•

First-Class Functions: Damit bezeichnet man die Tatsache, dass Funktionen selber

Werte sind. Mit ihnen kann genau wie mit anderen Daten gearbeitet werden. Das

heißt insbesondere können sie anderen Funktionen als Argumente übergeben

werden und von diesen als Ergebnisse zurückgegeben werden.

•

Funktionen höherer Ordnung: Die Existenz von Funktionen höherer Ordnung

resultiert direkt aus den First-Class Functions: Es handelt sich hierbei um

Funktionen, die andere Funktionen als Argumente übergeben bekommen oder

Funktionen als Ergebnisse zurückliefern. Klassische Beispiele aus der Welt der

funktionalen Programmierung sind die Funktionen Map und Reduce, die jeweils

eine Funktion übergeben bekommen, die sie auf allen Elementen einer Collection

ausführen.

•

unveränderliche Werte (immutable Values): Die zentralen Datenstrukturen in

Clojure sind unveränderlich, anders als zum Beispiel Variablen in Sprachen wie Java

oder JavaScript. Dadurch wird die Fehleranfälligkeit von Programmen reduziert,

denn es werden die sogenannten „Pure Functions“ (siehe unten) erst möglich.

Außerdem ist das Arbeiten mit unveränderlichen Werten ein wichtiger Aspekt der

nebenläufigen Programmierung, einer der Stärken von Clojure: wird mit mehreren

Threads parallel auf denselben Datenstrukturen gearbeitet, können diese sich darauf

verlassen, dass die Daten nicht gleichzeitig von anderen Threads verändert werden.

Dies erleichtert die nebenläufige Programmierung stark.

•

keine Seitenefekte: Als Seiteneffekte werden Interaktionen einer Funktion mit der

„Außenwelt“ bezeichnet; per Definition handelt es sich bei jedem Input/Output

eines Programms oder der Modifikation eines veränderlichen Objekts um einen

Seiteneffekt [Emerick2012].

•

Pure Functions: „Pure Funktionen“ verzichten auf die Nutzung von Seiteneffekten.

Bei gleichen Eingabewerten resultieren hier immer die gleichen Ausgabewerte.

Dadurch ist das Verhalten einer Funktion zu hundert Prozent vorhersagbar, was sie

wiederum sehr gut testbar macht und die Fehleranfälligkeit eines Programms

reduziert.

Die rein funktionale Programmierung kann man sich auch wie einen Baum vorstellen: Es

wird eine Funktion aufgerufen, die die Wurzel des Baumes bildet und wiederum weitere

Funktionen aufruft, welche wiederum weitere Funktionen aufrufen usw. Am Ende eines

jeden Astes liefert jeweils die unterste Funktion einen Rückgabewert, der dann an die

aufrufenden Funktionen weitergereicht bzw. von diesen weiterverarbeitet wird und

ebenfalls an die aufrufende Funktion zurückgegeben wird bis wieder die Wurzel des Baumes

erreicht ist.

10

Da in Programmen jedoch immer irgendeine Art von Eingabe und Ausgabe erfolgen muss,

damit das Programm einen sinnvollen Zweck erfüllen kann, sind rein funktionale

Programme in der Realität nicht möglich. Es wird stattdessen vielmehr auf eine Mischform

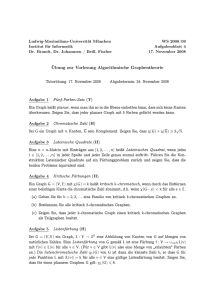

zurückgegriffen, wie sie in Abbildung 1 dargestellt ist. Ein Programm kann einen

funktionalen Kern haben, in dem alle Vorteile der funktionalen Programmierung genutzt

werden können. Es muss jedoch auch über einen Teil verfügen, der mit der restlichen Welt

kommunizieren kann und deswegen nicht seiteneffektfrei ist.

Abb. 1: Diagramm eines

funktionalen Programms

11

2.2 NoSQL

Bei NoSQL handelt es sich um eine ca. seit dem Jahr 200410 stattfindende Bewegung weg

von den allseits verbreiteten relationalen Datenbanken hin zu alternativen

Datenbankmodellen. Insbesondere hat sich der Bedarf nach neuen Datenbanktypen durch

die rasante Entwicklung des World Wide Web und besonders des sogenannten „Web 2.0“

ergeben. Einerseits da im Web 2.0 mit besonders großen Datenmengen (Big Data)

gearbeitet wird, wie diese zum Beispiel in sozialen Netzwerken vorkommen, und diese

effektiv und skalierbar gespeichert und verarbeitet werden sollen. Andererseits, da die

neuen, meist schemalosen Datenbanken eine agile Entwicklung, wie sie häufig bei WebStartups gefordert wird, unterstützen.

2.2.1 Polyglot Persistence

Ein bekanntes Stichwort der Bewegung lautet „Polyglot Persistence“. Damit gemeint ist,

dass unterschiedliche Anforderungen in Anwendungen auch mit unterschiedlichen

Datenbanken gelöst werden sollten. Unterschiedliche Datenbanktypen wurden für

bestimmte Zwecke geschaffen. Zu versuchen, alle unterschiedlichen Problembereiche mit

nur einem Datenbanktypen zu lösen, das heißt unterschiedliche Datentypen in das selbe

Schema zu pressen, ist oft kontraproduktiv und mündet in schlechter Performanz.

In [Sadalage2013] findet sich dazu ein Beispiel anhand einer E-Commerce Plattform: Es

macht wenig Sinn das Session-Management, den Benutzer-Einkaufswagen, die Bestell- und

Produktdaten sowie Kaufempfehlungen einer solchen Anwendung im selben

Datenbankmodell abzulegen. Denn es bestehen hier unterschiedliche Anforderungen an die

Konsistenz, die Verfügbarkeit, die Skalierbarkeit und die Datensicherheit. Die Autoren

schlagen hier einen hybriden Ansatz vor, in dem für das Session-Management und den

Einkaufswagen ein Key/Value-Store benutzt wird. Dieser ist schnell und skalierbar und

eignet sich hier insbesondere, da der Datenzugriff üblicherweise über bekannte User- und

Session-IDs erfolgen wird. Ein erhöhtes Maß an Datensicherheit ist dabei nicht

erforderlich. Abgeschickte Bestellungen und das Produkt-Inventar können dagegen in einer

traditionellen relationalen Datenbank abgespeichert werden. Alternativ könnte aber auch

eine dokumentbasierte Datenbank genutzt werden. Für Kaufempfehlungen aufgrund von

bereits gekauften Produkten oder den Bestellungen anderer Kunden eignet sich dagegen

insbesondere eine Graph-Datenbank, da diese in besonderem Maße dafür geeignet ist,

Verknüpfungen von Datensätzen untereinander abzubilden.

10 2004: Entwicklung von Googles BigTable und GFS (Google File System), aufgrund derer laut

[Edlich2011] Google als der „NoSQL-Vorreiter schlechthin“ gilt

12

Die Autoren von [Edlich2011] sehen zudem hinter dem Begriff Polyglot Persistence eine Art

Bewegung für eine freie Datenbank-Auswahl. Oft sind Unternehmen durch Verträge oder

auch durch mangelndes Wissen auf genau eine Datenbank festgelegt und so müssen die

unterschiedlichsten Datenstrukturen in unzählige relationale Datenbanken „gepresst“

werden. Die Autoren fordern, dass vor der Auswahl einer Datenbank die Anforderungen

genauer untersucht werden und auch schon in der Lehre mehr darauf geachtet wird,

Kenntnisse über die unterschiedlichen verfügbaren (NoSQL-)Systeme zu vermitteln.

2.2.2 Definition

Der Begrif NoSQL war zu Beginn der Bewegung als eine Art Negativ-Definition zu

verstehen, der auf eine Abkehr der auf der Abfragesprache SQL basierenden relationalen

Datenbanken hinwies. Mittlerweile wird der Begriff von der Community aber auch als

„Not only SQL“ definiert. Dies ist wohl darauf zurückzuführen, dass auch einige NoSQL

Datenbanken eine Abfrage mittels SQL oder einer (evtl. erweiterten) Untermenge dieser

Sprache ermöglichen.

Eine scharfe Trennung der Bereiche der klassischen relationalen, SQL-basierten Lösungen

und den Datenbanken der NoSQL-Fraktion wird erschwert durch eine Vielzahl an

Hybridlösungen zwischen beiden Welten und durch viele unterschiedliche Meinungen

darüber, wo eine mögliche Grenze zu ziehen ist [Edlich2011].

Die Autoren von [Edlich2011] haben aber einen Versuch gewagt und 7 Kriterien

entwickelt, um NoSQL Datenbanken als solche zu identifizieren11:

1. „Das zugrunde liegende Datenmodell ist nicht relational.“

→ hier hinter verbirgt sich die Erkenntnis, dass das relationale Datenmodell nicht immer

das passendste für ein Problem sein muss;

2. „Die Systeme sind von Anbeginn an auf eine verteilte und horizontale

Skalierbarkeit ausgerichtet.“

→ die herkömmlichen relationalen Datenbanken waren immer schwerer für große Web

2.0 Anwendungen zu skalieren; die Datenbanken der NoSQL-Bewegung haben dieses

Problem von Anfang an mit im Design berücksichtigt; hier können durch horizontale

Skalierung auch auf Standard-Hardware sehr große Datenmengen efektiv verwaltet

werden;

11 Es müssen jedoch nicht alle Punkte zwingend erfüllt sein, um eine Datenbank zur NoSQL-Fraktion zu

zählen.

13

3. „Das NoSQL-System ist Open-Source.“

→ dies ist das wohl am wenigsten strikt gemeinte Kriterium; ist ein System nicht Open

Source, ist das kein Ausschlusskriterium, aber viele der NoSQL-Systeme sind frei verfügbar

und verstehen sich als eine Art Protestbewegung gegen die Dominanz der (teilweise

kostspieligen) relationalen Systeme;

4. „Das System ist schemafrei oder hat nur schwächere Schemarestriktionen.“

→ hierdurch ergibt sich die bereits erwähnte Möglichkeit der agilen Entwicklung und

fexiblen Änderung und Erweiterung, wie sie mit konventionellen relationalen

Datenbanken und ihrem starren Tabellensystem schwer umzusetzen ist;

5. „Aufgrund der verteilten Architektur unterstützt das System eine einfache

Datenreplikation.“

→ dies wurde ebenfalls bei den meisten Systemen von Anfang an als Anforderung mit

umgesetzt; oft kann durch ein einziges Kommando eine ganze Datenbank repliziert werden

und auf einem zusätzlichen Server-Knoten bereitgestellt werden;

6. „Das System bietet eine einfache API.“

→ Datenbank-Anfragen konventioneller SQL-Systeme können durch viele JoinOperationen leicht kompliziert werden; außerdem ergibt sich eine gewisse Fehleranfälligkeit

und Starrheit dadurch, dass die Anfragen in Form von Strings formuliert werden; NoSQLLösungen bieten hier häufg eine einfachere API; Beispiel sind etwa Datenbanken, deren

Interaktion komplett über eine REST-Schnittstelle läuft12; bei komplexen DatenbankAnfragen hat jedoch meist noch SQL die Nase vorn, denn in NoSQL-Systemen müssen

diese häufg als Map/Reduce-Abfragen formuliert werden;

7. „Dem System liegt meistens auch ein anderes Konsistenzmodell zugrunde:

Eventually Consistent und BASE, aber nicht ACID.“

→ bei Web 2.0 Anwendungen (wie zum Beispiel bei Social Media Portalen) handelt es

sich häufg um nicht sicherheitskritische Anwendungen (im Gegensatz zum Beispiel zu

einer Bankanwendung); es muss damit häufg kein klassisches ACID-System 13 verwendet

werden, sondern die Daten können auch für einen kurzen Zeitraum inkonsistent sein, was

der Skalierbarkeit und der Verfügbarkeit zugute kommt; es reicht, wenn die Daten

„eventually consistent“ sind14;

12 Siehe hierzu auch Abschnitt 2.3.6

13 ACID steht für Atomicity, Consistency, Isolation, Durability und beschreibt grundsätzliche

Eigenschaften von Verarbeitungsschritten in Datenbank-Systemen; siehe hierzu auch

http://de.wikipedia.org/wiki/ACID

14 Siehe hierzu auch http://en.wikipedia.org/wiki/Eventual_consistency; das dazugehörige

Konsistenzmodell wird auch als BASE für Basically Available, Soft state, Eventual consistency

bezeichnet;

14

2.2.3 Dokumentbasierte Datenbanken

Eine dokumentbasierte Datenbank speichert Dokumente. Bei diesen Dokumenten handelt

es sich aber im Gegensatz zu „echten“ Dokumenten wie zum Beispiel Textdateien 15 um

strukturierte Datensammlungen wie Hashes oder JSON 16. Es gibt in den Dokumenten IDFelder und dazugehörige Values (Werte), die wiederum weiteren Dokumenten entsprechen

können. So können Daten beliebig geschachtelt werden. Dadurch dass die meisten

Datenbanken auf diesem Gebiet schemafrei sind, ist dieses Datenmodell sehr fexibel.

Die wohl bekanntesten Vertreter sind hier MongoDB17 und CouchDB18. Bei beiden

handelt es sich um Open Source Projekte. MongoDB wurde erstmals im Jahr 2009

veröffentlicht und CouchDB bereits 2005. Beide Datenbanken haben viele Gemeinsamkeiten. So eignen sich beide sowohl für kleine als auch für sehr große Anwendungen

[Redmond2012]. Bei beiden Datenbanken werden die Daten als JSON-Dokumente

abgespeichert19, es wird JavaScript als primäre Interaktionssprache eingesetzt und beide

bieten Map/Reduce-Funktionen20. Bei CouchDB funktioniert die Abfrage per sogenannter

Views, in denen Map/Reduce-Funktionen spezifiziert sind; die Views speichern die

Ergebnisse der Abfrage zwischen, bis sich die beteiligten Daten ändern. MongoDB bietet

zusätzlich zu Map/Reduce noch Ad Hoc Querying 21 und den Zugriff per Indices, wie man

ihn aus relationalen Systemen gewohnt ist. So wird eine Brücke geschlagen zwischen

klassischen relationalen Systemen und den Vorteilen der schemafreien, verteilten NoSQL

Systeme.

CouchDB bezeichnet sich selber als „Database for the Web“ und ist sehr nah an WebTechnologien gebaut. Als Interface zur Interaktion mit der Datenbank dient HTTP/REST.

CouchDB bietet im Gegensatz zu MongoDB ein integriertes Browser-Interface, welches das

Durchsuchen und Anlegen von Datensätzen erlaubt 22. Und mit CouchApps lassen sich

sogar Webseiten und (über JSON-Dokumente hinausgehende) Inhalte direkt an den

Browser senden, ohne eine weitere Softwareschicht dazwischen23.

15 Der Begriff der Dokumentendatenbank stammt von der Datenbank Lotus Notes, wo noch echte

Anwenderdokumente in der Datenbank gespeichert wurden [Edlich2011]

16 http://de.wikipedia.org/wiki/JSON

17 https://www.mongodb.org/

18 http://couchdb.apache.org/

19 Bei MongoDB genauer gesagt als BSON, was für „Binary JSON“ steht (siehe http://bsonspec.org/).

20 http://en.wikipedia.org/wiki/Map_reduce

21 Als Ad Hoc Queries bezeichnet man Queries, deren Inhalt erst zum Zeitpunkt der Ausführung in der

Anwendung bekannt ist; im Gegensatz zu vordefinierten Queries wie „zeige alle Datensätze der

Datenbank“; vgl. dazu auch http://www.learn.geekinterview.com/data-warehouse/dw-basics/what-isan-ad-hoc-query.html

22 Bei MongoDB sind hier aber Lösungen von Drittanbietern verfügbar; vgl.

http://docs.mongodb.org/ecosystem/tools/administration-interfaces/

23 Vgl. http://couchapp.org/page/what-is-couchapp

15

CouchDBs Design wurde auf hohe Verfügbarkeit und Datensicherheit ausgerichtet. Zu

jedem Dokument wird nicht nur eine ID abgespeichert, sondern auch eine RevisionsNummer für jeden Änderungszustand des Dokuments seit seiner Entstehung. Jeder Stand

des Dokuments wird mit der dazu gehörigen Revisions-Nummer abgespeichert und ist zur

Abfrage verfügbar. Änderungen an Dokumenten werden nur durchgeführt, wenn der

Benutzer zusätzlich zur Dokumenten-ID auch noch die Revisions-Nummer seiner

aktuellsten Version kennt. Dieses append-only Storage Modell macht die Daten sehr sicher

und ermöglicht eine leichte Replikation und Wiederherstellung, auch wenn Teile des

Netzwerks ausfallen sollten. Ein Nachteil ist, dass die Datenbank-Größe schnell zunimmt,

wenn sich die Daten häufig ändern.

MongoDBs Design wurde stark auf horizontale Skalierbarkeit ausgelegt. Wo bei CouchDB

vor allem vertikale Skalierung durch die Replikation und Bereitstellung der Daten auf

verschiedenen Servern möglich ist, ermöglicht MongoDB zusätzlich die horizontale

Skalierung durch das sogenannte Sharding. Hierbei werden Collections in Teile aufgeteilt,

die dann auf verschiedenen Servern bereitgestellt werden [Redmond2012].

Als weiterer Vertreter in der Gattung dokumentbasierter Datenbanken soll hier noch Riak

erwähnt werden. In dieser Datenbank werden üblicherweise Dokumente gespeichert, diese

jedoch per Key/Value-Funktionalität in sogenannten Bucket-Namensräumen abgespeichert

und in einem Ring-Adressraum verwaltet, weshalb die Entwickler bei Riak von einer

Key/Value-Datenbank sprechen [Edlich2011]. Riak wird deswegen im nächsten Abschnitt

nochmals beschrieben.

2.2.4 Key/Value Datenbanken

Bei Key/Value handelt es sich um ein sehr einfaches Datenbankmodell. Hier werden Keys

mit Values, also jeweils einem zum Key gehörigen Wert, gepaart. Key/Value Datenbanken

sind aufgrund dieser einfachen Datenstruktur ohne Relationen leicht skalierbar. Welcher

Datentyp dabei als Value gespeichert werden kann, variiert dabei von Datenbank zu

Datenbank. Bekannte Vertreter der Key/Value Gattung sind Redis 24 sowie das bereits

erwähnte Riak25, beides Open Source-Projekte.

Redis gilt als sehr schneller Key/Value-Store, da hier alle Daten im RAM gespeichert

werden und nur von Zeit zu Zeit mit der Festplatte synchronisiert werden. Es werden die

unterschiedlichsten Datentypen angeboten, die als Werte gespeichert werden können:

Strings, Hashes, Listen, Sets und sortierte Sets. Des Weiteren werden atomische

24 http://redis.io/

25 http://basho.com/riak/

16

Operationen auf den Datenstrukturen angeboten sowie Message Queues mit publish/

subscribe-Funktionalität.

Bei Riak handelt es sich um eine sehr vielseitige Datenbank. Sie wurde mit den Zielen

Verfügbarkeit, Fehlertoleranz und Skalierbarkeit entworfen. Die eigentliche Speicherengine

ist hier austauschbar. Grundsätzlich werden in Riak Dokumente gespeichert. Diese werden

in sogenannten Bucket-Namensräumen verwaltet, in denen dann die Keys abgelegt werden.

Durch die Möglichkeit, Links zwischen den Dokumenten abzuspeichern, können mit Riak

auch Graphen- oder relationale Strukturen umgesetzt werden. Als Konsistenzmodell wird

hier BASE/Eventually Consistent angewendet und Riak bietet Map/Reduce. Wie bei

CouchDB erfolgt der Zugriff auf die Datenbank immer über REST/HTTP-Anfragen.

Einer der Unterschiede zwischen den beiden Systemen ist jedoch, dass Riak mehr auf die

Skalierung und Verteilung der Daten ausgelegt ist [Edlich2011].

2.2.5 Graphdatenbanken

Graphdatenbanken speichern untereinander vernetzte Strukturen, die aus Knoten und

ihren Verbindungen, den Kanten, bestehen. Zeichnen sich Datensätze durch eine große

Anzahl an Verlinkungen der Einheiten untereinander aus und müssen in der Anwendung

diese Datensätze oft anhand ihrer Verlinkungen durchlaufen (traversiert) werden, so ist

meist eine Graph-Datenbank eine gute Wahl. Im Web-Umfeld werden diese zum Beispiel

oft im Bereich des Social Networking verwendet.

Der wahrscheinlich bekannteste Vertreter der Fraktion der Graphdatenbanken ist Neo4j26.

Es handelt sich bei Neo4J um eine hochskalierbare und gleichzeitig leichtgewichtige Open

Source Datenbank. Als Datenmodell bietet Neo4j Knoten sowie gewichtete Kanten, wobei

beide Typen Eigenschaften in Form von beliebigen Daten annehmen können 27. Die

Datenbank bietet ACID-Konsistenz und eine eigene Query-Language namens Cypher. Der

Zugriff auf die Daten kann abgesehen von Cypher entweder per REST-Interface oder einer

objektorientierten Java-Schnittstelle erfolgen. Ein Browser-Interface mit einer komfortablen

Graph-Visualisierung ist ebenfalls bereits in die Standard-Version integriert.

Des Weiteren soll kurz erwähnt werden, dass es mit dem Tinkerpop Blueprints Projekt

eine standardisierte Open Source API für die Programmiersprache Java gibt, welche einen

einheitlichen Zugriff auf Graph-Datenbanken ermöglicht und die von vielen

Graphdatenbanken, darunter auch Neo4J 28, implementiert wird. Neo4J bietet damit zwei

26 http://www.neo4j.org/

27 Das sich hier hinter verbergende Modell wird auch „Property Graph“ genannt.

28 https://github.com/tinkerpop/blueprints/wiki/Neo4j-Implementation

17

Query-Languages, das bereits erwähnte Cypher, sowie die Abfragesprache Gremlin, die Teil

von Tinkerpop Blueprints ist. Cypher weist dabei eher Ähnlichkeiten mit SQL auf,

während Gremlin mit seinem Collection-orientierten Zugriff Ähnlichkeiten zum DOMZugriff in jQuery aufweist [Redmond2012].

2.2.6 Wide Column Stores

Eine weitere Gruppe im NoSQL-Bereich sind die Wide Column Stores. Diese ähneln den

relationalen Datenbanken. Die Daten werden hier ebenfalls in Tabellen gespeichert, jedoch

anders als in relationalen Datenbanken ist die Speicherung nicht zeilen- sondern

spaltenorientiert. Das bedeutet, dass physisch auf dem Speichermedium nicht die

Datensätze (oder Tupel) hintereinander gespeichert werden, sondern die Attribute einer

Spalte. Dies bietet Vorteile bei der Analyse der Daten, bei der Datenkompression

[Edlich2011] und lässt außerdem zu, dass kein Speicherplatz verschwendet wird, sollten

nicht alle Spalten einer Datenbankzeile mit Werten belegt sein. Weiterhin ist das

Hinzufügen von Spalten wesentlich zeitefzienter als bei zeilenorientierten Datenbanken.

Es gibt aber auch Nachteile. Hierzu zählen der größere Aufwand beim Suchen und

Einfügen von Daten sowie beim Lesen von zusammengehörigen Datensätzen.

Die drei bekanntesten Vertreter der Gattung der spaltenorientierten Datenbanken sind

HBase, Cassandra und Hypertable (hier stimmen [Redmond2012] und [Edlich2011]

überein). Diese Datenbanken orientieren sich allesamt an Googles BigTable 29, weichen

jedoch von der oben beschriebenen Idee etwas ab und bieten eine Art Kombination aus

spaltenorientiertem Design in Verbindung mit Key/Value-Funktionalitäten. Durch den

Einsatz von mehrdimensionalen Tabellen in Kombination mit einer guten Skalierbarkeit

eignen sich diese Datenbanken sehr gut für besonders große Datenmengen.

Wide Column Stores spielen für diese Bachelorarbeit keine besondere Rolle und wurden

deshalb nur der Vollständigkeit halber erwähnt.

2.2.7 Multimodel-Datenbanken

Multimodel-Datenbanken vereinen die Konzepte vieler NoSQL-Datenbanken in einem

System. Neben der Datenbank ArangoDB, die später näher untersucht wird, ist

OrientDB30 ein Vertreter dieser Gattung. Bei OrientDB handelt es sich um eine Open

Source Datenbank, deren Basis eine Dokument-Datenbank ist. Diese wurde jedoch um

Graphen-Funktionalitäten erweitert und so lassen sich genau wie bei Riak in den

Dokumenten auch Links zu anderen Dokumenten abspeichern. OrientDB unterstützt

29 http://de.wikipedia.org/wiki/BigTable

30 http://www.orientdb.org/

18

Tinkerpop Blueprints und somit ist auch die Graphen-Traversierung mittels Gremlin

möglich. Der allgemeine Zugriff ist mittels einer erweiterten Untermenge von SQL als

Abfragesprache, über die native Java-API, sowie über eine REST/HTTP-Schnittstelle

möglich. Weiterhin verfügt OrientDB über ein umfangreiches Rechtemanagement für

Benutzer, es werden ACID-Transaktionen unterstützt und Dokumente können sowohl mit

als auch ohne Schemata benutzt werden sowie zusätzlich in einem gemischten Modus.

Zum Abschluss soll hier erwähnt werden, dass auch die Datenbank Riak über Merkmale

einer Multimodel-Datenbank verfügt. Genau wie in OrientDB werden bei Riak die Daten

in Dokumenten gespeichert und diese können zusätzlich über Verlinkungen verfügen. Riak

unterstützt zwar nicht wie OrientDB die Tinkerpop Graph-API zur Traversierung, es lassen

sich aber sehr wohl Graphen-Strukturen hiermit abbilden. OrientDB kann außerdem

ebenso wie Riak, das in erster Linie als Key/Value-Datenbank gilt, als Key/ValueDatenbank verwendet werden31.

2.2.8 Zusammenfassung

Man sieht, dass die Grenzen bei den Datenmodellen der NoSQL-Datenbanken teilweise

fießend sind und es einige Mischformen gibt, bzw. Aspekte von NoSQL-„Genres“ in

andere übernommen werden. Je nach Anwendungsbereich ist ein bestimmtes Datenmodell

besonders passend. Bei komplexen Anwendungen mit unterschiedlichen Anforderungen

bietet sich die Verwendung mehrerer unterschiedlicher Datenbanktypen nach dem Konzept

der „Polyglot Persistence“ an. In anderen Anwendungsbereichen macht dagegen eher die

Verwendung einer Multimodel-Datenbank Sinn, die die Konzepte mehrerer Typen vereint.

Zu diesem Typ zählt auch die Datenbank ArangoDB, die Gegenstand dieser Arbeit ist.

ArangoDB wird in Abschnitt 2.4 näher erläutert. In Abschnitt 4.4 werden außerdem einige

Clojure Treiber für die bisher vorgestellten NoSQL-Datenbanken verglichen und

untersucht.

31 Vgl. https://github.com/orientechnologies/orientdb/wiki/Key-Value-engine

19

2.3 REST und HTTP

2.3.1 REST Einführung

REST steht für REpresentational State Transfer und ist ein Entwurfsmuster, welches ein

verteiltes System bestehend aus Client und Server extrem skalierbar macht. Als

grundlegende Architektur des Web machte REST dessen enormes Wachstum und dessen

enormen Erfolg erst möglich. Dennoch bietet REST einen hohen Grad von Anpassbarkeit

und lässt Kompromisse zu [Tilkov2009]. Das REST-Prinzip wurde von Roy Thomas

Fielding, der vorher bereits das Protokoll HTTP mitentwickelt hatte 32, in dessen

Dissertation „Architectural Styles and the Design of Network-based Software Architectures“

beschrieben [Fielding2000].

Nach [Tilkov2009] lässt sich REST auf fünf Grundprinzipien reduzieren:

–

Ressourcen mit eindeutiger Identifikation

→ lesbare und manipulierbare Einheiten, die mittels global gültiger und eindeutiger Adressen

(URIs) identifziert werden

–

Unterschiedliche Repräsentationen

→ die Einheiten sind nach außen nur durch ihre Repräsentationen sichtbar und

manipulierbar; für jede Ressource kann es eine Vielzahl an Repräsentationen geben

–

Verknüpfungen/Hypermedia

→ Benutzung von Hypertext33 zur Verknüpfung von Inhalten untereinander

–

Standardmethoden

→ ein Satz von Methoden, der auf alle Ressourcen angewendet werden kann, bildet eine

einheitliche Schnittstelle

–

Statuslose Kommunikation

→ die Verantwortung für die Verwaltung des Applikationsstatus liegt beim Client, dadurch

wird das System deutlich vereinfacht

Bis in die 90er Jahre wurde das World Wide Web vor allem benutzt, um statische

Dokumente abzurufen. Vor allem mit dem Aufkommen vieler dynamischer Websites wurde

der Bedarf nach einer grundsätzlichen Theorie, einem theoretischen Fundament, das dem

World Wide Web zugrunde liegt, immer größer [Tilkov2009]. Roy Fielding hat mit REST

ein einheitliches Konzept für statische und dynamische Inhalte geschaffen: die Ressource.

32 Vgl. [wwwHTTP1999]

33 Die Begriffe Hypertex und Hypermedia werden oft synonym verwendet. Siehe dazu auch

http://de.wikipedia.org/wiki/Hypermedia

20

Im Zusammenhang mit REST spricht man daher auch von einer Ressourcen-orientierten

Architektur (ROA).34

2.3.2 Ressourcen und Repräsentationen

Bei einer Ressource handelt es sich um ein abstraktes Konzept für eine Einheit oder ein

Objekt. Laut [Richardson2007] ist eine Ressource „alles, was wichtig genug ist, um als

eigenständiges Etwas referenziert zu werden“. Möchte ein Nutzer Informationen über eine

Einheit abrufen, Änderungen an ihr vornehmen oder einen Hypertext-Verweis darauf

weiterleiten, sind dies Argumente dafür, etwas als Ressource zu identifizieren. Eine

Ressource kann dabei sowohl ein Dokument sein, ein reales physikalisches Objekt, ein

Eintrag in einer Datenbank (der wiederum die beiden vorgenannten Beispiele abbilden

könnte) oder auch eine Aufistung anderer Ressourcen.

Ressourcen als solche sind nach außen nicht sichtbar. Sichtbar sind stattdessen ihre

sogenannten Repräsentationen. Davon kann jede Ressource mehrere haben. Eine andere

Definition einer Ressource lautet daher auch: „eine durch eine gemeinsame ID

zusammengehaltene Menge von Repräsentationen“ [Tilkov2009]. Bei einer Repräsentation

kann es sich zum Beispiel um ein HTML-Dokument handeln, ein PDF-Dokument, ein

JSON-Dokument oder auch ein Bild. Repräsentationen werden auch benötigt, um

Ressourcen zu verändern; ein Beispiel hierfür könnte ein Formular sein, mit dem man die

Eigenschaften einer Ressource verändern kann.

Um Ressourcen zu identifizieren werden Uniform Resource Identifer35, kurz URIs, benutzt.

Hierbei handelt es sich um „Adressen“, welche global gültig und einzigartig sind. Jeder URI

identifiziert hierbei genau eine Ressource. Umgekehrt können aber auch mehrere URIs auf

dieselbe Ressource verweisen [wwwW3CArchitecture].

2.3.3 Die Bestandteile von REST

Bei REST handelt es sich um einen „Hybrid-Style“ für verteilte Systeme, der aus diversen

netzwerkbasierten Architekturstilen abgeleitet wurde und mit zusätzlichen Einschränkungen versehen wurde [Fielding2000]. Die wichtigsten Bestandteile sollen nun hier

kurz erläutert werden.

34 Genauer gesagt ist die ROA ein Weg, eine REST-konforme Architektur umzusetzen, da sie bereits

Gebrauch von konkreten Konzepten wie URIs und HTTP macht [Richardson2007].

35 Siehe auch http://de.wikipedia.org/wiki/Uniform_Resource_Identifier

21

Client-Cache-Stateless-Server

Ausgangspunkt bei REST ist das Client-Server Architekturmuster 36. Als nächste wichtige

Einschränkung wird festgelegt, dass die Kommunikation im System zustandslos sein soll,

womit das System das „Client-Stateless-Server“ Muster umsetzt. Diese Einschränkung

bedingt, dass jede Anfrage vom Client an den Server alle nötigen Informationen beinhalten

muss, um die Anfrage vollständig zu verstehen. Es wird somit auf dem Server kein für die

Kommunikation wichtiger Zustand gespeichert und der Client trägt die Verantwortung,

diesen zu verwalten. Durch diese Einschränkung wird das System weitaus verlässlicher und

skalierbarer. Da sich der Zustand auf dem Client befindet, können auch unterschiedliche

Server-Maschinen die Anfragen beantworten und es macht keine Probleme, sollte einer

ausfallen. Außerdem werden auf dem Server weniger Ressourcen verbraucht, wenn keine

Zustände gespeichert werden müssen und die Implementierung des Servers wird deutlich

einfacher.

Dadurch dass zusätzlich bei jeder Datenübermittlung angegeben wird, ob die Daten

cacheable37 sind, wird die Efzienz noch weiter erhöht, weil insgesamt weniger Daten

übermittelt werden müssen (wenn sich diese nicht ständig ändern). Zusätzlich wird die

Latenzzeit für viele Aktionen verringert.

Layered-System und Code-on-Demand

Zwei weitere Entwurfsmuster, die in REST mit eingefossen sind, sind das Layered-System

Muster und das Code-on-Demand Muster. Beim Layered-System Muster kann die

Architektur aus mehreren hierarchischen Ebenen bestehen, die jeweils nur Kenntnis von

einer weiteren Ebene besitzen. Mit dieser interagieren sie.

Das Code-on-Demand Muster propagiert, dass die Funktionalität des Clients dynamisch

erweitert werden kann. Zusätzlicher Code wird vom Server ausgeliefert und auf dem Client

ausgeführt. Dies gehört zu den Grundfunktionalitäten des World Wide Web, denn bei den

meisten Websites, die im Browser betrachtet werden, wird zusätzlicher Javascript Code vom

Server geladen und im Browser ausgeführt. So muss der Client von sich aus über keine

Informationen verfügen, wie er die vom Server gesendeten Daten verarbeiten kann,

sondern der Server liefert gewissermaßen die „Anleitung“ dazu gleich mit. Das gesamte

System wird dadurch sehr fexibel und beliebig erweiterbar.

Uniform Interface

REST propagiert die lose Kopplung durch eine „uniforme Schnittstelle“ [Fielding2000].

Mittels dieser können Ressourcen und deren Repräsentationen abgerufen und manipuliert

36 Siehe http://en.wikipedia.org/wiki/Client-server_model

37 Siehe http://de.wikipedia.org/wiki/Cache

22

werden. Jede Ressource muss dabei den gleichen Satz von Methoden unterstützen (daher

auch uniform = einheitlich). Durch die Nutzung dieser einheitlichen Schnittstelle werden

Abhängigkeiten vermieden und Teile des Systems leichter austauschbar, da die

Implementierung jeweils unter dem Interface verborgen ist.

2.3.4 REST, HTTP und die HTTP-Methoden

Bei der Entwicklung von REST wurden die Aspekte der Implementierung ausgeblendet

und stattdessen der Blick vollständig auf das System und dessen Eigenschaften als Ganzes

konzentriert. In der Praxis tritt REST meist im Zusammenhang mit dem Protokoll HTTP

auf38. HTTP bietet eine Schnittstelle um das REST Paradigma anzuwenden.

Vielen ist HTTP nur als einfaches Protokoll zum Abrufen von Websites bekannt. In

Wahrheit verfügt HTTP jedoch über mehr Fähigkeiten. Das Protokoll bietet eine Anzahl

von Operationen, die auch als Verben bezeichnet werden und für alle Ressourcen

gleichermaßen gültig sein sollen. Man spricht daher von der bereits erwähnten „uniformen“

Schnittstelle. Über diese Verben soll nun ein kurzer Überblick gegeben werden.

GET

GET ist die grundlegende und am häufigsten verwendete Operation von HTTP. Sie wird

bei jeder Anfrage eines Webbrowsers nach einer Website, also einem HTML-Dokument,

benutzt. Allgemeiner gesagt fragt sie eine Repräsentation einer Ressource ab. REST folgend

müssen GET Anfragen vom Client beliebig wiederholt werden können ohne eine

Änderung am Zustand des Servers hervorzurufen. Man sagt deshalb, dass die Methode

sicher (safe) ist. Der Client fordert keine Änderung am Zustand des Servers an und geht

somit auch keine Verpfichtungen ein. Ein Seiteneffekt in Form zum Beispiel eines Eintrags

in eine Logdatei auf dem Server ist jedoch durchaus möglich [Tilkov2009]. Selbst

Webanwendungen, die nicht das komplette REST Paradigma implementieren wollen,

sollten sich an diese Regel halten, sonst könnten zum Beispiel schon einfache Webcrawler

mittels Anfragen wie http://www.example.com/ressource/?action=delete große Schäden in der

Anwendung anrichten [Edlich2011].

HEAD

HEAD hat dieselben Eigenschaften wie GET, liefert aber statt der ganzen Repräsentation

nur die Metainformationen über eine Ressource zurück. Laut Spezifikation müssen genau

dieselben Daten im HTTP-Header zurück gesendet werden wie bei einer GET-Anfrage,

nur dass der üblicherweise dazugehörige Daten-Body nicht mitgesendet wird. Somit kann

38 Wie oben schon erwähnt wurde der HTTP Standard maßgeblich von Roy Fielding, dem auch REST zu

verdanken ist, mitgestaltet.

23

zum Beispiel die Existenz einer Ressource überprüft werden oder Informationen über den

Umfang einer Ressource eingeholt werden, bevor diese wirklich übertragen wird.

PUT

Im Gegensatz zur Abfrage mit GET können Ressourcen mit PUT geschrieben, das heißt

neu angelegt oder geändert werden. Ein PUT-Befehl überträgt eine neue Repräsentation

einer Ressource oder seine geänderten Eigenschaften an den Server. Die Methode ist

„idempotent“, das heißt wird der Befehl mehrere Male mit denselben Argumenten

aufgerufen, so muss dies immer zum selben Zustand auf dem Server führen.

POST

Mittels der POST Methode überträgt der Client Daten zur Verarbeitung an den Server. Die

Ergebnisse dieser Verarbeitung können zum Anlegen oder zur Änderung von Ressourcen

führen oder auch komplett seiteneffektfrei sein. POST ist damit die Methode der Wahl um

beliebige Funktionalitäten umzusetzen, die in der HTTP-Spezifikation nicht vorgesehen

sind und in denen der Client Daten an den Server senden muss. Als Alternative zur

Übertragung von Daten bietet sich noch GET an, hier müssen jedoch alle Daten komplett

im URI codiert werden. Dies kann aber zu Problemen führen und die Datenmenge ist hier

begrenzt. Weiterhin würde beispielsweise beim Ändern von Ressourcen die Einschränkung

unter Umständen nicht mehr eingehalten werden, dass GET zu keiner Änderung am

Zustand des Servers führen kann.

Im Umgang mit Ressourcen nach dem REST-Ansatz hat sich etabliert, dass zwischen den

beiden schreibenden Methoden PUT und POST folgendermaßen unterschieden wird:

POST legt neue Ressourcen an und und PUT ändert sie39. Ein grundsätzlicher Unterschied

zwischen beiden Methoden ist, dass man bei PUT die Anfrage an den URI der

anzulegenden/zu ändernden Ressource sendet, während bei POST die Anfrage an den URI

der für die Datenverarbeitung zuständigen Ressource gesendet wird. Der URI einer evtl.

neu angelegten Ressource kann dann vom Server bestimmt werden und wird im HTTPHeader der Antwort zurück gesendet. PUT eignet sich dagegen auch für das Neuanlegen

von Ressourcen unter einem durch den Client vorgegebenen URI.

PATCH

Bei PATCH handelt es sich um eine zusätzliche HTTP-Methode, die in [wwwHTTP2010]

vorgeschlagen wurde, um Ressourcen zu ergänzen bzw. teilweise zu ändern. Mit der PUTMethode wird immer die gesamte Ressource ausgetauscht; bei Ergänzungen erfordert dies

somit zunächst eine GET-Anfrage, um den aktuellen Stand der Ressource zu erfragen.

39 Vgl. z.B. Ruby on Rails Guides: http://guides.rubyonrails.org/routing.html#crud-verbs-and-actions

24

Diese Anfrage erspart man sich mit PUT, da man direkt Ergänzungen vornehmen kann

ohne die Ressource als Ganzes übersenden zu müssen. Des Weiteren ist die Gefahr geringer,

dass Änderungen verloren gehen, sollten mehrere Änderungen in einem kurzen Zeitraum

gesendet werden.40

DELETE

Wie der Name schon verrät, bewirkt DELETE die Löschung von Ressourcen. DELETE ist

genau wie PUT idempotent, denn da eine Ressource nur einmal gelöscht werden kann,

führen mehrere Aufrufe auf derselben Ressource zum gleichen Zustand auf dem Server.

TRACE, OPTIONS und CONNECT

Es gibt in der HTTP Spezifikation noch drei weitere Methoden: TRACE, OPTIONS und

CONNECT. Diese spielen jedoch keine wesentliche Rolle für Webanwendungen nach dem

REST-Prinzip. Sie sollen jedoch trotzdem hier kurz erwähnt werden: Mit der OPTIONS

Methode können Metadaten über eine Ressource angefordert werden, unter anderem

darüber, welche der HTTP-Methoden von ihr unterstützt werden. TRACE dient zur

Diagnose von HTTP-Verbindungen und liefert die Anfrage genau so zurück, wie sie vom

Server empfangen wurde. So kann festgestellt werden, ob sie eventuell auf dem Weg

verändert worden ist. CONNECT dient zur Initiierung einer Proxy-Verbindung durch

einen SSL-Tunnel.

2.3.5 HTTP-Header

Außer der HTTP-Methode, dem URI und dem Datenteil (Body) bestehen HTTPAnfragen und Antworten noch aus dem weiter oben bereits erwähnten Header. Hier

können Metainformationen in Form von Schlüssel/Wert-Paaren übergeben werden. Diese

Paare können beliebig sein, die meisten Headerfelder sind jedoch standardisiert

([wwwHTTP1999] und [wwwHTTP2005]). Sie erlauben zum Beispiel Angaben über

akzeptierte Antwortformate (Accept)41, über akzeptierte Sprachen der Antwort (AcceptLanguage) oder die Steuerung des Caching-Verhaltens, das zum Beispiel auch ganz verboten

werden kann (Cache-Control: no-cache). Einige Parameter werden genutzt um konditionale

GET-Anfragen zu senden, so wird einem Server zum Beispiel mittels des Headerfeldes IfModifed-Since erlaubt, bei unveränderten Daten nur einen Header mit dem Statuscode

304 (Not Modified)42 und ohne Daten zurückzusenden. So kann das unnötige Senden von

40 Siehe auch: http://www.mnot.net/blog/2012/09/05/patch

41 Um wieder den Bogen zum Konzept der Ressource zu schlagen kann man die Accept-Angabe auch so

sehen: Der Client entscheidet über die Art von Repräsentation(en), die er von der adressierten

Ressource zugesendet bekommen möchte. Dies kann aber auch schon durch den URI festgelegt sein,

wenn dieser z.B. eine Dateiendung wie .html enthält.

42 Weitere Informationen zu den Statuscodes finden sich unter http://de.wikipedia.org/wiki/HTTPStatuscode

25

großen Datenmengen vermieden werden, wenn sich nichts an der Repräsentation geändert

hat.

2.3.6 REST und NoSQL

Viele NoSQL Datenbanken, darunter auch ArangoDB, bieten REST/HTTP-Schnittstellen

zur Interaktion mit der Datenbank. Einige NoSQL Datenbanken verfolgen sogar intern

einen REST-Entwurfsansatz. Von den in Abschnitt 2.2 vorgestellten Datenbanken zählen

hierzu CouchDB, Riak und Neo4J. Bei allen diesen Datenbanken läuft der primäre ClientZugriff über REST/HTTP-Anfragen. Bei CouchDB und Neo4J gibt es dazu, ebenso wie

bei ArangoDB, ein integriertes Browser-Interface zur Verwaltung der Datenbank, welches

ebenfalls von der HTTP-Schnittstelle Gebrauch macht.43

Im nächsten Abschnitt wird nun näher auf die Datenbank ArangoDB eingegangen, die

Gegenstand dieser Arbeit ist. Neben einer grundlegenden Beschreibung ihrer Eigenschaften

wird auch ihre REST/HTTP-Schnittstelle näher untersucht.

43 Bei Riak sind ebenfalls Browser-Interfaces verfügbar, allerdings nur als Community-Projekte, die

nicht standardmäßig mitgeliefert werden.

26

2.4 ArangoDB

Bei ArangoDB handelt es sich um eine Multimodel Open Source NoSQL-Datenbank. Die

Datenbank unterstützt die Datenmodelle Dokumente, Key/Value und Graphen. Es handelt

sich somit um eine Art Mischung aus den in Abschnitt 2.2 vorgestellten Datenbanktypen.

Das Projekt ArangoDB wurde im Jahr 2011 von der Firma triAGENS 44 gestartet. Im

Frühling 2012 wurde Version 1.0 veröffentlicht und die Datenbank befindet sich nach wie

vor in stetiger Weiterentwicklung, sodass allein während des Entstehens dieser Arbeit

mehrere neue Versionen veröffentlicht wurden. Die in dieser Arbeit betrachtete Version ist

1.4.* (Version 1.4.0 wurde am 30.10.2013 veröffentlicht45).

Im Folgenden sollen die Eigenschaften von ArangoDB näher untersucht werden, um eine

Einordnung in das Feld der NoSQL-Datenbanken vornehmen zu können. Es soll auch

versucht werden, Parallelen und Unterschiede zu den in Abschnitt 2.2 beschriebenen

Datenbanken aufzuzeigen. Da es sich bei ArangoDB zuallererst um eine DokumentDatenbank handelt, soll der Vergleich vor allem mit CouchDB und MongoDB erfolgen.

2.4.1 Eigenschaften und Designziele

ArangoDB wird von seinen Entwicklern als „Database for the Web“ bezeichnet und von

ihnen außerdem zu einer „zweiten Generation von NoSQL-Datenbanken“ gezählt

[wwwArangoTalk1]. Die Datenbank ist eine Art „Allzweckwaffe“, die möglichst viele

Möglichkeiten der Anpassung an die sich stetig verändernden Anforderungen einer WebAnwendung im Laufe ihrer Entwicklung bieten soll.

ArangoDB bietet unter anderem verschiedene Möglichkeiten der Skalierung, verschiedene

Konsistenzmodelle, verschiedene Möglichkeiten der Abfrage von Daten sowie verschiedene

Möglichkeiten der Indizierung von Dokumentattributen. Sollte sich beispielsweise

während der Entwicklung einer Anwendung herausstellen, dass auch die Möglichkeit des

Durchsuchens von Datensätzen nach der geografischen Lage benötigt wird, kann in

ArangoDB auch eine Indizierung nach Geokoordinaten erfolgen [wwwArangoTalk2].

Ebenso sind Möglichkeiten der Datenreplikation vorhanden, es wird aber ausdrücklich

nicht versucht, eine horizontale Skalierbarkeit in Dimensionen, wie sie zum Beispiel mit

Riak oder MongoDB möglich ist, umzusetzen.46

44 http://de.triagens.com/

45 https://www.arangodb.org/2013/10/30/arangodb-1-4-0-released

46 Hier sollte aber erwähnt werden, dass ArangoDB ab Version 2 auch das sogenannte Sharding

unterstützt, womit eine horizontale Skalierung möglich wird. Siehe dazu auch Kapitel 7 „Fazit und

Ausblick“.

27

Eine der Hauptstärken von ArangoDB liegt in der Verfügbarkeit der verschiedenen

Datenmodelle. So muss nicht gleich auf eine zusätzliche Datenbank zurückgegriffen

werden, sollte sich beispielsweise während der Entwicklung einer Anwendung herausstellen,

dass nicht nur Dokumente, sondern auch Graphenstrukturen abgespeichert werden sollen.

Insbesondere bietet ArangoDB daher die Möglichkeit, das Konzept der Polyglot

Persistence mit nur einer Datenbank umzusetzen, sodass der technische Verwaltungsaufwand viel geringer ist als beim Einsatz mehrerer Datenbank-Systeme.

ArangoDB erlaubt in erweitertem Maße die Benutzung von JavaScript um mit der

Datenbank zu arbeiten, nicht nur auf der Client- sondern auch auf der Server-Seite. Hierzu

wird auf der Server-Seite von Googles JavaScript-Engine V8, die auch in Google Chrome

zum Einsatz kommt, Gebrauch gemacht. Der Kern von ArangoDB ist in C/C++ sowie

teilweise auch in JavaScript implementiert.

Der Server von ArangoDB arbeitet mit mehreren nebenläufig ausgeführten Threads und ist

für die Ausführung auf Multiprozessor-Systemen optimiert [ArangoDBBlog2]. DatenbankAnfragen können somit von mehreren Threads gleichzeitig bearbeitet werden. ArangoDB

unterstützt „blocking“ und „non-blocking“ Requests. Bei der optionalen Nutzung von

non-blocking Requests werden die Requests auf dem Server in einer Queue gespeichert; der

Client muss dann nicht auf eine Antwort des Servers warten, sondern kann gleich weitere

Anfragen schicken.

Eine Besonderheit von ArangoDB sind die sogenannten „schema-free Schemata“.

Gleichartige Dokumente in einer Collection werden von ArangoDB automatisch erkannt

und platzefzient abgespeichert. Gleichzeitig hat man weiterhin die Freiheit, komplett

schemafrei zu arbeiten [ArangoDBBlog1]. Bei diesem Ansatz werden die Vorteile der

Schemafreiheit einer Dokumenten-Datenbank kombiniert mit den Vorteilen von

Schemata, wie sie aus relationalen Systemen bekannt sind.

2.4.2 Speichereffizienz und Performance

ArangoDBs Design ist laut seiner Entwickler nicht auf Performance ausgelegt, sondern auf

vielseitige Anwendungsmöglichkeiten. Trotzdem erhält die Datenbank bei Performanceund Speicherverbrauchs-Vergleichen mit anderen Datenbanken durchaus gute Werte.

Laut den Tests in [wwwArangoBlog3] verbraucht ArangoDB bei einer großen Anzahl an

Datensätzen in der Datenbank durchweg weniger Speicherplatz als MongoDB. Dies ist

wohl vor allem der impliziten Schema-Erkennung (schema-free Schemata) bei ArangoDB

28

zu verdanken. Bei MongoDB und CouchDB werden die Strukturinformationen für jedes

Dokument redundant abgespeichert, während bei ArangoDB die Struktur bei gleich

aufgebauten Dokumenten automatisch erkannt wird und pro Collection nur einmal

gespeichert werden muss. Bei CouchDB ist dagegen aber eine Kompression der Daten

möglich, womit der benötigte Speicherplatz auch teilweise unter dem Niveau von

ArangoDB liegen kann.

Da bei ArangoDB alle Kommunikation zwischen Server und Client über HTTP-Requests

läuft, ist die Geschwindigkeit des HTTP-Layers der Datenbank von entscheidender

Wichtigkeit für die Gesamt-Performance der Datenbank. In [wwwArangoBlog4] wurde die

HTTP-Performance von ArangoDB in einigen Benchmark-Tests mit der einiger gängiger

Webserver verglichen47. Es zeigte sich, dass die Performance von ArangoDB im FileserverModus mit der gängiger Webserver mithalten kann. In Testfällen mit einer sehr hohen

Anzahl an gleichzeitig geöffneten Client-Verbindungen schlägt die Performance von

ArangoDB sogar die der anderen Webserver. Der die Performance betreffende nächste

„Konkurrent“ war hierbei der Webserver nginx, der bei wenigen gleichzeitig geöffneten

Verbindungen teilweise mehr Anfragen pro Sekunde beantworten konnte.

Die HTTP-Performance von ArangoDB kann außerdem noch verbessert werden durch die

Nutzung von Batch-Requests. Hierbei werden mehrere Datenbank-Anfragen im Body

einer HTTP-Anfrage übermittelt. Laut [wwwArangoBlog5] kann dadurch die benötigte

Zeit für das Einfügen und Ändern von Dokumenten um 80% reduziert werden 48. Im

Vergleich mit MongoDB liegt die Performance von ArangoDB bei Batch-Requests meist

nah an der von MongoDB; wobei ArangoDB bei großen Datensätzen auch schneller sein

kann als MongoDB. Die Bearbeitungszeit von Batch-Requests bei CouchDB betrug in

vielen Tests ein Vielfaches derer von ArangoDB und MongoDB [wwwArangoBlog6].49

2.4.3 Concurrency, Transaktionen, Skalierbarkeit und Replikation

Als Concurrency-Control Strategie kommt bei ArangoDB Append-Only/MVCC (letzteres

steht für „Multi-Version-Concurrency-Control“) zum Einsatz. Hierbei wird ein Dokument

bei einem Schreibvorgang nicht blockiert, sondern eine neue Version des Dokumentes

47 Hierbei handelte es sich ausdrücklich nur um vergleichende Tests, d.h. es bestand kein Interesse, die

absolute Performance der Produkte zu messen.

48 Dies ist jedoch abhängig vom Use-Case. Es ergeben sich vor allem Vorteile wenn eine größere Anzahl

an Requests mit jeweils wenig Daten gesendet werden.

49 Zu beachten ist hier einerseits, dass MongoDB nicht mit dem HTTP-Protokoll, sondern mit einem

binären Protokoll arbeitet, was der Datenbank einen initialen Performance-Vorsprung gibt;

Andererseits, dass in den Tests die Daten-Kompression bei CouchDB ausgeschaltet war, um die

Performance zu erhöhen, womit dann gleichzeitig die Vorteile des niedrigen Speicherverbrauchs von

CouchDB verloren gingen.

29

inklusive einer Versionsnummer erzeugt. So kann ein Lesezugriff zu jeder Zeit erfolgen,

auch wenn das Dokument gerade geändert wird. Ältere Versionen des Dokumentes werden

dann von einem Garbage-Collection Prozess regelmäßig gelöscht [ArangoDBBlog2]. Bei

ArangoDB sind hierdurch auch konditionale Schreibvorgänge möglich, wie zum Beispiel

„ändere ein Dokument nur, wenn die letzte Version die Versionsnummer 123456 hat“.

Dieses Vorgehen entspricht in etwa der Strategie bei CouchDB. Hier können im Gegensatz

zu ArangoDB jedoch auch mehrere konkurrierende Schreibvorgänge gleichzeitig

durchgeführt werden; eventuell entstehende Konfikte werden dann in einem MergeProzess beseitigt [Edlich2011].

Der MVCC-Ansatz erinnert zudem auch an die Concurrency-Strategie von Clojure. Hier

gibt es unveränderliche Datenstrukturen, die nur durch das Erstellen einer neuen,

aktualisierten Version „geändert“ werden können. Hierdurch wird ein sicheres

nebenläufiges Arbeiten möglich. Nicht mehr benötigte ältere Versionen der Daten werden

daraufhin von der Garbage-Collection50 der Java Virtual Machine gelöscht.

Seit Version 1.3 unterstützt ArangoDB zusätzlich auch ACID-Transaktionen. ACID steht

für „Atomic, Consistent, Isolated, and Durable“. Dies bedeutet, dass jede Transaktion

entweder vollständig ausgeführt wird oder gar keinen Effekt hat. Erst bei einem

erfolgreichen Abschluss einer Transaktion wird das Ergebnis nach außen sichtbar und dann

persistent abgespeichert. Bei ArangoDB werden die Transaktionen als Ganzes an den Server

geschickt, dort ausgeführt und anschließend eine Meldung an den Client über Erfolg oder

Misserfolg der Transaktion gesendet. Dieses Vorgehen unterscheidet sich von Transaktionen

in SQL, wo auch während einer Transaktion Kommunikation zwischen Client und Server

stattfinden kann [wwwArangoFAQ].

ArangoDB wird von seinen Entwicklern auch als „mostly-memory database“ bezeichnet.

Damit gemeint ist, dass die Performance besonders gut ist, wenn die gesamten Daten in

den RAM der ausführenden Maschine passen und die Datenbank nicht gezwungen ist,

Daten zwischen RAM und Festplatte hin- und her zu kopieren [wwwArangoFAQ].

Um die Festplatten-Synchronisation zu kontrollieren, bietet ArangoDB die zwei

Optionen „eventual“ und „immediate“. Diese beiden Optionen können jeweils pro

Collection dauerhaft konfiguriert werden, sowie auch bei jeder Aktion individuell. Bei

„immediate“ wird die Änderung sofort nicht nur im RAM gespeichert, sondern auch auf

der Festplatte gesichert. Erst wenn dies erfolgreich geschehen ist, sendet der Server eine

50 Vgl. http://en.wikipedia.org/wiki/Garbage_collection_(computer_science)

30

Antwort an den Client. Bei „eventual“ wird dagegen die Änderung zunächst nur im RAM

durchgeführt. Die Synchronisation mit der Festplatte erfolgt dann erst später im

Hintergrund. Insgesamt bedeutet dies einen Gewinn an Geschwindigkeit, da weniger

System-Anfragen durchgeführt werden. Dieses Vorgehen kann jedoch auch zu

Datenverlusten führen, sollte es beispielsweise zu einem Absturz des Systems kommen

[wwwArangoFAQ].

Als Strategie für die Replikation bietet ArangoDB die sogenannte asynchrone

Master/Slave-Replikation. Hierbei können die Datenbanken jeweils als Master oder als

Slave konfiguriert werden. Der Client kann dann Leseanfragen an alle Datenbanken

senden, Schreibanfragen jedoch nur an den Master. Änderungen am Master können

daraufhin von den Slaves aus dessen Log gelesen werden und jeweils auf die eigenen Daten

angewendet werden. Die Daten sind somit „eventual consistent“ [wwwArangoManRep].

Der Gewinn bei der Master/Slave-Replikation liegt in der „Lese-Skalierung“ und außerdem

in der Möglichkeit von „Hot Backups“. Es sollen aber laut der Entwickler bei ArangoDB

bewusst keine Features für unbegrenztes horizontales Skalieren umgesetzt werden. Generell

ist die Datenbank dafür konzipiert, dass alle Daten auf einen Server passen. In der

Abwägung zwischen Skalierbarkeit und guten Abfragemöglichkeiten geht ArangoDBs

Design eher in Richtung der Abfragemöglichkeiten. Diese Entscheidung steht im

Gegensatz beispielsweise zum Design von Riak, dessen Abfragemöglichkeiten nicht sehr

umfangreich sind (Key/Value, Volltext-Suche und Map/Reduce). Dafür ist die Datenbank

aber hochskalierbar.

2.4.4 ArangoDBs HTTP/REST-Interface

ArangoDB kommuniziert mit der Außenwelt, das heißt mit allen Clients, durch sein

HTTP-Interface. Dieses unterstützt die HTTP-Methoden GET, POST, PUT, DELETE

und PATCH sowie die HTTP-Versionen 1.0 und 1.1, wobei Antworten vom Server jedoch

immer in Version 1.1 erfolgen. Daten werden im Body des HTTP-Requests im JSONFormat an den Server gesendet und werden ebenfalls ausschließlich als JSON von diesem

zurückgegeben. Des Weiteren werden sowohl Standard- als auch einige Custom-Header

Parameter sowie einzelne Parameter auch als URI-Parameter unterstützt.

2.4.5 Datenbanken, Collections, Dokumente und Graphen in ArangoDB

Im Folgenden sollen kurz die Eigenschaften der in ArangoDB vorhandenen Datenstrukturen zur Organisation von Daten erläutert werden.

31

Datenbanken

Datenbanken stellen in ArangoDB die oberste Hierarchieebene zur Organisation von

Daten dar. Jeder ArangoDB Server kann mehrere Datenbanken enthalten, wobei immer

mindestens eine Datenbank namens _system vorhanden ist, die „System-Datenbank“