Von der flachen Erde bis zum Urknall

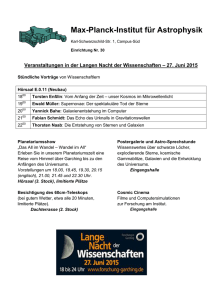

Werbung