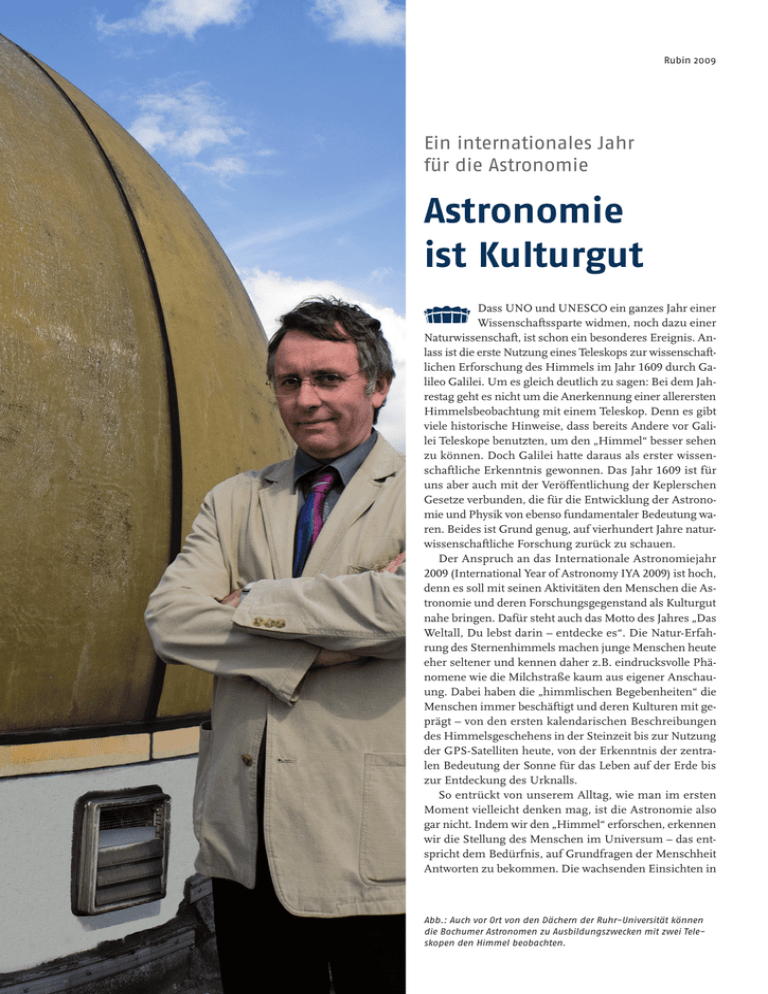

Astronomie ist Kulturgut - Rubin - Ruhr

Werbung