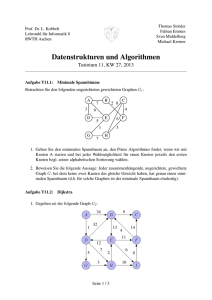

Algorithmen und Berechnungskomplexitaet I

Werbung