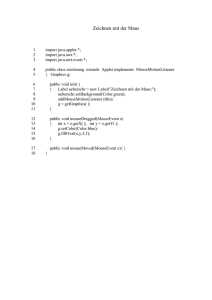

XML based Billing Agent for public WLANs

Werbung