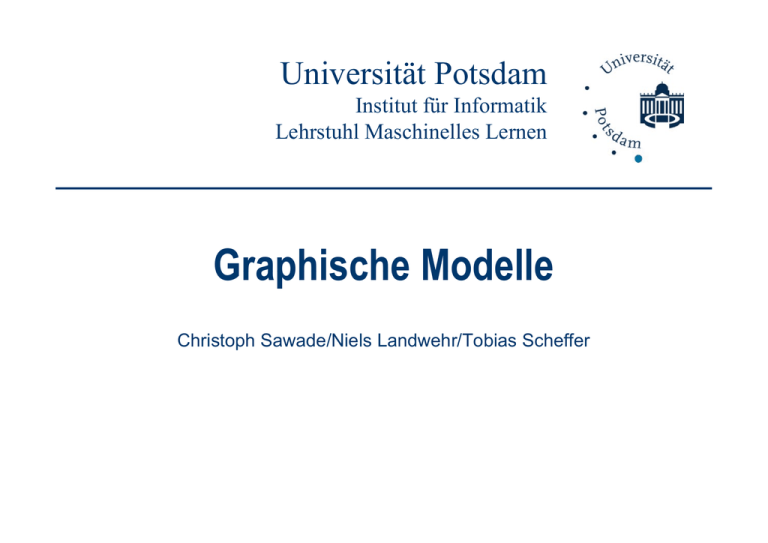

X - Institut für Informatik

Werbung

Universität Potsdam

Institut für Informatik

Lehrstuhl Maschinelles Lernen

Graphische Modelle

Christoph Sawade/Niels Landwehr/Tobias Scheffer

Graphische Modelle

Modellierung einer Domäne mit verschiedenen

Zufallsgrössen

Gemeinsame Verteilung, insb. Abhängigkeiten

Sa

awade/Landwehr/Sccheffer, Maschinelle

es Lernen II

2

Überblick

Gerichtete Graphische Modelle: Bayessche Netze

Graphische Modelle im Maschinellen Lernen

Inferenz in Graphischen Modellen

Ungerichtete Graphische Modelle: Markov Netze

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

3

Überblick

Gerichtete Graphische Modelle: Bayessche Netze

Graphische Modelle im Maschinellen Lernen

Inferenz in Graphischen Modellen

Ungerichtete Graphische Modelle: Markov Netze

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

4

Zufallsvariablen Verteilungen

Zufallsvariablen,

Zufallsvariable: Abbildung eines Ereignisses auf reelle Zahl

X :

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Raum der Elementarereignisse

Verteilung über ZV: wie wahrscheinlich, bestimmte Werte zu

beobachten?

Diskrete Zufallsvariablen: diskreter Wertebereich (z.B.

Münzwurf)

Diskrete Wahrscheinlichkeit p ( x) [0,1],

p( x)=1

x Wert der ZV

x

Kontinuierliche Zufallsvariablen: kontinuierlicher

Wertebereich (z.B. Körpergröße)

Di ht f kti p( x) 0 ,

Dichtefunktion

d 1

p( x)dx

x Wert der

d ZV

5

Zufallsvariablen Verteilungen

Zufallsvariablen,

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B i i l fü

Beispiele

für di

diskrete/kontinuierliche

k t /k ti i li h Verteilungen

V t il

Bernoulli-Verteilung: binäre ZV X {0,1}

Parameter p ( X 1| )

X ~ Bern( X | ) X (1 )1 X

Normalverteilung: kontinuierliche ZV X

N ( x | , 2 )

1

2

exp

2 (x )

2 1/2

(2 )

2

1

Mittelwert

Standardabweichung

6

Zufallsvariablen Verteilungen

Zufallsvariablen,

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Z

Zusammenhang

h

Di

Dichte/Wahrscheinlichkeit

ht /W h h i li hk it

p ( X [ x , x ])

x

p( z )dz

x

p ( X [ x , x ]) ist

(diskrete) Wahrscheinlichkeit

Oftt abstrahieren

O

abst a e e wir vom

o Typ

yp de

der Zufallsvariable

u a s a ab e

Rechenregeln sind im Wesentlichen gleich für

diskrete/kontinuierliche Variablen („ersetze Summe

durch Integral“)

Integral )

Grundlegende Begriffe wie Abhängigkeit,

Erwartungswert, Varianz sind auf beide Typen von

Variablen anwendbar

7

Gemeinsame Verteilung,

g bedingte

g

V t il

Verteilung

G

Gemeinsame

i

V

Verteilung

t il

p(X,Y) über

üb ZV X,Y

p ( x, y ) [0,1],

p ( x, y ) 1

p ( x, y ) 0 ,

x, y

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

p( x, y)dxdy 1

Bedingte Verteilung

p( X | Y )

p( X , Y )

p (Y )

diskret oder kontinuierlich

Für p ( y ) 0 ist p ( X | y ) wieder eine Verteilung über X :

p( x | y) 1 für p( y) 0 (diskret)

x

p( x | y)dx 1 für p( y) 0

(kontinuierlich)

8

Unabhängigkeit von Zufallsvariablen

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Unabhängigkeit (diskret

(

oder kontinuierlich))

X,Y unabhängig genau dann wenn p ( X , Y ) p ( X ) p (Y )

X Y unabhängig

X,Y

bhä i genau dann

d

wenn p ( X | Y ) p ( X )

X,Y unabhängig genau dann wenn p (Y | X ) p (Y )

Bedingte Unabhängigkeit (diskret oder kontinuierlich)

X,Y unabhängig gegeben Z genau dann wenn p ( X , Y | Z ) p ( X | Z ) p (Y | Z )

X,Y unabhängig gegeben Z genau dann wenn p (Y | X , Z ) p (Y | Z )

X,Y unabhängig gegeben Z genau dann wenn p ( X | Y , Z ) p ( X | Z )

... einfach Anwendung des Unabhängigkeitsbegriffs auf die

bedingte gemeinsame Verteilung p(X,Y|Z)

9

Rechenregeln Verteilungen

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Rechenregeln Wahrscheinlichkeiten/Verteilungen

/

Summenregel

p ( x ) p ( x, y )

diskrete Verteilungen

y

p ( x)

p( x, y)dyy

kontinuierliche Verteilungen

g

p( X ) heisst auch Randverteilung, Marginalverteilung

Produktregel

p( X , Y ) p ( X | Y ) p(Y )

diskret oder kontinuierlich

Wahrscheinlichkeitsrechnungen beruhen auf

Anwendungen dieser beiden Regeln

10

Graphische Modelle: Idee/Ziel

Ziel: Modellierung der gemeinsame Verteilung

p(X1,…,XN) einer Menge von ZV X1,…,XN

Aus p(X1,…,XN) lassen sich berechnen…

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Alle Randverteilungen (Summenregel)

p( X i1 ,..., X im ), {i1 ,..., im } {1,..., N }

Alle bedingten Verteilungen (aus Randverteilungen)

p( X i1 ,..., X im | X im1 ,..., X imk ), {i1 ,., im k } {1,..., N }

Damit lassen sich alle probabilistischen Fragestellungen

(Inferenzprobleme) über X1,…,XN beantworten

11

Graphische Modelle: Idee/Ziel

Graphische Modelle: Kombination von

Wahrscheinlichkeitstheorie und Graphentheorie

Kompakte, intuitive Modellierung von p(X1,…,XN)

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Graphstruktur repräsentiert Abhängigkeiten zwischen

Variablen X1,…,XN

Einsicht in Struktur des Modells; einfach,

einfach Vorwissen

einzubringen

Effiziente Algorithmen für Inferenz, die Graphstruktur

ausnutzen

Viele Methoden des maschinellen Lernens lassen sich

in Form von GM darstellen

Fragestellungen wie MAP Lernen, Bayessche

Vorhersage

g lassen sich als Inferenzprobleme

p

in GM

formulieren

12

Graphische Modelle: Beispiel

Beispiel: „Alarm

Alarm“ Szenario

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Unser Haus in LA hat eine Alarmanlage.

Wir sind im Urlaub. Unser Nachbar ruft an, falls er den Alarm

hö t Wenn

hört.

W

eingebrochen

i

b h wurde,

d wollen

ll wir

i zurück

ü k kkommen.

Leider ist der Nachbar nicht immer zu Hause

Leider geht die Alarmanlage auch bei kleinen Erdbeben los

5 binäre Zufallsvariablen

B

Burglary

g y – Einbruch hat stattgefunden

g

E

Earthquake – Erdbeben hat stattgefunden

A

Alarm – Alarmanlage geht los

N

NeighborCalls – Nachbar ruft an

R

RadioReport – Bericht über Erdbeben im Radio

13

Graphische Modelle: Beispiel

Zufallsvariablen haben eine gemeinsame Verteilung

p(B,E,A,N,R). Wie angeben? Welche Abhängigkeiten

gelten?

Beispiel für Inferenzproblem: Nachbar hat angerufen

(N=1), wie wahrscheinlich ist Einbruch (B=1)?

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Hängt von verschiedenen Faktoren ab

Wie wahrscheinlich Einbruch a priori?

Wie wahrscheinlich Erdbeben a priori?

Wie wahrscheinlich, dass Alarmanlage auslöst?

…

p( B 1,

1 N 1)

(Naive) Inferenz: p( B 1| N 1)

p( N 1)

p( B 1, E, A, N 1, R)

p( B, E, A, N 1, R)

E

A

R

B

E

A

R

14

Graphische Modelle: Beispiel

Wie modellieren wir p(B,E,A,N,R)?

p(B E A N R)?

2

N

1. Versuch: vollständige Tabelle

B

E

A

N

R

P(B,E,A,N,R)

0

0

0

0

0

0.6

1

0

0

0

0

0.005

0

1

0

0

0

0.01

…

…

…

…

…

…

+Alle Verteilungen p( B, E, A, N , R)

können repräsentiert werden

- Anzahl Parameter exponentiell

- Schwierig anzugeben

2. Versuch: alles unabhängig

p( B, E, A, N , R) p( B) p( E ) p( A) p( N ) p( R)

+Anzahl Parameter linear

- Zu

Z restriktiv,

t ikti Unabhängigkeitsannahme

U bhä i k it

h erlaubt

l bt keine

k i sinnvolle

i

ll Inferenz

I f

15

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Graphische Modelle: Beispiel

Graphisches Modell: Selektive Unabhängigkeitsannahmen

Unabhängigkeitsannahmen,

durch Vorwissen motiviert

Wähle Variablenordnung: z.B. B<E<A<N<R

Produktregel:

p( B, E, A, N , R) p( B, E , A, N ) p( R | B, E, A, N )

p( B, E, A) p( N | B, E , A) p( R | B, E , A, N )

p( B, E ) p( A | B, E ) p( N | B, E, A) p( R | B, E, A, N )

p( B) p( E | B) p( A | B, E ) p( N | B, E, A) p( R | B, E, A, N )

Faktoren beschreiben die Verteilung einer Zufallsvariablen in

Abhängigkeit anderer Zufallsvariablen.

Können wir diese Faktoren vereinfachen?

Welche dieser Abhängigkeiten bestehen wirklich?

16

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Graphische Modelle: Beispiel

Zerlegung in Faktoren nach Produktregel:

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

p( B, E, A, N , R) p( B) p( E | B) p( A | B, E ) p( N | B, E, A) p( R | B, E, A, N )

Annahme bedingter Unabhängigkeiten (Entfernen von

Variablen aus Bedingungsteil)

p ( E | B) p ( E )

p( A | B, E ) p( A | B, E )

Erdbeben hängt nicht von Einbruch ab

Alarm hängt von Einbruch und Erdbeben ab

p( N | B, E, A) p( N | A)

Anruff von Nachbar hängt

g nur von Alarm ab

p( R | B, E, A, N ) p( R | E )

Nachricht im Radio hängt nur Erdbeben ab

Vereinfachte Darstellung

g der g

gemeinsamen Verteilung:

g

p( B, E, A, N , R) p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

Vereinfachte Faktoren

17

Graphische Modelle: Beispiel

P(B=1)

P(E=1)

Modellierte Verteilung:

0.1

0.2

p( B, E, A, N , R) p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

B

B

E

P(A=1|B E)

P(A=1|B,E)

0

0

0.01

0

1

0.5

1

0

0.9

1

1

0.95

E

A

E

P(R=1|E)

0

0.01

1

0.5

R

Graphisches Modell:

N

A

P(N=1|A)

0

0.1

1

07

0.7

- Jede ZV ist ein Knoten

- Für jeden Faktor der Form p( X | X1 ,..., X k )

fügen wir gerichtete Kanten von den X i zu X ein

- Modell ist parametrisiert mit den bedingten

Verteilungen

il

p( X | X1 ,..., X k )

18

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Graphisches Modell für „Alarm

Alarm“ Szenario

Graphische Modelle: Beispiel

Graphisches Modell für „Alarm

Alarm“ Szenario

Sa

awade/Landwehr/Sccheffer, Maschinelle

es Lernen II

Anzahl Parameter: O(N*2K), K= max. Anzahl von

Elternknoten

Hier 1+1+2+2+4 statt 25-1 Parameter

Gerichtete g

graphische

p

Modelle heißen auch Bayessche

y

Netze

19

Bayessche Netze: Definition

Gegeben eine Menge von ZV {X1,…,X

XN}

Ein Bayessches Netz über den ZV {X1,…,XN} ist ein

gerichteter Graph mit

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Knotenmenge X1,…,XN

Es gibt keine gerichteten Zyklen X i X i ... X i X i

K t sind

Knoten

i d mit

it parametrisierten

ti i t b

bedingten

di t V

Verteilungen

t il

p( X i | pa( X i )) assoziiert, wobei pa( X i ) { X j | X j X i } die

Menge der Elternknoten eines Knoten ist

1

2

k

1

Das Bayessche Netz modelliert eine gemeinsame

V t il

Verteilung

üb

über X1,…,X

XN durch

d h

N

p( X 1 ,..., X N ) p( X i | pa( X i ))

i1

20

Bayessche Netze: Definition

Warum muss der Graph azyklisch sein?

Satz aus der Graphentheorie:

G ist azyklisch

y

es gibt

g Ordnung

g G der Knoten,, so dass ggerichtete Kanten

die Ordnung respektieren (N N ' N G N ')

Damit ergibt sich

N

p( X 1 ,..., X N ) p( X i | pa( X i ))

i 1

aus Produktregel + bedingten Unabhängigkeitsannahmen

(Variablen entsprechend G umsortieren)

Gegenbeispiel (kein Bayessches Netz):

X

Y

p( X , Y ) p( X | Y ) p(Y | X )

21

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Bayessche Netze: Unabhängigkeit

Die Graphstruktur eines Bayesschen Netzes impliziert

(bedingte) Unabhängigkeiten zwischen ZV

Notation: Für Variablen X, Y, Z schreiben wir

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

X Y | Z p( X | Y , Z ) p( X | Z )

"X unabhängig von Y gegeben Z"

Erweiterung auf disjunkte Mengen A, B, C von ZV

| C p ( A | B, C ) p ( A | C )

22

Bayessche Netze: Unabhängigkeit

Welche Unabhängigkeiten der Form | C werden

durch die Graphstruktur modelliert?

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Im Prinzip auszurechnen durch Summen/Produktregel aus

der gemeinsamen Verteilung

Bei graphischen Modellen aber direkt aus der

Graphstruktur ableitbar

ableitbar→ viel einfacher

„D-separation“: Menge einfacher Regeln, nach denen sich

alle Unabhängigkeiten ableiten lassen

23

Bayessche Netze: Unabhängigkeit

D separation: Welche Unabhängigkeiten der Form | C

D-separation:

werden durch die Graphstruktur modelliert?

Wichtige Rolle spielen Pfade im Graphen, die ZV verbinden

Notation:

…

…

…

X

Y

Z

…

…

…

…

X

Y

Z

…

…

…

…

X

Y

Z

…

Pfad

Pf

d zwischen

i h X und

d Z hat

h t eine

i

„konvergierende“ Verbindung

bei Y („head to head“)

Pfad zwischen X und Z hat eine

„serielle“ Verbindung bei Y („head

to tail“)

Pfad zwischen X und Z hat eine

„divergierende“ Verbindung bei Y

(„tail-to-tail“ )

24

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Divergierende Verbindungen

N

Gemeinsame Verteilung:

E

A

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

p( B, E, A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

R

B=„Einbruch“

E=„Erdbeben“

A Al

A=„Alarm“

“

N=„Nachbar ruft an“

R=„Radio Bericht“

Betrachte Pfad A←E→R. Gilt R | ?

25

Divergierende Verbindungen

E

A

Gemeinsame Verteilung:

p( B, E, A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

R

B=„Einbruch“

E=„Erdbeben“

A Al

A=„Alarm“

“

N

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

N=„Nachbar ruft an“

R=„Radio Bericht“

Betrachte Pfad A←E→R. Gilt R | ?

Nein, p( A | R) p( A)

Intuitiv:

[Ausrechnen mit gemeinsamer Verteilung]

RadioReport wahrscheinlich Erdbeben wahrscheinlich Alarm

p( A 1| R 1) p( A 1| R 0)

ZV R beeinflusst ZV A über die divergierende Verbindung R E A

26

Divergierende Verbindungen

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

E

Gemeinsame Verteilung:

A

N

R

p( B, E , A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

beobachteter Knoten

Betrachte Pfad A←E→R. Gilt R | E ?

27

Divergierende Verbindungen

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

E

Gemeinsame Verteilung:

A

R

N

p( B, E , A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

beobachteter Knoten

Betrachte Pfad A←E→R. Gilt R | E ?

Ja, p( A | R, E ) p( A | E )

Intuitiv:

[Ausrechnen mit gemeinsamer Verteilung]

Wenn wir schon wissen, dass ein Erdbeben eingetreten ist, wird die

Wahrscheinlichkeit für Alarm nicht höher/niedriger durch RadioReport

D di

Der

divergierende

i

d Pfad

Pf d R E A wird

i d durch

d h Beobachtung

B b ht

von E blockiert

bl ki t

28

Serielle Verbindungen

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

E

Gemeinsame Verteilung:

A

R

p( B, E , A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

N

Betrachte Pfad N ← A ← B. Gilt | ?

29

Serielle Verbindungen

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

E

Gemeinsame Verteilung:

A

p( B, E , A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

R

N

Betrachte Pfad N ← A ← B. Gilt | ?

Nein, p( B | N ) p( B)

Intuitiv:

NeighborCalls wahrscheinlich Alarm wahrscheinlich Burglary

[Ausrechnen mit gemeinsamer Verteilung]

p( B 1| N 1) p( B 1| N 0)

ZV N bbeeinflusst

i fl

ZV B über

üb den

d seriellen

i ll Pfad

Pf d N A B

30

Serielle Verbindungen

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

E

Gemeinsame Verteilung:

A

N

R

p( B, E , A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

beobachteter Knoten

Betrachte Pfad N ← A ← B. Gilt | A ?

31

Serielle Verbindungen

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

E

Gemeinsame Verteilung:

A

R

N

p( B, E , A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

beobachteter Knoten

Betrachte Pfad N ← A ← B. Gilt | A ?

Ja, p( B | N , A) p( B | A)

[Ausrechnen mit gemeinsamer Verteilung]

Intuitiv:

Wenn wir schon wissen, dass der Alarm ausgelöst wurde, sinkt/steigt die

Wahrscheinlichkeit für Einbruch nicht dadurch, dass Nachbar anruft

D serielle

Der

i ll Pfad

Pf d N A B wird

i d durch

d h Beobachtung

B b h

von A blockiert.

bl ki

32

Konvergierende Verbindung

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

E

Gemeinsame Verteilung:

A

R

p( B, E , A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

N

Betrachte Pfad B → A ← E. Gilt | ?

33

Konvergierende Verbindung

E

Gemeinsame Verteilung:

A

R

p( B, E , A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

N

Betrachte Pfad B → A ← E. Gilt | ?

Ja, p( B | E ) p( B)

Intuitiv:

Einbrüche treten nicht häufiger/seltener auf an Tagen mit Erdbeben

[Ausrechnen mit gemeinsamer Verteilung]

Der konvergierende Pfad B A E ist blockiert wenn A nicht beobachtet ist

34

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

Konvergierende Verbindung

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

E

Gemeinsame Verteilung:

A

N

R

p( B, E , A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

beobachteter Knoten

Betrachte Pfad B → A ← E. Gilt | A ?

35

Konvergierende Verbindung

E

Gemeinsame Verteilung:

A

R

N

p( B, E , A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

beobachteter Knoten

Betrachte Pfad B → A ← E. Gilt | A ?

Nein, p( B | E , A) p( B | A)

Intuitiv:

Alarm wurde ausgelöst. Falls wir ein Erdbeben beobachten, erklärt das

den Alarm, Wahrscheinlichkeit für Einbruch sinkt ("explaining away").

D kkonvergierende

Der

i

d Pfad

Pf d B A E wird

i d freigegeben durch

d h Beobachtung

B b ht

von A

[Ausrechnen mit gemeinsamer Verteilung]

36

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

Konvergierende Verbindung

E

Gemeinsame Verteilung:

A

R

N

p( B, E , A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

beobachteter Knoten

Betrachte Pfad B → A ← E. Gilt | N ?

Nein, p( B | N , A) p( B | A)

Intuitiv:

NeighborCalls indirekte Beobachtung von Alarm. Erdbebenbeobachtung

erklärt den Alarm, Wahrscheinlichkeit für Einbruch sinkt ("explaining away").

Der konvergierende Pfad B A E wird freigegeben durch Beobachtung von N

[Ausrechnen mit gemeinsamer Verteilung]

37

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

Zusammenfassung Pfade

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

B

E

Gemeinsame Verteilung:

A

R

p( B, E , A, N , R)

p( B) p( E ) p( A | E, B) p( N | A) p( R | E )

N

Zusammenfassung: ein Pfad …-X-Y-Z-… ist

Blockiert bei Y , wenn

Divergierende Verbindung, und Y beobachtet, oder

Serielle Verbindung, und Y beobachtet, oder

Konvergierende Verbindung, und weder Y noch einer seiner

Nachfahren Y‘ אDescendants(Y) beobachtet

Descendants(Y)={Y‘|es gibt gerichteten Pfad von Y zu Y‘}

Sonst ist der Pfad frei bei Y

38

D-Separation: Blockierte Pfade

D-Separation basiert auf blockierten Pfaden:

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Seien X,X‘ ZV, C eine beobachtete Menge

g von ZV, X,X‘

בC

Ein ungerichteter Pfad X – X1 – … – Xn – X‘ zwischen X

und

d X‘ ist

i t bl

blockiert

ki t gegeben

b C gdw

d es einen

i

K

Knoten

t Xi

gibt so dass Pfad bei Xi blockiert ist gegeben C

Seien A,B,C

, , disjunkte

j

Mengen

g von ZV.

Definition: A und B sind d-separiert durch C gdw jeder Pfad

von einem Knoten X אA zu einem Knoten Y אB blockiert

ist gegeben C.

C

39

D-Separation: Korrektheit

Gegeben ein Bayessches Netz über {X1,…,X

XN} mit

Graphstruktur G.

Das Bayessche Netz modelliert eine Verteilung durch

N

p( X1 ,..., X N ) p( X i | pa( X i ))

i 1

abhängig von den bedingten Verteilungen p( X n | pa( X n )) .

Theorem (Korrektheit, Vollständigkeit d-separation)

p( A | B, C ) p( A | C )

Falls

F ll A,B

A B d-separiert

d

i t gegeben

b C in

i G,

G dann

d

Es gibt keine anderen Unabhängigkeiten, die für jede

p( X i | pa( X i )) g

Wahl der bedingten

g

Verteilungen

g

gelten.

40

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

D-Separation: Beispiel

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

A

B

Gilt B H | E ?

D

C

F

Gilt A H | F ?

Gilt C | ?

E

G

H

Ein Pfad …-X-Y-ZX Y Z … ist

Blockiert bei Y , wenn

Divergierende Verbindung, und Y beobachtet, oder

Serielle Verbindung, und Y beobachtet, oder

Konvergierende Verbindung, und weder Y noch einer seiner

( ) beobachtet

Nachfahren Y‘ אDescendants(Y)

Sonst ist der Pfad frei bei Y

41

D-Separation: Beispiel

D

C

F

B

E

G

Gilt B H | E ?

Ja

Gilt A H | F ?

Gilt C | ?

Nein: A D B E H

Nein: C F D B E

H

Ein Pfad …-X-Y-ZX Y Z … ist

Blockiert bei Y , wenn

Divergierende Verbindung, und Y beobachtet, oder

Serielle Verbindung, und Y beobachtet, oder

Konvergierende Verbindung, und weder Y noch einer seiner

( ) beobachtet

Nachfahren Y‘ אDescendants(Y)

Sonst ist der Pfad frei bei Y

42

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

A

Bayessche Netze: Kausalität

Oft werden Bayessche Netze so konstruiert

konstruiert, dass gerichtete

Kanten kausalen Einflüssen entsprechen

G

A

„Erdbeben

Erdbeben lösen die Alarmanlage aus

aus“

Äquivalentes Modell

G‘

E

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

E

A

„die Alarmanlage löst Erdbeben aus“

Definition: I(G) ={ (A | C ) : A und B sind d-separiert gegeben C in G}

„Alle Unabhängigkeitsannahmen, die durch G kodiert werden“

I (G) I (G ') :

Keine statistischen Gründe, eines der Modelle vorzuziehen

Kann nicht aufgrund von Daten zwischen Modellen unterscheiden

Aber „kausale“ Modelle oft besser verständlich

43

Netze Unterschiedlicher Komplexität

Komplexität: bestimmt durch Menge der Kanten im Graph

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Beeinflusst die Anzahl der Parameter im Modell. Für binäre ZV

gilt: Anzahl Parameter in O(N*2K), K max i | pa( X i ) |

Hinzufügen von Kanten: Familie der darstellbare Verteilungen

wird grösser, I(G) wird kleiner

Extremfälle: Graph ohne Kanten, (ungerichtet) vollständig

verbundener Graph

B

A

N Parameter

B

E

A

R

N

I (G) {( A | C ) : A, B, C disj. Mengen von ZV}

E

R

N

N

2 -1

1 Parameter

I (G)

44

Überblick

Gerichtete Graphische Modelle: Bayessche Netze

Graphische Modelle im Maschinellen Lernen

Inferenz in Graphischen Modellen

Ungerichtete Graphische Modelle: Markov Netze

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

45

Erinnerung: Lernproblem

Erinnerung: Lernproblem

Trainingsdaten

L (x1 , y1 ),...,

) (x N , y N )

M ti

Matrixschreibweise

h ib i

Merkmalsvektoren

X x1

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

xi m Merkmalsvektoren

yi {0,1} binäre Klassenlabel

yi reelles Label

Zugehörige Klassenlabels

x11 xN 1

... x N

x

xNm

1

N

1m

y1

y ...

y

N

Ziel: Vorhersage des Klassenlabels für Testinstanz x

x y

46

Erinnerung: Lernen

Annahme: gemeinsame Verteilung p(x,y)

p(x y) (unbekannt)

i.i.d.

Trainingsdaten ( x i , yi ) ~ p ( x, y )

Testinstanzen

(x, y ) ~ p(x, y )

Wir betrachten probabilistische Modelle

p( y| x, ) [diskriminativ]

p(x, y | ) [generativ]

A-priori

A

priori Verteilung über Modelle p( ) (bekannt)

Vorhersageproblem: MAP Lösung

* arg max p( | L)

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

y* arg max y p ( y| x,* )

Vorhersageproblem: Bayes Lösung

y* arg max y p ( y | x, L) arg max y p ( y| x, ) p ( | L)d

47

Erinnerung:

g Parameterschätzung

g

Mü

Münzwurf

f

Erinnerung: Münzwurf

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Einzelner Münzwurf Bernouilli-verteilt mit Parameter μ

X ~ Bern( X | ) X (1 )1 X

p ( X 1| ) unbekannter Parameter

Parameterschätzproblem:

Wir haben N unabhängige Münzwürfe gesehen, als

Ausprägung L

L={x

{x1,…, xN } der ZV X1,…, XN

Der echte Parameter μ ist unbekannt, wir wollen eine

Schätzung ̂ bzw. eine posterior-Verteilung p ( | L)

Bayesscher Ansatz: Posterior Prior x Likelihood

p( | L) p( L | )

p( )

posterior

likelihood

prior

48

Erinnerung:

g Parameterschätzung

g

Mü

Münzwurf

f

Prior: Beta-Verteilung

Beta Verteilung über Münzparameter μ

Beta ( | 2 2

p ( | k z ) Beta ( | k z

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

k z k 1

(1 z 1

k z

Likelihood N unabhängige Münzwürfe:

N

P ( X 1 ,..., X N | ) p ( X n | )

i.i.d.

n 1

N

Bern( X n | )

n 1

N

X n (1 )1 X n

n 1

49

Erinnerung:

g Parameterschätzung

g

Mü

Münzwurf

f

Zufallsvariablen in Münzwurfszenario sind X 1 ,..., X N ,

Gemeinsame Verteilung von Daten und Parameter

(gegeben „Hyperparameter“ k , z ): Prior x Likelihood

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

N

p k z ( X 1 ,..., X N , ) p k z ( p ( X i | )

i 1

i

Bernoulli

Darstellung als graphisches Modell:

pa ( )

pa ( X i ) {}

…

X1

X2

X3

…

XN

50

Schätzung

g eines Münzparameters

p

als

G hi h M

Graphisches

Modell

d ll

Unabhängige Münzwürfe: Darstellung als graphisches

Modell

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

…

X1

X2

X3

…

XN

D-separation

Gilt

X N X1 ,..., X N 1 |

?

51

Schätzung

g eines Münzparameters

p

als

G hi h M

Graphisches

Modell

d ll

Unabhängige Münzwürfe: Darstellung als graphisches

Modell

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

…

X1

X2

X3

…

XN

D-separation

Gilt X N X1 ,..., X N 1 | ?

Nein, Pfad durch μ ist nicht blockiert.

Intuitiv:

X 1 X 2 ... X N 1 1 Wahrscheinlich 0.5 Wahrscheinlich X N 1

Der versteckte Parameter μ koppelt ZV X1,…, XN.

Aber es gilt X N X1 ,..., X N 1 |

52

Parameterschätzung als Inferenzproblem

MAP Parameterschätzung Münzwurf

MAP-Parameterschätzung

arg max p k z ( | x1 ,..., xN )

Sa

awade/Landwehr/Sccheffer, M

Maschinelle

es Lernen II

Inferenzproblem:

p k , z ( )

…

p( X | ) X

1

X2

X3

…

XN

p( X | )

Evidenz auf den Knoten X1,…, XN

Wahrscheinlichster Zustand des Knotens μ gegeben X1,…, XN

53