Parameteranpassung mit Maximum Likelihood und Kleinsten

Werbung

Gliederung

1

Parameterschätzung

Schätzwerte

Kriterien für Schätzwerte

2

Maximum Likelihood

Idee von Maximum Likelihood

Fehlerberechnung

3

Kleinste Quadrate

Prinzip der kleinsten Quadrate

Fehlerfortpflanzung und Hypothesentest

Armin Burgmeier (KIT)

Parameteranpassung

27. November 2009

1 / 24

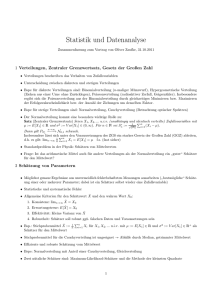

Parameterschätzung

Schätzwerte

Schätzwerte

Wahrer Wert nicht messbar, stattdessen folgen Messwerte einer

Verteilung

Schätzung eines Parameters a einer Verteilung anhand einer

Stichprobe {xi }

relative Häufigkeit

Schätzfunktion â ({xi })

80

×10-3

Beispiele:

â1 ({xi }) =

70

1

N

X

xi

i

60

â2 ({xi }) =

50

sY

N

xi

i

40

35

40

Armin Burgmeier (KIT)

45

Schuhgröße

â3 ({xi }) = median({xi })

â4 ({xi }) = max({xi })

Parameteranpassung

27. November 2009

2 / 24

Parameterschätzung

Schätzwerte

Schätzwerte

Wahrer Wert nicht messbar, stattdessen folgen Messwerte einer

Verteilung

Schätzung eines Parameters a einer Verteilung anhand einer

Stichprobe {xi }

relative Häufigkeit

Schätzfunktion â ({xi })

80

×10-3

Beispiele:

â1 ({xi }) =

70

1

N

X

xi

i

60

â2 ({xi }) =

50

sY

N

xi

i

40

35

40

Armin Burgmeier (KIT)

45

Schuhgröße

â3 ({xi }) = median({xi })

â4 ({xi }) = max({xi })

Parameteranpassung

27. November 2009

2 / 24

Parameterschätzung

Kriterien für Schätzwerte

Konsistenz

Der Schätzwert â soll sich für große Stichproben dem wahren

Wert a0 annähern

lim â ({xi }) = a0

n→∞

â1 ({xi }) =

1

N

X

xi

konsistent

xi

inkonsistent

i

â2 ({xi }) =

sY

N

i

â3 ({xi }) = median({xi })

im allgemeinen inkonsistent

â4 ({xi }) = max({xi })

inkonsistent

Armin Burgmeier (KIT)

Parameteranpassung

27. November 2009

3 / 24

Parameterschätzung

Kriterien für Schätzwerte

Erwartungstreue

Schätzwert â ist selbst Zufallsvariable: Andere Stichprobe ⇒

anderer Schätzwert

Erwartungstreu wenn Erwartungswert des Schätzwerts dem

wahren Wert entspricht

< â >= a0

Bias b =< â > −a0 kann korrigiert werden wenn bekannt

Im allgemeinen gilt nicht < â >= a0 ⇒< f (â) >= f (a0 )

Armin Burgmeier (KIT)

Parameteranpassung

27. November 2009

4 / 24

Parameterschätzung

Kriterien für Schätzwerte

Erwartungstreue: Beispiel

0.2

Moyal-Verteilung mit Mittelwert

µ = 7,5

0.1

0

0

5

10

15

20

Stichprobe aus 20

Messwerten, {xi } seien

aufsteigend sortiert

â1 ({xi }) =

0.15

0.1

â2 ({xi }) =

1

11

20

X

i=1

11

X

xi

xi

i=1

0.05

0

1

20

4

6

Armin Burgmeier (KIT)

8

10

Parameteranpassung

27. November 2009

5 / 24

Parameterschätzung

Kriterien für Schätzwerte

Effizienz

Kleine Varianz von â wünschenswert

Führt zu großer Wahrscheinlichkeit dass â nahe am

Erwartungswert liegt

Effizienz definiert als

V (âmin )

V (â)

V (âmin ) aus Maximum-Likelihood-Schätzung oder

Rao-Cramér-Frechet-Grenze.

0.15

V (â2 ) < V (â1 )

0.1

Verzerrung kann korrigiert

werden

0.05

0

4

6

Armin Burgmeier (KIT)

8

10

Parameteranpassung

27. November 2009

6 / 24

Parameterschätzung

Kriterien für Schätzwerte

Robustheit

Robustheit gegenüber Ausreißern“oder falschen

”

Voraussetzungen

Schlecht quantifizierbar

Mehr Robustheit geht meist auf Kosten der Effizienz

0.3

Beispiel: Ausreißer bei

Cauchy-Verteilung

0.2

Mittelwert nicht robust

0.1

0

Median robust; Effizienz

≈ 70%

-4

-2

0

Armin Burgmeier (KIT)

2

4

Parameteranpassung

27. November 2009

7 / 24

Maximum Likelihood

Idee von Maximum Likelihood

Idee von Maximum Likelihood

Definition

L (x|a) := f1 (x1 |a) · f2 (x2 |a) · . . . =

Y

fi (xi |a)

i

L heißt Likelihood-Funktion

L ist Wahrscheinlichkeitsdichte in x, abhängig von den zu

bestimmenden Parametern a

R

L ist nicht Wahrscheinlichkeitsdichte in a: L (x|a) da 6= 1

Suche a für den die gemessene Messwerte {xi } am

wahrscheinlichsten sind

L ({xi }|a) = Maximum

In der Praxis oft: Minimiere Log-Likelihood-Funktion

F = − (2) log L

Armin Burgmeier (KIT)

Parameteranpassung

27. November 2009

8 / 24

Maximum Likelihood

Idee von Maximum Likelihood

Beispiel zu Maximum Likelihood

Beispiel

L

Messung einer um wahren

Wert gaußverteilten Größe

2

f (x|a) = 2π1√σ exp − (x−a)

2

2σ

0.01

0.005

0

0

2

4

6

(x1 −a)2 +(x2 −a)2

2σ 2

2(x1 −a)+2(x2 −a)

−

=

2σ 2

8

a

Zwei Messungen, x1 = 3,

x2 = 5

2

+(x2 −a)2

L ∝ exp − (x1 −a) 2σ

2

F =C+

∂F

∂a

=

Armin Burgmeier (KIT)

0 wenn a =

Parameteranpassung

x1+x2

2

= 4.

27. November 2009

9 / 24

Maximum Likelihood

Idee von Maximum Likelihood

Beispiel: Lineare Regression

Beispiel

Wahre Werte liegen auf Ursprungsgerade g (x|a) = a · x

Messe {xi , yi }-Paare

Messwerte gaußverteilt mit Varianz σ 2 um wahren Wert

Wahrscheinlichkeitsdichte ist fi (xi , yi |a) = Gauss(yi − g (xi |a) , σ)

!

Y

Y 1

(yi − xi · a)2

√ exp

L=

fi (xi , yi |a) =

2π σ

2σ 2

i

i

X (yi − xi · a)2 ∂F

X 2xi · (yi − xi · a)

=−

,

2

∂a

2σ

2σ 2

i

i

!

!

X

X

2

(xi )

= 0 wenn a =

(xi · yi ) /

F =C+

∂F

∂a

i

i

Armin Burgmeier (KIT)

Parameteranpassung

27. November 2009

10 / 24

Maximum Likelihood

Fehlerberechnung

Parabolischer Fall

Likelihood-Funktion geht gegen Gaußkurve für große Stichproben

2

2

Entwickle F (a) = F (â) + 12 · ddaF2 · (a − â) + . . .

â)2

Vergleich mit Gaußkurve exp − (a−

2

2σ

2 −1/2

σ = ddaF2

F a

F(â ± r σ) = F(â) +

1 1

2 σ2

2

(â ± r σ − â) + . . . = F(â) +

r2

2

5

4

3

2

-2

-1

Armin Burgmeier (KIT)

0

1

2

a

Parameteranpassung

27. November 2009

11 / 24

Maximum Likelihood

Fehlerberechnung

Nichtparabolischer Fall

Sei z := z (a) so, dass Fz (z) := F a−1 (z) parabolisch ist

Bestimme σz wie vorher

F a

Fz (ẑ + r σz ) = Fz (ẑ) +

Fz (ẑ − r σz ) = Fz (ẑ) +

r2

2

r2

2

= F (â) +

= F (â) +

r2

2

r2

2

= F (â + r σr )

= F (â − r σl )

0

-1

Lese F dort ab wo es um

zugenommen hat

-2

-3

-4

-5

r2

2

Im allgemeinen

asymmetrische Fehler

0

0.5

Armin Burgmeier (KIT)

1

1.5

2

a

Parameteranpassung

27. November 2009

12 / 24

Maximum Likelihood

Fehlerberechnung

Fehlerberechnung bei Ausgleichsgerade

Beispiel

X xi · (yi − xi · a)

∂F

=−

∂a

σ2

i

X x2

∂2F

i

=

∂a2

σ2

i

2 −1/2

∂ F

σ

σa =

= qP

2

∂a

2

i xi

2.5

2

1.5

1

0.5

0

0

1

2

3

4

Fehler nur abhängig von x-Werten

Beschreibt nur Fortpflanzung der y-Fehler in a

Kein Goodness-of-fit

Armin Burgmeier (KIT)

Parameteranpassung

27. November 2009

13 / 24

Maximum Likelihood

Fehlerberechnung

Mehrere Parameter

Gleiche Ideen funktionieren weiter

∂F

∂ai

= 0 für alle ai .

Gij =

∂2F

∂ai ∂aj

liefert das Inverse der Kovarianzmatrix V = G−1

F (a) = F (â) +

r2

2

definieren Konturen gleicher Likelihood

Schließen r σ-Gebiete ein

Armin Burgmeier (KIT)

Parameteranpassung

27. November 2009

14 / 24

Maximum Likelihood

Fehlerberechnung

Profile Likelihood

Oft: Modell enthält Störparameter ν

Benötigt zur Modellierung, aber am Ende uninteressant

Wie wirkt sich Fehler bei der Bestimmung von ν auf interessanten

Parameter a aus?

F

Minimiere F für jedes a als Funktion von ν.

4

3.5

Kurve wird flacher als bei

konstantem ν

3

2.5

Führt zu größerem σa

2

-2

-1

Armin Burgmeier (KIT)

0

1

2

a

Parameteranpassung

27. November 2009

15 / 24

Maximum Likelihood

Fehlerberechnung

Neyman-Konstruktion

Bisher vorgestellte Ansätze problematisch bei kleinen Stichproben

Bestimme Konfidenzregion die a0 bei N Versuchen C · N mal

enthält (Frequentist)

peak k

C heißt Coverage, α = 1 − C ist Irrtumswahrscheinlichkeit

R

a ist in der Konfidenzregion enthalten wenn L (x|a) dx = C die

gemessenen {xi } enthält

200

180

160

140

120

100

80

60

40

0

2000

4000

6000

Armin Burgmeier (KIT)

8000

10000

12000

Length [km]

Freiheit: Wahl des

Integrationsgebiets, zum Beispiel:

R x0

L (x|a) dx = C

R−∞

∞

x L (x|a) dx = C

R x0u

L (x|a) dx = α/2 ∧

R−∞

+∞

L (x|a) dx = α/2

xo

Parameteranpassung

27. November 2009

16 / 24

Maximum Likelihood

Fehlerberechnung

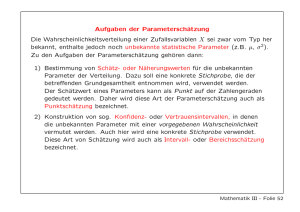

Bayes’sche Statistik

Bayes-Theorem gilt auch für Wahrscheinlichkeitsdichten

L (x|a) · f (a)

P (a|x) =

g (x)

Intepretiere P (a|x) als Glaube, dass a einen bestimmten Wert hat

g (x) konstant in a, legt Normierung fest

f (a) heißt Prior: Glaube vor der Messung dass a einen

bestimmten Wert hat

a liege mit Wahrscheinlichkeit 1 − α in der Kredibilitätsregion

R

P (a|{xi }) da = 1 − α

Erneut Freiheit bei der Wahl des Integrationsbereichs

Armin Burgmeier (KIT)

Parameteranpassung

27. November 2009

17 / 24

Kleinste Quadrate

Prinzip der kleinsten Quadrate

Prinzip der kleinsten Quadrate

Gaußverteilte Fehler führen für F zu Ausdrücken der Form

Definition

S :=

(y1 −a1 )2

σ12

+

(y2 −a2 )2

σ22

+ ... =

X (yi − ai )2 X ∆y 2

i

=

2

2

σi

σi

i

i

∆yi heißen Residuen

Prinzip der kleinsten Quadrate: S = Minimum

Äquivalent zu ML für gaußverteilte Fehler, sonst eigenes“

”

Verfahren

∆y1

Allgemein mit Kovarianzmatrix V und ∆y = ∆y2 :

..

.

S = ∆yT V−1 ∆y = Minimum

Armin Burgmeier (KIT)

Parameteranpassung

27. November 2009

18 / 24

Kleinste Quadrate

Prinzip der kleinsten Quadrate

Lineare kleinste Quadrate

Lineares Modell f (x|a) = a1 f1 (x) + a2 f2 (x) + . . .

Vereinfachung: {yi } seien unkorreliert und gleiche Varianz σ 2

X

(yi − f (xi |a))2

S = σ12

i

∂S

2 X

!

=− 2

fj (xi ) · (yi − a1 f1 (xi ) − a2 f2 (xi ) − . . .) = 0

∂aj

σ

i

⇒ Normalengleichungen:

a1

X

i

Armin Burgmeier (KIT)

fj (xi )f1 (xi ) + a2

X

fj (xi )f2 (xi ) + . . . =

i

Parameteranpassung

X

yi fj (xi )

i

27. November 2009

19 / 24

Kleinste Quadrate

Prinzip der kleinsten Quadrate

Matrixschreibweise

Normalengleichungen:

X

X

X

a1

fj (xi )f1 (xi ) + a2

fj (xi )f2 (xi ) + . . . =

yi fj (xi )

i

i

i

Definiere Matrix für n Messungen und p Parameter

f1 (x1 ) f2 (x1 ) . . . fp (x1 )

a1

f1 (x2 ) f2 (x2 ) . . . fp (x2 )

a2

a

=

A=

..

..

..

..

..

.

.

.

.

.

f1 (xn ) f2 (xn ) . . . fp (xn )

ap

y=

y1

y2

..

.

yn

Schreibe Normalengleichungen in Matrixform:

−1 T

AT A a = AT y ⇒ a = AT A

A y

Armin Burgmeier (KIT)

Parameteranpassung

27. November 2009

20 / 24

Kleinste Quadrate

Prinzip der kleinsten Quadrate

Matrixschreibweise

Normalengleichungen:

X

X

X

a1

fj (xi )f1 (xi ) + a2

fj (xi )f2 (xi ) + . . . =

yi fj (xi )

i

i

i

Definiere Matrix für n Messungen und p Parameter

f1 (x1 ) f2 (x1 ) . . . fp (x1 )

a1

f1 (x2 ) f2 (x2 ) . . . fp (x2 )

a2

a

=

A=

..

..

..

..

..

.

.

.

.

.

f1 (xn ) f2 (xn ) . . . fp (xn )

ap

y=

y1

y2

..

.

yn

Schreibe Normalengleichungen in Matrixform:

−1 T

AT A a = AT y ⇒ a = AT A

A y

Armin Burgmeier (KIT)

Parameteranpassung

27. November 2009

20 / 24

Kleinste Quadrate

Fehlerfortpflanzung und Hypothesentest

Allgemeine Lösung und Fehlerfortpflanzung

Definiere Gewichtsmatrix W := V−1

S = ∆yT V−1 ∆y = (y − Aa)T W(y − Aa)

−1 T

A Wy

S wird minimal bei a = AT WA

|

{z

}

B

Fehlerfortpflanzung:

Gegeben sei lineare Transformation y = Bx

Dann gilt Fehlerfortpflanzungsgesetz: Vy = BVx BT

Hier:

−1 T

−1 T T

Va = BVBT = AT WA

A WV AT WA

A W

−1 T T

−1

= AT WA

A W A AT WT A

−1

= AT WA

Armin Burgmeier (KIT)

Parameteranpassung

27. November 2009

21 / 24

Kleinste Quadrate

Fehlerfortpflanzung und Hypothesentest

χ2 -Test

χ2n -Verteilung gibt Wahrscheinlichkeitsdichte für Summe aus n

standard-normalverteilter Zufallsvariablen

S folgt χ2 -Verteilung mit n − p Freiheitsgraden (für gaußverteilte

Fehler)

Wahrscheinlichkeit diesen oder größeren Wert für S zu erhalten:

Z

∞

S

f (χ2n−p )dχ2

0.5

0.4

Erwartungswert ist E[χ2n ] = n

0.3

Für n − p > 2 ist auch

Wahrscheinlichkeit für kleines

S gering

0.2

0.1

0

0

2

4

Armin Burgmeier (KIT)

6

8

10

Parameteranpassung

27. November 2009

22 / 24

Zusammenfassung

Zusammenfassung

Input

Anwendbarkeit

Konsistent

Erwartungstreu

Effizient

Robust

Goodness-of-fit

Rechenaufwand

Armin Burgmeier (KIT)

Maximum

Likelihood

PDFs

PDFs bekannt

Ja

nur für große

Stichproben

asymptotisch

maximal

Nein

Nein

im allgemeinen hoch

Parameteranpassung

Kleinste Quadrate

Varianzen

Daten unverzerrt,

Varianzen endlich

Ja

Ja im lin. Fall

maximal (im lin. Fall)

Nein

Für gaußsche Fehler

Im lin. Fall relativ

gering

27. November 2009

23 / 24

Literatur

Literatur

Allgemein:

V. Blobel, E. Lohrmann, Statistiche und numerische Methoden der

Datenanalyse, Teubner (1998)

C. Amsler et al. (Particle Data Group), Physics Letters B667, 1

(2008)

Plots:

T. Schwetz, M. Tortola, J. W.F. Valle, New J.Phys.10:113011, 2008

K. Scholberg, A. Burgmeier, R. Wendell, (2009) 0910.3174

Armin Burgmeier (KIT)

Parameteranpassung

27. November 2009

24 / 24