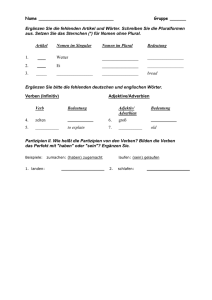

Was Hänschen nicht lernt, lernt Hans nimmermehr

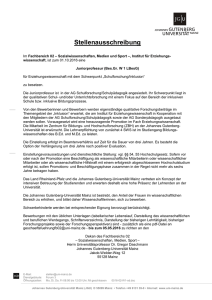

Werbung