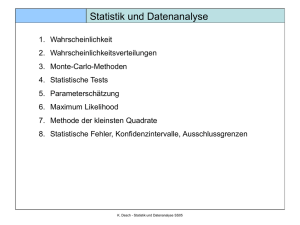

Wahrscheinlichkeit

Gliederung

• Inferenzstatistik

• Definitionen für Wahrscheinlichkeiten

– Relative Häufigkeit

– Grenzwerte („Gesetz der großen Zahl“)

• Bedingte Wahrscheinlichkeit

• Stochastische Unabhängigkeit

• Wahrscheinlichkeitsrechnung

– Additionstheorem

– Multiplikationstheorem

– Theorem von Bayes

• Wahrscheinlichkeitsverteilungen

04_wahrscheinlichkeit

1

Inferenzstatistik

• Die Inferenzstatistik („schlussfolgernde Statistik“) zieht aus den

Daten einer Stichprobe Rückschlüsse auf die zugrundeliegende

Population.

• Inferenzstatistik beruht auf Wahrscheinlichkeitsaussagen

• Beispiel:

– Bei den Psychologie Erstsemester 2008 in Freiburg schätzen die Männer

(31) ihre Statistikvorkenntnisse höher ein als die Frauen (24).

– „Ist das gleiche Muster auch für andere Semester (oder andere

Universitäten) zu erwarten?“

– „Wie wahrscheinlich ist es, dass in der Gesamt-Population aller

Psychologie-Studienanfänger Männer ihre Statistikkenntnisse höher

einschätzen als Frauen?“

– „Wie wahrscheinlich wäre das gefundene Ergebnis (Männer = 31; Frauen =

24), wenn es in der Population keinen Unterschied gäbe?“

04_wahrscheinlichkeit

2

Definitionen für Wahrscheinlichkeiten

Was bedeutet Wahrscheinlichkeit?

1. „a priori“ Wahrscheinlichkeit (Laplace)

–

Wahrscheinlichkeit ist der relativer Anteil der „günstigen Fälle“ an allen

möglichen Ereignissen:

p ( A)

nA

N gesamt

2. „a posteriori“ Wahrscheinlichkeit (Bernoulli)

–

Wahrscheinlichkeit ist der Grenzwert der relativen Häufigkeit des

Eintretens der „günstigen Fälle“ bei sehr häufigem Durchführen eines

Zufallsexperimentes:

( A)

lim

N

04_wahrscheinlichkeit

nA

N

3

Relative Häufigkeit

• Die relative Häufigkeit ist ein Schätzer für die „a posteriori“

Wahrscheinlichkeit.

• Die relative Häufigkeit wird berechnet als die Anzahl der

Probanden mit einer bestimmten Ausprägung auf einer Variable

geteilt durch die Stichprobengröße.

Herkunft

Baden-Württemberg

Hessen

Bayern

Berlin

Rest

Gesamt

04_wahrscheinlichkeit

Häufigkeit

53

8

7

2

28

98

p

0.54

0.08

0.07

0.02

0.29

1.00

4

„Gesetz der großen Zahl“

• Für große Zahlen ist die relative Häufigkeit ein immer besserer

Schätzer für die (a posteriori) Wahrscheinlichkeit.

• Der Grenzwert der relativen Häufigkeit für „N gegen Unendlich“

entspricht der Wahrscheinlichkeit.

• Beispiel: Relative Häufigkeit des Ereignisses „BadenWürttemberg“ in Abhängigkeit von N:

0,80

0,60

p(98) =.54

0,40

0,20

0,00

0

04_wahrscheinlichkeit

10

20

30

40

50

60

70

80

90

100

5

Bedingte Wahrscheinlichkeit

• Die bedingte Wahrscheinlichkeit gibt an, wie wahrscheinlich ein

Ereignis (A) ist, wenn gleichzeitig ein anderes Ereignis (B) gegeben

ist.

• Beispiele

– Wie wahrscheinlich ist es, dass eine Person depressiv ist (Ereignis A), wenn

sie an chronischen Schmerzen leidet (Ereignis B)?

– Wie wahrscheinlich ist es, dass eine Schüler durch eine Prüfung fällt

(Ereignis A), wenn es sich um einen Jungen handelt (Ereignis B)?

• Formale Schreibweise:

pA | B

„Die Wahrscheinlichkeit von A unter der Bedingung B“

04_wahrscheinlichkeit

6

Bedingte Wahrscheinlichkeit

• Die bedingte Wahrscheinlichkeit kann folgendermaßen berechnet

werden:

pA | B

pA B

p B

• p(A|B): Wahrscheinlichkeit von A gegeben B.

• p(A B): Wahrscheinlichkeit, dass A und B gleichzeitig zutreffen

• p(B): Wahrscheinlichkeit von B.

04_wahrscheinlichkeit

7

Bedingte Wahrscheinlichkeit

• Beispiel: Chronische Schmerzen (S) und Depression (D)

– 5% der Bevölkerung leiden an chronischen Schmerzen.

– 2% der Bevölkerung leiden an chronischen Schmerzen und Depressionen.

p D | S

p D S

p S

. 02

. 40

. 05

• Beispiel: Misserfolg in der Prüfung (P-) und Geschlecht (m)

Erfolg

Misserfolg

Männlich

12

3

Weiblich

14

1

p P | m

04_wahrscheinlichkeit

p P m

p m

. 10

. 20

. 50

8

Stochastische Unabhängigkeit

• Zwei Ereignisse sind stochastisch unabhängig, wenn die

Wahrscheinlichkeit für Ereignis A nicht vom Eintreten von Ereignis

B beeinflusst wird.

• Beispiel: 2 Würfelwürfe sind stochastisch unabhängig:

– Die Wahrscheinlichkeit, eine 6 zu würfeln (p(6) = 1/6), ist unabhängig vom

Ergebnis des zweiten Würfels.

• Formal: Die bedingte Wahrscheinlichkeit von A gegeben B

entspricht der bedingten Wahrscheinlichkeit von A gegeben

„nicht-B“

p A | B p A | B p A

04_wahrscheinlichkeit

9

Stochastische Unabhängigkeit

Beispiel 1: Zwei Würfelwürfe

p W 1 6

1

6

p W 1 6 | W 2 6

p W 1 6 | W 2 6

p W 1 6 W 2 6

p W 2 6

1 / 36

6 / 36

p W 1 6 W 2 6

p W 2 6

5 / 36

30 / 36

1

6

1

6

W2

1

2

3

4

5

6

1

2

W1

3

4

5

6

04_wahrscheinlichkeit

10

Stochastische Unabhängigkeit

Beispiel 2: Herkunft BW und Geschlecht

Herkunft

Männer

Frauen

Baden-Württemberg

14

38

sonstiges

7

37

p BW | m

14

p BW | w

38

. 67

21

. 51

75

– Formal: Keine Stochastische Unabhängigkeit von Herkunft und Geschlecht

– Aber: Exakt identische Werte sind in empirischen Erhebungen nie zu

erwarten

– Den statistischen Test für diese Fragestellung (Chi²-Test) lernen wir am

Ende des Wintersemesters kennen

04_wahrscheinlichkeit

11

Das Additionstheorem

• Mit dem Additionstheorem wird die Wahrscheinlichkeit

berechnet, dass entweder Ereignis A oder Ereignis B eintritt.

• Beispiel:

– Wie wahrscheinlich ist es, eine 5 oder eine 6 zu würfeln?

– Wie wahrscheinlich ist es, dass eine Person im Laufe Ihres Lebens an einer

Angststörung und an einer depressiven Störung erkranken wird

(Lebenszeitprävalenz: Angststörungen: 15%, Depressivität: 10%)?

• Formale Schreibweise

– p(A B)

– „Wahrscheinlichkeit von A oder B“

04_wahrscheinlichkeit

12

Das Additionstheorem

• Bei „disjunkten“ Ereignissen, die niemals gleichzeitig auftreten,

werden die Einzelwahrscheinlichkeiten einfach addiert:

p ( A B ) p ( A) p ( B )

• Wenn Ereignisse auch gemeinsam auftreten können, dann muss

die Formel ergänzt werden:

p A B p A p B p A B

Depression

Angststörung

nein

ja

nein

.78

.07

ja

.12

.03

04_wahrscheinlichkeit

13

Das Multiplikationstheorem

• Mit dem Multiplikationstheorem wird die Wahrscheinlichkeit

berechnet, dass die Ereignisse A und B gleichzeitig eintreten.

• Beispiel:

– Wie wahrscheinlich ist es, mit 2 Würfelwürfen jeweils eine 6 zu würfeln?

– Wie wahrscheinlich ist es, dass eine Person im Laufe Ihres Lebens an einer

Angststörung und an einer depressiven Störung erkranken wird

(Lebenszeitprävalenz: Angststörungen: 10%, Depressivität: 8%)?

• Formale Schreibweise

– p(A B)

– „Wahrscheinlichkeit von A und B“

04_wahrscheinlichkeit

14

Das Multiplikationstheorem

• Bei stochastisch unabhängigen Ereignissen werden die

Einzelwahrscheinlichkeiten einfach multipliziert:

p ( A B ) p ( A) p ( B )

• Wenn Ereignisse abhängig sind, dann muss folgende Formel

verwendet werden:

p A B p A | B p B

bzw.

p A B p B | A p A

04_wahrscheinlichkeit

Depression

Angststörung

nein

ja

nein

.78

.07

ja

.12

.03

15

Das Multiplikationstheorem

Beispiel

• Bei einer Untersuchungen von Schmerzpatienten stellen Sie fest,

das 30% der Schmerzpatienten gleichzeitig Medikamentenabhängig sind.

• 0.2 % der Bevölkerung leiden an einer chronischen

Schmerzerkrankung.

• Wie viel Prozent der Bevölkerung weisen sowohl eine

Schmerzerkrankung als auch eine Medikamentenabhängigkeit

auf?

p S M

04_wahrscheinlichkeit

p M

| S p S . 30 . 002 . 0006 0 . 06 %

16

Das Theorem von Bayes

• Das Theorem von Bayes erlaubt es, die bedingten

Wahrscheinlichkeiten p(A|B) und p(B|A) in Beziehung zu setzen.

pA | B

p A p B | A

p B

• Beispiel:

– 75% der Alkoholabhängigen sind Männer

– Lebenszeitprävalenz (insgesamt): 10%

– Wie hoch ist das Risiko für einen Mann eine Alkoholabhängigkeit zu

entwickeln?

p ( Alk . | m )

p ( Alk .) p ( m | Alk .)

p (m )

04_wahrscheinlichkeit

0 . 10 0 . 75

0 . 15

0 . 50

17

Wahrscheinlichkeitsverteilungen

• Bisher haben wir die Wahrscheinlichkeit von Einzelereignissen

betrachtet.

• Wahrscheinlichkeitsverteilungen geben die Auftretenswahrscheinlichkeiten für einzelne Werte einer Variable an.

• Beispiel Geschlecht:

– p(sex=„m“) = .22

– p(sex=„w“) = .78

• Beispiel Alter

–

–

–

–

–

p(age=18) = .03

p(age=19) = .19

p(age=20) = .21

p(age=21) = .10

…

04_wahrscheinlichkeit

18

Wahrscheinlichkeitsverteilungen

• Da jede Person genau einen Wert für die Variable hat, sind die

Ereignisse disjunkt.

• Daher können Bereiche durch Addition zusammengefasst

werden:

– p(17<age<21) = p(age=18)+p(age=19)+p(age=20) = .43

– Insgesamt addieren sich alle Einzelwahrscheinlichkeiten immer zu 1

04_wahrscheinlichkeit

K

i 1

p x xi 1

19

Wahrscheinlichkeitsverteilungen

Graphische Darstellung

• 50% geben einen

Wert von 1 oder 2 an

• Die gemeinsame

Fläche der Balken

entspricht der

gemeinsamen

Wahrscheinlichkeit

04_wahrscheinlichkeit

20

Wahrscheinlichkeitsverteilungen

Wahrscheinlichkeitsverteilungen für kontinuierliche Variablen

• Eine diskrete Wahrscheinlichkeitsverteilung gibt für jeden Wert

einer diskreten Variable die Auftretenswahrscheinlichkeit an.

• Eine diskrete Wahrscheinlichkeitsverteilung ergibt sich ebenfalls,

wenn für die Auftretenswahrscheinlichkeit für alle Kategorien

einer Diskreten Variable angegeben wird (Histogramm).

• Eine stetige Wahrscheinlichkeitsverteilung ergibt sich, wenn für

eine kontinuierliche Variable unendlich kleine Kategoriebreiten

verwendet werden.

• Stetige Wahrscheinlichkeitsverteilungen heißen auch

„Dichtefunktion“

04_wahrscheinlichkeit

21

Wahrscheinlichkeitsverteilungen

Beispiel: Diskrete und Kontinuierliche Verteilung des

Optimismusfragebogens.

Hinweise:

• Die kontinuierliche Verteilung

ergibt sich nicht direkt aus den

Daten

• Im Beispiel wurde eine Normalverteilung angenommen.

04_wahrscheinlichkeit

22

Wahrscheinlichkeitsverteilungen

Interpretation kontinuierlicher Wahrscheinlichkeitsverteilungen

• Bei kontinuierlichen Wahrscheinlichkeitsvertelungen kann man

nicht mehr direkt eine Wahrscheinlichkeit für eine Ausprägung

der Variablen ablesen.

• Die Wahrscheinlichkeit, dass bei einer kontinuierlichen Variable

exakt einen bestimmter Wert auftritt ist (theoretisch) unendlich

klein.

• Man kann aber Wahrscheinlichkeiten für bestimmte Bereiche

einer Verteilung sehen.

• Dazu wird die Fläche der Verteilung herangezogen

04_wahrscheinlichkeit

23

Wahrscheinlichkeitsverteilungen

Interpretation kontinuierlicher Wahrscheinlichkeitsverteilungen

• Die Wahrscheinlichkeit, zufällig einen Wert zwischen xmin und xmax

zu erhalten entspricht der Fläche unter der Verteilung zwischen

diesen Werten.

d

p

.30

f ( x ) dx

x min

.20

.10

.00

f ( x ) dx 1 . 00

x

xmin

04_wahrscheinlichkeit

x max

xmax

24

Die Normalverteilung

• Die wichtigste stetige Wahrscheinlichkeitsverteilung in der

Psychologie ist die Normalverteilung.

• Sie wurde von C.F. Gauss „entdeckt“ und war auf den alten

10 DM Scheinen abgebildet.

• Dort stand auch die Formel der Dichtefunktion der Normalverteilung:

f ( x)

( x )

1

2

e

2

2

2

2

• Die Normalverteilung ist deshalb so wichtig, weil in der Natur

sehr viele Merkmale (annähernd) normalverteilt sind.

04_wahrscheinlichkeit

25

Die Normalverteilung

• Jede Normalverteilung …

– hat einen „glockenförmigen“ Verlauf und

– ist symmetrisch (a3=0) und

– hat einen „normalen“ Exzess (a4 = 0)

• Es gibt unendlich viele Normalverteilungen

• Diese unterscheiden sich in Ihrem Mittelwert und in der

Standardabweichung (bzw. Varianz)

– Der Mittelwert (μ) gibt die Position des „Gipfels“ an.

– Die Standardabweichung (σ) gibt die Breite der Verteilung an.

04_wahrscheinlichkeit

26

Die Standardnormalverteilung

• Ein Normalverteilung mit einem Mittelwert μ=0 und einer

Streuung von σ=1 heißt Standardnormalverteilung.

• Werte einer Standardnormalverteilungen können besonders

einfach interpretiert werden, da die zugehörigen

Wahrscheinlichkeiten aus einer Tabelle im Statistikbuch

nachgeschlagen werden können.

• Jede normalverteilte Variable kann einfach in eine Standardnormalverteilung transformiert werden (z-Transformation)

x neu z x

04_wahrscheinlichkeit

x alt ˆ

ˆ

27

Die Standardnormalverteilung

Beispiel z-Transformation der Optimismuswerte

Deskriptive Statistik

Standardabweic

N

Mittelwert

lot

98

Gültige Werte (Listenweise)

98

LOT

zLOT

27

1.08

23

-0.03

16

-1.97

19

-1.14

25

0.53

25

0.53

04_wahrscheinlichkeit

23,1020

hung

3,60266

z lot

lot 23 . 10

3 . 60

28

Die Standardnormalverteilung

Interpretation von z-Werten (ungefähre Werte)

f(z)

2%

14%

-2

68%

-1

0

14%

1

2%

2

z

• Im Statistiklehrbuch findet man in der Tabelle zur Standardnormalverteilung für jeden z-Wert den Anteil der Fläche, die links

dieses Wertes liegt.

04_wahrscheinlichkeit

29

Zusammenfassung

• Die Inferenzstatistik verallgemeinert die Befunde einer

Stichprobe.

• Wahrscheinlichkeit ist der relativer Anteil „günstiger“ Ereignisse

an allen möglichen Ereignissen.

• Im Nachhinein kann die Wahrscheinlichkeit über relative

Häufigkeiten geschätzt werden.

• Das Gesetz der großen Zahl besagt, dass eine Abschätzung der

Wahrscheinlichkeit als relative Häufigkeit immer genauer wird, je

größer die Stichprobe ist.

• Eine bedingte Wahrscheinlichkeit gibt an, wie wahrscheinlich

Ereignis A ist, wenn man schon weiß, dass ein anderes Ereignis B

eingetreten ist.

04_wahrscheinlichkeit

30

Zusammenfassung

• Mit dem Additionstheorem kann berechnet werden, wie groß die

Wahrscheinlichkeit ist, dass entweder Ereignis A oder Ereignis B

eintritt.

• Mit dem Multiplikationstheorem kann berechnet werden, wie

groß die Wahrscheinlichkeit ist, dass Ereignis A und Ereignis B

eintreten.

• Das Theorem von Bayes erlaubt es, die bedingten

Wahrscheinlichkeiten p(A|B) und p(B|A) in Beziehung zu setzen.

• Wahrscheinlichkeitsverteilungen erlauben Aussagen über die

Wahrscheinlichkeiten von bestimmten Merkmalsausprägungen.

• Viele Psychologische Merkmale sind normalverteilt.

• Eine Normalverteilung mit Mittelwert 0 und Standardabweichung 1 heißt Standardnormalverteilung.

04_wahrscheinlichkeit

31