Mathematische und statistische Methoden II statistische Methoden II

Werbung

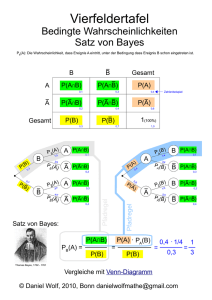

Statistik & Methodenlehre e ode e e Prof. Dr. G. Meinhardt 6. Stock, Wallstr. 3 ((Raum 06-206)) Sprechstunde jederzeit nach Vereinbarung und nach der Vorlesung. g Mathematische und statistische Methoden II Dr. Malte Persike } [email protected] http://psymet03.sowi.uni-mainz.de/methods/ SS 2010 Fachbereich Sozialwissenschaften Psychologisches Institut Johannes Gutenberg Universität Mainz Statistik & Methodenlehre e ode e e Bedingte Wk Satz von Bayes Mengenlehre Wk-Theorie Bedingte Wahrscheinlichkeit P( A ∩ B) P ( B | A) = P ( A) Ist die Wahrscheinlichkeit für das Ereignis B, B gegeben dass das Ereignis A bereits eingetreten ist (lies: „B gegeben A“). Die Wahrscheinlichkeit P(A) wird als Grundwahrscheinlichkeit bezeichnet. P(B | A) wird bedingte Wahrscheinlichkeit genannt. A A∩B B Im Venn Diagramm kann P(B | A) als Anteil der Fläche A ∩ Ban der Fläche A interpretiert werden (und nicht mehr am gesamten Stichprobenraum Ω). Ω Statistik & Methodenlehre e ode e e Bedingte Wk Mengenlehre Wk-Theorie Bedingte Wahrscheinlichkeit Im Laplace Ansatz Satz von Bayes Es seien a die für das Ereignis A günstigen Elementarereignisse b die für das Ereignis B günstigen Elementarereignisse c die für das Ereignis A ∩ B günstigen Elementarereign. n die Menge aller Elementarereignisse. Dann ist zunächst P(A) = a / n P(B) = b / n P(AB) = c / n Aus dem Venn Diagramm sieht man auch: P(B | A) = c / a Durch n/n teilen ergibt c P( A ∩ B) n = P ( B | A) = a P ( A) n Statistik & Methodenlehre e ode e e Bedingte Wk Mengenlehre Wk-Theorie Bedingte Wahrscheinlichkeit Im Kolmogoroff Ansatz Satz von Bayes In der axiomatischen Definition der Wahrscheinlichkeit kann die Berechnungsvorschrift für bedingte Wahrscheinlichkeiten nicht bewiesen werden. Deshalb muss die bedingte Wahrscheinlichkeit hier definiert werden: ! P( A ∩ B) P ( B | A) = P ( A) Statistik & Methodenlehre e ode e e Bedingte Wk Mengenlehre Wk-Theorie Bedingte Wahrscheinlichkeit Das Multiplikationstheorem Satz von Bayes gilt: Man sieht sofort dass g P(A ∩ B) = P(B ∩ A) Damit erhalten wir durch Umformen P( B | A) = P( A ∩ B) P( A) ⇔ P( A ∩ B) = P( B | A) ⋅ P( A) P( A | B) = P( A ∩ B) P( B) ⇔ P( A ∩ B) = P( A | B) ⋅ P( B) Multiplikationstheorem Statistik & Methodenlehre e ode e e Mengenlehre Wk-Theorie Bedingte Wk Wahrscheinlichkeitsbäume Satz von Bayes Additions- und Multiplikationstheorem für bedingte Wahrscheinlichkeiten lassen sich gut an einem Wahrscheinlichkeitsbaum veranschaulichen. Ereignis g B, gegeben A Ereignis A P(B1|A1) A1 B1 Multiplikations Multiplikationstheorem für Wk‘ten P(B1|A1)P(A1) P(B2|A1) B2 P(A1) P(B1|A2) S P(A ( 1) B1 A2 P(B2|A1)P(A1) P(B1|A2)P(A2) P(A1B1∪A2B1 ∪A3B1)= P(B2|A2) B2 P(B |A )P(A ) 2 2 2 P(A ( 1) P(B1|A3) B1 A3 P(B1|A3)P(A3) P(B2|A3) B2 Man sieht auch: P(B2|A3)P(A3) P(B1|A1)P(A1)+ P(B1|A2)P(A2)+ P(B1|A3)P(A3) Statistik & Methodenlehre e ode e e Bedingte Wk Satz von Bayes Mengenlehre Wk-Theorie Satz der totalen Wahrscheinlichkeit Wenn die Ereignisse B1, B2, … Bk paarweise disjunkt sind und das Ereignis A immer mit einem der Bi auftritt, gilt A = (A∩B1) ∪ (A∩B2) ∪ … ∪ (A∩Bk) Mit dem Additionsthorem erhalten wir P ( A) = P( A ∩ B1 ) + … + P ( A ∩ Bk ) Ω Bk … B1 B2 … … … … A Und mit dem Multiplikationssatz wird daraus P ( A) = P ( B1 ) P ( A | B1 ) + P( B2 ) P( A | B2 ) + … + P ( Bk ) P( A | Bk ) Satz der totalen Wahrscheinlichkeit Statistik & Methodenlehre e ode e e Bedingte Wk Satz von Bayes Mengenlehre Wk-Theorie Satz von Bayes Wir sehen anhand des Multiplikationstheorems, dass P(B | A) P(A) = P(A | B) P(B) Damit gilt P( B | A) = P( A | B) P( B) P ( A) bzw. P( A | B) = P( B | A) P ( A) P( B) Die bedingte Wahrscheinlichkeit eines Ereignisses A gegeben B ist zu berechnen aus der Wahrscheinlichkeit für B gegeben A und den Grundwahrscheinlichkeiten von A und B. Diese Beziehung ist der Satz von Bayes. Statistik & Methodenlehre e ode e e Bedingte Wk Mengenlehre Wk-Theorie Satz von Bayes Verallgemeinerung Satz von Bayes Hat man mehrere Ereignisse B1, B2, …, Bk wird beim Satz von Bayes P( A | Bi ) P ( Bi ) P ( Bi | A) = P ( A) vorausgesetzt, dass die Grundwahrscheinlichkeit für A vorausgesetzt bekannt ist. Häufig kennt man aber nur alle P(A|Bi). Mit dem Satz der totalen Wahrscheinlichkeit erhält man aus dem Satz von Bayes diese allgemeine Bayes-Formel: P( Bi | A) = P( A | Bi ) P( Bi ) P( A | B1 ) P( B1 ) + P( A | B2 ) P( B2 ) + … + P( A | Bk ) P( Bk )