3.2 Eigenwerte und das charakteristische Po

Werbung

Lineare Algebra II – Sommersemester 2017

3.2

c Rudolf Scharlau

215

Eigenwerte und das charakteristische Polynom

In diesem kurzen, aber zentralen Abschnitt werden die zunächst Begriffe „Eigenwert” und „Eigenvektor” definiert. Sie beziehen sich auf einen

Endomorphismus eines Vektorraumes, bzw. auf eine quadratische Matrix. Dann wird, aufbauend auf das Konzept der Determinante aus dem

vorigen Abschnitt, das charakteristische Polynom einer quadratischen

Matrix definiert. Mit Hilfe unserer Kenntnisse über Basiswechsel, insbesondere Satz 2.8.13 wird diese Definition auf Endomorphismen endlichdimensionaler Vektorräume übertragen. Nachdem all dieses entwickelt

ist, erfordert es keinen Aufwand mehr, den zentralen Satz dieses Abschittes zu beweisen: Die Eigenwerte sind genau die Nullstellen des charakteristischen Polynoms.

Definition 3.2.1 (Eigenwert, Eigenvektor) Es sei K ein Körper, V

ein K-Vektorraum und F : V → V ein Endomorphismus von V . Ein

Skalar λ ∈ K heißt Eigenwert von F , falls ein Vektor v ∈ V, v 6= 0

existiert mit F (v) = λv. Ein solcher Vektor v ∈ V heißt Eigenvektor von

F zum Eigenwert λ.

Wenn A ∈ K n×n eine quadratische Matrix ist, dann werden die Eigenwerte und Eigenvektoren des Endomorphismus FA von K n auch einfach

als Eigenwerte bzw. Eigenvektoren von A bezeichnet.

Bemerkung und Definition 3.2.2 (Eigenraum) Es sei F ein Endomorphismus von V und λ ∈ K.

a) Wir bezeichnen mit Eig(F, λ) ⊆ V die Menge aller Eigenvektoren

von F zum Eigenwert λ zusammen mit dem Nullvektor. Es gilt

Eig(F, λ) = Kern(F − λ IdV ) .

Insbesondere ist Eig(F, λ) ein Untervektorraum von V . Er heißt

der zu λ gehörige Eigenraum von F .

b) Ein Skalar λ ist genau dann ein Eigenwert von F , wenn der Kern

von F − λ IdV nicht nur aus dem Nullvektor besteht, d.h. wenn

F − λ IdV nicht injektiv ist.

Entsprechend wird ein Eigenraum Eig(A, λ) einer quadratischen Matrix

A als Eigenraum der zugehörigen linearen Abbildung FA definiert. Er

ist gleich den Kern der Matrix A − λEn , also gleich dem Lösungsraum

des zu dieser Matrix gehörigen homogenen Linearen Gleichungssystems:

Eig(A, λ) = L(A − λEn , 0).

Vor dem ersten Beispiel zu Eigenvektoren schieben wir noch eine kleine

Definition ein.

Definition und Bemerkung 3.2.3 (Fixpunkt)

a) Es sei M irgendeine Menge und f : M → M eine Abbildung. Ein

Fixpunkt von f ist ein Element x ∈ M , für das f (x) = x gilt.

b) Die Fixpunkte einer linearen Abbildung sind genau die Eigenvektoren zum Eigenwert 1 zusammen mit dem Nullvektor.

Fixpunkte spielen unter anderem in der Geometrie eine große Rolle. Der

Begriff hat nicht speziell mit linearen Abbildungen zu tun.

216 Lineare Algebra II – Sommersemester 2017

c Rudolf Scharlau

Beispiel 3.2.4 Wir betrachten eine reelle 2 × 2-Matrix der Gestalt

!

a

b

S=

wobei a, b, ∈ R, a2 + b2 = 1 ,

b −a

sowie die zugehörige lineare Abbildung

FS : R 2 → R 2 ,

~x 7→ S~x .

In Satz 2.10.31 hatten wir behauptet, dass FS eine Spiegelung ist. Insbesondere besitzt FS Fixpunkte, nämlich alle Punkte auf der Geraden,

an der gespiegelt wird. Betrachten der Matrix S − E2 gestattet es, dieses

zu bestätigen und die Fixpunkte unmittelbar zu bestimmen.

Übung. Man zeige, dass auch −1 Eigenwert von FS ist und jeder Eigenvektor zum Eigenwert −1 orthogonal zu jedem Eigenvektor zum Eigenwert 1 ist. Hierbei ist das Standardskalarprodukt auf R2 zugrundegelegt.

Wir beginnen nun damit, die auf K definierte Funktion

λ 7→ det(A − λEn )

genauer zu untersuchen. Die Nullstellen dieser Funktion sind genau die

Werte λ, für die A−λEn nicht regulär ist, d.h. die Nullstellen sind genau

die Eigenwerte.

Beispiel 3.2.5 (Das charakteristische Polynom für n = 2)

!

!

a c

a−λ

c

A=

, A − λE2 =

.

b d

b

d−λ

det(A − λE2 ) = λ2 − (a + d)λ + det A .

Wir erhalten also ein quadratisches Polynom in λ (genauer eine quadratische Polynomfunktion); die Eigenwerte sind die Nullstellen einer

quadratischen Gleichung.

Wie wir gleich sehen werden, erhält man für Matrizen der Größe n entsprechend eine Polynomfunktion vom Grad n. Wir wollen im folgenden

nicht nur die entsprechende Funktion auf K betrachten, sondern λ durch

eine Unbestimmte X ersetzen (vergleiche Kapitel 3.1). Der Grund hierfür ist, dass wir anstelle von X später nicht nur Skalare, sondern auch

andere Objekte, insbesondere Matrizen oder Endomorphismen in das

Polynom einsetzen wollen.

Definition 3.2.6 (Charakteristisches Polynom) Für eine n×n-Matrix A mit Koeffizienten in einem Körper K wird das charakteristische

Polynom als

PA := det(A − XEn )

definiert. Dabei wird dieses Polynom (induktiv über n) durch Entwicklung nach der ersten Spalte gemäß der Formel in 3.1.3 gebildet.

Bemerkung 3.2.7 Das charakteristische Polynom PA einer n×n-Matrix

hat den Grad n, den Leitkoeffizient (−1)n und den konstantem Term

det A.

Beweis: Die ersten beiden Behauptungen ergeben sich mit Induktion

über n sofort aus der Definition. Den konstanten Term a0 eines Polynoms

f erhält man immer als a0 = f (0), also durch Einsetzen von Null. Für

PA ergibt sich definitionsgemäß PA (0) = det A.

Lineare Algebra II – Sommersemester 2017

c Rudolf Scharlau

217

Wir wollen nun die Definition des charakteristischen Polynoms von Matrizen auf Endomorphismen endlich-dimensionaler Vektorräume übertragen. Dieses geschieht, wie nicht anders zu erwarten, mit Hilfe der früher

ausführlich behandelten Darstellungsmatrix. Im Abschnitt 2.8 wurde geA

klärt, wie sich diese Matrix MA

(F ) ändert, wenn wir die Basis A ändern:

Man geht über zu einer ähnlichen Matrix. Wir haben diese Tatsache unter 3.1.14 bereits zur Definition der Determinante eines Endomorphismus

genutzt. Nun geht es um den analogen Sachverhalt für das charakteristische Polynom:

Lemma 3.2.8 Ähnliche Matrizen haben dasselbe charakteristische Polynom.

Beweis: Wir machen für den folgenden Beweis eine zusätzliche, nicht

unbedingt erforderliche Annahme, nämlich dass der Grundkörper K unendlich viele Elemente besitzt. Dann wird der Beweis deutlich einfacher,

weil nach Korollar 1.4.21 jedes Polynom P ∈ K[X] durch die zugehörige

Polynomfunktion Pe : K → K, α 7→ P (α) eindeutig bestimmt ist: Wenn

P (α) = Q(α) für alle α ∈ K ist, dann gilt P = Q (Gleichheit von Polynomen, d.h. Gleichheit aller entsprechenden Koeffizienten). Aus dem

Beweis von 3.1.14 wissen wir schon, dass die Determinanten von ähnlichen Matrizen übereinstimmen: det(SAS −1 ) = det A . Für jedes λ ∈ K

können wir dieses auch auf die Matrix A − λEn anwenden. Wegen

S(A − λEn )S −1 = SAS −1 − λSEn S −1 = SAS −1 − λEn

folgt dann PA (λ) = PSAS −1 (λ), wie behauptet.

Nach der Vorarbeit in Lemma 3.2.8 macht nun die folgende Definition

Sinn:

Definition 3.2.9 Das charakteristische Polynom PF eines Endomorphismus F von V wird definiert als das charakteristische Polynom einer

beliebigen Darstellungsmatrix von F :

PF := PA = det(A − XEn ), wobei A = MBB (F ) ,

und B irgendeine Basis von V ist.

Nun können wir das Hauptergebnis dieses Abschnittes in definitiver Form

formulieren und auch leicht beweisen:

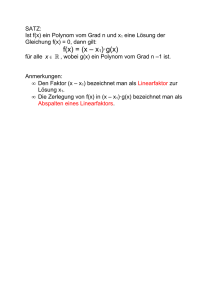

Satz 3.2.10 Es sei K ein Körper und F ein Endomorphismus eines

endlichdimensionalen K-Vektorraumes oder eine n × n-Matrix für ein

n ∈ N. Ein Element λ ∈ K ist ein Eigenwert von F genau dann, wenn

λ Nullstelle des charakteristischen Polynoms von F ist: PF (λ) = 0.

Aus Satz 1.4.20 (über die Anzahl der Nullstellen eines Polynoms) ergibt

sich nun eine oft benutzt einfache Folgerung:

Korollar 3.2.11 Eine quadratische Matrix der Größe n bzw. ein Endomorphismus eines n-dimensionalen Vektorraumes kann höchstens n

verschiedene Eigenwerte haben.

Statt eines Zahlenbeispiels notieren noch folgende allgemeine Folgerung

aus Satz 3.2.10.

Satz 3.2.12 Das charakteristische Polynom einer oberen Dreiecksmatrix A ∈ K n×n ergibt sich als

PA = (−1)n

n

Y

(X − aii ) .

i=1

Ihre Eigenwerte sind genau die Diagonalelemente.

218 Lineare Algebra II – Sommersemester 2017

c Rudolf Scharlau

Beweis: Die Formel für PA ergibt sich mittels Induktion über n unmittelbar aus der von uns gewählten (induktiven) Definition 3.2.6 des

charakteristischen Polynoms durch Entwicklung nach der ersten Spalte.2 Die Aussage über die Eigenwerte folgt dann aus Satz 3.2.10.

2 Den Satz 3.1.6.c) über die Determinante einer oberen Dreiecksmatrix kann man

hier nicht benutzen, weil er (jedenfalls mit dem von uns gegebenen Beweis) keine Unbestimmte X in der Matrix erlaubt. Vergleiche hierzu die Zusatzannahme im Beweis

von Lemma 3.2.8.

Lineare Algebra II – Sommersemester 2017

3.3

c Rudolf Scharlau

Diagonalisierbarkeit

Eine Diagonalmatrix ist eine quadratische Matrix, die nur (höchstens)

auf der Hauptdiagonalen von Null verschiedene Einträge besitzt. In diesem Abschnitt klären wir die Frage, wann ein Endomorphismus F diagonalisierbar ist, das heißt, bezüglich einer geeigneten Basis eine Diagonalmatrix als Darstellungsmatrix besitzt. Direkt aus den Definitionen

folgt, dass eine Darstellungsmatrix von F genau dann Diagonalgestalt

hat, wenn die benutzte Basis vollständig aus Eigenvektoren von F besteht (Bemerkung 3.3.3); die Diagonaleinträge der Matrix sind dann die

Eigenwerte (Bemerkung 3.3.4.c). Die Basisvektoren müssen also in gewissen Unterräumen, den Eigenräumen, liegen. Um diese Fragestellung

vollständig zu behandeln, muss man detaillierte Kenntnisse über „direkte Summen” von Unterräumen haben, die in den Sätzen 3.3.7 und

3.3.9 bereitgestellt werden. Diese haben eigentlich nichts speziell mit

Endomorphismen oder Eigenwerten zu tun, sondern bilden eine Ergänzung zur grundlegenden Theorie von Unterräumen und Basen. Technisch

führen wir hierfür in Definition 3.3.6 zunächst den Begriff der „Unabhängigheit” von Unterräumen ein, der die lineare Unabhängigkeit von

Vektoren verallgemeinert. Dieser Begriff der Unabhängigkeit beschreibt

eine bestimmte relative Lage von zwei oder (vor allem) mehr Unterräumen zueinander: die Unterräume sollten so „disjunkt wie möglich” sein.

In der Literatur gibt es hierfür meistens keine separate Definition, vielmehr wird die entsprechende Bedingung direkt bei der Definition einer

direkten Summe mit behandelt.3 Der Sachverhalt als solcher ist aber allgegenwärtig, und die Vokabel „unabhängig” scheint mir hierfür treffend

zu sein.

Ein weiterer grundlegender Satz 3.3.10 sagt dann, dass die Eigenräume zu den verschiedenen Eigenwerten unabhängig sind (also in üblicher Terminologie eine direkte Summe bilden). Dieses Resultat enthält

die (anschaulich vielleicht leichter zugängliche) Aussage, dass Eigenvektoren zu verschiedenen Eigenwerten linear unabhängig sind (Korollar

3.3.11). Diagonalisierbarkeit von F ist genau dann gegeben, wenn der

aus den Eigenräumen gebildete Summenraum der ganze Vektorraum ist

(Bemerkung 3.3.5). Beide Aussagen zusammengenommen ergeben zunächst einmal, dass man, Diagonalisierbarkeit vorausgesetzt, eine Basis

aus Eigenvektoren erhält, indem man Basen der einzelnen Eigenräume

zusammenfügt (Satz 3.3.12).

Weiter kann man die Frage, wann Digonalsierbarkeit vorliegt, nunmehr auf eine reine Dimensionsbetrachtung reduzieren. Deren Lösung

ergibt sich mit Hilfe der Vielfachheiten der Eigenwerte von F . Es gibt

zwei Sorten von Vielfachheiten: die „algebraische Vielfachheit” von λ, das

ist die Vielfachheit der Nullstelle λ im charakteristischen Polynom, deren Theorie wir aus Satz 1.4.19 kennen, und die „geometrische Vielfachheit”, das ist nach Definition die Dimension des Eigenraumes Eig(F, λ).

Diagonalisierbarkeit ist gegeben, wenn das charakteristische Polynom

in Linearfaktoren zerfällt und für jeden Eigenwert die algebraische mit

der geometrischen Vielfachheit übereinstimmt. Diese ist die Aussage des

letzten und abschließenden Satzes 3.3.14 dieses Abschnittes.

Beispiel 3.3.1 Es sei S eine Matrix wie im Beispiel 3.2.4 (eine 2 × 2Spiegelungsmatrix) und v, w ∈ R2 Eigenvektoren von S zum Eigenwert

1 bzw. −1. Dann ist B = (v, w) eine Basis von R2 , und für die Darstel3 Auch

in diesem Skript war das bis 2016 der Stand der Dinge.

219

220 Lineare Algebra II – Sommersemester 2017

c Rudolf Scharlau

lungsmatrix von FS bzgl. B gilt

MBB (FS )

=

1

0

!

0

.

−1

Die darstellende Matrix hat also außerhalb der Diagonale nur Nullen.

Man sagt auch, die Spiegelung FS ist „diagonalisierbar“. Die allgemeine

Definition lautet wie folgt.

Definition 3.3.2

a) Eine quadratische Matrix D = (dij ) heißt Diagonalmatrix, falls für alle Indizes i, j mit i 6= j gilt dij = 0.

b) Ein Endomorphismus eines endlich-dimensionalen K-Vektorraumes

heißt diagonalisierbar, falls eine Basis B von V existiert, für die

MBB (F ) eine Diagonalmatrix ist.

c) Seien d1 , d2 , . . . , dn Elemente aus K. Dann bezeichnet

Diag(d1 , d2 , . . . , dn ) ∈ K n×n

die Diagonalmatrix, deren Diagonaleinträge d1 , d2 , . . . , dn sind.

Der erste Satz über Diagonalisierbarkeit ist so einfach, dass wir ihn lediglich als Bemerkung betiteln:

Bemerkung 3.3.3 Ein Endomorphismus eines endlich-dimensionalen

Vektorraumes V ist genau dann diagonalisierbar, wenn V eine Basis bestehend aus Eigenvektoren von F besitzt. Genauer gilt für eine beliebige

Basis B von V die Äquivalenz

MBB (F ) ist Diagonalmatrix ⇐⇒ B besteht aus Eigenvektoren von F.

Der Beweis (beide Implikationen) ergibt sich sofort aus der Definition

der Darstellungsmatrix. Klar ist dabei auch, dass die Diagonalemente

der Darstellungsmatrix Eigenwerte sind. Von der Definition her nicht offensichtlich, aber ebenfalls korrekt ist die Tatsache, dass es keine weiteren

Eigenwerte gibt. Hierzu haben wir die nächste Bemerkung.

Bemerkung 3.3.4

a) Der Rang einer Diagonalmatrix ist gleich der

Anzahl ihrer von Null verschiedenen Einträge.

b) Eine Diagonalmatrix ist genau dann invertierbar, wenn alle Diagonalelemente di = dii ungleich Null sind.

c) Die Eigenwerte einer Diagonalmatrix sind genau die Diagonalelemente di .

Beweis: Teil a) ist klar. Teil b) folgt aus a). Ebenso folgt auch c) aus a).

Denn wenn λ ∈ K beliebig ist, dann hat die Diagonalmatrix D − λEn

genau dann eine Null auf der Diagonale, wenn λ gleich einem der di

ist.

Wir bemerken, dass Teil c) sogar allgemeiner für obere Dreiecksmatrizen gilt und aus Satz 3.2.12 bereits bekannt ist. In der Bemerkung soll

betont werden, dass der Sachverhalt für Diagonalmatrizen unabhängig

von Determinanten oder anderen Überlegungen völlig offensichtlich ist.

Man beachte, dass an dieser Stelle die Vielfachheiten der Nullstellen

noch nicht autauchen: Im Allgemeinen werden unter den di gleiche Werte

vorkommen, was hier noch keine Rolle spielt.

Als nächstes formulieren wir ein Kriterium für Diagonalisierbarkeit, das

nicht einzelne Eigenvektoren, sondern die Eigenräume benutzt. Wir erinnern an die Definition des Summenraumes 2.1.11, die sich leicht auf

(gegebenenfalls) mehr als zwei Unterräume U1 , U2 , . . . , Us erweitert:

U1 + U2 + · · · + Us := {u1 + u2 + · · · + us | uj ∈ Uj , j = 1, . . . , s}.

Lineare Algebra II – Sommersemester 2017

c Rudolf Scharlau

221

Der Summenraum ist der kleinste Unterraum des Gesamtraumes V , der

alle Ui enthält. Eine Erzeugendensystem des Summenraumes erhält man,

indem man Erzeugendensysteme der einzelnen Ui zusammenfügt (vergleiche den zweiten Teil des Beweises von 2.9.5). Allerdings erhält man

nicht unbedingt eine Basis des Summenraumes, selbst wenn man mit Basen der einzelnen Ui startet. Dieser Frage werden wir uns gleich zuwenden. Vorher halten wir eine Folgerung dessen fest, was wir schon wissen.

Aus der Bemerkung 3.3.3 folgt nämlich leicht die nächste Bemerkung:

Bemerkung 3.3.5 Ein Endomorphismus eines endlich-dimensionalen

Vektorraumes V ist genau dann diagonalisierbar, wenn der Summenraum aller Eigenräume von F gleich ganz V ist.

Wir wollen im folgenden eine Weiterführung der letzten Bemerkung entwickeln, die (Diagonalisierbarkeit vorausgesetzt) auch die Frage einer

Basis aus Eigenvektoren abschließend klärt. Hierfür soll die für zwei Summanden aus 2.9.6 bereits bekannte „direkte Summe” U1 ⊕ U2 ⊕ · · · ⊕ Us

erklärt werden. Für s = 2 lautete die Bedingung hierfür: U1 ∩ U2 = {0}.

Für s ≥ 3 wäre es eine erste naheliegende Verallgemeinerung zu verlangen, dass Ui ∩ Uj = {0} ist für alle i 6= j. Tatsächlich reicht dieses aber

nicht aus. Die „korrekte” Bedingung an die Ui ist die in der Einleitung

bereits angeprochene Unabhängigkeit der Ui ; sie wird in der folgenden

Definition beschrieben:

Definition 3.3.6 (Unabhängigkeit von Unterräumen) Ein System

U1 , . . . , Ur von Untervektorräumen eines K-Vektorraumes V heißt unabhängig, falls folgendes gilt:

Ui ∩ Vi = {0} für alle i ∈ {1, . . . , r}

wobei

Vi = U1 + · · · + Ui−1 + Ui+1 + · · · + Ur

die Summe der Uj , j 6= i ist.

Ähnlich wie bei der linearen Unabhängigkeit von Vektoren sagt man

etwas lockerer auch „die Unterräume U1 , . . . , Ur sind unabhängig”. Wie

der folgende Satz zeigt, hat die Unabhängigkeit von Unteräumen eng

mit der linearen Unabhängikeit von Vektoren zu tun (deswegen auch die

Namensgebung).

Satz 3.3.7 Für ein System U1 , . . . , Ur von r Untervektorräumen eines

K-Vektorraumes V sind die folgenden drei Bedingungen äquivalent:

(i) U1 , U2 , . . . , Ur sind unabhängig im Sinne der Definition 3.3.6.

(ii) Für alle Vektorsysteme u1 , . . . , ur mit ui ∈ Ui gilt:

u1 + u2 + · · · + ur = 0 =⇒ ui = 0 für alle i ∈ {1, . . . , r}.

(iii) Von Null verschiedene Vektoren uij ∈ Uij , j = 1, . . . , s sind immer

linear unabhängig.

Die Aussage (iii) ist so zu verstehen, dass man in gewissen der Ui , etwa

U1 , U3 , U5 jeweils einen Vektor wählt, deshalb die Doppelindices ij (im

Beispiel ist s = 3).

Beweis: siehe Vorlesung.

Definition 3.3.8 Ein Vektorraum V heißt direkte Summe von r Untervektorräumen U1 , U2 , . . . , Ur , in Zeichen V = U1 ⊕ U2 ⊕ · · · ⊕ Ur , falls

222 Lineare Algebra II – Sommersemester 2017

c Rudolf Scharlau

(i) V = U1 + U2 + · · · + Ur

(ii) Die r Unterräume U1 , . . . , Ur sind unabhängig im Sinne der Definition 3.3.6.

Für zwei Unterräume, also r = 2, stimmt diese Definition mit der früheren Definition 2.9.6 überein.

Hier ein ganz simples Konstrastbeispiel: Es seien U1 , U2 , U3 drei verschiedene Geraden im R2 . Dann ist Ui ∩Uj = {0} für alle i 6= j, aber trotzdem

ist das System aller drei Unterräume nicht unabhängig. Zum Beispiel ist

U1 ∩ V1 = U1 ∩ (U2 + U3 ) = U1 ∩ R2 = U1 6= {0}. Dementsprechend ist

R2 nicht die direkte Summe von U1 , U2 und U3 .

Die definierende Eigenschaft einer direkten Summe, also die Unabhängigkeit der benutzten Unterräume, hat einige Konsequenzen, die wir im

nächsten Satz festhalten.

Satz 3.3.9 (Eigenschaften einer direkte Summe) Es sei V ein endlich-dimensionaler K-Vektorraum, U1 , . . . , Ur ein unabhängiges System

von Untervektorräumen. Wir betrachten den Summenraum

V 0 := U1 + U2 + · · · + Ur = U1 ⊕ U2 ⊕ · · · ⊕ Ur

Dann gilt folgendes:

a) Für jedes v ∈ V 0 existieren eindeutige Vektoren u1 , . . . , ur mit ui ∈

Ui und v = u1 + u2 + · · · + ur .

b) Für jede Wahl von Basen

u11 , . . . , u1n1

u21 , . . . , u2n2

...

ur1 , . . . , urnr

von U1

von U2

von Ur

ist das zusammengesetzte Vektorsystem

u11 , . . . , u1n1 , u21 . . . , u2n2 , . . . , ur1 . . . , urnr

eine Basis von V 0 .

c) dim V 0 = dim U1 + dim U2 + · · · + dim Ur

Beweis: a) Übungsaufgabe; b) siehe Vorlesung; c) folgt aus b).

Wir kehren nun zu den Eigenvektoren zurück und beweisen den folgenden

grundlegenden Satz, der später in der Normalformentheorie noch stark

verallgemeinert wird (siehe Satz 3.5.7).

Satz 3.3.10 Es seien λ1 , . . . , λs verschiedene Eigenwerte von F ∈ End V .

Dann sind die Eigenräume Eig(F, λi ), i = 1, . . . , s unabhängig (gemäß

Definition 3.3.6).

Beweisskizze: Man zeigt die Bedingung (ii) des Satzes 3.3.7; für Details

verweisen wir auf die Vorlesung.

Das folgende Korollar folgt sofort aus Aussage (iii) des Satzes 3.3.7.

Korollar 3.3.11 Eigenvektoren zu verschiedenen Eigenwerten sind linear unabhängig.

Lineare Algebra II – Sommersemester 2017

c Rudolf Scharlau

Umgekehrt impliziert die Aussage dieses Korollars nach Satz 3.3.7 auch

die volle Behauptung des Satzes 3.3.10. 4 Für sich genommen liefert

das Korollar für die meisten Zwecke eine zu schwache Aussage. In der

Anwendung auf Normalformen werden die Aussagen b) und c) aus 3.3.9

benötigt.

Das Korollar 3.3.11 reicht aus, um einen neuen Beweis von Korollar

3.2.11 zu geben. Es seien nämlich λ1 , . . . , λs verschiedene Eigenwerte von

F ∈ End V . Wähle zu jedem λi einen Eigenvektor ui . Diese Vektoren sind

nach dem Korollar linear unabhängig. Ihre Anzahl s kann also höchstens

gleich der Dimension von V sein.

Aus Satz 3.3.10 und Teil b) von Satz 3.3.9 folgt nun unmittelbar die oben

angekündigte Verbesserung der Wenn-Aussage in Bemerkung 3.3.5.

Satz 3.3.12 Es sei F ein diagonalisierbarer Endomorphismus des endlich-dimensionalen K-Vektorraumes V . Dann erhält man eine Basis von

V , die aus Eigenvektoren von F besteht, indem man Basen der einzelnen

Eigenräume zusammenfügt.

Da Basen eines Eigenraumes rechentechnisch Basen eines Kerns sind,

löst dieser Satz auch das praktische Problem der Diagonalisierbarkeit

einer Matrix, nämlich die Berechnung einer Transformationsmatrix S,

die die Ähnlichkeit zu einer Diagonalmatrix vermittelt: Wenn die Spalten von S eine Basis von K n aus Eigenvektoren von A ∈ K n×n sind,

dann ist S −1 AS eine Diagonalmatrix. (Man mache sich klar, dass das

gerade beschriebene S in dieser Formel tatsächlich rechts von A steht,

und dementsprechend S −1 links.)

Die bisherigen Auführungen dieses Kapitels haben noch keine tieferliegende Aussage gemacht, wann Diagonalisierbarkeit wirklich vorliegt.

Die Beantwortung dieser Frage erfordert einen genaueren Blick auf das

charakteristische Polynom.

Definition 3.3.13 Es sei F ein Endomorphismus eines endlich-dimensionalen Vektorraumes oder eine quadratische Matrix. Die Vielfachheit

m = m(λ, PF ) einer Nullstelle λ ∈ K des charakteristischen Polynoms

PF heißt auch algebraische Vielfachheit des Eigenwertes λ. Es ist also

PF = (X − λ)m · g, mit g ∈ K[X], g(λ) 6= 0 .

Die Dimension des Eigenraumes Eig(F, λ) heißt in diesem Zusammenhang auch geometrische Vielfachheit von λ.

Der folgende Satz klärt den Zusammenhang zwischen den beiden Vielfachheiten und darüber hinaus zumindest im Prinzip die Frage der Diagonalisierbarkeit. Der Teil b) beruht wesentlich auf unserer detaillierten

Untersuchung von direkten Summen in Satz 3.3.9 sowie dem Satz 3.3.10.

Satz 3.3.14

a) Die geometrische Vielfachheit eines Eigenwertes ist

höchstens gleich seiner algebraischen Vielfachheit:

dim Eig(F, λ) ≤ m(λ, PF ) für alle λ ∈ K.

b) Ein Endomorphismus oder eine Matrix F ist genau dann diagonalisierbar, wenn die beiden folgenden Bedingungen erfüllt sind:

4 In der Literatur wird tatsächlich in diesem Kontext oft nur das Korollar formuliert. Mir scheint es aber den wesentlichen Punkt nicht genau zu treffen, das tut schon

eher die Bedingung (ii) des Satzes 3.3.7.

223

c Rudolf Scharlau

224 Lineare Algebra II – Sommersemester 2017

- das charakteristische Polynom PF zerfällt in Linearfaktoren,

PF = (−1)n

r

Y

i=1

(X − λi )mi , wobei

r

X

mi = n = dim V ,

i=1

- für jeden Eigenwert λ von F stimmt die geometrische Vielfachheit mit der algebraischen Vielfachheit überein:

dim Eig(F, λ) = m(λ, PF ).

Beweis zu Teil a): siehe Vorlesung.

Beweis zu b): Im Wesentlichen geht es nur noch um die Implikation

„⇐”, also die Wenn-Aussage. Wir bezeichnen mit V 0 den Summenraum

aller Eigenräume. Nach Bemerkung 3.3.5 wollen wir zeigen, dass V 0 = V

ist. Hierzu reicht es zu zeigen, dass dim V 0 = dim V ist. Nach Satz 3.3.10

und Teil b) von Satz 3.3.9 ist dim V 0 die Summe der Dimensionen der

einzelnen Eigenräume. Diese Dimensionen sind nach Voraussetzung die

Zahlen mi , i = 1, . . . , r aus dem Satz (die algebraischen Vielfachheiten).

Deren Summe ist aber, wie im Satz bereits festgehalten, gleich dim V .

Also ist dim V 0 = dim V , wie gewünscht.

Das nächste Korollar folgt zwar schon aus dem früheren Korollar 3.3.11,

illustriert aber auch in einem einfachen Spezialfall, was im letzten Satz

passiert.

Korollar 3.3.15 Wenn ein Endomorphismus F eines n-dimensionalen

Vektoraumes n verschiedene Eigenwerte besitzt, dann ist F digonalisierbar.

Beweis (mittels Satz 3.3.14): Da das charakteristische Polynom den

Grad n und nach Voraussetzung n verschiedene Nullstellen hat, muss

es in Linearfaktoren zerfallen, und für jede Nullstelle λ (also für jeden

Eigenwert von F ) kann die (algebraische) Vielfachheit nur noch 1 sein.

Die geometrische Vielfachheit ist nach Teil a) des Satzes höchstens so

groß, andererseits ungleich 0, weil λ Eigenwert ist. Also stimmen beide

Vielfachheiten überein (sind beide gleich 1), und die Behauptung des

Korollars folgt aus dem Satz.