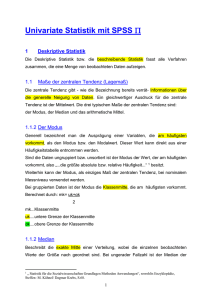

Skript zur Vorlesung „Statistik 1“ (Prof. Dr. Christoph Stahl

Werbung

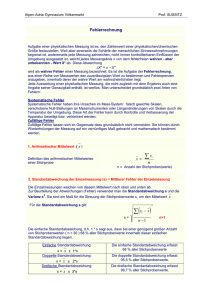

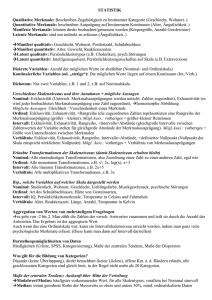

Weder die Autorin noch der Fachschaftsrat Psychologie übernimmt Irgendwelche Verantwortung für dieses Skript. Das Skript soll nicht die Lektüre der Prüfungsliteratur ersetzen. Verbesserungen und Korrekturen bitte an [email protected] mailen. Die Fachschaft dankt der Autorin im Namen aller Studierenden! Version 1.0 (2011) Skript zur Vorlesung „Statistik 1“ (Prof. Dr. Christoph Stahl) Wintersemester 2009/10 verfasst von Kim K. 2 Statistik Vorlesung 1. Vorlesung Messen = Zuordnung von Zahlen zu Merkmalsausprägungen; empirisches Relativ wird in ein numerisches Relativ abgebildet Abbildungsfunktion = Regel, nach der diese Zuordnung erfolgt Skala = numerisches Relativ Homomorphe Abbildung = jedem Objekt aus dem empirischen Relativ wird genau eine Zahl im numerischen Relativ zugeordnet; Relationen zwischen den Messobjekten werden durch Relationen zwischen zugeordneten Zahlen ausgedrückt Variable = Ergebnis der Messung Datensatz = Zusammenfügen der Ergebnisse verschiedener Messungen Skalenniveaus = 5 verschiedene; unterscheiden sich hinsichtlich der empirischen Relationen, die sie abbilden; Messgenauigkeit/Aussagekraft der Daten steigt; Daten sollten auf einem möglichst hohen Skalenniveau erfasst werden; hängt ab vom erhobenen Merkmal und der Abbildungsfunktion (Messvorschrift) Nominalskala: gleich/verschieden - Annahmen: Exklusivität (Unterschiedliche Merkmalsausprägungen unterschiedliche Zahlen) & Exhaustivität (jeder beobachteten Merkmalsausprägung wird eine Zahl zugeordnet) „Homomorphe“ Abbildung - Aussagen: Gleichheit/Verschiedenheit eines Merkmals - Transformationen: alle eineindeutigen - Bsp.: Geschlecht; klin. Diagnosen Ordinalskala: größer/kleiner; zusätzlich: - Annahmen: zugeordnete Zahlen repräsentieren Rangreihe der Merkmalsausprägung - Aussagen: Größer / Kleiner Relationen - Transformationen: alle monotonen - Bsp.: Sitzreihe, Rangplätze Intervallskala: Differenzen; zusätzlich: - Annahmen: Gleich große Intervalle zwischen Zahlenwerten der Variable repräsentieren gleich große Abstände in der Merkmalsausprägung - Aussagen: Interpretation der Größe von Unterschieden zwischen Merkmalsausprägungen - Transformationen: Alle linearen - Bsp: Ratingskala (?), Temperatur (in °C) Verhältnisskala: Verhältnisse; zusätzlich: - Annahmen: Die Skala hat einen definierten/natürlichen Null-Punkt - Aussagen: Interpretation des Verhältnisses von Merkmalsausprägungen - Transformationen: Alle multiplikativen (Ähnlichkeitstransformationen) - Bsp.: Alter, Reaktionszeit Absolutskala: Maßeinheit; zusätzlich: - Annahmen: Die Skala hat eine natürliche Maßeinheit - Aussagen: Interpretation der Merkmalsausprägung selbst: Häufigkeiten! - Transformationen: keine möglich - Bsp.: Häufigkeiten Bei der Erfassung vieler psychologischer Merkmale (z.B mittels Rating-Skalen): Intervallskalenniveau 3 2. Vorlesung Deskriptive Statistik = Gruppe statistischer Methoden zur Beschreibung statistischer Daten anhand statistischer Kennwerte, Graphiken, Diagrammen oder Tabellen; bezieht sich immer auf eine Stichprobe Stichprobe = Personen, die tatsächlich untersucht bzw. beobachtet wurden Inferenzstatistik = zieht aus Stichprobendaten Schlüsse auf zugrundeliegende Population Urliste = alle Werte einer Stichprobe; Darstellung der Verteilung: Zusammenfassung in Häufigkeitstabelle Oft hat ein Merkmal zu viele Ausprägungen, um für jede einzelne die Häufigkeit anzugeben Kategorien Kategorien = disjunkt (keine Überlappung); direkt benachbart (keine Lücken); an Rändern sind „offene“ Kategorien (z.B. <50) erlaubt; alle geschlossenen Kategorien sind gleich breit; je größer Stichprobe, desto mehr und desto schmalere Kategorien werden gebildet, in der Regel nicht mehr als 20 Scheinbare Kategoriegrenzen = Kategoriegrenzen enthalten Lücken, aber: wenn auf diskreter Variable beruht keine „Zwischenwerte“ möglich Kategoriegrenzen ausreichend Wahre Kategoriegrenzen = Intervalle werden mathematisch exakt angegeben; sollte immer bei kontinuierlichen Variablen geschehen Maße der zentralen Tendenz = geben an, wie ein Merkmal bei den meisten Mitgliedern einer Stichprobe bzw. in dieser Stichprobe im Durchschnitt ausgeprägt ist; - Modalwert (für mindestens nominalskalierte Daten) - Median (für mindestens ordinalskalierte Daten) - Mittelwert (für mindestens intervallskalierte Daten) Modalwert (Mo) = Wert, der am häufigsten vorkommt; es kann auch mehrere geben; bei kategorisierten Daten wird die Mitte der am häufigsten besetzten Kategorie angegeben; besonders bei nominalskalierten Daten sinnvoll Median = Wert, der geordnete Reihe der Messwerte in die obere und die untere Hälfte aufteilt; Anzahl der Messwerte drüber und drunter gleich; ab Ordinalskalenniveau Arithmetisches Mittel = Summe aller Messwerte geteilt durch deren Anzahl N; zulässig ab Intervallskalenniveau Rechtssteile Verteilung = AM, Median, Modalwert Linkssteile Verteilung = Modalwert, Median, AM Symmetrische Verteilung = alle mittig Statistische Kennwerte = dienen der vereinfachten Darstellung von Daten Maße der zentralen Tendenz lassen auch Rückschlüsse auf die Verteilungsform zu 3. Vorlesung: Maße der Dispersion = beziehen sich auf „Variabilität“ einer Verteilung Variationsbreite (Spannweite, Range) = Geringe Aussagekraft über Verteilung, da nur 2 Werte berücksichtigt werden; hohe Empfindlichkeit gegenüber Ausreißerwerten - Für kontinuierliche Variablen: Range = maximaler Wert – minimaler Wert - Für diskrete Variablen: Range = maximaler Wert – minimaler Wert + 1 (entspricht Kategorienanzahl) Quartile = Punkte einer Verteilung, die geordnete Liste von Werten in 4 Bereiche mit je 25% der SP einteilen; Q2 entspricht Median; ab Ordinalskalenniveau Interquartilabstand = Abstand zwischen dem 1. und dem 3. Quartil; Maß für den „Kernbereich“ einer Verteilung; in ihm liegen 50% der SP; IQA = Q3 – Q1 Varianz (s2) = wichtigstes Maß für die Dispersion; jeder einzelne Wert wird berücksichtigt (wie weit ist jede individuelle Merkmalsausprägung vom Mittelwert der Verteilung entfernt?); mittlere quadrierte Abweichung vom Gesamtmittelwert; ab Intervallskalenniveau; durch Bildung der Quadrate schwer zu interpretieren Standardabweichung (s) = Quadratwurzel aus der Varianz Verteilungsformen = Range, Interquartilabstand, Varianz und Standardabweichung sind Maße für Variabilität einer Verteilung; sagen aber noch nichts über konkrete Form der Verteilung aus Vergleich der Kennwerte der zentralen Tendenz – Modus, Median, Mittelwert – erlaubt Rückschlüsse auf Verteilungsform - rechtssteile Verteilung: AM < Median < Modus 4 - linkssteile Verteilung: Modus < Median < AM - symmetrische Verteilung: alle mittig Schiefe = linkssteil vs. rechtssteil - a3 < 0 rechtssteil - a3 = 0 symmetrisch - a3 > 0 linkssteil Exzess (Kurtosis) = breitgipflig vs. schmalgipflig - a4 < 0 breitgipflig - a4 = 0 Normalverteilung - a4 > 0 schmalgipflig Zentrale Momente dritter und vierter Ordnung (Potenzmomente) = Zur Berechnung von Schiefe & Exzess - Zentrales Moment 1. Ordnung: (xi -xquer) - Zentrales Moment 2. Ordnung: (xi -xquer)2 Varianz 3 Schiefe - Zentrales Moment 3. Ordnung: (xi -xquer) - Zentrales Moment 4. Ordnung: (xi -xquer)4 Exzess Graphische Darstellung der Verteilungsform = Histogramm, Stem-Leaf-Plot, Boxplot Histogramm = zeigt (ausschließlich) Häufigkeiten der in einer Verteilung vorkommenden Werte eines Merkmals; es können Kategorien gebildet werden (d.h. verschiedene benachbarte Werte werden zu einer Säule zusammengefasst); gut geeignet für kontinuierliche Variablen (Annäherung an WS-dichteverteilung) Stem-and-Leaf-Plot = exakte Werte der Probanden werden abgebildet; Werte, die sich nur auf der letzten Ziffer unterscheiden, werden in einer Zeile hintereinander dargestellt (wie ein um 90°gedrehtes Histogramm); jede Zeile ist folgendermaßen aufgebaut: - Ganz vorne steht Anfang der Zahl („stem“), den alle Probanden in der Zeile gemeinsam haben - Anschließend wird für jeden Wert, der in diese Zeile gehört, nur die letzte Ziffer dargestellt („leaf“) Boxplot = stellen viele Verteilungsinformationen gleichzeitig dar; man sieht Median, Interquartilabstand, Variationsbreite und Ausreißer- und Extremwerte Ausreißer = Werte, die mehr als das 1.5fache des Interquartilabstandes unter Q1 oder über Q3 liegen Extremwerte = Werte, die mehr als das 3fache des Interquartilabstandes unter Q1 oder über Q3 liegen Beispiel: Q1 = 30; Q3 = 38; IQA = 8 Ausreißer: x < 18 oder x > 50; Extremwerte: x < 6 oder x > 62 4. Vorlesung Bivariate Deskriptivstatistik = Beschreibung von zwei Variablen gemeinsam, also ihrem Zusammenhang; statistische Kennwerte: Kovarianz und Korrelation; graphische Darstellung: Streudiagramm Scatterplot/Streudiagramm = graphische Darstellung von Zusammenhängen zwischen zwei Variablen positiver Zusammenhang = hoher X-Wert hoher Y-Wert negativer Zusammenhang = hoher X-Wert niedriger Y-Wert Form des Zusammenhang = z.B. linear (Y = aX+b) , quadratisch (Y = aX²+bX+c), kubisch Richtung des Zusammenhangs = positiv (Y = aX+b; a>0), negativ (Y = aX+b ; a<0) Stärke des Zusammenhangs = stark (Punkte nah beineinander), schwach (Punkte weit gestreut) Kovarianz und Korrelation = Maße für die Stärke des linearen Zusammenhangs zwischen zwei Variablen; je stärker der Zusammenhang, desto größer sind Kovarianz und Korrelation - Positiv: hoher Wert auf einer Variable geht häufig mit hohem Wert auf der anderen Variable einher - Negativ: hoher Wert auf einer Variable geht häufig mit niedrigem Wert auf der anderen Variable einher Voraussetzungen: - Intervallskalenniveau beider Variablen - Normalverteilung beider Variablen - Homoskedastizität (Normalverteilung von y für alle Untersuchungsobjekte, die gleichen x-Wert haben) - es können nur lineare Zusammenhänge beschrieben werden Kovarianz = „gemeinsame Varianz“; Maß für Zusammenhang zweier (mindestens intervallskalierter) Variablen; unstandardisiertes Maß, d.h. sie hängt von der Skalierung der beteiligten Variablen ab; können weder (a) direkt interpretiert noch (b) zwischen unterschiedlichen Untersuchungen verglichen werden Produkt-Moment-Korrelation = Korrelationskoeffizient nimmt Werte zwischen +1 und -1 an; zeigen nur einen statistischen Zusammenhang; können nicht als Beleg für Kausalität verwendet werden; nicht intervallskaliert; 5 zentrale Tendenz zweier Korrelationen ist nicht als deren arithmetisches Mittel berechenbar; Differenzen (Abstände bzw. Intervalle) zwischen Korrelationskoeffizienten sind nicht interpretierbar (z.B. Unterschiede zwischen zwei Korrelationskoeffizienten) - r = +1 perfekt positiver Zusammenhang - r = 0 kein Zusammenhang - r = -1 perfekt negativer Zusammenhang Zusammenhänge können bedeuten, dass… - sich „A“ auf „B“ auswirkt. - sich „B“ auf „A“ auswirkt. - „A“ und „B“ beide von einem dritten Merkmal „C“ beeinflusst werden Fishers Z-Werte = Transformation der Korrelationskoeffizienten in (annähernd) intervallskalierte Werte; annähernd normalverteilt; berechnen oder in Tabelle nachschlagen - Berechnung/Nachschlagen von Fishers Z für die einzelnen Korrelationen - Berechnung des (gewichteten) Mittelwertes der Z-Werte - Rücktransformation des arithmetischen Mittels in einen Korrelationskoeffizienten Determinationskoeffizient (r²) = quadrierte Korrelation; relativer Anteil gemeinsamer Varianz zweier Merkmale Latente Merkmale = nur indirekt über assoziierte manifeste Merkmale erfassbar (Bsp. Angst) Dichotom = zweifach gestuft (z.B. männlich, weiblich) Polytom = mehrfach gestuft (z.B. Diagnose: Schizophrenie, Depression, Angststörung, …) Künstliche Dichotomisierung = ein ordinal- oder intervallskaliertes Merkmal wird in 2 Wertebereiche aufgeteilt („gesplittet“) (z.B. am Median, sog. „Median-Split“) Spearmans Rangkorrelation = Alle Variablen werden vor der Berechnung in eine Rangreihe (Rang 1 bis N) transformiert; Wenn Rangplätze mehrfach besetzt sind („Rangbindung“), sollte sie nicht verwendet werden, sondern Kendalls т Voraussetzungen: - zwei Variablen (x, y) als Rangreihe - eine intervallskalierte und eine ordinalskalierte Variable - bei intervallskalierten Variablen, wenn keine Normalverteilung vorliegt Cramérs Index = Zusammenhang zweier polytomen nominalskalierten Variablen; Werte zwischen 0 und 1 5. Vorlesung Lineare Regression = Ziel ist Vorhersage einer Variable y durch eine Variable x; nur möglich, wenn x und y miteinander korrelieren; es wird eine Gerade ermittelt, die den Zusammenhang zwischen x und y beschreibt; mit dieser kann zu jedem Wert von x ein Wert von y vorausgesagt werden Kriteriumsvariable y = vorherzusagende Variable Prädiktorvariable x = zur Vorhersage verwendete Variable Allgemeine Geradenfunktion = y = bx + a (b = Steigung; a = y-Achsen-Abschnitt/Höhenlage) Vorhersagefehler (Residuum) ei = Differenz zwischen geschätztem und tatsächlichem y-Wert Methode der kleinsten Quadrate = a und b werden so gewählt, dass der quadrierte Vorhersagefehler über alle Probanden minimal ist; Differenz der tatsächlichen von den vorhergesagten y-Werten wird also quadriert Abweichungswerte sind immer positiv; große Abweichungen werden stärker berücksichtigt als kleine Standardschätzfehler = Maß dafür, wie stark wahre y-Werte von vorhergesagten Werten abweichen; Standardabweichung der Residuen; Streuung der y-Werte um die Regressionsgerade - Je größer die Streuung des Kriteriums, desto größer der Standardschätzfehler - Je größer die Korrelation zwischen Prädiktor und Kriterium, desto kleiner ist der Standardschätzfehler. Kreuzvalidierung = Verfahren zur Überprüfung der „externen“ Validität (Generalisierbarkeit) einer Regressionsgleichung; wichtig, da Regressionskoeffizienten häufig stichprobenabhängig sind; prüft Gültigkeit der Gleichung für eine neue SP; Güte der Regressionsgleichung (z.B. Standardschätzfehler) für beide Stichproben vergleichbar? 2 SP nötig (S1 und S2 oder nur aufgeteilte S1) - Berechnung der Regressionsgleichung R1 anhand S1 und R2 anhand S2 - Anwendung der Regressiongleichung R1 auf S2 und R2 auf S1 - Vergleich der vorhergesagten Kriteriumswerte mit den wahren Kriteriumswerten in S2 und S1 - Regressionsgleichungen vergleichbar? Standardschätzfehler vergleichbar? 6 6. Vorlesung Erklärte Varianz = Varianzanteil von Y, der durch X vorhergesagt/„aufgeklärt“ werden kann Nicht-erklärbare Varianz= Y-Varianzanteil, der nicht mit X zusammenhängt; Varianz d. Regressionsresiduen Multiple Korrelation = Zusammenhang mehrerer Variablen untereinander; Voraussetzung für Multiple Regression Partialkorrelation rxy.z = Zusammenhang zwischen x und y nach Eliminieren der Drittvariablen z; Regression (Vorhersage von x und y durch Prädiktor z) Korrelation der Residuen (Restvarianz ohne Einfluss von z) quadrierte Partialkorrelation r2xy|z = Anteil gemeinsamer Varianz, der von der Drittvariable unabhängig ist Semipartialkorrelation ry(x|z) = Zusammenhang zweier Variablen x und y, nachdem eine Drittvariable z nur aus einer der beiden Variablen herauspartialisiert wurde quadrierte Semipartialkorrelation r²y(x|z) = Anteil der Varianz von y, den die Variable x zusätzlich zu einer Drittvariable z erklärt Multiple Korrelation Ry.xz = Summe der Semipartialkorrelationen Multipler Korrelationskoeffizient R = vereinigter Zusammenhang aller Prädiktoren (x, z) mit dem Kriterium (y) Multipler Determinationskoeffizient R² = Anteil der durch alle Prädiktoren gemeinsam aufgeklärten Kriteriumsvarianz Nullkorrelation = R = R² = 0 Kein Prädiktor klärt Varianz auf Inkrementelle Validität = Variable besitzt inkrementelle Validität, wenn ihre Aufnahme als zusätzlicher Prädiktor den Anteil aufgeklärter Varianz (R²) am Kriterium (substantiell) erhöht (=die Vorhersage verbessert) 7. Vorlesung Zufallsexperiment = prinzipiell beliebig oft wiederholbarer Versuch, dessen Ergebnis vom Zufall abhängt Wahrscheinlichkeit = Grenzwert des relativen Anteils „günstiger“ Ereignisse an den möglichen Ereignissen; kann über relative Häufigkeiten geschätzt werden; p(A) ist ein „Schätzer“ für die Wahrscheinlichkeit π(A); Schätzungsgenauigkeit wächst mit N („Gesetz der großen Zahlen“) Laplacesches Prinzip = Wahrscheinlichkeit als relativer Anteil der „günstigen Fälle“ an allen möglichen Ereignissen; variiert zwischen 0 und 1 Additionstheorem = p(A B) = p(A) + p(B) − p(A B) Disjunkte Ereignisse = p(A B) = p(A) + p(B) Bedingte Wahrscheinlichkeit = gibt an, wie wahrscheinlich ein Ereignis ist unter der Bedingung, dass ein anderes Ereignis gegeben ist; p (A│B) = p(A B) / p(B) Multiplikationstheorem = Wahrscheinlichkeit, dass zwei Ereignisse A und B gemeinsam eintreten - p(A B) = p(B) . p(A│B) - p(A B) = p(A) . p(B│A) Stochastische Unabhängigkeit = Wahrscheinlichkeit für Ereignis A nicht vom Eintreten von Ereignis B beeinflusst; p(A) = p (A│B) = p (A│non-B) Bayes-Theorem = erlaubt es, die bedingten Wahrscheinlichkeiten p(A|B) und p(B|A) in Beziehung zu setzen 8. Vorlesung diskrete Wahrscheinlichkeitsverteilung = gibt für jeden Wert der Variablen einer diskreten Variable (jedes Ereignis des Zufallsexperiments) die Auftretenswahrscheinlichkeit an stetige Wahrscheinlichkeitsdichteverteilung = beschreibt Zufallsexperiment mit unendlich vielen möglichen Ereignissen; jedes einzelne Ereignis hat unendlich kleine WS; WS können immer nur in Bereichen (Intervallen) angegeben werden; Kurve selbst beschreibt WS-Dichte; Fläche unter der Kurve gibt WS an; Gesamtfläche unter Kurve = 1; Fläche für einen bestimmten Wertebereich von x gibt WS an, dass Ereignis in diesem Wertebereich „landet“ Normalverteilung = „glockenförmiger“ Verlauf; symmetrisch; „normaler“ Exzess; wichtigste stetige WSVerteilung; wird von 2 Parametern definiert: - Mittelwert (μ) gibt die Position des „Gipfels“ an - Streuung oder Standardabweichung (σ) gibt die Breite der Verteilung an Standardnormalverteilung (SNV) = Normalverteilung mit μ=0 und σ=1 7 Standardisierung = Transformation einer NV in eine SNV mit Hilfe von z-Werten; xneu = zx = xalt – μ / σ z-Werte = Werte der SNV; Interpretation: Abstand vom Mittelwert in Standardabweichungs-Einheiten Prozentrang = gibt an, wie viel Prozent der Population Werte kleiner oder gleich einem kritischen Wert haben 9. Vorlesung deskriptive Statistik = bezieht sich immer auf eine SP Stichprobe = Personen, die tatsächlich untersucht/beobachtet wurde Inferenzstatistik = zieht aus den in einer SP erhobenen Daten Schlüsse auf die zugrundeliegende Population Stichprobenkennwerte = Mittelwert, Median, Standardabweichung, Varianz, …; können als Schätzer für entsprechenden Populationskennwerte verwendet werden; Je größer SP, desto genauer die Schätzung Stichprobenkennwerteverteilung (SKV) = „Verteilung der Mittelwerte“ von SP; aus einer SP ergibt sich jeder Kennwert nur einmal immer wieder SP aus gleicher Population jedes Mal ein neuer Kennwert (z.B. Mittelwert) Zentraler Grenzwertsatz = SKV: asymptotisch normalverteilt; unendlich viele SP: SKV identisch mit einer NV Mittelwert der SKV = identisch mit dem Mittelwert der Messwerte in der Population Standard(schätz)fehler des Mittelwertes = Standardabweichung der SKV der Mittelwerte; gibt an, wie nah empirischer SP-Mittelwert am Mittelwert der SKV und damit am Populationsmittelwert liegt; kann direkt berechnet werden, ohne dass man mehrere SP erheben muss Konfidenzintervall = Da Mittelwert der SKV unbekannt ist, wird ein Intervall um den SP-Mittelwert angegeben, in dem dieser Mittelwert mit einer bestimmten WS liegt Rückschluss von SP auf Population = Vorgehen: - Erheben eines Merkmals an einer SP - Berechnung des Stichprobenkennwertes (M) - Berechnung des Standardfehlers des Mittelwerts - mithilfe des Standardfehlers wird das Konfidenzintervall bestimmt darin befindet sich mit bestimmter - WS der Mittelwert der SKV - Dieser Mittelwert entspricht dem Mittelwert der Population 10. Vorlesung Wichtige, zentrale Punkte: - Der Populationsmittelwert entspricht dem Mittelwert der SKV des Mittelwerts - Jeder Mittelwert einer SP entstammt einer SKV, deren Mittelwert dem Mittelwert des Merkmals in der Population entspricht. - Der Mittelwert der SKV ist unabhängig von der SP-Größe: Für ein gegebenes Merkmal in einer gegebenen Population haben alle SKV denselben Mittelwert. (Der Mittelwert jeder SKV der Mittelwerte entspricht dem Mittelwert des Merkmals in der Population.) - Man sagt: „der Erwartungswert des SP-Mittelwerts entspricht dem Populationsmittelwert“, oder „der SP-Mittelwert ist ein erwartungstreuer Schätzer des Populationsmittelwerts“, oder E(M) = μ - Die SKV des Mittelwerts ist annähernd normalverteilt - Verteilungsform der SKV des Mittelwerts ist unabhängig von Verteilungsform d Merkmals in Population - Ab einer Stichprobengröße von n>30 gilt die SKV des Mittelwerts als näherungsweise normalverteilt - Zentraler Grenzwertsatz: „Die Verteilung der SP-Mittelwerte aus SP des Umfanges n aus derselben Population geht mit zunehmendem Stichprobenumfang in eine Normalverteilung über.“ 8 - Das Konfidenzintervall um einen „zufällig gezogenen“ Stichprobenmittelwert enthält mit einer bestimmten Wahrscheinlichkeit den Populationsmittelwert - SKV ist normalverteilt: ein zufällig gezogener SP-Mittelwert M liegt mit p=.68 im Intervall von +- 1 SE um den Mittelwert der SKV - Wenn der SP-Mittelwert M in diesem Bereich liegt (mit p=.68), dann umfasst das Konfidenzintervall M +- 1 SE den Mittelwert der SKV - Wenn der SP-Mittelwert M außerhalb dieses Bereichs liegt (mit p=1-.68=.32), dann umfasst das Konfidenzintervall M +- 1 SE den Mittelwert der SKV nicht - Mittelwert der SKV (und der Population) liegt mit einer bestimmten WS im Konfidenzintervall um den SP-Mittelwert M Welchen Mittelwert hat das Merkmal in der Population? - SP-Mittelwert ist ein erwartungstreuer Schätzer des Populationsmittelwerts - Mittelwert des Merkmals in Population liegt mit bestimmter WS im Konfidenzintervall um SPMittelwert - Stammt eine zufällig gezogene SP aus der gegebenen Population? - Kern des Signifikanztests - fragt nach WS eines empirischen Werts unter bestimmten Annahmen Grundlagen des Signifikanztests = Hypothesen (z.B. H1: μP > μA bzw. H0: μP ≤ μA); Prüfverteilung; Entscheidungskriterium festlegen; Entscheidung: Vergleich empirischer Wert – kritischer Wert Hypothesen = Erwartungen über Unterschiede zwischen oder Zusammenhänge von Variablen, die vor einer Untersuchung formuliert werden inhaltliche Hypothese = Forschungsfrage; bezieht sich auf psychologische Inhalte statistische Hypothesen = beziehen sich auf statistische Kennwerte Nullhypothese (H0) = besagt, dass es keinen Unterschied zwischen 2 Populationen in Ausprägung eines Merkmals (bzw. keinen Zusammenhang zwischen 2 Merkmalen in einer Population) gibt; komplementär zur H1 Alternativhypothese (H1) = besagt, dass es Unterschied (bzw. Zusammenhang) gibt; komplementär zur H0 Signifikanztest = prüft die WS für einen empirischen Wert unter der Annahme, dass die H0 gilt Prüfverteilung = Verteilung des relevanten statistischen Kennwerts unter der Annahme, dass die H0 gilt, z.B. SKV des Mittelwerts (normalverteilt) Entscheidungskriterium = Wie unwahrscheinlich muss das zufällige Auftreten eines Wert sein, bevor wir die H0 ablehnen?; Übliche Festlegung: Wert sollte seltener als in 5% der Fälle zufällig auftreten (α = 5% = 0,05) Entscheidung = Vergleich empirischer Wert – kritischer Wert Empirischer Wert > kritischer Wert Ablehnung der H0 und Entscheidung für H1 Kritischer Wert = Wert, der die oberen 5% der Verteilung „abschneidet“: μ + 1.64 SE Empirischer Wert = statistischer Kennwert der Stichprobe - 11. Vorlesung z-Test = ein bestimmter Signifikanztest; bei großen SP (n>30); Prüfverteilung = SKV: Standardnormalverteilung (z-Werte-Verteilung); bei n>30 gilt annähernd der zentrale Grenzwertsatz; 6 Schritte: - 1) Formulierung der (inhaltlichen und statistischen) Hypothesen, Operationalisierung des Merkmals - 2) Erfassung des Merkmals in einer SP - 3) Berechnung des Standardfehlers des Mittelwerts - 4) Berechnung des empirischen z-Werts - 5) Festlegung Alpha-Niveau & Bestimmung des kritischen z-Werts - 6) Entscheidung zwischen H0 und H1 über Vergleich empirischer – kritischer Wert t-Test = ein bestimmter Signifikanztest; bei kleinen Stichproben (n≤30); Prüfverteilung = SKV: t-Verteilung; n≤30 zu klein für zentralen Grenzwertsatz; Voraussetzung: Merkmal in Population normalverteilt; auch für Vergleich zweier SP-Mittelwerte; 3 Varianten (für 1 SP, für 2 unabhängige SP und für 2 abhängige SP) t-Test für unabhängige Stichproben = 6 Schritte: - 1) Formulierung der (inhaltlichen und statistischen) Hypothesen, Operationalisierung des Merkmals - 2) Erfassung desselben Merkmals in zwei unabhängigen SP - 3) Berechnung des Standardfehlers der Mittelwertsdifferenz 9 - 4) Berechnung des empirischen t-Werts: Differenz der Mittelwerte beider SP - 5) Festlegung Alpha-Niveau & Bestimmung des kritischen t-Werts - 6) Entscheidung zwischen H0 und H1 über Vergleich empirischer – kritischer Wert Einseitiger Test = bei gerichteter H1; signifikant, wenn temp > tkrit(1-α) Zweiseitiger Test = bei ungerichteter H1; signifikant, wenn │temp│ > tkrit(1- α/2) 12. Vorlesung Ungerichtete Hypothese = keine Richtung des Unterschieds vorgegeben Gerichtete Hypothese = Richtung des Unterschieds vorgegeben Zwei Wege beim Signifikanztest = Entscheidung auf 2 Wegen möglich: - 1) Vergleich empirische Prüfgröße – kritische Grenze(n) - 2) Vergleich Überschreitungswahrscheinlichkeit – Signifikanzniveau Überschreitungswahrscheinlichkeit p = Wahrscheinlichkeit, per Zufall einen extremeren Wert als die gegebene Prüfgröße (z.B. empirischen t-Wert) zu erhalten, wenn die H0 gilt t-Test für unabhängige SP = prüft WS, gegeben die H0, dass eine bestimmte Mittelwertsdifferenz auftritt; SKV der Mittelwertsdifferenzen ist eine t-Verteilung mit df = n1 + n2 – 2; Voraussetzungen: - 1) Intervallskalenniveau der Messung - 2) Normalverteilung des Merkmals in Population (sonst: nonparametrisches Schätzverfahren, z.B. UTest) - 3) „Varianzhomogenität“ (gleiche Varianzen in beiden Stichproben) (sonst: Korrektur der Freiheitsgrade durch Welch-Test) - 4) Unabhängigkeit der Stichproben (sonst: t-Test für abhängige SP) Unabhängigkeit der SP = Ziehung eines Merkmalsträgers in 1. SP beeinflusst nicht Zugehörigkeit eines Merkmalsträgers zur 2. SP t-Test für abhängige SP = prüft WS, gegeben die H0, dass eine bestimmte mittlere Differenz auftritt; SKV der Mittelwerte der Differenzen ist eine t-Verteilung mit df = n – 1; Voraussetzungen: - 1) Intervallskalenniveau der Messung - 2) Normalverteilung der Differenzen in Population 6 Schritte: - 1) Statistische Hypothesen H0 und H1 ableiten - 2) Signifikanzniveau α festlegen; ggf.: ein- vs. zweiseitiger Test? - 3) Auswahl des Testverfahrens, Prüfung der Voraussetzungen, Bestimmung der zugehörigen SKV - 4) Bestimmung des SP-Kennwerts (Untersuchung durchführen, Merkmal erfassen); Entscheidung für H0, falls SP-Kennwert mit H1 inkonsistent (Bsp. einseitiger Test) - 5) Bestimmung der Vergleichswerte (kritische Grenze(n) und Prüfgröße oder Überschreitungswahrscheinlichkeit und Signifikanzniveau) - 6) Entscheidung zwischen H0 und H1 13. Vorlesung Alternativhypothese H1 = kann unspezifisch (z.B. μ1 > μ0) oder spezifisch sein, d.h. einen spezifischen Wert enthalten (z.B. μ1 – μ0 = 3) spezifische: erlaubt die Kontrolle des Beta-Fehlers Effektgröße = spezifischer Wert der spezifischen H1; gibt angenommene Größe des Effekts (z.B. Abstand zwischen 2 Mittelwerten) in der Population an; kann anhand einer SP geschätzt werden; Zur Berechnung wird der Mittelwertsunterschied und die Standardabweichung berücksichtigt Effektgrößenmaß Delta = Abstand der Mittelwerte, normiert an der Streuung Abstand der Mittelwerte in Standardabweichungs-Einheiten (vgl. z-Werte) Empirische Effektgröße d = Schätzer für die Streuung: Gemittelte Streuung beider Stichproben; wächst mit größerem Abstand der Mittelwerte und mit kleinerer Streuung; Cohen: „Daumenregel“: - d ≥ .20: kleiner Effekt - d ≥ .50: mittlerer Effekt - d ≥ .80: großer Effekt 10 ; Gegenstück zum β-Fehler; WS, mit der ein in der Population tatsächlich Teststärke (Power) = 1 – β existierender Effekt in einer empirischen Untersuchung auch entdeckt wird; Jede Untersuchung sollte hohe Teststärke/kleinen β –Fehler haben; bei geringer Teststärke ist eine Entscheidung für H0 wenig aussagekräftig; 6 Einflussgrößen: - 1) Höhe des Alpha-Niveaus: je größer Alpha, desto größer auch die Power - 2) Art der Testung: bei zweiseitiger Testung ist Power geringer als bei einseitiger Testung, da dann erst bei höherem kritischem Wert H1 angenommen wird (größerer β-Fehler) - 3) Varianz des Merkmals: Je mehr Varianz ein Merkmal hat, desto geringer ist die Teststärke - 4) Stichprobenumfang: Je größer die Stichprobe, desto höher ist die Power eines Tests - 5) Effektgröße: Je größer der erwartete Effekt (z.B. Mittelwertsdifferenz), desto höher ist die Teststärke - 6) Auswahl des statistischen Tests: - SP: Tests mit abhängigen SP haben eine höhere Power als Tests mit unabhängigen SP - Skalenniveau: Tests, die auf höherem Skalenniveau beruhen, haben idR eine höhere Power Teststärke kann erhöht werden, indem: - ein höherer α-Fehler akzeptiert wird - eine gerichtete Hypothese formuliert wird - die Merkmalsvarianz verringert wird - der Stichprobenumfang erhöht wird - für eine große Mittelwertsdifferenz gesorgt wird - abhängige Stichproben verwendet werden - ein statistisches Verfahren verwendet wird, dass das erhobene Skalenniveau ausnutzt Festlegung/Berechnung: - a priori: benötigte SP(n)-Größe wird aus Teststärke, α-Fehler und erwarteter Effektgröße berechnet - post hoc: kann aus Effektgröße, Stichprobengröße und α-Fehler berechnet werden 14. Vorlesung Einflussgrößen der Teststärke = direkte und indirekte: - α-Fehler-Niveau (Signifikanzniveau) Lage des Entscheidungskriteriums - Stichprobenumfang Standardabweichung der SKV - Effektgröße Abstand und Standardabweichung der SKVn - gerichtete Hypothese α-Fehler-Niveau/Signifikanzniveau - Merkmalsvarianz Effektgröße, Standardabweichung der SKV - Mittelwertsdifferenz Effektgröße - un-/abhängige Stichprobe Standardabweichung der SKV Optimaler Stichprobenumfang = Stichprobenumfang, der sicherstellt, dass eine gegebene Effektgröße mit dem gewählten Signifikanzniveau und der gewählten Teststärke gefunden werden kann Stichprobenumfangsplanung = 2 Arten: - 1) a priori = Planung des Stichprobenumfangs; Effektgröße, α und Teststärke sind gegeben - 2) post hoc = Teststärkeberechnung bei geg. SP; Effektgröße, α & Stichprobenumfang sind gegeben