zf-statistik

Werbung

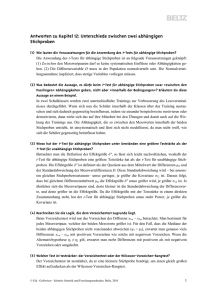

STATISTIK Qualitative Merkmale: Beschreiben Zugehörigkeit zu bestimmter Kategorie (Geschlecht, Wohnort..) Quantitative Merkmale: beschreiben Ausprägung auf bestimmtem Kontinuum (Alter, Ängstlichkeit..) Manifeste Merkmale: können direkt beobachtet/gemessen werden (Körpergröße, Anzahl Geschwister) Latente Merkmale: sind nur indirekt zu erfassen (Ängstlichkeit..) Manifest qualitativ: Geschlecht, Wohnort, Postleitzahl, Schulabschluss Manifest quantitativ: Alter, Gewicht, Reaktionszeiten Latent qualitativ: Persönlichkeitstypus (z.B. Choleriker), psych.Störungen Latent quantitativ: Intelligenzquotient, Persönlichkeitseigenschaften auf Skala (z.B. Extraversion) Diskrete Variablen: Anzahl der möglichen Werte ist abzählbar (Nominal- und Ordinalskala) Kontinuierliche Variablen (od. „stetige“): Die möglichen Werte liegen auf einem Kontinuum (Int./Verh.) Dichotom: Nur zwei Variablen, z.B. 1 und 2, z.B. auf Nominalskala. Verschiedene Skalenniveaus und ihre Annahmen + mögliche Aussagen Nominal: Exklusivität (Untersch. Merkmalsausprägungen werden untschl. Zahlen zugeordnet), Exhaustivität (es wird jeder beobachteten Merkmalsausprägung eine Zahl zugeordnet), homomorphe Abbildung. Mögliche Aussagen: Gleichheit / Verschiedenheit eines Merkmals Ordinal: Exklusivität, Exhaustivität, +Rangreihe (die zugeordneten Zahlen repräsentieren eine Rangreihe der Merkmalsausprägung (größer – kleiner). Mögl.Auss.: vorheriges + größer-kleiner Relationen Intervall: Exklusivität, Exhaustivität, Rangreihe, +Intervalle=Abstände (gleichgroße Intervalle zwischen Zahlenwerten der Variable stehen für gleichgroße Abstände der Merkmalsausprägung). Mögl.Auss.: vorheriges + Größe von Unterschieden zwischen Merkmalen Verhältnis: Exklusivität, Exhaustivität, Rangreihe, Intervalle=Abstände, +definierter Nullpunkt (Nullpunkt der Skala entspricht wirklichem Nullpunkt). Mögl. Auss.: vorheriges + Verhältnis von Merkmalsausprägungen Erlaubte Transformationen der Skalenniveaus (damit Skalenniveau erhalten bleibt) Nominal: Alle eineindeutigen Transformationen, also Zuordnung einer Zahl zu einer anderen Zahl, egal wie Ordinal: Alle monotonen Transformationen, z.B. x², 2x, log(x), x+3 Intervall: Alle linearen Transformationen, z.B. 2x+5 Verhältnis: Alle multiplikativen Transformationen, z.B. 3x Bsp., welche Variablen auf welcher Skala dargestellt werden Nominal: Studienfach, Wohnort, Geschlecht, Lieblingsfarbe, Musikgeschmack, psychische Störungen Ordinal: Art des Schulabschlusses, Härte von Gesteinsarten, Intervall: IQ, Persönlichkeitsmerkmale, Temperatur in Celsius und Fahrenheit Verhältnis: Alter, Reaktionszeit, Länge, Anzahl, Temperatur in Kelvin Aggregation von Werten von mehrstufigem Fragebogen es geht von -2 bis 2. Man zählt die Zahlen der versch. Antworten zusammen und teilt sie durch die Anzahl der Antworten. Das Ergebnis ist der aggregierte Wert. Auch wenn das eine Ordinalskala war, kann ein Intervallskalenniveau erreicht werden, indem man ganz viele psychologische Merkmale erfasst. (Diese kann man dann auf Intervall darstellen) Darstellungsmöglichkeiten von Daten Häufigkeiten (Urliste, SPSS, Kategorisierung), Maße der zentralen Tendenz, Maße der Dispersion Was gilt für die Bildung von Kategorien? Disjunkt (keine Überlappung), direkt benachbart (keine Lücken), offene Kat. a. d. Rändern erlaubt, alle geschlossenen Kategorien sind gleich breit, in der Regel nicht mehr als 20 Kategorien. Maße der zentralen Tendenz: Auskunft über Mitte der Verteilung Modalwert/Modus: häufigster vorkommender Wert, für alle Skalentypen, vorallem bei Nominal sinnvoll Median: trennt geordnete Reihe der Messwerte in obere und untere 50%, mind. ordinalskalierte Daten Mittelwerte: Summe aller Messwerte geteilt durch Anzahl N. Für mind. intervallskalierte Daten Maße der zentralen Tendenz lassen auch Rückschlüsse auf Verteilungsform zu! (Rechtssteil/linkssteil/symmetr.) Maße der Dispersion: Auskunft über „Variabilität“ einer Verteilung Range: Spannweite oder Variationsbreite. Für kontinuierliche: Max-Min. Für diskrete: Max-Min+1 Nachteile: Geringe Aussagekraft über Verteilung, hohe Empfindlichkeit gegenüber Ausreißern Quartile: geordnete Liste in jeweils 25% einteilen. Q2 entspricht dem Md. Von Q1-Q3: 50% (Interquartilsabstand). Voraussetzung: Ordinalskalenniveau! Varianz: hier geht mit ein, wie weit jede individuelle Merkmalsausprägung vom Mittelwert entfernt ist. Durch Quadrierung werden größere Abw. stark berücksichtigt. Freiheitsgrade N-1 bei der Varianzschätzung: Heißt, dass alle Werte außer einem beliebig gewählt werden können. Voraussetzung f. Varianz: Intervallskalenniveau! Standardabweichung: Wegen schwerer Interpretierbarkeit der Varianz: Wurzel. Schiefe: linkssteil oder rechtssteil, wird mit zentralem Moment 3. Ordnung berechnet. a3<0: rechtssteil, a3=0: symmetrisch, a3>0: linkssteil Exzess(=Kurtosis): mit zentr.Mom. 4.Ordnung berechnet. a4<3:breitgipflig, a4=3:symmetr., a4>3:schmalgipflig Grafische Darstellung von Daten Balkendiagramm: gut für diskrete Var. geeignet, für Mittelwert darstellen Histogramm: Häufigkeiten für alle Werte, es werden Kategorien gebildet, gut für kontinuierliche Var. Stem-and-lead-plot: exakte Werte aller Probanden Boxplot: Median, IQA, Range, Ausreißer- und Extremwerte Scatter-Plot: Zwei Variablen in Bez. zueinander, jeder Wert ist als Punkt dargestellt Relativer Anteil der günstigen Fälle an allen möglichen Ereignissen (Laplace) p(A)=n(A) / N (gesamt). Wenn man also gegeben hat, wieviele weiße Murmeln es gibt und wieviele Murmeln insgesamt, kann man die WS angeben, mit der zufällig eine weiße gezogen wird. Gesetz der großen Zahl: Bei sehr häufiger Durchführung wird (relative Häufigkeit-)Schätzung immer genauer Bedingte Wahrscheinlichkeit p(A/B)=p(A^B) / p(B). WS von A unter Bed. B errechnet sich aus WS für A geschnitten B (WS, dass A und B gleichzeitig eintreten) geteilt durch WS, dass B eintritt. Stochastische Unabhängigkeit p(A)=p(A/B)=p(A/B-). WS für A ist gleich der WS für A unter Bed. B, gleich WS für A unter Bed. „nicht B“ Theorem von Bayes p(A/B)=p(A) x p(B/A) / p(B) u.a.r. Wahrscheinlichkeitsverteilungen Diskrete: Gibt für jeden Wert einer diskreten Variable die Auftretens-WS an. Stetige: ergibt sich, wenn für eine kontinuierliche Variable unendliche kleine Kategoriebreiten verwendet werden Fläche unter der Kurve repräsentiert Anteile der Population in best. Wertebereich (WS-Dichteverteilung) Wichtigste stetige WS-Verteilung: Normalverteilung (von Gauß entdeckt). Die Normalverteilung -glockenförmiger Verlauf -symmetrisch (a3=0) -normaler Exzess (a4=3) -Definiert durch: Mw. Gibt die Position des „Gipfels“ an, Streuung/Std.abw. gibt die Breite der Verteilung an. Standardnormalverteilung: Normalverteilung mit Mw.=0 und Streuung=1. Jede normalverteilte Variable kann in eine Stand.norm.vert. transformiert werden: z-Transformation (heißt auch „Standardisierung“). Der z-Wert entspricht der Abw. vom Mw. in „Std.abw.-Einheiten“. Z-Tabelle zur Std.norm.vert. gibt an, wie groß die Fläche die Fläche unter der Kurve links von einem z-Wert ist. Und man kann Prozentränge ablesen. -68% aller Werte liegen zwischen s=-1 und s=+1 (von z=-1,64 bis z=+1,64) -ca. 95% aller Werte liegen zwischen s=-2 und s=+2 (von z=-1,96 bis z=+1,96) -ca. 2,14% der Werte liegen links von s=-2 oder rechts von s=+2 -ca. 0,13% liegen links von s=-3 / rechts von s=+3 Bsp. IQ: ist immer so skaliert, dass er Mw. von 100 und Streuung von 15 hat. Stichprobengröße und Variabilität der Stichprobenkennwerte Bei größeren Stichproben geringere Variabilität! (Wenn 10x 2 Personen ziehen und zum Vergleich 10x 20 Personen ziehen: Stichprobenkennwerteverteilung von 20 Personen hat geringere Varianz. Dies gilt für alle Stichprobenkennwerte, nicht nur Mw. Auch Streuung, Schiefe,…). Große Stichproben liefern bessere Schätzer! Zentraler Grenzwertsatz Wenn man oft genug Stichprobe zieht, ist die Verteilung des (interessierenden) Kennwerts aus allen diesen Stichrproben irgendwann normalverteilt! Wenn die Population normalverteilt ist, ist auch die Stichprobenkennwerteverteilung bei geringem N schon normalverteilt. Bei unendlich vielen Stichproben entspricht übrigens der Kennwert der Stichpr.vert. dem in der Population. Standardfehler Der Standardfehler eines Kennwerts ist die Std.abw. der Verteilung dieses Kennwerts aus vielen Stichproben. Er gibt an, wie nah ein empirischer Stichprobenkennwert am wahren Populationskennwert liegt. Kann direkt aus einer Stichprobe berechnet werden, also ohne dass man mehrere Stichproben erheben muss. Interpretation des Standardfehlers und Konfidenzintervalle Standardfehler ist ja Std.abw. der Stichpr.kennw.vert., und da diese normalverteilt ist (ab N>30), kann WS berechnet werden, dass der Kennwert in einem bestimmten Intervall liegt. Man geht also von Standardnormalverteilungskurve aus und nimmt z-Werte, um den WS-Bereich festzulegen. Mit p=.68 ist der Kennwert einer Stichpr.kennw.vert. höchstens einen Std.fehler vom Stichpr.kennw. entfernt Der interessierende Kennwert der Stichpr.kennw.vert. ist ja unbekannt, deshalb wird Intervall um den Stichprobenmittelwert. angegeben, in dem dieser Kennwert mit einer best. WS liegt: 95%-Intervall für den Mw.: p(Mw.-1,96 mal Std.fehler des Mw. < µ < Mw. + 1,96 mal Std.fehler des Mw Dieser Mittelwert der Stichpr.kennw.vert. entspricht dem Populationsmittelwert! Vorgang des Hypothesentestens -Die Nullhypothese besagt, dass kein Unterschied zwischen zwei Populationen (bzw. zw. den 2 Merkmalen) -Die Alternativhypothese besagt, dass ein Unterschied besteht (bei gerichteter: bestimmter Unterschied) -Die Verteilung der relevanten Kennwerte (meistens Mw. von etw.) muss klar sein (Normalverteilung? σ? µ?) -Entscheidungskriterium (kritischer t-Wert) wird festgelegt: wie klein muss Wert sein, damit unterdurchschntl.?) -Empirischer Wert (durch Test ermittelt) wird mit kritischem Wert verglichen. -Fehler: alpha-Fehler (1.Art): man entsch. sich falsch für H1, beta-Fehler (2.Art): man entsch. s. falsch für H0. -das alpha-Niveau gibt an, wie „unws. H0 sein muss“, damit H1 angenommen wird. Meistens: α=.05! Das Ergebnis ist also signifikant, wenn p < .05! Mit WS von α wird also H1 fälschlicherweise angenommen. Voraussetzungen für den t-Test für unabhängige Stichproben Intervallskalenniveau, Normalverteilung der Population (KS-Test), Varianzhomogenität (Levene-Test), Unabhängigkeit der Stichproben. Wenn Normalverteilungsvoraussetzung verletzt, ist das vorallem bei kleinem N problematisch! Dann sollte ein nonparametrischer Test verwendet werden, z.B. u-Test Wenn die Varianzhomogenität verletzt ist, müssen die Freiheitsgrade korrigiert werden, denn eine Verteilung ist flacher, wenn Varianz nicht gleich, d.h., die WS stimmt nicht mehr! 5%-Niveau bei flacher weiter rechts! Voraussetzungen für den t-Test für abhängige Stichproben Abhängige Stichproben (Parallelisierung/Matching), Intervallskalenniveau, Normalverteilung. Gemeinsame Varianz ist sowieso gegeben Voraussetzungen für den t-Test für eine Stichprobe Normalverteilung, Intervallskalenniveau, + ZUFALLSSTICHPROBE! Effektgröße/Effektstärke Gibt an, wie bedeutungsvoll ein Unterschied ist. Wächst mit größeren Unterschieden zwischen den experimentellen Bedingungen und kleinerer Streuung innerhalb der Bedingungen. Diff. d.Pop.Mw.durch:Varianz Empirischer Effekt wächst: …mit größerem Abstand der Mittelwerte …mit kleinerer Streuung …mit größerem N (=kleinere Streuung) Konventionen: d≥2: kleiner Effekt, d≥0,5: mittlerer Effekt, d≥0,8: großer Effekt Der Varianzquotient φ² gibt das Verhältnis systematischer zu unsystematischer Varianz an. Er wächst: …mit größerer systematischer Varianz …mit kleinerer Fehlervarianz Wenn man weiß, welche Effektgröße zu erwarten ist, kann man den β-Fehler festlegen. (?) Teststärke (Power) = 1-β. WS, einen bestehenden Unterschied nachzuweisen (also WS, H1 anzunehmen, wenn H1 gilt). Power vergrößern: β-Fehler reduzieren (=größerer α-Fehler, also „höheres α-Niveau“) einseitig testen, da sich so das α-Niveau erhöht Streuung reduzieren, da dann geringere Überlappung, und dadurch wiederum geringere WS für Fehler Stichprobe vergrößern, da bei größerem N geringere Streuung Effektstärke vergrößern (also kleinere Streuung, größeres N, vorallem aber: größere Abst. d. Mw.): weil bei größerem Abstand der Mw. die Überlappung geringer ist, dadurch geringere WS für Fehler Abhängige Stichproben verwenden, da sich so die Fehlervarianz reduziert – weniger Überlappung der Vert. Teststärkeres Verfahren auswählen: parametrische Tests haben größere Effizienz (weil Info besser ausgenutzt), dadurch größere Teststärke, kleinerer β-Fehler Festlegen des Fehlerniveaus (traditionelles Vorgehen): α-Niveau wird festgelegt, aber β-Fehler nicht explizit. Ergibt sich eben aus dem ersteren. Man weiß dabei nie genau, wie groß zweiterer denn genau ist. Sowohl H0 als auch H1 können gelten.. Problem mit Falsifizierbarkeit der Hypothesen (H1 kann nicht falsifiziert werden. Bei Beibehaltung von H0 kann nicht gefolgert werden, dass H1 NICHT gilt. Nur wenn H0 abgelehnt wird, kann gesagt werden, dass H1 mit bestimmter Fehler-WS α gilt Wenn man bei diesem Vorgehen β-Fehler reduzieren will, wählt man α-Niveau von 20%. Blöd! Stichprobenumfangsplanung Man legt β-Fehler, α-Fehler und Teststärke fest. Dadurch alle Ergebnisse interpretierbar. Wenn H0 verworfen wird, kann H1 mit bekannter FehlerWS α angenommen werden; wenn H0 NICHT verworfen wird, wird die H1 mit bestimmter FehlerWS β abgelehnt. Da außerdem Teststärke bekannt: Unters. mit geringer Teststärke verm. Bsp.1: UV: Geschlecht, AV: Lesefähigkeit. Förderprogramm? Leider knappe Kassen. Deshalb: nur bei bedeutsamem Unterschied finanziert.mindestens mittlerer Effekt (>.5), geringes Alpha-Niveau (1%), hohes Beta-Niveau, da nicht tragisch(20%) Bsp.2: Nebenwirkungen von Medikament. UV: Placebo vs. geringe Dosis vs. hohe Dosis. AV: Nebenwirkungen. Auch kleinste Nebenwirkung soll aufgedeckt werden, deshalb: kleiner Effekt gesucht. Vermeiden, dass Nebenwirkung nicht entdeckt wird: geringes Beta-Niveau = hohe Teststärke erwünscht (z.B. bei 1% festlegen). Weniger tragisch, wenn fälschlicherweise Unterschied gefunden, also Alpha-Niveau z.B. 10% wenn zu geringe Power: H1 wird mit zu geringer WS angenommen, wenn sie in Population gilt zu hohe Power: H0 wird mit hoher WS verworfen, auch wenn Abw. von H0 sehr klein (d.h. praktisch unbed.) Ziel: Für eine interessierende Effektgröße eine vernünftige Power finden, d.h. möglichst ausgeglichene und geringe FehlerWS Alpha und Beta. A-priori-Teststärkeanalyse Wieviele VP brauche ich? Festlegen von: Effektgröße, Alpha-Niveau, Teststärke Berechnung von: benötigter Stichprobengröße Post-hoc-Teststärkenanalyse Wie groß war Power bei Untersuchung? Festlegen von: Effektgröße, Alpha-Niveau, Stichprobengröße Berechnung von: Teststärke Bsp.: Wenn Schlussfolgerung eines Tests, dass z.B. Amnestiker in direkten Tests benachteiligt sind, nicht dagegen in indirekten Tests, dann stellt sich Frage, ob zweiter Teil gerechtfertigt. Wenn man jetzt die Teststärke berechnet, kommt raus, dass die Power (1-β) bei kleinem Effekt (d=.2) .09 war, bei mittlerem .19 und bei großem .33! Das bedeutet: sogar bei großem Effekt wurde die H0 mit einer FehlerWS von 67% angenommen. Kompromiss-Teststärkenanalyse Wie groß sind Alpha-Niveau und Power bei einer bestimmten Stichprobengröße? Festlegen von: Effektgröße, Stichprobengröße, Verhältnis Beta/Alpha Berechnung von: Alpha und Teststärke. Anw. bei begrenzter Stichprobengröße (z.B. wenig Patienten, zu teuer..) Ein Beispiel für jeweilige Verwendung der Teststärkenanalysen AV: Anzahlder Lernversuche von Ratten bis zum fehlerfreien Durchlaufen eines Labyrinths. Hypothese: Ratten mit vorheriger Explorationsmöglichkeit brauchen weniger Lernversuche. Erwartet wird ein mittelstarker Effekt d=.5, getestet wird auf Signifikanzniveau α=.05, t-Test. -Wie groß ist die Power? Post-hoc-Poweranalyse. Erg.: Power .59, also sehr gering. -Wie groß müsste die Stichprobe sein, um einen Effekt d=.5 mit einer Power von .95 aufzudecken? A-prioriPoweranalyse. Erg.: N=176. Es sind aber nur 120 Ratten verfügbar. -Wie groß müssen Alpha und Beta gewählt werden, damit beide FehlerWS gleich sind? KompromissPoweranalyse Warum Produkt-Moment-Korrelation? Warum reicht Kovarianz nicht? Kovarianz ist unstandardisiertes Maß, d.h. sie hängt von der Skalierung der beteiligten Variablen ab. Daher nicht direkt interpretierbar und vergleichbar! Standardisierte Kovarianz ist der Korrelationskoeffizient. Von -1 bis 1 Unterschied d und r? Sind beides Effektgrößen! r bezeichnet Effektgröße eines Zusammenhangs, d bezeichnet Effektgröße eines Unterschieds. Determinationskoeffizient Ist die quadrierte Korrelation. Beschreibt den relativen Anteil der gemeinsamen Varianz von zwei Merkmalen. Probleme des Korrelationskoeffizienten ist nicht intervallskaliert, deshalb: 1.Mittelwert zweier Korrelationen ist nicht als das arithmetische Mittel berechenbar 2.Differenzen (Abstände bzw. Intervalle) zwischen Korrelationskoeffizienten sind nicht interpretierbar LÖSUNG: Transformation der Korrelationskoeff. in annähernd intervallskalierte Werte: Fishers Z-Werte. Sind: annähernd intervallskaliert, annähernd normalverteilt. Berechnen oder in Tabelle nachschlagen. Mittelwert von Korr.koeff. Man berechnet den Fishers Z-Wert für einzelne Korr., bildet dann das (gew.) Mittel, dann: Rücktransformation Unterschiede zwischen Korrelationen Berechnung Fishers Z für einzelne Korr., Berechnung eines z-Werts, Vergleich mit krit. z-Wert (aus Std.norm.vert.-Tabelle). Wenn z(emp)>z(krit), dann liegt signifikanter Unterschied zw. r1 und r2 vor. Prüfen einer spezifischen Hypothese z.B. „Korr. in Population hat genau den Wert rho“. (1) Berechnung von Fishers Z für die empirische und die erwartete Korrelation (2) Berechnung eines z-Werts: Z - Z(rho) geteilt durch Std.abw von Z (3)Vergleich mit einem kritischen Wert aus der Std.norm.vert.-Tabelle. Bei z(emp)>z(krit): Signifikanter Unterschied zwischen r und rho. Weitere Korrelationskoeffizienten Intervall+Ordinal: Spearmans Rangkorrelation Ordinal+Ordinal: Spearmans Rangkorrelation natürlich dichotom (z.B. Geschlecht), also Nominal +Intervall: punktbiseriale Korrelation natürlich dichotom, also Nominal +Ordinal: biseriale Rangkorrelation polytom (z.B. Parteien), also Nominal +Ordinal: Cramers Index polytom + künstlich dichotom (z.B. deutsch: ja/nein) (also: Nominal+Nominal): Cramers Index polytom + natürlich dichotom (Nominal+Nominal): Cramers Index polytom + polytom (Nominal+Nominal): Cramers Index Lineare Regression Ziel: Vorhersage einer Variablen y durch eine Variable x. Nur möglich, wenn Korrelation der beiden. Vorherzusagende Variable: Kriteriumsvariable Zu Vorhersage verw. Var.: Prädiktorvariable Residuum: Vorhersagefehler (ei). Bezeichnet die Abw. der vorhergesagten (geschätzen) y-Werte von den tatsächlichen y-Werten. ei = vorhergesagter y-Wert minus tatsächlicher y-Wert. Methode der kleinsten Quadrate a und b (die beiden Parameter, die die Regr.gl. definieren. a=Achsenabschnitt, b=Regr.gewicht.) werden so gewählt, dass der quadrierte Vorhersagefehler über alle Probanden minimal ist. Für die Ermittlung der Regressionsgleichung wird die Differenz der tatsächlichen von den vorhergesagten y-Werten also quadriert. Vorteile: -Abweichungswerte immer positiv -große Abweichungen werden stärker berücksichtigt als kleine Abweichungen Güte der Vorhersage Das Residuum bezeichnet die Qualität. Der „wahre Wert“ der Variable y setzt sich also aus dem vorhergesagten Wert und einem Residuum zusammen. (Tatsächl. Wert = vorhergesagter Wert + Residuum) Standardschätzfehler …ist die Standardabweichung der Residuen! Gibt die Streuung der y-Werte um die Regressionsgleichung an. Gibt also an, wie stark die wahren y-Werte von den vorhergesagten y-Werten (der Geraden) abweichen. Je größer die Streuung des Kriteriums (s Index y), desto größer der Fehler Je größer die Streuung des Prädiktors, desto kleiner der Fehler. (je größerer Bereich, in dem x-Werte, desto besser kann man schätzen, also desto kleiner der Fehler) Je größer die Korrelation zwischen Prädiktor und Kriterium, desto kleiner ist der Fehler. Fehler ist klein, wenn ein Kriterium mit geringer Varianz hoch mit eine Prädiktor mit großer Varianz korreliert! Kreuzvalidierung Frage der Generalisierbarkeit (externe Validität) einer Regressionsgleichung, also ob auch für alle Personen gültig, die ursprünglich nicht zur Stichprobe gehörten. Für die Kreuzvalidierung wird deshalb an zwei Stichproben die Gültigkeit der Regressionsgleichung für eine andere Stichprobe überprüft. Vorgang: (1) Berechnung der Regressionsgleichung R1 anhand Stichprobe S1 und Ber. von R2 anhand S2 (2) Anwendung von R1 auf S2, Anwendung von R2 auf S1 (3) Vergleich der vorhergesagten Kriteriumswerte mit den wahren Kriteriumswerten in S2, u.a.r. Einengung der Streubreite Nötig, denn je geringer die Streuung der Merkmale, desto schwächer ist ihr Zusammenhang und manchmal ist in bestimmtem Bereich nicht zu erkennen, was für eine Regressionsgerade. Deshalb: Wertebereich von x einschränken! (Schaubild „in die Breite ziehen“). Dann wird klarer, was für ein Zusammenhang.