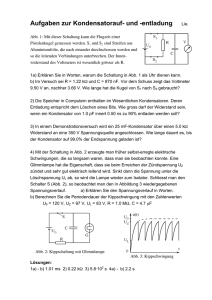

next_generation_ _next_generation 2007

Werbung