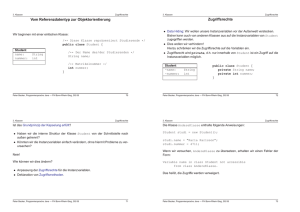

Textalgorithmen

Werbung