Rechnen mit Wahrscheinlichkeiten

Werbung

Werner Timischl

Biostatistik

Eine Einfuhrung fUr

Biologen und Mediziner

Zweite, neubearbeitete Auflage

Springer-V erlag Wien GmbH

Univ.-Prof. Dipl.-Ing. Dr. Werner Timischl

Institut fUr Algebra und Computennathematik

Technische Universităt Wien

Wien, Osterreich

Das Werk ist urheberrechtlich geschiitzt.

Die dadurch begriindeten Rechte, insbesondere die der Ubersetzung, des Nachdruckes, der

Entnahme von Abbildungen, der Funksendung, der Wiedergabe auf photomechanischem oder

ăhnlichem Wege und der Speicherung in Datenverarbeitungsanlagen, bleiben, auch bei nur

auszugsweiser Verwertung, vorbehalten.

© 2000 Springer-Verlag Wien

Urspri.inglich erschienen bei Springer-VerlagIWien 2000

Reproduktionsfertige Vorlage vom Autor

Graphisches Konzept: Ecke Bonk

Gedruckt auf săurefreiem, chlorfrei gebleichtem Papier - TCF

SPIN 10728430

Mit 59 Abbildungen

ISBN 978-3-211-83317-9

ISBN 978-3-7091-6313-9 (eBook)

DOI 10.1007/978-3-7091-6313-9

Vorwort zur zweiten Auflage

Die Neubearbeitung der "Biostatistik" unterscheidet sich sowohl im Aufbau als

auch in der in Auswahl der Inhalte von der ersten Auflage. Da heute die statistische Bearbeitung von Problemen meist computerunterstiitzt mit Hilfe einschlagiger Statistiksoftware erfolgt, verlagern sich die Anforderungen an den Anwender

mehr und mehr auf die Modellbildung und die Interpretation. Beides gelingt umso

besser, je mehr man mit den Denkweisen der Statistik und den hinter den statistischen Methoden steckenden Ideen vertraut ist . Es ist das Ziel des Buches, Interesse

an der Statistik zu wecken und das Verstandnis fiir die sachgemahe Anwendung

von statistischen Methoden zu fordern.

Die "Biostatistik" ist in erster Linie ein Lehr- und Ubungsbuch fiir Studierende

der Biowissenschaften. Abweichend von der erst en Auflage werden nun deskriptive

und induktive Verfahren, die auch bei praktischen Problemlosungen eng miteinander verbunden sind, nicht in getrennten Abschnitten, sondern parallel behandelt . Nach einer kurzen EinfUhrung in die Wahrscheinlichkeitsrechnung und die

fiir die Praxis relevanten Wahrscheinlichkeitsverteilungen folgt der Einstieg in die

Punkt- und Intervallschatzung. Ausflihrlich wird das Testen von Hypothesen mit

den wichtigsten Verfahren fiir Ein- und Zweistichprobenvergleiche einschlieBlich

Anpassungstests und Aquivalenzprmung behandelt . Einen breiten Raum nimmt

auch die Korrelation bei metrischen und nominalen Daten sowie die einfache und

mehrfache lineare Regression ein. Stark erweitert wurde die Darstellung der varianzanalytischen Modelle. Neben dem Grundmodell der einfaktoriellen Varianzanalyse werden allgemeinere Versuchsanlagen wie die Blockvarianzanalyse, die

Kovarianzanalyse oder die zweifaktorielle Varianzanalyse betrachtet . Neu aufgenom men wurde ein Kapitel iiber multivariate Statistik, das in die Clusteranalyse,

die Hauptkomponentenanalyse, die Faktorenanalyse und die Diskriminanzanalyse

einfiihrt .

Grundsiitzlich werden nur Kenntnisse aus der Schulmathematik vorausgesetzt.

Wenn auch auf Formeln nicht vezichtet werden kann, so wird nicht zuletzt durch

die vielen durchgerechneten Beispiele das Anwenden der verschiedenen Verfahren

in den Mittelpunkt geriickt . Die Empfehlung "learning by doing" gilt ganz besonders fur die angewandte Statistik. Indem man Beispiele nachvollzieht und sich im

Losen einfacherer und komplexerer Musteraufgaben iibt , gewinnt man die fiir die

Anwendungspraxis notwendige Sicherheit. Neben den Beispielen bilden die Aufgaben am Ende eines jeden Kapitels ein zusatzliches Ubungsmaterial, das auch

zu computerunterstiitzten Problemlosungen anregen soll. Zu den Aufgaben gibt

es im Anhang einen ausfiihrlichen Losungsteil .

VI

Vorwort

Mein Dank gilt allen Lesern, die durch Hinweise zur Verbesserung des Textes und zur Korrektur fehlerhafter Stellen beigetragen haben . Fiir das Mitlesen

der Korrekturen habe ich Frau Dipl.-Ing. Edith Fenz und Herrn Mag. Herbert

Weilguni, vor allem aber Herrn DDr. Martin Baumgartner zu danken, der auch

die Bespiele nachgerechnet hat . SchlieBlich danke ich Frau Mag. Elisabeth Bohunovsky und Herrn Thomas Redl vom Springer-Verlag in Wien fiir die Betreuung

wahrend der Entstehung der Druckvorlage und die gute Zusammenarbeit.

Wien, im April 2000

Werner Timischl

Inhaltsverzeichnis

1 Rechnen mit Wahrscheinlichkeiten

1.1

1.2

1.3

Begriff der Wahrsch~inlichkeit . . .

1.1.1 Zufallsexperiment und Ereignis

1.1.2 Laplace-Wahrscheinlichkeit . ..

1.1.3 Statistische Wahrscheinlichkeit .

1.1.4 Elementare Eigenschaften der Wahrscheinlichkeit

Bedingte Wahrscheinlichkeit . . . . . . . . . . . . .

1.2.1 Definition der bedingten Wahrscheinlichkeit

1.2.2 Unabhangige Ereignisse

.

1.2.3 Satz von der totalen Wahrscheinlichkeit .

1.2.4 Bayes'sche Formel.

Aufgaben

.

1

1

3

5

5

7

7

9

10

11

13

2 Wahrscheinlichkeitsverteilungen

2.1

Zufallsvariable

.

2.1.1 Merkmalstypen . .. . .

2.1.2 Diskrete Zufallsvariable .

2.1.3 Stetige Zufallsvariable .

2.1.4 Unabhangigkeit von Zufallsvariablen

2.1.5 MaBzahlen von Zufallsvariablen

2.2 Einige diskrete Wahrscheinlichkeitsverteilungen . . . . . . . . . . . . . .

2.2.1 Binomialverteilung

.

2.2.2 Hypergeometrische Verteilung

2.2.3 Poisson-Verteilung . . . . .

2.2.4 Negative Binomialverteilung

2.3 Normalverteilung

.

2.3.1 Standardnormalverteilung .

2.3.2 Allgemeine Normalverteilung

2.3.3 Logarithmische Normalverteilung

2.3.4 Zentraler Grenzwertsatz

2.4 Aufgaben

.

16

16

18

19

22

24

27

27

32

35

36

37

37

39

42

43

43

VIII

3 Parameterschatzung

3.1 Begriff der Zufallsstichprobe

3.1.1 Grundgesamtheit ..

3.1.2 Stichprobenauswahl .

3.2 Datenbeschreibung bei einem Merkmal

3.2.1 Hiiufigkeitsverteilungen ohne Klassenbildung

3.2.2 Hiiufigkeitsverteilungen mit Klassenbildung .

3.2.3 Weitere Kenngroflen und Ergiinzungen . .

3.3 Punktschiitzung . . . .. . . .. . . . . . .. . . .

3.3.1 Stichprobenmittel und Stichprobenvarianz

3.3.2 Schiitzfunktionen. . . . . . . . .

3.4 Intervallschiitzung. . . . . . .. . . . . . .

3.4.1 Konfidenzintervalle fur Varianzen .

3.4.2 Konfidenzintervalle fiir Mittelwerte

3.4.3 Konfidenzintervalle fiir Wahrscheinlichkeiten

3.4.4 Planung von Stichprobenumfangen

3.4.5 Bootstrap-Schiitzung

3.5 Aufgaben

Inhaltsverzeichnis

46

46

47

48

48

53

59

63

63

64

69

69

72

74

76

78

80

4 Testen von Hypothesen

4.1 Einfuhrung in das Testen : l-Stichprobenvergleiche .

84

4.1.1 Der Binomialtest bei groBen Stichproben

84

4.1.2 Giitefunktion des Binomialtests

90

4.1.3 Logik der Signifikanzpriifung . . . . . . .

94

4.1.4 Der l-Stichproben-t-Test . . . . . . . . .

97

4.2 2-Stichprobenvergleiche bei normalverteilten Grundgesamtheiten . 101

4.2.1 Unabhiingige und abhangige Stichproben . .

101

102

4.2.2 Der F-Test zum Vergleich zweier Varianzen

4.2.3 Der 2-Stichproben-t-Test . . . . . . . . .

104

107

4.2.4 Der t-Test fiir abhiingige Stichproben . . . .

110

4.2.5 Verteilungsfreie Alternativen zum t- Test . .

4.3 2-Stichprobenvergleiche bei dichotomen Grundgesamtheiten .

116

4.3.1 Vergleich zweier Anteile aus unabhiingigen Stichproben

116

4.3.2 Dei McNemar-Test fiir abhiingige Stichproben

122

4.4 Anpassungstests . . . . . . . . . . . . . . . .

125

4.4.1 Der X2- Test fiir diskrete Vert eilungen

125

129

4.4.2 Normalitiitspriifung . . . . . . . . .

4.5 Aquivalenzpriifun g . . . . . . . . . . . . .

134

4.5.1 Gleichwertigkeit von Mitt elwerten .

134

4.5.2 Gleichwert igkeit von Anteilen

137

4.6 Aufgaben

139

Inhaltsverzeichnis

IX

5 Korrelation und Regression

5.1

5.2

5.3

5.4

5.5

Zweidimensionale Kontingenztafeln

143

5.1.1 Unabhangigkeit und Korrelation .

143

5.1.2 KontingenzmaBe

148

5.1.3 Homogenitatshypothesen . . . . .

151

Korrelation bei metrischen Merkmalen .

153

5.2.1 Zweidimensionale Normalverteilung

153

5.2.2 Produktmomentkorrelation . . ..

156

5.2.3 Verteilungsfreie Korrelationsmafe .

163

Einfache lineare Regression . . . . . . . . .

168

5.3.1 Regressionsfunktion bei zweidimensional normalverteilten

Variablen

168

174

5.3.2 Zufallsgestorte lineare Abhangigkeiten

5.3.3 Beurteilung der Anpassungsgiite . . . .

180

5.3.4 Linearisierende Transformationen . . .

185

5.3.5 Regressionsgerade durch einen festen Punkt

188

Mehrfache lineare Regression . . . . . . . . .

190

5.4.1 Bestimmung der Regressionsfunktion . . . .

190

5.4.2 Multiple und partielle Korrelation . . . . . .

197

5.4.3 Globale und partielle Abhangigkeitsprufung

202

Aufgaben

206

6 Varianzanalytische Modelle

6.1

Einfaktorielle Varianzanalyse . . . . . . . . . . . . . . . .

6.1.1 Globaltest zum Vergleich von k > 2 Mittelwerten

6.1.2 Untersuchung der Varianzhomogenitat . . . . . .

6.1.3 Multiple Vergleiche von Mittelwerten . . . . . . .

6.1.4 Rangvarianzanalyse fiir unabhangige Stichproben

6.2 MaBnahmen zur Verkleinerung des Versuchsfehlers . . . .

6.2.1 Randomisierte Blockanlage. . . . . . . . . . . . .

6.2.2 Einfaktorielle Varianzanalyse mit Messwiederholungen

6.2.3 Rangvarianzanalyse fur verbundene Stichproben

6.2.4 Einfaktorielle Versuche mit einer Kovariablen

6.3 Zweifaktorielle Varianzanalyse . . . . . . . . . .

6.3.1 Der vollstandige zweifaktorielle Versuch .

6.3.2 Versuche mit einfach besetzten Zellen .

6.4 Aufgaben

213

213

221

222

226

229

229

235

238

241

249

249

258

262

7 Multivariate Methoden

7.1

7.2

Clusteranalyse

.

7.1.1 Prinzip der hierarchischen Klassifikation

7.1.2 Distanz- und AhnlichkeitsmaBe

7.1.3 Fusionierung von Gruppen

Hauptkomponentenanalyse . . . .

7.2.1 Pr inzip und Grundbegriffe

266

266

268

269

273

273

x

Inhaltsverzeichnis

7.2.2 Berechnung der Hauptkomponenten . .

7.2.3 Interpretation der Hauptkomponenten

7.3 Faktorenanalyse

.

7.3.1 Modell der Faktorenanalyse . .

7.3.2 Schiitzung der Faktorladungen .

7.4 Diskriminanzanalyse

.

7.4.1 Das Diskriminanzkriterium von Fisher

7.4.2 Diskriminanzanalyse fur zwei Gruppen

7.4.3 Zuordnung von Objekten .

275

280

282

282

284

289

289

293

296

Anhang A: Statistische Tafeln . . .

299

Anhang B: Rechnen mit Matrizen

310

Anhang C: Losungen der Aufgaben

314

Literatur .. . .

331

Sachverzeichnis

334

Kapitel 1

Rechnen mit Wahrscheinlichkeiten

Aueh wer sieh bloB als Anwend er von statistisehen Methoden sieht , sollte zumindest die in der einschlagigen Literatur (z.B. Softwaredokumentationen) besehriebenen Anwendungsvoraussetzungen verstehen und die erhaltenen Ergebnisse riehtig interpretieren konnen . Zu diesem Zweek ist eine Vertrautheit mit

dem Wahrseheinliehkeitsbegriff und einfa ehen Regeln fiir das Reehnen mit Wahrseheinliehkeiten ebenso niitzlieh wie die Kenntnis der grundlegenden Wahrseheinliehkeitsverteilungen. Die beiden ersten Kapitel dienen dazu, in die Begriffswelt

der Wahrseheinliehkeitsreehnung einzufUhren , die das mathematisehe Standbein

der Statistik darstellt.

1.1

1.1.1

Begriff der Wahrscheinlichkeit

Zufallsexperiment und Ereignis

Mit vielen physikalisehen Prozessen verbindet man die Vorstellung, dass sie mit

Hilfe geeigneter Formeln vorausbereehnet werden konnen . Wenn man z.B. einen

Stein die Hohe H frei durchfallen lasst , dann Iiefert jede Wiederholung des Experimentes im Wesentliehen (d .h. innerhalb der Messgenauigkeit) die dureh die

Formel T = J2H/g gegebene Falldauer T . (Die Konstante 9 bezeichnet die Erdbesehleunigung.) Der Ausgang eines jeden Fallversuehes ist - wenigstens unter

idealen Bedingungen - determiniert. Vollig anders ist der Ausgang bei dem in

Abb . 1.1 dargestellten Kreuzungsversuch: Eine Pflanze (Pisum sativum) mit violetter Bliitenfarbe (Genotyp VV) wird durch eine Pflanze mit weiBer Bliitenfarbe

(Genotyp ww) best iiubt. In der Ft-G eneration entstehen nur violette Pflanzen. Die

daraus hervorgehenden Pflanzen sind miseherbig, d.h., sie entwickeln Keimzellen ,

die zur Halfte die Erbanlage V fiir die violette und zur and eren Halft e die Erbanlage w fiir die weiBe Bliitenfarbe besitzen. Erfolgt eine weitere Befruchtung mit

einer miseherbigen Pflanze , sind drei Viertel der Fr Pflanzen violet t bliihend (d .h.

yom Genotyp VV , Vw oder wV) und ein Viertel weif bliihend (d.h . vom Genotyp

ww) . 1m Gegensatz zu dem zuerst betraeht et en Fallversueh gibt es beim Mendelsehen Kreu zungsexp erim ent in der FrGeneration beziiglieh des Genotyps gleieh

vier mogliche Ausgiinge, namli ch die Kornbinationen \lV , Vw, wV oder ww , die

W. Timischl, Biostatistik

© Springer-Verlag/Wein 2000

2

1 Rechnen mit Wahrscheinlichkeiten

a)

VV

I

b)

ww

x

I

v

w

~/

Vw

Vw

x

~

VV

Vw

wV

ww

E1 =

{wV, Vw}

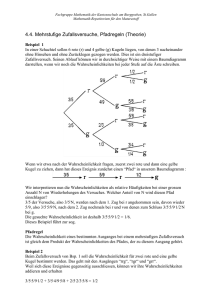

Abb. 1.1. a) Mendels Kreuzungsversuch mit Erbsen (V und w bezeichnen die

Erbanlagen fiir eine violette bzw. weiBe Bliitenfarbe, V ist gegeniiber w dominant .)

b) Veranschaulichung der Ergebnismenge durch ein Mengendiagramm

sich im Phanotyp auf die beiden Ausgange violette Bliitenfarbe bzw. weijJe Bliiien[arbe reduzieren. Welche Bliitenfarbe eine einzelne F 2-Pfianze besitzt, ist also nicht

vorhersagbar.

Man bezeichnet allgemein einen (im Prinzip beliebig oft wiederholbaren) Vorgang, dessen Ausgang sich nicht vorhersagen lasst, als ein Zufallsexperiment.

Mendels Kreuzungsversuch ist ein Zufallsexperiment mit vier moglichen Ausgangen. Weitere einfache Beispiele sind das Ausspielen eines Wiirfels, das Werfen einer

Miinze oder die aufs Geratewohl erfolgte Auswahl eines Elementes aus irgendeiner

Menge von Objekten. Die durch Zusammenfassen der Ausgange eines Zufallsexperimentes gebildete Menge nennt man dessen Ergebnismenge. Wir bezeichnen

sie kurz mit n. Das besprochene Kreuzungsexperiment besitzt die Ergebnismenge

n = {VV, Vw, wV, ww}, die in Abb . LIb anschaulich durch ein sogenanntes Mengendiagramm dargestellt ist. Jede Teilmenge von n nennt man ein Ereignis. Im

Zusammenhang mit dem Kreuzungsversuch in Abb. 1.1 kann man z.B. die Ereignisse E 1 = {Vw, wV} (heterozygoter Ausgang), E 2 = {VV, ww} (homozygoter Ausgang) oder E3 = {VV, Vw,wV} (violette Bliitenfarbe) formulieren . Man

sagt, das Ereignis E ist eingetreten, wenn der Ausgang des Zufallsexperimentes

in E enthalten ist . Wichtige Sonderfalle von Ereignissen sind die sogenannten

Elementarereignisse (d.h. die einelementigen Teilmengen von n), das bei jeder Versuchsausfiihrung eintretende sichere Ereignis (d.h. die Ergebnismenge

selbst) und das zu einem vorgegebenen Ereignis E gehorende komplementare

Ereignis E, das genau dann eintritt, wenn E nicht eintritt (d.h., E umfasst aIle

jene Ausgange in n, die nicht zu E gehoren]. Aus zwei Ereignissen E 1 und E2

konnen durch spezielle Verkniipfungen zusammengesetzte Ereignisse gebildet

werden. Wir erwahnen

• das durch die oder-Verkniipfung aus E 1 und E2 zusammengesetzte Ereignis (E 1 oder E 2 ) , das genau dann eintritt, wenn entweder E 1 oder E 2 oder

beide zusammen eintreten, sowie

3

1.1 Begriff der Wahrscheinli chkeit

• das durch die und-Verkniipfung aus E 1 und E 2 zusammengesetzte Ereignis (E1 und E2 ) , das genau dann eintritt, wenn sowohl E1 als auch E2

eintritt.

Wenn die in E 1 zusammengefassten Ausgange von den in E 2 enthaltenen Ausgangen verschieden sind , kann bei keiner Versuchsausfiihrung sowohl E 1 als auch E2

eintreten. Man nennt in diesem Fall das zusammengesetzte Ereignis (E1 und E 2 )

das unmogliche Ereignis und schreibt dafiir 0. Zwei Ereignisse E 1 und E2 , fiir

die (E1 und E2 ) = 0 gilt , heissen einander ausschlieBend oder disjunkt. Sind

z.B. n = {VV, Vw ,wV,ww} (vgl. Abb. 1.1), E 1 = {Vw,wV} (heterozygoter

Versuchsausgang) , E2 = {VV, ww} (homozygoter Versuchsausgang) und E3 =

{VV, Vw ,wV} (violette Bliitenfarbe) , so gilt (E 1 oder E2 ) = {VV, Vw ,wV,ww} =

n, (E 2 und E3 ) = {VV} und (E1 und E 2 ) = 0.

1.1.2

Laplace-Wahrscheinlichkeit

Wir setzen nun ein Zufallsexperiment mit endlich vielen , verschiedenen Ausgiingen

voraus . Urn das Zufallsexperiment zu beschreiben, muss man die Ergebnismenge

n nennen und eine Bewertung der einzelnen Ausgiinge durch sogenannte Wahrscheinlichkeiten vornehmen, d.h. durch Kennzahlen, die einen Vergleich der

Ausgange hinsichtlich der Moglichkeit ihres Eintretens erlauben. Recht einfach

ist die Situation dann , wenn das ZufaIlsexperiment lauter gleichwahrscheinliche

Ausgiinge besitzt . In diesem Falle ist es naheliegend, alle Ausgange mit derselben

Wahrscheinlichkeit zu bewerten und als Folge davon die Wahrscheinlichkeit P(E)

eines Ereignisses E proportional zur Anzahl lEI der in E befindlichen Ausgange

anzusetzen. Wir schreib en also P(E) = clEI, wobei c eine gewisse Proportionalitatskonstante bedeutet. Man nennt lEI auch die Anzahl der fiir das Ereignis E

"giinstigen" Ausgange . In Analogie dazu bezeichnen wir mit Inl die Anzahl aIler

moglichen Ausgange des betrachteten Zufallsexperimentes. Legt man c so fest ,

dass p(n) = 1 (Normierungsbedingung) erfiillt ist, ergibt sich die auf Laplace

zuriickgehende klassische Definition

P( E)

= Anzahl der fiir E

giinstigen Ausgange

Anzahl der moglichen Ausgiinge

=~

Inl

(1.1)

der Wahrs cheinlichkeit, die man auch als Laplace-Wahrscheinlichkeit bezeichnet . Betrachten wir kurz ein einfaches Beispiel. Beim Kreuzungsversuch der Abb .

1.1 ist n = {VV, Vw , wV, ww} , also Inl = 4. Die Anzahl der fiir das Ereignis

E = {Vw , wV} (heterozygoter Versuchsausgang) giinstigen Ausgange ist lEI = 2.

Unter der (durch die Erfahrung bestatigten) Annahme, dass alle vier Ausgange

gleichwahrs cheinlich sind , erhalt man die Wahrscheinlichkeit P(E) = IEI/lnl =

2/4 = 1/2. Bei Anwendung der Formel (1.1) hat man stets die in der Ergebnismenge n bzw. die im Ereignis E enthaltenen Ausgange abzuzahlen. Dafiir gibt es

niitzliche Hilfsmittel, wie z.B. das im folgenden Beispiel verwendete Baumdiagramm.

4

1 Rechnen mit Wahrscheinlichkeiten

Abb . 1.2. Baumdiagramm zur Berechnung des Diversitatsindex von Simpson

Beispiel 1.1. Der Diversitatsindex C nach Simpson ist definiert als die

Wahrscheinlichkeit, dass zwei aus einer Artengemeinschaft zufallig ausgewahlte Individuen zur selben Art gehoren. Wir wollen eine Formel zur Berechnung von C herleiten, wenn die Artengemeinschaft aus den zwei Arten

Sl und S2 mit nl bzw. n2 Individuen besteht. Dazu denken wir uns die Individuen der ersten und zweiten Art von 1 bis nl bzw. nl + 1 bis n = nl + n2

durchnummeriert. Offensichtlich gibt es n verschiedene Moglichkeiten, das

erste Individuum auszuwahlen. In Abb . 1.2 sind diese Auswahlmoglichkeiten so veranschaulicht, dass von einem Punkt (der sogenannten Wurzel des

Baumes) ausgehend zu n Punkten Strecken gezogen werden, von denen jede

einem der durchnummerierten Individuen entspricht . Nachdcm ein Individuum ausgewahlt worden ist, gibt es offensichtlich nur mehr n - 1 Moglichkeiten, irgendein zweites Individuum auszuwahlen. Die zufallige Auswahl

zweier Individuen stellt somit ein (zweistufiges) Zufallsexperiment dar mit

Inl = n(n - 1) = (nl + n2)(n) + n2 - 1) moglichen Ausgiingen . Gesucht

ist die Wahrscheinlichkeit des Ereignisses E , zwei Individuen derselben Art

zu erhalten. Urn lEI zu ermitteln, nehmen wir zuerst an, dass als erstes ein

Sl-Individuum ausgewahlt wurde. Zu jedem so ausgewahlten S)-Individuum

(z.B. dem i-ten) gibt es nl-l Moglichkeiten, ein weiteres Sl-Individuum auszuwahlen. Zwei Sl-Individuen konnen also auf nl(nl -1) verschiedene Arten

ausgewahlt werden. Analog findet man n2( n2 - 1) verschiedene Moglichkeiten fur die Auswahl zweier S2-Individuen. Daher ist die Anzahl der fiir E

giinstigen Ereignisse durch lEI = nl(nl - 1) + n2(n2 - 1) gegeben. Es folgt

5

1.1 Begriff der Wahrscheinlichkeit

Tabelle 1.1. Stabilisierung der relativen Hiiufigkeit hn(E) des Ereignisses E=

"gerade Augenzahl" bei einem Wiirfelexperiment

n

1

2

3

4

5

6

7

8

9

10

1.1.3

hn(E)

1

1

1

1

0.8

0.667

0.571

0.5

0.556

0.5

100

200

300

400

500

600

700

800

900

1000

0.43

0.46

0.5

0.503

0.504

0.495

0.489

0.499

0.504

0.501

Statistische Wahrscheinlichkeit

Die Annahme von endlich vielen und gleichwahrscheinlichen Ausgiingen trifft bei

vielen Zufallsexperimenten nicht zu. Urn auch im allgemeinen Fall die Wahrscheinlichkeit eines Ereignisses bestimmen zu konnen, macht man sich die folgende Erfahrungetatsache zunutze: Wir fiihren das betrachtete Zufallsexperiment

wiederholt aus, wobei die einzelnen Wiederholungen als voneinander unabhiingig,

d .h. einander nicht beeinflussend vorausgesetzt werden. Es zeigt sich dann, dass

sich mit wachsender Anzahl n der Versuchsdurchfiihrungen die relative Haufigkeit hn(E) eines Ereignisses E (also die durch n geteilte Anzahl der Versuchsdurchfiihrungen, bei denen E eintritt) einem konstanten Wert niihert, den man

als die (statistische) Wahrscheinlichkeit P(E) von E bezeichnet . Es gilt also

P(E)

~

hn ( E) fiir geniigend groBes n.

(1.2)

Die "Stabilisierung" der relativen Hiiufigkeit eines Ereignisses urn einen konstanten Wert bezeichnet man auch als das empirische Gesetz der groBen Zahlen.

Den Prozess der Stabilisierung kann man z.B . durch Wiirfelexperimente demonstrieren . Tabelle 1.1 enthiilt das Ergebnis einer (auf einem Computer generierten)

Versuchsserie, bei der die relative Hiiufigkeit fur das Auftreten einer geraden Augenzahl in Abhiingigkeit von der Anzahl n der Versuchsdurchfiihrungen dargestellt

ist.

1.1.4

Elementare Eigenschaften der Wahrscheinlichkeit

Im Prinzip kann jedem auf der Ergebnismenge eines Zufallsexperimentes definierten Ereignis E die bei oftmaliger Wiederholung "stabilisierte" relative Haufigkeit hn ( E) als Wahrscheinlichkeit P( E) zugeordnet werden. Man nennt diese Zuordnung die durch das Zufallsexperiment erzeugte Wahrscheinlichkeitsverteilung. Man erkennt unmittelbar aus der Definition, dass P( E) (und ebenso auch

6

1 Rechnen mit Wahrscheinlichkeiten

n=1

n=2

n=3

K

M

~

K

~

M

K

M

/\/\/\/\

K

M

K

M

K

M

K

M

Abb . 1.3. Baumdiagramm zu Beispiel 1.2

die durch (1.1) definierte Laplace-Wahrscheinlichkeit) folgende Eigenschaften aufweist:

• Fur jedes Ereignis E ist P(E) ~ 0 (Nichtnegativitateeigenschaft).

• Fur das sichere Ereignis

n ist

p(n) = 1 (Normiertheitseigenschaft) .

• 1st El, E 2 , •• • eine endliche Folge yon paarweise disjunkten Ereignissen und

A das Ereignis (E 1 oder E2 oder . . . ), dann ist P(A) = P(E 1 ) + P(E 2 ) +...

(Additivitatseigenschaft).

In der Mathematik wird mit diesen Eigenschaften (ergiinzt urn die auch auf unendliche Folgen ausgedehnte Additivitatseigenschaft) die Wahrscheinlichkeitsverteilung axiomatisch postuliert (Kolmogorov'sche Axiome) .

Die Anwendung der Additivitatseigenschaft auf zwei disjunkte Ereignisse E 1

und E2 fiihrt auf die sogenannte Additionsregel P(E 1 oder E2 ) = P(E1 )+ P(E2 ) ;

setzt man speziell E 1 = E und E2 = E, erhiilt man die niitzli che Formel P(E) =

1 - P( E) ftir zwei komplementiire Ereignisse.

Beispiel 1.2. Ein Ehepaar wiinscht sich wenigstens ein Miidchen. Wieviele

Kinder miissen "geplant" werden, damit dieser Wunsch mit einer Sicherheit

(d.h . Wahrscheinlichkeit) yon mindestens 95% in Erfiillung geht? (Knabenund Miidchengeburten mogen als angeniihert gleichwahrscheinlich gelten.)

Wir bezeichnen mit En das Ereignis "Von n Kindem ist mindestens eines

ein Miidchen". Urn P(E n) in Abhiingigkeit yon n darzustellen, berechnen

wir zuerst P(E n), d.h. die Wahrscheinlichkeit des zu En komplementiiren

Ereignisses En = "Von n Kindem ist kein einziges ein Miidchen". Mit Hilfe

eines Baumdiagramms (ygl. Abb. 1.3) kann man sich leicht klarrnachen,

dass Inl = 2n und IEnl = 1 ist, so dass P(E n) = 1/2 n und schlieBlich

P(E n) = 1 - P(E n) = 1 - 1/2 n folgt. Gesucht ist also die kleinste ganze

Zahl n, filr die 1 - 1/2 n ~ 0.95 gilt. Durch Umforrnung ergibt sich daraus

n ~ 1~21n O.~5 = 4.32, d.h ., erst n = 5 "geplante" Kinder ergeben eine

Sicherheit yon zumindest 95%, dass sich darunter wenigstens ein Miidchen

befindet .

7

1.2 Bedingte Wahrscheinlichkeit

1.2

1.2.1

Bedingte Wahrscheinlichkeit

Definition der bedingten Wahrscheinlichkeit

Wir betrachten ein Zufallsexperiment mit der Ergebnismenge 0 und zwei Ereignisse A und B aus O. Urn ein konkretes Experiment vor Augen zu haben ,

denke man an die hintereinander erfolgende, zufallige Auswahl von 2 Individuen aus einer Population mit n1 Individuen der Art 8 1 und n2 Individuen der

Art 8 2 (vgl. Beispiel 1.2); A und B seien die Ereignisse, dass das erste bzw.

zweite ausgewahlte Individuum aus 8 1 stammt. Die Ergebnismenge 0 des aus

den beiden Auswahlvorgangen zusammengesetzten Zufallsexperimentes umfasst

insgesamt 101 = n(n - 1) Ausgange. Offensichtlich spielt bei der Berechnung der

Wahrscheinlichkeit des Ereignisses B das Wissen iiber den Ausgang des ersten

Auswahlvorganges eine Rolle.

Hat man namlich keine Kenntnis, ob das zuerst ausgewahlte Individuum zu

8 1 oder 8 2 gehort, muss man bei der Bestimmung der Wahrscheinlichkeit von B

sowohl A als auch .4 beriicksichtigen; das Ere ignis B tritt genau dann ein, wenn

entweder = (A und B) oder D = (.4 und B) gilt. und D sind disjunkt, so dass

P(B) = P(C) + P(D) ist . Wegen lei = n1(n1 - 1) und IDI = n2n1 ist

e

e

P(B) = n1(n1 - 1) +

n(n -

1)

n1 n2 _ n1

n(n - 1)

n

WeiB man dagegen, dass beim ersten Auswahlvorgang z.B. ein 8 rIndividuum

ausgewahlt wurde, also A eingetreten ist, wird man dieses Vorwissen bei der Bestimmung der Wahrscheinlichkeit von B einbringen. Da die zweite Auswahl unter

der Bedingung erfolgt, dass bereits ein 8 rIndividuum ausgewahlt wurde, sprechen wir nun genauer vom Ereignis Bunter der Bedingung A und schreiben dafiir

BIA . Durch die Bedingung A wird das urspriingliche Experiment auf den zweiten

Auswahlvorgang eingeschrankt ; die Ergebnismenge des so eingeschrankten Experimentes sei 0'. Offensichtlich ist 10'1 = n -1. Von den in 0' liegenden Ausgangen

sind n1 - 1 fiir BIA giinstig, so dass

P(BIA)

= n1 -

1

n-l

ist . Man nennt allgemein die Wahrscheinlichkeit P(BIA) dafiir , dass ein Ereignis B

zutrifft , unt er der Vorausetzung, dass ein anderes Ereignis A eingetreten ist , eine

bedingte Wahrscheinlichkeit . Zu einer Definitionsgleichung fiir die bedingte

Wahrs cheinlichkeit P(BIA) kommt man auf folgende Weise:

Da nach Voraussetzung A eingetreten ist, kann B nur in Verbindung mit A

gelten: es ist dah er nahe liegend , die Wahrs cheinlichkeit von BIA proportional

zur Wahrscheinlichkeit von (A und B) anzusetzen , d.h ., P(BIA) = cP(A und B)

zu schr eib en mit der Proportionalitatskonstanten c. Auf Grund der unmittelbar

einsichtigen Forderung P(AIA) = 1 ergib t sich c = 1/ P(A), wobei P(A) > 0

vorauszusetz en ist. Zusammenfassend gelangt man also zur Definit ionsgleichung

P(BIA)

=

P(A und B)

P(A)

,

(1.3)

8

1 Rechnen mit Wahrscheinlichkeiten

mit der die bedingte Wahrscheinlichkeit P(BIA) auf die Berechnung der Wahrscheinlichkeiten P(A und B) und P(A) zuriickgefiihrt wird. 1m Besonderen liefert

(1.3) das im oben betrachteten Beispiel auf direktem Wege gefundene Resultat .

Einerseits ist namlich P(A und B) = n~f:~~~); denn das Ereignis (A undB) beinhaltet I(A undB)I = n,(n, - 1) Ausgiinge, da es n, Moglichkeiten gibt, zuerst

ein Srlndividuum auszuwahlen, und zu jeder ersten Wahl n, - 1 Moglichkeiten ,

ein zweites S,-Individuum auszuwahlen. Andererseits ist P(A) = nl/n; mit (1.3)

folgt daher P(BIA) = n~,'.

Allgemein gelten auch fur bedingte Wahrscheinlichkeiten die in Abschnitt

1.1.4 fiir "unbedingte" Wahrscheinlichkeiten formulierten Eigenschaften (Kolmogorov'sche Axiome); im Besonderen seien die Nichtnegativitiit (P(BIA) ~ 0) ,

die Normiertheit (p(nIA) = 1) sowie die Additionsregel P(B,IA oder B 2IA) =

P(B,IA) + P(B 2IA) fiir zwei disjunkte Ereignisse B" B 2 erwahnt.

Beispiel 1.3.

i. Nach der Sterbetafel 1990/92 fiir Osterreich sind die Wahrscheinlichkeiten der Ereignisse Em80 und Emso, dass ein mannlicher Neugeborener

das achtzigste bzw . fiinfzigste Lebensjahr vollendet, durch P(Em80) = 0.365

bzw . P(Emso) = 0.919 gegeben. Die entsprechenden Wahrscheinlichkeiten

fur eine weibliche Neugeborene sind P(Ew80) = 0.566 bzw. P(Ewso) = 0.958.

Wegen (E m8o und E mso) = Em80 und (E wso und Ewso) = Ewso - ein(e) 80Jiihrige(r) hat natiirlich au ch das 50. Jahr vollendet - findet man als (bedingte) Wahrscheinlichkeiten, dass ein 5Q-jiihriger Mann bzw . eine 50-jiihrige

Frau das achtzigste Lebensjahr vollenden, P(Em80IEmso) = ~:~~; = 0.397

und P(Ew80IEwso) = ~:;~~ = 0.591.

ii. In der Medizin werden bedingte Wahrscheinlichkeiten u.a. verwendet,

urn den Zusammenhang zwischen ein em interessierenden Risikofaktor und

einer bestimmten Diagnose (z.B . Krankheit) zu beschreiben. Bezeichnen R+

und R_ die Ereignisse "Risikofaktor vorhanden bzw. nicht vorhanden" sowie D+ und D_ die Ereignisse "Krankheit tritt auf bzw . tritt nicht auf" ,

dann stehen die Chancen (odds) , die Krankheit zu bekommen, wenn man

dem Risiko ausgesetzt ist , im Verhaltnis P(D+IR+) : P(D_IR+); analog

konnen die Chancen zu erkranken, wenn man dem Risiko nicht ausgesetzt

ist , durch P(D+IR_) : P(D_IR_) ausgednlckt werden. Bildet man schlieBlich den Quotienten aus den Wahrscheinlichkeitsverhiiltnissen fiir und gegen

das Auftreten der Erkrankung in den beiden unterschiedenen Risikosituationen , erhalt man das sogenannte Chancenverhaltnis (Odds-Ratio)

Im folgend en Zahlenbeispiel ist der Risikofaktor das "Geburtsgewicht" (R+

und R_ bedeuten ein Geburtsgewicht kleiner bzw . groBer gleich 2.500 g). Fur

Osterreich (1996) ist die - vorn Geburtsgewicht abhiingige - Wahrscheinlichkeit , da ss ein Siiugling stirbt (Ereignis D+), durch P(D+IR+) = 0.0515 bzw.

P( D+ IR_) = 0.0022 gegeb en . Gilt R+, stehen die Wahrscheinlichkeiten fiir

9

1.2 Bedingte Wahrschcinlichkeit

Tod und Uberleben im Verhiiltnis 0.0515 : 0.9485 ~ 1 : 18; gilt dagegen

R_, lautet das entsprechende Verhiiltnis 0.0022 : 0.9978 ~ 1 : 454. Damit

ergibt sich das Odds-Ratio w = 24.6, das eine deutliche Abhiingigkeit der

Siiuglingsstcrblichkeit vom Geburtsgewicht zum Ausdruck bringt.

1.2.2

Unabhangige Ereignisse

Durch Umformung gewinnt man aus Forme! (1.3) P(A und B) = P(BIA)P(A),

woraus sich die Wahrscheinlichkeit des zusammengesetzten Ereignisses (A und B)

als Produkt der Wahrscheinlichkeiten P( BIA) und P(A) darstellen lasst . Die Formel behalt auch im Faile P(A) = 0 ihre Giiltigkeit; indem man A und B vertauscht, gilt gleichermaBen P(A und B) = P(AIB)P(B). Wir notieren die Multiplikationsregel

P(A und B)

= P(BIA)P(A) = P(AIB)P(B) .

(1.4)

Wenn die Wahrscheinlichkeit von B (bzw. A) nicht davon abhiingt, ob A oder A

(bzw. B oder B) eintritt, wenn also P(BIA) = P(B) bzw. P(AIB) = P(A) gilt ,

heiBen die Ereignisse A und B unabhangig. Fur zwei unabhiingige Ereignisse A

und B vereinfacht sich die Multiplikationsrege! auf

P(Aund B)

= P(A)P(B) .

(1.5)

Beispiel 1.4. Bei der Bearbeitung eines Problems sind zwei Entscheidungen zu treffen, von denen jede einze!ne mit der Wahrscheinlichkeit O:j = 0.05

eine Fehlentscheidung sein kann. Wir bestimmen die sogenannte simultane

Irrtumswahrscheinlichkeit 0:9 , d.h. die Wahrscheinlichkeit, dass eine der Entscheidungen oder beide falsch sind . (Simultane Irrtumswahrscheinlichkeiten

spielen bei wiederholten Signifikanzpnifungen eine Rolle.) Offensichtlich ist

das Ereignis, wenigstens einmal falsch zu entscheiden, komplementiir zu dem

Ereignis, zweimal richtig zu entscheiden. Es seien A und B die Ereignisse,

dass die erste bzw. zweite Entscheidung richtig ist . Da A und B komplementar sind zu den Ereignissen, das erste bzw. zweite Mal falsch zu entscheiden, ist P(A) = P( B) = 1 - o, = 0.95.

i. Wir setzen zuerst A und B als voneinander unabhiingig voraus . Die

Wahrscheinlichkeit des zusammengesetzten Ereignisses (A und B), dass sowohl die erste als auch die zweite Entscheidung richtig ist, kann dann mit

Hilfe der Multiplikationsrege! (1.4) berechnet werden. Es ist P(A und B) =

P(A)P(B) = (1 - O:j? = 0.9025 ~ 0.9. Die Wahrscheinlichkeit, wenigstens

einmal falsch zu entscheiden, ist daher 0:9 = 1 - (1- O:j)2 = 20: j - O:j2 ~ 0.1.

(Man beachte, dass die simultane Irrtumswahrscheinlichkeit etwa doppe!t

so groB ist wie die Irrtumswahrscheinlichkeit einer jeden einze!nen Entscheidung .)

ii. Wenn die Ereignisse A und B nicht als unabhiingig vorausgesetzt

werden konnen, kommt man auf folgende Weise zu einer Abschiitzung der

simultanen Irrtumswahrscheinlichkeit. Wir betrachten die Ereignisse

£1

= (A und B),

£2

= (13 und A) und

£3

= (A und B) ;

10

1 Rechnen mit Wahrscheinlichkeiten

(A und B) --+--+---o

B

(A und B)

-~--4--<>

A

(8 und A)

-+---\----<>

Abb . 1.4. Veranschaulichung zu Beispiel1.4ii

es ist P(Ed = P(BIA)P(A) ::; P(A) und P(E 2 ) = P(AIB)P(B) ::; P(B) .

Nach Abb . 1.4 sind die Ereigniss e Ell E2 und E3 paarweise disjunkt, und

fur das sichere Ereignis gilt die Darstellung n = (E 1 oder E2 oder E3 ) . Es

folgt p(n) = 1 = P(Ed+P(E2)+P(E3 ) bzw. P(E 3 ) = 1-P(Ed-P(E2 ) ,

woraus sich die Ungleichung

P(A und B) 2: 1 - P(A) - P(B) = 1 - (1 - P(A) - (1 - P(B»

ergibt (Sonderfall der Bonferroni-Ungleichung) . Setzt man P(A) = P(B) =

1- 0i ein, erhalt man P( A und B) 2: 1- 20i und schlieBlich fiir die simultane

Irrtumswahrscheinlichkeit 0 9 = 1 - P(A und B) ::; 20i.

1.2.3

Satz von der totalen Wahrscheinlichkeit

Wir gehen von einem Zufallsexperiment mit der Ergebnismenge n und einer

"Zerlegung" von n in n Ereignisse AI, A 2 , •• • , An mit P(A i ) > 0 aus ; diese

sind so beschaffen , dass jeder Versuchsausgang in genau einem Ai liegt (vgl. Abb .

1.5). Ferner sei B irgendein Ereignis aus n mit P( B) > O. Mit Hilfe der Ai findet

man durch folgende Uberlegung eine Darstellungsformel fiir P(B) : Wir bilden die

zusammengesetzten Ereigniss e B, = (B und Ai) (i = 1,2 , ... , n) ; in jedem B, sind

also die Ausgange von B zusammengefasst, die auch in Ai liegen . Wie die Ai sind

auch die B, paarweise disjunkt ; da in den Ai alle Ausgange der Ergebnismenge

liegen, kann es keinen in B liegend en Ausgang geben , der nicht in einem B, liegt .

oder B n ) lind wegen der AdditivitatseigenDaher gilt B = (B 1 oder B 2 oder

schaft P(B) = P(Bd + P(B 2 ) +

+ P(B n) = P(B und Ad + P(B und A2 ) +

. . ·+P(B und An). Mit Hilfe der Multiplikationsregel (1.4) erhalt man daraus den

sogenannten Satz von der totalen Wahrscheinlichkeit

Beispiel 1.5. Zur Beschreibung der genetis chen Struktur einer Population

werden Genotypfrequenzen bzw. Genfrequen zen verwend et. Wir betrachten ein Merkrnal M, das dur ch einen Genort mit zwei Allelen (Genen) MI,

1.2 Bedingte Wahrscheinlichkeit

11

B

o-----'\---+-- B, = (B und Ai)

Abb. 1.5. Veranschaulichung zum Satz von der totalen Wahrscheinlichkeit

M 2 bestimmt ist. Durch Kombination der Allele ergeben sich die Genotypen M1Mh M 1M2 und M 2M2 • Als Genotypfrequenzen bezeichnen wir die

Wahrscheinlichkeiten D, H und R dafiir, dass ein zufallig ausgewahltes Individuum vom Genotyp MlMh M lM2 bzw. M 2M2 ist. Als Genfrequenzen

bezeichnen wir die Wahrscheinlichkeiten p und q dafiir, dass ein zufallig

ausgewahltes Gen vom Typ M, bzw. M 2 ist. Mit Hilfe des Satzes von der

totalen Wahrscheinlichkeit lassen sich die Genfrequenzen aus den Genotypfrequenzen berechnen, wie im Folgenden fur die Genfrequenz p gezeigt wird.

Zu diesem Zweck simulieren wir die Auswahl eines Gens aus der Population durch ein zweistufiges Zufallsexperiment, das in der Auswahl eines

Genotyps aus der Population und der nachfolgenden Auswahl eines Gens

aus dem Genotyp besteht. Indem wir die Auswahl der Genotypen MlMh

M lM2 und M 2M2 (in Verbindung mit der anschlieBenden Auswahl des ersten oder zweiten Gens) als Ereignis A l , A 2 bzw. Aa bezeichnen , haben wir

in den (paarweise disjunkten) Ereignissen A h A 2 und Aa eine Zerlegung

der Ergebnismenge des Zufallsexperimentes; die Wahrscheinlichkeiten dieser Ereignisse sind die Genotypfrequenzen, d.h . P(AI) = D, P(A 2 ) = H

und P(A a) = R. Bezeichnet weiter B die Auswahl eines Ml-Gens, kann die

gesuchte Genotypfrequenz p = P( B) als totale Wahrscheinlichkeit wie folgt

bestimmt werden:

p = P(B)

P(BIAI)P(AI)

=

1.2.4

+ P(BIA 2)P(A2 ) + P(BIAa)P(Aa)

+0 . R

1 · D + (1/2) . H

D+H/2

Bayes'sche Formel

Wie in Abschnitt 1.2.3 bedeuten die Ereignisse A h A 2 , . •. , An eine Zerlegung

der Ergebnismenge eines Zufallsexperiments, und B sei irgendein Ereignis mit

P(B) > O. Man stelle sich z.B. unter B das Auftreten eines Symptoms und unter den Ai mogliche Krankheitsursachen (Diagnosen) vor; aus Patientenstatistiken lassen sich die bedingten Wahrscheinl ichkeiten P( BIA i ) fiir das Auftreten

eines Symptoms bei Vorliegen einer Erkrankung recht gut schatzen. Der umge-