Kontextuelle Gleichheit, Programmtransformation, Korrektheit

Werbung

Kapitel 5

Kontextuelle Gleichheit,

Programmtransformation,

Korrektheit

In diesem Kapitel soll die Gleichheit von Programmen bzw. Programmfragmenten von Haskell behandelt werden. Wir führen das auf die Gleichheit von KFPProgrammen zurück. Diese Methode baut darauf auf, dass Haskell-Programme

in KFP-Programme übersetzt werden können.

Weiterhin benötigt diese Gleichheit die operationalen Semantik in KFP, d.h.

Kontexte und die Normalordnungsreduktion in KFP. Wichtigstes Unterscheidungsmerkmal zwischen Ausdrücken bzw. theoretische Beobachtung wird die

Terminierung / Nichtterminierung sein. Es kann dann geschlossen werden, dass

Gleichungen die in KFP gelten, auch rückübersetzt werden können. Aber man

kann nicht alle Gleichheiten in Haskell damit erfassen, da es in Haskell weniger

Kontexte als in KFP gibt.

5.1

Die Kernsprache KFP

In diesem Kapitel führen wir die funktionale Kernsprache KFP ein, auf die man

die höheren Konstrukte einer funktionalen Programmiersprache zurückführen

kann, insbesondere KFPT und Haskellprogramme, Diese Kernsprache ist für

Grundlagenbetrachtungen für nicht-strikte (und strikte) funktionale Programmiersprachen geeignet, da sie eine sehr einfache Syntax und wenig Reduktionsregeln hat.

5.1.1

Syntax der funktionalen Kernsprache KFP

Die Kernsprache KFP ist angelehnt an Kernsprachen der Compiler von funktionalen Programmiersprachen und hat möglichst einfache Syntax, und möglichst

1

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

2

wenig vordefinierte Funktionen, Namen und Konstrukte. KFP hat ein schwaches

Typsystem (Programme mit Typfehlern sind möglich).

Syntax: Es gibt Konstantensymbole, die jeweils eine feste Stelligkeit haben.

Diese nennen wir Konstruktoren. Die Anzahl der Konstruktoren sei N , die Konstruktoren seien mit ci , i = 1, . . . , N bezeichnet,

Wir nehmen an, dass es eine Möglichkeit gibt, alle Konstruktoren mit Stelligkeit

anzugeben, ohne dass wir diese Methode näher spezifizieren. Zum Beispiel als

eine Auflistung aller Konstruktoren mit Stelligkeit.

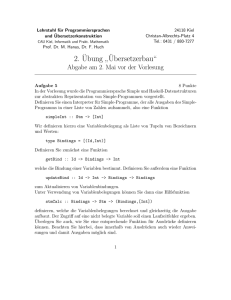

Definition 5.1.1 Eine einfache kontextfreie Grammatik für KFP-Ausdrücke

(Terme, Expressions EXP ) ist:

E

::= V

V sind Variablen

| \V. EXP

wobei V eine Variable ist.

| (E1 E2 )

| (c E1 . . . En )

wobei n = ar (c)

| (case E {P at1 → E1 ; . . . ; P atN +1 → EN +1 })

Hierbei ist P ati Pattern zum Konstruktor i, und

P atN +1 das Pattern lambda.

(P ati → Ei ) heißt auch case-Alternative.

Pat

::=

(c V1 . . . Var (c) ) | lambda

Die Variablen Vi müssen alle verschieden sein.

Wesentlich ist die andere Struktur des jetzt ungetypten case-Konstruktes: Es

gibt nur ein case, und es sind stets alle Konstruktoren als Alternativen vorhanden, ebenso eine weitere Alternative, die mit dem Pattern lambda abgedeckt

wird, und die zum Zuge kommt, wenn der zu untersuchende Ausdruck eine

Abstraktion ist.

Beispiel 5.1.2 Die Funktion, die erkennt, ob eine Liste, die mit den Konstruktoren Nil, Cons aufgebaut wurde, leer ist, kann man schreiben als:

\xs . (case xs {Nil -> True;

....

(Cons y ys) -> False;

;lambda -> bot}

Bei Konstruktoranwendungen und Pattern gibt es feste Stelligkeitsregeln, da es

sich um feste syntaktische Strukturen handelt.

Zur Kernsprache STG des Compilers von Haskell gehört auch noch ein sogenanntes letrec. Lässt man letrec zu, so gewinnt man Effizienz beim Übersetzen und kann auch eine abstrakte Maschine besser und effizienter formulieren.

Die formale Behandlung eines letrec in der Kernsprache ist sehr aufwändig

und komplex. Zudem kann man mit einer kleineren Kernsprache KFP für formale Untersuchungen der wesentlichen Aspekten der operationalen Semantik

auskommen. Wir lassen deshalb letrec in der Kernsprache weg.

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

3

Der Nachteil ist, dass man die Anzahl Schritte einer Auswertung, oder die Anzahl der Schritte einer abstrakten Maschine, d.h. die Komplexität eines Programms, nicht in dieser let-freien Theorie behandeln kann, da die ReduktionsAnzahlen in KFP und Haskell zu verschieden sind.

5.1.2

Übersetzung von Haskell und KFPT nach KFP

Wir gehen kurz auf die erweiterte Kernsprache KFPT ein und zeigen, wie man

diese in KFP kodiert.

Man muss nur noch spezifizieren, wie man den typisierten case-Ausdruck nach

KFP übersetzt:

Man übersetzt ein caseT yp einfach als ein KFP-case, wobei die vorhandenen

Alternativen übernommen werden und für die anderen Konstruktoren extraPattern hinzugefügt werden: (pat → bot), ebenso am Ende (lambda → bot).

Hierbei ist bot ein nichtterminierender Ausdruck.

Diese Übersetzung ist natürlich rekursiv auch für die Unterterme durchzuführen.

Die Verwendung von bot statt eines gezielteren Fehlerausgangs ist absichtlich,

denn in KFP werden Fehler, Abbrüche und Nichtterminierung in einen Topf

geworfen und als gleich behandelt. Der Hintergrund ist, dass KFP einen Begriff

der Gleichheit von Programmen und Ausdrücken bereitstellen wird.

Übersetzung von Haskell nach KFP

Die meisten Konstrukte von Haskell kann man dadurch nach KFP übersetzen,

indem man diese zuerst nach KFPT und dann nach KFP übersetzt. Es fehlen

die Übersetzung rekursiv definierter Superkombinatoren nach KFPT und die

Übersetzung von seq und $!, wobei $! einInfix-kokmbinator ist, der statt der

Auswertung von (f s) zuerst s auswertet, dann erst (f s), d.h. er macht f strikt.

Die rekursiven Superkombinatoren werden wir noch nachholen.

Die Funktionen seq, $! in Haskell müssen direkt nach KFP übersetzt werden:

seq

s t = case s

{p_1 -> t; ... p_{N+1} -> t}

wobei die Pattern neue Variablen enthalten sollen. Die Übersetzung von strict

kann einfach mittels seq gemacht werden, und von seq weiß man, wie es nach

KFP übersetzt wird.

($!)

= \f x -> seq x (f x)

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

5.1.3

4

Baumdarstellung von Termen

Die Darstellung von Ausdrücken als markierte geordnete Bäume (Syntaxbäume)

wird oft verwendet, wenn auch nur implizit: Als Beispiel betrachte f (f a b) c

·=

==

==

==

=

c

·<

f

<<

<<

<<

<

a

f

b

Der erste Term in einer Liste von Termen ist die Funktion, der Rest sind die

Argumente:

Man kann eine kompaktere Darstellung wählen:

a

f·

===

==

==

=

c

f· @

@@

@@

@@

@

b

Bei Termen als Bäumen werden wir auch die Adressierungsmethode in Bäumen

verwenden:

f·

===

1

==2

==

=

c

f· @

@@

1

@@

2 @@@

a

b

Die Wurzel (mit Markierung f) hat Adresse ε (leeres Wort) Der Knoten mit

Markierung c hat Adresse 2. Die Blätter mit den Markierungen a, und b haben

die Adressen 1.1 und 1.2.

Die Darstellung mit expliziten Anwendungsknoten (mit @ markiert) ist folgendermaßen.

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

f

f

5.1.4

5

@·

} ???

}

??

}

??

}}

?

}~ }

c

@@

@@

@@

@@

@

@?

~~ ???

~

~

??

~~

??

~~~

@@

b

@@

@@

@@

@

a

Auswertungsregeln

Wir geben der Vollständigkeit halber die komplette operationale Semantik von

KFP an, auch wenn sich diese nur leicht von der operationalen Semantik von

KFPT unterscheidet.

Definition 5.1.3 Ein Wert bzw. eine WHNF (weak head normal form, schwache Kopfnormalform) in KFP ist ein Ausdruck entweder von der Form

1. (c t1 . . . tn ), wobei n = arity(c) und c ein Konstruktor ist (CWHNF), oder

2. eine Abstraktion: λx . e (FWHNF)

Dazu definieren wir zunächst, was Programmkontexte sind:

Definition 5.1.4 Ein Programmkontext (ein Kontext) ist analog zu einem

Ausdruck, der an einer Stelle ein “Loch“ hat, an dem ein Ausdruck eingesetzt

werden kann. Formal definieren wir: Ein Kontext kann sein:

C

::= [] | (e C) | (C e) | (λx . C)

| (c e1 . . . C . . . ear (c) )

| (case C {p1 → t1 ; . . . ; pN +1 → tN +1 })

| (case t {p1 → t1 ; . . . ; pi → C; . . . ; pN +1 → tN +1 })

wobei e ein Ausdruck ist.

Allerdings gilt in Kontexten die freie Umbenennbarkeit von Variablen nur für

die Unterausdrücke, die das Loch nicht enthalten.

Wenn das Loch in einem Gültigkeitsbereich einer Variablen ist, dann wird der

Kontext als syntaktisch gegebenes Programm angesehen, in dem man an der

Loch-Stelle andere Ausdrücke einsetzen kann, auch solche, die freie Variablen

haben, und diese freien Variablen dann nach dem Einsetzen gebunden sind, d.h.

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

6

eingefangen wurden. D.h. es tritt der Effekt auf, dass die Namen von gebundenen Variablen eine Rolle spielen, sofern das Loch innerhalb des Rumpfs einer

Abstraktion ist. Z.B. ist der Kontext λx . [] vom Kontext λu . [] verschieden,

da beim Einsetzen von x jeweils andere Ausdrücke entstehen.

Beispiel 5.1.5 Damit sind als Kontexte z.B. definiert:

• [·] : der leere Kontext. Setzt man einen Ausdruck e in den leeren Kontext

ein, so ergibt sich e selbst.

• (x ([·] y)). Einsetzen von t in den Kontext ergibt (x (t y))

• (case (x [·]) {p1 → t1 ; . . . ; pN +1 → tN +1 }). Einsetzen von e in den

Kontext ergibt (case (x e) {p1 → t1 ; . . . ; pN +1 → tN +1 })

• Mit C := λx.([·] x) ergibt sich C[x] = λx.(x x)

Beachte, dass innerhalb eines Pattern kein Loch sein kann, ebenso ist der Kontext λ · .e nicht möglich.

Wir werden den Begriff der Gleichheit und Ungleichheit von Ausdrücken noch

formaler spezifizieren.

Definition 5.1.6 Auswertungsregeln (Reduktionsregeln), wobei (Case) zwei

Regeln hat.

Beta

((λx.t) s)

t[s/x]

Case

(case (c t1 . . . tn ) {. . . ; c x1 . . . xn → s; . . .})

s[t1 /x1 , . . . , tn /xn ]

(case (λx.t) {. . . ; lambda → s})

s

Wir nennen das die unmittelbare Reduktion von Ausdrücken. Wir unterscheiden im folgenden zwischen allgemeiner Reduktion (oder kurz: Reduktion) und

unmittelbarer Reduktion, wobei die allgemeine Reduktion auch die unmittelbare

Reduktion eines Unterausdrucks umfasst.

Die Auswertungsregeln sollen in allen Programmkontexten verwendet werden

dürfen. D.h. Wenn s → t in einem Schritt reduziert, dann gilt auch C[s] → C[t]

für jeden Programmkontext C.

Die Reduktionsrelation schreiben wir als s → t, wenn die (allgemeine) Reduktion

in einem Schritt erfolgt. Die transitive bzw. reflexiv-transitive Hülle schreiben

+

∗

wir als s −

→ t bzw. s −

→ t.

Der Begriff des Redex (reducible expression) kann jetzt definiert werden: Wenn

in C[s] das s unmittelbar reduziert werden kann, dann ist s (zusammen mit

seiner Position) ein Redex in C[s].

Man definiert die Normalordnungs-Reduktion (normal-order-Reduktion,

Standard-Reduktion), wozu man Reduktionskontexte braucht.

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

7

Definition 5.1.7 Reduktionskontexte sind:

R

::= [] | (R e) | (case R {p1 → t1 ; . . . ; pN +1 → tN +1 }

Jetzt ist die Normalordnungs-Reduktion diejenige, die immer in einem Reduktionskontext den Ausdruck unmittelbar reduziert:

Definition 5.1.8 Sei R[s] ein Ausdruck, so dass R ein Reduktionskontext ist,

wobei s keine WHNF ist, und s reduziert unmittelbar zu t:

Dann ist R[s] → R[t] die Ein-Schritt-Normalordnungsreduktion (Standardreduktion, normal order reduction) von R[s].

Der Unterterm s zusammen mit seiner Position wird auch Normalordnungsredex genannt. Die Reduktionsrelation wird mit dem Marker n versehen. Analog

n,+

wie oben bezeichnen wir die transitive und reflexiv-transitive Hülle mit −−→ bzw.

n,∗

−−→.

n,∗

Die Relation −−→ bezeichnet man auch als Normalordnungsrelation oder als Auswertung eines Terms.

Wenn ein geschlossener Term t unter Normalordnung zu einer WHNF reduziert,

dann sagen wir, t konvergiert bzw. terminiert und bezeichnen dies mit t⇓. Anderenfalls und falls t geschlossen ist, divergiert t, bezeichnet mit t⇑. Wenn t offen

ist, dann definieren wir t: divergiert (t⇑), falls t eine Normalordnungsreduktion

hat, die unendlich ist, oder die Normalordnung endet mit einem Term der Form

R[t0 t00 ], wobei t0 eine Konstruktoranwendung ist und R ein Reduktionskontext.

Der Fall R[x] bleibt dabei offen.

Wir sagen, t hat eine WHNF, wenn t zu einer WHNF reduziert. Die WHNF, zu

der t unter Normalordnung reduziert, ist eindeutig, aber es gibt i.a. viele WHNFs

zu denen ein Term t reduzieren kann. Z.B. t ≡ (cons ((λx.x) True)) Nil) ist

selbst in WHNF, aber (cons True Nil) ist ebenfalls eine WHNF zu t.

Alternative Definition des Normalordnungsredex:

Sei R das Label: Starte mit tR und wende die Regeln solange an, bis keine

Anwendung mehr möglich ist.

C[(s t)R ]

→ C[(sR t)]

C[(case s alts)] → C[(case sR alts)]

Normalordnungsreduktion; mit R-Label definiert:

Beta

((λx.t)R s)

t[s/x]

Case

(case (c t1 . . . tn )R {. . . ; c x1 . . . xn → s; . . .})

s[t1 /x1 , . . . , tn /xn ]

(case (λx.t)R {. . . ; lambda → s})

s

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

8

Damit haben wir alle zur Auswertung von Ausdrücken notwendigen Begriffe

definiert und können jetzt Ausdrücke auswerten.

n

Beispiel 5.1.9 ((λx.x) Nil) −

→ Nil

n

n

((λx.λy.x) s t) −

→ ((λy.s) t) −

→ s.

Lemma 5.1.10 Es gilt auch in KFP:

• Jede unmittelbare Reduktion in einem Reduktionskontext ist eine Normalordnungsreduktion.

• Der Normalordnungsredex und die Normalordnungsreduktion sind eindeutig.

• Eine WHNF hat keinen Normalordnungsredex und erlaubt keine Normalordnungsreduktion.

Beweis. Das erkennt man an der Definition der Reduktionskontexts und der

Normalordnungsreduktion.

2

5.2

Kontextuelle Gleichheit von Ausdrücken in

KFP

Gleichheit von Ausdrücken s, t kann man annehmen, wenn s und t sich gleich

verhalten (Verhaltensgleichheit). Da die Erkennung des Verhaltens ein formales Beobachten erfordert, benutzen wir das Kriterium der Terminierung bzw.

Nichtterminierung als Ergebnis der theoretischen Beobachtung. Natürlich kann

man Nichtterminierung nicht praktisch bzw. effektiv beobachten, insofern ist

das Beobachtungskriterium nicht effektiv. Die formale Definition hilft aber beim

Erkennen und Nachweisen der Korrektheit von Programmtransformationen, wie

wir sehen werden.

Man sieht (offene und geschlossene) Ausdrücke s, t als gleich an, wenn Programme ihr Terminierungsverhalten niemals ändern, wenn man s durch t ersetzt.

Dieses Kriterium erscheint zunächst schwach, aber da man alle Programme und

alle Stellen innerhalb der Programme ausprobieren kann, ergibt sich ein starkes

Kriterium.

Man kann im Prinzip auch andere Formen von Tests nehmen. Wenn man Beobachten im engeren Sinne auslegt, könnte man auch die Effizienz eines Programmes als Kriterium nehmen (Anzahl der Schritte). Das wäre eine stärkere

Forderung, die wir aber hier nicht betrachten, da die kontextuelle Ordnung darauf nicht zugeschnitten ist, und sich dann fast nichts mehr nachweisen lässt.

Man definiert zunächst eine Approximationsordnung s ≤c t, die bedeutet, dass

t besser terminiert als s, oder, dass s weniger Information liefert als t.

Definition 5.2.1

(Kontextuelle Approximation) Seien s, t KFP-Ausdrücke

und C[.] ein Kontext.

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

9

s ≤c t gdw. ∀C[] : C[s]⇓ ⇒ C[t]⇓

s ∼c t gdw s ≤c t ∧ t ≤c s

Die Ordnung ≤c nennen wir kontextuelle Approximation, und ∼c kontextuelle

Gleichheit.

Die Gleichheitsrelation kann man auch interpretieren als:

Terme sind gleich, wenn man sie mit keinem Experiment unterscheiden kann.

Das Experiment ist: Einsetzen in einen Kontext und Terminierung beobachten.

Ein großer Vorteil dieser Definition ist, dass man sich ganz auf die definierte

Sprache und die Auswertung zurückziehen kann, ohne die Hilfe einer externen

Semantik in Anspruch zu nehmen. Ein weiterer, dass man viele Schlüsse und

Methoden unabhängig von der Sprache entwickeln kann.

Ein kleiner Nachteil ist, dass diese Definition der Gleichheit von Ausdrücken

vom Sprachumfang abhängt. Die Gleichheit kann sich ändern, wenn man die

Sprache verkleinert oder erweitert.

Beispiel 5.2.2 Mit

∼c

kann

man

z.B.

(S

0)

von

True

unterscheiden,

indem

man

den

Kontext

case .

{True -> True; False -> True: ... ;(S x) -> bot: ...}

verwendet.

case (S 0) {True -> True; False -> True; ... ;(S x) -> bot; ...}

terminiert nicht; aber case True {True -> True; False -> True; ...}

ist reduzierbar zu True.

Eine wichtige und (im Gegensatz zu anderen Definitionen) leicht zu zeigende

Eigenschaft ist, dass sich durch Ersetzung eines Unterausdrucks e durch einen

kontextuell gleichen Ausdruck e0 ein Programm in ein kontextuell äquivalentes

verwandelt.

Aussage 5.2.3 ≤c und ∼c sind stabil gegen Einsetzung in Kontexte und ≤c ist

eine Präordnung, während ∼c eine Äquivalenzrelation ist. Zusammengefasst:

≤c ist eine Präkongruenz und ∼c ist eine Kongruenzrelation auf Ausdrücken.

Beweis. Offensichtlich ist ≤c transitiv und ∼c ist eine Äquivalenzrelation. Wir

zeigen, dass ≤c stabil gegen Einsetzung in Kontexte ist. Sei dazu s ≤c t. Wir

zeigen dass für einen beliebigen Kontext C: C[s] ≤c C[t] gilt. Sei D ein Kontext

und sei D0 := D[C[]]. Aus s ≤c t folgt dann dass D[C[s]]⇓ ⇒ D[C[t]]⇓. Da das

für alle Kontexte D gilt, folgt die Behauptung.

2

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

10

Ein Vorteil dieser Herangehensweise ist die Maximalität der kontextuellen

Gleichheit. Bei Definition einer zu schwachen Gleichheit ∼weak , d.h. die zuviele

Terme unterscheidet, kommt es vor, dass man bei bestimmten Programmtransformationen dann doch für deren Korrektheit argumentiert, obwohl die Programme nach der Transformation verschieden sind (unter ∼weak ),. Diese sind

aber i.a. noch gleich unter ∼c .

Es gilt, dass ∼c maximale Relation ist mit folgenden Eigenschaften:

• ∼c ist Kongruenz: D.h. Äquivalenzrelation und kompatibel mit Kontexten.

n

• s−

→ t =⇒ s ∼c t

• λx.s 6∼c (c . . .)

• (c1 . . .) 6∼c (c2 . . .)

• s⇑ =⇒ s 6∼c (c . . .)

• s⇑ =⇒ s 6∼c λx.s

Der Nachweis ist relativ einfach: Sei ∼max die maximale Relation mit obigen

Eigeschaften.

• ∼c hat alle diese Eigenschaften, (wobei der Nachweis von s → t =⇒ s ∼c

t erst im nächsten Abschnitt erfolgt,) also ist ∼c ⊆ ∼max .

• Sei s ∼max t, C ein Kontext, und sei C[s]⇓. Da die Relation ∼max kompatibel mit Kontexten ist, gilt C[s] ∼max C[t]. Aus C[s]⇓ folgt, dass

C[s] ∼max s0 und s0 ist eine Abstraktion oder eine Konstruktoranwendung. Damit gilt aber auch, dass C[t] ∼max s0 . Wenn die (eindeutige)

Normalordnung von C[t] nicht konvergiert, dann gilt C[t]⇑, Das ergibt

einen Widerspruch zu obigen Annahmen, also gilt C[t]⇓. Das gilt für alle

Kontexte, also gilt s ∼max t =⇒ s ∼c t.

5.3

KFP: Invarianz der Terminierung, Standardisierungssatz

Wir behandeln jetzt die Sprache KFP etwas formaler. Das Ziel dieses Kapitels

ist der Nachweis, dass die kontextuelle Äquivalenz erhalten bleibt beim Reduzieren. Dazu wird als Hilfsmittel gezeigt, dass Terminierung von Ausdrücken

erhalten bleibt, wenn man Reduktionsregeln anwendet. Genauer, dass im Falle

t → t0 die Terminierung sich nicht verändert; d.h. t⇓ ⇔ t0 ⇓. Diese erfordert

die Betrachtung beider Implikationen t⇓ ⇒ t0 ⇓ und t⇓ ⇐ t0 ⇓, bei deren Beweis

jeweils verschiedene Methoden verwendet werden.

Eine verwandte, aber doch leicht andere Aussage (Standardisierungssatz), ist der

Nachweis, dass jeder Ausdruck, der sich mit irgendeiner Folge von Reduktion

mit den Kalkülregeln auf eine WHNF reduzieren lässt, auch eine terminierende

no-Reduktion hat.

11

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

Das ganze ist technisch etwas aufwändig, aber doch elementar. Da diese Aussagen die Basis für die Korrektheit von Programmtransformationen sind, lohnt es

sich auch, diese etwas genauer durchzugehen.

Zuerst eine informelle Begründung, warum man mit einfacher Induktion nicht

zeigen kann, dass s → t =⇒ (s⇓ ⇔ t⇓). Das Problem liegt in der Verdopplung

der Beta-Reduktion:

/ (λx.(x x)) a

(λx.(x x)) ((λy.y)a)

no

no

/ ((λy.y)a) a

((λy.y)a) ((λy.y)a)

/aa

Mit Induktion nach der Länge der Normalordnung kann man damit, nachdem

man alle Überlappungsfälle analysiert hat, zumindest die Richtung s → t =⇒

(s⇓ =⇒ t⇓) zeigen. Die andere Richtung ist das Problem. Denn das obere Bild

hat Varianten: es könnte auch

/ (λx.(x x)) a

(λx.(x x)) ((λy.y)a)

no

((λy.y)a) ((λy.y)a)

no

no

/ ((λy.y)a) a

/aa

Damit hat man als allgemein Vertauschungsregel nur:

/t

s

no,∗

no

∗

s0 _ _ _/ t0

die keine Induktion mehr zulässt, da man keine oberen Schranken für die Anzahl

der Reduktionen nach Vertauschung hat.

Für die Induktion gibt es eine Lösung, die wir aber für beide Richtungen verwenden:

Wir benötigen dafür die sogenannte 1-Reduktion (siehe [?]), deren Bedeutung

die parallele 1-Schritt-Reduktion ist. D.h. zwei Terme s, t stehen in der 1Relation, wenn s parallel auf t reduzierbar ist. Hierbei ist gemeint, dass man

irgendeine Untermenge der Redexe von s gleichzeitig (parallel) reduziert.

Dieser Parallelitätsbegriff muss formal definiert werden, da es nicht ganz offensichtlich ist, wie er gemeint ist. Betrachte z.B.

Beispiel 5.3.1 (λx.x x)((λy . y)a). Es gibt zwei Redexe die man unabhängig

voneinander reduzieren kann. Z.B. ist dieser Term parallel reduzierbar zu: a a.

Aber: der Term (λx.x x)(λy . y) ist nur 1-reduzierbar zu (λy . y) (λy 0 . y 0 ), und

nicht zu (λy 0 . y 0 ). Diese Reduktionen sind sequentiell, denn der zweite Redex

entsteht erst durch die Reduktion.

Definition 5.3.2 Sei →1 die folgende Relation auf Ausdrücken:

12

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

• s →1 s

• Wenn s →1 s1 und t →1 t1 , dann (s t) →1 (s1 t1 ).

• Wenn s →1 s1 , dann (λ x . s) →1 (λ x . s1 ).

• Wenn si →1 s0i und t →1 t0 , dann

case t {(c x1,1 . . . x1,n1 ) → s1 ; . . . ; (c xm,1 . . . xm,nm ) → sm }

→1 case t0 {c x1,1 . . . x1,n1 → s01 ; . . . ; (c xm,1 . . . xm,nm ) → s0m }.

• Wenn s →1 s1 , t →1 t1 , dann (((λ x . s)) t) →1 s1 [t1 /x]

• Wenn si →1 s0i , t →1 t0 , dann

(case (c s1 . . . sn ){. . . ; (c x1 . . . xn ) → t; . . .}

→1 t0 [s01 /x1 , . . . , s0n /xn ].

• Wenn t →1 t0 , dann

(case (λx.s){. . . ; lambda → t; . . .}

→1 t0 .

Die 1-Relation kann aufgelöst werden in eine Folge von normalen Reduktionen:

∗

Lemma 5.3.3 Wenn s →1 t gilt, dann auch s −

→ t.

Beweis. Das kann man mit Induktion nach der Struktur des Terms s zeigen.

Als Beispiel zeigen wir wie das im Fall der Beta-Reduktion geht: Angenommen,

s = ((λx.s1 ) s2 ) und s1 →1 t1 , s2 →1 t2 und t = t1 [t2 /x]. Dann gilt mit

∗

∗

∗

∗

Induktion, dass s1 −

→ t1 , s2 −

→ t2 , also auch ((λx.s1 ) s2 ) −

→ ((λx.s1 ) t2 ) −

→

∗

((λx.t1 ) t2 ) → t1 [t2 /x], also insgesamt s −

→ t.

2

no

Lemma 5.3.4 Sei t ein (evtl. offener) Ausdruck. Wenn t −→ s und t →1 t0 ,

dann ist entweder s →1 t0 , oder es existiert ein Term s0 , so dass s →1 s0 , und

no

t0 −→ s0 .

1

t

1

no

s

/ t0

@

/ t0

no

no

1 _/ 0

_

_

s

s

t

1

Beweis. Dies zeigt man mit Induktion über die Struktur des Ausdrucks; Genauer

über die Tiefe des Normalordnungsredex: Dazu braucht man eine Fallunterscheidung:

• Sei t ≡ t1 t2 und t1 ist keine Abstraktion. Dann ändert die Normalordnungsreduktion den Ausdruck t2 nicht. Für den Ausdruck t1 ist die

no

Tiefe des Normalordnungsredex kleiner, also gilt mit t1 −→ s1 , auch:

no

t1 t2 −→ s1 t2 . Für t1 t2 →1 t01 t02 gilt t1 →1 t01 und t2 →1 t02 . Mit

Induktion gibt es jetzt zwei Fälle:

13

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

– s1 →1 t01 . Dann gilt auch s1 t2 →1 t01 t02 .

1

t1 t2

no

x

s1 t2

1

x

x

/ t01 t02

x;

no

– Es gibt ein s01 mit s1 →1 s01 und t01 −→ s01 .

no

Zusammengesetzt ergibt das: s1 t2 →1 s01 t02 und t01 t02 −→ s01 t02 .

/ t01 t02

no

no

1 _/ 0 0

_

_

s1 t2

s1 t2

t1 t2

1

• t ≡ t1 t2 und t1 ist eine Abstraktion λx . t3 . Dann ist die Normalordno

nungsreduktion gerade t1 t2 −→ t3 [t2 /x], wobei wir die Konvention über

disjunkte (gebundene) Variablennamen annehmen. Es gibt zwei Fälle für

die 1-Relation:

Wenn t1 t2 →1 t01 t02 , dann können wir auch schreiben (λx . t3 ) t2 →1

(λx . t03 ) t02 mit t3 →1 t03 , t2 →1 t02 . Damit gilt t3 [t2 /x] →1 t03 [t02 /x] und

no

(λx . t03 ) t02 −→ t03 [t02 /x].

Wenn (λx . t3 ) t2 →1 t03 [t02 /x], dann gilt t3 [t2 /x] →1 t03 [t02 /x], und wir

haben die Behauptung gezeigt.

• Wenn t ≡ case t1 {alt1 . . . altn }, und dieser Ausdruck ist kein Normalordnungsredex, dann kann man Induktion über die Struktur wie im ersten

Fall machen.

• Wenn t ≡ case t1 {alt1 ; . . . ; altn } und der Ausdruck ist ein

Normalordnungsredex,

dann

ist

die

Normalordnungsreduktion

no

case (c t1 . . . tn ) {. . . ; (c x1 . . . xn ) → tn+1 ; . . .} −→ tn+1 [t1 /x1 , . . . tn /xn ].

Die 1-Reduktion kann sein: case (c t1 . . . tn ) {. . . ; (c x1 . . . xn ) →

tn+1 ; . . .} →1 case (c t01 . . . t0n ) {. . . ; (c x1 . . . xn ) → t0n+1 ; . . .}. In diesem

Fall ist die Vertauschbarkeit analog zu den anderen Fällen.

Wenn die 1-Reduktion direkt den case-Ausdruck reduziert:

case (c t1 . . . tn ) {. . . ; (c x1 . . . xn ) → tn+1 ; . . .} →1 t0n+1 [t01 /x1 , . . . , t0n /xn ],

dann ist auch: tn+1 [t1 /x1 , . . . , tn /xn ], →1 t0n+1 [t01 /x1 , . . . , t0n /xn ].

Analog sind die Fälle, in denen der Ausdruck von der Form

(case (λx.t) {. . .}) ist.

2

14

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

no,k

Aussage 5.3.5 Sei t ein (evtl. offener) Ausdruck. Wenn t −−−→ t2 und t2 ist

no,k0

eine WHNF, und t →1 t0 . Dann gilt t0 −−−→ t02 , t2 →1 t02 , wobei k ≥ k 0 und t02

eine WHNF ist. Somit terminiert dann die no-Reduktion von t0 .

/ t0

0

no,k

no,k

1

t2 _ _ _/ t02

t

1

≤k

Beweis. Induktion nach k, der Anzahl der Normalordnungsreduktionen. Im Basisfall muss man nur noch beachten, dass aus t →1 t0 und t ist WHNF folgt,

dass t0 ebenfalls eine WHNF ist.

no,k−1

no

Im Falle k > 0 zerlegen wir die no-Reduktion in t −→ t1 −−−−−→ t2 . Nach

Lemma 5.3.4 gibt es zwei Fälle:

• t1 →1 t0 . Induktion zeigt die Existenz einer WHNF t02 mit t2 →1 t02 und

no,k0

t0 −−−→ t02 und k − 1 ≥ k 0 . Dann gilt auch k ≥ k 0 und die Behauptung des

Lemmas ist gezeigt.

no

• Es gibt ein t01 mit t0 −→ t01 und t1 →1 t01 . Induktion nach k zeigt dann die

no,k0 −1

Existenz einer WHNF t02 mit t01 −−−−−→ t02 und t2 →1 t02 und k−1 ≥ k 0 −1.

no,k0

Zusammensetzen der Diagramme ergibt t0 −−−→ t02 und t2 →1 t02 und

k ≥ k0 .

1

t

1

no

1

t2

t

no,k0

0

? t2

t1

no,k−1

/ 0

?t

1

/ t0

no

t1

1

no,k−1

t2

1

no

/ t01

no,k0 −1

/ t0

2

2

Da jede 1-Schritt-Reduktion auch als 1-Relation darstellbar ist, folgt unmittelbar:

Satz 5.3.6 Sei t ein (evtl. offener) Ausdruck. Wenn t⇓, und t → t0 mit einer

anderen Reduktion. Dann gilt auch t0 ⇓.

Jetzt fehlt noch die Richtung: (t → t0 ∧ t0 ⇓) ⇒ t⇓. Die Idee hier ist, eine

Reduktion zur WHNF, die aus Normalordnungsreduktionen und 1-Reduktionen

besteht, in eine Normalordnungsreduktion zu verwandeln.

15

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

Definition 5.3.7 Sei t ein (evtl. offener) Term. Die Reduktion t →1 s ist intern, d.h. ohne anteilige Normalordnungsreduktion, wenn sie nicht von einer der

Formen ist:

• R[((λx . t1 ) t2 )] →1 R0 [t01 [t02 /x]] wobei R ein Reduktionskontext ist, t1 →1

t01 , t2 →1 t02 , R →1 R0 , wobei man →1 für Kontexte wie für einen Term

mit einer extra Konstanten definiert.

• t = R[(case (c t1 . . . tn ) {. . . ; (c x1 . . . xn ) → tn+1 ; . . .})] →1

R0 [t0n+1 [t01 /x1 , . . . , t0n /xn ]] wobei R ein Reduktionskontext ist und ti →1

t0i , R →1 R0 .

• t = R[(case (λx.r) {. . . ; (lambda → t)}] →1 R0 [t0 ] wobei R ein Reduktionskontext ist und t →1 t0 , R →1 R0 .

2

Man kann die Anzahl der notwendigen Einzelreduktionen in der parallelen Reduktion r1 →1 r2 durch Markieren der Unterterme des Terms r1 mit dieser

Anzahl festhalten. Diese Anzahl entspricht der Anzahl Reduktionen, wenn man

diese “von oben“ her abarbeitet. Diese Anzahl kann man berechnen anhand der

syntaktischen Form von r1 und der Änderungen, die die 1-Reduktion bewirkt.

Sei ϕ diese Markierung, geschrieben als Abbildung von Untertermen auf die

Anzahl. Eigentlich ist das eine Abbildung der ganzen Reduktion.

• Wenn (s t) →1 s0 t0 , dann markiere (s t) mit ϕ(s) + ϕ(t)

• Wenn (λx . s) →1 (λx . s0 ), dann markiere (λx . s) mit ϕ(s).

• Wenn (case s {p1 → t1 ; . . . ; pn → tn }) →1 (case s0 {p1 → t01 ; . . . ; pn →

t0n }), dann markiere mit ϕ(s) + Σ ϕ(ti ).

• Wenn (λx . s) t →1 s0 [t0 /x], dann markiere mit 1 + ϕ(s) + ϕ(t) ∗ (#(x, s0 ))

wobei #(x, s) die Anzahl der freien Vorkommen von x in s ist.

• Wenn (case (c s1 . . . sn ) {. . . ; (c x1 . . . xn )

→

t; . . .})

→1

t[s1 /x1 , . . . , sn /xn ], dann markiere mit 1 + ϕ(t) + (Σ (ϕ(s0i ) ∗ (#(xi , t)))).

Lemma 5.3.8 Sei t ein (evtl. offener) Ausdruck. Wenn t →1 s, dann kann

no,∗

man die Reduktion zerlegen in: t −−−→ u →1 s, wobei die Reduktion u →1 s

intern ist.

no

Beweis. Dass man eine nicht-interne Reduktion t →1 s in t −→ u1 →1 s zerlegen

kann, folgt aus der Definition der Reduktion und aus der Definition von intern.

Dies kann man iterieren, bis die Reduktion u1 →1 s intern ist. Allerdings ist

nicht ganz offensichtlich, ob es terminiert. Dazu muss man die Anstrengung etwas erhöhen: Die Idee ist, dass die Anzahl ϕ der notwendigen Einzelreduktionen

vermindert wird: Es gibt zwei Fälle (Beta und Case):

16

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

no

• Wenn die erste Zerlegung so aussieht: R[(λx . s) t] −→ R[s[t/x]] →1

R0 [s0 [t0 /x]], dann ist die Zahl der Reduktionen (ϕ) in der Reduktion

R[s[t/x]] →1 R0 [s0 [t0 /x]] um mindestens 1 vermindert.

• Wenn die Zerlegung so aussieht: R[(case (c s1 . . . sn ) {. . . ; (c x1 . . . xn ) →

no

t; . . .})] −→ R[t[s1 /x1 , . . . , sn /xn ]] →1 R0 [t0 [s01 /x1 , . . . , s0n /xn ]], dann folgt

ebenfalls aus der obigen Definition, dass die Anzahl der Reduktionen mindestens um 1 vermindert ist. Die Verminderung kann größer sein, denn

eine case-Reduktion kann ganze Unterterme löschen.

Insgesamt heißt das, dass das Abspalten von no-Reduktionen terminiert.

2

no

Lemma 5.3.9 Sei t ein (evtl. offener) Ausdruck. Wenn t →1 u −→ s, dann

no,+

kann man die Reduktionen vertauschen: ∃u0 : t −−−→ u0 →1 s, so dass die

0

Reduktion u →1 s intern ist.

/u

t

no,+

no

1,int u0 _ _ _/ s

1

no,∗

no

Beweis. Die Reduktionsfolge t →1 u −→ s kann man zerlegen in: t −−−→ t0 →1

no

u −→ s, so dass t0 →1 u intern ist. Beachte, dass die 1-Relation auch trivial sein

no

kann. Es gibt nur die folgenden zwei Fälle für die Reduktion t0 →1 u −→ s:

no

1. Der erste Fall ist, dass R[(λx . t1 ) t2 ] →1 R0 [(λx . t01 ) t02 ] −→ R0 [t01 [t02 /x]],

wobei R Reduktionskontext, t1 →1 t01 , t2 →1 t02 , R →1 R0 , wobei man →1

für Kontexte wie für einen Term mit einer extra Konstanten definiert (eigentlich braucht man dafür Induktion nach der Termstruktur). In diesem

no

Fall gilt: R[(λx . t1 ) t2 ] −→ R[t1 [t2 /x]] →1 R0 [t01 [t02 /x]].

2. Der zweite Fall ist t = R[(case (c t1 . . . tn ) {. . . ; (c x1 . . . xn ) →

no

tn+1 ; . . .})] →1 R0 [(case (c t01 . . . t0n ) {. . . ; (c x1 . . . xn ) → t0n+1 ; . . .})] −→

0 0

0

0

0

R [tn+1 [t1 /x1 , . . . , tn /xn ]] wobei R Reduktionskontext, ti →1 ti , R →1 R0 .

no

In diesem Fall gilt wie im ersten t −→ R[tn+1 [t1 /x1 , . . . , tn /xn ]] →1

R0 [t0n+1 [t01 /x1 , . . . , t0n /xn ]].

no,∗

D.h. in diesem Fall ist die Reduktion vertauschbar, und wir erhalten: t −−−→

no

t1 −→ t2 →1 s. Wenn die letzte Reduktion nicht intern ist, dann kann man mit

Lemma 5.3.8 den Normalordnungsanteil abspalten.

2

no

Lemma 5.3.10 Sei s ein (evtl. offener) Ausdruck. Eine Folge s →1 s2 −→

no

. . . −→ sn wobei sn eine WHNF ist, kann man umändern in eine Reduktion, die

nur Normalordnungs-Reduktionen verwendet, um zu einer WHNF zu kommen.

no,∗

Genauer: in eine Reduktion s −−−→ s0n−1 →1 sn , bei der s0n−1 eine WHNF ist.

17

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

Beweis. Das Lemma 5.3.9 kann man zum Verschieben der 1-Reduktion nach

no

no

rechts verwenden. s →1 s2 −→ . . . −→ sn wird damit im ersten Schritt zu

no,∗

no

0

s −−−→ s2 →1 s3 . . . −→ sn . Schiebt man die 1-Reduktion weiter nach rechts, so

no,∗

no,∗

erhält man schließlich: s −−−→ s02 −−−→ s3 . . . s0n−1 →1 sn . Die letzte Reduktion

ist intern, also ist s0n−1 eine WHNF.

1 /

s2

s

no,∗

no

1

s02 _ _ _/ s3

no,∗ no

1

s03 _ _ _/ s4

no

.

2

∗

Satz 5.3.11 (Standardisierung). Sei t ein (evtl. offener) Ausdruck. Wenn t −

→

t1 mit beliebigen (Beta) und (case)-Reduktionen, wobei t1 eine WHNF ist, dann

no,∗

∗

existiert eine WHNF tN F , so dass t −−−→ tN F , und tN F −

→ t1 .

t>

∗

>

no,∗

>

>

∗

t1 _ _ _ _ _ _/ t2

Beweis. Jede Reduktion ist auch eine Folge von 1-Reduktionen. Danach kann

man Lemma 5.3.10 mehrfach anwenden.

2

Satz 5.3.12 (Invarianz der Terminierung) Seien t, t0 (evtl. offene) Ausdrücke

mit t → t0 . Dann gilt t⇓ ⇔ t0 ⇓

Beweis. Das folgt aus Satz 5.3.11 (Standardisierung) und Satz 5.3.6.

2

Der nächste Satz ist der erste Satz über Korrektheit von Programmtransformationen. Er sagt aus, dass man die Reduktionsregeln Beta und Case an beliebiger

Stelle (vorwärts und rückwärts) in einem Programm verwenden kann, um das

Programm (zur Compilezeit) zur verändern, bzw. zu optimieren, ohne dass man

einen Fehler macht. Dies nennt man auch partielle Auswertung.

Satz 5.3.13 Seien t, t0 Terme, so dass t → t0 mit einer KFP-Reduktion. Dann

gilt t ∼c t0 .

18

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

Beweis. Sei C irgendein Kontext. Dann gilt auch C[t] → C[t0 ], da Reduktionen

überall erlaubt sind. Wenn C[t]⇓, dann auch C[t0 ]⇓ nach Satz 5.3.12. Da das für

alle Kontexte gilt, schließen wir t ≤c t0 .

Wenn C[t0 ]⇓, dann auch C[t]⇓, ebenfalls wegen Satz 5.3.12. Deshalb gilt t0 ≤c t.

Zusammen ergibt sich t0 ∼c t.

2

Damit haben wir schon eine große Klasse von kontextuellen Gleichheiten im

Griff: alle die sich mittels Reduktion ineinander überführen lassen. Allerdings

sind das nicht alle interessanten Gleichungen, wie wir noch sehen werden.

Definition 5.3.14 Die durch Reduktion erzeugte Gleichheit (sogenannte Konversionsgleichheit) ist definiert als:

∗

s ←−

−→ t gdw. es eine Folge von Reduktionen (→ und ←) zwischen s und t gibt

Diese Relation sieht Terme, die sich nur um Umbenennung von gebundenen

Variablen unterscheiden, als gleich an.

∗

∗

Es gilt, dass ←−

−→ eine Kongruenz in KFP ist. Für ←−

−→ gilt das ChurchRosser-Theorem, das man auch mit det 1-Reduktion beweisen kann:

∗

Satz 5.3.15 (Church-Rosser) Wenn s ←−

−→ t, dann existieren s0 , t0 mit

∗

∗ 0

0

0

0

s ≡α t und s −

→ s und t −

→ t . Als Diagramm:

/t

s o

∗

∗

α

_

_

0 _

s _ _ _ t0

∗

∗

Satz 5.3.16 Für alle s, t gilt: s ←−

−→ t ⇒ s ∼c t

∗

In KFP ist die Umkehrung falsch: Es gibt Ausdrücke s, t mit s ∼c t, aber s ←

6 → t:

Beispiel 5.3.17 Wir geben Kombinatoren an:

Y

rp1

rp2

= \f-> (\x-> f (x x)) (\x->

= Y (\r1 y -> 1 : r1 a) a

= Y (\r2 y -> 1 : r2 b) b

f (x x))

Wenn man Superkombinatoren benutzen dürfte, wäre es einfacher:

rep1 y = 1 : rep1 a

rep2 y = 1 : rep2 b

Die Ausdrücke rp1 und rp2 sind KFP-Ausdrücke, denn die Rekursion ist direkt

kodiert.

∗

Mit Induktion kann man zeigen, dass alle Ausdrücke t1 mit t1 ←−

−→ rp1 ein a

∗

enthalten, aber kein b enthalten, während das für alle Ausdrücke t2 mit t2 ←−

−→

19

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

rp2 genau umgekehrt ist. Aus dem Satz von Church-Rosser kann man schließen,

∗

dass somit nicht gilt: rp1 ←−

−→ rp2.

Beide Ausdrücke erzeugen aber die unendliche Liste 1 : 1 : . . .. Wir werden

später sehen, dass diese Ausdrücke dann kontextuell äquivalent sein müssen.

Beispiel 5.3.18 Ein weiteres einfaches Beispiel ist:

s = \x .x

t = \x -> case x of {p1 -> x; ....; p_n -> x; lambda -> x}

Der Ausdruck t entspricht \x -> seq x x. Diese beiden Ausdrücke können als

∗

gleich gezeigt werden, aber sind nicht gleich bzgl der Konversion ←−

−→, da nach

obiger Überlegung dann s, t auf α-äquivalente Terme reduzieren müssten, diese

aber bereits in Normalform sind.

5.3.1

Exkurs: verallgemeinerte Induktion

Eine irreflexive partielle Ordnung < auf einer Menge M ist fundiert (wellfounded), gdw. jede absteigende Kette endlich ist.

Wenn man eine fundierte Ordnung < auf einer Menge M mit Menge der kleinsten Elemente Mmin hat, dann kann man folgendes Induktionsschema verwenden, um eine Aussage P (.) für alle Elemente der Menge M zu zeigen:

((∀m ∈ Mmin : P (m))

∧ (∀x : (∀y.y < x ⇒ P (y)) ⇒ P (x)))

⇒ ∀x.P (x)

Basis

Induktionsschluss

Es gibt Standardmethoden, um aus (linearen) fundierten Ordnungen weitere

(lineare) fundierte Ordnungen zu erzeugen.

Eine fundierte Ordnung, die wir verwenden wollen, ist die lexikographische Ordnung auf Tupeln, deren Komponenten eine fundierte Ordnung haben. Es gilt:

Wenn die Ordnung < auf M fundiert ist, dann auch die lexikographische Ordnung auf den Tupeln M n , wobei (a1 , . . . , an ) < (b1 , . . . , bn )

gdw. für einen Index i : a1 = b1 , . . . , ai−1 = bi−1 , ai < bi

Die Ordnung < auf den natürlichen Zahlen ist fundiert und linear. Also ist auch

die lexikographische Ordnung auf m-Tupeln über natürlichen Zahlen für festes

m eine lineare und fundierte Ordnung. Eine nicht-lineare fundierte Ordnung ist

die echte-Teilmengen“ -Beziehung auf der Menge der endlichen Teilmengen von

”

N.

5.4

Kontextuelle Gleichheit von Ausdrücken in

KFP

Wir betrachten und zeigen jetzt Eigenschaften der kontextuellen Approximation

und der kontextuellen Gleichheit. Nochmal zur Erinnerung die Definition:

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

20

Seien s, t KFP-Ausdrücke und C[.] ein Kontext.

s ≤c t gdw. ∀C[] : C[s]⇓ ⇒ C[t]⇓

s ∼c t gdw s ≤c t ∧ t ≤c s

Wir erinnern uns auch, dass ≤c eine Präkongruenz und ∼c eine Kongruenzrelation auf Ausdrücken ist.

Ein erstes Lemma ist:

Lemma 5.4.1

• Für verschiedene Variablen x, y gilt x 6≤c y und y 6≤c x

• Für verschiedene Konstanten c, d gilt c 6≤c d und d 6≤c c.

Beweis. Für die Variablen betrachte den Kontext C = (λy . (λx . [])) Ω Nil.

Dann reduziert C[x] zu Nil, während C[y] nicht terminiert.

Für die Konstanten betrachte die Kontexte C = case [.] c -> Ω; d ->

Nil; ... und C 0 =case [.] d -> Ω;c -> Nil; ....

2

Man kann auch fordern, dass die Kontexte die Terme s, t schließen:

Aussage 5.4.2 In KFP gilt: s ≤c t gdw. ∀C : wenn C[s], C[t] geschlossen, dann

C[s]⇓ ⇒ C[t]⇓.

Beweis. Die eine Richtung ist klar.

Es gelte ∀C : wenn C[s], C[t] geschlossen, dann C[s]⇓ ⇒ C[t]⇓. Sei C irgendein

Kontext, so dass C[s]⇓, aber nicht C[t]⇓. Dann erweitern wir den Kontext C

so dass alle freien Variablen in C[s], C[t] eingefangen werden, indem wir für die

freien Variablen x1 , . . . xn den Kontext D[] := (λx1 , . . . , xn .C[]) Ω . . . Ω nehmen.

Dann gilt weiterhin D[s]⇓, denn eine WHNF ist unbeeinflusst von den Einsetzungen in die freien Variablen. Es gilt auch noch D[t]⇑, denn entweder ist die

Normalordnungsreduktion nicht terminierend, oder ergibt einen Typfehler, was

nicht durch die Einsetzung beeinflusst ist, oder bei der Reduktion von C[t] gerät

eine freie Variable in einen Reduktionskontext. Diese ist aber durch Ω ersetzt,

somit gilt D[t]⇑, ein Widerspruch.

2

Wir können für Ausdrücke, die kontextuell gleich sind, mehr über die Struktur

der zugehörigen WHNF sagen.

Aussage 5.4.3 Seien s, t zwei Terme mit s ≤c t. Dann gilt einer der drei Fälle:

1. s⇑.

∗

∗

2. s −

→ (c s1 . . . sn ) und t −

→ (c t1 . . . tn ) für einen Konstruktor c und si ≤c ti

für alle i.

∗

∗

3. s −

→ λx.s0 und t −

→ λx.t0 und für alle r: ((λx.s0 ) r) ≤c ((λx.t0 ) r).

21

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

Beweis. Wir nehmen an, dass s⇓, so dass wir nur zeigen müssen, dass dann der

zweite oder dritte Fall eintritt.

Mit Kontexten der Form (case [] {alts}) ist sofort zu zeigen, dass aus s ≤c t

folgt, dass die WHNF für t den gleichen Topkonstruktor wie s haben muss, bzw.

sowohl s als auch t Abstraktionen sind.

∗

∗

Angenommen, s −

→ (c s1 . . . sn ). Dann gilt t −

→ (c t1 . . . tn ). Um für

ein i die Beziehung si ≤c t zu zeigen, nehme den Kontext Ci =

case [] {... ; (c x_1 ... x_i ... x_k) -> x_i; ... } . Da aus s ≤c

t auch C[s] ≤c C[t] folgt, und man auch reduzieren darf wegen Satz 5.3.16, folgt

sofort: si ≤c ti .

∗

∗

Angenommen, s −

→ λx.s0 . Dann gilt t −

→ λx.t0 . Um ((λx.s0 ) r) ≤c ((λx.t0 ) r) für

alle r zu zeigen, nehme den Kontext Cr := ([] r).

2

Aussage 5.4.4 Seien s, t zwei Terme mit s ∼c t.

Dann gilt einer der drei Fälle:

1. s⇑ und t⇑.

∗

∗

2. s −

→ (c s1 . . . sn ) und t −

→ (c t1 . . . tn ) für einen Konstruktor c und si ∼c ti

für alle i.

∗

∗

3. s −

→ λx.s0 und t −

→ λx.t0 und für alle r: ((λx.s0 ) r) ∼c ((λx.t0 ) r).

Definition 5.4.5 Ein Konstruktorterm ist ein Ausdruck, der nur aus Konstruktoren besteht.

Beachte, dass damit endliche Konstruktorterme“

”

drücke sind immer endlich.

gemeint sind, denn Aus-

Satz 5.4.6 Erhält man für einen Ausdruck mittels zweier verschiedener (auch

nicht-Normal-Ordnungs-) Reduktionen jeweils Konstruktorterme, so sind diese

gleich.

∗

∗

Formal: s −

→ s1 , s −

→ s2 wobei s1 , s2 Konstruktorterme sind, dann gilt s1 = s2 .

Beweis. Folgt aus der Aussage 5.4.4 mit Induktion über die Tiefe des Konstruktorausdrucks. Oder auch aus Theorem 5.3.16.

2

Jetzt können wir auch noch zeigen, dass man für Ausdrücke mit freien Variablen

eingeschränktere Kriterien für die kontextuelle Äquivalenz hat:

Lemma 5.4.7 Seien s, t KFP-Ausdrücke mit den freien Variablen x1 , . . . , xn

und sei ρ eine Umbenennung der Variablen xi . D.h. eine Injektion mit ρ(x) = yi .

Dann gilt s ≤c t gdw. sρ ≤c tρ.

Aussage 5.4.8 Seien s, t KFP-Ausdrücke mit den freien Variablen x1 , . . . , xn .

Dann gilt s ≤c t gdw. λx1 , . . . , xn .s ≤c λx1 , . . . , xn .t.

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

22

Beweis. Die eine Richtung ist klar.

Sei λx1 , . . . , xn s ≤c λx1 , . . . , xn t, und sei C ein Kontext, so dass C[s], C[t] geschlossen sind, und sei C[s]⇓.

Bilde den Kontext C 0 := C[(λx1 , . . . , xn .[])x1 . . . xn ). Dann reduziert C 0 [s] nach

einigen Beta-Reduktionsschritten zu C[s], also gilt C 0 [s]⇓ nach Satz 5.3.16. Da

C 0 [s] = C[(λx1 , . . . , xn .s)x1 . . . xn ], erhält man wegen der Voraussetzung auch

C[(λx1 , . . . , xn .t)x1 . . . xn ]⇓. Da dies zu C[t] reduziert, erhält man C[t]⇓, und

damit gilt die Behauptung.

2

5.4.1

Simulation und Bisimulation

Zum Erkennen der kontextuellen Gleichheit von zwei Ausdrücken ist es hilfreich, wenn man diese nicht in allen (unendlich) vielen Kontexten ausprobieren

muss, sondern wenn es ausreicht, die Terme selbst (d.h. im leeren Kontext) zu

reduzieren, und dies evtl. zu iterieren; d.h. die Komponenten des Ergebnisses zu

reduzieren oder falls es eine Funktion ist, diese auf ein Argument anzuwenden.

Dies leistet die sogenannte Simulation bzw. Bisimulation.

Definition 5.4.9 Wir definieren ≤b als den größten Fixpunkt des folgenden

Operators [.] auf Relationen R auf geschlossenen Termen.

Sei R eine Relation. Die Relation s [R] t für geschlossene Terme s, t gilt, wenn

folgendes erfüllt ist:

Wenn s⇓(c s1 . . . sn ), dann t⇓(c t1 . . . tn ) und si R ti für alle i.

und

wenn s⇓(λx.s0 ), dann t⇓(λx.t0 ) und für alle geschlossenen r:

((λx.s0 ) r) R ((λx.t0 ) r)

Man definiert s ∼b t, gdw s ≤b t und t ≤b s.

Die Relation ≤b nennt man auch Simulation und ∼b Bisimulation.

Die Relation s ∼b t gilt, wenn man s, t mittels WHNF-Reduktion und dann

entweder durch Anwenden auf gleiche Argumente, oder Betrachten von Untertermen nicht unterscheiden kann. Diese Betrachtungsweise wird durch die

Definition mittels größtem Fixpunkt erreicht.

Einschub Knaster-Tarski Fixpunktsatz

Ein vollständiger Verband A ist ein Verband, d.h. eine Menge mit einer partiellen

Ordnung ≤, so dass glb und lub von zwei Elementen existieren. Vollständig

bedeutet, dass man zu jeder Teilmenge S ⊆ A den glb und lub bilden kann.

Ein wichtiges Beispiel zu vollständigen Verbänden ist der VerbandSder Teilmengen einer

T Menge M geordnet mit ⊆. Hier kann man lub(S) = (S) und

glb(S) := S definieren.

Wir nennen a ist ein Fixpunkt einer Funktion f , gdw. f (a) = a;

a ist ein Post-Fixpunkt einer Funktion f , gdw. a ≤ f (a).

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

23

Entsprechend ist a ist ein Pre-Fixpunkt einer Funktion f , gdw. f (a) ≤ a.

Der Fixpunktsatz von Knaster-Tarski:

Sei A ein vollständiger Verband und f eine monotone Funktion. Dann existiert

ein Fixpunkt von f .

Der größte Fixpunkt von f ist lub{x ∈ A | x ≤ f (x)}.

Der kleinste Fixpunkt von f ist glb{x ∈ A | f (x) ≤ x}.

Da man die Relationen auf den Ausdrücken als Mengen von Paaren ansehen

kann, hat man einen vollständigen Verband von Relationen, und man kann

den Fixpunktsatz von Knaster-Tarski verwenden. Wir formulieren den Satz auf

Mengen mit Vereinigung und Untermenge:

Satz 5.4.10 Sei (L, ⊆) ein (vollständiger) Mengen-Verband und sei f : L → L

eine monotone Funktion. Dann ist

[

m = νf = {R ∈ L | R ⊆ f (R)}

ein größter Fixpunkt, und auch ein größter Post-Fixpunkt.

\

k = µf = {R ∈ L | f (R) ⊆ R}

ein kleinster Fixpunkt, und auch ein kleinster Pre-Fixpunkt.

Die Funktion [·] ist monoton auf Relationen, denn bei einer kleineren Relation

R stehen auch weniger Paare von Ausdrücken in der [R]-Relation. Deshalb kann

man den Satz von Knaster-Tarski auf Relationen und die Funktion [·] anwenden.

(Satz von Kleene)

Wenn die Funktion f für die man den Fixpunkt bilden will, die Eigenschaft der

(glb)-Stetigkeit hat:

D.h. für alle absteigenden Folgen s1 ≥c s2 ≥c . . ., die einen glb s haben, gilt:

glb(f (si )) = f (glb(si )).

Dann kann man den größten Fixpunkt von f auch definieren über eine Folge

von Relationen ≤b,i mit folgender Eigenschaft:

Entsprechendes gilt für lub-stetige Funktionen und den kleinsten Fixpunkt.

Man braucht noch die offene Erweiterung ≤ob : von ≤b :

s ≤ob t gdw. für alle Einsetzungen σ von geschlossenen Termen: σ(s) ≤b σ(t)

gilt. Entsprechend ist ∼ob definiert.

Es gilt folgende Aussage zum Zusammenhang zwischen ≤b und ≤c :

Satz 5.4.11 (siehe Howe-1989, 1996). Es gelten die Aussagen:

≤ob = ≤c

∼ob = ∼c

24

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

Es folgt sofort, dass Ω ≤c t ist für alle t, denn für alle geschlossenen t: Ω ≤b t

ist offensichtlich. Es folgt auch, dass für zwei geschlossene Ausdrücke s, t mit

s⇑, t⇑ die Beziehung s ∼c t ∼c Ω folgt. Für offene t folgt es dann auch aus der

Definition von ≤ob .

Leider können wir das Theorem 5.4.11 nicht im Rahmen des Skriptes zeigen,

da man dafür spezifische Methoden verwenden muss. Was man allerdings mit

unseren Mitteln zeigen kann, ist eine Richtung:

Aussage 5.4.12 Es gilt ≤c

⊆

≤ob

Beweis. Es genügt zu zeigen, dass ≤c,0 (≤c,0 ist ≤c eingeschränkt auf geschlossene Terme) ein Post-Fixpunkt des Operators [.] ist, d.h. dass ≤c,0 ⊆ [≤c,0 ],

denn nach dem Satz von Knaster-Tarski ist ≤b ein größter Post-Fixpunkt von

[·]. Das ist aber gerade der Inhalt von Aussage 5.4.3, denn aus s ≤c,0 t folgt

einer der drei Fälle in 5.4.3, und daraus folgt, dass s [≤c,0 ] t. Für offene Terme

folgt es dann aus der offenen Erweiterung.

2

Der Unterscheidung offen / geschlossen bietet auch keine Überraschungen:

Aussage 5.4.13 Seien s, t KFP-Ausdrücke mit den freien Variablen

x1 , . . . , xn . Dann gilt s ≤c t gdw. für alle Einsetzungen σ von geschlossenen Termen für freie Variablen σ(s) ≤c σ(t).

Beweis. Die eine Richtung folgt leicht aus der Aussage 5.4.8 oben.

Die andere Richtung folgt aus dem Satz von Howe: ≤c,0

⊆

≤ob und da

≤b = ≤c,0 ist, wobei ≤c,0 die Einschränkung von ≤c auf geschlossene Terme

ist.

2

Durch die Definition von ≤b als größter Fixpunkt (und größter Postfix-Punkt)

und durch die Gleichheit von ≤b und ≤c gilt folgendes Induktionsprinzip (CoInduktion).

Lemma 5.4.14 Wenn für eine Relation R gilt: R

R ⊆ ≤b = ≤c .

⊆

[R], dann gilt

Das einfache Prinzip des Kleene-Satzes kann man leicht durch die abstraktere

Methode der Co-Induktion ersetzen, um konkrete Gleichheiten zu zeigen:

Lemma 5.4.15 Gegeben zwei Terme s, t. Sei R1 so definiert, dass s0 R1 t0 gdw.

(s0 , t0 ) Grundterme sind, die eine gemeinsame Einsetzung von Termen für die

Variablen in (s, t) ist. Wenn

R1 ⊆ [R1 ∪ ≤b ], dann gilt R1 ⊆ ≤b , und somit s ≤b t, also auch s ≤c t,

Beweis. Aus R1 ⊆ [R1 ∪ ≤b ] folgt (R1 ∪ ≤b ) ⊆ [R1 ∪ ≤b ],. Denn ≤b ⊆ [R1 ∪ ≤b ]

gilt, da ≤b ⊆ R1 ∪ ≤b , wegen der Monotonie des Operators [·] un da ≤b ein

Fixpunkt des Operators [·] ist, auch ≤b = [≤b ] ⊆ R1 ∪ ≤b . Damit gilt die

Behauptung, da ≤c und ≤b übereinstimmen, und da ≤b der größte Fixpunkt

25

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

von [·] ist, und somit R1 ∪ ≤b ⊆ ≤b , also R1 ⊆ ≤b

s ≤c t folgt aus der Aussage 5.4.13.

= ≤c . Die Relation

2

Aus dem bisherigen folgt auch:

Lemma 5.4.16 Gegeben zwei Terme s, t. Sei R1 so definiert, dass s0 R1 t0 gdw.

(s0 , t0 ) Grundterme sind, die eine gemeinsame Einsetzung von Termen für die

Variablen in (s, t) ist. Wenn

R1 ⊆ [R1 ∪ ∼b ], dann gilt R1 ⊆ ∼b , also auch R1 ⊆ ∼c und s ∼c t.

Diese Aussagen helfen, die Gleichheit von Ausdrücken zu prüfen:

Beispiel 5.4.17 s = λx, y.if x then (Cons x y) else (Cons True y)

t = λx, y.if x then (Cons True y) else (Cons True y)

Diese Terme haben keine freien Variablen. Die Relation R1 besteht genau aus

(s, t). Man muss also nur zeigen, dass (s, t) ∈ [{(s, t)}∪ ∼b ]. Dazu muss man

s [{(s, t)}∪ ∼b ] t testen. Das gilt, wenn man (nach zwei Schritten) für alle

(geschlossenen) Ausdrücke r1 , r2 : die Gleichheit von s r1 r2 und t r1 r2 testet,

d.h. {(s, t)}∪ ∼b

Für r1 = True bzw. r1 = False ergibt sich der gleiche Term. Aber für r1 = bot

ergibt sich ebenfalls das gleiche: s bot r2 = bot und t bot r2 = bot.

Beachte aber, dass die Terme s, t nicht kontextuell äquivalent zu

λx, y.(Cons True y) sind.

Beispiel 5.4.18 Im folgenden Beispiel gehen wir davon aus, dass repeat und

map in KFP geeignet definiert sind.

Wenn s = (repeat 1) und t = map (λx.1) (repeat 2), gilt dann s ∼c t?

Hierzu kann man s und t reduzieren und erhält jeweils eine WHNF:

1 : (repeat 1) und 1 : map (λx.1) (repeat 2). Die rekursive Frage ist dann wieder die gleiche, nämlich ob s ∼c t. Hier kann man das Lemma 5.4.16 anwenden.

Damit folgt s ∼c t.

Wir zeigen, dass in KFP die einfache Induktion ausreicht, statt der CoInduktion. Dazu definieren wir:

≤b,0

≤b,i+1

≤b,ω

:= E × E

d.h. gilt immer

:= [≤

]

in Tiefe i + 1 abschneiden

b,i

T

:=

(≤

)

b.i

i≥0

Einige Fakten sind: ≤b,i bildet eine absteigende Kette bzgl ⊆, und ≤b ⊆ ≤b,i .

Wir weisen nach, dass ≤b ⊆ ≤b,i und dass ≤b,ω ein Fixpunkt des Operators [·]

ist, und damit auch größter Fixpunkt. Genauer, wir zeigen, dass ≤b,ω ⊆ [≤b,ω ].

Seien s, t Grundterme, so dass s ≤b,ω t gilt. Wenn s⇑, dann gilt die Behauptung

offenbar. Wenn s⇓(c s1 . . . sn ), dann gilt s⇓(c t1 . . . tn ), und für jedes i gilt

auch si ≤b,i ti , also wegen der determininistischen Reduktion in KFP auch

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

26

si ≤b,ω ti , damit gilt auch s[≤b,ω ]t.

Wenn s⇓(λx.s0 ), dann t⇓(λx.t0 ) und für alle r und alle i:

((λx.s0 ) r) ≤b,i

((λx.t0 ) r). Damit gilt wegen der determininistischen

Reduktion in KFP auch ((λx.s0 ) r) ≤b,ω ((λx.t0 ) r). Damit haben wir mit

Co-Induktion nachgewiesen, dass ≤b,ω =≤b .

5.4.2

Das Kontextlemma

Ein wichtiges Lemma zur kontextuellen Approximation ist die Einschränkung

des Kriteriums “für alle Kontexte“ auf Reduktionskontexte. Das kann in anderen Kalkülen (i.a. call-by-need-Kalküle) als gleichwertiger oder überlegener Weg

zu den Aussagen wie Korrektheit von Programmtransformationen und Standardisierungslemma verwendet werden. Wir erwähnen das Kontextlemma wegen

seiner herausragenden Rolle in anderen Reduktionskalkülen; es lässt sich auch

in KFP unabhängig nachweisen, allerdings scheint es nicht der richtige Weg

zu sein, die Korrektheit der KFP-Kalkülregeln als Programmtransformationen

nachzuweisen. Mögliche Gründe sind: KFP-Reduktionskontexte können offene

Terme nicht abschließen, was in anderen Kalkülen (mit let) möglich ist; In KFP

wird call-by-name verwendet (d.h. die Beta-Reduktion setzt beliebige Ausdrücke

ein). In call-by-need Kalkülen

Für das Kontextlemma benötigen wir den technischen Begriff des Multikontexts.

Das ist eine Verallgemeinerung des Begriffs Kontext auf mehrere Löcher. Dazu

kann man z.B. neue Konstanten nehmen, bezeichnet als ·1 , . . . , ·n und Terme

bauen, die diese Konstanten enthalten. Wir nehmen zusätzlich an, dass diese

Konstanten genau einmal vorkommen, wenn sie erwähnt sind, d.h. C[·1 , . . . , ·n ]

ist ein Ausdruck, der jede Konstante ·i genau einmal enthält.

Lemma 5.4.19 (Kontext-Lemma)

Seien s, t geschlossene Ausdrücke.

Wenn für alle (geschlossenen) Reduktionskontexte R: R[s]⇓ ⇒ R[t]⇓ gilt, dann

gilt auch s ≤c t.

Beweis. Der hier gegebene Beweis ist unabhängig von den Beweisen mittels

der 1-Relation, und auch unabhängig von den Bsimulationssätzen. Beachte im

folgenden, dass R[s], R[t] geschlossene Terme sind.

Wir beweisen die allgemeinere Behauptung:

Wenn für die geschlossenen Terme si , ti : ∀i, R : R[si ]⇓ ⇒

R[ti ]⇓ erfüllen, dann gilt für alle Multikontexte C[·1 , . . . , ·m ]:

Wenn C[s1 , . . . , sn ], C[t1 , . . . , tn ] geschlossen sind, dann gilt

C[s1 , . . . , sn ]⇓ ⇒ C[t1 , . . . , tn ]⇓.

Wie nehmen an, dies sei falsch, Dann gibt es ein Gegenbeispiel, d.h. geschlossene Terme si , ti mit ∀i, R : R[si ]⇓ ⇒ R[ti ]⇓, aber es gibt einen Multikontext

C[·1 , . . . , ·n ], so dass C[s1 , . . . , sn ]⇓, aber C[t1 , . . . , tn ]⇑. Wir wählen den Multikontext so, dass er minimal ist bzgl. der lexikographischen Ordnung mit den

Komponenten

1. Die Anzahl der Normalordnungsreduktionen von C[s1 , . . . , sn ],

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

27

2. Die Anzahl der Löcher von C.

Wenn ein Loch von C[·1 , . . . , ·n ] in einem Reduktionskontext ist, d.h., einer der

Kontexte C[·, t2 , . . . , tn ], C[t1 , ·, t3 , . . . , tn ], . . . , C[t1 , . . . , tn−1 , ·] ist ein Reduktionskontext, dann nehmen wir der Einfachheit halber an, das erste Loch sei

in einem Reduktionskontext. Dann ist C[·, t2 , . . . , tn ] ein Reduktionskontext.

Sei C 0 := C[s1 , ·2 , . . . , ·n ]. Da C 0 [s2 , . . . , sn ] ≡ C[s1 , . . . , sn ], haben beide dieselbe Normalordnungsreduktion. Die Anzahl der Löcher von C 0 ist kleiner als

die von C, also gilt C 0 [t2 , . . . , tn ]⇓. Das bedeutet, dass C[s1 , t2 , . . . , tn ]⇓. Da

C[·, t2 , . . . , tn ] ein Reduktionskontext ist, folgt aus den Bedingungen des Lemmas : C[t1 , t2 , . . . , tn ]⇓, was ein Widerspruch ist.

Wenn keiner der Kontexte C[·, t2 , . . . , tn ], C[t1 , ·, t3 , . . . , tn ], . . . ,

C[t1 , . . . , tn−1 , ·] ein Reduktionskontext ist, dann ist entweder C[s1 , . . . , sn ]

eine WHNF, oder die zwei Terme C[s1 , . . . , sn ] und C[t1 , . . . , tn ] werden mit

derselben Normalordnungsreduktion reduziert. Das liegt daran, dass das Finden

des Normalordnungsredex von oben nach unten geschieht und in diesem Falle

unabhängig von den Ausdrücken in den Löchern ist.

Falls C[s1 , . . . , sn ] eine WHNF ist, dann terminiert die Suche nach einem Normalordnungsredex innerhalb des Kontexts C, somit ist auch C[t1 , . . . , tn ] eine

WHNF.

Wir betrachten den Fall dass C[s1 , . . . , sn ] keine WHNF ist, aber C[s1 , . . . , sn ]⇓.

Die Normalordnungsreduktion produziert aus C[s1 , . . . , sn ] einen Ausdruck

C 0 [u1 , . . . , um ] wobei ui = sφ(i) für eine Abbildung φ : [1..m] → [1..n].

Es ist möglich dass m > n. Die Anzahl der Normalordnungsschritte von

C 0 [u1 , . . . , um ] ist um 1 kleiner als die von C[s1 , . . . , sn ]. Jetzt zeigt die Annahme der Minimalität, dass dann auch C 0 [v1 , . . . , vm ]⇓ mit vi = tφ(i) . Da der

Ausdruck C[t1 , t2 , . . . , tn ] in Normalordnung auf C 0 [v1 , . . . , vm ] reduziert, gilt

auch C[t1 , t2 , . . . , tn ]⇓.

2

Beispiel 5.4.20 Dieses Beispiel zeigt, dass der Beweis des Kontextlemma zu

KFP nicht auf offene Terme verallgemeinerbar ist: Nehme den Multikontext

C = (λx.·1 )·2 . Dann reduziert C[[x], 1] zu [1], aber weder ist eines der Löcher

in einem Reduktionskontext, noch kann man alle eingesetzten Ausdrücke unverändert im Redukt wiederfinden, z.B. ist [x] zu [1] geworden. D.h. der Beweisschritt, der Normalordnungsreduktion anwendet, und dann das Resultat als

neuen Multikontext mit eingesetzten Termen beschreibt, ist in diesem Fall nicht

mehr zu begründen.

Leider gibt das Kontext-Lemma keine Information über die kontextuelle Äquivalenz von offenen Ausdrücken. In Zusammenarbeit mit folgender Aussage kann

man das Kontextlemma auch in allgemeineren Zusammenhängen verwenden.

Wir beweisen diese Aussage, die oben aus dem Howe-Satz folgt, nochmal direkt.

Aussage 5.4.21 Seien s, t Ausdrücke mit den freien Variablen x1 , . . . , xn .

Dann:

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

s ≤c t gdw. für alle geschlossenen ti gilt: s[t1 /x1 , . . . , tn /xn ]

t[t1 /x1 , . . . , tn /xn ]

28

≤c

Beweis. Die nichttriviale Richtung der Implikation ist: Wenn für alle geschlossenen ti gilt: s[t1 /x1 , . . . , tn /xn ] ≤c t[t1 /x1 , . . . , tn /xn ], dann gilt s ≤c t.

Induktion nach der Anzahl der freien Variablen in s, t.

Es genügt, für s0 := λx1 , . . . xn .s und t0 := λx1 , . . . xn .t zu zeigen, dass s0 ≤c t0 .

Jetzt kann man das Kontextlemma anwenden.

Sei R ein Reduktionskontext. Dann ist das Loch entweder in einem case.

Dann sind die Reduktionen von R[s0 ], R[t0 ] beide mit Typfehler, oder das Loch

wird angewendet, d.h. R[] = R0 ([] r), wobei r geschlossen ist. Dann gilt wegen der Induktionsannahme λx2 , . . . , xn .s[r/x1 ] ≤c λx2 , . . . , xn .t[r/x1 ]. D.h.

R[s0 ] ∼c R0 ([s0 ] r) ∼c R0 (λx2 , . . . , xn .s[r/x1 ]). Somit gilt: R[s0 ]⇓ ⇒ R[t0 ]⇓. Das

Kontextlemma zeigt jetzt s0 ≤c t0 , und somit auch s ≤c t.

2

5.4.3

Programmtransformationen

Programmtransformationen sind zunächst mal alle Veränderungen eines Programms P resultierend in einem Programm P 0 . Natürlich soll diese Transformation nicht das Programm verfälschen, z.B. aus einem Programm, das Zahlen

testet, ob sie gerade sind, ein Programm machen, das Zahlen testet, ob sie ungerade sind. Dies wird durch den Begriff der kontextuellen Gleichheit erfasst.

Definition 5.4.22 Eine Programmtransformation ist eine Relation T auf Ausdrücken. Man sagt zu e1 T e2 , dass T den Ausdruck e1 zu einem Ausdruck e2

transformiert.

Die Programmtransformation T ist korrekt, wenn aus e1 T e2 stets e1 ∼c e2

folgt.

Die Programmtransformation T ist modular, wenn für jeden Kontext C aus

e1 T e2 auch C[e1 ] T C[e2 ] folgt.

Modularität einer Programmtransformation bedeutet, dass man sie auf Unterterme anwenden kann ohne den Rest des Programms zu kennen.

Beachte, dass die Korrektheit von Programmtransformationen zunächst nur bedeutet, das diese während des Kompilierens verwendet werden dürfen. Während

des Programmlaufs, d.h. in eine Normalordnungsreduktion eingeschoben darf eine Transformation nur verwendet werden, wenn man darauf achtet, dass sich

die Terminierungseigenschaften dadurch nicht ändern. Eine veränderte Normalordnung könnte auch eine gewünschte Verbesserung der Auswertung sein, aber

dazu sind andere Betrachtungen notwendig: Man muss dazu verschiedene Reduktionsstrategien vergleichen, was wir an anderer Stelle machen werden.

Beispiel 5.4.23 Ein triviales Beispiel für eine veränderte Normalordnungsreduktion, die aus korrekten Programmtransformation während der Normalordnungsreduktion besteht, aber ein falsches Terminierungsverhalten hat, ist:

Mache einen Normalordnungsreduktionsschritt, und dann mache diesen wieder

29

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

rückgängig. Diese “Reduktion“ ändert die Terme nicht, kann also i.a. nicht terminieren.

Korollar 5.4.24 Aus dem Satz 5.3.16 oben folgt, dass die Beta- und die CaseReduktion an beliebigen Stellen eines Programms während des Kompilierens als

Programmtransformationen verwendet werden dürfen. Das gilt auch für die umgekehrten Regeln. D.h. Beta-Expansion und Case-Expansion.

Die meisten KFP-Programmtransformationen sind eine Kombination von

Kalkülregeln. Es gibt auch solche, die keine Kombination von Kalkülregeln sind.

(z.B. Assoziativität von append (++))

Die sogenannte Lambda-Lifting-Transformation ist im ungetypten LambdaKalkül, d.h. ohne case und Konstruktoren, eine bekannte Methode, um Superkombinatorprogramme herzustellen.

Definition 5.4.25 Sei λx.e ein Ausdruck, so dass e eine freie Variable y

enthält. Dann ist die Lambda-Lifting Transformation:

ll

λx.e −

→ (λz.λx.e[z/y]) y, wobei z eine neue Variable ist.

Aussage 5.4.26 Lambda-Lifting ist in KFP eine korrekte Programmtransformation.

Beweis. Das folgt daraus, dass sich (λz.λx.e[z/y]) y mittels Beta-Reduktion

wieder zu λx.(e[z/y])[y/z] = λx.e reduzieren läßt, und dass Beta eine korrekte

Programmtransformation ist.

2

Die sogenannte η-Transformation ist ebenfalls im ungetypten Lambda-kalkül

bekannt. Man kann diese zum Lambda-Kalkül hinzunehmen oder nicht, was

natürlich verschiedene Reduktions-Gleichheiten ergibt.

Definition 5.4.27 Sei e ein Ausdruck, der die Variable x nicht frei enthält.

Dann ist die η-Transformation definiert als:

η

λx.(e x) −

→ e

Lemma 5.4.28 Die η-Transformation ist i.a. nicht korrekt in KFP.

Beweis Dazu genügt es einen Ausdruck anzugeben, für den das falsch ist.

Der Ausdruck (λx.bot x) hat im leeren Kontext eine WHNF, aber es gilt

η

λx.bot x −

→ bot, und bot hat keine WHNF.

2

Die folgende Variante der η-Reduktion ist korrekt:

Definition 5.4.29 Sei e ein Ausdruck, der die Variable x nicht frei enthält,

und der eine WHNF hat, die eine Abstraktion ist (bzw. von Typ“a → b ist).

”

Dann ist die η 0 -Transformation definiert als:

η0

λx.(e x) −→ e

30

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

Aussage 5.4.30 Die η 0 -Transformation ist korrekt.

Beweis. Hierzu genügt es, den Satz zur Bisimulation zur verwenden: Da beide

eine WHNF haben, genügt es, beide Ausdrücke auf allen geschlossenen Argumenten r zu testen: ((λx.(e x)) r) reduziert zu (e r).

2

Man kann diese Transformation noch etwas allgemeiner fassen: Die ηTransformation ist korrekt, wenn man sie im richtigen Kontext verwendet:

η 00

((λx.(e x)) t) −−→ (e t) . Diese Transformation ist ebenfalls mittels des

Bisimulationssatzes leicht als korrekt zu erkennen.

5.4.4

Kleinste und Größte Elemente bzgl. ≤c

Wir betrachten kleinste und größte Elemente bzgl. ≤c , wobei wir das modulo

∼c meinen. Was wir im folgenden zeigen können, ist die kontextuelle Äquivalenz

aller nichtterminierenden Ausdrücke und aller ungetypten Ausdrücke, insbesondere ⊥.

Offene Ausdrücke, die ungetypt sind, oder die eine nichtterminierende Normalordnungsreduktion haben, behalten diese Eigenschaft auch nach Einsetzung von

Termen für die freien Variablen:

n

1. Sei t −

→ t0 , so dass t0 direkt ungetypt ist. (wir haben das dynamisch

ungetypt genannt). Dann ist für jede Einsetzung ρ auch der Ausdruck t ρ

dynamisch ungetypt.

Das liegt daran, dass die Normalordnungsreduktion freie Variablen nicht

unmittelbar anfasst, sondern nur mitschleppt.

∞,n

∞,n

2. Sei t −−−→. Dann gilt für jede Einsetzung ρ auch t ρ −−−→. Auch hier ist

die Normalordnungsreduktion die gleiche.

Wir zeigen mit den Mitteln des Skriptes (nicht über den Bisimulationssatz),

dass ⊥ das kleinste Element ist (modulo ∼c ):

Lemma 5.4.31 Sei s ein geschlossener Ausdruck mit s⇑ und t ein weiterer

geschlossener Ausdruck. Dann gilt s ≤c t.

Beweis. Sei R ein Reduktionskontext. Jede Normalordnungsreduktion von R[s]

muss zuerst s in WHNF reduzieren, was nach Voraussetzung nicht geht. Damit

gilt R[s]⇓ ⇒ R[t]⇓ und somit folgt aus dem Kontextlemma, dass s ≤c t

2

Vorsicht bei offenen Termen! z.B. gilt x⇑, aber x 6∼c ⊥.

Lemma 5.4.32 Sei s ein (evtl. offener) Ausdruck, so dass für alle Einsetzungen ρ: (s ρ)⇑, und sei t ein weiterer Ausdruck. Dann gilt s ≤c t.

Beweis. Das Lemma oben zeigt, dass für alle Einsetzungen ρ, die alle freien

Variablen von s, t mit geschlossenen Ausdrücken ersetzen, dass sρ⇑, und damit

sρ ≤c tρ. Lemma 5.4.21 zeigt dann auch s ≤c t.

2

31

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

Damit gibt es ein kleinstes Element in der ≤c -Ordnung in der Menge der geschlossenen Ausdrücke (modulo ∼c ), nämlich bot, auch als ⊥ geschrieben.

Aussage 5.4.33 Seien s, t zwei (evtl. offene) Ausdrücke, die entweder eine

nicht terminierende Normalordnungsreduktion haben oder direkt nicht wohlgetypt sind. Dann gilt s ∼c t.

Beweis. Folgt aus obigem Lemma, da wegen s⇑ und t⇑ sowohl s ≤c t als auch

t ≤c s gilt.

2

Beachte, dass es auch offene Terme gibt, die eine unendliche Normalordnungsreduktion haben: Z.B. bot x. Für diese gilt ebenfalls bot x ∼c bot.

Aussage 5.4.34 Wenn es mindestens einen Konstruktor mit Stelligkeit ≥ 1

gibt, dann gibt es kein größtes Element in der ≤c -Ordnung

Beweis. Sei c ein Konstruktor der Stelligkeit n: Ein größtes Element s muss eine

WHNF haben. Dafür gibt es zwei Möglichkeiten:

• s = λx . s0 . In dem Fall ist c ⊥

. . ⊥} 6≤c s: Nehme den Kontext

| .{z

n

case [] {(c x1 . . . xn ) → c; lambda → ⊥; . . .}.

• s = d s1 . . . sm wobei d ein Konstruktor der Stelligkeit m ist. In dem Fall

ist λx.x 6≤c s: Nehme den Kontext case [] {(d x1 . . . xn ) → bot; lambda →

(d ⊥ . . . ⊥); . . .}.

2

Diese Aussage zeigt, dass eine Einbettung (d.h. eine Implementierung, die die

kontextuelle Ordnung erhält) von KFP in den einfachen ungetypten LambdaKalkül nicht 1-1 sein kann, denn der Lambda-Kalkül ohne Konstruktoren mit

der kontextuellen Ordnung wie in “The lazy Lambda-Calculus“ von Abramsky

beschrieben, hat ein eindeutiges größtes Element (modulo der kontextuellen

Ordnung): (Y K)1 , das ist ein Lambda-Ausdruck, der beliebig viele Argumente

schluckt, ohne sich bzgl. ∼c zu verändern: (Y K) t ∼c (Y K), wobei ∼c hier die

kontextuelle Ordnung im lazy Lambda-Kalkül ist. Der Ausdruck Y K entspricht

dem Superkombinator f x = f .

5.4.5

Auswertungsreihenfolgen

Aus dem Satz über die Korrektheit der Anwendbarkeit von Reduktionen an

beliebigen Stellen in einem Ausdruck folgt, dass man Ausdrücke in einem Programm in beliebiger Reihenfolge auswerten darf, solange man die Reduktionsregeln verwendet. Allerdings gilt das nur, wenn die Auswertungen auch terminieren für Ausdrücke mit WHNF.

1 Y ist der Fixpunktkombinator wie in Abschnitt 5.6.2 beschrieben und K ist definiert als

K xy=x

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

32

Definition 5.4.35 Eine Auswertungsstrategie S ist eine Relation t →S t0 auf

Termen, wobei zumindest t →S t0 ⇒ t ∼c t0 gelten soll. Diese Relation muss

effektiv sein, d.h es muss einen Algorithmus geben, der bei Eingabe des Terms

t das Redukt t0 berechnet und ausgibt, oder sagt: keine Reduktion möglich, oder:

ist eine S-Normalform. Die transitive, reflexive Hülle der Reduktion bezeichnen

∗

∗

wir mit −

→S . Falls t −

→S t0 , wobei t0 eine S-Normalform, dann schreiben wir

t⇓S . Wir nehmen an, dass S-Normalformen auch WHNFs sind.

• Seien S1 , S2 zwei Strategien. Die Strategie S1 ist strikter als S2 , gdw. für

alle Terme t: t⇓S1 ⇒ t⇓S2 ,

• Eine Strategie S ist korrekt, gdw. für alle Terme t: t⇓S ⇒ t⇓. D.h., wenn

sie strikter als die Normalordnungsreduktion ist.

Aus unseren Sätzen folgt sofort, dass alle Strategien korrekt sind.

Folgende Normalform für strikte Auswertung entspricht der Auswertung der

Argumente einer Anwendung vor dem Einsetzen der Argument.

Definition 5.4.36 Eine strikte Normalform ist definiert als:

• Eine Abstraktion ist eine strikte Normalform.

• Wenn s1 , . . . , sn strikte Normalformen sind, dann auch c s1 . . . sn für

einen Konstruktor c mit ar(c) ≥ n.

Beachte, dass in dieser Definition der kleinste Fixpunkt gebildet wird.

Zwei Strategien bzw. Methoden der Reduktion haben eigene Namen:

Normalordnung (normale Reihenfolge, normal-order, nicht-strikte Auswertung), die wir bereits kennen.

Anwendungsordnung (applikative Reihenfolge, applikative Ordnung, strikte Auswertung). Hier wird verlangt, dass man die Beta-Reduktion nur

verwenden darf, wenn das Argument ausgewertet ist, d.h., eine strikte

Normalform ist. Ebenso, dass der zu analysierende Ausdruck im case eine strikte Normalform ist. Die zur Strategie gehörige Normalform ist die

strikte Normalform.

Die Anwendungsordnung ist die Strategie, die in Lisp, und ML verwendet wird.

Es gibt auch andere Varianten der Auswertung, in denen Normalform durch

etwas anderes (z.B. HNF) ersetzt ist.

Aus Satz 5.4.6 folgt, dass die verschiedenen Methoden die gleichen Resultate

liefern, wenn die Auswertung mit Konstruktortermen terminiert.

Allerdings kann das Verhalten bzgl. Terminierung verschieden sein:

Beispiel 5.4.37 Sei K = λx.(λy . x).

Dann wertet die Anwendungsordnung den Ausdruck K Nil bot so aus, dass

zuerst versucht wird, bot in Normalform zu bringen. Das gelingt nicht, also

terminiert das nicht.

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

33

Die Normalordnung wertet den Ausdruck K Nil bot so aus, dass zuerst der Ausdruck ((λy . Nil) bot) entsteht. Danach wird bot eingesetzt, und der Ausdruck

reduziert zu Nil. D.h. in diesem Fall terminiert die Auswertung.

Beispiel 5.4.38 Ein weiteres Beispiel ist hd (map f (map g [1..100])),

wobei f,g Funktionen sind, die Zahlkonstanten als Ein- und Ausgabe haben. In der Normalordnung wird vom Ausdruck [1..100] nur das erste Element ausgewertet, d.h. bis 1: [2..100], usw. Das Ergebnis ist

hd ((f (g 1)) : (map f (map g [2..100]))). Das ergibt (f (g 1)) und

danach wird dieser Ausdruck ausgewertet.

In der Anwendungsordnung wird zunächst der Ausdruck [1..100] zur Liste der

Länge 100: [1,2,3,...,100] ausgewertet. Am Ende hat man den Ausdruck

hd [a1,...,a100] wobei ai das Ergebnis von f (g i) ist. Das Ergebnis ist

ai.

Es gilt folgender Satz (Church-Rosser) der in der Literatur unter Existenz einer

Standardreduktion für den Lambda-Kalkül bekannt ist. Wir formulieren ihn

leicht verallgemeinert.

Satz 5.4.39 Sei s ein geschlossener Ausdruck. Wenn es einen Ausdruck t in

WHNF gibt mit s ∼c t, dann gilt s⇓.

Beweis. Unsere Definitionen sind auf diesen Fall zugeschnitten: Nehme den leeren Kontext. Dann folgt aus s ∼c t und t⇓ dass auch s⇓

2

Insbesondere heißt das:

Aussage 5.4.40 Wenn für einen Term t die Reduktion bzgl. irgendeiner Strategie (z.B. Anwendungsordnung) terminiert, dann auch die Reduktion in Normalordnung. D.h. jede Strategie (auch die Anwendungsordnung) ist strikter als

die Normalordnung.

Beweis. Folgt aus der Annahme, dass S-Normalformen auch WHNFs sind, dass

Reduktionen ∼c erhalten, und aus dem Standardisierungs-Satz.

2

Aussage 5.4.41 Die Normalordnungsreduktion ist eine maximale Strategie bzgl

der Relation ist strikter als“ , wobei wir die striktere Strategie als kleiner an”

sehen.

Beweis. Das folgt aus dem Standardisierungssatz.

Beispiel 5.4.42 Zu verschiedenen Reihenfolgen der Auswertung von Ausdrücken.

Wertet man (quadrat(3 ∗ 3)) aus, so kann man das auf drei Weisen machen:

(quadrat(3 ∗ 3)) → quadrat 9 → 81 oder

(quadrat(3 ∗ 3)) → ((3 ∗ 3) ∗ (3 ∗ 3)) → (9 ∗ (3 ∗ 3)) → (9 ∗ 9) → 81 oder

(quadrat(3 ∗ 3)) → ((3 ∗ 3) ∗ (3 ∗ 3)) → ((3 ∗ 3) ∗ 9) → (9 ∗ 9) → 81

EFP, WS2008/09, kontextuelle Gleichheit, Standardisierung, 3. Februar 2009

34

Bemerkung: Funktionale Programmiersprachen, die die Anwendungsordnung als

Auswertungsstrategie haben, nennt man strikte FPS, solche die die Normalordnung benutzen, nennt man auch nicht-strikte FPS. Der Begriff kommt eigentlich

aus der denotationalen Semantik der Programmiersprachen, wird aber auch für

die passende operationale Semantik verwendet.