Konzepte und diskrete Wahrscheinlichkeitstheorie

Werbung

Elementare Wahrscheinlichkeitstheorie

Vorlesungsmitschrift

SS 2008

SS98

Uwe Rösler

Kapitel 1

Konzepte und diskrete

Wahrscheinlichkeitstheorie

1.1

Einführung und Motivation

Wahrscheinlichkeiten werden im täglichen Sprachgebrauch verwendet und intuitiv verstanden.

Hieraus entwickeln wir dann in mehreren Schritten das gängige Konzept der Wahrscheinlichkeitstheorie,

die Axiomatik von Kolmogoroff.

1.1.1

Laplaceräume

Beispiel 1.1.1 Wir würfeln einen normalen Würfel. Die Ergebnisse sind eine Zahl aus 1 bis 6.

Die Wahrscheinlichkeit (W-keit), dass die Zahl 6 erscheint ist 61 . Aus Symmetriegründen ist die

Wahrscheinlichkeit für das Erscheinen der Zahl 1 genauso gross. Für jede Zahl i von 1 bis 6 gilt:

Wahr(Die Zahl i erscheint) =

1

.

6

Die Wahrscheinlichkeit (W-keit) für das Würfeln einer geraden Zahl ist

Wahr(Eine gerade Zahl erscheint) = Wahr(2) + Wahr(4) + Wahr(6) =

1

.

2

Ebenso lassen sich andere W-keiten für Teilmengen A der Ergebnismenge {1, 2, . . . , 6} leicht

berechnen,

1

Wahr(A) = |A|.

6

Würfeln ist ein einfaches Beispiel eines Zufallsexperiments. Die Ergebnisse heis̈en auch Realisierungen

des Zufallsexperiments. Der Raum aller Realisierungen heis̈t Stichprobenraum und wird konventionell

mit Ω bezeichnet. Ein Element ω des Stichprobenraumes heißt Realisierung oder Stichprobe. Die

Potenzmenge Pot(Ω) des Stichprobenraumes heis̈t Ereignisraum, eine Teilmenge des Stichprobenraumes

Ereignis. Ein Wahrscheinlichkeitsmas̈ (W-mas̈) ordnet jedem Ereignis einen Wert aus dem Einheitsintervall

[0, 1] zu. Konventionell wird diese Abbildung

P : Pot(Ω) → [0, 1]

mit P als Abkürzung fürs englische probability bezeichnet.

Definition 1.1.2 (Laplaceraum) Ein Laplaceraum ist ein Tupel (Ω, P ). Hierbei ist Ω eine

nichtleeren endliche Menge und P die Abbildung auf der Potenzmenge Pot(Ω) ins Einheitsinvall

gegeben durch

|A|

P (A) =

.

|Ω|

1

Uwe Rösler

Merkregel:

die

SS98

1.1

Einführung und Motivation

Einprägsamer ausgedrückt: für Laplaceräume ist die Wahrscheinlichkeit eines Ereignisses

Anzahl der günstigen geteilt durch die Anzahl der möglichen Fälle.

Jedes Elementarereignis {ω} hat die W-keit

W-keit eines Ereignisses berechnet sich zu

1

|Ω| .

P (A) =

Elementarereignisse haben die gleiche W-keit. Die

X

P ({ω}).

ω∈Ω

Die Bestimmung von W-keiten reduziert sich zu reinem abzählen.

Beispiel 1.1.3 (Lotto) Aus 49 durchlaufend numerierten Kugeln werden 6 Kugeln zufällig gezogen.

Ein Ergebnis ist die Menge der sechs gezogenen zahlen, üblicherweise geschrieben als 6-Tupel

(x1 , . . . , x6 ) mit 1 ≤ x1 < x2 < . . . < x6 ≤ 49. Dies sind die Stichproben. Jede Stichprobe hat

dieselbe W-keit. (Dazu stelle man sich die Kugeln umnummeriert vor. Die Umnummerierung hat

keinen Einflus̈ auf das Ziehen der Kugeln. Daher sollte mögliche Zahlenkombination dieselbe Wkeit besitzen.) Wir haben einen Laplaceraum vorliegen. Die W-keit 6 richtige mit dem Tip y zu

haben ist

1

1

1

= ¡49¢ =

P ({y}) =

|Ω|

13.983.816

6

Lemma 1.1.4 Eine n-elementige Menge hat

n

k

k-elementige Teilmengen.

¡ ¢

n!

Notation nk := k!(n−k)!

= n(n−1)(n−2)...(n−k+1)

wird n über k gelesen. Das Symbol n! = n(n −

k(k−1)...1

1)(n − 2) . . . 1 wird n-Fakultät

¡ ¢ gelesen.

Konvention 0! = 1 und n0 = 1

Beispiel 1.1.5 Wir betrachten n-maliges Würfeln eines Würfels. Eine Realisierung wird durch ein

Element ω = (ω1 , . . . , ωn ) aus {1, 2, . . . , 6}n beschrieben. Jede Realisierung sollte gleichwahrscheinlich

sein. Es ergibt sich der Laplaceraum (Ω = {1, . . . , 6}n , P ).

Auch auf Laplaceräumen gibt es interessante Zufallsgrös̈en. Sei z.B. X(ω) = |{i ≤ n | ωi = 1}|

die Anzahl der aufgetretenen Einsen. Dann hat X eine Binomialverteilung Bin(n, 1/6), d.h.

|{ω | X(ω) = k}|

P ({ω | X(ω) = k}) =

=

6n

1.1.2

µ ¶ µ ¶k µ ¶n−k

n

5

1

.

6

6

k

Diskrete Wahrscheinlichkeitsräume

Laplaceräume sind die einfachsten Wahrscheinlichkeitsräume. Unser nächstes Beispiel zeigt einen

W-Raum, der kein Laplaceraum ist.

Beispiel 1.1.6 Wir werfen eine Münze solange bis Adler erscheint. Das Ergebnis dieses Zufallsexperiments

sei die Anzahl der Würfe. Der Stichprobenraum sind die natürlichen Zahlen IN. Die W-keit für

einmaliges werfen ist 12 , für zweimaliges werfen 14 für dreimaliges 18 usw

P ({n}) = 2−n .

Die W-keit eines Ereignisses A berechnet sich zu

P (A) =

X

ω∈A

2

P ({ω}).

Elementare Wahrscheinlichkeitstheorie

Vorlesungsmitschrift

SS 2008

SS98

Uwe Rösler

Definition 1.1.7 (Diskreter Wahrscheinlichkeitsraum) Ein diskreter W-raum ist ein Tupel

(Ω, P ). Hierbei ist Ω eine endliche oder abzählbare nichtleere Menge und die Abbildung P :

Pot(Ω) → [0, 1] erfüllt die Eigenschaften

X

P ({ω})

∀A ⊂ Ω

P (A) =

ω∈A

P (Ω) = 1.

Proposition 1.1.8 Sei Ω eine endliche oder abzählbare nichtleere

PMenge. Es gibt eine Bijektion

zwischen W-mas̈en P auf Ω und positiven Funktionen f auf Ω mit ω∈Ω f (ω) = 1. Diese Bijektion

kann durch

P ({ω}) = f (ω)

gegeben werden.

Der Beweis ist einfach.

W-mas̈e eines diskreten W-raumes werden eindeutig beschrieben durch die Dichtefunktion f.

Ist ω1 , ω2 , . . . eine Aufzählung von Ω, so spricht man auch von dem Wahrscheinlichkeitsvektor

(f (ω1 ), f (ω2 ), . . .).

Die Wahrscheinlichkeit eines Ereignisses A berechnet sich zu

X

P (A) =

f (ω).

ω∈A

Die Dichtefunktion f kann den Wert 0 annehmen.

Beispiel 1.1.9 (Ereignisraum eines rot-grün Blinden) Wir würfeln zwei ununterscheidbare

Würfel gleichzeitig. Als Ergebnis dieses Experiments erhalten wir ein Tupel (i, j), i ≤ j der gewürfelten

Zahlen. Das Tupel haben wir der Grös̈e nach geordnet, die kleinere Zahl steht zuerst. Da die Würfel

ununterscheidbar sind, können wir die Zahlen nicht einem Würfel zuordnen. Das W-mas̈ P auf

dem Stichprobenraum beschreiben wir durch die Dichtefunktion f

½ 1

f alls i = j

36

f (i, j) =

2

f alls i < j

36

Wie haben wir die W-keiten gefunden? Betrachten wir dazu das Experiment des würfelns mit

zwei unterscheidbaren Würfeln, z.B. roter und grüner Würfel. Als Ergebnis notieren wir das Tupel

(i, j), i das Ergebnis des roten Würfel und j des grünen. Sei (Ω, P ) der zu diesem Experiment

gehörige Laplaceraum.

Ein rot-grün blinder Mensch kann die Würfel nicht unterscheiden und notiert die gewürfelten

Zahlen als Tupel (i, j), i ≤ j der Grös̈e nach geordnet. Der Farbblinde benutzt den diskreten Wraum (Ω0 , P 0 ) aus Beispiel 1.1.9. Jedem beobachtbaren Ereignis des Farbblinden ordnen wir ein

entsprechenden Ereignis mit unterscheidbaren Würfeln zu. Dazu betrachten wir die Abbildung

X : Ω → Ω0

Ω 3 (i, j) 7→ X(i, j) = (min i, j, max i, j) ∈ Ω0 .

Diese Abbildung ist wohldefiniert und surjektiv. Ein Ereignis A0 des Farbblinden entspricht dem

Ereignis X −1 (A0 ) des Normalsichtigen. Daher definiert

P 0 (A0 ) := P (X −1 (A0 ))

das richtige W-mas̈ P 0 für den Farbblinden. P 0 heis̈t auch transportiertes Mas̈s.

Bemerkung: Im obigen Beispiel haben wir eine Äquivalenzrelation auf Ω gebildet (ω ∼ ω ↔

X(ω) = X(ω)) und Ω0 entspricht den Äquivalenzklassen. Auf Ω selbst bezogen hat der Farbblinde

einen echt kleineren Ereignisraum (X −1 (Pot(Ω0 )) als der Normalsichtige.

3

Uwe Rösler

1.1.3

SS98

1.1

Einführung und Motivation

Kolmogoroff Axiomatik

Wir kommen jetzt zum allgemeinen Konzept der Wahrscheinlichkeitstheorie. Das Beispiel des

Farbblinden zeigt bereits die Notwendigkeit kleinere Ereignisräume als die volle Potenzmenge

zuzulassen. Wir benötigen strukturelle Forderungen an die Ereignisraum, wie z.B. die Vereinigung

von Ereignissen ist ein Ereignis.

Die folgende Axiomatik von Kolmogoroff hat sich als sehr erfolgreich erwiesen.

Definition 1.1.10 Ein Wahrscheinlichkeitsraum ist ein Tupel (Ω, A, P ). Der Stichprobenraum

Ω ist eine nichtleere Menge, der Ereignisraum A ⊂ Pot(Ω) ist eine σ-Algebra und P : A → [0, 1]

ist ein Wahrscheinlichkeitsmas̈.

Definition 1.1.11 Eine σ-Algebra A über einer Menge Ω ist eine Teilmenge der Potenzmenge

von Ω mit den folgenden Eigenschaften

i) A ist nicht leer.

ii) A ist komplementabgeschlossen.

iii) A ist abgeschlossen bzgl. abzählbarer Vereinigung.

In mathematischerer Schreibweise

i) A 6= ∅

ii) ∀ A ∈ A : Ac ∈ A

iii) ∀ An ∈ A, n ∈ IN : ∪n∈IN An ∈ A

Ein mes̈barer Raum (Ω, A) besteht aus einer nicht leeren Menge Ω und einer σ-Algebra darüber.

Bemerkung: Die Forderung A nicht leer können wir durch A enthält die leere Menge ersetzen.

Not. R := IR ∪ {−∞, ∞} bezeichne die erweiterten reellen Zahlen.

Definition 1.1.12 Ein Mas̈ auf einem mes̈baren Raum (Ω, A) ist eine Abbildung µ : A → R mit

folgenden Eigenschaften

i) µ(∅) = 0

ii) µ(A)

S ≥ 0 für jedes

P Element A der σ-Algebra A

iii) µ( ◦ n∈IN An ) = n∈IN µ(An ) für jede paarweise disjunkte Folge An , n ∈ IN aus A.

S

Not: Das Symbol ◦ i Ai steht für die Vereinigung paarweiser disjunkter Mengen Ai , i aus einer

Indexmenge.

Definition 1.1.13 Ein Wahrscheinlichkeitsmas̈(W-mas̈) ist ein Mas̈ µ mit der zusätzlichen

Normierung

µ(Ω) = 1.

Kon W-mas̈e werden üblicherweise mit P bezeichnet.

Definition 1.1.14 Ein Mas̈raum ist ein Tupel (Ω, A, µ) bestehend aus einem mes̈baren Raum

(Ω, A) und einem Mas̈ µ darauf. Ein W-raum ist ein Mas̈raum (Ω, A, P ) mit einem W-mas̈ P.

Beispiele: Laplaceräume und diskrete W-rüame sind W-räume. Jeder W-raum mit endlichem

Stichprobenraum Ω, der Potenzmenge als σ-Algebra und gleicher W-keit aller Stichproben ist ein

Laplaceraum. Jeder W-raum mit höchstens abzählbarem Stichprobenraum Ω und der Potenzmenge

als σ-Algebra ist ein diskreter W-raum.

1.1.4

Zufallsgrös̈en:

W-Räume sind die neuen Objekte, die wir betrachten wollen. Zu einer tieferen Theorie benötigen

wir strukturerhaltende Abbildungen zwischen W-räumen.

Definition 1.1.15 Eine Abbildung X von einem mes̈baren Raum (Ω, A) in einen anderen mes̈baren

Raum (Ω0 , A0 ) heis̈t mes̈bar, falls X −1 (A0 ) ∈ A für jedes Ereignis A0 ∈ A0 . Eine Zufallsgrös̈e

(Zg) ist eine mes̈bare Abbildung X : Ω → Ω0 .

4

Elementare Wahrscheinlichkeitstheorie

Vorlesungsmitschrift

SS 2008

SS98

Uwe Rösler

Not Zgn werden mit gros̈en Buchstaben gekennzeichnet, X, Y, Z. Realisierungen werden vorzugsweise

mit kleinen Buchstaben bezeichnet.

Bemerkung Den Begriff Mes̈barkeit benötigen wir nur, falls wir Ereignisräume betrachten, die

kleiner als die Potenzmenge sind. Im Setting diskreter W-räume ist jede Funktion bereits mes̈bar.

1.1.5

Transportierte Maße

Proposition 1.1.16 Sei X : Ω → Ω0 eine Abbildung von einem Mas̈raum (Ω, A, µ) in einen

mes̈baren Raum (Ω0 , A0 ). Dann ist die Abbildung µ0 : A0 → IR

µ0 (A0 ) := µ(X −1 (A0 ))

ein Mas̈.

Beweis: Nachrechnen der Eigenschaften. (Übung)

Definition 1.1.17 Das Mas̈ µ0 wie oben heis̈t transportiertes Mas̈. Ist X eine Zg und µ ein

W-mas̈, so heis̈t µ0 die Verteilung von X.

Not Folgende Notationen sind gebräuchlich, µX , µX und µX −1 . Ich benutze vorzugsweise P X für

die Vereteilung von X.

Not Das ω wird gerne unterdrückt. Wir schreiben X ∈ A0 für das Ereignis {ω ∈ Ω | X(ω) ∈ A} =

X −1 (A0 ). Typisch ist P (X ∈ A0 ) anstelle P ({ω ∈ Ω | X(ω) ∈ A}).

Not Mengenklammern werden gerne unterdrückt. Wir schreiben z.B. P (ω) anstelle von P ({ω}).

1.1.6

Verteilungen

Konvention: Im folgenden betrachten wir nur diskrete W-räume mit der Potenzmenge als

Ereignisraum. Einige W-räume, mehr noch die zugehörigen W-maße, auch Verteilungen genannt,

sind besonders wichtig.

• Bernoulliverteilung: Dies ist ein diskretes W-maß P auf dem Stichprobenraum {0, 1} mit

P (1) = p und q := P (0) = 1 − p. Das Standardbeispiel ist der Münzwurf. Das Ergebnis des

Münzwurfs ist 1 (für Kopf) mit Wahrsch. p und 0 (für Zahl) mit Wahrsch. q.

• Binomialverteilung: Die Binomialverteilung Bin(n, p) zum Parameter (n, p), 0 ≤ n, 0 ≤

p ≤ 1, ist ein W-Maß P auf dem Stichprobenraum Ω = {0, . . . , n} mit

µ ¶

n k

P ({k}) =

p (1 − p)n−k .

k

Werfen wir n mal eine gefälschte Münze, p sei die Wahrsch. für Kopf (1), so ist die Gesamtanzahl

S der Kopfwürfe P ({ω | S(ω) = k}) = P ({k}) binomialverteilt Bin(n, p).

• Geometrische Verteilung: Die geometrische Verteilung Geo(p) zum Parameter p ∈ [0, 1)

ist ein W-Maß P auf den natürlichen Zahlen als Stichprobenraum mit

P ({k}) = (1 − p)pk−1 .

Wir werfen eine gefälschte Münze, p sei die Wahrsch. für Kopf (= 1). Sei X die Anzahl der

Kopfwürfe vor dem ersten Zahlwurf. Das Ereignis,der k-te Wurf ist der erste Zahlwurf, hat

die Wahrsch. P ({ω | X(ω) = k}) = (1 − p)pk−1 .

• Poissonverteilung: Die Poissonverteilung Poi(λ) zum Parameter λ ∈ (0, ∞) ist ein W-Maß

P auf dem Stichprobenraum ZZ + mit

P ({k}) = exp(−λ)λk /k!.

Beachte

P

k

P ({k}) = 1 wegen der Taylor Entwicklung exp(x) =

5

P∞

xn

n=0 n! .

Uwe Rösler

SS98

1.1

Einführung und Motivation

• Negative Binomialverteilung: Die negative Binomialverteilung zum Parameter (n, p), n ∈

IN, 0 ≤ p < 1, ist ein W-Maß P auf dem Stichprobenraum IN0 mit

¶

µ

k+n−1 n k

q p ,

P ({k}) =

k

P

P ¡k+n−1¢ k

1

q = 1 − p. Beachte k P ({k}) = 1 wegen der Taylor Entwicklung (1−x)

x .

n =

k

k

6

Elementare Wahrscheinlichkeitstheorie

Vorlesungsmitschrift

SS 2008

1.2

SS98

Kombinatorische Wahrscheinlichkeitstheorie

Uwe Rösler

In diesem Abschnitt betrachten wir nur endlichen Stichprobenräume versehen mit der Potenzmenge

als σ-Algebra. Das Wahrscheinlichkeitsmaß P schreibt sich als additive Funktion,

X

P ({ω}).

P (A) =

ω∈A

Notation: P (ω) = P ({ω}).

Durch gute Wahl des w-theoretischen Modells reduzieren sich viele W-theoretische Argumente auf

Kombinatorik und geschicktes Abzählen. Die Betonung liegt auf geschicktes, denn eine häufige

Schwierigkeit ist die Wahl der “richtigen” Anschauung und Darstellung des Stichprobenraumes.

Mit der richtigen Betrachtungsweise wird das Abzählen meist einfach.

Besonders geeignete Kandidaten sind die Laplaceräume, da die W-keiten sich als Quotient erweisen,

Anzahl der günstigen geteilt durch die Anzahl der möglichen Fälle.

1.2.1

Laplaceraum

Definition 1.2.1 Ein Laplaceraum ist eine endliche Menge Ω versehen mit der Potenzmenge

als σ-Algebra und dem W-maß

|A|

P (A) =

|Ω|

auf den Ereignissen.

Proposition 1.2.2 Ein W-raum (Ω, P(Ω), P ) mit endlichem Stichprobenraum ist genau dann ein

Laplaceraum, wenn alle Stichproben gleichwahrscheinlich sind.

P

1

Bew: Die Hinrichtung folgt aus P (ω) = |Ω|

und die Rückrichtung, beachte 1 = P (Ω) = ω∈Ω P ({ω})

aus

X

|A|

.

P (A) =

P ({ω}) =

|Ω|

ω∈A

q.e.d.

Die Standardvorstellung zu einem Laplace-Experiment ist das Modell einer Urne mit n numerierten

Kugeln, aus der wir einmal ziehen. Überhaupt bilden Urnenmodelle eine geeignete Vorstellung für

alle w-theoretischen Fragestellungen bei endlichem Stichprobenraum. Daher eine kleine Übersicht

der wichtigsten Urnenmodelle.

1.2.2

Urnenmodelle

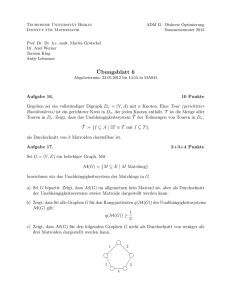

13j

12j

11j 10j8j 9j 14j

6j 7j 5j 1j 4j 2j 3j %

&

Gegeben sei eine Urne mit n numerierten Kugeln, aus der wir insgesamt k-mal ziehen wollen. Die

Kugeln seien durchgehend numeriert von 1 bis n. Wir ziehen zufällig (jede Kugel hat dieselbe

W-keit) eine Kugel heraus und sehen uns das Ergebnis an. Abhängig vom Urnenmodell legen wir

die Kugel zurück oder nicht. Dann wird zum zweitenmal zufällig gezogen usw., insgesamt k-mal.

Als Gesamtergebnis notieren wir die Nummern der gezogenen Kugeln in zeitlicher Reihenfolge der

Ziehung oder, falls uns die zeitliche Reihenfolge vorenthalten wird, in lexikographischer Ordnung.

(i) Ziehen in Reihenfolge und mit Zurücklegen

Eine Realisierung ist ein Tupel ω = (ω1 , ω2 , . . . , ωk ), wobei ωj die Nummer der j-ten gezogenen Kugel angibt. Jede solche Realisierung ist gleich wahrscheinlich (Symmetrieüberlegungen

und eventuelle Umnummerierung der Kugeln). Der zugehörige Stichprobenraum

ΩRZ := {1, 2, . . . , n}k

7

Uwe Rösler

SS98

1.2 Kombinatorische Wahrscheinlichkeitstheorie

hat

Elemente und ist ein Laplaceraum.

|ΩRZ | = nk

(ii) Ziehen in Reihenfolge und ohne Zurücklegen

Wir notieren die Folge der gezogenen Zahlen. Eine Realisierung wird beschrieben durch ein

k−Tupel (ω1 , ω2 , . . . , ωk ) verschiedener Zahlen von 1 bis n. Der Stichprobenraum

ΩR∼Z := {ω ∈ {1, 2, . . . , n}k | ωi 6= ωj for 1 ≤ i 6= j ≤ k}.

hat

|ΩR∼Z | = (n)k := n(n − 1) . . . (n − k + 1) =

n!

(n − k)!

Elemente und ist ein Laplaceraum. (Für die Auswahl des ersten Elements ω1 haben wir n

Möglichkeiten, für die zweite Kugelzahl nur noch n − 1 Möglichkeiten, dann n − 2 usw.)

Für n = k erhalten wir alle Permutationen der Zahlen 1 bis n, d.h. alle bijektiven Abbildungen von {1, 2, . . . , n} auf sich selbst.

(iii) Ziehen ohne Reihenfolge und ohne Zurücklegen

Als Gesamtergebnis der Ziehung bekommen wir nur mitgeteilt, welche Kugeln gezogen

wurden und wie oft diese gezogen wurden. Wir kennen nicht die zeitliche Reihenfolge der

Ziehung. Der Übersichtlichkeit halber ordnen wir die gezogenen Zahlen in lexikographischer

(=natürlicher) Ordnung. Wir verwenden den Stichprobenraum

Ω∼R∼Z := {ω ∈ {1, 2, . . . , n}k | ω1 < ω2 < . . . < ωk },

oder auch alternativ den Stichprobenraum

Ω0∼R∼Z := {A ⊂ {1, 2, . . . , n} | |A| = k}.

Die Abbildung (ω1 , . . . , ωk ) 7→ {ω1 , . . . , ωk } ist eine Bijektion von Ω∼R∼Z nach Ω0∼R∼Z .

Beide Stichprobenräume haben

µ ¶

n

= |ΩR∼Z |/k!

|Ω∼R∼Z | =

k

Elemente und sind Laplaceräume.

(Zum Beweis betrachten wir die obige Abbildung jetzt von ΩR∼Z nach Ω∼R∼Z zuordnet.

Jedes Urbild f −1 (y) := {ω | f (ω) = y} von y ∈ Ω∼R∼Z hat genau k! Elemente. Damit

erhalten wir obige Formel.)

Die häufigste Verwendung dieses Urnenmodells ist enthalten in der folgenden Merkregel:

Die Anzahl der k-elementigen Teilmengen einer n-elementigen Menge ist

(iv) Ziehen ohne Reihenfolge und mit Zurücklegen

¡n ¢

k

.

Als praktische Durchführung denken wir uns ein Ziehen mit Reihenfolge und mit Zurücklegen. Genannt werden nur die Nummern der gezogenen Kugeln, eventuell mit Mehrfachnennungen.

Eine Realisierung beschreiben wir durch das k-Tupel ω der aufsteigend geordneten Kugelnummern. Der Stichprobenraum zu diesem Urnenmodell ist

Ω∼RZ := {ω ∈ {1, 2, . . . , n}k | ω1 ≤ ω2 ≤ . . . ≤ ωk }.

Die Wahrscheinlichkeit eines Ereignisses ω berechnet sich als Summe der Wahrscheinlichkeiten aller ω 0 beim Ziehen mit Reihenfolge und mit Zurücklegen, die zu einer Nennung ω

führen.

8

Elementare Wahrscheinlichkeitstheorie

Vorlesungsmitschrift

SS 2008

SS98

Uwe Rösler

Sei ϕ : ΩRZ 7→ Ω∼RZ die Abbildung, die jedem ω 0 ∈ ΩRZ das geordnete Tupel zuordnet.

Das W-maß P∼RZ : ¶(Ω∼RZ ) → IR ist das durch ϕ transportierte Maß

P∼RZ (A) = PRZ (ϕ−1 (A)) =

|ϕ−1 (A)|

.

|ΩRZ |

Der W-raum (Ω∼RZ , ¶(Ω∼RZ ), P∼RZ ) ist der gesucht Wahrscheinlichkeitsraum. Dies ist kein

Laplaceraum. Z.B. hat in unserer Versuchsanordnung für n = 4, k = 4 die Realisierung

(1, 1, 1, 1) die Wahrscheinlichkeit 1/(44 ), die Realisierung (1, 2, 3, 4) aber eine Wahrscheinlichkeit

von 4!/44 . Verschiedene Realisierungen beim Ziehen mit Reihenfolge und mit Zurücklegen

ergeben dieselbe Nennung (ohne Reihenfolge.) Die Ziehungen in der zeitlichen Reihenfolge

4, 2, 1, 3 und 4, 3, 2, 1 ergeben als geordnetes Tupel beide (1, 2, 3, 4). Es gibt 4! verschiedener

Anordnungen von 1, 2, 3, 4, die als geordnetes Tupel (1, 2, 3, 4) ergeben, aber nur eine von

1, 1, 1, 1, die (1, 1, 1, 1) ergibt.

¢

¡

Elemente.

(Der Raum Ω∼RZ hat n+k−1

k

ϕ

Zum Beweis betrachten wir die Abbildung (ω1 , ω2 , . . . , ωk ) 7→ (ω1 , ω2 + 1, . . . , ωk + k −

1). Dies ist eine bijektive Abbildung von Ω∼RZ nach dem Stichprobenraum Ω∼R∼Z eines

Urnenmodell, aus n + k − 1 numerierten Kugeln ¡k Kugeln

¢ zu ziehen, ohne Zurücklegen und

verschiedene Möglichkeiten.)

ohne Reihenfolge. (Nachrechnen.) Dafür gibt es n+k−1

k

Satz 1.2.3 Die Ergebnisse sind im Vorgriff in der folgenden Tabelle zusammengefaßt.

k-mal ziehen

mit

ohne

aus n Kugeln

Zurücklegen

Zurücklegen

mit

Laplaceraum

Laplaceraum

unterscheidbare

Reihenfolge

|ΩRZ | = nk

|ΩR∼Z | = (n)k

Kugeln

ohne

Kein Laplaceraum

Laplaceraum

¡ ¢

|Ω∼R∼Z | = nk

ununterscheidbare

mit

ohne

k Kugeln verteilen

Mehrfachbelegung

Mehrfachbelegung

auf n Urnen

Reihenfolge

Kugeln

Die offensichtlichen Vorzüge der Modellierung durch Laplaceräume führt zu folgender Merkregel:

Modelliere Urnenmodelle stets mit Reihenfolge.

Beispiele

• Pasch: Berechne die W-keit bei dreimaligem Würfeln jeweils dieselbe Augenzahl zu würfeln.

Hier verwenden wir das erste Urnenmodell, mit Zurücklegen und mit Reihenfolge. Wir

haben einen Laplaceraum mit insgesamt 63 verschiedenen Möglichkeiten. Genau die sechs

9

Uwe Rösler

SS98

1.2 Kombinatorische Wahrscheinlichkeitstheorie

Würfelergebnisse (1, 1, 1), (2, 2, 2) bis (6, 6, 6) sind die “günstigen” Fälle. Damit ist die gesuchte

Wahrsch. für einen Pasch 6/63 = 1/36.

Wir werfen jetzt drei identisch aussehende Würfel gleichzeitig. Wie groß ist die Wahrsch. für

einen Pasch? Wir denken uns die Würfel (durch Farben) gekennzeichnet, und argumentieren

dann wie oben, mit demselben Resultat.

Es wäre möglich, aber ungeschickt und dies ist eine häufige Fehlerquelle, ein Urnenmodell

mit Zurücklegen und ohne Reihenfolge anzusetzen. Dies ist kein Laplaceraum.

• Zahlenlotto: Wie groß ist die W-keit für exakt 5 Richtige im Lotto (6 aus 49)? Unser

Grundraum ist ein Urnenmodell mit n = 49 Kugeln und k =

Ziehen, ohne

¡ 6-maligem

¢

Zurücklegen und ohne Reihenfolge. Der Laplaceraum Ω∼R∼Z hat 49

=

13.983.816

Elemente.

6

Wir haben genau 5 Richtige, falls aus den¡ sechs

Gewinnzahlen

genau

5

vorliegen

und aus

¢¡ ¢

verschiedene

Realisierungen.

Die

gesuchte

den restlichen 43 genau eine. Dafür gibt es 65 43

1

Wahrsch. 43/(49 · 47 · 46 · 22) liegt in der Größenordnung 1/50000.

• Geburtstag-Paradoxon: Selbst in kleinen Gruppen haben relativ häufig zwei Personen

an demselben Tag Geburtstag. Wir wollen dies “erklären”. Als Modell wählen wir ein

Urnenmodell mit Reihenfolge und mit Zurücklegen und mit nk Elementen. Die Geburtstage

der k Personen entsprechen dem Ergebnis zufälligen Ziehens eines Tages aus dem Jahr.

Das Ereignis Ek , kein Geburtstag ist doppelt, entspricht den Elementen von ΩR∼Z , allen kelementigen Teilmengen von {1, . . . , n} unter Berücksichtigung der Reihenfolge. Wir erhalten

P (Ek ) =

k−1

k−1

X

X i

n−i

k(k − 1)

(n)k

ln(

=

exp(

))

≈

exp(−

) = exp(−

).

nk

n

n

2n

i=0

i=0

Hierbei nutzen wir die Taylor Approximation ln(1 + x) ≈ x für x dicht bei 0.

Für welche Gruppengröße wird die Wahrsch. ungefähr 1/2? Ein wenig Rechnung liefert uns

P (E22 ) = 0, 5243 > 1/2 und P (E23 ) = 0, 4927 < 1/2. Bereits bei 23 Personen ist die Chance

für den Zusammenfall von zwei Geburtstagen ungefähr fifty-fifty.

In der Informatik kommt die Problemstellung vor bei zufälligem Abspeichern von Daten,

siehe dort unter Hashing.

• Olympialotterie: In einer Lotterie sind alle gleichteuren Lose auch gleich gewinnträchtig,

zumindest ist dies eine weitverbreitete Meinung. Alle Lose sind gleich, aber manchmal sind

einige Lose “gleicher”. Für die Glücksspirale der Olympialotterie 1971 wurden 10 Millionen

Lose mit siebenstelligen Zahlen angeboten, von Nummer 0000000 bis hin zu 9999999. Die

Auslosung geschah durch siebenmaliges Ziehen ohne Zurücklegen der numerierten Kugeln

aus einer Trommel. Die gezogenen Ziffern, in zeitlicher Reihenfolge aufgeschrieben, ergab die

Gewinnzahl. In der Trommel waren insgesamt 70 Kugeln, jeweils 7 Kugeln der Ziffern 0 bis

9.

Die Losnummer 0000000 hat eine Gewinnwahrsch. von

7 6

1

...

= 7!/(70)7 ≈ 8, 3 · 10−10 .

70 69

64

Die Losnummer 0123456 hat eine wesentlich höhere Gewinnwahrsch. von

7 7

7

...

= 77 /(70)7 ≈ 1, 3 · 10−7 .

70 69

64

(Weshalb?) Dies sind gleichzeitig die extremen Elementarwahrscheinlichkeiten.

10

Elementare Wahrscheinlichkeitstheorie

Vorlesungsmitschrift

SS 2008

1.2.3

Urnenmodelle revisited*

SS98

Uwe Rösler

[ [ [ [ [[ [ [ [ [ [ [ [ [ [ [

◦ ◦

◦

◦

Der Versuchsaufbau besteht jetzt aus n Urnen, numeriert durch 1 bis n, und k Kugeln, die darauf

zufällig verteilt werden sollen. Unterschieden wird, ob Mehrfachbelegung der Urnen möglich ist

und ob die Kugeln unterscheidbar (=numeriert) sind. Zufällig bedeuted, jede der für eine Belegung

möglichen Urnen wird gleich behandelt.

Wir stellen uns zufälliges Ziehen der Urnen vor, wobei die gezogenen Urne in i-ter Runde durch

hineinlagen der Kugel i gekennzeichnet wird. Damit ist das Experiment wie Ziehen numerierter

Kugeln (mit/ohne Zurücklegen und mit/ohne Reihenfolge) aus einer Urne äquivalent zu einem

Verteilen von Kugeln (numeriert/ununterscheidbar) auf numerierte Urnen (mit/ohne Mehrfachbelegung). Im Detail:

(i) Verteilung unterscheidbarer Kugeln und mit Mehrfachbelegung

Eine Realisierung besteht in der Angabe der Kugeln in der j-ten Box nach der Verteilung.

Der Stichprobenraum

[

ΩU M := {(A1 , A2 , . . . , An ) | ∀ 1 ≤ i ≤ n : Ai ⊂ {1, 2, . . . , k}, ◦ Aj = {1, 2, . . . , k}}

j

ist bijektiv zum Stichprobenraum ΩRZ des ersten Urnenmodells.

Dazu betrachten wir die Bijektion (A1 , . . . , An ) 7→ (ω1 , . . . , ωk ) mit i ∈ Aωi . In Worten,

i ∈ Aj entspricht in der i-ten Ziehung (Urnenmodell mit Zurücklegen und mit Reihenfolge)

wird die Kugel mit der Zahl j gezogen.

(ii) Verteilung unterscheidbarer Kugeln und ohne Mehrfachbelegung

Eine Realisierung beschreiben wir durch die Angabe der Kugelnummer in der i-ten Urne,

bzw. durch die leere Menge, falls die Urne leer ist. Formal ist der Stichprobenraum

ΩU ∼M := {(A1 , . . . , An ) ∈ ΩI | ∀1 ≤ i ≤ n |Ai | ≤ 1}.

Diese Menge hat ebensoviele Elemente wie ΩR∼Z . Dazu betrachten wir die Bijektion

(A1 , . . . , An ) 7→ ω, eine Kugel j ∈ Ai in Urne i entspricht dem Ziehen der Kugelzahl i

in der j-ten Ziehung.

(iii) Verteilung ununterscheidbarer Kugeln und ohne Mehrfachbelegung

Eine Realisierung beschreiben wir durch eine 0-1 Folge der Länge n. Eine 0 bzw. 1 an

der i-ten Stelle entspricht einer leeren bzw. besetzten i-ten Box. Formal ergibt dies den

Stichprobenraum

n

X

ji = k}.

Ω∼U ∼M := {j ∈ {0, 1}n |

i=1

Dieser hat ebenso viele Elemente wie der Stichprobenraum Ω∼R∼Z . Jeder 0-1 Folge j ordnen

wir eine Menge A aus den Zahlen 1 bis n zu. Eine Zahl i sei Element von A genau dann, falls

die i-te Koordinate ji von j eine 1 ist. Dies ergibt eine Bijektion von Ω∼U ∼M auf Ω∼R∼Z .

(iv) Verteilung ununterscheidbarer Kugeln und mit Mehrfachbelegung

Eine Realisierung beschreiben wir durch durch die Angabe ji der jeweiligen Kugelanzahl in

der i-ten Urne. Der zugehörige Stichprobenraum

X

Ω∼U M := {j ∈ {0, 1, . . . , k}n |

ji = k}

i

ist gleichmächtig wie Ω∼RZ . Die Abbildung j 7→ ω, ji die Häufigkeit |{l | ωl = i}| mit der

die Kugel i aus der Urne gezogen wird, ist bijektiv.

Die Beschreibungen eines Experiments durch die Ziehen aus Urnen oder durch Verteilen auf Urnen

sind äquivalent.

11

Uwe Rösler

SS98

1.2 Kombinatorische Wahrscheinlichkeitstheorie

Urnenmodelle in der Physik: Das Modell ΩU M heißt in der Physik die Maxwell-Boltzman

Statistik. Die Urnen entsprechen räumlich gleichgroßen Quadern, die Kugeln nicht-wechselwirkenden Teilchen. Keine Teilchen gehorchen diesen Gesetzen.

Das Modell ΩU ∼M heißt in der Physik Fermi-Dirac Statistik. Die Teilchen, die diesem Modell

gehorchen, heißen Fermionen [?].

Bei der Untersuchung des Aufbaus der Elektronenhülle des Atoms fand Pauli das Gesetz, daß

zwei Elektronen nicht in allen vier, ihren Zustand beschreibenden Quantenzahlen übereinstimen

dürfen. In anderen Worten, nicht mehr als ein Elektron darf den seinem Zustand beschreibenden

Phasenraumvolumen besetzen.

Jedem Elementarteilchen ordnet man einen “abstrakten” Eigendrehimpuls zu, den sogenannten

Spin. Dieser kann die Werte nh/(4π) oder −nh/(4π) annehmen (n ∈ IN, h = Planck’sches

Wirkungsquantum). Die Teilchen mit ganzzahligem Spin (ungerade) sind die Bosonen, die mit

halbzahligem Spin (n ungerade) die Fermionen.

1.2.4

Weitere Urnenmodelle

(v) Hypergeometrische Verteilung

Die hypergeometrische Verteilung zum Parameter (W, S, n) ∈ ZZ + ×ZZ + ×{1, . . . , S +W }

ist ein W-maß P auf dem Stichprobenraum {0, 1, . . . , n}

P ({k}) =

¡S ¢¡

W

n−k

¡S+W

¢

n

k

¢

.

Aus einer Urne mit S schwarzen und W weißen Kugeln ziehen wir n−mal zufällig ohne

Zurücklegen und ohne Reihenfolge. Die Wahrsch., genau s schwarze und w weiße in n = s+w

Ziehungen zu ziehen, ist

¡S ¢¡W ¢

¡sS+Ww¢ .

s+w

Diese Wahrsch. als Funktion von s mit Parametern S, S +W, s+w, ist die hypergeometrische

Verteilung.

¢

¡

Elemente. Wir denken uns die

Unser gewählte Laplace Grundraum Ω∼R∼Z hat S+W

s+w

¡ ¢

numerierten Kugeln 1, 2, . . . , S als schwarz, die anderen W Kugeln als weiß. Es gibt Ss

verschiedene Möglichkeiten daraus s¡schwarze

(und numerierte) Kugeln (ohne Reihenfolge)

¢

auszuwählen. Entsprechend gibt es W

verschieden

Kombinationen für die weißen. Jedes

w

“günstige” Ereignis wird eindeutig durch die numerierte Menge der schwarzen, bzw. der

weißen Bälle beschrieben.

Beispiele

• Skat: Wie groß ist die Wahrsch., daß beim Skatspiel Vorhand drei Buben ausgeteilt bekommt?

Wir benutzen ein Urnenmodell mit 32 Kugeln und 10-maligem Ziehen ohne

Zurücklegen

und

¢

¡ ¢¡

.

Damit

hat

ohne Reihenfolge. Die Anzahl der günstigen Verteilungen für Vorhand ist 43 28

7

¡ ¢¡ ¢ ¡32¢

drei

Buben.

/

Vorhand mit Wahrsch. 43 28

10

7

• Fischezählung: Wie lassen sich Fische in einem Teich zählen? Wir fangen S Fische heraus

und markieren diese. Danach setzen wir diese zurück, “mischen” kräftig durch und fischen

zufällig k Fische heraus. Darunter seien s > 0 markierte. Naiv erwarten wir ein ähnliches

Zahlenverhältnis der wiedergefangenen markierten Fische zu den gefangenen wie das der

gefangenen zu allen. Dies ergibt heuristisch einen Schätzer N̂ = kS/s der Gesamtanzahl N,

(der auch praktisch benutzt wird).

12

Elementare Wahrscheinlichkeitstheorie

Vorlesungsmitschrift

SS 2008

SS98

Uwe Rösler

Hier ein anderes Argument, beruhend auf einem mathematischen Prinzip (Maximum-Likelihood

Schätzer). Die hypergeometrische Verteilung ordnet dem Ereignis, s markierte Fische wiederzu(S)(W )

fangen, eine Wahrsch. von p(s) = sS+Ww zu.

( s+w )

Für eine gegebene Gesamtanzahl N = S+W wird die Anzahl der wiedergefangenen markierten

Fische s häufig einen relativ großen Wert von p(s) liefern. Umgekehrt, wenn wir die Anzahl

der wiedergefangenen markierten Fische s kennen, aber nicht die Gesamtanzahl N, so werden

wir eine Gesamtanzahl N erwarten, sodaß die obige Wahrsch. groß wird. Als Schätzer wählen

wir denjenigen Wert N, der obige Wahrsch., jetzt für festes s, maximiert. Die Lösung dieser

nun mathematischen Aufgabe ist N̂ = kS

s .

¡ ¢

Multinomialkoeffizienten: Die Binomialkoeffizienten nk beschreiben die Anzahl der verschiedenen Teilungen einer n-elementige Menge in zwei Gruppen, wobei die erste Gruppe genau k

Elemente haben soll.

r

Seien n, r natürliche Zahlen und k = (k1 , . . . , kr ) ∈ ZZ≥

ein Vektor mit k1 + k2 + . . . + kr = n. Die

Multinomialkoeffizienten sind definiert durch

µ ¶

n

n!

.

:=

k

k1 !k2 ! . . . kr !

¡ ¢

Die Multinomialkoeffizienten nk geben die Anzahl der möglichen Teilungen von n numerierten

Kugeln in r numerierte Gruppen an,¡ wobei

die i−te Gruppe ki Elemente haben

soll.

¢

¡

¢ Für die

1

Auswahl der ersten Gruppe haben wir kn1 Möglichkeiten, für die zweite nur noch n−k

Möglichkeik2

¡n−k1 −k2 ¢

usw. Dies ergibt die Formel.

ten, dann

k3

Die hier betrachteten Gruppen sind numeriert, d.h. die Einteilung ist auch abhängig von der

Reihenfolge der Gruppenstärken k1 , k2 , . . . , kr . Das folgende Beispiel verdeutlicht die Wichtigkeit

dieser Unterscheidung.

Beispiel Mannschaftseinteilung: 26 Schulkinder wollen Fußball und Tennis spielen. Dazu

bilden sie zwei Mannschaften

B zu

¡ A,

¢ je 11 Spielern für Fußball und zwei Mannschaften C, D für

26

das Tennisdoppel. Es gibt (11,11,2,2)

Möglichkeiten der verschiedenen Mannschaftaufteilungen in

¡ 26 ¢ 1

A, B, C, D. Die Anzahl der verschiedenen Spielkombinationen (Paarungen) 11,11,2,2

4 ist kleiner.

Trotz verschiedener Mannschaftsaufstellung, z.B. A = {1, 2, . . . , 11}, B = {12, . . . , 22}, C =

{23, 24}, D = {25, 26} und A = {12, . . . , 22}, B = {1, . . . , 11}, C = {25, 26}, D = {23, 24},

spielen eventuell dieselben Mannschaften gegeneinander.

(vi) Multinomialverteilung Seien n, r natürliche Zahlen, p ein W-maß auf {1, . . . , r}, geschrieben als Vektor

X

p = (p1 , . . . , pr ),

pj = 1.

j

Die Multinomialverteilung zum

P Parameter (n, r, p) ist ein W-maß P auf dem Stichprobenraum {k = (k1 , . . . , kr ) ∈ IN0r | i ki = n} mit

µ ¶

n k

P (k) =

p .

k

Hierbei ist pk = pk11 pk22 . . . pknn die Multiindexschreibweise. Das Standardbeispiel ist es, n

Kugeln auf r Urnen zu verteilen. Die erste Kugel wird mit der W-verteilung p in eine Urne

gelegt, dann die zweite (unabhängig von der ersten) usw.

13

Uwe Rösler

1.3

SS98

1.3

Bedingte Wahrscheinlichkeit

Bedingte Wahrscheinlichkeit

Heuristik: Wir betrachten nur W-räume mit endlichem oder abzählbarem Stichprobenraum.

Die W-keit eine 6 gewürfeln zu haben, wenn bereits bekannt ist, dass der Wurf 4 oder 5 oder 6

zeigt, ist 1/3. Abstrakter, wenn wir im Venn-Diagramm wie unten die Flächen der Mengen als

W-keit interpretieren, dann sollte die W-keit eines Ereignisses A unter B die gemeinsame Fläche

A ∩ B dividiert durch die Fläche des bekannten Ereignissses B sein.

$$

''

A

A∩B

B

&&

%%

Definition 1.3.1 Die bedingte Wahrscheinlichkeit eines Ereignisses A unter dem Ereignis B

mit P (B) > 0 ist

P (A ∩ B)

.

P (A | B) =

P (B)

Sprachgebrauch: W-keit von A unter (oder gegeben) B.

Konvention: Die Verwendung des Symbols P (A | B) beinhaltet bereits die strikte Positivität der

Wahrsch. des Ereignisses B.

Rechenregeln ergeben sich aus der einfachen Feststellung, dass die Abbildung P (· | B) vom

Ereignisraum in die reellen Zahlen ein W-maß ist, das Tripel (Ω, A, P (. | B)), ist ein Wahrscheinlichkeitsraum. Ebenso ist das auf B beschränkte Tupel

(Ω>B , A|B , P|B ) = (B, {A ∩ B | A ∈ A}, PB = P (. | B))

ein W-Raum, genannt der induzierte oder auch eingeschränkte W-Raum. Ist der zugrundeliegende

W-Raum ein Laplaceraum, so auch der eingeschränkte.

Lemma 1.3.2 (Bedingte Rekursionsformel)

Für Ereignisse A, B, C mit P (B ∩ C) > 0 gilt

P (A ∩ B ∩ C) = P (A)P (B | A)P (C | A ∩ B).

Beweis: Nachrechnen.

Induktiv ergibt sich für Ereignisse A1 , . . . , An

q.e.d.

n−1

Ai ).

P (A1 ∩ . . . ∩ An ) = P (A1 )P (A2 | A1 ) . . . P (An | ∩i=1

Bsp: Lotto revisited: Wir betrachten Lottoziehen life am Fernseher. Die Zg Xi stehe für die i-te

gezogenen Zahl. Sei x1 , . . . , x6 mein Tipp bestehend aus 6 verschiedenen Zahlen aus {1, . . . , 49}.

Sei Ai das Ereignis {ω | Xi (ω) = xi }. (Wir verwenden als Kurzschreibweise hierfür Xi = xi .)

Dann werden unsere Zahlen x1 , . . . , x6 in dieser Reihenfolge gezogen mit W-keit

= P (A1 )P (A2 | A1 )P (A3 ∩ A2 ∩ A1 ) . . . P (A6 | ∩5i=1 Ai )

1 1

1

=

... .

49 48

44

Nach der i-ten Ziehung sind 49 − i Kugeln in der Urne und davon soll ich genau die vorgegebene

Kugel mit der Zahl xi+1 (Laplaceraum) ziehen.

Ist unser Tipp {x1 , . . . , x6 } ein Haupttreffer? Da es auf die Reihenfolge nicht ankommt gilt,

summieren wir über alle Permutationen π der Zahlen 1 bis 6,

X

P (Xi = xπ(i) für i = 1, . . . , 6)

P ({X1 , . . . , X6 } = {x1 , . . . , x6 }) =

P (∩6i=1 Ai )

π

=

14

k!

1

= ¡49¢

(49)6

6

Elementare Wahrscheinlichkeitstheorie

Vorlesungsmitschrift

SS 2008

SS98

Uwe Rösler

Wir erhalten jeder Tipp ist gleichwahrscheinlich.

Bsp: Bridge: Gefragt ist nach der W-keit, daß in einer Bridgehand, 52 Karten werden gleichmäßig

und zufällig auf 4 Spieler verteilt, jeder Spieler genau ein Ass erhält. Entspreche Ai dem Ereignis,

der Spieler i hält genau ein Ass in seinen 13 Karten, so folgt mit Hilfe der hypergeometrischen

Verteilung

¡ ¢¡ ¢

¡ ¢¡ ¢

P (A1 ) =

4

1

48

¢

¡5212

13

P (A3 | A1 ∩ A2 ) =

3

1

¡2¢¡24¢

¡2612

¢

1

36

¢

¡3912

P (A2 | A1 ) =

13

P (A4 | A1 ∩ A2 ∩ A3 ) = 1.

13

Unsere gesuchte W-keit ist das Produkt dieser vier Wahrsch..

1.3.1

Bayes Formel

Satz 1.3.3 (Bayes Formel) Sei der Stichprobenraum in paarweise disjunkte Ereignisse B1 , B2 , . . . ,

zerlegt, endlich oder abzählbar viele. Jedes dieser Ereignissse habe strikt positive W-keit.

Die Formel von der totalen Wahrscheinlichkeit lautet für ein Ereignis A :

X

P (Bi )P (A | Bi ).

P (A) =

i

Im Falle strikt positiver Wahrscheinlichkeit des Ereignisses A gilt die Bayes Formel

P (B1 )P (A | B1 )

P (B1 | A) = P

.

i P (Bi )P (A | Bi )

Beweis: Die erste Identität folgt aus der σ-Additivität des Wahrscheinlichkeitsmaßes

[

X

X

P (A) = P ( ◦ (A ∩ Bi )) =

P (A ∩ Bi ) =

P (Bi )P (A | Bi ).

i

i

i

Die Bayes Formel (Bayes 1763) folgt aus der Identität P (B1 | A) = P (B1 )P (A | B1 )/P (A) mit

Einsetzen von P (A) aus der Formel von der totalen Wahrscheinlichkeit.

q.e.d.

Bsp: Urnenwahl. Seien n Urnen gegeben. Die i-te Urne enthalte Si schwarze Kugeln und Wi

weiße. Zufällig wird eine Urne i mit W-keit pi ausgewählt und aus dieser eine Kugel gezogen.

Gesucht ist die W-keit für das Ereignis A, eine schwarze Kugel zu ziehen. (Präsisieren Sei Bi das

Ereignis die i-te Urne auszuwählen. Der Satz von der totalen Wahrsch. liefert

P (A) =

n

X

pi

i=1

Si

.

S i + Wi

Bsp: Reihenuntersuchung. Bereits 0,5% der Bevölkerung leidet an der Krankheit ’Ghost’. Bei

einer Reihenuntersuchung zeigen durchschnittlich 99% der Kranken eine positive Testreaktion.

Von den Gesunden zeigen rund 2% eine positive Testreaktion. Wie beunruhigend ist mein positives

Testergebnis wirklich?

Als erstes müssen wir die gegebenen Informationen sauber in ein Modell einbetten. Eine Realisierung sei ein 0 − 1 Tupel in dem Produktraum Ω := {0, 1}2 und X1 , X2 seien die Projektion auf

die erste, bzw. 2. Koordinate. Die erste Koordinate X1 = 1 bzw. 0 entspreche krank bzw. gesund

und die zweite Koordinate X2 = 1 bzw. 0 entspreche positivem bzw. negativem Testergebnis.

Obigen Angaben entsprechen präzise den Aussagen P (X1 = 1) = 0, 005, P (X2 = 1 | X1 = 1) =

0, 99, P (X2 = 1 | X1 = 0) = 0, 02. (Es gibt genau ein W-maß zu diesen Werten.) Mit Hilfe der

Bayes Formel erhalten wir das uns interessierende Resultat

P (X1 = 1)P (X2 = 1 | X1 = 1)

P (X1 = 1)P (X2 = 1 | X1 = 1) + P (X1 = 0)P (X2 = 1 | X1 = 0)

495

=

≈ 0, 2.

2485

Wie beunruhigend dies für mich wirklich ist, bleibt eine Interpretations- und Persönlichkeitsfrage.

P (X1 = 1 | X2 = 1)

=

15

Uwe Rösler

SS98

1.3

Bedingte Wahrscheinlichkeit

Unsauberes Denken

Der Umgang mit bedingten Wahrsch. im realen Leben führt durch unsauberes Denken und unzureichende Information häufig zu fehlerhaften Schlüssen. Hier zwei Beispiele:

Bsp: Diskriminierung. Folgende Zahlen deuteten auf eine sexuelle Diskriminierung weiblicher

Bewerber hin. An der Universität Berkeley wurden im Herbst 1973 von den 8442 männlichen

Bewerbern für ein Studium 44% (=3738) zugelassen. Von den 4321 weiblichen Bewerbern erhielten

nur 35% (=1494) einen Studienplatz. Dieser Unterschied erweist sich auch wissenschaftlich als

signifikant, er kann nicht allein durch Zufall ’erklärt’ werden. Da wir apriori davon ausgehen, daß

die Damen gleich qualifiziert und leistungsfähig sind, liegt nur der Schluß einer sexuellen negativen

Diskriminierung nahe.

Um die Hauptquelle der negativen Diskriminierung ausfindig zu machen, sehen wir uns die Daten

nach Fächern aufgelistet an. In den hundert Fächern gibt es bei einigen eine leichte Bevorzugung

der Männer, bei anderen eine leichte Bevorzugung der Frauen. Insgesamt aber eher eine Bevorzugung

der Frauen. Die folgende Liste der sechs Fächer mit den meisten Bewerbern gibt diese Tendenz

gut wieder.

Fach

1

2

3

4

5

6

Studienzulasssungszahlen

männlich

weiblich

Bewerbungen % Zulassungen Bewerbungen % Zulassungen

825

62

108

82

560

63

25

68

325

37

593

34

417

33

375

35

191

28

393

24

373

6

341

7

Auch bei Zugrundelegung dieser Liste ist der Anteil der akzeptierten männlichen mit 44,5%

signifikant höher als der der weiblichen mit 32%. Wo liegt die Erklärung?

Die ersten beiden Fächer haben relativ hohe Zulassungsraten. Hier gibt es einen hohen Anteil an

männlichen Bewerbern, jedoch nur einen niedrigen an weiblichen. In den nächsten drei Fächern

war die Zulassungsquote eher klein, der weibliche Anteil aber überproportinal groß.

Selbst wenn in jedem Fach die Frauen deutlich bevorteilt werden, kann insgesamt der prozentual

zugelassene Anteil der Männer wesentlich höher sein. Wir wollen uns dies am Beispiel zweier

Fächer A und B verdeutlichen. Sei Z die Menge der zugelassenen Personen und M (F ) die Menge

der sich bewerbenden Männern (Frauen) M (F ). Wir wollen strikte Bevorzugung der Frauen in

jedem Fach annehmen,

P (Z ∩ M | A ∩ M ) < P (Z ∩ F | A ∩ F )

P (Z ∩ M ∩ | B ∩ M ) < P (Z ∩ F | B ∩ F ).

Die geschlechterspezifischen Gesamtzahlen der Zulassung ergeben sich mit Hilfe der totalen Wahrscheinlichkeiten,

P (Z ∩ M | M ) = P (A | M )P (Z ∩ M | M ∩ A) + P (B | M )P (Z ∩ M | M ∩ B)

P (Z ∩ F | F ) = P (A | F )P (Z ∩ F | F ∩ A) + P (B | F )P (Z ∩ F | F ∩ B).

Wir betrachten den Extremfall, die einzige weibliche Bewerberin für das Fach A erhält einen

Studienplatz, der einzige männliche Bewerber für das Fach B erhält keinen. In jedem Fach werden

die Frauen bevorzugt (und damit diskriminiert, wenn auch positiv.) Durch Wahl der Zulassungsraten

für die Fächer ergäben sich beliebig große ’Diskriminationen’ für die Frauen

P (Z ∩ M | M ) =

P (Z ∩ F | F ) =

|M | − 1

P (Z ∩ M | M ∩ A)

|M |

1

|F | − 1

+

P (Z ∩ F | F ∩ B).

|F |

|F |

Die Beobachtung, Frauen haben eine Tendenz sich für Fächer mit geringerer Zulassungsquote zu

bewerben, ist eine plausible ’Erklärung.’ Jeder Leser wird zu dieser Aussage eigene Erfahrungen

16

Elementare Wahrscheinlichkeitstheorie

Vorlesungsmitschrift

SS 2008

SS98

Uwe Rösler

und ’Erklärungen’ haben, vielleicht auch Analogien sehen. Dies führt uns jedoch zu weit in die

reale Welt.

Bsp: Von Autos und Ziegen: Der Sieger einer Quizshow gewinnt den hinter einer Tür versteckten

Preis. Hinter einer der drei Türen ist ein Auto, hinter den anderen sind Ziegen. Der Sieger darf

eine Tür wählen und soll das dahinter versteckte Objekt erhalten. Nach der Wahl des Kandidaten

öffnet der Moderator jedoch erst eine der nichtgewählten Türen, hinter der eine Ziege erscheint. Der

Moderator bietet dem Kandidaten einen Wechsel seiner Türwahl an. Wie wäre Ihre Entscheidung?

Wenn wir davon ausgehen, daß der Showmaster stets eine Ziege präsentiert, sei es gezwunge-nermaßen oder aus Sympathiegründen, sollte der Kandidat seine Wahl ändern. Die anfangs gewählte

Tür zu öffnen behält die Wahrsch. von 1/3 das Auto zu verdecken bei. Das Auto steht hinter der

verbliebenen Tür mit Wahrsch. 2/3.

Mathematisches Modell: Das mathematische Modell ist aus der Sicht des Kandidaten zum

Zeitpunkt seiner zweiten Entscheidung. Als geeigneten (=hinreichend großen) Grundraum wählen

wir Ω = {1, 2, 3}3 mit der Potenzmenge als σ-Algebra. Die erste Koordinate X1 gibt die Tür an,

hinter der das Auto steht. Die zweite Koordinate X2 gibt die Wahl des Kandidaten an. Die dritte

Koordinate gibt die vom Quizmaster geöffnete Tür an. Wir benutzen Xi = j für das Ereignis aller

ω mit Xi (ω) = j.

Jetzt müssen wir ein (das) geeignetes W-maß P angeben, aus Sicht des Kandidaten. Der Kandidat

möchte seine Entscheidung X2 so wählen, daß P (X1 = X2 ) möglichst groß wird. Der Kandidat hat zum Zeitpunkt seiner ersten Wahl keine Vorinformation (und ist kein Prophet), welche

Tür das Auto verdeckt. Jede Prozedur, eine Tür zu wählen oder das Auto zu verstecken, ist

gleichgut mit einer, bei der die Türen permutiert sind. Durch Mittelung, erst eine Permutation

und dann nach vorgegebener Prozedur eine Tür zu wählen, ebenso gut. Dies führt auf den Ansatz

der Gleichverteilung von X1 und X2 . Ferner modellieren wir mit Unabhängigkeit, d.h. P (X1 =

i, X2 = j) = P (X1 = i)P (X2 = j).

Zur weiteren Bestimmung des W-maßes P benötigen wir einige Modellannahmen zum Verhalten

des Moderators. Die ’natürlichen’ Annahmen wären: Der Moderator kennt die Tür X1 mit dem

Auto und öffnet immer(!) eine nichtgewählte Tür mit Ziege dahinter. Falls er die Wahl zwischen

2 Türen hat, so wählt er zufällig mit Gleichverteilung eine der Türen, z.B. durch Münzwurf.

Damit sind alle W-keiten P (X3 = k | X1 = i, X2 = j) jetzt wohlbestimmt und das W-maß P

eindeutig gegeben,

P ((i, j, k)) = P (X1 = i)P (X2 = j | X1 = i)P (X3 = k | (X1 = i, X2 = j).

Zum Zeitpunkt der zweiten Wahl sind X2 und X3 bekannt. Der Einfachheit halber sei X2 = 1 und

X3 = 2, die anderen Fälle liefern aus Symmetriegründen das gleiche Resultat.

P (X1 = X2 | X2 = 1, X3 = 2)

=

=

=

P (X1 6= X2 | X2 = 1, X3 = 2)

P ((1, 1, 2))

P (X2 = 1, X3 = 2)

P (X1 = 1)P (X2 = 1 | X1 = 1)P (X3 = 2 | X1 = 1, X2 = 1)

P ((1, 1, 2)) + P ((2, 1, 2)) + P ((3, 1, 2))

111

332

111

332

+0+

11

3 31

=

1

3

= 1 − P (X1 = X2 | X2 = 1, X3 = 2) =

2

.

3

Der Kandidat sollte eindeutig seine Entscheidung ändern.

Wie ändern sich die Wahrscheinlichkeiten, wenn die Annahmen den Moderator betreffend nicht

zutreffen.

Annahme 1: Der Moderator kennt die Tür mit dem Auto dahinter und öffnet immer(!) eine

nichtgewählte Tür mit Ziege dahinter. Falls er die Wahl zwischen 2 Türen hat, so wählt er stets

diejenige mit der kleinsten Nummer mit einer Wahrscheinlichkeit p.

Annahme 2: Der Moderator kennt nicht die Tür mit dem Auto dahinter und öffnet zufällig eine

der verbleibenden Türen. Dahinter erscheint eine Ziege.

17

Uwe Rösler

SS98

1.3

Bedingte Wahrscheinlichkeit

Annahme 3: Der Moderator kennt die Tür mit dem Auto dahinter. Er gönnt dem Kandidaten nicht

das Auto. Der Moderator öffnet nur eine Tür, hinter der eine Ziege erscheint, wenn der Kandidat

zuerst die Tür mit Auto gewählt hatte. (Zonk)

Annahme 4: Der Knadidat wählt für X2 nicht die Gleichverteilung.

(Auflösung: In den Fällen 1 und 2 sollte der Kandidat wechseln. Im Fall 3 nicht. Argument? Die

Wahl von 4 ändert nichts an der Argumentation, solange....)

Bsp: Die drei Todeskandidaten:

Die Originalvorlage ist meines Wissens nach von Martin Gardner. Drei Gefangene sitzen in einer

Todeszelle. Genau einer der Kandidaten soll morgen hingerichtet werden. Keiner der Gefangenen

weiß, wer es ist. Der Gefangene A fragt den Wärter, wer morgen hingerichtet wird. Der Gefängniswärter,

der den Namen kennt, sagt stets die Wahrheit. Er antwortet: Ich darf den Namen nicht verraten.

”

Aber ich darf versichern, daß es nicht der Gefangene B ist.“Wie groß ist jetzt die W-keit, daß

morgen A hingerichtet wird? Tippen Sie auf 1/3 oder auf 1/2? Welche Argumente würden Sie

anführen?

Informationsbegriff: Es erhebt sich die grundsätzliche Frage, wieviel ’Information’ in der Antwort

des Wärters enthalten ist.

Noch weitergehend, durch geschickte Auswahl von objektiv richtiger Information kann der Wärter

die subjektiven W-keiten des Todeskanditen bewußt beeinflussen. Überlegen Sie sich mögliche

Auswirkungen und Informationsstrategien in Gerichtsprozessen oder den Einfluß gezielter (wahrer) Informationsweitergabe auf Aktienkurse.

1.3.2

Konstruktion von W-Räumen

1.3.3

Wahrscheinlichkeitsbäume

Alle obigen Beispiele haben das gleiche Bildungsschema via Wahrscheinlichkeitsbäumen bzw.

Familienbäumen.

Sei V = supn∈IN S n die Menge aller echten endlichen Folgen mit Werten in S, S endlich oder

abzählbar. (Konvention S 0 = {∅}.) Wir schreiben v = (v1 , v2 , . . . , vn ) oder einfacher v = v1 v2 . . . vn .

Wir verwenden einen familiennahen Sprachgebrauch, wie vi ist das i-te Kind von v und v das

Eltern von vi, vw ist ein Nachkomme von v und v ist ein Vorfahre von vw. Die Generation von v

entspricht der Länge |v| = n des Tupels. Die Einschränkung von v auf die ersten m−Generationen

ist v|m = v1 . . . vm .

Ein Element von V wird Knoten oder Individuum, im Englischen vertex, genannt. Ein Baum

ist eine nichtleere Teilmenge W von V, sodass jedes Individuum aus W auch alle seine Vorfahren

in W hat. Ein Element w ∈ W ohne Nachkommen in W heis̈t Blatt.

Ein Wahrscheinlichkeitsbaum ist ein Baum W versehen mit Kantengewichten p(w, wi) auf den

Kanten (w, wi) ∈ W 2 im Baum, mit

– p(w,

P wi) ≥ 0,

– wi∈W p(w, wi) = 1 falls w aus dem Baum und kein Blatt ist.

Definiere dazu die Pfadgewichte L : W → IR durch L(∅) = 1 und rekursiv

L(wi) = L(w)p(w, wi).

Diese heißen Pfadgewichte, da Pfade von der Wurzel ∅ nach w mit w identifiziert werden. L(w)

ist das Produkt der Kantengewichte längs des Pfades von der Wurzel nach w.

Proposition 1.3.4 Sei W ein Wahrscheinlichkeitsbaum. Die Menge Ω der Blätter (Namen) versehen

mit den W-keiten

P ({v}) = L(v)

P

und P (A) = v∈Ω L(v) bildet eine W-raum.

Bew: Es reicht zu zeigen P (Ω) = 0. Dies geschieht durch Induktion. (Übung).

q.e.d.

Ein Ereignisbaum ist ein Baum W versehen mit einem Ereignisvektor A : W → Ω, sodass gilt

– A(∅) = Ω,

S

– A(w) = ◦ wi∈W A(wi) falls w aus dem Baum und kein Blatt ist.

18

Elementare Wahrscheinlichkeitstheorie

Vorlesungsmitschrift

SS 2008

SS98

Uwe Rösler

Proposition 1.3.5 Jeder Ereignisbaum liefert einen W-baum, indem wir p(v, vi) = P (A(vi) |

A(v)) setzen. Es ergeben sich die Pfadgewichte L(v) = P (A(v)).

Umgekehrt, zu jedem W-baum können wir einen Ereignisbaum auf einem geeigneten W-raum

konstruieren.

Bew: Der erste Teil folgt durch nachrechnen.

Für den zweiten wähle als Stichprobenraum Ω alle Blätter des Baumes, als Ereignisraum A

die Potenzmenge und das W-mass eines Blattes w wird eindeutig durch das Pfadgewicht L(w)

bestimmt. Die Ereignisse A(w) sind die Menge der Blätter, die Nachfahre des Individuums w sind.

q.e.d.

Die Modellierung bzw. Konstruktion von W-bäumen geschieht von der Wurzel her via einem

Ereignisbaum und Bestimmung der bedingten W-keiten P (A(vi) | A(v)).

³

³³

³³

)³

³

0u

¡@

¡

@

ª

¡

Ru01

@

00 u

¢A

¢A

¢ A

¢ A

u

u

¢®

Uu

A

¢®

UAu

u

³³ PPP

PP

PP

qu1

¡@

¡

@

ª

¡

Ru11

@

10 u

¢A

¢A

¢ A

¢ A

u

¢®

AUu101 u

AUu

¢®

PP

Polya’s Urnenmodell: In einer Urne befinden sich S schwarze und W weiße Kugeln. Nach

jeder der k zufälligen Ziehungen werden c + 1 ∈ IN Kugeln der gleichen Farbe zurückgelegt. Der

Fall c = −1 entspricht einem Urnenmodell ohne Zurücklegen und c = 0 einem mit Zurücklegen.

(Meine mathematischen Bäume wachsen nach unten.)

Wir betrachten einen binären Baum der Tiefe k. An jeder Verzweigung steht der linke Ast für

das Ziehen einer weißen Kugel (0 für weiß), der rechte Ast für eine schwarze (1). Dies liefert die

Namen der Knoten. Der zugehörige Ereignisbaum ordnet jedem Namen v das Ereignis A(v) zu,

in der Reihenfolge v1 , v2 , . . . , v|v| weiße bzw. schwarze zu ziehen. Mathematisch modellieren wir

durch die Menge {0, 1}k der Blätter und setzen A(v) als die Menge der Blätter, die Nachfahre

von v sind. Dies ist der Ereignisbaum. Die Kantengewichte p(v, vi) = P (A(vi) | A(v)) erhalten

wir durch das Ziehen einer i-farbigen Kugel aus einer Urnen mit zur Vorgeschichte v entsprechend

P|v|

farbigen Kugeln (S + c i=1 (vi ) schwarze von S + W + c|v| Kugeln). Die Kantengewichte sind

bedingte W-keiten. Dies liefert den W-baum.

Proposition 1.3.6 Für das Polyasche Urnenmodell ist das W-maß P auf Ω := {0, 1}k gegeben

durch

Qs−1

Qk−s−1

(W + jc)

i=0 (S + ic)

j=0

.

P ({(ω1 , ω2 , . . . , ωk )}) =

Qk−1

l=0 (S + W + lc)

Pk

Hierbei ist s := i=1 ωi die Gesamtzahl der gezogenen schwarzen Kugeln. P (ω) ist permutationsinvariant.

Beweis: Sei die Realisierung (v1 , v2 , . . . , vk ). Definiere die Ereignisse Ai := {j1 } × {j2 } × . . . ×

{ji } × {0, 1} × . . . × {0, 1} ⊂ Ω durch Festlegen der ersten i Koordinaten. Die Wahrsch. von Ai+1 ,

gegeben

PiA1 , . . . , Ai entspricht der Wahrsch. aus einer Urne mit S + W + ic Kugeln, davon sind

S + c l=1 vl Kugeln schwarz, eine Kugel mit der Farbe vi+1 zu ziehen. In Formeln ausgedrückt

ergibt dies im Fall vi+1 = 1,

Pi

S + c l=1 vl

.

P (Ai+1 | A1 ∩ . . . ∩ Ai ) =

S + W + ic

Der Durchschnitt aller dieser Ereignisse enthält genau die gewählte Realisierung. Das Lemma 1.3.2

ergibt die Behauptung.

Die Modellkonstruktion des Ziegenproblems ist von Baumgestalt.

19

Uwe Rösler

SS98

1.3

Bedingte Wahrscheinlichkeit

Beispiel 1.3.7 (Ziegenproblem revisited) Der Baum W besteht aus allen Folgen der Zahlen

1, 2, 3 mit Länge höchstens 3. (Die leere Folge entspricht ∅.) Die Blätter sind die Folgen aus

W mit Länge 3. Der Stichprobenraum ist {1, 2, 3}3 . A(i) entspricht dem Ereignis hinter der iten Tür ist das Auto. A(i, j) entspricht dem Ereignis hinter der i-ten Tür ist das Auto und der

Kandidat wählt die j-te Tür. A(i, j, k) entspricht A(i, j) und zusätzlich öffnet der Moderator die

k-te Tür. Die Zuordnung der Wahrscheinlichkeiten geschieht nun von der Wurzel her. Jede der

Mengen A(i) erhält die W-keit 1/3. Gegeben A(i) erhält A(i, j) die W-keit 1/3. Für die W-keiten

P (A(i, j, k) | A(i, j)) haben wir eventuelle Freiheiten, wie in den Fallunterscheidungen angegeben.

Beispiel Duell: In einigen Spielen, gerade den neueren Spielen für Erwachsene, hat der technisch

beste Spieler die schlechtesten Chancen zu gewinnen. Drei Spieler A,B und C wollen sich mit

Pistolen duellieren. Es soll jeweils reihum ein Schuß in der zyklischen Reihenfolge A,B,C abgegeben

werden bei freier Zielwahl. Es wird solange geschossen, bis ein befriedigter Sieger feststeht (oder

nach 3 Runden beendet.)

Der schlechteste Schütze A trifft in rund 50% aller Fälle, der Spieler B hat Trefferquote von 80%

und Spieler C trifft immer. Spieler A beginnt. Die Spieler B und C versuchen stets den verbliebenen

Spieler mit der größten Trefferw-keit zu erschiessen.

Welche Strategie sollte A verwenden und wie sind die Überlebenswahrscheinlichkeiten der Duellanten.

(Erstelle einen W-baum mit den bedingten W-keiten als Übergangskerne. Was passiert, wenn das

Schlitzohr A als erstes in die Luft schießt?)

Die Idee der W-bäme läs̈t sich leicht auch für nichtendliche Bäume ausdehnen.

1.3.4

Produkträume

Ein weiteres Beispiel mit eigenständiger Bedeutung von W-keitsbäumen sind die Produkträume.

Produktraum: Seien (Ω1 , Pot(Ω1 ), P1 ), . . . , (Ωn , Pot(Ωn ), Pn ) diskrete W-Räume. Auf dem Produktraum Ω := Ω1 × Ω2 × . . . × Ωn definieren wir das Produktmaß P durch

P ({(ω1 , . . . , ωn )}) =

n

Y

i=1

Pi ({ωi }).

Der W-Raum (Ω, ¶(Ω), P ) heißt Produktraum, oder auch Produktwahrscheinlichkeitsraum.

. (Übung: Gebe einen zugehörigen W-baum und W-ereignisbaum an.)

Proposition 1.3.8 Für Ai ∈ Pot(Ωi , i = 1, . . . , n gilt

P (A1 × A2 × . . . × An ) =

Y

Pi (Ai ).

i

P

P

q.e.d.

Beweis: Beide Seiten sind gleich ω1 ∈A1 . . . ωn ∈An P1 ({ω1 }) . . . Pn ({ωn }).

Bsp: Wright-Fisher. DNS wird durch Vererbung weitergegeben. Gegeben sei eine feste Bevölkerungsgröße

von Individuen. Jedes Individuum der neuen Generation ’sucht’ sich ein Individuum aus der

vorhergehenden Generation als Eltern aus (und übernimmt dessen Meinung, DNS,...). Das WrightFisher modelliert durch Gleichverteilung (Sodom und Gomorrha) auf den Individuen der vorhergehenden

Generation. Frage, gibt es einen gemeinsamen ersten Vorfahren.

13j

12j j j j

j

11

10 8 9

14j

j

j

j

j

j

j

j

6 7 5 1 4 2 3

Mathem. Modell: Sei S die endliche Menge der Individuen und oEdA {1, . . . , N }. Sei F die

Menge der Funktionen von S in sich. Zu vorgegebener

Verteilung (Gleichverteilung im WrightQn

Fisher Modell) ν auf F sei (Ω = F n , P(F n ), i=1 ν) der Produktraum und Xi sei die i-te

20

Elementare Wahrscheinlichkeitstheorie

Vorlesungsmitschrift

SS 2008

SS98

Uwe Rösler

Projektion. (Wir betrachten maximal n Generationen rückwärts.) Das Hauptobjekt ist der Prozess

Yi = Xi ◦ Xi−1 . . . X1 . (Formal definiert als Abbildung ω 7→= (Xi (ω))((Xi−1 (ω))(. . .)(X1 (ω)) . . .))

und unterdrücke in der Schreibweise das ω ∈ Ω.) Für festes s hat (Yi (s))i , 1 ≤≤ n (formal

definiert als Abbildung ω 7→ (Yi (ω))(s) ∈ S und dann das ω unterdrückt) die Interpretation

als i-ter Ahne von s aus der jetzigen Generation. (Mathematisch heißt die Folge Yn ein iteriertes

Funktionensystem, IFS.)

Im Wright-Fisher Modell haben alle Individuen, falls wir weit genug in die Vergangenheit blicken

können, einen ersten gemeinsamen Vorfahren. Auf DNS bezogen, sind alle Kopien voneinander.

Interessant wird das Modell durch die Erweiterung, wobei von dem Eltern die DNS mit zufälligen

Änderungen (=Mutationen) übernommen werden. Falls wir die Anzahl der Änderungen schätzen

können, lassen sich Fragestellungen nach Verwandtschaftsgraden und Stammbäumen von verschiedenen

Arten beantworten.

Übergangskerne*

Die zugrundeliegende Idee der W-bäume und auch der Produkträume sind Übergangskerne. Wir

wollen dies formalisieren.

Seien Ω, Ω0 zwei endliche oder abzählbare Mengen. Ein Übergangskern K, oder auch Wahrscheinlichkeitskern von Ω nach Ω0 ist eine Abbildung K : Ω × P(⊗0 ) 7→ IR+ , mit K(ω, ·) ist ein W-maß

auf Ω0 für alle ω ∈ Ω.

Das Standardbeispiel eines Übergangskerns ist zweimaliges Würfeln. Sei Ω = Ω0 = {1, 2, . . . , 6}

und K(i, {j}) die bedingte

P Wahrscheinlichkeit, daß der zweite Wurf zeigt j gegeben der erste Wurf

zeigt i. Mit K(i, A0 ) = j∈A0 K(i, {j}) erhalten wir einen Übergangskern.

Übergangskerne spielen bei der Konstruktion von W-Räumen die Rolle von bedingten Wahrscheinlichkeiten.

Sei (Ω1 , Pot(Ω1 ), P1 ) ein diskreter W-raum und K ein Übergangskern von Ω1 nach Ω2 versehen

mit der Potenzmenge. Auf dem Stichprobenraum Ω = Ω1 × Ω2 versehen mit der Potenzmenge als

Ereignisraum definieren wir das W-mas̈ P durch

= P1 ({ω1 })K(ω1 , {ω2 })

X

P ({a}).

P (A) =

P ({(ω1 , ω2 )})

a∈A

(Übung: P ist ein W-mas̈.)

Diese Konstruktion läs̈t sich durch weitere Übergangskerne erweitern.

Proposition 1.3.9 Gegeben seien endliche oder abzählbare Mengen Ω1 , . . . , Ωn ein W-maß P1

auf Ω1 und Übergangskerne

i−1

Y

Ωj ) × Ωi → IR

Ki : (

j=1

für 2 ≤ i ≤ n. Dann ist Ω =

Qn

i=1

Ωi versehen mit

P ({(ω1 , . . . , ωn }) = P1 ({ω1 })

n

Y

i=2

K((ω1 , . . . , ωi−1 ), {ωi })

ein W-raum.

Qi

Bew: Konstruiere rekursiv Pi auf j=1 Ωj durch Pi−1 und den Übergangskern Ki .

(Übung: Modelliere Polyas Urnenmodell durch Übergangskerne.)

1.3.5

Markoffketten

Sei S endlich oder abzählbar.

21

q.e.d.

Uwe Rösler

SS98

1.3

Bedingte Wahrscheinlichkeit

Definition 1.3.10 Eine stochastische Matrix auf S ist eine Matrix P = (pi,j )i,j∈S mit positiven

Einträgen und die Summe jeder Zeile ist 1,

X

pi,j = 1

j∈S

für alle i ∈ S.

Eine stochastische Matrix liefert einen Übergangskern via

K(i, {j}) = pi,j

und umgekehrt.

Zu vorgegebenem W-maß µ auf S definiere ein W-maß Pµ auf dem Stichprobenraum S N durch

Pµ ((i1 , i2 , . . . , iN )) = µ({i1 })pi1 ,i2 pi2 ,i3 . . . piN −1 ,iN .

P

(Dies liefert mit P (A) = i∈A P ({i}) ein W-maß.) Sei Xn : S N → S die n-te Projektion.

Not: X = i ist eine Kurzschreibweise für die Menge X −1 (i) = {ω | X(ω) = i}. Die Trennung durch

Kommata steht für den Durchschnitt bzw. ein logisches und bei der Interpretation als Aussagen.

Proposition 1.3.11 Im obigen Modell gilt

P (X1 = i1 , X2 = i2 , . . . , Xn = in ) = µ({i1 })pi1 ,i2 pi2 ,i3 . . . pin−1 ,in

P (Xn = i, Xn+1 = j) = P (Xn = i)pi,j

P (Xn+1 = j | Xn = i) = pi,j

Bew:

P (X1 = i1 , X2 = i2 , . . . , Xn = in )

=

X

P (X1 = i1 , X2 = i2 , . . . , Xn = in , Xn+1 = in+1 . . . XN = iN )

in+1 ,...,iN ∈S

=

X

in+1 ,...,iN ∈S

=

µ({i1 })

µ({i1 })

X

µ({i1 })

X

µ({i1 })

in+1 ,...,iN −1 ∈S

=

in+1 ,...,iN −2 ∈S

...

= µ(i1 )

n−1

Y

pij ,ij+1

j=2

X

in+1 ,...,iN −1 ∈S

=

N

−1

Y

N

−2

Y

pij ,ij+1 )(

j=2

N

−2

Y

X

iN ∈S

piN −1 ,iN )

pij ,ij+1

j=2

N

−3

Y

pij ,ij+1

j=2

pij ,ij+1

j=2

P (Xn = in , Xn+1 = in+1 )

=

X

P (X1 = i1 , X2 = i2 , . . . , Xn = in , Xn+1 = in+1 )

i1 ,...,in−1 ∈S

=

X

i1 ,...,in−1 ∈S

=

pin ,in+1

µ({i1 })

X

i1 ,...,in−1 ∈S

=

P (Xn+1 = j | Xn = i)

=

n

Y

pij ,ij+1

j=2

µ({i1 })

n−1

Y

j=2

pin ,in+1 P (Xn = in )

P (Xn+1 = j, Xn = i)

= pi,j .

P (Xn = i)

22

pij ,ij+1

Elementare Wahrscheinlichkeitstheorie

Vorlesungsmitschrift

SS 2008

SS98

Uwe Rösler

q.e.d.

Definition 1.3.12 Eine Markoffkette mit Zustandsraum S ist eine Folge von Funktionen Xn :

Ω → S, n ≤ N auf einem W-raum mit der Markoffeigenschaft

P (Xn+1 = j | Xn = i) = P (Xn+1 = j | Xn = i, Xn−1 = in−1 , . . . , X1 = i1 )

für alle n < N, i, j, i1 , . . . , in−1 ∈ S.

Der obige Prozess zu vorgegebener stochastischer Matrix P und Anfangsverteilung µ ist eine

Markoffkette. Umgekehrt, ist X = (Xn )n eine Markoffkette, so können wir die stochastische Matrix

pi,j = P (Xn+1 = j | Xn = i) und das Anfangsmaß µ({i}) = P (X1 = i) wiedergewinnen.

(Eventuell muß die erhaltene Matrix ergänzt werden.) Gilt Ω = S N , so sprechen wir von dem

kanonischen W-raum.

Eine stochastische Matrix wird gerne als ein gewichteter Graph (V, E) dargestellt. Dabei sind

die Knoten die Zustände (V = S) und die Kanten sind diejenigen Tupel (i, j) mit pi,j > 0. Ein

Markoffgraph ist der obige Graph mit den Kantengewichten E 3 (i, j) 7→ pi,j . Bildlich malen

wir einen Pfeil von i nach j und schreiben den Wert pi,j daran.

Bsp: Markoffgraph. S = {1, 2, 3, 4} mit

1/2 1/2

0

0

¾» ¾» ¾» ¾»

1/2 1/2

0

0

P =

0

1/4 1/2 1/4

6

6

6

6

u¾

u¾

u

u

½¼

½¼

½¼

½¼

0

0

0

1

Bsp: Peter und Paul. Peter und Paul werfen die Münze. Der Gewinner bekommt eine Einheit

von dem anderen. Jeder fängt mit einem Startkapital an und darf solange spielen, bis er pleite ist

oder N Teilspiele gespielt sind.

Mathem. Modell: Sei x0 das Anfangskapital von Paul und K das Gesamtkapital beider. Wir

modellieren das Kapital Xn von Paul nach dem n-ten Spiel durch eine Markoffkette zu der

stochastischen Matrix pi,i+1 = 1/2 = pi,i−1 für i = 1, . . . , K − 1 und p0,0 = 1 = pK,K . Das

Anfangsmaß ist das Punktmaß δx0 , δx0 (A) = 11x0 ∈A auf x0 .

(Übung: Wie sieht der Graph der Markoffkette aus?)

Bsp: Polyas Urnenmodell. Um Polyas Urnenmodell als Markoffkette zu simulieren, setzen wir

+S+sc

S = ∪ki=1 {0, 1}i als Stichprobenraum, µ({0}) = WW+S = 1 − µ({1}), px,x1 = WW+S+|x|c

mit |x| < k

P|

die Länge von x und s = i=1 x|xi und px,x = 1 für |x| = k.

(Übung: Wie sieht der Graph der Markoffkette aus.)

Bsp: Wright-Fisher. Im Wright-Fisher Modell ist die Ahnenreihe Yn (s) eine Markoffkette. Der

Zustandsraum ist S und die Übergangsmatrix ist

pi,j = P ({ω | (X(ω))(i) = j}) = ν({f ∈ F | f (i) = j}).

23

Uwe Rösler

1.4

1.4.1

SS98

1.4

Diverses

Diverses

Die Einschluß-Auschluß Formel

Satz 1.4.1 (Einschluß-Ausschluß Formel) Seien Ai , i ∈ I, endlich viele Ereignisse. Es gilt

die Einschluß-Ausschluß Formel

\

X

[

(1.1)

(−1)1+|J| P ( Ai ).

P ( Ai ) =

i∈J

J⊂I

i∈I

Beweis: Wir führen einen Induktionsbeweis nach der Anzahl n der Elemente in der Indexmenge

I. Die Aussage gilt für n = 1 und für n = 2,

P (A1 ∪ A2 ) = P (A1 ) + P (A2 ) − P (A1 ∩ A2 ).

Im Induktionsschritt zeigen wir die Aussage für n + 1, vorausgesetzt für n ist die Aussage richtig.

n+1

[

P(

Ai ) = P (

n

[

i=1

i=1

=

Ai ) + P (An+1 ) − P ((

X

i=1

(−1)1+|J| P (

X

\

Ai ) ∩ An+1 )

Aj ) + P (An+1 ) −

j∈J

J⊂{1,...,n}

=

n

[

(−1)1+|K| P (

\

X

J⊂{1,...,n}

(−1)1+|J| P (

\

j∈J

(Aj ∩ An+1 ))

Ak ).

k∈K

K⊂{1,...,n+1}

Die letzte Summe wird aufgeteilt in die drei Summen über diejenigen K mit K ⊂ {1, . . . , n}, mit

K = {n + 1} und K enthält {n + 1} ist aber ungleich.

T

Bemerkung In vielen Anwendungen ist P ( i∈J Ai ) nur von der Mächtigkeit |J| von J abhängig.

Die Einschluß-Ausschluß Formel vereinfacht sich zu

µ ¶

n

n

[

X

n

P ( Ai ) =

(−1)1+k

ak

(1.2)

k

i=1

k=1

Tk

mit ak := P ( i=1 Ai ).

Beispiel

Tanzparty: Bei einer Tanzparty mit n Ehepaaren werden die Tanzpartnerinnen zufällig zugelost.

Mit welcher Wahrsch. werden zwei Ehepartner zusammengelost?

Wenn wir die Ehepaare numerieren, so ist eine Auslosung eine zufällige Permutation π der Zahlen

1 bis N, der Herr k tanzt mit der Dame π(k). Der Stichprobenraum der Permutationen ist

ein Laplaceraum, alle Permutationen sind gleichwahrsch. Gefragt ist nach der Wahrsch. eine

Permutation π mit einem Fixpunkt π(x) = x zu wählen.

Die Ereignisse Ak , der Herr k tanzt mit Dame k, sind die Permutationen π auf I := {1, 2, . . . , N }

mit Fixpunkt k. Insgesamt gibt es (n! verschiedene Permutationen. Die Wahrsch. der Permutationen

mit vorgeschrieben Fixpunkten J ⊂ I ist

P(

\

Aj ) =

j∈J

(n − |J|)!

.

n!

Die Einschluß-Ausschluß Formel liefert

P(

[

i∈I

Ai ) =

n

X

(−1)1+k

k=1

24

k!

.

Elementare Wahrscheinlichkeitstheorie

Vorlesungsmitschrift

SS 2008

SS98

Uwe Rösler

Die Wahrsch. der Auslosung einer Tanzpaarung, in der kein Ehepaar miteinander tanzt ist

P(

\

Aci )

i∈I

= 1 − P(

[

i∈I

Im Grenzwert n → ∞, beachte e−x =

gegen den Wert 1e echt größer Null.

P∞

xn

n=0 n! ,

Ai ) = 1 −

n

X

(−1)1+k

k!

k=1

.

strebt diese Wahrscheinlichkeit (überraschenderweise)

Es gibt viele Varianten der obigen Problemstellung. Zum Beispiel zur Weihnachtsfeier bringt jeder

Teilnehmer ein Geschenk mit, das später unter den Teilnehmern ausgelost wird. Die ursprüngliche

Problemstellung von de Montmort (1713) behandelt die Zulosung von n Karten zu n Spielern.

Lemma 1.4.2 (Bonferoni Ungleichung) Seien An , n ∈ IN Ereignisse. Es gilt

X

X

X

P (An ) −

P (Am ∩ An ) ≤ P (∪n An ) ≤

P (An ).

n

m<n

n

Allgemeiner, für 1 ≤ k ≤ n

[

(−1)k (P ( An ) −

n

X

(−1)1+|J| P (

\

j∈J

J⊂I, |J|≤k

Aj )) ≤ 0.

Beweis:

Betrachte

Bn := An \(A1 ∩ . . . ∩ An−1 ). Die Ereignisse Bn sind paarweise disjunkt,

S

S

i≤n Ai = ◦ i≤n Bi und Bn ⊂ An . Damit

[

[

X

P ( An ) = P ( ◦ Bn ) =

P (Bn ).

n

n

n

Die zweite Ungleichung in der ersten Zeile folgt aus der Monotonie P (Bn ) ≤ P (An ). Für die erste

argumentiere

n−1

[

P (Bn ) = P (An ) − P (

i=1

(Ai ∩ An )) ≤ P (An ) −

n−1

X

i=1

P (Ai ∩ An ).

q.e.d.

Bemerkung 1.4.3 Obige Bonferoni-Ungleichung ist nur der einfachste Fall der allgemeineren

Ungleichung

\

X

[

Aj )) ≤ 0

(−1)1+|J| P (

(−1)k (P ( An ) −

n

J⊂I, |J|≤k

j∈J

für 1 ≤ k ≤ n.

1.4.2

Besondere Aufgaben

In einem Duell ist die Wahl der Waffen vorteilhaft. In vielen Spielsituationen ist die erste Wahl

oder der erste Zug vorteilhaft. Dies ist nicht immer so.

Beispiel

Der Beste: Auf dem Tisch liegen drei Würfel, beschriftet mit den Zahlen (6, 6, 3, 3, 3, 3), (5, 5, 5, 2, 2, 2)

und (4, 4, 4, 4, 4, 1). Spieler A läs̈t Spieler B die erste Wahl eines Würfels und wählt anschlies̈end

einen verbleibenden. Dann wird gewürfelt und der Spieler mit der höheren Augenzahl gewinnt.

Wer ist im Vorteil? Welche Seite nehmen Sie, A oder B.?

Auflösung: Im direkten Vergleich gewinnt der erste Würfel gegen den zweiten mit Wahrsch. 24/36,

der zweite gegen den dritten mit Wahrsch. 21/36 und der dritte gegen den ersten mit Wahrsch.

20/36. Es ist ein Nachteil als Erster einen Würfel zu wählen. In diesem Beispiel gibt es keinen

absolut besten Würfel.

25

Uwe Rösler

1.5

SS98

1.5

Konzept: Unabhängigkeit

Konzept: Unabhängigkeit

Der Konzept der stochastischen Unabhängigkeit ist ein ganz wesentlicher Bestandteil der Stochastik.

Dieses Konzept ermöglicht erst in seinen Konsequenzen den Aufbau einer Wahrscheinlichkeitstheorie.

Geschichtlich gesehen wurde eine präzise mathematische Formulierung der Unabhängigkeit recht

spät gegeben, erst im 20-ten Jahrhundert.

Heuristik: Zwei Ereignisse A, B sind unabhängig, falls die Wahrsch. für das Eintreten von A

nicht von der Kenntnis des Eintretens oder Nichteintretens des Ereignisses B abhängt. Diese

Überlegung führt auf den Ansatz P (A | B) = P (A) bzw. P (B | A) = P (B).

Definition 1.5.1 (unabhängig) Zwei Ereignisse A und B heißen paarweise unabhängig , falls

die W-keit für den Eintritt beider gleich dem Produkt der Einzelw-keiten ist,

P (A ∩ B) = P (A)P (B).

Sind A und B unabhängig, so auch B, A und A, B c usw. Gilt P (A), P (B) > 0, so sind A, B

unabhängig genau dann, wenn die Wahrsch. von A bedingt auf B gleich der Wahrsch. von A

selbst ist.

Bsp: Gefälschte Münze. Wir werfen zweimal mit einer eventuell gefälschten Münze. Sei p ∈

(0, 1) die W-keit für Kopf, identifiziert mit der 1. Wir betrachten die Ereignisse A, der erste Wurf

zeigt ’Kopf’ und B, genau ein ’Kopf’ erscheint. Dies Experiment modellieren wir durch Ω := {0, 1}2

mit dem W-maß P ({(i, j)}) = pi+j q 2−i−j . Die Koordinatenabbildungen Xi : Ω → {0, 1} geben

das Ergebnis im i-ten Wurf an. Die Ergebnisse des ersten Wurfes und des zweiten Wurfes sind

unabhängig,

P (X1 = i, X2 = j) = P (X1 = i)P (X2 = j).

Die Ereignisse A := {X1 = 1} = {(1, 0), (1, 1)} und B := {X1 + X2 = 1} = {(0, 1), (1, 0)} haben

die W-keiten P (A) = p, P (B) = P ({(0, 1)}) + P ({(1, 0)}) = 2p(1 − p), P (A ∩ B) = p(1 − p). Die

beiden Ereignisse A, B sind genau dann paarweise unabhängig, falls p = 1/2 gilt.

Jetzt zur allgemeinen formalen Definition der Unabhängigkeit.

Definition 1.5.2 (unabhängig) Eine Familie Ai ∈ A, i ∈ I, von Ereignissen zu beliebiger

Indexmenge I heißt (stochastisch) unabhängig, falls für jede endliche Auswahl von Ereignissen

die W-keit des Durchschnitts gleich dem Produkt der Wahrsch. ist,

Y

\

P (Aj ).

Aj ) =

∀J ⊂ I, |J| < ∞

P(

j∈J

j∈J

Eine Familie Ai ⊂ A, i ∈ I, von Untermengen der Ereignismenge zu beliebiger Indexmenge I heißt

unabhängig , falls jedes Repräsentantensystem Ai ∈ Ai , i ∈ I, eine Familie von unabhängigen

Ereignissen bildet.

Die drei Definitionen sind in aufsteigender Reihenfolge der Allgemeinheit, die dritte enthält die

zweite und diese die erste als Spezialfall.

Lemma 1.5.3 Die Ereignisse Ai , i ∈ I, sind genau dann unabhängig wenn die Mengensysteme

{∅, Ai , Aci , Ω}, i ∈ I, unabhängig sind.

Seien die Mengensysteme Ai ⊂ A, i ∈ I, stochastisch unabhängig. Sind IkS, k ∈ K, paarweise

disjunkte Teilmengen der Indexmenge I, so sind die Mengensysteme Bk := i∈Ik Ai , k ∈ K der

Vereiningung unabhängig.

Bew: Die Rückrichtung der ersten Aussage ist einfach. Für die Hinrichtung beschränken wir uns

oEdA auf endliche Indexmenge I. Wir werden zeigen: Sind die Ereignisse Ai , i ∈ I unabhängig, so

auch Aci0 , Ai , i ∈ I\{i0 } für jedes i0 ∈ I.

26

Elementare Wahrscheinlichkeitstheorie