Forschungspraktikum Gruppenbezogene Menschenfeindlichkeit

Werbung

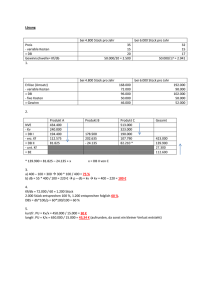

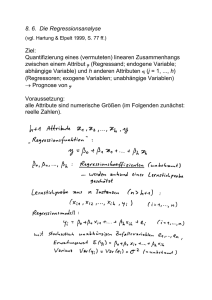

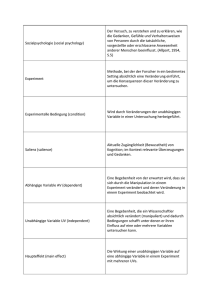

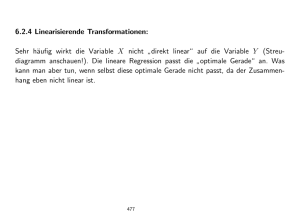

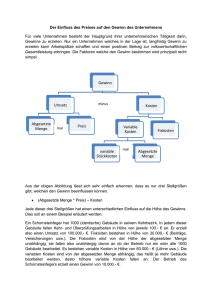

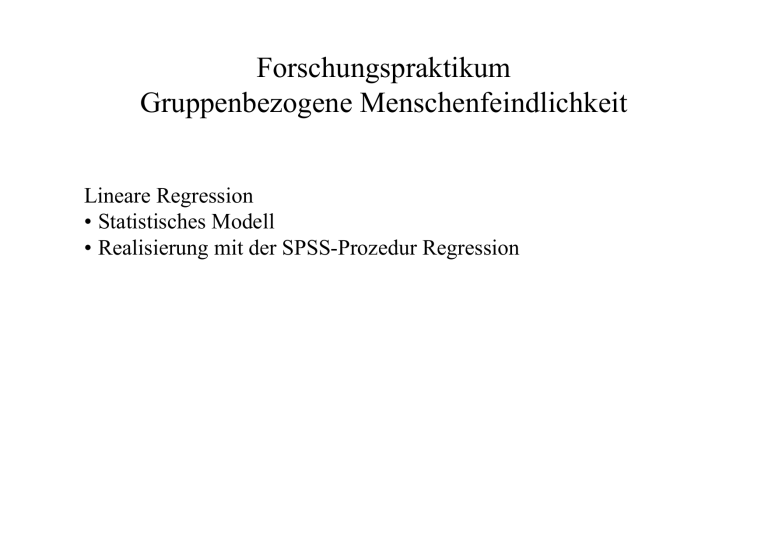

Forschungspraktikum Gruppenbezogene Menschenfeindlichkeit Lineare Regression • Statistisches Modell • Realisierung mit der SPSS-Prozedur Regression Lineare Regression Statistische Zusammenhangsanalyse Um zu untersuchen, ob eine erklärende Variable X Einfluss auf eine abhängige Variable Y hat, wird die gemeinsame Verteilung der beiden Variablen untersucht. Aus der Definition statistischer Unabhängigkeit zweier Ereignisse folgt, dass zwischen zwei Variablen ein statistischer Zusammenhang besteht, wenn sich die bedingten Verteilungen der abhängigen Variablen Y bei verschiedenen Ausprägungen der erklärenden Variablen X voneinander unterscheiden. Um dies zu prüfen, wird in einer Kreuztabellen die bivariate Verteilung von X und Y berechnet. Als Beispiel soll aus den Trenddaten des GMF der Mittelwert über die Items zur Erfassung von Fremdenfeindlicheit durch die Links-Rechts-Selbsteinstufung erklärt werden. GET FILE='C:\... \trend.sav'. compute FFmean=mean.1(ff03d to ff08d). var lab FFmean 'Fremdenfeindlichkeit mean.1(ff03,ff04,ff05,ff08)'. cross FFmean by po01. Forschungspraktikum GMF 1 Statistische Zusammenhangsanalyse FFmean Fremdenfeindlichkeit. mean.1(ff03,ff04,ff05,ff08) * po01 Politische Einstellung Kreuztabelle Anzahl FFmean (Y) 1.00 Fremdenfeindlichkeit. 1.25 mean.1(ff03,ff04,ff05,ff08) 1.33 1.50 1.67 1.75 2.00 2.25 2.33 2.50 2.67 2.75 3.00 3.25 3.33 3.50 3.67 3.75 4.00 Gesamt 1 links 35 12 0 35 1 13 68 35 6 64 8 71 146 65 7 99 2 57 166 890 po01 Politische Einstellung (X) 3 genau in 2 eher links 4 eher rechts der Mitte 59 416 117 26 143 44 2 19 4 74 482 107 4 33 7 58 278 70 186 727 181 159 540 126 12 52 6 318 957 191 15 52 8 286 653 93 635 1168 117 270 372 44 17 26 1 330 400 45 9 16 4 170 164 11 331 316 28 2961 6814 1204 5 rechts 59 14 1 36 2 24 36 21 0 38 1 5 29 4 0 8 2 2 8 290 Gesamt 686 239 26 734 47 443 1198 881 76 1568 84 1108 2095 755 51 882 33 404 849 12159 Zur Interpretation müssen allerdings die relativen Häufigkeiten bzw. Prozentwerte der abhängigen Variable (allgemein meist als Y bezeichnet) bei unterschiedlichen Ausprägungen der erklärenden Variablen (X) verglichen werden: cross FFmean by po01 /cells col. Forschungspraktikum GMF 2 Statistische Zusammenhangsanalyse FFmean Fremdenfeindlichkeit. mean.1(ff03,ff04,ff05,ff08) * po01 Politische Einstellung Kreuztabelle % von po01 Politische Einstellung FFmean (Y) 1.00 Fremdenfeindlichkeit. 1.25 mean.1(ff03,ff04,ff05,ff08) 1.33 1.50 1.67 1.75 2.00 2.25 2.33 2.50 2.67 2.75 3.00 3.25 3.33 3.50 3.67 3.75 4.00 Gesamt 1 links 3.9% 1.3% 3.9% .1% 1.5% 7.6% 3.9% .7% 7.2% .9% 8.0% 16.4% 7.3% .8% 11.1% .2% 6.4% 18.7% 100.0% po01 Politische Einstellung (X) 3 genau in der Mitte 2 eher links 4 eher rechts 2.0% 6.1% 9.7% .9% 2.1% 3.7% .1% .3% .3% 2.5% 7.1% 8.9% .1% .5% .6% 2.0% 4.1% 5.8% 6.3% 10.7% 15.0% 5.4% 7.9% 10.5% .4% .8% .5% 10.7% 14.0% 15.9% .5% .8% .7% 9.7% 9.6% 7.7% 21.4% 17.1% 9.7% 9.1% 5.5% 3.7% .6% .4% .1% 11.1% 5.9% 3.7% .3% .2% .3% 5.7% 2.4% .9% 11.2% 4.6% 2.3% 100.0% 100.0% 100.0% 5 rechts 20.3% 4.8% .3% 12.4% .7% 8.3% 12.4% 7.2% 13.1% .3% 1.7% 10.0% 1.4% 2.8% .7% .7% 2.8% 100.0% Gesamt 5.6% 2.0% .2% 6.0% .4% 3.6% 9.9% 7.2% .6% 12.9% .7% 9.1% 17.2% 6.2% .4% 7.3% .3% 3.3% 7.0% 100.0% Wenn sich die relativen Häufigkeiten einer Ausprägung der abhängigen Variablen bei verschiedenen Ausprägungen der erklärenden Variable unterscheiden, spricht dies für einen Zusammenhang. Haben die Variablen sehr viele Ausprägungen, sind die resultierenden Tabellen allerdimgs sehr unübersichtlicht und aufgrund zu geringer Fallzahlen in den einzelnen Tabellenzellen kaum zu interpretieren. Forschungspraktikum GMF 3 Berechnung bedingter Mittelwerte: SPSS-Prozedur Means Bei einer metrischen abhängigen Variablen werden daher nur die bedingten Mittelwerte (bzw. bedingten Erwartungswerte) der abhängigen Variable über die Werte der erklärenden Variablen verglichen. In SPSS können die bedingten Mittelwerte mit der SPSS-Prozedur "Means" berechnet werden, die formal wie die Prozedur crosstabs aufgebaut ist: MEANS varlist BY varlist evtl. BY varlist ... /varlist ... /MISSING= INCLUDE oder DEPENDENT /CELLS= MEAN COUNT STDDEV DEFAULT ALL NONE SEMEAN SUM MIN MAX RANGE VARIANCE MEDIAN GMEDIAN KURT SEKURT SKEW SESKEW FIRST LAST NPCT SPCT NPCT(var) SPCT(var) HARMONIC GEOMETRIC /STATISTICS=ANOVA ALL Wie bei der Prozedur "crosstabs" werden zunächst die Dimensionen von mehrdimensionalen Kreuzztabellen definiert, wobei vor dem ersten "BY" die abhängigen Variablen, hinter dem ersten "BY" die unabhängigen Variablen und nach jeweils weiteren "BY" Kontrollvariablen definiert werden. Standardmäßig werden Fälle mit ungültigen Werten bei einer Variablen ausgeschlossen. Mit der Option "/mis inc" werden benutzerdefinierte ungültige Werte als gültig in die Berechnungen aufgenommen bei "/mis dep" werden nur die benutzerdefinierten ungültigen Werte der erklärenden Variablen als gültig betrachtet. Forschungspraktikum GMF 4 Berechnung bedingter Mittelwerte: SPSS-Prozedur Means Anstelle von Häufigkeiten werden für jede Zelle der definierten multivariaten Kreuztabellen Statistiken berechnet und ausgedruckt. Welche Statistiken berechnet werden, wird durch die Option "/cells=" defniert: /CELLS=COUNT MEAN STDDEV DEFAULT ALL NONE SEMEAN SUM MIN MAX RANGE VARIANCE MEDIAN GMEDIAN KURT SEKURT SKEW SESKEW NPCT SPCT NPCT(var) SPCT(var) HARMONIC GEOMETRIC Ohne die Option "/cells" werden die Defaults-Statistiken Fallzahl jeder Zelle ("count"), Mittelwert ("mean") und Standardabweichung ("stddev") ausgegeben, ansonsten nur die hinter der Option angeforderten Statistiken. Neben den genannten Parametern steht "semean" für den Standardfehler des Mittelwertes bei einfacher Zufallsauswahl, "sum" für die Summe über alle Fälle, "min", "max" und "range" für kleinsten bzw. größten Wert und Spannweite, "variance", "median" und "gmedian" für Varianz, median und gruppierten Median (berechnet über Summenkurve), "kurt", "sekurt", "skew", "seskew" für Steilheit bzw, Schiefe und deren Standardfehler, "npct" und "spct" für den Prozentwert der Fälle bzw. der summierten Werte an der gesammten Fallzahl bzw. Summe und bei einer nachfolgenden Variablennennung in Klammern bezogen auf diese Variable, wobei die Variable als erklärende bzw. Kontrollvariable aufgeführt sein muss. Mit der Option "/stat anova oder all" können univariate Varinanzanalysen (mit Linearitätsprüfung beim Schlüsselwort "all" angefordert werden, wobei die Variablen nach dem ersten "by" als Faktoren dienen. Forschungspraktikum GMF 5 Berechnung bedingter Mittelwerte: SPSS-Prozedur Means Werden die Mittelwerte von FFmean für die gültigen Ausprägungen der Links-RechtsSelbsteinstufung berechnet, ergibt sich folgendes Bild: means FFmean by po01 /cells mean. Bericht Mittelwert 1 links FFmean Fremdenfe indlichkeit. mean. 1(ff03,ff04,f f05,ff08) 2.9623 2 eher links 2.9319 po01 Politische Einstellung 3 genau in der Mitte 4 eher rechts 2.5153 2.2499 5 rechts 2.0092 Insgesamt 2.6111 Im Beispiel zeigt sich, dass der Mittelwert der vier Items um so geringer wird, je weiter rechts sich eine Person einordnet. Die bedingten Mittelwerte können mathematisch als eine Funktion der erklärenden Variablen aufgefasst werden. Diese Funktion heißt Regressionsfunktion. Von einer linearen Regression spricht man, wenn die Regressionsfunktion in der Population eine Gerade ist. Forschungspraktikum GMF 6 Regressionsfunktion FFmean Lineare Regressionskurve Empirische Regressionskurve 4.0 4.0 3.0 3.0 2.0 2.0 1.0 1.0 0.0 0.0 1 2 3 4 5 1 Links-Rechts 2 3 4 5 Links-Rechts Die empirische Regressionskurve der bedingten Stichprobenmittelwerte ist eine Schätzung der nicht beobachtbaren Regressionsfunktion in der Population. Es ist sehr unwahrscheinlich, dass die empirische Regressionsfunktion tatsächlich eine Gerade ergibt. Abweichungen von einer Regressionsgeraden können jedoch auch Folge von Stichprobenfehlern sein. Dann kann versucht werdne, eine unterstellte Regressionserade aus den Stichprobendaten zu schätzen. Forschungspraktikum GMF 7 Das lineare Regressionsmodell 4.0 β1 FFmean 3.0 2.0 2·β1 3·β1 4·β1 Wenn sich zwei Werte der erklärenden Variable um +1 Einheit unterscheiden, dann unterscheiden sich die bedingten Erwartungswerte um den Wert β1. 5·β1 β0 Bei einer kausalen Interpretation wird davon ausgegangen, dass die Veränderung in X um +1 Einheit, eine Veränderung des Mittelwerts der abhängigen Variablen Y um β1 bewirkt. 1.0 0.0 0 1 2 3 4 5 6 Links-Rechts Eine Regressionsgrade lässt sich algebraisch durch eine einfache Funktion beschreiben: μ Y X = β0 + β1 ⋅ x Die Lage der Regressionsgerade wird durch die beiden Regressionskoeffizienten β0 und β1 bestimmt. Die Regressionskonstante β0 gibt den bedingten Erwartungswert wieder, wenn die erklärende Variable den Wert 0 aufweist. Das Regressionsgewicht β1 gibt die Steigung der Regressionsgerade an. Forschungspraktikum GMF 8 Das lineare Regressionsmodell 4.0 FFmean 3.0 2.0 1.0 0.0 0 1 2 3 4 5 6 Links-Rechts Da Populationsdaten in ihrer Gesamtheit nicht verfügbar sind, werden die Regressionkoeffizienten β0 und β1 aus Stichprobendaten geschätzt: μˆ = βˆ + βˆ ⋅ X YX 0 1 Ŷ = bo + b1 ⋅ X Für die Schätzung der Regressionskoeffizienten benötigt man • empirische (Stichproben-) Daten, auf die das Modell angewendet werden kann • und eine geeignete Schätzmethode zur Bestimmung der Regressionskoeffizienten. Forschungspraktikum GMF 9 OLS-Schätzung der Regressionskoeffizienten Die klassische Methode zur Bestimmung der Regressionskoeffizienten ist die (ungewichtete) Kleinstquadratmethode (engl: ordinary least squares, OLS). Bei der OLS-Schätzung werden die Regressionskoeffizienten so bestimmt, dass die Summe der quadrierten Differenzen der empirischen Realisierungen von der geschätzten Regressionsfunktion minimal ist: n n n QOLS ( b 0 , b1 ) = ∑ ( yi − ( b 0 + b1 ⋅ x i ) ) = ∑ ( yi − yˆ i ) = ∑ e = min 2 i =1 i =1 7 6 Ŷ=1+1⋅X 5 4 3 ei = yi –(1+1·xi) 2 1 0 0 1 2 3 2 4 5 X 1 2 2 2.5 3 3 3.5 4 4 6 5 ∑ 30 i =1 2 i ! Y Ŷ = 1 + 1 ⋅ X 2 2 1 3 5 3 1 3.5 2 4 6 4 7 4.5 3 5 7 5 6 6 40 40 Forschungspraktikum GMF E 0 –2 2 –2.5 –2 2 2.5 –2 2 0 0 E2 0 4 4 6.25 4 4 6.25 4 4 0 36.5 10 OLS-Schätzung der Regressionskoeffizienten FFmean 3.5 2.5 1.5 1 2 3 4 5 Links-Rechts Die mit der OLS-Schätzung bestimmte lineare Regressionsfunktion beträgt bei den GMFDaten: μˆ Y X = βˆ 0 + βˆ 1 ⋅ X Ŷ = b0 + b1 ⋅ X = 3.407 − 0.289 ⋅ X Die geschätzten bedingten Mittelwerte werden üblicherweise als Vorhersagewerte (oder YDach) bezeichnet und durch ein Dach (^) über der abhängigen Variablen gekennzeichnet. Die Berechnung der Koeffizienten erfolgt mit der SPSS-Prozedur "Regression". Forschungspraktikum GMF 11 OLS-Schätzung der Regressionsfunktion: SPSS-Prozedur Regression Die SPSS-Prozedur "Regression" hat sehr viele Optionen. Im einfachten Fall benötgt man aber nur die Angabe von abhängigen Variablen in der Option "/dependent" und die Angabe der erklärenden Variablen hinter dem Schlüsselwort "/enter": REGRESSION /DEPENDENT=varlist /ENTER varlist reg dependent=FFmean /enter po01 . Koeffizientena Modell 1 (Konstante) po01 Politische Einstellung Nicht standardisierte Koeffizienten Standardf ehler B 3.407 .024 -.289 Standardisie rte Koeffizienten Beta .008 -.298 T 140.919 Signifikanz .000 -34.359 .000 a. Abhängige Variable: FFmean Fremdenfeindlichkeit. mean.1(ff03,ff04,ff05,ff08) Das bivariate Regressionsmodell lässt sich leicht zum multiplen Regressionsmodell mit mehreren erklärenden Variablen verallgemeinern: K μ Y x1 ,x 2 ,",x K = β0 + ∑ βk ⋅ x k k =1 Forschungspraktikum GMF 12 OLS-Schätzung der Regressionsfunktion: SPSS-Prozedur Regression Mit OLS-werden die Koeffizienten wieder aus Stichprobendaten geschätzt. Die geschätzte Modellgleichung lautet: K ˆ μˆ = β + βˆ ⋅ X Y x1 ,x 2 ,",x K 0 ∑ k =1 k k K Ŷ = b 0 + ∑ b k ⋅ X k = b 0 + b1 ⋅ X1 + b 2 ⋅ X 2 + ... + b K ⋅ X K k =1 Im Beispiel wird zusätzlich zur Links-Rechts-Selbstpositionierung die Region, in der eine befragte Person lebt, zur Vorhersage herangezogen. Wenn der Wert 1 der Region für die alten und der Wert 2 für die neuen Bundesländer steht, ergibt die OLS-Regression mit SPSS folgende Koeffizientenschätzung: reg dep=FFmean /ent po01 westost. Koeffizientena Modell 1 (Konstante) po01 Politische Einstellung westost Befragte in West- und Ostdeutschland Nicht standardisierte Koeffizienten Standardf B ehler 3.843 .032 Standardisie rte Koeffizienten Beta T 121.104 Signifikanz .000 -.303 .008 -.312 -36.494 .000 -.299 .014 -.177 -20.717 .000 a. Abhängige Variable: FFmean Fremdenfeindlichkeit. mean.1(ff03,ff04,ff05,ff08) Forschungspraktikum GMF 13 OLS-Schätzung der Regressionsfunktion: SPSS-Prozedur Regression Das lineare Regressionsmodells wurde über die bedingten Erwartungswerte der abhängigen Variablen definiert. Alternativ kann die abhängige Variable Y als lineare Funktion der erklärenden Variablen X und einer (unbeobachteten) Residualvariable ζ dargestellt werden: ˆ +ζ Y =β +β ⋅X + ζ = Y 0 1 Die Berechnung eines Regressionsmodells soll vor allem folgende fünf Fragen beantworten: (1) Besteht ein Zusammenhang zwischen der abhängigen Variable auf der einen Seite und den Prädiktoren auf der anderen Seite, d.h. unterscheiden sich die bedingten Mittelwerte der abhängigen Variable bei unterschiedlichen Werten der Prädiktoren? (2) Wenn ein Zusammenhang besteht, wie stark ist der Zusammenhang? (3) Wenn es einen Zusammenhang gibt, stellt sich die Frage, ob ein spezifischer Prädiktor Xk bzw. eine spezifische Teilmenge aller Prädiktoren einen Effekt auf die bedingten Mittelwerte der abhängigen Variable hat? (4) Für jeden Prädiktor bzw. jede erklärende Variable Xk stellt sich die Frage, wie diese Variable die bedingten Mittelwerte beeinflusst, d.h. primär, ob ein positiver oder ein negativer Effekt besteht und wie stark dieser Effekt ist? (5) Wenn in einem Modell mehrere erklärende Variablen spezifiziert sind, stellt sich schließlich die Frage nach der relativen Effektstärke, d.h. ist der Effekt einer Variable stärker als der einen anderen Variable? Forschungspraktikum GMF 14 Der F-Test zur Prüfung der Signifikanz der Erklärungskraft eines Regressionsmodells (1) Besteht ein Zusammenhang zwischen der abhängigen Variable und den Prädiktoren? Wenn die erklärenden Variablen (auch als Prädiktoren bezeichnet) keinen Einfluss auf die abhängige Variable haben, sind alle Regressionsgewichte β1, β2, ..., βK in der Population null. Selbst wenn die Regressionsgewichte in der Stichprobe auf einen Zusammenhang hinweisen, ist es denkbar, dass es in der Population keinen Zusammenhang gibt und der beobachtete Zusammenhang nur in der zufälligen Datenkonstellation der Stichprobe besteht. Mit Hilfe eines F-Tests wird bei der OLS-Regression eines linearen Regressionsmodells geprüft, ob der Zusammenhang auch in der Population besteht. ANOVAb Modell 1 Ŷ Regression E Residuen Gesamt Quadrats umme 920.721 6777.885 7698.606 df 2 12156 12158 Mittel der Quadrate 460.361 .558 F 825.647 Signifikanz .000a a. Einflußvariablen : (Konstante), westost Befragte in West- und Ostdeutschland, po01 Politische Einstellung F= = SSŶ / K SSE / ( n − K − 1) 920.721/ 2 6777.885 /12156 b. Abhängige Variable: FFmean Fremdenfeindlichkeit. mean.1(ff03,ff04,ff05,ff08) Die empirische Signifikanz von 0.000 des F-Werts 825.647 besagt, dass die Wahrscheinlichkeit <0.001 ist, dass in der Grundgesamtheit alle Regressionsgewichte null sind, wenn die aus Stichprobendaten berechneten Koeffizienten oder noch weiter von Null entfernte Werte vorkommen. Selbst bei einer Irrtumswahrscheinlichkeit von 0.1% ist demnach die Nullhypothese, dass keine Beziehung zwischen der abhängigen Variablen und den erklärenden Variablen besteht, zu verwerfen. Forschungspraktikum GMF 15 Determinationskoeffizient R2 (2) Wenn ein Zusammenhang besteht, wie stark ist der Zusammenhang? Für die zweite Frage wird der Determinationskoeffizient R2 betrachtet: Modellzusammenfassung Modell 1 R R-Quadrat a .346 .120 Korrigiertes R-Quadrat .119 Standardf ehler des Schätzers .74671 a. Einflußvariablen : (Konstante), westost Befragte in West- und Ostdeutschland, po01 Politische Einstellung Der Determinationskoeffizient (R-Quadrat) von 0.120 oder 12% besagt, dass knapp 12% der Variation der Fremdenfeindlichkeit werden durch die Links-Rechts-Selbsteinstufung und die Region erklärt. Diese Interpretation basiert auf der Eigenschaft der OLS-Regression, dass die Variation der abhängigen Variable die Summe der Variation der Vorhersagewerte plus der Variation der Residuen ist, wobei die Residuen die Differenzen der abhängigen Variable von den Vorhersagewerten sind: K yi = b 0 + ∑ b k ⋅ x k,i + ei = yˆ i + ei k =1 n n n SSY = ∑ ( yi − y ) = ∑ ( yˆ i − y ) + ∑ ei2 = SSYˆ + SSE i =1 2 i =1 2 i =1 Forschungspraktikum GMF 16 Determinationskoeffizient R2 Modellzusammenfassung Modell 1 Korrigiertes R-Quadrat .119 R R-Quadrat .346a .120 Standardf ehler des Schätzers .74671 a. Einflußvariablen : (Konstante), westost Befragte in West- und Ostdeutschland, po01 Politische Einstellung Der Determinationskoeffizient (R-Quadrat) ist als Quotient der Variation der Vorhersagewerte zur Variation der abhängigen Variable definiert. SS ˆ SS SSY = SSYˆ + SSE → R 2 = Y = 1 − E SSY SSY Bezogen auf alle Fälle der Population ist der Determinationskoeffizient der Anteil der Varianz einer abhängigen Variable Y, der durch die Varianzen der Prädiktoren bedingt ist: 2 σ2 μ Y X1 ,X2 ,...,XK σ ζ R 2Pop. = =1− 2 σ2Y σY ( ) Die (positive) Quadratwurzel R des Determinationskoeffizienten wird als "Multiple Korrelation" bezeichnet und ist die Produkt-Moment-Korrelation der Vohersagewerte mit der abhängigen Variablen: ˆ R = R 2 = r Y, Y ( ) Forschungspraktikum GMF 17 Determinationskoeffizient R2 Modellzusammenfassung Modell 1 R R-Quadrat .346a .120 Korrigiertes R-Quadrat .119 Standardf ehler des Schätzers .74671 a. Einflußvariablen : (Konstante), westost Befragte in West- und Ostdeutschland, po01 Politische Einstellung 920.721 6777.885 =1− 7698.606 7698.606 6777.885 /12156 = 0.119 = 1 − 7698.606 /12158 R 2 = 0.120 = 2 R adj Der Determinationskoeffizient (R-Quadrat) überschätzt den Anteil der erklärten Varianz in der Gesamtpopulation. Diese Verzerrung wird durch den korrigierten oder adjustierten Determinationskoeffizienten reduziert, der sich aus den Quotienten der Populationsschätzungen der Varianzen der abhängigen Variablen Y und der Residualvariable ζ ergibt. 2 ˆ σ SS SS / ( n − K − 1) SS ˆ 2 = 1 − 2ζ = 1 − E R 2 = Y = 1 − E ; R adj σˆ Y SSY SSY SSY / ( n − 1) ANOVAb Modell 1 Regression Residuen Gesamt Quadrats umme 920.721 6777.885 7698.606 df 2 12156 12158 Mittel der Quadrate 460.361 .558 F 825.647 Signifikanz .000a a. Einflußvariablen : (Konstante), westost Befragte in West- und Ostdeutschland, po01 Politische Einstellung b. Abhängige Variable: FFmean Fremdenfeindlichkeit. mean.1(ff03,ff04,ff05,ff08) Forschungspraktikum GMF 18 Determinationskoeffizient R2 ANOVAb Modell 1 Regression Residuen Gesamt Quadrats umme 920.721 6777.885 7698.606 df 2 12156 12158 Mittel der Quadrate 460.361 .558 F 825.647 Signifikanz .000a a. Einflußvariablen : (Konstante), westost Befragte in West- und Ostdeutschland, po01 Politische Einstellung b. Abhängige Variable: FFmean Fremdenfeindlichkeit. mean.1(ff03,ff04,ff05,ff08) Modellzusammenfassung Modell 1 R R-Quadrat .346a .120 Korrigiertes R-Quadrat .119 Standardf ehler des Schätzers .74671 a. Einflußvariablen : (Konstante), westost Befragte in West- und Ostdeutschland, po01 Politische Einstellung Der "Standardfehler des Schätzers" ist die Quadratwurzel aus der Schätzung der Residualvarianz: σˆ ζ = SSE / ( n − K − 1) = 0.558 = 0.746 Forschungspraktikum GMF 19 Signifikanztests von Regressionskoeffizienten (3) Hat ein spezifischer Prädiktor Xk einen Effekt auf die abhängige Variable? Koeffizientena Modell 1 (Konstante) po01 Politische Einstellung westost Befragte in West- und Ostdeutschland Nicht standardisierte Koeffizienten Standardf ehler B 3.843 .032 Standardisie rte Koeffizienten Beta T 121.104 Signifikanz .000 -.303 .008 -.312 -36.494 .000 -.299 .014 -.177 -20.717 .000 a. Abhängige Variable: FFmean Fremdenfeindlichkeit. mean.1(ff03,ff04,ff05,ff08) Für die dritte Frage wird geprüft, ob ein Regressionsgewicht signifikant ist. In der Tabelle mit den geschätzten Koeffizienten ist für jede erklärende Variable (und zusätzlich für die Regressionskonstante) die Test-Statistik T, das ist der Quotient aus dem Koeffizienten geteilt durch seinen Standardfehler, und die empirische Signifikanz der Prüfung der Nullhypothese aufgeführt, dass der entsprechende Koeffizient in der Population Null ist. bi βi = 0 ⇒ T = ∼ t df = n − K −1 σˆ ( bi ) Den Signifikanzwerten ist zu entnehmen, dass alle drei Regressionskoeffizienten signifikant von Null verschieden sind. Forschungspraktikum GMF 20 F-Test auf Veränderung der Erklärungskraft Eine Alternative zum T-Test ist ein F-Test auf Erhöhung der Erklärungskraft in einer schrittweisen Regression. Zwei Regressionsmodelle sind hierarchisch ineinander geschachtelt, wenn: (a) das restriktive Modell M0 Restriktionen über das weniger restriktive oder liberalere Modell M1 postuliert und (b) die Schätzung beider Modelle auf der gleichen Stichprobe (d.h. den gleichen Fällen) beruht. Wenn M0 das restriktive Modell bezeichnet und M1 das weniger restriktive Modell, dann ist die Teststatistik SSE ( M o ) − SSE ( M1 ) ) / ( df 0 − df1 ) ( F= SSE ( M1 ) / df1 f-verteilt, wenn die Restriktionen des Modells M0 in der Population zutreffen. Die Freiheitsgrade im Zähler sind zum einen die Differenz der Freiheitsgrade der beiden Modelle und zum anderen die Freiheitsgrade des liberaleren Modells, wobei die Freiheitsgrade eines Modells gleich der Fallzahl minus der Zahl der nicht restringierten zu schätzenden Regressionskoeffizienten ist. Forschungspraktikum GMF 21 F-Test auf Veränderung der Erklärungskraft Die beiden als Beispiel geschätzten Regressionsmodelle sind ineinander hierarchisch geschachtelt: M0: Ffmean = β0 + β1· po01 + 0 · westost + E0 M1: Ffmean = β0 + β1· po01 + β2 · westost + E1 Restriktion: β2 = 0. Die Modelle können daher mit F-Tests gegeneinander getestet werden, wenn die Schätzungen auf gleicher Fallzahl beruhen. Dies wird sichergestellt, wenn die Spezifikation der Modelle im selben SPSS-Befehl erfolgt: reg dep=FFmean /ent po01 /ent westost /remove po01. Mit dem Befehl wird eine schrittweise Regression angefordert: Schritt 1: Regression von FFmean auf po01. Schritt 2: Zusätzliche Aufnahme von westost als weitere erklärende Variable. Schritt 3: Entfernen ("remove") von po01 als erklärende Variable. Die Modelle aus Schritt 1 und Schritt 3 sind hierarchisch in das Modell aus Schritt 2 geschachtelt. Modell 1 und Modell 3 sind dagegen nicht ineinander geschachtelt. Forschungspraktikum GMF 22 F-Test auf Veränderung der Erklärungskraft ANOVAd Modell 1 2 3 Regression Residuen Gesamt Regression Residuen Gesamt Regression Residuen Gesamt Quadrats umme 681.423 7017.183 7698.606 920.721 6777.885 7698.606 178.137 7520.470 7698.606 df 1 12157 12158 2 12156 12158 1 12157 12158 Mittel der Quadrate 681.423 .577 F 1180.540 Signifikanz .000a 460.361 .558 825.647 .000b 178.137 .619 287.962 .000c a. Einflußvariablen : (Konstante), po01 Politische Einstellung b. Einflußvariablen : (Konstante), po01 Politische Einstellung, westost Befragte in West- und Ostdeutschland c. Einflußvariablen : (Konstante), westost Befragte in West- und Ostdeutschland d. Abhängige Variable: FFmean Fremdenfeindlichkeit. mean.1(ff03,ff04,ff05,ff08) Die F-Teststatistiken von po01 und westost berechnen sich dann nach. FM1vs.M 2 = FM3vs.M 2 = ( 7017.183 − 6777.885) / (12157 − 12156 ) 6777.885 /12156 ( 7520.470 − 6777.885) / (12157 − 12156 ) 6777.885 /12156 = 429.176 = 1331.811 Die Freiheitsgrade sind in beiden Fällen df1=1 und df2=21156. Forschungspraktikum GMF 23 F-Test auf Veränderung der Erklärungskraft Diese F-Werte ergeben sich (bis auf Rundungsfehler) auch, wenn man den Parameter "F" in der Options "Statistics" der SPSS-Prozedur "Regression" verwendet: reg stat default F /dep=FFmean /ent po01 westost. Koeffizientena Modell 1 (Konstante) po01 Politische Einstellung westost Befragte in West- und Ostdeutschland Nicht standardisierte Koeffizienten Standardf B ehler 3.843 .032 Standardisie rte Koeffizienten Beta F 14666.125 Signifikanz .000 -.303 .008 -.312 1331.810 .000 -.299 .014 -.177 429.176 .000 a. Abhängige Variable: FFmean Fremdenfeindlichkeit. mean.1(ff03,ff04,ff05,ff08) Durch den Paramter "cha" in der Option "Statistics" werden die F-Tests auf Veränderung der Erklärungskraft bei schrittweiser Regression berechnet: reg stat default cha /dep=FFmean /ent po01 /rem westost. Forschungspraktikum GMF 24 F-Test auf Veränderung der Erklärungskraft Modellzusammenfassung Änderungsstatistiken Modell 1 2 3 R R-Quadrat a .298 .089 b .346 .120 c .152 .023 Korrigiertes R-Quadrat .088 .119 .023 Standardf ehler des Schätzers .75975 .74671 .78652 Änderung in R-Quadrat .089 .031 -.096 Änderung in F 1180.540 429.176 1331.810 df1 1 1 1 df2 12157 12156 12156 Änderung in Signifikanz von F .000 .000 .000 a. Einflußvariablen : (Konstante), po01 Politische Einstellung b. Einflußvariablen : (Konstante), po01 Politische Einstellung, westost Befragte in West- und Ostdeutschland c. Einflußvariablen : (Konstante), westost Befragte in West- und Ostdeutschland Der F-Test, der die Nullhypothese prüft, ob überhaupt ein Zusammenhang besteht, basiert auf der gleichen Logik. Geprüft wird, ob das liberalere Modell mit allen Prädiktoren signifikant besser ist als ein restriktives Modell, dass nur die Regressionskonstante beinhaltet. Sichtbar wird dies, wenn mit der Option "/origin" der Prozedur "Regression" schrittweise Modelle geschätzt werden, die keine automatische Konstante enthalten, und stattdessen eine generierte Konstante als Variable "C" verwendet wird: comp C=1. reg stat default cha /origin /dep=FFmean /ent C /ent po01 westost. Forschungspraktikum GMF 25 F-Test auf Veränderung der Erklärungskraft Modellzusammenfassung Änderungsstatistiken Modell 1 2 a R R-Quadrat b .957 .915 c .962 .925 Korrigiertes R-Quadrat .915 .925 Standardf ehler des Schätzers .79575 .74671 Änderung in R-Quadrat .915 .010 Änderung in F 130916.390 825.647 df1 1 2 df2 12158 12156 Änderung in Signifikanz von F .000 .000 a. Bei der Regression durch den Ursprung (Modell ohne konstanten Term) mißt das R-Quadrat den Anteil der Variabilität in der abhängigen Variable durch den Ursprung, der durch Regression erklärt werden kann. Dieses Verfahren KANN NICHT mit dem R-Quadrat bei Modellen verglichen werden, die einen konstanten Term enthalten. b. Einflußvariablen: C c. Einflußvariablen: C, westost Befragte in West- und Ostdeutschland, po01 Politische Einstellung Koeffizientena,b Modell 1 2 C C po01 Politische Einstellung westost Befragte in West- und Ostdeutschland Nicht standardisierte Koeffizienten Standardf B ehler 2.611 .007 3.843 .032 Standardisie rte Koeffizienten Beta .957 1.408 T 361.824 121.104 Signifikanz .000 .000 -.303 .008 -.319 -36.494 .000 -.299 .014 -.155 -20.717 .000 Bei einer Regression durch de Ursprung können nur die unstandisierten Regressionskoeffizienten, deren Standardfehler und Teststatistiken interpretiert werden. a. Abhängige Variable: FFmean Fremdenfeindlichkeit. mean.1(ff03,ff04,ff05,ff08) b. Lineare Regression durch den Ursprung Forschungspraktikum GMF 26 Einseitige Tests von Regressionskoeffizienten Koeffizientena Modell 1 (Konstante) po01 Politische Einstellung westost Befragte in West- und Ostdeutschland Nicht standardisierte Koeffizienten Standardf ehler B 3.843 .032 Standardisie rte Koeffizienten Beta T 121.104 Signifikanz .000 -.303 .008 -.312 -36.494 .000 -.299 .014 -.177 -20.717 .000 a. Abhängige Variable: FFmean Fremdenfeindlichkeit. mean.1(ff03,ff04,ff05,ff08) Die F-Statistik eines einzelnen Koeffizienten ist das Quadrat der T-Statistik: t(b1) = –36.494; F(b1) = 3131.810 = (–36.494)2. Der Vorteil der T-Statistik besteht darin, dass auch einseitige Hypothesen über einen Regressionskoeffizienten geprüft werden können. H0: βi ≥ γ vs. H1: βi < γ bzw. H0: βi ≤ γ vs. H1: βi > γ wobei γ ein durch die Nullhypothese postulierter Minimal- bzw. Maximalwert ist. Die Nullhypothese wird mit der Irrtumswahrscheinlichkeit α jeweils abgelehnt, wenn b −γ T= i σˆ ( bi ) kleiner als das α-Quantil bzw, größer als das (1–α)-Quantil der T-Verteilung mit df=n-K-1 Freiheitsgraden ist. Forschungspraktikum GMF 27 Interpretation der Effekte Koeffizientena Modell 1 (Konstante) po01 Politische Einstellung westost Befragte in West- und Ostdeutschland Nicht standardisierte Koeffizienten Standardf ehler B 3.843 .032 Standardisie rte Koeffizienten Beta T 121.104 Signifikanz .000 -.303 .008 -.312 -36.494 .000 -.299 .014 -.177 -20.717 .000 a. Abhängige Variable: FFmean Fremdenfeindlichkeit. mean.1(ff03,ff04,ff05,ff08) (4) Welchen Effekt hat ein spezifischer Prädiktor Xk? Die Interpretation der Regressionsgewichte ergibt sich aus der Vorhersagegleichung: μˆ Y = 3.843 − 0.303 ⋅ po01 − 0.299 ⋅ westost Die negativen Vorzeichen, weisen darauf hin, dass der bedingte Mittelwert von FFmean geringer ist, wenn die Werte von po01 und westost ansteigen. Aus der Kodierung der drei Variablen folgt, • dass pro Einheit weiter rechts Befragte um 0.303 Einheiten eher fremdenfeindlichen Items zustimmen. • dass im Befragte aus dem Osten um 0.299 Einheiten eher fremdenfeindlichen Items zustimmen als Personen aus dem Westen. Forschungspraktikum GMF 28 Leichtere Interpretation der Effekte durch Rekodierung Ungünstig ist, dass kleine Werte bei der abhängigen Variable für hohe Fremdenfeindlichkeit und große Werte für geringe Fremdenfeindlichkeit stehen, obwohl die Variable "Fremdenfeindlichkeit" und nicht "Fremdenfreundlichkeit" erfassen soll. Es ist daher sinnvoll, die Variable vor der Analyse umzupolen, so dass der Wert 1 für "stimme gar nicht zu" und der Wert 4 für "stimme voll und ganz zu" steht. Außerdem sollte das Label von "po01" die Bedeutung dieser Variable beschreiben. if (not missing(FFmean))FFmean=5-FFmean. var lab FFmean 'Fremdenfeindlichkeit 5-mean(ff03 to ff08)'. var lab po01 'Links-Rechts-Selbsteinstufung'. reg dep=FFmean /ent po01 westost. Koeffizientena Modell 1 (Konstante) po01 Links-RechtsSelbsteinstufung westost Befragte in West- und Ostdeutschland Nicht standardisierte Koeffizienten Standardf B ehler 1.157 .032 Standardisie rte Koeffizienten Beta T 36.455 Signifikanz .000 .303 .008 .312 36.494 .000 .299 .014 .177 20.717 .000 a. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Forschungspraktikum GMF 29 Interpretation der Effekte (5) Welche Variable hat den relativ stärksten Effekt? Da die beiden erklärenden Variablen auf unterschiedlichen Antwortskalen gemessen werden, macht es wenig Sinn, die unstandardisierten Regressionsgewichte zu vergleichen. Um dennoch Aussagen über die relative Effektstärke treffen zu können, werden die sogenannten standardisierten Regressonsgewichte betrachtet. Ein standardisierter Effekt ergibt sich dadurch, dass anstelle der erklärenden Variablen die ztransformierten (standardisierten) Werte der Variablen als Prädiktor in die Regressionsgleichung aufgenommen werden. Werden alle erklärenden Variablen und die abhängige Variable standardisiert, dann ist die Regressionskonstante notwendige null. Ein standardisiertes Regressionsgewicht gibt dann an, um wie viele Standardabweichungen der abhängigen Variable der bedingte Mittelwert ansteigt (bei positiven Werten) bzw. sinkt (bei negativen Werten), wenn die jeweilige erklärende Variable um +1 Standardabweichung ansteigt. Formal berechnen sich die standardisierten Effekte b* aus den unstandardisierten durch die Gleichung: σˆ ( X i ) b = bi ⋅ = bi ⋅ s(Y) σˆ ( Y ) * i s ( Xi ) Forschungspraktikum GMF 30 Interpretation der Effekte Die standardisierten Effekte oder Regressionsgewichte werden im SPSS-Ausdruck als "Beta" bezeichnet. Koeffizientena Modell 1 (Konstante) po01 Links-RechtsSelbsteinstufung westost Befragte in West- und Ostdeutschland Nicht standardisierte Koeffizienten Standardf B ehler 1.157 .032 Standardisie rte Koeffizienten Beta T 36.455 Signifikanz .000 .303 .008 .312 36.494 .000 .299 .014 .177 20.717 .000 a. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Im Beispiel ist der Effekt von "po01" mit einem standardisierten Regressionsgewicht von 0.312 deutlich höher als der Effekt der Region mit einem Wert von 0.177. Forschungspraktikum GMF 31 Komplexere Regressionsfunktionen Wenn unterstellt wird, dass die Regressionsfunktion nicht-linear ist, lässt sie sich trotzdem über eine lineare OLS-Regression schätzen, falls es möglich ist, die Variablen vor der Berechnung der Regressionskoeffizienten so zu transformieren, dass alle Prädiktoren linear in die Gleichung eingehen. Als Beispiel wird angenommen, dass Alter mit einem quadratischen Effekt auf Fremdenfeindlichkeit wirkt, so dass ältere Befragte fremdenfeindlicher sind als jüngere, der Anstieg aber flacher wird. Formal lässt sich dies durch folgende Regressionsfunktion darstellen: μ FFmean = β0 + β1 ⋅ age + β2 ⋅ age 2 Wenn die Erwartung zutrifft, sollte β1 ein positives und β2 ein negatives Vorzeichen aufweisen. Wenn Alter und das quadrierte Alter als zwei Prädiktoren in die Regressionsgleichung einfließen, lässt sich die Vermutung über ein lineares Regressionsmodell schätzen: compute age=jahr-gebj. compute age2=age**2. reg dep=FFmean /ent age age2. Forschungspraktikum GMF 32 Komplexere Regressionsfunktionen Koeffizientena Modell 1 (Konstante) age age2 Nicht standardisierte Koeffizienten Standardf ehler B 2.334 .051 -.006 .002 .000 .000 Standardisie rte Koeffizienten Beta -.120 .278 T 45.334 -2.569 5.954 Signifikanz .000 .010 .000 a. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Die Vorzeichen sind zwar tatsächlich umgekehrt aber entgegen den Erwartungen. Aufgrund der Kodierung sind die unstandardisierten Effekte aber sehr klein. Misst man Alter nicht in Jahren, sondern in Jahrhunderten, ergeben sich höhere Werte: compute agejhd=age/100. compute agejhd2=agejhd**2. reg dep=FFmean /ent agejhd agejhd2. Koeffizientena Modell 1 (Konstante) agejhd agejhd2 Nicht standardisierte Koeffizienten Standardf ehler B 2.334 .051 -.592 .230 1.427 .240 Standardisie rte Koeffizienten Beta -.120 .278 T 45.334 -2.569 5.954 Signifikanz .000 .010 .000 a. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Forschungspraktikum GMF 33 Komplexere Regressionsfunktionen Mit Hilfe der Option "/scatterplot (varY,varX)" läst sich eine Grafik der Vorhersagewerte nach dem Alter berechnen. Wenn Alter keine erklärende Variable ist, muss diese Variable mit allen Modellvariablen in der Option "variables= varlist" aufgenommen worden sein: reg variables=FFmean age agejhd agejhd2 /dep=FFmean /ent agejhd agejhd2 /sca (*pred,age). Sichtbar wird, dass entgegen der Vermutung bei zunehmendem Alter der Effekt auf Fremdenfeindlichkeit zunimmt. Tatsächlich ist der lineare Anteil der Regressionsfunktion negativ, der quadratische positiv. Da Alter nur Werte >0 aufweist, bedeutet dies, dass mit größeren Werten der positive quadratische Anstieg gegenüber dem negativen linearen Abfall immer größeres Gewicht erhält. Forschungspraktikum GMF 34 Regression auf nominalskalierte erklärende Variablen: Varianzanalyse Da ein Regressionsgewicht angibt, wie sich der bedingte Mittelwert der abhängigen Variable ändert, wenn ein Prädiktor um +1 Einheit ansteigt, wird implizit unterstellt, dass alle Prädiktoren metrisches Messniveau aufweisen. Bei einer nominalskalierten erklärenden Variablen mit J Ausprägungen werden daher zunächst J–1 Designvariablen gebildet und diese dann als Prädiktoren in das Regressionsmodell aufgenommen. Als Beispiel soll Fremdenfeindlichkeit durch Bildungsabschluss mit den Ausprägungen "kein Abschluss", "Hauptschulabschluss", "mittlere Reife", "Hochschulreife" und "Hochschulabschluss" vorhergesagt werden. Zunächst werden aus der Bildungsvariable 0/1-kodierte Designvaiablen (Dummy-Variablen) berechnet, die den Wert 1 aufweisen, wenn der entsprechende Bildungsabschluss als höchster Abschluss erreicht wird. Diese Dummy-Variablen dienen dann als Prädiktoren, wobei ein Abschluss als Referenzkategorie ausgelassen wird. recode educ (missing=sysmis)(1=1)(else=0) into NoHS. recode educ (missing=sysmis)(2,3,4=1)(else=0) into HS. recode educ (missing=sysmis)(5,6=1)(else=0) into MR. recode educ (missing=sysmis)(7=1)(else=0) into Abi. recode educ (missing=sysmis)(8=1)(else=0) into Uni. reg dep=FFmean /ent HS MR Abi Uni. Forschungspraktikum GMF 35 Regression auf nominalskalierte erklärende Variablen: Varianzanalyse Koeffizientena Modell 1 (Konstante) HS MR Abi Uni Nicht standardisierte Koeffizienten Standardf ehler B 2.349 .072 .326 .073 .180 .073 -.190 .073 -.246 .073 Standardisie rte Koeffizienten Beta .170 .108 -.096 -.126 T 32.778 4.457 2.480 -2.595 -3.358 Signifikanz .000 .000 .013 .009 .001 a. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Das Auslassen einer Referenzkategorie, im Beispiel "kein Abschluss" ist notwendig, da bereits die übrigen 4 Dummy-Variablen alle Informationen über den Bildungsabschluss enthalten. "Kein Bildungsabschluss" liegt vor, wenn alle Dummy-Variablen den Wert "0" aufweisen. Die Regressionskonstante gibt daher die durchschnittliche vorhergesagte Fremdenfeindlichkeit von Befragten ohne Abschluss an. Die Regressionsgewichte der spezifizerten Dumy-Variablen erfassen die Distanz der jeweiligen Gruppe zur Referenzkategorie. Befragte mit Hauptschulabschluss haben also einen um 0.326 höheren Mittelwert, Befragte mit mittlerer Reife einen um 0.180 höheren wert, Abiturienten einen um 0.190 geringeren und Hochschulabsolventen einen um 0.246 geringeren Wert als Personen ohne Schulabschluss. Forschungspraktikum GMF 36 Multikollinearität Generell lassen sich Regressionsgewichte nur dann eindeutig schätzen, wenn die Prädiktoren nicht perfekt miteinander korrelieren, da ansonsten mindestens ein Prädiktor keine zusätzliche Information enthält. Selbt wenn die Prädiktoren nicht perfekt, aber sehr hoch untereinander korrelieren, kann es Schätzprobleme geben. Diese drücken sich dadurch aus, dass standardisierte Regressionsgewichte größer 1 bzw. kleiner –1 sind, dass die Standardfehler sehr groß sind und dass die Schätzung der Korrelationen der Kennwerteverteilungen der Schätzer sehr hoch sind. SPSS berechnet vor einer Aufnahme in die Modellgleichung für jede Variable die Toleranz, das ist eins minus dem Determinationskoeffizienten der Regression eines Pädiktors auf alle anderen Prädiktoren. Wenn die Toleranz größer einem Minimalswert ist, wird der Prädiktor nicht berückichtigt. Die Inverse der Toleranz wird als "VIF" (variance inflation factor) bezeichnet und gibt an, um welchen Faktor die quadrierten Standardfehler ansteigen, wenn ein Prädiktor nicht unkorreliert ist. Mit den Parametern "bcov" "tol" und "collin" in der Options "/Statistics" werden die Varianzen und Kovarianzen der Schätzerverteilungen und Kollinearitätsstatistiken ausgedruckt. Neben Toleranz und VIF wird dazu eine Hauptkomponentenanalyse der Prädiktoren berechnet. reg /stat def bcov collin tol /dep=FFmean /ent NoHS to Uni . Forschungspraktikum GMF 37 Multikollinearität Aufgenommene/Entfernte Variablenb Modell 1 Aufgenomme ne Variablen Uni, NoHS, a Abi, HS Entfernte Variablen . Modellzusammenfassung Methode Eingeben a. Toleranz = .000 erreichte Grenzen. b. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Modell 1 R R-Quadrat a .289 .083 Korrigiertes R-Quadrat .083 Standardf ehler des Schätzers .76531 a. Einflußvariablen : (Konstante), Uni, NoHS, Abi, HS Koeffizientena Modell 1 (Konstante) NoHS HS Abi Uni Nicht standardisierte Koeffizienten Standardf B ehler 2.529 .012 -.180 .073 .146 .019 -.370 .019 -.426 .019 Standardisie rte Koeffizienten Beta -.021 .076 -.186 -.218 Kollinearitätsstatistik T 219.464 -2.480 7.865 -19.360 -22.625 Signifikanz .000 .013 .000 .000 .000 Toleranz .984 .790 .798 .794 VIF 1.016 1.266 1.253 1.260 a. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Forschungspraktikum GMF 38 Multikollinearität Modell 1 Ausgeschlossene Variablenb Beta In T .a MR . Signifikanz . Partielle Korrelation . Kollinearitätsstatistik Minimale Toleranz VIF Toleranz .000 . .000 a. Einflußvariablen im Modell: (Konstante), Uni, NoHS, Abi, HS b. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Korrelation der Koeffizientena Modell 1 Korrelationen Kovarianzen Uni 1.000 .097 .369 .380 .000 .000 .000 .000 Uni NoHS Abi HS Uni NoHS Abi HS NoHS .097 1.000 .096 .099 .000 .005 .000 .000 Abi .369 .096 1.000 .374 .000 .000 .000 .000 HS .380 .099 .374 1.000 .000 .000 .000 .000 a. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Kollinearitätsdiagnosea Modell 1 Dimension 1 2 3 4 5 Eigenwert 1.804 1.000 1.000 1.000 .196 Kondition sindex 1.000 1.343 1.343 1.343 3.031 (Konstante) .10 .00 .00 .00 .90 Varianzanteile NoHS HS .00 .06 .37 .26 .37 .14 .21 .00 .04 .54 Abi Uni .06 .01 .25 .18 .51 .06 .11 .00 .31 .52 a. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Forschungspraktikum GMF 39 Interaktionseffekte Wenn ein Regressionsmodell als Prädiktoren nur Designvariablen für nominalskalierte erklärende Variablen aufweist, spricht man auch von Varianzanalyse. Die nominalskalierten erklärenden Variablen heißen dann auch Faktoren. Von Interaktionseffekten spricht man, wenn davon ausgegangen wird, dass der Effekt eines Prädiktors in Abhängigkeit von den Ausprägungen der übrigen Variablen unterschiedlich ausfällt. Modelliert werden (lineare) Effekte dadurch, dass man Produkte von erklärenden Variablen als Prädiktoren berücksichtigt. In der Varianzanalyse werden dazu alle Designvariablen verschiedener Faktoren miteinander multipliziert. Als Beispiel wird eine 2-faktorielle Varianzanalyse mit Interaktionseffekten aus der Bildung und Region geschätzt: recode westost (1=0)(2=1) into Ost. do repeat #1=HS MR Abi Uni /#2=HSOst MROst AbiOst UniOst. compute #2=#1*Ost. end repeat print. reg /stat def cha /dep=FFmean /ent Ost HS MR Abi Uni /ent HSOst MROst AbiOst UniOst. Forschungspraktikum GMF 40 Interaktionseffekte Modellzusammenfassung Änderungsstatistiken Modell 1 2 R R-Quadrat .327a .107 .330b .109 Korrigiertes R-Quadrat .106 .108 Standardf ehler des Schätzers .75546 .75461 Änderung in R-Quadrat .107 .002 Änderung in F 297.541 7.980 df1 5 4 df2 12446 12442 Änderung in Signifikanz von F .000 .000 a. Einflußvariablen : (Konstante), Uni, Ost, Abi, HS, MR b. Einflußvariablen : (Konstante), Uni, Ost, Abi, HS, MR, AbiOst, HSOst, UniOst, MROst ANOVAc Modell 1 2 Regression Residuen Gesamt Regression Residuen Gesamt Quadrats umme 849.059 7103.154 7952.213 867.236 7084.977 7952.213 df 5 12446 12451 9 12442 12451 Mittel der Quadrate 169.812 .571 96.360 .569 F 297.541 Signifikanz .000a 169.218 .000b a. Einflußvariablen : (Konstante), Uni, Ost, Abi, HS, MR b. Einflußvariablen : (Konstante), Uni, Ost, Abi, HS, MR, AbiOst, HSOst, UniOst, MROst c. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Forschungspraktikum GMF 41 Interaktionseffekte Modell 1 2 Koeffizientena (Konstante) Ost HS MR Abi Uni (Konstante) Ost HS MR Abi Uni HSOst MROst AbiOst UniOst Nicht standardisierte Koeffizienten Standardf ehler B 2.257 .071 .264 .015 .352 .072 .168 .072 -.165 .072 -.247 .072 2.429 .088 -.227 .148 .173 .089 -.032 .089 -.314 .089 -.398 .090 .521 .152 .563 .150 .401 .152 .432 .151 Standardisie rte Koeffizienten Beta .155 .183 .101 -.083 -.126 -.133 .090 -.019 -.158 -.204 .149 .244 .111 .143 T 31.813 18.101 4.881 2.349 -2.285 -3.420 27.690 -1.533 1.936 -.365 -3.516 -4.447 3.430 3.756 2.637 2.857 Signifikanz .000 .000 .000 .019 .022 .001 .000 .125 .053 .715 .000 .000 .001 .000 .008 .004 a. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Referenzgruppe sind Befragte ohne Schulabschluss im Westen. Die signifikanten Interaktionseffekte weisen darauf hin, dass Region und Schulabschluss miteinander interagieren. Forschungspraktikum GMF 42 Statistische Eigenschaften der OLS-Schätzer Die aus Stichprobendaten berechneten Kenngrößen sollen Aussagen über die Regression in der Population erlauben. Tatsächlich führt die OLS-Schätzung eines (linearen) Regressionsmodells unter bestimmten Bedingungen zu statistisch optimalen Ergebnissen. Wenn nämlich gilt: (1) die Stichprobendaten sind eine (einfache) Zufallsauswahl aus einer Zielpopulation, (2) die Regressionsfunktion ist korrekt spezifiziert, d.h. die bedingten Populationsmittelwerte der abhängigen Variablen folgen der in der Vorhersagegleichung formulierten Funktion dann sind die berechneten unstandardisierten Regressionsgewichte Realisationen von (a) konsistenten und (b) erwartungstreuen Schätzern, d.h. mit steigendem Stichprobenumfang sinkt die Wahrscheinlichkeit großer Abweichungen zwischen Schätzungen und zu schätzenden Populationswerten und der Erwartungswert aller denkbaren Schätzungen ist mit den zu schätzenden Populationswerten identisch. Forschungspraktikum GMF 43 Statistische Eigenschaften der OLS-Schätzer Wenn zusätzlich gilt, dass (3) die Residualvarianz, d.h. die bedingten Populationsvarianzen von Y gegeben X konstant sind, dann gilt folgendes: (c) Die Kennwerteverteilung der Regresseionskoeffizienten ist asymptotisch um die Populationswerte multinormalverteilt, (d) und die Residualvarianz in der Population und die Varianzen und Kovarianzen der Kennwerteverteilungen der Regressionskoeffizienten lassen sich konsistent und erwartungstreu schätzen. Wenn zusätzlich gilt, (4) dass die Populationsresiduen normalverteilt sind, dann sind (e) die Kennwerteverteilungen der Regressionskoeffizienten auch bei kleinen Fallzahlen exakt normalverteilt. Die oben vorgestellten F- und T-Tests unterstellen die Gültigkeit aller vier Annahmen, wobei bei großen Fallzahlen aufgrund der asymptotischen Annäherung an die Normalverteilung die Tests auch ohne Normalverteilugsannahme asymptotisch gültig sind. Forschungspraktikum GMF 44 Statistische Eigenschaften der OLS-Schätzer Anstelle der Annahmen(1) bis (4) werden oft folgende Annahmen unterstellt: (1) Die Werte von X sind fest vorgegeben ("fixed-X"), X ist dann keine Zufallsvariable. (2) Die Residuen werden als Realisierungen von Zufallsvariablen aufgefasst, wobei der Erwartungswert jedes Residuums null ist. (3) Alle Residuen sind unabhängig und identisch verteilt (engl: independent and identical distributed): iid-Annahme. (4) Die Residuen sind normalverteilt. Anstelle von Annahme (1) reicht eine Konsequenz aus (1) aus: (1/) Die Residualvariable ist nicht mit der erklärenden Variablen korreliert. Anstelle der Annahme (3) reichen ebenfalls zwei ihrer Konsequenzen aus: (3a) Die Varianzen der Residuen sind gleich (Homoskedastizitätsannahme) (3b) Die Residuen sind untereinander unkorreliert (keine Autokorrelation). Es kann gezeigt werden, dass unter der fixed-X-Annahme die Berechnungsformeln der Regressionskoeffizienten lineare Funktionen der Populationsresiduen sind. Die OLS-Schätzer sind bei dieser Sichtweise lineare Schätzer. Dann gilt zudem, dass die OLS-Schätzer optimal in dem Sinne sind, dass es keine erwartungstreuen linearen Schätzer mit geringeren Varianzen der Kennwerteverteilung gibt. Die OLSRegression weist daher die BLU-Eigenschaft auf, wobei BLU für "best linear unbiased" steht. Forschungspraktikum GMF 45 Prüfung der Anwendungsvoraussetzungen der Regression Da die positiven Eigenschaften der OLS-Schätzung an Bedingungen geknüpft ist, sollte versucht werden, die Gültigkeit der Anwendungsvoraussetzungen zu prüfen. Als Beispiel wird die Regression von FFmean auf Links-Rechts-Selbsteinstufung, Bildung, Alter, Region und Erhebungsjahr berechnet, wobei Bildung und Alter und Erhebungsjahr jeweils linear und als metrische Variable in das Modell eingehen: recode educ (missing=sysmis)(1=0)(2,3,4=1) (5,6=2)(7=3)(8=4) into Bildung. val lab Bildung 0'kein Abschluss' 1'Hauptschulabschluss' 2'mittl. Reife' 3'(Fach-)Hochschulreife' 4'Hochschulabschluss' /Ost 0'Westen' 1'Osten'. compute Welle=jahr-2002. freq FFmean po01 Bildung age Ost Welle /form notab /stat min max mean std. reg descriptives /dep=FFmean /ent po01 Bildung age Ost Welle. Die Option "/descriptives" berechnet zunächst für alle Modellvariablen desktiptive Statistiken. Forschungspraktikum GMF 46 Prüfung der Anwendungsvoraussetzungen der Regression Deskriptive Statistiken FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) po01 Links-RechtsSelbsteinstufung Bildung age Ost Welle Mittelwert Standardab weichung 2.3875 .79593 11960 2.76 .819 11960 2.3991 45.2576 .3282 1.7624 1.07609 16.19906 .46957 1.37149 11960 11960 11960 11960 N Korrelationen Korrelation nach Pearson FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) po01 Links-RechtsSelbsteinstufung Bildung age Ost Welle FFmean Fremdenfei ndlichkeit 5-mean(ff0 3 to ff08) po01 LinksRechtsSelbstein stufung 1.000 .300 -.269 .150 .152 .070 .300 1.000 -.152 .044 -.077 -.026 -.269 .150 .152 .070 -.152 .044 -.077 -.026 1.000 -.080 .027 .059 -.080 1.000 .053 -.029 .027 .053 1.000 -.029 .059 -.029 -.029 1.000 Forschungspraktikum GMF Bildung age Ost Welle 47 Prüfung der Anwendungsvoraussetzungen der Regression ANOVAb Modellzusammenfassung Modell 1 R R-Quadrat .442a .195 Korrigiertes R-Quadrat .195 Standardf ehler des Schätzers .71425 Modell 1 a. Einflußvariablen : (Konstante), Welle, po01 Links-Rechts-Selbsteinstufung, age, Ost, Bildung Regression Residuen Gesamt Quadrats umme 1477.761 6098.396 7576.157 df 5 11954 11959 Mittel der Quadrate 295.552 .510 F 579.338 Signifikanz .000a a. Einflußvariablen : (Konstante), Welle, po01 Links-Rechts-Selbsteinstufung, age, Ost, Bildung b. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Koeffizientena Modell 1 (Konstante) po01 Links-RechtsSelbsteinstufung Bildung age Ost Welle Nicht standardisierte Koeffizienten Standardf B ehler 1.601 .036 Standardisie rte Koeffizienten Beta T 44.394 Signifikanz .000 .268 .008 .276 33.151 .000 -.169 .006 .299 .057 .006 .000 .014 .005 -.228 .113 .177 .099 -27.372 13.739 21.415 12.001 .000 .000 .000 .000 a. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Forschungspraktikum GMF 48 Prüfung der Anwendungsvoraussetzungen: Korrekte Modellspezifikation Zur Beurteilung der Gültigkeit der Modellspezifikation können die Residuen gegen die Werte der abhängigen Variable geplottet werden. Oft werden auch sogenannte Partialplots berechnet, bei denen die Residuen der abhängigen und einer erklärenden Variable betrachtet werden, wobei beide Variablen jeweils auf die übrigen erklärenden Variablen regrediert sind. reg /dep=FFmean /ent po01 Bildung age Ost Welle /sca (*resid age) /part age. Forschungspraktikum GMF 49 Prüfung der Anwendungsvoraussetzungen: Korrekte Modellspezifikation Die Punktewolken weisen nicht darauf hin, dass der (partielle) Zusammenhang nichtlinear ist. Als weitere Kontrolle können die Residuen auch in die aktive Datenmatrix gespeichert werden und z.B. bedingte Mittelwerte gegen eine (gruppierte) erklärende Variable berechnet werden. Forschungspraktikum GMF 50 Prüfung der Anwendungsvoraussetzungen: Korrekte Modellspezifikation recode age (lo thru 25=1)(25 thru 35=2)(35 thru 45=4) (45 thru 55=5)(55 thru 65=6)(65 thru hi=7) into agegroup. reg /dep=FFmean /ent po01 Bildung age Ost Welle /save resid(e1). means e1 by agegroup /stat all. Bericht e1 Unstandardized Residual agegroup 1.00 2.00 4.00 5.00 6.00 7.00 Insgesamt Mittelwert .0196486 .0024980 -.0018241 -.0168107 -.0357572 .0454913 .0000000 N 1490 2004 2969 2191 1753 1553 11960 Standardab weichung .67424632 .68713032 .68782006 .73245450 .74318487 .77091394 .71410222 Die Mittelwerte der Residuen weisen Werte nahe null auf, wobei die Mittelwerte an den Rändern eher unter- und an den Extremen eher überschätzt werden. Die Mittelwertdifferenzen sind zwar bei 5%, aber nicht bei 1% signifikant. Aufgrund der hohen Fallzahl sollte α maximal 1% sein. ANOVA-Tabelle e1 Unstandardized Residual * agegroup Zwischen den Gruppen Innerhalb der Gruppen Insgesamt (Kombiniert) Linearität Abweichung von der Linearität Quadrats umme 6.672 .052 5 1 Mittel der Quadrate 1.334 .052 F 2.619 .102 Signifikanz .023 .749 6.620 4 1.655 3.248 .011 6091.724 6098.396 11954 11959 .510 Forschungspraktikum GMF df 51 Prüfung der Anwendungsvoraussetzungen: Korrekte Modellspezifikation Es besteht auch die Möglichkeit, Nichtlinearität über eine nichtlineare Regression zu testen: reg /dep=FFmean /ent po01 Bildung age Ost Welle age2. Koeffizientena Modell 1 (Konstante) po01 Links-RechtsSelbsteinstufung Bildung age Ost Welle age2 Nicht standardisierte Koeffizienten Standardf B ehler 1.681 .055 Standardisie rte Koeffizienten Beta T 30.310 Signifikanz .000 .268 .008 .276 33.140 .000 -.167 .002 .299 .057 4.26E-005 .006 .002 .014 .005 .000 -.226 .032 .177 .098 .083 -26.872 .724 21.418 11.967 1.893 .000 .469 .000 .000 .058 a. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Bei Kontrolle der übrigen Variablen ist der nichtlineare Alterseffekt selbst bei einer Irrtumswahrscheinlichkeit von 5% nicht signifikant. Bei erklärenden Variablen mit wenigen (J) Ausprägungen (wie bei der Bildung) kann die Linearitätsannahme durch zusätzliche Dummy-Variablen für J–2 Ausprägungen überprüft werden: reg stat def cha /dep=FFmean /ent po01 Bildung age Ost Welle /ent NoHS Abi Uni. Forschungspraktikum GMF 52 Prüfung der Anwendungsvoraussetzungen: Korrekte Modellspezifikation Modellzusammenfassung Änderungsstatistiken Modell 1 2 R R-Quadrat .442a .195 .447b .200 Standardf ehler des Schätzers .71425 .71236 Korrigiertes R-Quadrat .195 .199 Änderung in R-Quadrat .195 .004 Änderung in F 579.338 22.174 df1 5 3 df2 11954 11951 Änderung in Signifikanz von F .000 .000 a. Einflußvariablen : (Konstante), Welle, po01 Links-Rechts-Selbsteinstufung, age, Ost, Bildung b. Einflußvariablen : (Konstante), Welle, po01 Links-Rechts-Selbsteinstufung, age, Ost, Bildung, NoHS, Abi, Uni Koeffizientena Modell 1 2 (Konstante) po01 Links-RechtsSelbsteinstufung Bildung age Ost Welle (Konstante) po01 Links-RechtsSelbsteinstufung Bildung age Ost Welle NoHS Abi Uni Nicht standardisierte Koeffizienten Standardf ehler B 1.601 .036 Standardisie rte Koeffizienten Beta T 44.394 Signifikanz .000 .268 .008 .276 33.151 .000 -.169 .006 .299 .057 1.528 .006 .000 .014 .005 .048 -.228 .113 .177 .099 -27.372 13.739 21.415 12.001 32.162 .000 .000 .000 .000 .000 .265 .008 .273 32.797 .000 -.098 .005 .289 .057 -.272 -.179 -.194 .018 .000 .014 .005 .077 .030 .047 -.132 .111 .170 .099 -.032 -.091 -.100 -5.285 12.833 20.494 12.058 -3.548 -5.951 -4.123 .000 .000 .000 .000 .000 .000 .000 Die Analyse zeigt, dass Bildung nicht als linearer Effekt modelliert werden sollte, sondern besser als nominalskalierte Variable in das Modell aufzunehmen ist: reg /dep=FFmean /ent po01 age Ost Welle NoHS MR Abi Uni. a. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Forschungspraktikum GMF 53 Prüfung der Anwendungsvoraussetzungen: Korrekte Modellspezifikation ANOVAb Modellzusammenfassung Modell 1 R R-Quadrat .447a .200 Korrigiertes R-Quadrat .199 Standardf ehler des Schätzers .71236 a. Einflußvariablen : (Konstante), Uni, Ost, NoHS, Welle, age, po01 Links-Rechts-Selbsteinstufung, Abi, MR Modell 1 Regression Residuen Gesamt Quadrats umme 1511.518 6064.639 7576.157 df 8 11951 11959 Mittel der Quadrate 188.940 .507 F 372.325 Signifikanz .000a a. Einflußvariablen : (Konstante), Uni, Ost, NoHS, Welle, age, po01 Links-Rechts-Selbsteinstufung, Abi, MR b. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Koeffizientena Modell 1 (Konstante) po01 Links-RechtsSelbsteinstufung age Ost Welle NoHS MR Abi Uni Nicht standardisierte Koeffizienten Standardf ehler B 1.431 .036 Standardisie rte Koeffizienten Beta T 39.386 Signifikanz .000 .265 .008 .273 32.797 .000 .005 .289 .057 -.174 -.098 -.375 -.487 .000 .014 .005 .071 .018 .021 .020 .111 .170 .099 -.021 -.059 -.190 -.251 12.833 20.494 12.058 -2.454 -5.285 -17.822 -24.091 .000 .000 .000 .014 .000 .000 .000 a. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Forschungspraktikum GMF 54 Prüfung der Anwendungsvoraussetzungen: Kontrolle auf Inhomogenität Ein Regressionmodell ist vermutlich nicht korrekt spezifziert, wenn wenige Ausreißerfälle die Regressionsfunktion stark beeinflussen. Dies könnte für eine Verletzung der iid-Annahme sprechen. Eine Möglichkeit, mögliche Ausreißerfälle zu kontrollieren ist die Berechnung und Ausgabe von Cooks Distanzen: reg dep=FFmean /ent po01 age Ost Welle NoHS MR Abi Uni /sca (*cook,*pred). Der Plot von Cooks Distanzen nach den Vorhersagewertten weist nicht auf besonders einflussreiche Fälle hin: alle Werte der Distanzen sind kleiner 0.01. Forschungspraktikum GMF 55 Prüfung der Anwendungsvoraussetzungen: Kontrolle auf Homoskedastizität Da die Standardfehler der Residuen an den Rändern der Verteilung kleiner werden, sind die Stichprobenresiduen selbst dann nicht homoskedastisch, haben also variierende Varianzen, wenn die Populationsresiduen homoskedastisch wären. Zur Kontrolle werden daher die Residuen durch ihre geschätzten Populationsstandardabweichungen geteilt. Zur Unterscheidung von Z-Werten werden diese Quotienten in SPSS als studentisierte Residuen bezeichnet. reg dep=FFmean /ent po01 age Ost Welle NoHS MR Abi Uni /sca (*sresid,*pred). Zwar sind die Bandbreiten der Residuen in etwa gleich groß; es fällt jedoch auf, dass bei kleinen Vorhersagewerten eher positive und bei großen eher negative studentisierte Residuen auftreten. Dies ist eine Folge des begrenzten Wertbereichs der abhängigen Variable. Forschungspraktikum GMF 56 Prüfung der Anwendungsvoraussetzungen: Kontrolle auf Autokorrelation Für eine gewisse Kontrolle der Autokorrelation der Residuen (zwischen zwei benachbarten Fällen) kann in der Option "/Residuals" die Durbin-Watson-Statistik zur Prüfung auf Autokorrelation berechnet werden. Werte um 2 weisen auf keine Autokorrelation, Werte nahe Null auf negative und Werte nahe 4 auf positive Autorkorrelation hin: reg dep=FFmean /ent po01 age Ost Welle NoHS MR Abi Uni /resid def durbin. Modellzusammenfassungb Modell 1 R R-Quadrat .447a .200 Korrigiertes R-Quadrat .199 Standardf ehler des Schätzers .71236 DurbinWatsonStatistik 1.983 a. Einflußvariablen : (Konstante), Uni, Ost, NoHS, Welle, age, po01 Links-Rechts-Selbsteinstufung, Abi, MR b. Abhängige Variable: FFmean Fremdenfeindlichkeit 5-mean(ff03 to ff08) Der berechnete Wert nahe 2 weist darauf hin, dass es vermutlich keine Verletzung der Annahme gibt, dass die Residuen nicht autokorreliert sind. Forschungspraktikum GMF 57 Prüfung der Anwendungsvoraussetzungen: Kontrolle auf Normalverteilung Mit den Default-Parametern "NORMPROB(ZRESID)" und "HISTOGRAM(ZRESID)" der Option "/residuals", werden QQ-Plots der z-transformierten Residuen gegen eine Normalverteilung und ein Histogramm der Residuen angefordert, anhand derer deutliche Abweichungen von der Normalverteilungsannahme entdeckt werden können. Forschungspraktikum GMF 58 Prüfung der Anwendungsvoraussetzungen: Kontrolle auf Normalverteilung Die Abbildungen weisen nicht auf außergewöhnlichen Abweichungen von der Normalverteilungsannahme hin. Forschungspraktikum GMF 59 Syntax der SPSS-Prozedur Regression REGRESSION Variables=varlist /DESCRIPTIVES= DEFAULTS MEAN STDDEV CORR COV VARIANCE XPROD N /SELECT=varname relation value /MISSING=INCLUDE PAIRWISE MEANSUBSTITUTION /REGWGT=varname /STATISTICS=DEFAULTS R COEFF ANOVA OUTS ZPP LABEL CHA CI F BCOV SES XTX COLLIN TOL ALL /CRITERIA=TOL(zahl)PIN(zahl)POUT(zahl)FIN(zahl)FOUT(zahl}CIN(zahl) /ORIGIN /DEPENDENT=varlist /METHOD=ENTER varlist oder REMOVE varlist oder FORWARD varlist oder BACKWARD varlist oder STEPWISE varlist /RESIDUALS=DEFAULTS DURBIN OUTLIERS(ZRESID) ID(varname) NORMPROB(ZRESID) HISTOGRAM(ZRESID) /CASEWISE=DEFAULTS All oder OUTLIERS(3) PLOT(ZRESID) DEPENDENT PRED RESID tempvars /SCATTERPLOT (varname,varname) ... /PARTIALPLOT=ALL oder varlist /SAVE=tempvar(newname) ... . Die Optionen werden einzeln vorgestellt. Forschungspraktikum GMF 60 Syntax der SPSS-Prozedur Regression /DESCRIPTIVES= DEFAULTS MEAN STDDEV CORR COV VARIANCE XPROD N Berechnung deskriptiver Statistiken: "defaults": Mittelwert ("mean"), Standardabweichung ("stddev") und Korrelationen ("corr"). Bei Nennung von Parametern werden nur diese aufgeführt, wobei neben den Defaults "variance" für die geschätzte Populationsvarianzen, "cov" für die Varianzen und Kovarianzen, "xprod" für die Variationen und Kovariationen und "N" für eine Tabelle mit den verwendeten Fällen bei der Berechnung der Korrelationen steht. Bei "cov", "var" und "std" wird durch Fallzahl minus 1 geteilt. /SELECT=varname relation value Mit der Option können Fälle für die Berechnung ausgewählt werden. Vorhersagewerte, Residualstatistiken und temopräre Variablen werden getrennt für ausgewählte und nichtausgewählte Fälle berechnet. • "varname" darf nicht in der Option "variables" vorkommen; • "relation" steht für "EQ", "NE", "LT", "LE", "GT", or "GE". Andere Symbole sind unzulässig. • Die Schätzung erfolgt auf der Basis der Fälle, bei denen die Bedingung in "/select" erfüllt ist. /REGWGT=varname Mit der Option können Fälle über die aufgeführte Variable gewichtet werden, um Heteroskedastizität auszugleichen. Forschungspraktikum GMF 61 Syntax der SPSS-Prozedur Regression /MISSING=INCLUDE PAIRWISE MEANSUBSTITUTION Voreingestellt ist fallweiser Ausschluss bei mindestens einem ungültigen Wert bei einer Modellvariable. Mit "include" werden benutzerdefinierte Missing Values als gültig betrachtet, bei "pairweise" werden Fälle paarweise ausgeschlossen und bei "meansubstitution" werden fehlende Fälle durch den Mittelwert der Variable ersetzt. /STATISTICS=R COEFF ANOVA OUTS DEFAULTS ALL ZPP LABEL CHA CI F BCOV SES XTX COLLIN TOL Mit Statisik wird die Ausgabe der Regressionsschätzung gesteuert; "default" umfasst "R" für die Berechnung der multiplen Korrelation, des einfachen und adjustierten Determinationskoeffizienten und die Wurzel aus der geschätzten Residulavarianz, "coeff" für die Regressionskoeffizienten, deren Standardfehler, T-Werte und zweiseitigen empirischen Signifikanzen, sowie den standard. Regressionsgewichten, "anova" für die Variationszerlegung und F-Test von R-Quadrat und "outs" für das stand. gewicht, T-Test und minimale Toleranz für Variablen, die nicht in die Modellgleichung aufgenommen wurden. "ZPP" berechnet die einfachen, partiellen und semipartiellen Korrelationen eines Prädiktors mit der abhängigen Variablen, "CI" Konfidenzintervalle für die unstandardisierten Koeffizienten, "cha" Differenzen der Determinationskoeffizienten und zugehörige F-Tests bei schrittweisen Regressionen, "F" F-Tests statt T-tests, "bcov" Varianzen und Kovarianzen der geschätzten Koeffizien-ten, "SES" asymptotische Standardfähler für die standardisierten Regressionsgewichte, "collin" Kollinearitätsstatistiken (Eigenwerte und VIF), "tol" Toleranzen und "all" alle verfügbaren Statistiken. Forschungspraktikum GMF 62 Syntax der SPSS-Prozedur Regression /ORIGIN Die Option "origin" berechnet eine Regressionslinie durch den Ursprung ohne Regressionskonstante. Bei der Berechnung werden Rohmomente anstelle von Momenten um den Mittelwert genutzt. /DEPENDENT=varlist Spezifikation einer oder mehrerer abhängiger Variablen. /METHOD=ENTER varlist oder REMOVE varlist oder FORWARD varlist oder BACKWARD varlist oder STEPWISE varlist Das Schlüsselwort "method" kann ausgelassen werden. "enter varlist": Alle aufgeführten Variablen werden (zusätzlich) in die Regressionsgleichung aufgenommen, soweit sie nicht den kritischen Toleranzwert unterschreiten. Alle aufgeführten Variablen werden aus der Modellgleichung entfernt. "remove varlist": "backward varlist": Automatischer Ausschluss, solange die Werte von "fout" unter- bzw. "pout" überschritten werden. "forward varlist": Automatischer schrittweiser Einschluss, solange die Werte von "fint" über- bzw. "pint" unterschreiten. "stepwise varlist": = Abwechselnd "backward" und "forward" bis keine Variable mehr aufgenommen und keine mehr entfernt werden kann. Forschungspraktikum GMF 63 Syntax der SPSS-Prozedur Regression Die Prozedur Regression kann eine Reihe temporärer Variablen generieren, die für die Modellbeurteilung benötigt und auch in den aktiven Datensatz aufgenommen werden können: "pred": unstandardisierte Vorhersagewerte, "sepred": Standardfehler eines Vorhersagewertes "zpred": standardisierte Vorhersagewerte, "adjpred": adjustierte Vorhersagewerte, das sind Vorhersagewerte, wenn der betrachtete Fall bei der Schätzung der Modellgleichung ignoriert wird, Differenz aus "pred" und "adjpred", "dffit": unstandardisierte Residuen, "resid": "zresid": standardisierte Residuen, "sresid": studentisierte Residuen, das sind Residuen, die durch ihre geschätzte Populationsstandardabweichung geteilt sind, "dresid": Differenz zwischen abhängiger Variable und adjustierten Vorhersagewert, "sdresid": standardisiertes "dresid", Hebelwert (leverage) eines Falles, "lever": Cooks Distanzwerte, "cook": "dffit": Differenz aus "pred" und "adjpred", "mcin" und "icin": Grenzen von Konfidenzintervallen für geschätzte Mittelwerte bzw. individuelle Vorhersagewerte. Forschungspraktikum GMF 64 Syntax der SPSS-Prozedur Regression /RESIDUALS=DEFAULTS DURBIN OUTLIERS(ZRESID) ID(varname) NORMPROB(ZRESID) HISTOGRAM(ZRESID) "durbin" berechnet die Durbin-Watson-Statistik zur Prüfung auf Autokorrelation. Werte um 2 weisen auf keine Autokorrelation, Werte nahe Null auf negative und Werte nahe 4 auf positive Autorkorrelation hin. "out(zres)" Die 10 Fälle mit den größten Werten der temporären Variable in der Klammer werden ausgegegen. Neben "zresid" können "resid", "sredid", "dresid", "sdresid" und "cook" angegeben werden. Für jeden gelistetenFall wird die Fallnummer aus "$casenum" mit ausgegeben. Wird zusätzlich mit "ID(varname)" eine belibige Variable aus dem Datensatz genannt, wird auch deren jeweilige Realisierung mit ausgegeben. "normprob(zres)" druckt ein QQ-Plot gegen die Normalverteilung aus. Neben "zresid" können "zpred" und "sdresid" geplottet werden. "hist(zres)": Histogramme der aufgeführten temopären Variable werden erzeugt. Neben "zresid" können "resid", "sresid", "dresid", "sdresid", "pred", "zpred", "adjpred", "sepred", "lever" und "cook" angegeben werden. = "durb out norm hist" "Default": Forschungspraktikum GMF 65 Syntax der SPSS-Prozedur Regression /CASEWISE=DEFAULTS All oder OUTLIERS(3) PLOT(ZRESID) DEPENDENT PRED RESID tempvars Die Option "casewise" berechnet fallweise Statistiken entweder für alle Fälle ("ALL") oder für die Fälle, für die der Absolutwert der im Parameter "plot" aufgeführten Variable mindestens den Wert in der Klammer hinter "outliers" hat. Für diese Fälle könen die Werte der abhängigen Variable ("dependent"), der Vorhersagewerte ("pred"), der Residuen ("resid") sowie aller anderen temporären Variablen aufgeistet werden. Wenn in der Option "/residuals" im Parameter "id" eine Variable aufgeführt wird, wird diese neben der stets ausgedruckten Variable "$casenum" mit ausgegegben. /SCATTERPLOT (varname,varname) ... Die Option "scatterplot" erzeugt Punktewolken der aufgeführten Variablenpaare. Angesprochen werden können alle Variablen, die in der Option "variables=" aufgeführt sind, sowie die temporären Variablen "pred", "zpred", "adjpred", "sepref", "resid", "zresid", "sresid", "dresid", "sdresid", "lever" und "cook". Um diese Variablen von benutzererzeugten zu unterscheiden, werden sie durch "*" am Anfang gekennzeichnet, z.B. "(*resid,*pred)". /PARTIALPLOT=ALL oder varlist Die Option "partialplot" erzeugt Punktewolken der Residuen der abhängigen Variable gegen die Residuen der in "varlist" aufgeführten erklärenden Variablen, wobei abhängige und unabhängige Variable jeweils auf alle anderen erklärenden Variablen regrediert worden sind. Forschungspraktikum GMF 66 Syntax der SPSS-Prozedur Regression /SAVE=tempvar(newname) ... Mit der Option "/save" können die aufgeführten temporären Variablen (z.B. "pred" und "resid" als zusätzliche Variablen an die Datenmatrix des aktiven Datensatzes angehängt werden. In Klammern können Variablennamen für die temporären Variablen vergeben werden. Ansonsten generiert SPSS Variablennamen. Voraussetzung für die Aufnahme in den Datensatz ist, dass in "/dependent" nur eine abhängige Variable definiert ist. Forschungspraktikum GMF 67